Материалы по тегу: nvidia

|

21.09.2025 [13:40], Сергей Карасёв

Schneider Electric готовит стойки NVIDIA GB300 NVL72 мощностью 142 кВтКомпания Schneider Electric анонсировала две эталонные платформы, призванные ускорить построение инфраструктур для дата-центров, ориентированных на ресурсоёмкие нагрузки ИИ и НРС. Разработка систем ведётся в партнёрстве с NVIDIA. Один из проектов предусматривает создание референсных стоек для суперускорителей NVIDIA GB300 NVL72. Такие стойки смогут обеспечивать мощность до 142 кВт. Предусмотрено использование жидкостного охлаждения. В одном машинном зале могут быть расположены три кластера GB300 NVL72, насчитывающих в общей сложности до 1152 ускорителей. Отмечается, что в основу решения положены наработки и опыт, полученные в ходе реализации аналогичного проекта для NVIDIA GB200 NVL72. Клиентам будет доступна специальная среда моделирования на базе вычислительной гидродинамики (CFD): могут применяться цифровые двойники для оценки различных конфигураций электропитания и охлаждения с целью оптимизации платформ под определённые нужды.

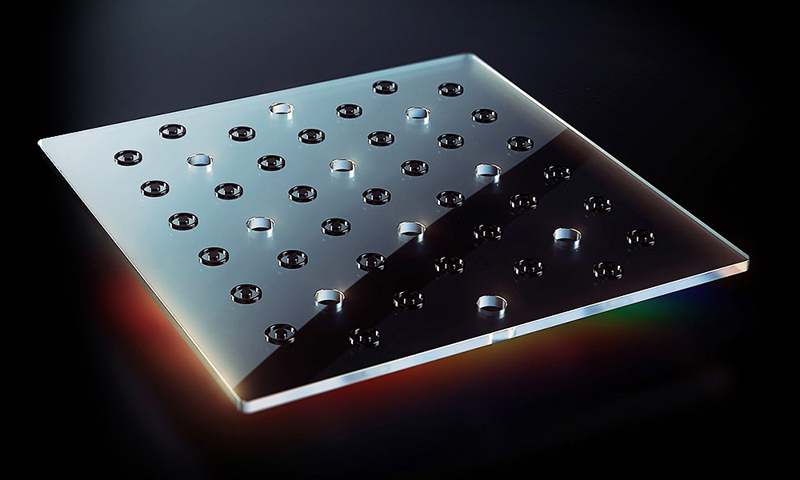

Источник изображения: Schneider Electric Второй эталонный проект, как утверждается, представляет собой первую и единственную в отрасли платформу, предполагающую интеграцию систем управления питанием и жидкостным охлаждением, включая решения Motivair (контрольный пакет акций этой фирмы Schneider Electric приобрела в конце 2024 года). Для новой платформы заявлена совместимость с NVIDIA Mission Control — программным обеспечением NVIDIA для контроля производственных процессов и оркестрации работы ИИ-систем, включая управление кластерами и рабочими нагрузками. В таких системах могут применяться суперускорители GB300 NVL72 и GB200 NVL72. Подчёркивается, что новые эталонные решения являются результатом продолжающегося сотрудничества Schneider Electric и NVIDIA, которое направлено на удовлетворение растущих потребностей операторов дата-центров в области ИИ.

21.09.2025 [13:23], Сергей Карасёв

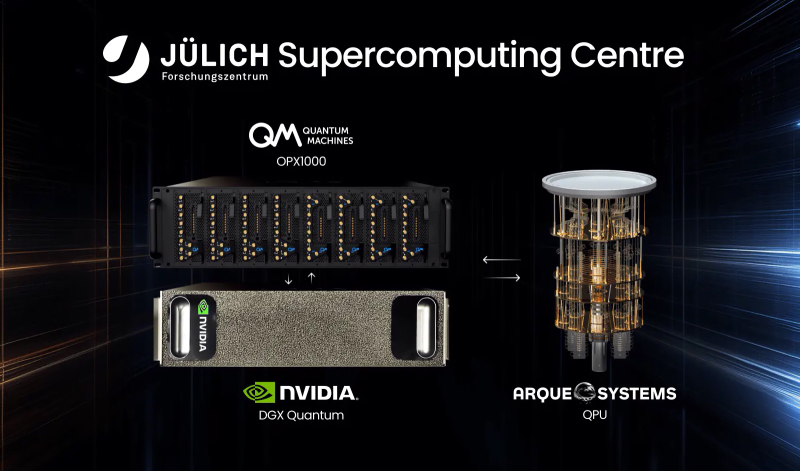

В Германии запущена квантово-классическая система с суперчипами NVIDIA GH200Компании Quantum Machines и Arque Systems развернули в Юлихском суперкомпьютерном центре в Германии (Jülich Supercomputing Centre, JSC) гибридную квантово-классическую вычислительную систему на платформе NVIDIA DGX Quantum. Это первый подобный проект, реализованный на базе крупной НРС-площадки в Европе. Новая система сочетает суперчипы NVIDIA GH200, 5-кубитный квантовый процессор Arque Systems и гибридный квантово-классический контроллер Quantum Machines OPX1000. Использованная архитектура, как утверждается, обеспечивает возможность квантовой коррекции ошибок (QEC), что является критически важным требованием при организации практических квантовых вычислений. Контроллер OPX1000, как отмечается, обеспечивает бесшовное взаимодействие между классическими и квантовыми вычислительными ресурсами. Достигается двусторонняя передача данных с задержкой менее 4 мкс, что в 1000 раз лучше, чем в предыдущих подобных реализациях. Ключевыми задачами проекта названы ускорение процедур калибровки кубитов и тестирование производительности квантовой коррекции ошибок. Кроме того, на базе комплекса планируется осуществлять разработку гибридных квантово-классических вычислительных алгоритмов. Одним из главных преимуществ платформы названа возможность запуска нейронных сетей и моделей машинного обучения на высокопроизводительных GPU с сохранением взаимодействия с квантовой подсистемой с низкой задержкой. Такой уровень интеграции, как подчёркивается, недоступен ни в одной другой современной системе квантовых вычислений. «Объединяя квантовые и классические вычислительные ресурсы на базе ведущего европейского суперкомпьютерного центра, мы открываем новые возможности для исследователей в плане изучения гибридных квантово-классических алгоритмов», — говорит доктор Кристель Михильсен (Kristel Michielsen), директор JSC. Нужно отметить, что JSC является оператором первого в Европе экзафлопсного суперкомпьютера — машины JUPITER, которая была официально запущена в эксплуатацию в сентябре 2025 года. Система использует примерно 6000 вычислительных узлов с гибридными ускорителями NVIDIA Quad GH200 и интерконнектом InfiniBand NDR200 (4×200G на узел, DragonFly+): в общей сложности задействованы почти 24 тыс. NVIDIA GH200.

20.09.2025 [01:40], Владимир Мироненко

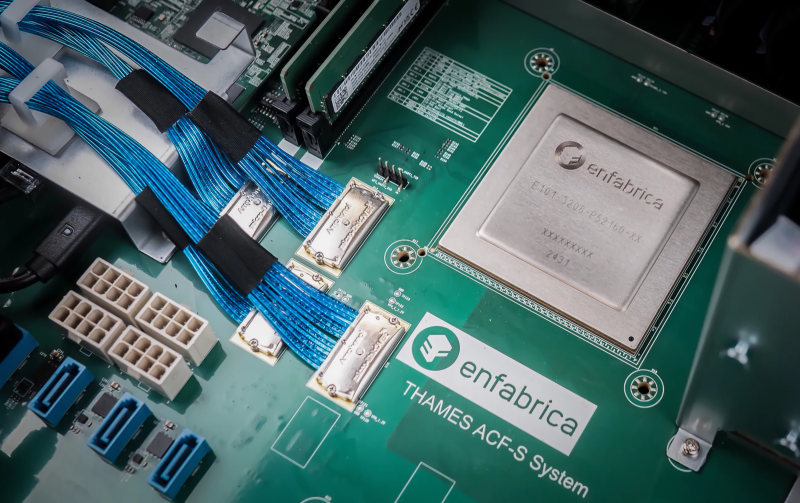

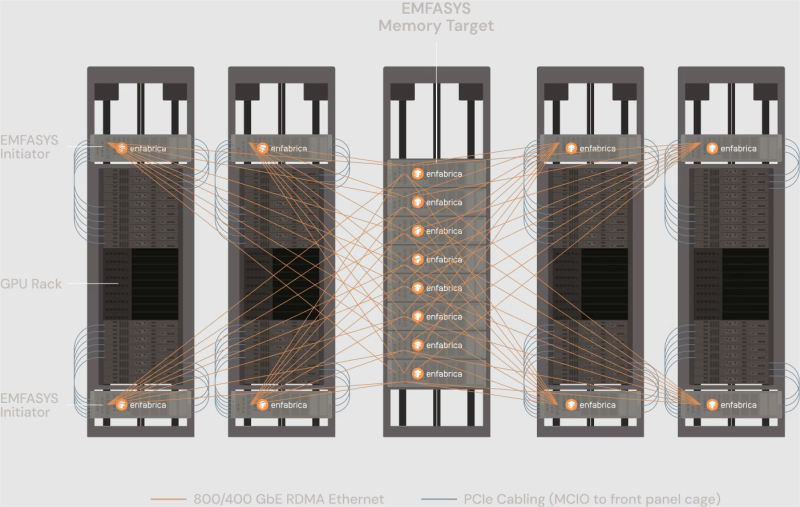

NVIDIA купила за $900 млн разработчика интерконнекта для ИИ-платформ EnfabricaСогласно публикациям CNBC и The Information, NVIDIA заключила сделку с разработчиком интерконнекта для ИИ-систем Enfabrica стоимостью $900 млн, чтобы лицензировать ряд его технологий, а также переманить его гендиректора и ключевых сотрудников. Оплата сделки, завершённой на прошлой неделе, производилась собственными средствами NVIDIA и её акциями. Глава Enfabrica Рочан Санкар (Rochan Sankar) уже присоединился к команде NVIDIA. Спрос на вычислительные мощности для поддержки генеративного ИИ со стороны таких компаний, как OpenAI, Anthropic, Mistral, AWS, Microsoft и Google, ставит перед NVIDIA сложную задачу: как создать унифицированный, отказоустойчивый GPU-кластер, способный справиться с такими огромными нагрузками. Решения Enfabrica, основанной в 2019 году, призваны решить эту задачу. Как пишет Network World со ссылкой на аналитиков, NVIDIA считает интеграцию технологий Enfabrica критически важной для повышения эффективности своих кластеров в обучении новейших ИИ-моделей. Во всяком случае, Enfabrica утверждает, что её технология позволяет бесшовно объединить более 100 тыс. ускорителей в единый кластер. Кроме того, к ускорителям можно добавить CXL-пулы DRAM/SSD. «Используя SuperNIC и фабрику Enfabrica, NVIDIA может ускорить передачу данных в кластерах, обойти текущие ограничения масштабирования сетевых фабрик и снизить зависимость от дорогостоящей памяти HBM», — отметила Рачита Рао (Rachita Rao), старший аналитик Everest Group, имея в виду чип ACF-S, разработанный для обеспечения более высокой пропускной способности, большей отказоустойчивости, меньшей задержки и лучшего программного управления для операторов ЦОД, работающих с ресурсоёмкими ИИ-системами и HPC. Enfabrica утверждает, что ACF-S более отказоустойчив в сравнении с традиционным интерконнектом, поскольку заменяет двухточечные соединения GPU многопутевой архитектурой, которая снижает перегрузку, улучшает распределение данных и гарантирует, что сбои в работе GPU не приведут к остановке процесса вычислений. По мнению Чарли Дая (Charlie Dai), главного аналитика Forrester, для NVIDIA также представляет интерес технология EMFASYS, позволяющая дать ИИ-серверам доступ к внешним пулам памяти. По словам Дая, сочетание ACF-S и EMFASYS может помочь NVIDIA добиться более высокой загрузки GPU и снижения совокупной стоимости владения (TCO) — ключевых показателей для гиперскейлеров и разработчиков LLM. Как сообщает Blocks & Files, Enfabrica привлекла в общей сложности $290 млн венчурного финансирования: $50 млн в раунде A в размере $50 млн в 2022 году при оценке в $50 млн; $125 млн в раунде B в 2023 году с оценкой в размере $250 млн; $115 млн в раунде C в 2024 году. По данным Pitchbook, оценочная стоимость компании сейчас составляет около $600 млн. NVIDIA инвестировала в компанию в раунде B. На этой неделе NVIDIA также объявила об инвестициях в Intel в размере $5 млрд в рамках совместной разработки специализированных чипов для ЦОД и ПК. Квазислияния получили широкое распространение в Кремниевой долине, поскольку позволяют обойти препоны регуляторов. В начале этого года Meta✴ приобрела за $14,3 млрд 49 % акций Scale AI, переманив его основателя Александра Ванга (Alexandr Wang) вместе с ключевыми сотрудниками. Месяц спустя Google объявила о похожем соглашении с ИИ-стартапом Windsurf, в рамках которого его соучредитель и гендиректор Варун Мохан (Varun Mohan) перешёл вместе с рядом сотрудников в подразделение Google DeepMind. Аналогичные сделки были в прошлом году у Google с Character.AI, Microsoft с Inflection AI и у Amazon с Adept.

19.09.2025 [14:43], Владимир Мироненко

NVIDIA инвестирует £2 млрд в развитие экосистемы ИИ-стартапов Великобритании — £500 млн получит NscaleNVIDIA объявила об инвестициях в размере £2 млрд ($2,7 млрд) в ИТ-рынок Великобритании с целью стимулирования развития экосистемы стартапов в сфере ИИ, разработки инновационных ИИ-технологий, создания новых компаний и рабочих мест, а также расширения конкурентных возможностей Великобритании на мировом ИИ-рынке. Как отмечено в пресс-релизе NVIDIA, развитие ИИ-компаний в Великобритании осложняется ограниченным доступом к суперкомпьютерам, ограниченным венчурным капиталом за пределами Лондона, а также растущими ценами на электроэнергию и трудностями с доступом венчурных капиталистов к ведущим академическим учреждениям, где многие исследователи также являются предпринимателями. В связи с этим американский технологический гигант планирует в сотрудничестве с британскими компаниями Accel, Air Street Capital, Balderton Capital, Hoxton Ventures и Phoenix Court ускорить развитие ИИ-экосистемы в Великобритании, предоставив новый капитал стартапам в этой сфере. Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA, заявил, что сейчас самое подходящее время для инвестиций в Великобританию, поскольку «ИИ открывает новые горизонты в науке и стимулирует развитие совершенно новых отраслей». «Благодаря новому капиталу и развитой инфраструктуре мы удваиваем усилия, чтобы дать Великобритании возможность возглавить следующую волну инноваций в области ИИ», — подчеркнул он. В связи с недавним обязательством NVIDIA производить в США суперкомпьютеры для ИИ-нагрузок на сумму до полутриллиона долларов, инвестиции будут осуществляться в Соединённых Штатах и «активироваться» в Великобритании, а британские венчурные партнеры помогут производителю чипов найти стартапы в области ИИ, которым необходима поддержка, отметил Bloomberg. По данным ресурса, NVIDIA планирует инвестировать в разработчиков технологий автономных транспортных средств Wayve и Oxa, финтех-компанию Revolut, а также ИИ-стартапы PolyAI, Synthesia, Latent Labs и Basecamp Research. Wayve сообщила, что NVIDIA инвестирует в компанию $500 млн для ускорения разработки и внедрения её ИИ-модели. Сумма в £2 млрд также включает в себя долю NVIDIA в размере £500 млн ($683 млн) в британской компании Nscale, занимающейся разработкой ИИ ЦОД. Средства будут выделены из баланса NVIDIA, сообщил представитель компании. Ранее Microsoft, OpenAI и Google также объявили об инвестициях на общую сумму в десятки миллиардов долларов и партнёрских соглашениях в Великобритании.

19.09.2025 [14:19], Сергей Карасёв

В Нью-Йорке заработал гибридный ЦОД Digital Realty с ИИ-кластером и квантовым компьютеромКомпания Digital Realty объявила об открытии на своей площадке JFK10 в Нью-Йорке специализированного дата-центра для задач ИИ, объединяющего вычисления на базе GPU и квантового компьютера. В реализации проекта приняли участие NVIDIA и Oxford Quantum Circuits (OQC). В состав платформы входит квантовая система Genesis, разработанная специалистами OQC. Она базируется на фирменной технологии двухканальных кубитов Dimon, которая, как утверждается, является прорывом в области устранения ошибок. Применение Dimon, по заявлениям OQC, позволяет снизить накладные расходы, одновременно открывая путь к отказоустойчивым квантовым вычислениям. Ещё одной составляющей нового дата-центра являются суперчипы NVIDIA GH200. Их использование в связке с Genesis позволяет сформировать среду для гибридных квантовых вычислений в области ИИ. Применённый подход предоставляет предприятиям доступ к интегрированной платформе, обеспечивающей более быстрое обучение ИИ-моделей и генерацию данных с повышенной эффективностью. Таким образом, компании могут одновременно задействовать возможности квантовых вычислений и ИИ при реализации сложных проектов и создании приложений следующего поколения.

Источник изображения: OQC Одной из ключевых сфер использования гибридной платформы названы финансы. Речь идёт о высокоточном моделировании рисков, обнаружении мошенничества, оптимизации услуг и пр. Кроме того, система может применяться для улучшения логистических операций, поддержки принятия решений в условиях неопределённости, повышения устойчивости в критически важных областях и др. Квантовые вычисления открывают также новые возможности для самого ИИ. Предполагается, что в перспективе новые системы Genesis будут поставляться с ускорителями NVIDIA в стандартной комплектации.

19.09.2025 [11:42], Сергей Карасёв

AAEON представила компактную ИИ-систему Intelli i14 Edge с ускорителем NVIDIA RTXКомпания AAEON анонсировала компьютер небольшого форм-фактора Intelli i14 Edge, рассчитанный на использование в коммерческой и индустриальной сферах. Устройство подходит для решения задач промышленной автоматизации, машинного зрения, предиктивного обслуживания, проектирования робототехники и пр. В основу новинки положена аппаратная платформа Intel Raptor Lake. Применён процессор Core i9-14900T, который объединяет 24 вычислительных ядра (8Р + 16Е; 32 потока). Максимальная тактовая частота — 5,5 ГГц. В состав чипа входит графический блок Intel UHD Graphics 770. Объём оперативной памяти DDR5-4800 может достигать 32 Гбайт в виде двух модулей SO-DIMM с поддержкой ЕСС. Компьютер несёт на борту ускоритель NVIDIA RTX A2000 или RTX A4500 (MXM), благодаря чему обеспечивается возможность локальной обработки ИИ-моделей. Есть два коннектора M.2 2280 M-Key для NVMe SSD и разъём M.2 2230 E-Key для адаптера Wi-Fi / Bluetooth. Реализованы два интерфейса DisplayPort для вывода изображения. Благодаря наличию сетевых портов 2.5GbE (Intel I226-IT) и 1GbE (Intel I219-LM), а также пяти разъёмов USB 3.2 Gen1 Type-A, как отмечает AAEON, обеспечивается бесшовная интеграция с камерами, лидарами, инерциальными измерительными блоками (IMU) и промышленными концентраторами ввода-вывода. Предусмотрен также один порт USB 3.2 Gen2 Type-C. Устройство имеет размеры 205 × 190 × 70 мм и весит около 3 кг. Диапазон рабочих температур — от 0 до +50 °C. Решение протестировано на устойчивость к вибрации в соответствии со стандартом IEC EN60068-2-64, что делает его пригодным для использования в автомобильных системах помощи водителю при движении (ADAS), оборонных комплексах, робототехнических платформах и других системах, которые эксплуатируются в неблагоприятных условиях. Говорится о совместимости с Windows 10 IoT.

19.09.2025 [01:45], Владимир Мироненко

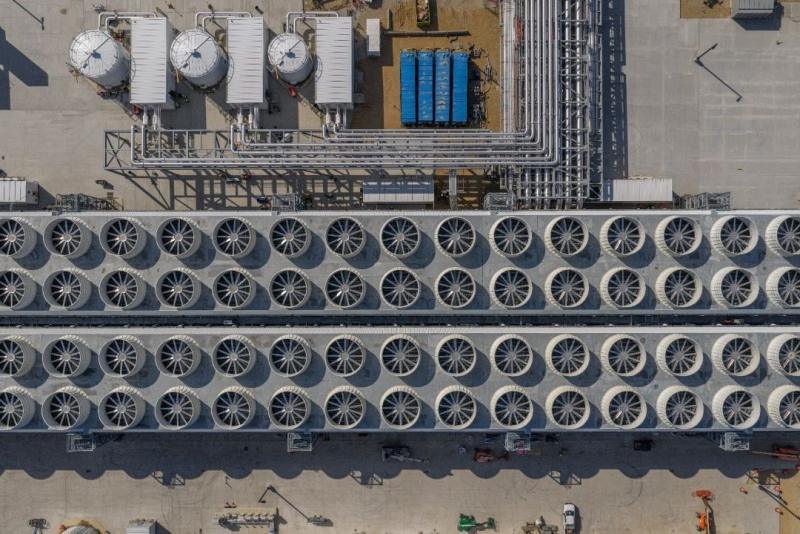

Microsoft вот-вот достроит «самый передовой» ИИ ЦОД в мире Fairwater и потратит $4 млрд на ещё один такой жеMicrosoft заявила, что находится на завершающей стадии строительства дата-центра Fairwater в Маунт-Плезант (Mount Pleasant) в Висконсине (США) стоимостью $3,3 млрд, который она называет самым передовым ИИ ЦОД в мире, пишет газета The Wall Street Journal. Ранее сообщалось, что Microsoft приостановила вторую фазу проекта, чтобы провести переоценку планов. Вице-председатель и президент Microsoft Брэд Смит (Brad Smith) сообщил, что объект будет запущен в эксплуатацию в начале 2026 года и первоначально будет использоваться для обучения моделей компании OpenAI, к которой затем могут присоединиться и другие арендаторы, включая саму Microsoft. Неподалёку будет построен ещё один ИИ ЦОД таких же масштабов, на который компания выделит в течение следующих трёх лет $4 млрд. Третий ЦОД семейства Fairwater появится в Джорджии. По словам Смита, сочетание вычислительной мощности ускорителей NVIDIA с сетевыми и системными решениями сделает проекты «поистине передовыми», что позволит обучать продвинутые как никогда ИИ-модели. ЦОД в Висконсине занимает площадь в 127,5 Га и включает три двухэтажных здания (это упростит развёртывание сети) общей площадью 111,5 тыс. м 2. Для его строительства потребовалось 74,6 км свай фундамента глубокого заложения, 112 тыс. т металлоконструкций, 190 км подземного кабеля среднего напряжения и 112,6 км трубопроводов. Впрочем, признаёт компания, им повезло, что хоть какая-то базовая инфраструктура на участке уже была создана усилиями бывшего владельца кампуса — Foxconn. Microsoft сообщила, что в ЦОД будут размещены сотни тысяч ускорителей NVIDIA GB200, соединённых оптоволокном (800G InfiniBand/Ethernet), которого хватило бы, чтобы «обернуть планету четыре раза». Производительность ЦОД будет в десять раз выше, чем у самых быстрых современных суперкомпьютеров, утверждает компания, не предоставляя дополнительных подробностей. ЦОД отличается передовой системой охлаждения. Более 90 % оборудования объекта будет обслуживаться замкнутой системой СЖО, которая будет заполнена на этапе строительства и, по словам компании, не потребует дозаправки. Остальная часть серверного оборудования будет использовать охлаждение наружным воздухом, а вода будет потребляться лишь в самые жаркие дни. В результате общее годовое потребление воды одним ЦОД на территории кампуса будет примерно эквивалентно расходу воды обычного ресторана за этот же период. Для питания ЦОД будут заключены соглашения о закупках электроэнергии (PPA) из возобновляемых источников. Microsoft также финансирует новый проект солнечной электростанции мощностью 250 МВт, строительство которой в настоящее время ведётся в округе Портидж (Portage). Ожидается, что в первом ЦОД штат составит около 500 сотрудников, а после завершения строительства второго дата-центра их количество вырастет до 800.

18.09.2025 [17:16], Сергей Карасёв

Стартап Carbon3.ai намерен развернуть в Великобритании экологичную суверенную ИИ-инфраструктуруКомпания Carbon3.ai, по сообщению Datacenter Dynamics, планирует создать в Великобритании общенациональную суверенную ИИ-инфраструктуру, которая в конечном итоге будет насчитывать до 100 тыс. GPU-ускорителей. Партнёрами в рамках масштабного проекта выступают НРЕ, VAST Data и World Wide Technology (WWT). Целью инициативы является развёртывание сети ЦОД, получающих питание исключительно от возобновляемых источников энергии. Все инфраструктурные объекты будут располагаться исключительно на территории Великобритании, соответствуя стандартам национальной безопасности. Предполагается, что сеть свяжет более 50 площадок по всей стране. На сайте Carbon3.ai говорится, что проектом предусмотрено использование ИИ-ускорителей NVIDIA Blackwell для решения ресурсоёмких задач, включая обучение больших языковых моделей (LLM) и инференс. Кроме того, будет задействована программно-аппаратная платформа HPE Private Cloud AI. Carbon3.ai заявляет, что уже получила в Великобритании «значительный первоначальный капитал», рассчитывая в перспективе довести объём привлечённых средств до £1 млрд ($1,36 млрд). Предполагается, что создаваемая суверенная ИИ-инфраструктура поможет клиентам контролировать свои данные, одновременно добиваясь целей в области устойчивого развития.

Источник изображения: Carbon3.ai Нужно отметить, что на днях ряд крупных компании объявили о намерении инвестировать огромные суммы в развитие ИИ в Великобритании. Так, Microsoft планирует вложить в ИИ-проекты на территории этой страны около $30 млрд, BlackRock — примерно $678 млн, а Google — около $6,8 млрд. Кроме того, NVIDIA и партнёры инвестируют до $15 млрд в расширение британских дата-центров, создав ИИ-фабрики со 120 тыс. ускорителей Blackwell. Компания CoreWeave вложит в дата-центры для задач ИИ в Великобритании дополнительно $2 млрд.

18.09.2025 [16:09], Владимир Мироненко

Intel разработает для NVIDIA кастомные CPU для серверов и ПК, а NVIDIA вложит в Intel $5 млрдNVIDIA и корпорация Intel заключили соглашение о сотрудничестве с целью совместной разработки специализированных чипов для ЦОД и ПК для использования гиперскейлерами, а также другими клиентами на корпоративном и потребительском рынках. Согласно пресс-релизу, компании намерены обеспечить бесшовное объединение архитектур NVIDIA и Intel с использованием NVIDIA NVLink, реализуя преимущества NVIDIA в области ИИ и ускоренных вычислений совместно с ведущими технологиями процессоров Intel и экосистемой x86 для предоставления передовых решений для клиентов. Ранее NVIDIA представила интерконнект NVLink Fusion, который как раз и позволяет объединять решения компании с чиплетами других вендоров. Одним из первых продуктов стал чип GB10, включающий GPU Blackwell и Arm-процессор MediaTek. В рамках партнёрства Intel разработает кастомные серверные x86-процессоры для ИИ-платформ NVIDIA. Для персональных компьютеров Intel разработает SoC с архитектурой x86 и GPU-чиплетами NVIDIA RTX. Новые SoC RTX на базе x86 будут использоваться в широком спектре ПК. У Intel уже был опыт интеграции GPU AMD в свои SoC, но не слишком удачный — Kaby Lake-G были заброшены через пару лет после выхода. В рамках соглашения о сотрудничестве NVIDIA инвестирует в Intel $5 млрд путём приобретения на эту сумму обыкновенных акций Intel по цене $23,28 за единицу. После этого объявления акции Intel подскочили на премаркете на 33 % до примерно $33 за единицу, сообщил ресурс CNBC. Ранее SoftBank потратила $2 млрд на покупку акций Intel по $23/шт. В конце августа власти США приобрели 9,9 % долю в Intel за $8,9 млрд, получив акции по $20,47 за бумагу. «Это историческое сотрудничество тесно связывает ИИ-технологии и ускоренные вычисления NVIDIA с CPU Intel и обширной экосистемой x86 — слиянием двух платформ мирового класса. Вместе мы расширим наши экосистемы и заложим основу для следующей эры вычислений», — отметил генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang). Как полагают аналитики CNBC, сотрудничество, по всей видимости, не включают производство чипов NVIDIA на производственных мощностях Intel.

18.09.2025 [15:25], Сергей Карасёв

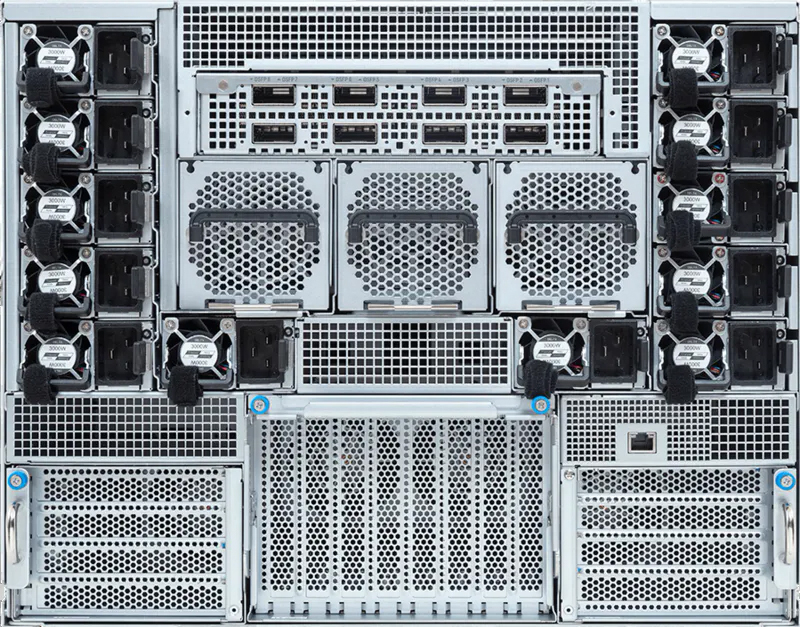

Giga Computing представила флагманский ИИ-сервер на базе NVIDIA HGX B300Компания Giga Computing, подразделение Gigabyte, анонсировала сервер G894-SD3-AAX7 — флагманскую систему, предназначенную для решения сложных HPC-задач, обучения больших языковых моделей (LLM), инференса и других ресурсоёмких ИИ-нагрузок. В основу новинки положены процессорры Intel Xeon Granite Rapids и ускорители NVIDIA Blackwell Ultra. Сервер выполнен в форм-факторе 8U. Возможна установка двух процессоров Xeon 6500P/6700P с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 RDIMM-6400 или MRDIMM-8000. Во фронтальной части расположены восемь посадочных мест для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe) и поддержкой горячей замены. Кроме того, есть два внутренних коннектора для SSD типоразмера M.2 2280/22110 (PCIe 5.0 x4 и PCIe 5.0 x2).  Система, построенная на платформе NVIDIA HGX B300, имеет восемь SXM-ускорителей Blackwell Ultra. Могут быть реализованы восемь портов 800G OSFP InfiniBand или 16 портов 400GbE посредством адаптеров NVIDIA ConnectX-8 SuperNIC. Говорится о поддержке DPU NVIDIA BlueField-3 и о наличии четырёх слотов PCIe 5.0 x16 для карт FHHL.  Сервер оснащён двумя портами 10GbE на базе Intel X710-AT2, выделенным сетевым портом управления 1GbE, контроллером ASPEED AST2600, двумя портами USB 3.2 Gen1 Type-A и интерфейсом D-Sub. Применяется воздушное охлаждение. За питание отвечают 12 блоков мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C. |

|