Материалы по тегу: сервер

|

03.10.2025 [08:58], Сергей Карасёв

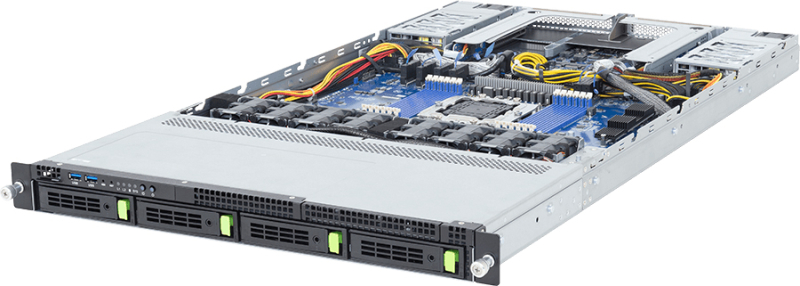

Giga Computing представила серверы с Arm-чипами AmpereOne M для ИИ-инференсаКомпания Giga Computing, подразделение Gigabyte, анонсировала серверы R1A3-T40 и R2A3-T40, построенные на процессорах AmpereOne M, которые спроектированы специально для поддержания ресурсоёмких ИИ-нагрузок в дата-центрах. Представленные системы подходят для инференса, облачных приложений и пр. Модель R1A3-T40 выполнена в форм-факторе 1U, устройство R2A3-T40 — в корпусе 2U. В обоих случаях допускается установка одного чипа AmpereOne M, который может содержать до 192 кастомизированных 64-бит ядер на базе Arm v8.6+. Показатель TDP — до 425 Вт. Есть 12 слотов для модулей оперативной памяти DDR5-5600. Младшая версия располагает четырьмя фронтальными отсеками для накопителей LFF/SFF с интерфейсом SATA/SAS-4 или PCIe 5.0 (NVMe). Доступны два слота PCIe 5.0 x16 для карт расширения типоразмера FHHL и два разъёма OCP NIC 3.0 PCIe 5.0 x16. Сервер 2U, в свою очередь, оснащён 12 посадочными местами для SFF-накопителей (SATA/SAS-4 или PCIe 5.0), одним слотом PCIe 5.0 x16 и одним разъёмом OCP NIC 3.0 PCIe 5.0 x16. Новинки несут на борту контроллер ASPEED AST2600 и сетевой адаптер Intel I210-AT стандарта 1GbE. Есть выделенный сетевой порт управления 1GbE, а также коннектор M.2 для SSD формата 2242/2260/2280/22110 с интерфейсом PCIe 5.0 x4. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 PLUS Titanium. Предусмотрены три порта USB 3.2 Gen1 Type-A (два располагаются на лицевой панели), порт Micro-USB, интерфейс Mini-DP, гнёзда RJ45 для сетевых кабелей и аналоговый разъём D-Sub (только у модели R2A3-T40). Применена система воздушного охлаждения. Диапазон рабочих температур — от +10 до +35 °C.

02.10.2025 [12:25], Сергей Карасёв

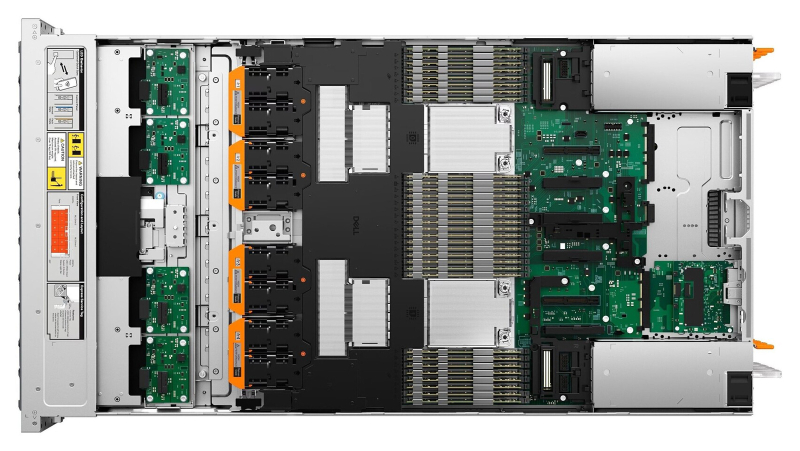

Dell представила сервер PowerEdge XR8720t для инфраструктур Cloud RANКомпания Dell анонсировала сервер PowerEdge XR8720t, ориентированный на заказчиков из телекоммуникационного сектора. Устройство, выполненное на аппаратной платформе Intel, предназначено для применения в составе инфраструктур Cloud RAN. По заявлениям Dell, PowerEdge XR8720t — это первое односерверное решение Cloud RAN. Отмечается, что обычно для таких задач требуются несколько серверов, что объясняется фундаментальными архитектурными ограничениями. Уникальная многосекционная архитектура Dell позволяет обойти эти сложности, используя единственный сервер в корпусе типоразмера 2U, в котором блоки располагаются бок о бок. Утверждается, что модель PowerEdge XR8720t специально разработана для периферийных и телекоммуникационных рабочих нагрузок, где задержка, отказоустойчивость и адаптивность имеют первостепенное значение. Полностью характеристики новинки не раскрываются. Известно, что сервер оснащается процессорами Xeon 6, насчитывающими от 32 до 72 вычислительных ядер. Это первый сервер с сетевым адаптером Intel OCP 3.0 E830-XXVDA8. Разъёмы для подключения сетевых кабелей располагаются во фронтальной части. Устройство заключено в корпус глубиной 433 мм. Питание обеспечивают два блока мощностью 1400 Вт. Диапазон рабочих температур простирается от -5 до +55 °C. Говорится о соответствии стандартам NEBS Level 3 и GR-3108 Class 1. Сервер рассчитан на эксплуатацию в неблагоприятных условиях. Ещё одним преимуществом решения названа модульная архитектура, благодаря которой клиенты смогут расширять мощности или добавлять новые узлы без необходимости перепроектирования всей инфраструктуры.

26.09.2025 [11:35], Сергей Карасёв

Стартап FuriosaAI представил ИИ-сервер NXT RNGD с производительностью 4 ПфлопсЮжнокорейский стартап FuriosaAI анонсировал высокопроизводительный сервер NXT RNGD для ресурсоёмких нагрузок ИИ. Утверждается, что в сценариях частного облака и локальных дата-центров новинка обеспечивает большую эффективность и меньшую стоимость владения по сравнению с решениями, оборудованными ускорителями на базе GPU. Система NXT RNGD заключена в корпус форм-фактора 4U. Она оснащена восемью специализированными ускорителями RNGD, которые выполнены в виде карт расширения PCIe 5.0 x16. Каждая из карт располагает 48 Гбайт памяти HBM3 с пропускной способностью до 1,5 Тбайт/с и 256 Мбайт памяти SRAM (384 Тбайт/с). Таким образом, суммарный объём памяти HBM3 составляет 384 Гбайт.

Источник изображения: FuriosaAI Ускорители RNGD обладают ИИ-производительностью до 512 Тфлопс в режиме FP8 и до 512 TOPS в режиме INT8. Таким образом, сервер NXT RNGD демонстрирует показатели до 4 Пфлопс и 4 тыс. TOPS соответственно. При этом общая потребляемая мощность составляет 3 кВт против 10,2 кВт у NVIDIA DGX H100. Таким образом, как отмечает FuriosaAI, стандартная серверная стойка мощностью 15 кВт способна вместить до пяти систем NXT RNGD, в то время как в случае NVIDIA DGX H100 может поддерживаться работа только одной машины. Среди других преимуществ платформы NXT RNGD разработчик называет простоту и удобство развёртывания в любом месте (в том числе с ограничениями по доступной мощности), суверенитет данных (подходит для приложений с обработкой конфиденциальной информации), гибкость в плане новых вариантов использования (доступен комплект SDK) и существенное снижение совокупной стоимости владения. В настоящее время сервер предлагается для тестирования клиентам по всему миру. Приём заказов на NXT RNGD начнётся в 2026 году.

25.09.2025 [11:37], Сергей Карасёв

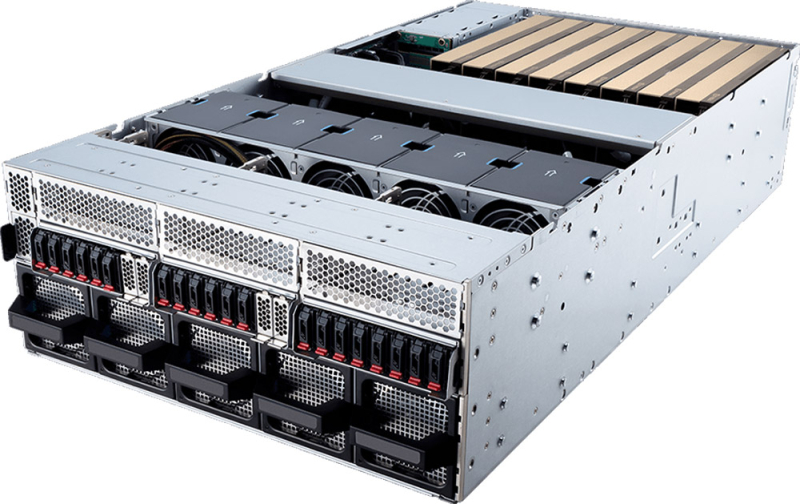

Edgecore Networks представила ИИ-сервер AGS8600 на базе AMD EPYC Turin и Instinct MI325XКомпания Edgecore Networks анонсировала сервер AGS8600 формата 8U, построенный на аппаратной платформе AMD. Устройство, уже доступное для заказа, предназначено для решения ресурсоёмких задач в сферах ИИ, машинного обучения, НРС, научных исследований и пр. Система несёт на борту два 64-ядерных процессора EPYC 9575F поколения Turin с показателем TDP в 400 Вт. Доступны 24 слота для модулей оперативной памяти DDR5. Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 (NVMe): базовая конфигурация включает шесть SSD вместимостью 7,68 Тбайт каждый и два SSD на 1,92 Тбайт. Сервер укомплектован восемью GPU-ускорителями Instinct MI325X с 256 Гбайт памяти HBM3e и производительностью до 2,6 Пфлопс в режиме FP8. Задействованы семь линий Infinity Fabric в расчёте на GPU. В оснащение включены восемь однопортовых сетевых адаптеров BCM957608-P1400GDF00 400G QSFP112-DD PCIe Ethernet NIC. Кроме того, присутствуют два двухпортовых адаптера BCM957608-P2200GQF00 200GbE QSFP112 PCIe Ethernet NIC, выделенный сетевой порт управления 1GbE, контроллер ASPEED AST2600, два порта USB 3.0 и интерфейс D-Sub. За возможности расширения отвечают восемь слотов PCIe 5.0 x16 для карт половинной высоты и четыре разъёма PCIe 5.0 x16 для карт полной высоты. Питание обеспечивают шесть блоков мощностью 3300 Вт с сертификатом 80 Plus Titanium. Применена система воздушного охлаждения с 15 вентиляторами, допускающими горячую замену. Габариты составляют 448 × 850 × 351 мм. Диапазон рабочих температур — от +10 до +35 °C. На сервере используется ОС с ядром Linux. Среди поддерживаемого ПО упомянуты ROCm 6.2.4, RCCL 2.20.5, PyTorch 2.3/2.2/2.1/2.0/1.13, TensorFlow 2.16.1/2.15.1/2.14.1, JAX 0.4.26 и ONNX Runtime 1.17.3.

22.09.2025 [16:44], Сергей Карасёв

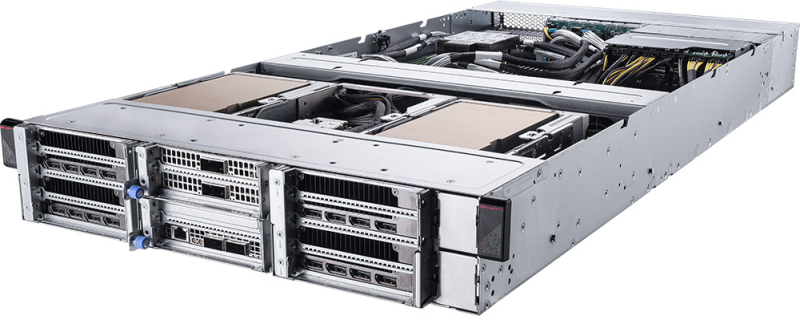

OpenYard представила российский GPU-сервер HN203I на базе Intel Xeon 6Российский разработчик и производитель серверного оборудования OpenYard сообщил о создании флагманской системы HN203I на аппаратной платформе Intel Xeon 6. Сервер выполнен в формате 2OU в соответствии со стандартом Open Rack v3.0 (опционально Open Rack v2.2). «HN203I — это технологический скачок для российской серверной индустрии. Мы создаём флагманскую платформу, которая сочетает в себе максимальную производительность, энергоэффективность и простоту эксплуатации», — говорит компания. Возможна установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 с поддержкой изделий RDIMM ёмкостью до 128 Гбайт и 3DS RDIMM ёмкостью до 256 Гбайт. Таким образом, максимальный объём ОЗУ составляет 8 Тбайт. В оснащение входят восемь слотов PCIe 5.0 x16 MCIO и три слота PCIe 5.0 x4 MCIO, разъём OCP 3.0 (PCIe 5.0 x16), два коннектора M.2 M-Key (PCIe 5.0 x2 и PCIe 5.0 x4), а также разъём M.2 Key E (PCIe 5.0 x1). Допускается монтаж десяти SFF-накопителей (NVMe) с возможностью горячей замены и четырёх LFF-устройств с интерфейсом SATA/SAS. Кроме того, могут быть установлены до четырёх PCIe-ускорителей NVIDIA H100/L40/L40S/L4. Модель HN203I располагает контролером ASPEED AST2600, двумя сетевыми портами управления RJ45 (по одному спереди и сзади), двумя портами USB 3.0 Type-A, интерфейсом mini-DP. Применено воздушное охлаждение, а диапазон рабочих температур простирается от +10 до +40 °C. Максимальная мощность блоков питания — 5500 Вт. Габариты составляют 537 × 801,6 × 93 мм. Управление осуществляется через BIOS OpenYard и систему OYBMC. Сервер подходит для ИИ-нагрузок, облачных сервисов, телеком-задач и гиперскейл-инфраструктуры.

18.09.2025 [15:25], Сергей Карасёв

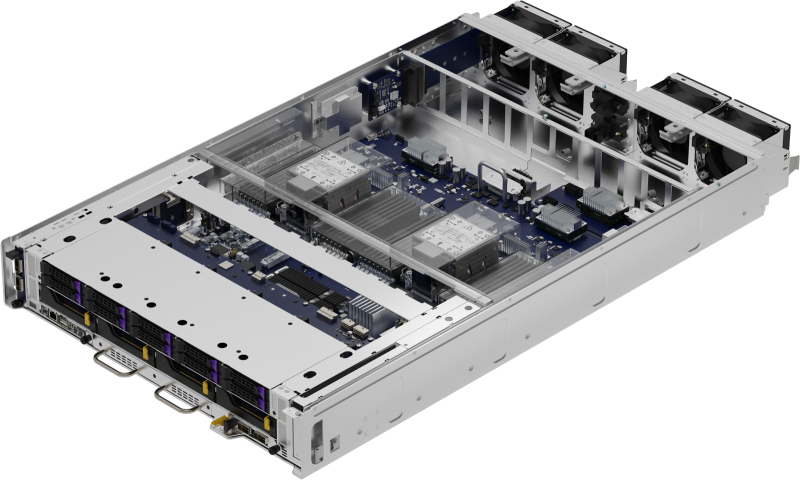

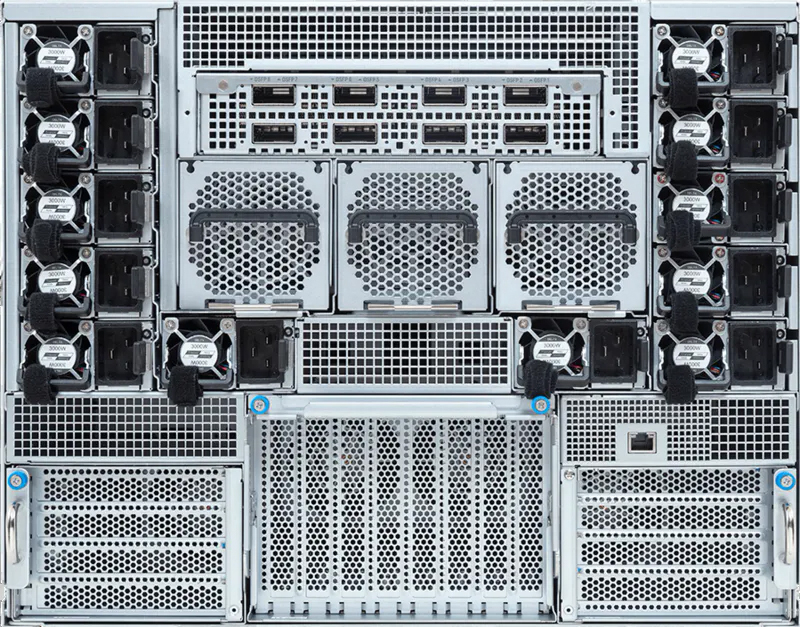

Giga Computing представила флагманский ИИ-сервер на базе NVIDIA HGX B300Компания Giga Computing, подразделение Gigabyte, анонсировала сервер G894-SD3-AAX7 — флагманскую систему, предназначенную для решения сложных HPC-задач, обучения больших языковых моделей (LLM), инференса и других ресурсоёмких ИИ-нагрузок. В основу новинки положены процессорры Intel Xeon Granite Rapids и ускорители NVIDIA Blackwell Ultra. Сервер выполнен в форм-факторе 8U. Возможна установка двух процессоров Xeon 6500P/6700P с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 RDIMM-6400 или MRDIMM-8000. Во фронтальной части расположены восемь посадочных мест для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe) и поддержкой горячей замены. Кроме того, есть два внутренних коннектора для SSD типоразмера M.2 2280/22110 (PCIe 5.0 x4 и PCIe 5.0 x2).  Система, построенная на платформе NVIDIA HGX B300, имеет восемь SXM-ускорителей Blackwell Ultra. Могут быть реализованы восемь портов 800G OSFP InfiniBand или 16 портов 400GbE посредством адаптеров NVIDIA ConnectX-8 SuperNIC. Говорится о поддержке DPU NVIDIA BlueField-3 и о наличии четырёх слотов PCIe 5.0 x16 для карт FHHL.  Сервер оснащён двумя портами 10GbE на базе Intel X710-AT2, выделенным сетевым портом управления 1GbE, контроллером ASPEED AST2600, двумя портами USB 3.2 Gen1 Type-A и интерфейсом D-Sub. Применяется воздушное охлаждение. За питание отвечают 12 блоков мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C.

18.09.2025 [10:52], Сергей Карасёв

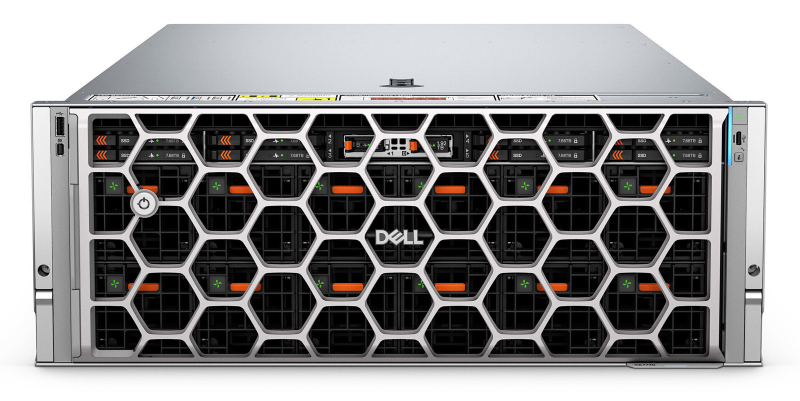

Dell представила ИИ-сервер PowerEdge XE7740 с ускорителями Intel Gaudi 3Компания Dell полностью раскрыла характеристики стоечного сервера PowerEdge XE7740, о подготовке которого впервые стало известно в ноябре 2024 года. Новинка ориентирована на решение ресурсоёмких задач в области ИИ, включая тонкую настройку больших языковых моделей (LLM), инференс, распознавание изображений и речи, выявление мошенничества в сфере финансовых услуг и пр. Сервер, выполненный в форм-факторе 4U, рассчитан на установку двух процессоров Intel Xeon 6 поколения Granite Rapids-SP, которые могут насчитывать до 86 вычислительных ядер. Доступны 32 слота для модулей DDR5-6400 суммарным объёмом до 4 Тбайт. Во фронтальной части расположены восемь отсеков для NVMe SSD стандарта E3.S вместимостью до 122,88 Тбайт. Кроме того, доступны два внутренних коннектора M.2 для загрузочных NVMe-накопителей. Машина может нести на борту до восьми ИИ-ускорителей Intel Gaudi 3. В зависимости от конфигурации возможна установка восьми карт FHFL двойной ширины (до 600 Вт) с интерфейсом PCIe 5.0 x16 или 16 карт FHFL одинарной ширины (75 Вт). Кроме того, есть слот OCP NIC 3.0. Сервер оборудован системой воздушного охлаждения. За питание отвечают блоки мощностью 3200 Вт с сертификатом 80 PLUS Titanium. На лицевую панель выведены по одному порту USB 2.0 Type-A (iDRAC/BMC Direct), USB 2.0 Type-A (опционально) и Mini-DisplayPort. Сзади расположены два порта USB 3.1 Type-A, коннектор D-Sub и выделенный Ethernet-порт (iDRAC). Габариты составляют 899,56 × 482,0 × 174,3 мм, масса — 71,35 кг. Заявлена совместимость с Ubuntu Server LTS, Red Hat Enterprise Linux, SUSE Linux Enterprise Server и VMWare ESXi.

09.09.2025 [17:50], Сергей Карасёв

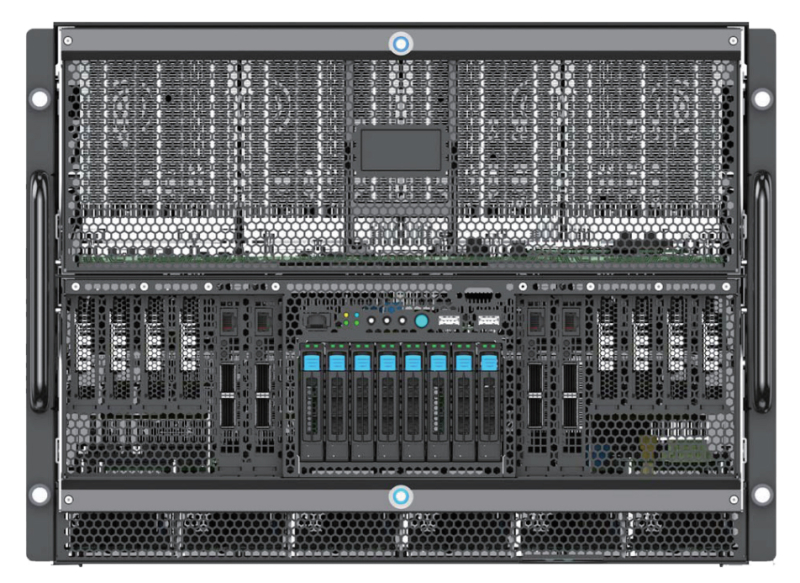

Бескабельные серверы и стойки Softbank помогут роботам вытеснить людей из ЦОДКорпорация SoftBank объявила о разработке новой стойки для серверов без кабелей. Это поможет в организации обслуживания ЦОД при помощи специализированных роботов. Стойка упрощает выполнение таких задач, как установка и демонтаж модулей, замена компонентов в случае неисправности и проведение автоматизированных проверок. В современных ЦОД большое количество кабелей внутри серверных стоек является серьёзным препятствием для выполнения тех или иных работ с использованием роботов. Из-за плотной кабельной сети затрудняется точное определение и управление целевым оборудованием в стойке, что негативно отражается на возможностях автоматизации обслуживания. Для решения данной проблемы SoftBank разработала серверную стойку с «бескабельной конструкцией».

Источник изображений: SoftBank Новинка имеет ширину 19″: она выполнена в соответствии со стандартом OCP ORv3 (Open Rack v3). Говорится о совместимости с системами жидкостного охлаждения. Стойка рассчитана на монтаж серверов общего назначения. Питание подаётся по общей шине на задней стороне стойки. В системе охлаждения используется «слепой разъём», упрощающий соединение магистралей СЖО. Для передачи данных служит оптический интерфейс. Таким образом, при установке серверы могут просто задвигаться в стойку без необходимости подключения кабелей.  В настоящее время SoftBank готовится к тестированию стоек в реальных условиях с использованием специализированных роботов для обслуживания. Проект является частью программы SoftBank по внедрению автоматизации в дата-центре для задач ИИ на острове Хоккайдо, открытие которого запланировано на 2026 финансовый год. Нужно отметить, что робототехнические комплексы для выполнения рутинных задач в ЦОД тестируют и многие другие компании. В их число входят Google, Digital Edge, Digital Realty, Scala Data Centers и Oracle. Правда, пока речь идёт в основном о патрулировании и выполнении некоторых простейших с точки зрения человека операций.

02.09.2025 [12:15], Сергей Карасёв

MSI выпустила серверы на платформе NVIDIA MGX с ускорителями RTX Pro 6000 Blackwell Server EditionКомпания MSI анонсировала серверы CG480-S5063 и CG290-S3063 на модульной архитектуре NVIDIA MGX. Новинки, ориентированные на задачи ИИ, оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition с 96 Гбайт GDDR7. Модель CG480-S5063 выполнена в форм-факторе 4U. Допускается установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400/5200 или MRDIMM 8000). Во фронтальной части могут быть размещены 20 накопителей E1.S с интерфейсом PCIe 5.0 x4 (NVMe). Кроме того, есть два внутренних коннектора М.2 2280/22110 (PCIe 5.0 x2; NVMe). Система предлагает восемь слотов PCIe 5.0 x16 для карт FHFL двойной ширины и пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Таким образом, могут быть задействованы до восьми ИИ-ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на основе Intel X710-AT2, выделенный сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Питание обеспечивают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Задействовано воздушное охлаждение с вентиляторами, допускающими горячую замену. Диапазон рабочих температур — от 0 до +35 °C. В свою очередь, сервер CG290-S3063 типоразмера 2U рассчитан на один процессор Xeon 6500P/6700P с TDP до 350 Вт. Предусмотрены 16 слотов для модулей DDR5 (RDIMM 6400/5200 или MRDIMM 8000). В тыльной части расположены отсеки для четырёх SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe). Внутри есть два коннектора М.2 2280/22110 для SSD (PCIe 5.0 x2; NVMe). Данная система предоставляет четыре слота PCIe 5.0 x16 для карт FHFL двойной ширины и три слота PCIe 5.0 x16 для карт FHFL одинарной ширины. Могут быть использованы до четырёх ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. Прочие характеристики включают контроллер ASPEED AST2600, сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Применены четыре блока питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium и воздушное охлаждение.

01.09.2025 [12:05], Сергей Карасёв

Giga Computing представила блейд-серверы B-series на платформах AMD и IntelКомпания Giga Computing, подразделение Gigabyte, объявила о выходе на рынок блейд-серверов, оптимизированных для корпоративных, периферийных и облачных рабочих нагрузок. Первыми системами данного класса стали устройства B343-C40 на аппаратной платформе AMD и B343-X40 с процессорами Intel. Все новинки выполнены в форм-факторе 3U с 10-узловой конфигурацией. Серверы B343-C40 могут комплектоваться чипами EPYC 4005 Grado или Ryzen 9000 с показателем TDP до 170 Вт (один CPU на узел). Доступны четыре слота для модулей оперативной памяти DDR5-5600/3600 в расчете на узел. Каждый из узлов также предлагает слот M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x1, два посадочных места для SFF-накопителей NVMe/SATA, один разъём для карты расширения FHHL с интерфейсом PCIe 5.0 x16 и три слота OCP NIC 3.0 (PCIe 4.0 x4). В семейство B343-C40 вошли три модификации — B343-C40-AAJ1, B343-C40-AAJ2 и B343-C40-AAJ3, у которых каждый из узлов располагает соответственно двумя портами 1GbE (контроллер Intel I350-AM2), 10GbE (Broadcom BCM57416) и 25GbE (Broadcom BCM57502). Кроме того, во всех случаях предусмотрен выделенный сетевой порт управления 1GbE и контроллер ASPEED AST2600 (на узел). За питание системы в целом отвечают четыре блока мощностью 2000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C. Применяется воздушное охлаждение. В свою очередь, у сервера B343-X40 каждый из узлов может оснащаться одним процессором Xeon 6300 с TDP до 95 Вт. Реализованы четыре слота для модулей DDR5-4400/4000/3600 и два порта 1GbE на основе контроллера Intel I350-AM2 (в расчёте на узел). В остальном технические характеристики аналогичны AMD-версиям. При этом в систему установлены два блока питания мощностью 3200 Вт с сертификатом 80 PLUS Titanium. |

|