Материалы по тегу: dgx

|

25.07.2025 [17:41], Сергей Карасёв

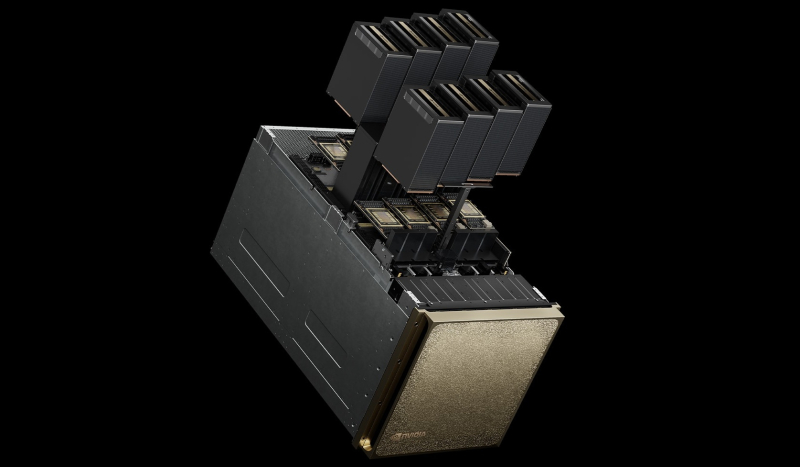

SoftBank развернула крупнейшую в мире ИИ-платформу на базе NVIDIA DGX B200Японский холдинг SoftBank объявил о расширении вычислительной ИИ-инфраструктуры на платформе NVIDIA DGX SuperPOD: развёрнуты системы DGX B200, насчитывающие в общей сложности 4 тыс. ускорителей поколения Blackwell. О планах SoftBank по созданию первого в мире ИИ-суперкомпьютер на базе NVIDIA DGX B200 стало известно в конце прошлого года. Вычислительная система использует интерконнект Quantum-2 InfiniBand и поддерживается программной платформой NVIDIA AI Enterprise. Холдинг SoftBank изначально внедрил DGX SuperPOD с более чем 2 тыс. ускорителями поколения NVIDIA Ampere в сентябре 2023 года: на тот момент производительность достигала 0,7 Эфлопс на операциях ИИ (точность вычислений не раскрывается). В октябре 2024 года завершился первый этап модернизации, в ходе которого были добавлены 4000 ускорителей семейства NVIDIA Hopper. В результате, суммарное быстродействие поднялось до 4,7 Эфлопс. После установки DGX B200 показатель вырос до 13,7 Эфлопс. Отмечается, что на сегодняшний день новая вычислительная инфраструктура SoftBank является крупнейшей в мире ИИ-платформой на основе DGX B200. При этом в общей сложности задействованы свыше 10 тыс. ускорителей. Изначально систему будет использовать SB Intuitions Corp. — дочерняя структура SoftBank, которая специализируется на разработке собственных больших языковых моделей (LLM), адаптированных для Японии. SB Intuitions уже создала LLM с примерно 460 млрд параметров, а в текущем 2025 финансовом году, который заканчивается 31 марта 2026-го, компания планирует представить коммерческую ИИ-модель Sarashina mini с 70 млрд параметров. Нужно отметить, что ранее SoftBank и OpenAI объявили о формировании совместного предприятия SB OpenAI для развития корпоративных ИИ-сервисов в Японии. Кроме того, SoftBank участвует в мегапроект Stargate — это совместное предприятие с OpenAI и Oracle по развитию ИИ-инфраструктуры в США. Предполагается, что суммарные затраты на реализацию Stargate достигнут $500 млрд. Впрочем, пока проект продвигается с большим трудом.

13.04.2025 [23:54], Владимир Мироненко

ИИ-агенты под присмотром: Google Distributed Cloud заработает на on-premise платформах NVIDIA Blackwell DGX/HGX

b200

dgx

google cloud platform

hardware

hgx

nvidia

гибридное облако

ии

ии-агент

инференс

конфиденциальность

облако

частное облако

NVIDIA объявила о стратегическом партнёрстве с Google Cloud с целью внедрения агентного ИИ на предприятиях, которые хотели бы локально использовать семейство моделей Google Gemini с помощью платформ NVIDIA Blackwell HGX/DGX, а также функции NVIDIA Confidential Computing для повышения безопасности данных. Интеграция платформы NVIDIA Blackwell с портфелем программно-аппаратных решений Google Distributed Cloud позволяет локальным ЦОД соответствовать нормативным требованиям и законам о суверенитете данных, блокируя доступ к конфиденциальной информации, включая истории болезни пациентов, финансовые транзакции и секретную правительственную информацию. NVIDIA Confidential Computing защищает конфиденциальный код в моделях Gemini от несанкционированного доступа и утечек данных — запросы пользователя к API Gemini, а также данные, которые они использовали для тонкой настройки, остаются в безопасности и защищены от несанкционированного доступа или изменений. Сачин Гупта (Sachin Gupta), вице-президент и генеральный менеджер по инфраструктуре и решениям в Google Cloud, отметил, что партнёрство позволяет предприятиям в полной мере использовать весь потенциал агентного ИИ, внедряя модели Gemini в локальные системы, и объединяя производительность NVIDIA Blackwell и возможности конфиденциальных вычислений. Хотя многие уже могут использовать модели с мультимодальным рассуждением — интегрируя текст, изображения, код и другие типы данных для решения сложных проблем и создания облачных приложений агентного ИИ, предприятия с повышенными требованиями к безопасности или суверенитету данных столкнулись с трудностями при внедрении этих технологий. Данное партнёрство позволит решить эти проблемы, благодаря чему Google Cloud становится одним из первых поставщиков, предлагающих возможности конфиденциальных вычислений для защиты рабочих нагрузок ИИ-агентов в любой среде, как облачной, так и гибридной. Масштабирование агентного ИИ требует надёжного мониторинга и безопасности для обеспечения стабильной производительности и соответствия требованиям. Google Cloud представила новый шлюз GKE Inference Gateway, созданный для оптимизации развёртывания рабочих нагрузок ИИ-агентов с расширенной маршрутизацией и масштабируемостью. Интеграция с NVIDIA Triton Inference Server и NVIDIA NeMo Guardrails обеспечивает интеллектуальную балансировку нагрузки, которая повышает производительность и снижает затраты на обслуживание, также обеспечивая централизованную безопасность и управление моделями. В дальнейшем Google Cloud планирует улучшить отслеживания рабочих нагрузок агентского ИИ, интегрировав NVIDIA Dynamo, библиотеку с открытым исходным кодом, предназначенную для обслуживания и масштабирования рассуждающих моделей. Этот перспективный подход гарантирует, что предприятия смогут уверенно масштабировать свои приложения агентского ИИ, сохраняя при этом безопасность и соответствие требованиям.

05.04.2025 [10:36], Сергей Карасёв

Европейский суперкомпьютер Discoverer получил обновление в виде NVIDIA DGX H200Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о модернизации суперкомпьютера Discoverer, установленного в Софийском технологическом парке в Болгарии. Обновленная НРС-система получила название Discoverer+. Комплекс Discoverer, построенный на платформе BullSequana XH2000, был введён в эксплуатацию в 2021 году. Изначальная конфигурация включала 1128 вычислительных узлов, каждый из которых содержит два 64-ядерных процессора AMD EPYC 7H12 поколения Rome. Производительность (FP64) достигала 4,52 Пфлопс с пиковым значением в 5,94 Пфлопс. С такими показателями система находится на 221-й позиции в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500. В рамках модернизации добавлен GPU-раздел на основе четырёх модулей NVIDIA DGX H200. Каждый из них содержит восемь ускорителей H200 и два процессора Intel Xeon Platinum 8480C поколения Sapphire Rapids с 56 ядрами (до 3,8 ГГц). Модули обладают быстродействием до 32 Пфлопс каждый в режиме FP8. Кроме того, обновлённый комплекс получил Lustre-хранилище вместимостью 5,1 Пбайт, систему хранения Weka ёмкостью 273 Тбайт и дополнительную ИБП-систему.

Источник изображения: EuroHPC JU Как отмечается, Discoverer стал первым суперкомпьютером EuroHPC, прошедшим серьёзную модернизацию с момента своего первоначального запуска. После наращивания мощностей комплекс планируется использовать для крупномасштабных проектов в области ИИ, таких как обучение нейронных сетей, создание цифровых двойников сложных объектов и пр. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они расположатся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Кроме того, такие объекты планируется создать в Австрии, Болгарии, Франции, Германии, Польше и Словении. Эти площадки станут частью высококонкурентной и инновационной экосистемы ИИ в Европе.

24.03.2025 [20:02], Владимир Мироненко

ИИ в один клик: NVIDIA и Equinix предложат готовые к использованию кластеры DGX GB300 и DGX B300 в 45 регионах по всему мируЧтобы удовлетворить растущий спрос на ИИ-инфраструктуру, NVIDIA представила NVIDIA Instant AI Factory — управляемый сервис на базе платформ NVIDIA DGX SuperPOD с ускорителями Blackwell Ultra и ПО NVIDIA Mission Control. NVIDIA сообщила, что её партнёр Equinix станет первой компанией, которая предложит новые системы DGX GB300 и DGX B300 в своих предварительно сконфигурированных ЦОД с жидкостным или воздушным охлаждением, готовых к обработке ИИ-нагрузок и расположенных на 45 рынках по всему миру. Как пишет SiliconANGLE, Тони Пейкдей (Tony Paikeday), старший директор NVIDIA по маркетингу продуктов и систем ИИ, заявил, что партнёрство с Equinix позволит компании выйти на более чем 45 рынков по всему миру «с предварительно настроенными объектами, которые готовы в зависимости от спроса клиентов масштабировать, эксплуатировать и управлять ИИ-инфраструктурой». NVIDIA отметила, что сервис предоставит предприятиям полностью готовые ИИ-фабрики, оптимизированные для обучения современных моделей и рабочих нагрузок моделей рассуждений в реальном времени, что избавит от многомесячного планирования инфраструктуры перед развёртыванием. Поскольку Equinix предоставляет средства и инфраструктуру для разработки ИИ, Пейкдей возлагает большие надежды на платформу SuperPOD и считает, что она окажет позитивное влияние на развёртывание ИИ компаниями. «Equinix — ключевой компонент этой платформы, потому что вам нужно жидкостное охлаждение, вам нужны ЦОД следующего поколения, вам нужны сверхскоростные соединения с внешним миром, чтобы передавать эти данные», — заявил он.

19.03.2025 [09:56], Сергей Карасёв

NVIDIA представила персональный ИИ-суперкомпьютер DGX Station на базе GB300NVIDIA анонсировала настольный ИИ-суперкомпьютер DGX Station на аппаратной платформе Blackwell Ultra. Устройство, оснащённое суперчипом Grace Blackwell GB300, ориентировано на ресурсоёмкие нагрузки ИИ, включая задачи инференса. По заявлениям NVIDIA, система DGX Station обеспечивает производительность уровня ЦОД в настольном формате. Задействован ускоритель GB300 с 288 Гбайт памяти HBM3E, которая обеспечивает пропускную способность до 8 Тбайт/с. Ускоритель Blackwell Ultra связан с процессором Grace с 72 Arm-ядрами Neoverse V2 посредством NVLink-C2C (900 Гбайт/с). При это сам модуль ускорителя съёмный. Система несёт на борту 496 Гбайт памяти LPDDR5X (четыре модуля SOCAMM) с пропускной способностью до 396 Гбайт/с. DGX Station оснащён 800G-адаптером NVIDIA ConnectX-8 SuperNIC (два порта QSFP или OSFP), а также два порта RJ45. На заднюю панель выведены четыре USB-порта Type-A и один Type-C, видеовыход MiniDP и шесть аудиоразъёмов. На самой плате присутствуют три PCIe-разъёма x16 и три слотам M.2. Кроме того, есть слот для карты с BMC. Прочие технические характеристики новинки пока не раскрываются. В качестве программной платформы применяется NVIDIA DGX OS — специализированная модификация Ubuntu, оптимизированная для работы с ИИ. Пользователи могут получить доступ к микросервисам NVIDIA NIM для быстрого развёртывания ИИ-моделей и программной экосистеме NVIDIA AI Enterprise в целом. Система демонстрирует ИИ-производительность до 20 Пфлопс в режиме FP4. Устройства DGX Station будут предлагаться такими партнёрами NVIDIA, как ASUS, Box, Dell, HPE, Lambda и Supermicro. Продажи начнутся позднее в текущем году.

06.12.2024 [16:42], Сергей Карасёв

iGenius анонсировала Colosseum — один из мощнейших в мире ИИ-суперкомпьютеров на базе NVIDIA DGX GB200 SuperPodКомпания iGenius, специализирующаяся на ИИ-моделях для отраслей со строгим регулированием, анонсировала вычислительную платформу Colosseum. Это, как утверждается, один из самых мощных в мире ИИ-суперкомпьютеров на платформе NVIDIA DGX SuperPOD с тысячами ускорителей GB200 (Blackwell). Известно, что комплекс Colosseum располагается в Европе. Полностью характеристики суперкомпьютера не раскрываются. Отмечается, что он обеспечивает производительность до 115 Эфлопс на операциях ИИ (FP4 с разреженностью). Говорится о применении передовой системы жидкостного охлаждения. Для питания используется энергия из возобновляемых источников в Италии. По информации Reuters, в состав Colosseum войдут около 80 суперускорителей GB200 NVL72. Таким образом, общее количество ускорителей Blackwell достигает 5760. Общее энергопотребление системы должно составить почти 10 МВт. Стоимость проекта не называется. Но глава iGenius Ульян Шарка (Uljan Sharka) отмечает, что компания в течение 2024 года привлекла на развитие примерно €650 млн и намерена получить дополнительное финансирование для проекта Colosseum. При этом подчёркивается, что iGenius — один из немногих стартапов в области ИИ в Европе, капитализация которого превышает $1 млрд. iGenius планирует применять Colosseum для ресурсоёмких приложений ИИ, включая обучение больших языковых моделей (LLM) с триллионом параметров, а также работу с открытыми моделями генеративного ИИ. Подчёркивается, что создание Colosseum станет основой для следующего этапа сотрудничества между iGenius и NVIDIA в области ИИ для поддержки задач, требующих максимальной безопасности данных, надёжности и точности: это может быть финансовый консалтинг, обслуживание пациентов в системе здравоохранения, государственное планирование и пр. Модели iGenius AI, созданные с использованием платформы NVIDIA AI Enterprise, NVIDIA Nemotron и фреймворка NVIDIA NeMo, будут предлагаться в виде микросервисов NVIDIA NIM. По заявлениям iGenius, Colosseum поможет удовлетворить растущие потребности в ИИ-вычислениях. Colosseum также будет служить неким хабом, объединяющим предприятия, академические учреждения и государственные структуры. Нужно отметить, что около месяца назад компания DeepL, специализирующаяся на разработке средств автоматического перевода на основе ИИ, объявила о намерении развернуть платформу на базе NVIDIA DGX GB200 SuperPod в Швеции. DeepL будет применять этот комплекс для исследовательских задач, в частности, для разработки передовых ИИ-моделей.

14.11.2024 [08:17], Владимир Мироненко

SoftBank построит в Японии первый в мире ИИ-суперкомпьютер на базе NVIDIA DGX B200NVIDIA объявила о серии совместных проектов с SoftBank, направленных на ускорение суверенных инициатив Японии в области ИИ, которые также обеспечат возможность получения дохода от ИИ для поставщиков телекоммуникационных услуг по всему миру. В выступлении на саммите NVIDIA AI Summit Japan генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) объявил, что SoftBank создаёт самый мощный в Японии ИИ-суперкомпьютер с использованием платформы NVIDIA DGX SuperPOD B200 и интерконнекта Quantum-2 InfiniBand. Эта система станет первой в мире, которая получит системы DGX B200. Она будет использоваться компанией для разработки генеративного ИИ и развития других бизнес-решений, а также для предоставления вычислительных услуг университетам, научно-исследовательским институтам и предприятиям в стране. Суперкомпьютер идеально подойдёт для разработки больших языковых моделей (LLM), говорится в пресс-релизе. Пока что на звание самого мощного ИИ-суперкомьютера Японии претендует система ABCI 3.0 на базе NVIDIA H200. Впрочем, Softbank не сидит сложа руки и планирует построить ещё один суперкомпьютер, на этот раз на базе суперускорителей GB200 NVL72. Они же будут использоваться в проекте Sharp, KDDI и Supermicro по созданию «крупнейшего в Азии» ИИ ЦОД. Также в ходе саммита было объявлено, что SoftBank, используя платформу ускоренных вычислений NVIDIA AI Aerial, успешно запустил первую в мире телекоммуникационную сеть, объединяющую возможности ИИ и 5G. В ходе испытаний, проведенных в префектуре Канагава, SoftBank продемонстрировала, что решение AI-RAN достигло производительности 5G операторского класса, используя ресурсы ускорителя для одновременной обработки сетевого трафика и инференса. Отмечается, что мобильные сети традиционно рассчитаны на обработку пиковых нагрузок и в среднем задействуют только треть аппаратных ресурсов, что позволяет монетизировать оставшиеся две трети путём предоставления ИИ-сервисов. NVIDIA и SoftBank также сообщили, что с помощью ПО NVIDIA AI Enterprise японская компания будет создавать локализованные безопасные ИИ-сервисы.

04.11.2024 [13:05], Сергей Карасёв

DeepL развернёт в Швеции ИИ-платформу на базе NVIDIA DGX GB200 SuperPod, чтобы «разрушить языковые барьеры»Компания DeepL объявила о намерении развернуть вычислительный комплекс на платформе NVIDIA DGX SuperPOD с ускорителями GB200. Система расположится на площадке EcoDataCenter в Швеции, а её ввод в эксплуатацию запланирован на середину 2025 года. DeepL специализируется на разработке средств автоматического перевода на основе ИИ. По заявлениям Ярека Кутыловски (Jarek Kutylowski), генерального директора и основателя DeepL, компания создала решение, которое по точности перевода превосходит все другие сервисы на рынке. Более 100 тыс. предприятий, правительственных структур и других организаций, а также миллионы индивидуальных пользователей по всему миру применяют языковые ИИ-инструменты DeepL. Штат компании насчитывает более 1 тыс. сотрудников. Её поддерживают инвестициями Benchmark, IVP, Index Ventures и др. В 2023 году DeepL развернула суперкомпьютер Mercury на базе NVIDIA DGX SuperPOD с ускорителями H100. В июньском рейтинге TOP500 эта система занимает 41-е место с FP64-производительностью 21,85 Пфлопс и теоретическим пиковым быстродействием 33,85 Пфлопс. Платформа NVIDIA DGX SuperPOD с ускорителями GB200 предусматривает использование жидкостного охлаждения. Возможно масштабирование до десятков тысяч ускорителей. DeepL намерена применять новый комплекс для исследовательских задач — в частности, для разработки передовых ИИ-моделей, которые позволят ещё больше расширить возможности средств перевода между различными языками. Это позволит «разрушить языковые барьеры для предприятий и профессионалов по всему миру», обещает компания.

26.10.2024 [14:00], Сергей Карасёв

Дженсен Хуанг и король Фредерик X запустили самый производительный в Дании ИИ-суперкомьютер GefionОснователь и генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) и король Дании Фредерик X объявили о запуске крупнейшего в стране суверенного суперкомпьютера для задач ИИ. Система получила название Gefion («Гевьон») — в честь скандинавской богини плодородия. НРС-комплекс эксплуатируется Датским центром инноваций в области искусственного интеллекта (DCAI), который был создан при поддержке фонда Novo Nordisk Foundation и Датского фонда экспорта и инвестиций. В церемонии ввода Gefion в эксплуатацию, проходившей в Копенгагене, приняла участие Надя Карлстен (Nadia Carlsten), генеральный директор DCAI. Суперкомпьютер объединяет 191 систему DGX H100, что в общей сложности даёт 1528 ускорителей NVIDIA H100. Задействованы 382 процессора Intel Xeon Platinum и интерконнект NVIDIA Quantum-2 InfiniBand. Прочие технические характеристики, а также показатели быстродействия системы пока не раскрываются. Пиковая теоретическая FP64-производительность должна составить около 52 Пфлопс, а в FP8-расчётах с разреженностью — порядка 6 Эфлопс. Сообщается, что Gefion будет применяться для решения сложных задач в области квантовых вычислений, «зелёной» энергетики, биотехнологий и пр. В частности, исследователи из Копенгагенского университета (UCPH) намерены задействовать машину для проведения крупномасштабного распределённого моделирования квантовых компьютерных схем. Кроме того, UCPH, Технический университет Дании (DTU), Novo Nordisk и Novonesis совместно разработают многомодальную геномную ИИ-модель для анализа мутаций заболеваний и разработки вакцин. Доступ к Gefion также получат стартапы, реализующие перспективные проекты в области обработки текста, изображений и видео. Суперкомпьютер размещён в одном из дата-центров Digital Realty на территории Дании. Этот объект на 100 % получает питание от возобновляемых источников энергии. Сборкой и установкой вычислительного комплекса занимались специалисты Eviden.

02.06.2024 [16:20], Сергей Карасёв

NVIDIA представила ускорители GB200 NVL2, платформы HGX B100/B200 и анонсировала экосистему следуюшего поколения Vera RubinNVIDIA сообщила о широкой отраслевой поддержке своей архитектуры нового поколения Blackwell. Эти ускорители, а также чипы Grace легли в основу многочисленных систем для ИИ-фабрик и дата-центров, которые, как ожидается, будут способствовать «следующей промышленной революции». Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) объявил о том, что серверы на базе Blackwell выпустят ASRock Rack, ASUS, Gigabyte, Ingrasys, Inventec, Pegatron, QCT, Supermicro, Wistron и Wiwynn. Речь идёт об устройствах разного уровня, рассчитанных на облачные платформы, периферийные вычисления и ЦОД клиентов. «Началась очередная промышленная революция. Компании и целые страны сотрудничают с NVIDIA, чтобы трансформировать традиционные дата-центры общей стоимостью в триллионы долларов в платформы нового типа — фабрики ИИ», — говорит Хуанг. Для решения ИИ-задач и поддержания других ресурсоёмких приложений будут выпущены серверы с CPU на архитектурах х86 и Arm (изделия Grace) с воздушным и жидкостным охлаждением. Заказчикам будут доступны модели с одним и несколькими ускорителями. В частности, сама NVIDIA предлагает DGX-системы Blackwell, а для сторонних производителей доступны готовые платформы HGX B100 и HGX B200. Кроме того, компания представила ускоритель GB200 NVL2, т.е. сборку из двух GB200, объединённых NVLink 5. NVIDIA также сообщила о том, что модульная архитектура NVIDIA MGX отныне поддерживает Blackwell, включая и GB200 NVL2. В целом, NVIDIA MGX предлагает свыше 100 различных конфигураций. На сегодняшний день на базе MGX выпущены или находятся в разработке более 90 серверов от более чем 25 партнёров NVIDIA по сравнению с 14 системами от шести партнёров в 2023 году. В составе MGX, в частности, впервые будут использоваться изделия AMD EPYC Turin и чипы Intel Xeon 6 (ранее — Granite Rapids). Отмечается, что глобальная партнёрская экосистема NVIDIA включает TSMC, а также поставщиков различных компонентов, включая серверные стойки, системы электропитания, решения для охлаждения и пр. В число поставщиков такой продукции входят Amphenol, Asia Vital Components (AVC), Cooler Master, Colder Products Company (CPC), Danfoss, Delta Electronics и Liteon. Серверы нового поколения готовят Dell Technologies, Hewlett Packard Enterprise (HPE) и Lenovo. В скором времени NVIDIA представит улучшенные ускорители Blackwell Ultra, которые получат более современную HBM3e-память. А уже в следующем году компания покажет решения на архитектуре следующего поколения: ускорители Rubin, процессоры Vera, NVLink 6 с удвоенной пропускной способностью (3,6 Тбайт/с), коммутаторы X1600 и DPU SuperNIC CX9 для сетей 1,6 Тбит/с. |

|