Материалы по тегу: nvidia

|

17.09.2025 [23:52], Владимир Мироненко

Глава NVIDIA разочарован запретом Китая на покупку RTX Pro 6000D, но все вопросы будут решаться на высшем уровнеВ Китае вынесли запрет компаниям, включая ByteDance и Alibaba, на тестирование и размещение заказов на разработанный специально для Поднебесной ускоритель NVIDIA RTX Pro 6000D, сообщила в среду Financial Times со ссылкой на источники, знакомые с ситуацией. За несколько дней по итогам расследования Государственного управления по регулированию рынка Китая (SAMR) до власти обвинили NVIDIA в нарушении антимонопольного законодательства при покупке Mellanox. По словам источника, запрет Государственной канцелярии интернет-информации КНР (CAC) поступил после проведения сравнения чипов, изготавливаемых компаниями Huawei и Cambricon, а также Alibaba и Baidu, с продукцией NVIDIA. В итоге регулятор пришёл к выводу, что китайские ИИ-чипы достигли уровня, сопоставимого или превосходящего уровень продукции NVIDIA, разрешённой к экспорту в Китай. В прошлом месяце Financial Times сообщила о планах китайских производителей чипов утроить объём производства ИИ-ускорителей в стране в следующем году.

Источник изображения: NVIDIA | NVIDIA RTX PRO 6000 Blackwell Server Edition Ускоритель RTX Pro 6000D был представлен в июле во время визита гендиректора компании Дженсена Хуанга (Jensen Huang) в Пекин. Тогда же NVIDIA заявила, что Вашингтон ослабляет ранее введенный запрет на экспорт в страну ускорителей H20. Financial Times сообщила, что китайские регулирующие органы в ответ на ослабление ограничений со стороны США ужесточили контроль закупок H20, требуя от компаний предоставить обоснование решения купить эти чипы вместо отечественной продукции. При этом RTX Pro 6000D спросом не пользуется. Комментируя запрет Пекина, Дженсен Хуанг заявил, что разочарован этим. «Мы можем служить рынку, только если страна этого хочет», — сказал он. «Мы рекомендовали всем финансовым аналитикам не включать Китай» в финансовые прогнозы, заявил Хуанг, пояснив, что этот вопрос «в значительной степени будет обсуждаться правительствами США и Китая».

17.09.2025 [13:15], Сергей Карасёв

NVIDIA и партнёры развернут в Великобритании ИИ-фабрики со 120 тыс. ускорителей BlackwellКомпания NVIDIA, как и ожидалось, объявила о масштабных инвестициях в развитие ИИ-инфраструктуры в Великобритании. Инициатива будет реализовываться совместно с партнёрами, в число которых входят Microsoft, оператор ИИ-облака CoreWeave и британский поставщик ИИ-инфраструктуры Nscale. Речь идёт о создании ИИ-фабрик, которые смогут поддерживать наиболее ресурсоёмкие нагрузки, в том числе модели OpenAI. Предполагается, что создание таких площадок позволит Великобритании достичь своих государственных целей в области ИИ и развития инноваций. В рамках масштабного проекта NVIDIA и партнёры инвестируют до £11 млрд ($15 млрд) в расширение британских дата-центров. В общей сложности будут установлены 120 тыс. мощных ускорителей Blackwell Ultra, что станет крупнейшим подобным развёртыванием в истории Великобритании. Компании Nscale, OpenAI и NVIDIA участвуют в программе Stargate UK, предполагающей формирования платформы для передовых ИИ-моделей, в том числе GPT-5.

Источник изображения: NVIDIA Nscale и Microsoft также объявили о планах строительства самого мощного британского суперкомпьютера. Ожидается, что он будет оснащён более чем 24 тыс. ускорителей Grace Blackwell Ultra. Платформу планируется использовать в том числе для предоставления сервисов Microsoft Azure в Великобритании. Кроме того, NVIDIA поможет компании Nscale в масштабировании её инфраструктуры по всему миру: в общей сложности в глобальном масштабе (в США, Португалии, Норвегии и других странах) будут развёрнуты до 300 тыс. Grace Blackwell, включая 60 тыс. в Великобритании. Вместе с тем CoreWeave объявила о создании в Шотландии современного дата-центра на базе Grace Blackwell Ultra, получающего питание от возобновляемых источников энергии. Нужно также отметить, что ранее стало известно о планах американской компании BlackRock инвестировать до £500 млн ($678 млн) в расширение инфраструктуры дата-центров в Великобритании. Кроме того, Google намерена вложить £5 млрд ($6,8 млрд) в развитие ИИ в этой стране.

17.09.2025 [13:15], Руслан Авдеев

Собственный ЦОД Stargate и крупнейший в стране ИИ-суперкомпьютер: американские IT-гиганты вложат более $40 млрд в развитие ИИ в Великобритании

coreweave

google

hardware

microsoft

nscale

nvidia

openai

salesforce

stargate

великобритания

ии

инвестиции

суперкомпьютер

сша

финансы

цод

Microsoft объявила о намерении вложить около $30 млрд в ИИ-проекты на территории Великобритании к 2028 году. $15,5 млрд уйдёт на капитальное расширение в течение трёх лет, а $15,1 млрд — на операции в стране, сообщает CNBC. В частности, инвестиции позволят построить «крупнейший суперкомпьютер» в Великобритании с более 23 тыс. передовых ускорителей (24 тыс. по данным NVIDIA) совместно с британской Nscale. Дата запуска не раскрывалась, но в Nscale ранее объявляли, что новый ЦОД компании заработает в 2026 году и обеспечит доступ к 46 тыс. ускорителей. Планируемая мощность составляет 50 МВт, а всего на площадку выделено 90 МВт. На фоне государственного визита в Великобританию президента США Дональда Трампа (Donald Trump), инвестировать в развитие ИИ в стране пообещали NVIDIA, Google, OpenAI и Salesforce, общая сумма превысит $40 млрд. Эксперты ожидают, что премьер-министр Великобритании Кир Стармер и Дональд Трамп подпишут 17 сентября новое соглашение, открывая путь к инвестициям и сотрудничеству в сфере ИИ, квантовых и ядерных технологий. Президент Microsoft Брэд Смит (Brad Smith) заявил, что его позиция в отношении Великобритании «потеплела» с годами, ранее он критиковал Соединённое Королевство за попытку заблокировать в 2023 году сделку Microsoft по покупке Activision-Blizzard за $69 млрд. Впрочем, в том же году она была одобрена. По словам Смита, его воодушевляют сделанные правительстовм в последние несколько лет шаги для улучшения делового климата — ещё несколько лет назад подобные инвестиции были бы немыслимы из-за действующих норм и практики. Кроме того, не было спроса на такие вложения в ИИ. NVIDIA уже объявила о намерении вложить в Великобританию совместно с Nscale и CoreWeave £11 млрд ($15 млрд). NVIDIA намерена разместить в Соединённом Королевстве 120 тыс. ИИ-ускорителей Blackwell, это станет крупнейшим в этом роде проектом компании в Европе. Утверждается, что это сделает Великобританию действительно «производителем ИИ, а не потребителем».

Источник изображения: chan lee/unsplash.com Инвестировать в ИИ-проекты в Великобритании £5 млрд ($6,8 млрд) намерена Google. Компания откроет новый ЦОД в 19 километрах от центра Лондона. В Google уверены, что новый дата-центр поможет удовлетворить спрос на сервисы компании с ИИ-элементами: Google Cloud, Workspace, Search и Maps. Предполагается, что инвестиции позволят ежегодно создавать 8250 рабочих мест в британских компаниях. Значительный вклад внесёт и OpenAI благодаря проекту Stargate UK. Речь идёт о специализированной местной версии масштабного проекта, совместно реализуемого с SoftBank и Oracle. В Великобритании ИИ-стартап будет сотрудничать над проектом с Nscale и NVIDIA. OpenAI уже заявила, что в начале 2026 года для внедрения в Великобритании будут развёрнуты 8 тыс. ИИ-ускорителей с возможностью расширения мощностей до 31 тыс. в будущем. Первая крупная стройка для Stargate UK запланирована на территории Cobalt Park в Ньюкасле (Newcastle) на севере Англии. Salesforce объявила о планах увеличить инвестиции в Великобритании до $6 млрд, увеличив обязательства в сравнении с 2023 годом до $4 млрд. В Salesforce подчеркнули, что визит Трампа в Великобританию подтверждает важность отношений между Великобританией и США. Наконец, CoreWeave объявила о дополнительных инвестициях в размере £1,5 млрд для увеличения мощности своего ИИ ЦОД в стране. Благодаря этому обязательству общий объем инвестиций CoreWeave в этой стране достигнет £2,5 млрд. Суммарный объём инвестиций IT-гигантов превысит $40 млрд.

16.09.2025 [18:07], Владимир Мироненко

NVIDIA отказалась от активного развития собственного ИИ-облака DGX CloudNVIDIA отказалась от первоначальных планов относительно будущего облачной платформы DGX Cloud, запущенной в 2023 году в партнёрстве с ведущими облачными провайдерами, для которых оно было не очень-то и выгодно. Как сообщает Data Center Dynamics со ссылкой The Information, NVIDIA прекратила предлагать платформу новым клиентам из-за более высоких цен по сравнению с предложениями самих облачных провайдеров и теперь в основном использует её для нужд собственных исследовательских подразделений. Ранее NVIDIA планировала получить $150 млрд дохода от своего облачного бизнеса и даже собиралась арендовать ЦОД для поддержания его работы. Но в отчёте о финансовых результатах NVIDIA за II квартал 2026 финансового года больше нет упоминания DGX Cloud в расходах на облако, как это было в предыдущих кварталах. Вместе с тем в компании выразили несогласие с публикацией The Information по поводу того, что сервис не оправдал ожиданий. «DGX Cloud пользуется большим успехом как облако для собственных исследований и разработок NVIDIA в области ИИ, а также как своего рода “песочница”, в которой мы работаем с облачными партнёрами над оптимизацией их вычислительных стеков и с их разработчиками ИИ-стеков на основе CUDA», — сообщила Алексис Блэк Бьорлин (Alexis Black Bjorlin), руководитель DGX Cloud, изданию The Information. Она подчеркнула, что спрос в разрезе подразделений NVIDIA остаётся высоким, и компания продолжает расширять мощности DGX Cloud. Более того, у сервиса продолжают появляться новые клиенты. В частности, стартап SandboxAQ, работающий в области квантовых вычислений и ИИ, в который инвестировала NVIDIA, сообщил в апреле об использовании для своих разработок DGX Cloud. Ранее в этом году NVIDIA представила DGX Cloud Lepton — торговую площадку, предназначенную для использования разработчиками ускорителей от таких поставщиков, как CoreWeave, SoftBank и Yotta Data Services. Несмотря на то, что это решение открыло новые способы доступа к вычислительным мощностям, оно всё же вызвало конфликты с представителями инфраструктурного бизнеса, расценившими это как попытку NVIDIA найти пути общения с их клиентами напрямую, отметил ресурс Data Center Dynamics. Тем не менее, сервис DGX Cloud Lepton позволил более мелким поставщикам оставаться в экосистеме NVIDIA. Для разработчиков переход с DGX Cloud на Lepton означает более доступную вычислительную мощность по конкурентоспособным ценам в уже используемых ими облаках, а для NVIDIA — меньше конфликтов между каналами продаж и более строгий контроль над потоком рабочих нагрузок GPU по всему миру, отмечает Tom's Hardware.

16.09.2025 [13:19], Сергей Карасёв

Китайский регулятор обвинил NVIDIA в нарушении антимонопольного законодательства при покупке MellanoxГосударственное управление по регулированию рынка Китая (SAMR), по сообщению Datacenter Dynamics, обвинило NVIDIA в нарушении антимонопольного законодательства. Речь идёт о сделке по покупке израильского поставщика сетевого оборудования Mellanox. О намерении NVIDIA приобрести Mellanox стало известно в марте 2019 года, но осуществить слияние удалось только в апреле 2020-го, поскольку ожидалось одобрение со стороны регулирующих органов КНР. Стоимость сделки составила $6,9 млрд. Одним из условий соглашения с властями КНР было то, что NVIDIA продолжит поставлять на китайский рынок ускорители на базе GPU. Однако администрация США запрещает NVIDIA отгружать передовые продукты в Китай. Американское правительство выражает обеспокоенность тем, что китайские военные могут использовать мощные ускорители для разработки оружия. Впрочем, несмотря на экспортные ограничения, передовые продукты NVIDIA всё же поступают в Китай обходными путями. На фоне сложившейся ситуации в конце прошлого года Китай инициировал антимонопольное расследование против NVIDIA в рамках сделки по поглощению Mellanox. По заявлениям SAMR, NVIDIA нарушила антимонопольное законодательство, не выполнив в полном объёме положения, определённые регулятором при одобрении сделки. По мнению некоторых экспертов, антимонопольное расследование китайских властей в отношении NVIDIA может знаменовать собой начало реализации систематической «стратегии возмездии». Регулятор Китая может налагать штрафы в размере от 1 % до 10 % от годового объема продаж компании за предыдущий год в случае нарушения антимонопольных требований. На днях представители правительств США и Китая встретились в Мадриде с целью обсуждения торговых отношений. В частности, на повестке стоят вопросы экспортных ограничений. Однако обвинения со стороны SAMR в адрес NVIDIA могут осложнить ситуацию.

16.09.2025 [09:00], Владимир Мироненко

NVIDIA обязалась выкупить у CoreWeave все нераспроданные ИИ-мощности за $6,3 млрдCoreWeave подписала с NVIDIA новый контракт в рамках генерального соглашения от 10 апреля 2023 года, согласно которому чипмейкер обязуется выкупить все нераспроданные CoreWeave облачные вычислительные мощности. Контракт с начальной суммой в размере $6,3 млрд действует до 13 апреля 2032 года. Об этом стало известно из документа, направленного CoreWeave в Комиссию по ценным бумагам и биржам США (SEC). На прошлой неделе NVIDIA также заключила два соглашения с Lambda общей стоимостью $1,5 млрд об аренде собственных чипов (до 18 тыс. единиц) в течение следующих четырёх лет. На фоне этой новости акции CoreWeave выросли на 8 %, поскольку для инвесторов эта сделка означает укрепление позиций компании в качестве ключевого партнёра NVIDIA в сфере облачных вычислений и служит ей своего рода защитой в случае возможного снижения спроса на вычислительные мощности для ИИ-нагрузок, пишет Reuters. «Мы считаем это позитивным фактором для CoreWeave, учитывая опасения инвесторов относительно способности компании заполнить мощности центров обработки данных за пределами двух крупнейших клиентов (Microsoft и OpenAI)», — отметили аналитики Barclays. Точный объём вычислительных мощностей не разглашается. Ранее NVIDIA уже заключала с CoreWeave соглашения об аренде её вычислительных мощностей, став вторым по величине заказчиком неооблака. Ключевым же заказчиком (62 % выручки в 2024 году) была Microsoft, которая арендовала мощности в первую очередь для OpenAI. В свою очередь CoreWeave заключила в марте с OpenAI пятилетний контракт на сумму $11,9 млрд. Спустя пару месяцев ими было подписано дополнительное соглашение на аренду вычислительных мощностей на сумму в $4 млрд сроком до апреля 2029 года. Непростые отношения Microsoft и OpenAI потенциально могут негативно сказаться на бизнесе CoreWeave. Вместе с тем активное развитие инфраструктуры на фоне высокого спроса на ИИ-вычисления привело к рекордному росту капзатрат CoreWeave, составивших во II квартале $2,9 млрд. С целью финансовой поддержки и сопровождения проектов в сфере ИИ компания сформировала венчурное подразделение.

15.09.2025 [13:43], Сергей Карасёв

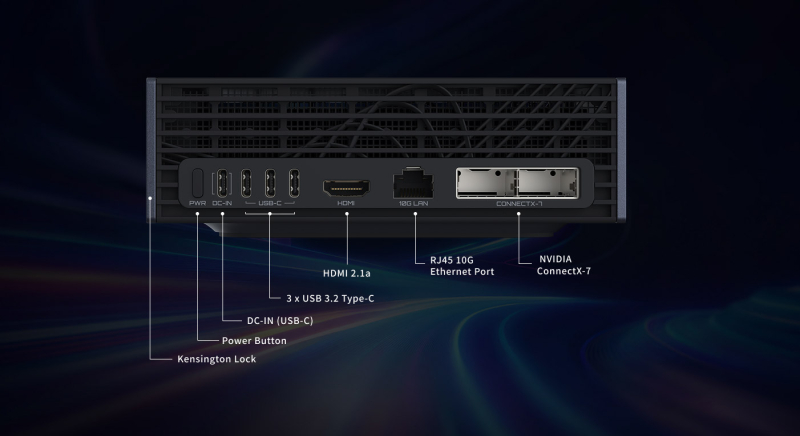

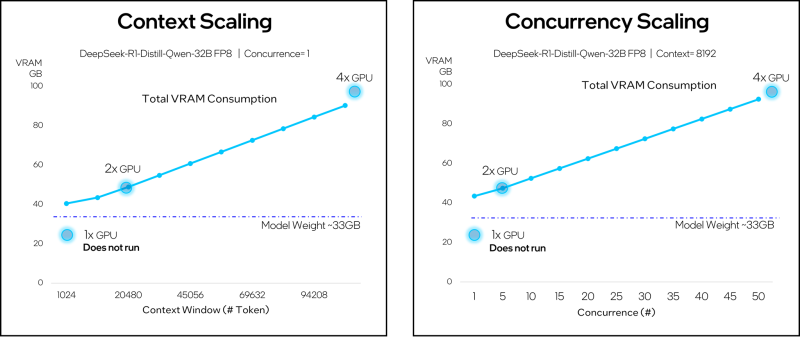

Gigabyte выпустила компактный ИИ ПК AI Top Atom на базе суперчипа NVIDIA GB10Компания Gigabyte анонсировала компактный ИИ-суперкомпьютер AI Top Atom — рабочую станцию небольшого форм-фактора, первая информация о подготовке которой появилась в мае нынешнего года на выставке Computex. Устройство может использоваться для локального запуска передовых ИИ-моделей. Новинка построена на суперчипе NVIDIA GB10 Grace Blackwell, который содержит 20-ядерный процессор Grace (10 × Arm Cortex-X925 и 10 × Arm Cortex-A725) и ускоритель Blackwell. Предусмотрено 128 Гбайт унифицированной системной памяти LPDDR5x с пропускной способностью 273 Гбайт/с. ИИ-производительность на операциях FP4 достигает 1000 TOPS. Рабочая станция оборудована контроллерами Wi-Fi 7 и Bluetooth 5.3, а также адаптерами 10GbE и NVIDIA ConnectX-7 SmartNIC. Установлен SSD с интерфейсом PCIe 5.0 (NVMe) вместимостью до 4 Тбайт. В набор разъёмов входят гнездо RJ45 для сетевого кабеля, порт USB 3.2 Gen 2x2 Type-C (PD), три порта USB 3.2 Gen 2x2 Type-C и коннектор HDMI 2.1a. Устройство заключено в корпус с размерами 150 × 150 × 50,5 мм, а масса составляет около 1,2 кг. В комплект поставки включён блок питания мощностью 240 Вт. Применяется программная платформа NVIDIA DGX OS — модификации Ubuntu, предназначенная специально для задач ИИ. Компактный ИИ-суперкомпьютер AI Top Atom допускает работу с ИИ-моделями, насчитывающими до 200 млрд параметров. Более того, посредством ConnectX-7 два таких устройства быть объединены в одну систему, что позволит запускать ИИ-модели с 405 млрд параметров. Новинка ориентирована на разработчиков ИИ, энтузиастов, исследователей и специалистов по анализу данных. Впрочем, у всех новинок на базе GB10 идентичные характеристики, а отличия между решениями разных вендоров в большей степени косметические.

15.09.2025 [08:53], Сергей Карасёв

Biostar выпустила индустриальные компьютеры EdgeComp MS-NANX 8G/16G на базе NVIDIA Jetson Orin NXКомпания Biostar анонсировала компьютеры небольшого форм-фактора EdgeComp MS-NANX 8G/16G, предназначенные для выполнения ИИ-задач на периферии. Устройства подходят для таких приложений, как удалённый мониторинг оборудования, предиктивное обслуживание, визуальный контроль, промышленная автоматизация, системы умного города и пр. Основой компьютеров служит модуль NVIDIA Jetson Orin NX в вариантах с 8 и 16 Гбайт памяти LPDDR5. В первом случае задействованы шесть CPU-ядер Arm Cortex-A78AE, во втором — восемь. Кроме того, в состав обоих изделий входит графический блок на архитектуре NVIDIA Ampere с 1024 ядрами. ИИ-производительность на операциях INT8 (Sparse) достигает соответственно 70 и 100 TOPS. Устройства наделены слотом M.2 Key-E 2230 для адаптера Wi-Fi/Bluetooth, коннектором M.2 Key-B 3042/3052 для сотового модема 4G/5G (плюс разъём Nano SIM) и слотом M.2 Key-M 2242/2260/2280 для NVMe SSD. Присутствуют сетевые контроллеры 1GbE и 2.5GbE с опциональной поддержкой PoE. Имеются два гнезда RJ45 для сетевых кабелей, два последовательных порта (RS232/CAN и RS232/422/485), четыре порта USB 3.2 Type-A и комбинированное аудиогнездо на 3,5 мм. Компьютеры заключены в прочный корпус, ребристая верхняя часть которого выполняет функции радиатора для рассеяния тепла (применяется пассивное охлаждение). Габариты составляют 160 × 102 × 80 мм. Диапазон рабочих температур простирается от -20 до +50 °C. Питание 12–20 В подаётся через DC-разъём или 2-контактный терминальный разъём. Подчёркивается, что устройства спроектированы специально для интеграции в промышленные, коммерческие и государственные среды. Заявлена совместимость с Linux (NVIDIA Jetpack 6.2).

12.09.2025 [23:30], Владимир Мироненко

Благодаря NVIDIA доля Arm на рынке серверных процессоров достигла 25 %Стремительный рост вычислительных мощностей ЦОД на фоне бума ИИ-технологий способствовал росту доходов не только производителей ускорителей и серверных CPU, но и компании Arm, чью архитектуру они используют в своих чипах, передаёт The Register. В январе Arm заявила о намерении занять 50 % рынка чипов для ЦОД к концу 2025 года Согласно исследованию Dell’Oro Group, во II квартале доля Arm-чипов на рынке серверных CPU составила 25 %, тогда как годом ранее она равнялась 15 %. Движущей силой роста стало внедрение суперускорителей NVIDIA GB200 NVL72 и GB300 NVL72, которые включают 36 Arm-процессоров Grace на базе архитектуры Neoverse V2 (Demeter) с интерфейсом NVLink-C2C. Заказы на поставку чипов NVIDIA расписаны на месяцы вперёд, что обеспечивает гарантированный источник доходов Arm наряду с ростом доли на рынке. Аналитик Dell’Oro Барон Фунг (Baron Fung) сообщил The Register, что ещё год назад рост Arm на рынке серверных процессоров обеспечивался практически исключительно за счёт кастомных CPU, таких как AWS Graviton. Но теперь выручка от продаж Grace сопоставима с доходами от облачных GPU. AWS использует кастомные процессоры на архитектуре Arm с 2018 года. А Microsoft и Google лишь в последние несколько лет начали всерьёз развивать свои Arm-процессорах Cobalt и Axion соответственно, отметил The Register. Рост доли Arm на рынке зависит от того, насколько больше разработчиков чипов выведет свои чипы на рынок серверных процессоров. NVIDIA сейчас работает над новым процессором на базе Arm с использованием кастомных ядер Vera. Qualcomm и Fujitsu также работают над серверными чипами. А появление NVIDIA NVLink Fusion может привести к созданию новых гибридных чипов. По данным Dell’Oro, рост рынка ИИ-технологий также привёл к росту рынка компонентов для серверов и СХД, составившему во II квартале 44 % в годовом исчислении. Продажи SmartNIC и DPU, которые зачастую тоже используют Arm-ядра, примерно удвоились по сравнению с прошлым годом на фоне перехода на Ethernet для вычислительных ИИ-кластеров. Поставки ASIC для обработки ИИ-нагрузок сейчас сопоставимы с объёмами поставок GPU, хотя GPU по-прежнему приносят большую часть доходов.

12.09.2025 [23:07], Владимир Мироненко

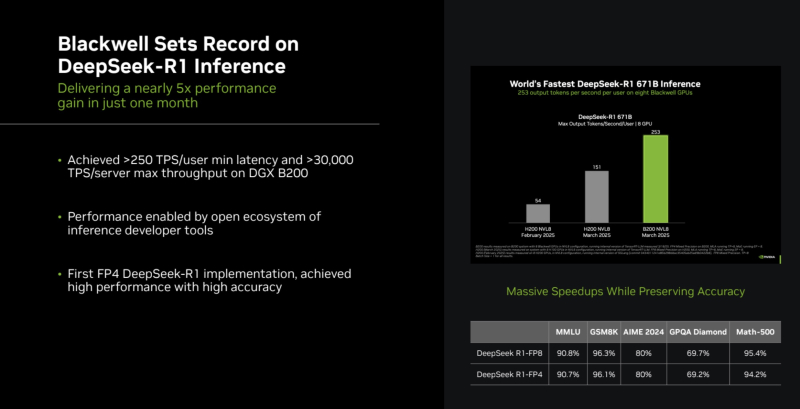

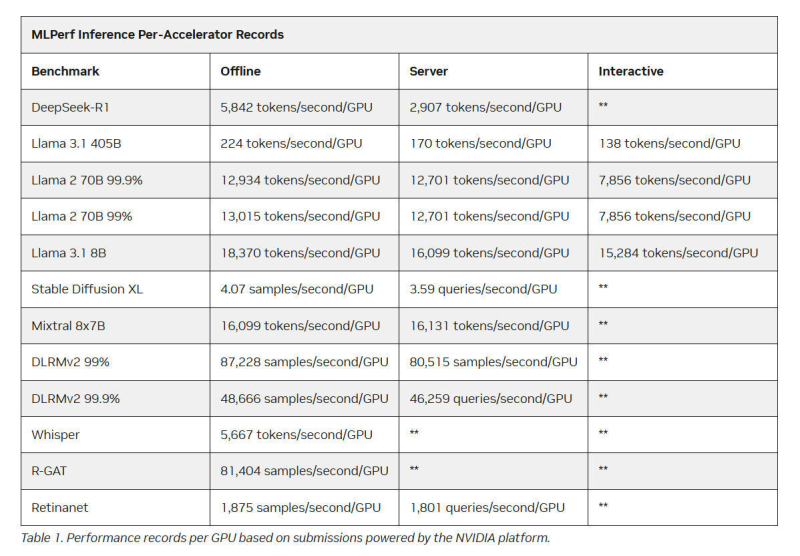

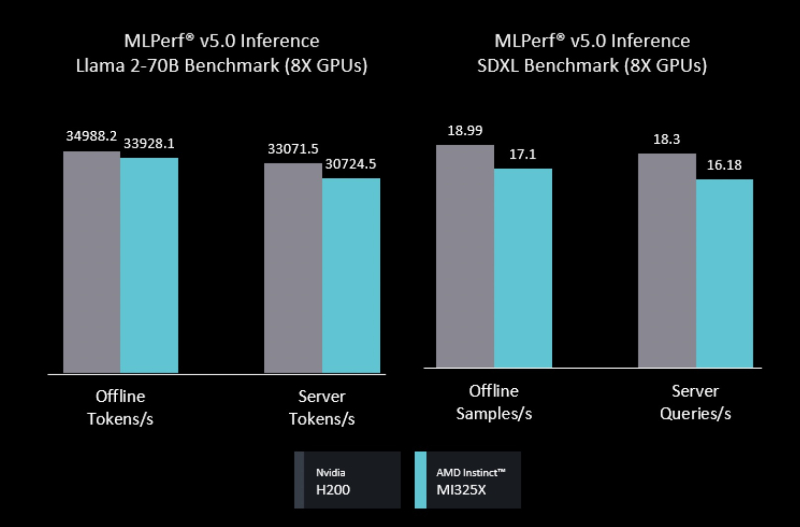

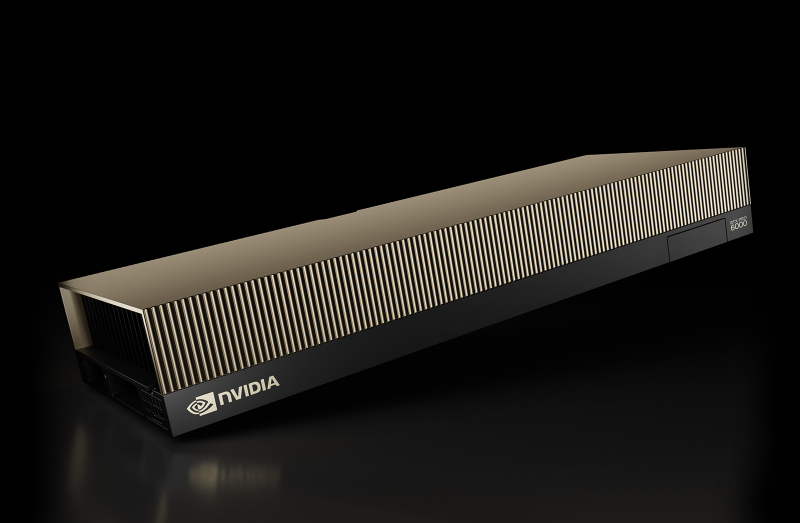

Intel Arc Pro впервые поучаствовали в бенчмарках MLPerf Inference, но в лидерах предсказуемо осталась NVIDIAMLCommons объявил результаты набора бенчмарков MLPerf Inference v5.1. Последний раунд демонстрирует, насколько быстро развивается инференс и соответствующие бенчмарки, пишет ресурс HPCwire. В этом раунде было рекордное количество заявок — 27. Представлены результаты сразу пяти новых ускорителей: AMD Instinct MI355X, Intel Arc Pro B60 48GB Turbo, NVIDIA GB300, NVIDIA RTX 4000 Ada 20GB, NVIDIA RTX Pro 6000 Blackwell Server Edition. Всего же количество результатов MLPerf перевалило за 90 тыс. результатов. В текущем раунде были представлены три новых бенчмарка: тест рассуждений на основе модели DeepSeek-R1, тест преобразования речи в текст на основе Whisper Large v3 и небольшой тест LLM на основе Llama 3.1 8B. Как отметил ресурс IEEE Spectrum, бенчмарк на основе модели Deepseek R1 671B (671 млрд параметров), более чем в 1,5 раза превышает самый крупный бенчмарк предыдущего раунда на основе Llama 3.1 405B. В модели Deepseek R1, ориентированной на рассуждения, большая часть вычислений выполняется во время инференса, что делает этот бенчмарк ещё более сложным. Что касается самого маленького бенчмарка, основанного на Llama 3.1 8B, то, как поясняют в MLCommons, в отрасли растёт спрос на рассуждения с малой задержкой и высокой точностью. SLM отвечают этим требованиям и являются отличным выбором для таких задач, как реферирование текста или периферийные приложения. В свою очередь бенчмарк преобразования голоса в текст, основанный на Whisper Large v3, был разработан в ответ на растущее количество голосовых приложений, будь то смарт-устройства или голосовые ИИ-интерфейсы. NVIDIA вновь возглавила рейтинг MLPerf Inference, на этот раз с архитектурой Blackwell Ultra, представленной платформой NVIDIA GB300 NVL72, которая установила рекорд, увеличив пропускную способность DeepSeek-R1 на 45 % по сравнению с предыдущими системами GB200 NVL72 (Blackwell). NVIDIA также продемонстрировала высокие результаты в бенчмарке Llama 3.1 405B, который имеет более жёсткие ограничения по задержке. NVIDIA применила дезагрегацию, разделив фазы работы с контекстом и собственно генерацию между разными ускорителями. Этот подход, поддерживаемый фреймворком Dynamo, обеспечил увеличение в 1,5 раза пропускной способности на один ускоритель по сравнению с традиционным обслуживанием на системах Blackwell и более чем в 5 раз по сравнению с системами на базе Hopper. NVIDIA назвала «дезагрегированное обслуживание» одним из ключевых факторов успеха, помимо аппаратных улучшений при переходе к Blackwell Ultra. Также свою роль сыграло использованием фирменного 4-бит формата NVFP4. «Мы можем обеспечить точность, сопоставимую с BF16», — сообщила компания, добавив, что при этом потребляется значительно меньше вычислительной мощности. Для работы с контекстом NVIDIA готовит соускоритель Rubin CPX. В более компактных бенчмарках решения NVIDIA также продемонстрировали рекордную пропускную способность. Компания сообщила о более чем 18 тыс. токенов/с на один ускоритель в бенчмарке Llama 3.1 8B в автономном режиме и 5667 токенов/с на один ускоритель в Whisper. Результаты были представлены в офлайн-, серверных и интерактивных сценариях, при этом NVIDIA сохранила лидерство в расчете на GPU во всех категориях. AMD представила результаты AMD Instinct MI355X только в «открытой» категории, где разрешены программные модификации модели. Ускоритель MI355X превзошёл в бенчмарке Llama 2 70B ускоритель MI325X в 2,7 раза по количеству токенов/с. В этом раунде AMD также впервые обнародовала результаты нескольких новых рабочих нагрузок, включая Llama 2 70B Interactive, MoE-модель Mixtral-8x7B и генератор изображений Stable Diffusion XL. В число «закрытых» заявок AMD входили системы на базе ускорителей AMD MI300X и MI325X. Более продвинутый MI325X показал результаты, схожие с показателями систем на базе NVIDIA H200 на Llama 2 70b, в комбинированном тесте MoE и тестах генерации изображений. Кроме того, компанией была представлена первая гибридная заявка, в которой ускорители AMD MI300X и MI325X использовались для одной и той же задачи инференса — бенчмарка на базе Llama 2 70b. Возможность распределения нагрузки между различными типами ускорителей — важный шаг, отметил IEEE Spectrum. В этом раунде впервые был представлен и ускоритель Intel Arc Pro. Для бенчмарков использовалась видеокарта MaxSun Intel Arc Pro B60 Dual 48G Turbo, состоящая из двух GPU с 48 Гбайт памяти, в составе платформы Project Battlematrix, которая может включать до восьми таких ускорителей. Система показала результаты на уровне NVIDIA L40S в небольшом тесте LLM и уступила ему в тесте Llama 2 70b. Следует также отметить, что в этом раунде, как и в предыдущем, участвовала Nebius (ранее Yandex N.V.). Компания отметила, что результаты, полученные на односерверных инсталляциях, подтверждают, что Nebius AI Cloud обеспечивает «высочайшие» показатели производительности для инференса базовых моделей, таких как Llama 2 70B и Llama 3.1 405B. В частности, Nebius AI Cloud установила новый рекорд производительности для NVIDIA GB200 NVL72. По сравнению с лучшими результатами предыдущего раунда, её однохостовая инсталляция показала прирост производительности на 6,7 % и 14,2 % при работе с Llama 3.1 405B в автономном и серверном режимах соответственно. «Эти два показателя также обеспечивают Nebius первое место среди других разработчиков MLPerf Inference v5.1 для этой модели в системах GB200», — сообщила компания. |

|