Материалы по тегу: gb300

|

15.10.2025 [23:05], Владимир Мироненко

Microsoft арендует у Nscale ещё 116 тыс. ускорителей NVIDIA GB300Nscale и Microsoft заключили расширенное соглашение о предоставлении гиперскейлеру ИИ-инфраструктуры в США и Европе — 116,6 тыс. ускорителей на базе платформы NVIDIA GB300, сообщил Data Center Dynamics. Microsoft, как и другие крупные технологические компании, нуждается в увеличении вычислительных мощностей для удовлетворения растущего спроса на ИИ-технологии. С учётом более ранних контрактов Microsoft получит от Nscale почти 200 тыс. ускорителей. Nscale развернёт в течение следующих 12–18 мес. около 104 тыс. ускорителей в ЦОД Cedarvale в Барстоу (Barstow, шт. Техас), который она арендует у биткоин-майнера Ionic Digital в рамках десятилетнего соглашения стоимостью $2 млрд. На начальном этапе мощность инфраструктуры составит 240 МВт (хотя в пресс-релизе Ionic указано 234 МВт), а поэтапное предоставление её услуг Microsoft начнётся в III квартале 2026 года, сообщила Nscale. Nscale планирует в дальнейшем постепенно увеличить мощность объекта до 1,2 ГВт, при этом у Microsoft есть опцион на вторую фазу мощностью 700 МВт, начиная с конца 2027 года. В рамках соглашения Nscale также предоставит Microsoft для использования вычислительные мощности на базе до 12,6 тыс. ускорителей в кампусе Start Campus в Синише (Sines, Португалия). Монтаж оборудования здесь начнётся в I квартале 2026 года. На данный момент в эксплуатации находится один дата-центр кампуса, введённый в строй в январе 2025 года — SIN01. Сейчас ведётся строительство объекта SIN02 мощностью 180 МВт. Суммарно кампус будет включать шесть ЦОД. Nscale и Microsoft не назвали точную стоимость последних сделок, но исходя из аналогичной стоимости контракта на один ускоритель, их общая стоимость составляет до $14 млрд, сообщил ресурс The Financial Times. Ранее крупнейший среди неооблаков контракт был подписан между Microfoft и CoreWeave в интересах OpenAI, которая после разлада с Microsoft теперь напрямую закупает мощности у CoreWeave. В этом году Microsoft уже подписала сделки на аренду ИИ-мощностей с Nebius, Lambda и Nscale на общую сумму порядка $33 млрд. Новые сделки Nscale с Microsoft расширяют контракт стоимостью $6,2 млрд, в рамках которого Microsoft арендует вычислительные мощности на базе 52 тыс. ускорителей NVIDIA на объекте Nscale в Норвегии. Nscale и Microsoft также заняты реализацией крупного проекта в Великобритании. В прошлом месяце компании объявили о планах строительства самого мощного британского ИИ-суперкомпьютера в будущем ЦОД Nscale в Лоутоне (Loughton, граф. Эссекс), который, как ожидается, будет оснащён не менее 23 тыс. чипов Grace Blackwell Ultra. Но и от строительства собственных ИИ ЦОД Microsoft не отказывается.

10.10.2025 [14:50], Руслан Авдеев

Не для себя стараемся: Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72Microsoft представила первый в мире ИИ-кластер, использующий более 4,6 тыс. NVIDIA Blackwell Ultra в составе суперускорителей NVIDIA GB300 NVL72, объединённых интерконнектом Quantum-X800 InfiniBand. Этот кластер — лишь первый из многих. Компания развернёт сотни тысяч ускорителей Blackwell Ultra в ИИ ЦОД по всему миру. Благодаря им Microsoft намерена стать первой, поддерживающей обучение для моделей с сотнями триллионов параметров. Как сообщают в Microsoft, запуск в Microsoft Azure суперкластера NVIDIA GB300 NVL72 стал важным шагом в развитии передовых ИИ-технологий. Разработанная совместно с NVIDIA система представляет собой первый в мире масштабируемый ИИ-кластер на основе GB300, обеспечивающий вычислительные мощности, необходимые OpenAI для обслуживания моделей с триллионами параметров. Речь идёт о новом стандарте ускоренных вычислений, говорят компании. Новые инстансы Azure ND GB300 v6 оптимизированы для рассуждающих моделей, агентных систем и мультимодального генеративного ИИ. Каждая стойка GB300 NVL72 обслуживает 18 виртуальных машин, а сам суперускоритель с производительностью до 1,44 Эфлопс (FP4 Tensor Core) включает:

Источник изображения: Microsoft Создание передовой инфраструктуры требует переосмысления всех уровней системы, включая вычисления, память, системы охлаждения и питания, ЦОД в целом как единой структуры. Новая архитектура стоек обеспечивает высокую пропускную способность инференса при меньших задержках на крупных моделях, это позволяет агентным и мультимодальным ИИ-системам быть более масштабируемыми и эффективными, чем когда-либо, говорит компания. Для масштабирования за пределы стойки используется NVIDIA Quantum-X800 InfiniBand, что гарантирует обучения сверхбольших моделей с применением десятков тысяч ИИ-ускорителей с минимальными накладными расходами на их синхронизацию, что дополнительно повышает производительность.

Источник изображения: Microsoft Передовые системы охлаждения Azure используют автономные теплообменники, чтобы свести к минимуму расход воды и поддерживать температурную стабильность для высокоплотных кластеров. Также продолжается разработка и внедрение новых моделей распределения питания, обеспечивающих высокую энергетическую плотность и динамический баланс нагрузок. Дополнительную помощь в оптимизации работы оказывает и модернизированное программное обеспечение. Ранее Microsoft обладала эксклюзивными правами на предоставление облачных сервисов компании OpenAI, но в январе 2025 года появилась новость, что ИИ-стартапу разрешили пользоваться и облаками других провайдеров, если у Microsoft не хватит собственных мощностей. Разногласия между компаниями продолжают нарастать. Формально первенство по создание кластера на базе GB300 NVL72 принадлежит CoreWeave, имеющей тесные отношения с NVIDIA и обслуживающей OpenAI — как напрямую, так и при посредничестве Microsoft.

02.10.2025 [21:02], Владимир Мироненко

Microsoft потратит $33 млрд на доступ к 100+ тыс. NVIDIA GB300 в неооблаках, но со временем хочет перейти на свои ИИ-ускорителиВ Сети появились новые подробности о сделке стоимостью до $19,4 млрд, заключённой Microsoft с Nebius Group NV в начале сентября. Как сообщает Bloomberg со ссылкой на информированные источники, Microsoft получит пятилетний доступ к выделенной инфраструктуре на базе более чем 100 тыс. суперускорителей NVIDIA GB300. Ранее сообщалось, что речь идёт о мощностях нового ЦОД Nebius в Вайнленде (Нью-Джерси, США). Как пишет Forbes, Nebius отличается от многих облачных провайдеров тем, что фокусируется только на рабочих нагрузках ИИ и МО, что позволяет лучше оптимизировать архитектуру ЦОД в отличие от гиперскейлеров, которые занимаются решением множества задач. Кроме того, Nebius отличается от других неооблаков, таких как CoreWeave, тем, что предоставляет инструменты и сервисы для разработчиков, которые позволяют совершенствовать ИИ-модели, выполнять инференс и разрабатывать кастомные решения, а не просто фокусируется на «чистой» вычислительной мощности. При этом Nebius начала наращивать вычислительные мощности ещё до того, как возник спрос на эти ресурсы, отметил Forbes. Подобные контракты Microsoft заключила с ещё несколькими неооблаками (neocloud), включая CoreWeave, Nscale и Lambda, на общую сумму в $33 млрд, и они обеспечивают её большую выгоду. Вместо того, чтобы тратить огромные ресурсы на строительство собственных ЦОД, Microsoft обращается к проверенному поставщику ИИ-инфраструктуры, благодаря чему может быстрее совершенствовать свою ИИ-инфраструктуру с меньшими первоначальными затратами, используя высвободившиеся мощности для предоставления клиентам прибыльных услуг на базе ИИ. Вдобавок такой подход позволяет Microsoft быстрее менять стратегию, чем при использовании собственных дата-центров. В начале бума ИИ Microsoft арендовала мощности даже у Oracle, своего прямого конкурента, для поддержки ИИ-функций в поиске Bing. Эти сделки также устраняют для Microsoft значительную часть финансовых рисков, связанных со строительством собственных ЦОД. Она не только сразу получает необходимые мощности для своих ИИ-сервисов, вместо того чтобы тратить годы на строительство ЦОД, но и перекладывает на других вопросы строительства, финансирования и управление этими ЦОД, что даёт компании большую финансовую гибкость. Так, Microsoft может отнести некоторые затраты к операционным, а не капитальным, что, по словам аналитика Bernstein Марка Мёрдлера (Mark Moerdler), даёт потенциальные преимущества для денежного потока, налогообложения и способа представления прибыли в финотчётах. Компания использует серверы неооблаков не только для обучения ИИ-моделей, но и для сложного инференса. Сделки с неооблаками становятся популярными и у конкурентов Microsoft, хотя им далеко до её масштабов. В мае 2025 года OpenAI расширила с конкурирующей с Nebius компанией CoreWeave контракт стоимостью $11,9 млрд на $4 млрд, после чего заключила ещё одно соглашение на $6,5 млрд, увеличив общую сумму соглашений до $22,4 млрд. Ещё один технологический гигант Meta✴ подписал сделку с CoreWeave на сумму в $14,2 млрд, обеспечив себе доступ к её облачным ИИ-сервисов на период до 2031 года. Вместе с тем в долгосрочной перспективе Microsoft намерена переключиться на ИИ-ускорители собственной разработки, которые обеспечивают лучший показатель TCO, передаёт CNBC. Два года назад компания представила первые ИИ-чипы Maia 100. Следующее поколение этих чипов, как ожидается, появится в 2026 году. При этом компания сосредоточится не на чипах в отдельности, а будет использовать более системный подход, учитывающий вопросы охлаждения, интерконнекта и т.д. Пока что, признаёт Microsoft, в течение многих лет решения NVIDIA обеспечивали лучшее соотношение цены к производительности.

28.09.2025 [12:30], Сергей Карасёв

«Зелёная» энергия для «зелёных» ускорителей: Lambda и ECL впервые запитали NVIDIA GB300 NVL72 от водородаОблачный провайдер Lambda и стартап ECL объявили о развёртывании первых в отрасли систем NVIDIA GB300 NVL72 с питанием от водорода. Высокопроизводительная платформа предназначена для обучения базовых ИИ-моделей, инференса и других ресурсоёмких задач. ECL специализируется на создании автономных модульных дата-центров с питанием от водорода, при возведении которых применяются технологии 3D-печати. Первым ЦОД компании стал объект MV1 мощностью 1 МВт на площадке в Маунтин-Вью (Калифорния, США). Кроме того, ECL заявила о намерении построить ИИ ЦОД TerraSite-TX1 мощностью 1 ГВт к востоку от Хьюстона (Техас, США). Как сообщается, системы NVIDIA GB300 NVL72 компании Lambda смонтированы на базе модульного дата-центра MV1. Эта площадка отличается нулевым потреблением воды и нулевым уровнем выбросов вредных газов в атмосферу. Питание обеспечивается исключительно от водородных топливных элементов. Развёрнутые устройства GB300 NVL72 разработаны компанией Supermicro. Они обладают мощностью 142 кВт. Для отвода тепла применяется система прямого жидкостного охлаждения, вода для которой поступает от водородных топливных элементов, на которых вырабатывается в качество побочного продукта при генерации электричества. Задействованы централизованные блоки распределения охлаждающей жидкости (CDU). Утверждается, что это первое в отрасли подобное сочетание инфраструктуры на базе ускорителей NVIDIA с водородным источником «зеленой» энергии. Отмечается, что развёртывание систем NVIDIA GB300 NVL72, масса которых составляет примерно 1800 кг, сопряжено с серьёзными трудностями. Лишь немногие дата-центры способны справиться с требованиями к плотности мощности и охлаждению. Водородные топливные элементы рассматриваются в качестве одного из наиболее перспективных способов решение проблемы питания таких объектов. При этом становится возможным устойчивое развитие облачных ИИ-платформ.

27.09.2025 [15:32], Сергей Карасёв

Майнинговая компания Iren увеличила мощность ИИ-облака, закупив тысячи ускорителей NVIDIA и AMD за $674 млнКриптомайнинговая компания Iren (ранее известная как Iris Energy), по сообщению Datacenter Dynamics, увеличила количество ИИ-ускорителей в своём облаке примерно в два раза. Стоимость приобретённого оборудования оценивается в $674 млн. Компании прочат статус серьёзного игрока на рынке неооблаков. Компания находится в процессе перехода от майнинга криптовалют к облачному бизнесу на базе ИИ. В частности, закуплены 7100 ускорителей NVIDIA B300 и 4200 изделий NVIDIA B200, а также 1100 AMD Instinct MI350X. В результате, общее количество ускорителей в составе платформы Iren достигло приблизительно 23 тыс. Новое оборудование в ближайшие месяцы будет развёрнуто в кампусе Iren в городе Принс-Джордже (Prince George) в северной части провинции Британская Колумбия в Канаде. В настоящее время на этой площадке ведётся строительство вычислительного комплекса с жидкостным охлаждением мощностью 10 МВт (ИТ-нагрузка), который сможет поддерживать более 4500 суперускорителей NVIDIA GB300. В конце августа нынешнего года Iren сообщила о приобретении 1200 ускорителей NVIDIA B300 для серверов с воздушным охлаждением и 1200 изделий NVIDIA GB300 для систем с жидкостным охлаждением: стоимость данной партии составила примерно $168 млн. Эти чипы также предназначены для ЦОД в Принс-Джордже. Тогда говорилось, что Iren привлекла финансирование в размере около $96 млн для покупки GB300: средства получены по схеме лизинга сроком на два года. В настоящее время Iren управляет пятью кампусами ЦОД общей мощностью 810 МВт, расположенными в Северной Америке: два в Техасе (США) и три в Британской Колумбии (Канада). Ещё 2,1 ГВт находятся в стадии строительства, причём 2 ГВт из них приходится на новый кампус в Техасе. Как отмечает Дэниел Робертс (Daniel Roberts), соучредитель и содиректор Iren, удвоение парка GPU позволит удовлетворить растущие потребности клиентов в масштабируемых вычислительных мощностях.

21.09.2025 [13:40], Сергей Карасёв

Schneider Electric готовит стойки NVIDIA GB300 NVL72 мощностью 142 кВтКомпания Schneider Electric анонсировала две эталонные платформы, призванные ускорить построение инфраструктур для дата-центров, ориентированных на ресурсоёмкие нагрузки ИИ и НРС. Разработка систем ведётся в партнёрстве с NVIDIA. Один из проектов предусматривает создание референсных стоек для суперускорителей NVIDIA GB300 NVL72. Такие стойки смогут обеспечивать мощность до 142 кВт. Предусмотрено использование жидкостного охлаждения. В одном машинном зале могут быть расположены три кластера GB300 NVL72, насчитывающих в общей сложности до 1152 ускорителей. Отмечается, что в основу решения положены наработки и опыт, полученные в ходе реализации аналогичного проекта для NVIDIA GB200 NVL72. Клиентам будет доступна специальная среда моделирования на базе вычислительной гидродинамики (CFD): могут применяться цифровые двойники для оценки различных конфигураций электропитания и охлаждения с целью оптимизации платформ под определённые нужды.

Источник изображения: Schneider Electric Второй эталонный проект, как утверждается, представляет собой первую и единственную в отрасли платформу, предполагающую интеграцию систем управления питанием и жидкостным охлаждением, включая решения Motivair (контрольный пакет акций этой фирмы Schneider Electric приобрела в конце 2024 года). Для новой платформы заявлена совместимость с NVIDIA Mission Control — программным обеспечением NVIDIA для контроля производственных процессов и оркестрации работы ИИ-систем, включая управление кластерами и рабочими нагрузками. В таких системах могут применяться суперускорители GB300 NVL72 и GB200 NVL72. Подчёркивается, что новые эталонные решения являются результатом продолжающегося сотрудничества Schneider Electric и NVIDIA, которое направлено на удовлетворение растущих потребностей операторов дата-центров в области ИИ.

04.08.2025 [14:17], Владимир Мироненко

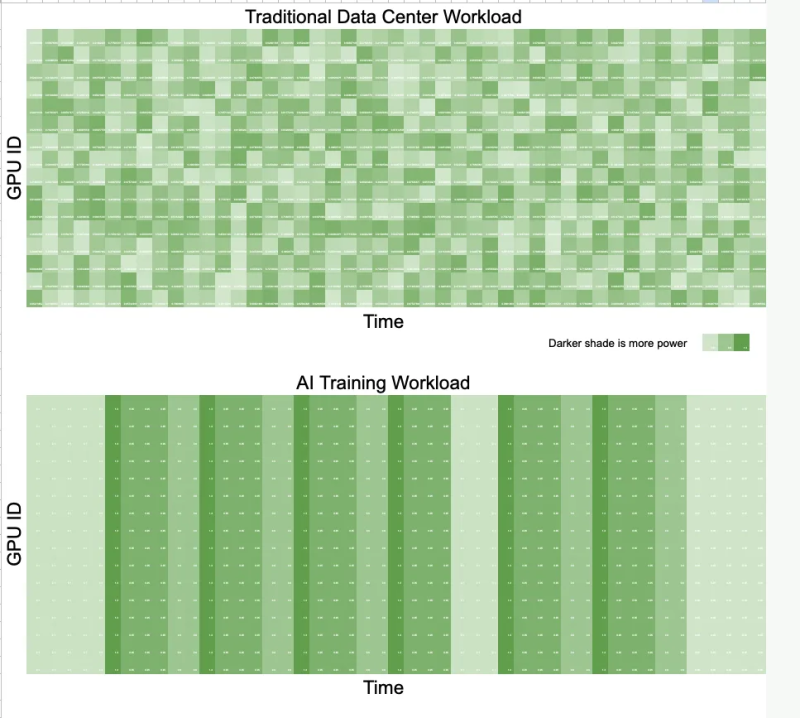

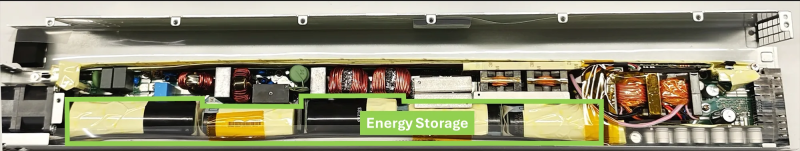

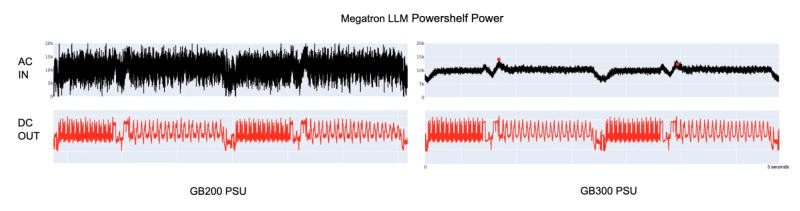

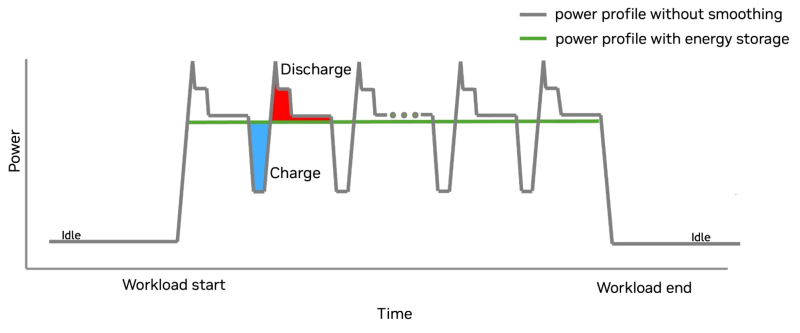

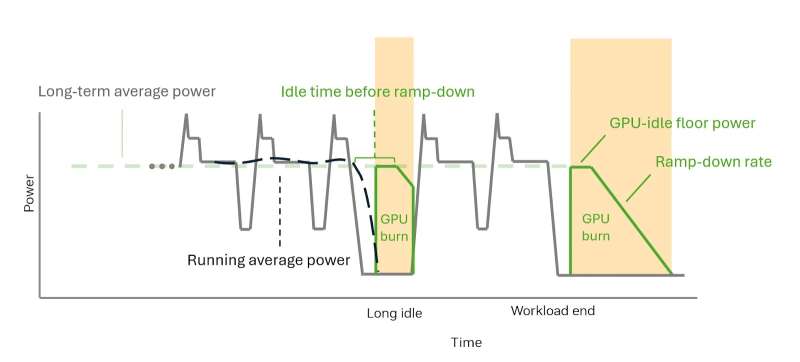

Суперускоритель с «батарейкой» — NVIDIA GB300 NVL72 получили особые блоки питания для сглаживания энергопотребленияNVIDIA представила решение для платформы GB300 NVL72, которое позволяет смягчать колебания напряжения, вызванные синхронной работой тысяч ускорителей (GPU) при работе ИИ-систем, и снижать пиковую нагрузку на сеть до 30 %. Подобные колебания крайне негативно влияют на энергосеть и других потребителей. Новое решение NVIDIA также будет использоваться в системах GB200 NVL72. В процессе обучения ИИ-моделей тысячи ускорителей работают синхронно и выполняют одни и те же вычисления с разными данными. Эта синхронизация приводит к колебаниям мощности на уровне сети — падению напряжения или появлению излишков энергии при внезапных простоях, в отличие от традиционных рабочих нагрузок ЦОД, где ускорители работают асинхронно и некоррелированные задачи «сглаживают» нагрузку. Meta✴ даже пришлось в качестве временной меры добавить в PyTorch опцию PYTORCH_NO_POWERPLANT_BLOWUP, которая загружает ускорители бессмысленной работой в моменты простоя. Для решения этой проблемы компания оснастила NVIDIA GB300 блоком питания с конденсаторами, т.е. накопителями энергии, разработанными с привлечением компании LITEON Technology, а также необходимым аппаратным и программным обеспечением. На разных этапах работы системы используется несколько механизмов, включая ограничение мощности, накопление энергии и «сжигание» энергии — функция NVIDIA GPU Burn. Электролитические конденсаторы обеспечивают равномерное энергопотребление непосредственно в стойке. Они занимают почти половину объёма БП и обеспечивают накопление 65 джоулей энергии на каждый ускоритель. Накопитель (конденсатор) заряжается при низком потреблении энергии ускорителем и разряжается при высоком. Этот своего рода буфер помогает снизить колебания энергопотребления, что продемонстрировано в сравнительных тестах GB200 и GB300 при одинаковой нагрузке. GB300 снижает пиковую нагрузку на сеть на 30 %, обеспечивая при этом аналогичную мощность для ускорителей. GB300 ограничивает скачки, пошагово увеличивая энергопотребление ускорителя. Ограничение по мощности увеличивается постепенно, в соответствии с возможностями сети. По завершении задания, программный драйвер, реализующий алгоритм сглаживания энергопотребления, активирует аппаратное снижение энергопотребления. Ускоритель продолжает потреблять постоянную мощность благодаря функции NVIDIA GPU Burn, ожидая возобновления нагрузки. Если нагрузка не возобновляется, ускоритель плавно снижает энергопотребление. Если нагрузка на ускоритель возобновляется, функция NVIDIA GPU Burn мгновенно отключается. После завершения нагрузки ускоритель с помощью NVIDIA GPU Burn постепенно снижает энергопотребление со скоростью, соответствующей возможностям сети, а затем отключается. Эти параметры контролируются такими настройками, как минимальное энергопотребление в режиме ожидания и время постепенного снижения нагрузки, которые можно настроить с помощью NVIDIA SMI или Redfish. Такой полный контроль энергопотребления снижает нагрузку на электросеть и делает планирование заданий более предсказуемым. Как отметил ресурс The Futurum Group, благодаря предложенной NVIDIA схеме питания ЦОД больше не нужно строить с учётом пиковых потребностей в мощности. Вместо этого их можно масштабировать ближе к средним показателям использования, что означает возможность размещения большего количества оборудования в том же пространстве или снижение общих затрат на электроэнергию. Суперконденсаторы в качестве энергетического буфера для всего объекта целиком предлагает Siemens, хотя уже есть и более компактные решения размером со стойку. Кроме того, поскольку сглаживание потребления мощности ограничено стойкой без её подачи обратно в сеть, операторы получают больше контроля над энергопотреблением. Такое сочетание аппаратного и программного обеспечения обеспечивает масштабируемость и делает ЦОД дружественными к энергосети, независимо от того, используют ли они системы GB200 или GB300 NVL72. Как отметил ресурс ServeTheHome, использование дополнительных аккумулирующих модулей в стойке, предложенное LITEON, также поможет более равномерному распределению нагрузки между крупными ИИ-кластерами. Сантьяго Грихальва (Santiago Grijalva), профессор электротехники и вычислительной техники в Технологическом институте Джорджии, назвал новую технологию «довольно серьёзным событием», учитывая доминирующую роль NVIDIA в этой области. «Но это решение ограничено высококлассными системами NVIDIA, — указал он в электронном письме ресурсу Utility Dive. — Это решение конкурирует с решениями Tesla и аппаратными оптимизациями Meta✴, предлагая существенное, но не революционное усовершенствование существующих методов управления питанием».

23.07.2025 [15:46], Руслан Авдеев

Илон Маск объявил, что ИИ-суперкомпьютер xAI Colossus 2 запустят в ближайшие неделиОснователь ИИ-стартапа xAI Илон Маск (Elon Musk) поделился в социальной сети X информацией о будущем второго кампуса ЦОД в Мемфисе (Теннесси). В числе прочего он объявил намерении запустить в эксплуатацию суперкомпьютер Colossus 2 в ближайшие недели, сообщает Commercial Appeal. По его словам, Colossus 2 получит 550 тыс. ИИ-ускорителей. Компания располагает в городе двумя кампусами — Colossus 1 и Colossus 2. Первый расположен на территории бывшего завода Electrolux и включает 230 тыс. укорителей, в том числе 30 тыс. NVIDIA GB200. Система используется только для обучения, инференс осуществляется в облаках партнёров xAI. Второй кампус, Colossus 2 на площадке Тулейн-роуд (Tulane Road), на первом этапе получит 110 тыс. GB200 и GB300, что потребует 170 МВт энергии. Он должен начать работу в течение нескольких недель. Сроки развёртывания оставшихся 440 тыс. ускорителей не определены, поскольку поставки NVIDIA GB300 задерживаются. В феврале дочерняя структура xAI, компания CTC Property, купила более 75 га вдоль Тулейн-роуд за $70,9 млн. С тех пор, как xAI объявил о планах довести количество ускорителей Colossus до 1 млн, всё чаще возникает вопрос, как именно компания намерена снабжать свой проект энергией. В мае Маск объявил, что Colossus 2 станет первым гигаваттным ИИ-кластером. 15 июля в xAI подтвердили, что компания работает с Memphis Light, Gas and Water (MLGW) и Tennessee Valley Authority (TVA) над обеспечением объекта питанием. MLGW подтвердила, что у неё есть договор на поставку 500 кВт объекту xAI на Тулейн-роуд. А 16 июля MXZ Tech LLC, дочерняя компания xAI, приобрела территорию бывшей электростанции Duke Energy (46 га) неподалёку от кампуса Colossus 2. Этот объект сохранил подключение к энергосети TVA. Кроме того, кампус Colossus 2 уже получил 168 модулей Tesla Megapacks. По-видимому, этот кампус тоже не обойдётся без газовых турбин, и использование которых для питания Colossus 1 вызвало недовольство местных экоактививстов NAACP и SELC. Впрочем, пока непонятно, состоится ли серьёзное разбирательство. Совсем недавно Илон Маск сообщил о намерении ввести в эксплуатацию эквивалент 50 млн NVIDIA H100 в течение пяти лет — это ответ на недавнее заявление OpenAI о намерении освоить более 1 млн ускорителей к концу текущего года, а в будущем получить в своё распоряжение 100 млн ускорителей. Сейчас xAI намерена найти ещё $12 млрд на закупку ускорителей.

20.07.2025 [14:26], Сергей Карасёв

NVIDIA приступила к производству ИИ-ускорителей GB300Компания NVIDIA, по сообщению DigiTimes, приступила к ограниченному производству суперчипов Grace Blackwell GB300 для ресурсоёмких ИИ-нагрузок. Ожидается, что поставки изделия будут организованы в сентябре с постепенным наращиванием объёмов выпуска. Решение GB300 представляет собой связку из Arm-процессора Grace с 72 ядрами Neoverse V2 и двух чипов Blackwell Ultra. В оснащение входят 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. Ускоритель GB300 является основой стоечной системы GB300 NVL72, которая насчитывает 36 чипов Grace и 72 процессора Blackwell Ultra. ИИ-производительность такого комплекса достигает 720 Пфлопс на операциях FP8/FP6. «На данном этапе серьёзных проблем с GB300 нет. Поставки должны идти гладко со II половины года», — подчеркнули представители одного из ODM-производителей.

Источник изображения: NVIDIA Вместе с тем, как отмечается, сохраняется высокий спрос на ускорители GB200. Заказчики продолжают закупать эти изделия, несмотря на сложности с охлаждением. Огромная вычислительная мощность и повышенная плотность компоновки серверов обусловили необходимость применения жидкостных систем отвода тепла. Однако при этом возникли проблемы протечек. Оказалось, что во многих случаях это связано с быстроразъёмными соединениями, которые не всегда удовлетворяют нужным требованиям — даже после стресс-тестирования на заводе. ODM-производители отмечают, что реальные условия эксплуатации сильно различаются по давлению воды и конструкции трубопроводов, что затрудняет полное исключение протечек. Послепродажное обслуживание требует значительных временных и финансовых затрат. В случае GB200 основные сложности были обусловлены переходом от архитектуры Hopper к Blackwell, что привело к комплексным изменениям на уровне платформы. С другой стороны, GB300 использует существующую инфраструктуру, а поэтому, как ожидается, серьёзных проблем при выпуске и поставках этих изделий не возникнет. ODM-производители, которые в настоящее время активно тестируют GB300, говорят об обнадёживающих результатах. Предполагается, что переход пройдёт гладко: массовые поставки запланированы на III квартал с увеличением объёмов выпуска в последней четверти текущего года. Новые вызовы может создать появление ускорителей следующего поколения семейства Rubin, которые придут на смену Blackwell Ultra во II половине 2026 года. Эта платформа предполагает использование чиплетов и полностью новой стойки Kyber (для VR300 NVL 576), которая заменит нынешнюю конструкцию Oberon. Плотность компоновки возрастёт до 600 кВт на стойку, что потребует ещё более надёжных систем охлаждения. Отмечается, что применение СЖО станет обязательным для суперускорителей Rubin. Вместе с тем с восстановлением производства ослабленных ускорителей H20, которые США вновь разрешили поставлять в Китай, возможны проблемы. Как передаёт Reuters со ссылкой на The Information, TSMC успела переключить производственные линии, которые использовались для H20, на выпуск других продуктов. Полное восстановление производства H20 может занять девять месяцев.

05.07.2025 [02:13], Владимир Мироненко

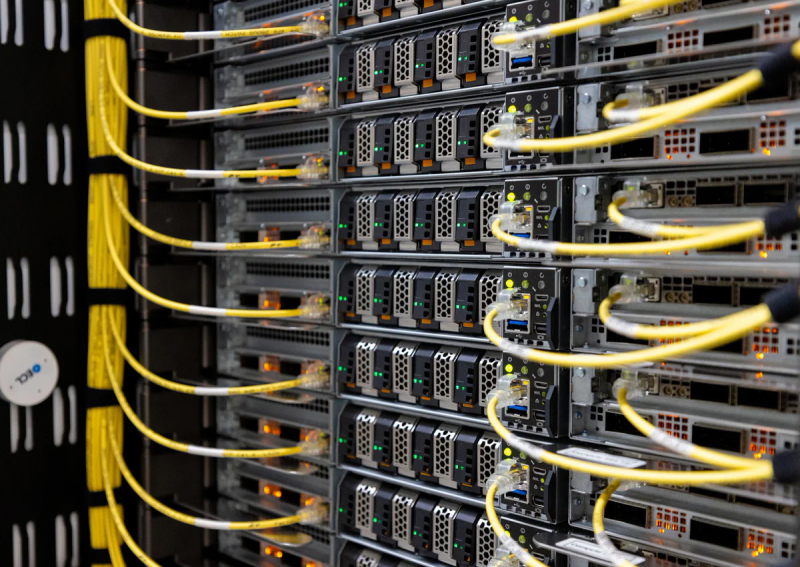

CoreWeave первой в отрасли развернула кластер на базе NVIDIA GB300 NVL72Облачный провайдер CoreWeave объявил о первом в отрасли развёртывании кластера на базе передовой платформы NVIDIA GB300 NVL72, размещённой в интегрированной стоечной системе, поставленной Dell. Развёртыванием кластера занимался оператор ЦОД Switch. Dell заявила, что стоечные системы поставляются собранными и протестированными. Они изначально разработаны для быстрой установки и развёртывания. GB300 NVL72 в исполнении Dell представляет собой интегрированное стоечное решение на базе серверов PowerEdge XE9712 с жидкостным охлаждением, которое объединяет 72 ускорителя NVIDIA Blackwell Ultra, 36 Arm-процессоров NVIDIA Grace на базе Arm-архитектуры, интерконнект NVLink и 18 или 36 DPU NVIDIA BlueField-3 в одну мощную платформу, использующую в работе широкий спектр передовых решений NVIDIA. Каждая стойка GB300 NVL72 оснащена 21 Тбайт HBM3E и 40 Тбайт RAM. В решении используются 800G-сеть с коммутаторами Quantum-X800 InfiniBand и адаптерами ConnectX-8 SuperNIC. Каждая стойка GB300 NVL72 обеспечивает производительность 1,1 Эфлопс в FP4-вычислениях для инференса и 0,36 Эфлопс в FP8 (без разреженности) для обучения, что на 50 % выше по сравнению с GB200 NVL72. Программная инфраструктура NVIDIA DOCA, работающая на NVIDIA BlueField-3, ускоряет рабочие нагрузки ИИ, обеспечивая пользователям скорость сети до 200 Гбит/с и высокопроизводительный доступ к данным ускорителей. Как отметила CoreWeave, новое оборудование означает для клиентов значительный рост производительности при обработке рабочих нагрузок рассуждающих ИИ-моделей. |

|