Материалы по тегу: openai

|

23.10.2025 [00:40], Владимир Мироненко

Умение Альтмана играть на самолюбии руководителей позволило OpenAI заключить сделки на сотни миллиардов долларовГлава OpenAI Сэм Альтман (Sam Altman) оказался умелым стратегом. Чтобы обеспечить компанию чуть ли не бесконечными вычислительными мощностями, он организовал целую серию сделок на сотни миллирдов долларов, натравив друг на друга гигантов Кремниевой долины. Альтман сыграл на их самолюбии и желании нажиться на будущем росте OpenAI. Все они теперь делают ставку на успех стартапа, который пока невероятно далёк от прибыльности, пишет The Wall Street Journal. Но выйти из игры они уже не могут — OpenAI должна выжить любой ценой. А NVIDIA даже готова расплатиться по долгам OpenAI, если что-то пойдёт не так. За последние два месяца цены на акции Oracle, NVIDIA, AMD и Broadcom резко взлетали вверх после объявления о сделках, связанных с OpenAI. В общей сложности их рыночная стоимость выросла на $630 млрд в первый день торгов после этих объявлений. Каждый раз за этим следовал более масштабный рост акций технологических компаний, способствуя росту фондового рынка США до рекордных высот. «Самые успешные люди, которых я знаю, верят в себя почти до самообмана», — написал в 2019 году Альтман в блоге «Как достичь успеха», а затем добавил: «Одной веры в себя недостаточно — нужно ещё и уметь убеждать других в своей вере». В этом году OpenAI планирует получить выручку в размере $13 млрд, что несопоставимо со счетами на $650 млрд, которые компания получит только в рамках сделок с NVIDIA и Oracle, согласно подсчётам The Wall Street Journal. С учётом соглашений с AMD, Broadcom и другими провайдерами облачных услуг, такими как Microsoft, общая сумма затрат приближается к $1 трлн. Обязательства на такие объёмы поставок чипов и километровых ЦОД до того, как OpenAI сможет себе это позволить, вызывают опасения, что энтузиазм в отношении ИИ превращается в пузырь, зависящий от успеха всего одной компании. Некоторые партнёры даже помогают OpenAI оплачивать свои чипы, заключая циклические сделки. В прошлом году Альтман спросил гендиректора Microsoft Сатью Наделлу (Satya Nadella), готова ли его компания инвестировать не менее $100 млрд в создание новых ЦОД OpenAI в рамках будущего проекта Stargate. Тот ответил отказом. Такой же ответ он получил от TSMC. Последней он представил проект стоимостью $7 трлн по строительству новых заводов по производству микросхем по всему миру. Ситуация изменилась, когда Альтману удалось заручиться поддержкой гендиректора SoftBank Масаёси Сона (Masayoshi Son). Сон согласился возглавить проект стоимостью $500 млрд. После объявления Белого дома США о поддержке проекта Stargate, акции SoftBank подскочили на 11 %, как и акции других технологических партнёров, участвующих в проекте. Практически сразу NVIDIA предложила OpenAI организовать похожий проект и помочь с его финансированием, но без участия SoftBank. В последующие после анонса недели и месяцы OpenAI получила сотни предложений о потенциальных площадках для строительства, что подготовило почву для её следующих шагов. В свою очередь Microsoft расторгла договоры аренды некоторых ЦОД в США, ссылаясь на отказ от поддержки нагрузок OpenAI. Вместе с тем она, являясь на тот момент главным инвестором OpenAI, разрешила ей найти дополнительные вычислительные мощности у других поставщиков и сосредоточила усилия на привлечении клиентов. После этого OpenAI заключила контракт с Oracle на $300 млрд, что привело к рекордному за четверть века росту акций последней. Внутри Microsoft сделку раскритиковали — не было уверенности, что Oracle справится, поскольку строительство гигантских ЦОД обязывает OpenAI выплачивать в среднем $60 млрд/год, что более чем вчетверо превышает её текущую выручку. Между тем переговоры OpenAI и NVIDIA по их собственному проекту создания ИИ-инфраструктуры зашли в тупик. Всё изменилось в июне, когда стало известно о сделке между Google и OpenAI. А после появления сообщения о том, что OpenAI начала арендовать ускорители TPU у Google для поддержки ChatGPT, гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) практически сразу позвонил Альтману, чтобы узнать, правда ли это, и дал понять, что готов возобновить переговоры. В итоге NVIDIA подписала соглашение о предоставлении в аренду OpenAI до 5 млн своих чипов, что по сегодняшним ценам обойдётся в $350 млрд. Также NVIDIA готова инвестировать до $100 млрд, чтобы помочь стартапу оплатить сделку. Более того, в рамках сделки NVIDIA также обсуждает предоставление гарантий по некоторым кредитам, которые OpenAI планирует взять на строительство собственных ЦОД, сообщили источники WSJ. Этим шагом NVIDIA может возложить на себя миллиардные долговые обязательства, если стартап не сможет вовремя погасить кредиты. Несмотря на заключённые с NVIDIA и другими компаниями контракты, OpenAI продолжала расширять свою вычислительную базу. Всего через несколько недель компания подписала с AMD контракт на 6 ГВт, в рамках которого может также получить до 10 % её акций. После объявления 6 октября о сделке с OpenAI акции AMD выросли на рекордные 24 %. Неделю спустя OpenAI официально представила проект по разработке ИИ-чипа совместно с Broadcom, над которым они работали с начала 2024 года. После объявления о сделке OpenAI с NVIDIA переговоры о заключении крупного соглашения ускорились. Сделка с Broadcom сопоставима по масштабу со сделкой с NVIDIA — до 10 ГВт вычислительной мощности для OpenAI к 2029 году.

15.10.2025 [15:25], Руслан Авдеев

OpenAI и Oracle развернут 450 тыс. ускорителей NVIDIA в техасском дата-центре StargateПо словам председателя Oracle Ларри Эллисона (Larry Ellison), дата-центр проекта Stargate а Абилине (Abilene, Техас) вместит более 450 тыс. ускорителей на базе NVIDIA GB200, сообщает Datacenter Dynamics. Дата-центр Stargate получит 1,2 ГВт энергии — по словам Эллисона, энергии достаточно, чтобы обеспечить миллион домохозяйств в США. Как заявил миллиардер, «это довольно большой город». Питаться кампус будет как от энергосети штата, так и от газовых турбин. Информация подтверждает данные о том, что OpenAI и Oracle освоят всю ёмкость кампуса, застраиваемого Crusoe. Первые два строения уже функционируют, они введены в эксплуатацию в сентябре 2025 года. Строительство оставшихся шести зданий должны быть завершены к середине 2026 года. В марте 2025 года заявлялось, что площадка получит 64 тыс. ускорителей NVIDIA к концу 2026 года. С тех пор OpenAI подписала не имеющее обязательной силы письмо о намерении арендовать оборудование NVIDIA на 10 ГВт, которая в ответ пообещала инвестировать в OpenAI $100 млрд.

Источник изображения: OpenAI О росте числа используемых Stargate ускорителей можно было догадаться после анонса Oracle облачного ИИ-суперкомпьютера Zettascale10, который должен заработать во II половине 2026 года. Он объединит до 800 тыс. ускорителей в нескольких близко расположенных ЦОД. В Oracle отмечали, что суперкомпьютер станет основой флагманского суперкластера, создаваемого при участии OpenAI в Абилине в рамках проекта Stargate.

14.10.2025 [12:46], Владимир Мироненко

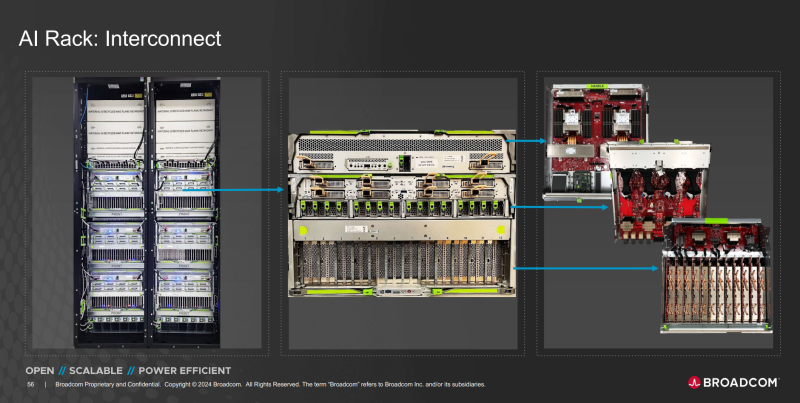

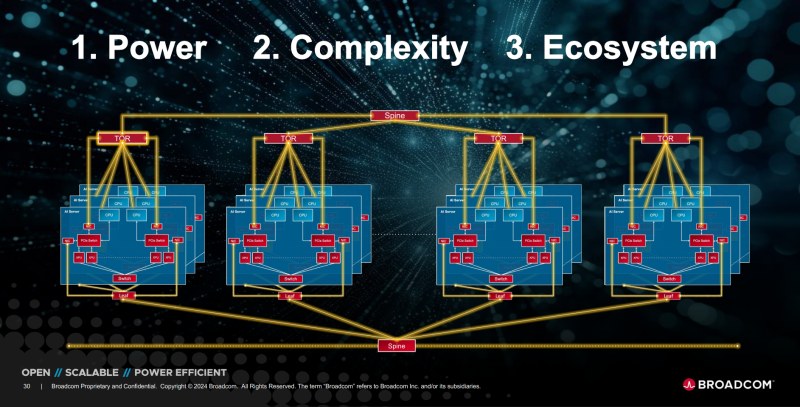

OpenAI и Broadcom совместно разработают и развернут ИИ-ускорители на 10 ГВтOpenAI и Broadcom объявили о заключении соглашения о стратегическом сотрудничестве с целью совместного создания и дальнейшего развёртывания кастомных ИИ-ускорителей общей мощностью 10 ГВт. Речь идёт об вертикально интегрированных решениях уровня стоек и ЦОД. OpenAI отметила в пресс-релизе, что при разработке собственных чипов и систем сможет интегрировать имеющиеся достижения в создании передовых моделей и продуктов непосредственно в аппаратное обеспечение. «Стойки, полностью масштабируемые с использованием Ethernet и других сетевых решений Broadcom, удовлетворят растущий глобальный спрос на ИИ и будут развёрнуты на объектах OpenAI и в партнёрских ЦОД», — сообщила компания. Начало развертывания систем запланировано на II половину 2026 года, а завершение — на конец 2029 года. «Партнёрство с Broadcom — критически важный шаг в создании инфраструктуры, необходимой для раскрытия потенциала ИИ и предоставления реальных преимуществ людям и бизнесу», — заявил Сэм Альтман (Sam Altman), соучредитель и генеральный директор OpenAI. Он отметил, что разработка собственных ускорителей дополняет более широкую экосистему партнёров, которые вместе создают потенциал, «необходимый для расширения возможностей ИИ на благо всего человечества». Чарли Кавас (Charlie Kawwas), президент группы полупроводниковых решений Broadcom сообщил, что кастомные ускорители «прекрасно сочетаются со стандартными сетевыми решениями Ethernet для масштабирования и горизонтального масштабирования», позволяя создать оптимизированную по стоимости и производительности ИИ-инфраструктуру нового поколения. По его словам, стойки будут включать комплексный набор решений Broadcom для Ethernet, PCIe и оптических соединений. Как пишет The Register, президент OpenAI Грег Брокман (Greg Brockman) рассказал, что при разработке ускорителя компания смогла использовать собственные ИИ-модели, которые позволили оптимизировать и ускорить процесс. По его словам, благодаря этому удалось увеличить плотность размещения компонентов. «Вы берёте компоненты, которые уже оптимизированы людьми, просто указываете для них вычислительные мощности, и модель сама предлагает решение», — цитирует Брокмана SiliconANGLE. Компании не уточнили, какие именно продукты Broadcom будут использоваться в рамках партнёрства. Вполне возможно, что это будет анонсированный на прошлой неделе Ethernet-коммутатор TH6-Davisson, оптимизированный для ИИ-кластеров и обеспечивающий пропускную способность до 102,4 Тбит/с, что, по заявлению компании, вдвое превышает показатели изделий ближайшего конкурента. Также Broadcom поставляет линейку PCIe-коммутаторов серии PEX и ретаймеры. Ранее в этом месяце OpenAI заключила соглашение с AMD на поставку ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт для обеспечения своей ИИ-инфраструктуры. По предварительным оценкам, стоимость контракта составляет $60–$80 млрд. В сентябре NVIDIA объявила о соглашении с OpenAI на поставку ускорителей для развёртывания ИИ-инфраструктуры мощностью не менее 10 ГВт с сопутствующими инвестициями в размере $100 млрд. Broadcom в сентябре сообщила о получении заказа от нового клиента на разработку и поставку кастомного ИИ-чипа на сумму более $10 млрд. По мнению аналитиков, речь шла как раз об OpenAI. Создание сети взаимозависимостей означает, что несколько технологических компаний с оборотом в миллиарды долларов кровно заинтересованы в успехе OpenAI, отметил The Register. При этом OpenAI заявляет, что у неё не будет положительного денежного потока ещё четыре года и вместе с тем планирует в течение этого периода значительно увеличить расходы на инфраструктуру ЦОД. Такой подход вызывает опасения у экспертов, заявляющих, что подобные сделки указывают на своего рода пузырь на ИИ-рынке, поскольку компании оперируют такими терминами, как гигаватты и токены, вместо таких «скучных старых терминов», как выручка или доход.

11.10.2025 [11:42], Сергей Карасёв

OpenAI создаст в Аргентине кампус Stargate мощностью 500 МВтOpenAI и энергетическая компания Sur Energy, по сообщению Reuters, подписали соглашение о сотрудничестве, которое предусматривает строительство в Аргентине масштабного кампуса дата-центров для задач ИИ. Проект будет реализован в рамках инициативы Stargate. Напомним, что Stargate — это совместное предприятие OpenAI, SoftBank и Oracle по развитию ИИ-инфраструктуры в США: ожидается, что суммарные затраты на реализацию проекта достигнут $500 млрд. При этом также планируется строительство площадок Stargate в других странах в рамках инициативы OpenAI for Countries. Комплекс ЦОД, созданием которого займутся OpenAI и Sur Energy, станет первым объектом Stargate в Латинской Америке. Речь идёт о строительстве кампуса мощностью до 500 МВт. Суммарные затраты на создание объекта могут составить до $25 млрд. Ожидается, что это будет одна из крупнейших инвестиций в технологическую и энергетическую инфраструктуру в истории Аргентины. Финансирование проекта будет осуществляться через совместное предприятие Sur Energy и неназванного международного разработчика облачных систем. При этом OpenAI выступит в качестве потребителя вычислительных мощностей дата-центра после его ввода в эксплуатацию. «Мы с гордостью объявляем о планах запуска Stargate Argentina — нового инфраструктурного проекта в партнёрстве с одной из ведущих энергетических компаний страны, Sur Energy», — заявил генеральный директор OpenAI Сэм Альтман (Sam Altman). Ранее OpenAI анонсировала проект Stargate Norway — первый в Европе дата-центр, создающийся в рамках программы OpenAI for Countries: объект мощностью 230 МВт расположится в Норвегии. Кроме того, OpenAI построит ИИ ЦОД Stargate в Южной Корее. В начале сентября стало известно о том, что компания Альтмана рассчитывает построить в Индии дата-центр мощностью не менее 1 ГВт. А крупнейший кампус Stargate будет создан в ОАЭ, если, конечно, опять не появятся проблемы с поставками ускорителей NVIDIA. Вместе с тем недавно в США заработали первые ИИ ЦОД флагманского кампуса OpenAI Stargate.

10.10.2025 [14:50], Руслан Авдеев

Не для себя стараемся: Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72Microsoft представила первый в мире ИИ-кластер, использующий более 4,6 тыс. NVIDIA Blackwell Ultra в составе суперускорителей NVIDIA GB300 NVL72, объединённых интерконнектом Quantum-X800 InfiniBand. Этот кластер — лишь первый из многих. Компания развернёт сотни тысяч ускорителей Blackwell Ultra в ИИ ЦОД по всему миру. Благодаря им Microsoft намерена стать первой, поддерживающей обучение для моделей с сотнями триллионов параметров. Как сообщают в Microsoft, запуск в Microsoft Azure суперкластера NVIDIA GB300 NVL72 стал важным шагом в развитии передовых ИИ-технологий. Разработанная совместно с NVIDIA система представляет собой первый в мире масштабируемый ИИ-кластер на основе GB300, обеспечивающий вычислительные мощности, необходимые OpenAI для обслуживания моделей с триллионами параметров. Речь идёт о новом стандарте ускоренных вычислений, говорят компании. Новые инстансы Azure ND GB300 v6 оптимизированы для рассуждающих моделей, агентных систем и мультимодального генеративного ИИ. Каждая стойка GB300 NVL72 обслуживает 18 виртуальных машин, а сам суперускоритель с производительностью до 1,44 Эфлопс (FP4 Tensor Core) включает:

Источник изображения: Microsoft Создание передовой инфраструктуры требует переосмысления всех уровней системы, включая вычисления, память, системы охлаждения и питания, ЦОД в целом как единой структуры. Новая архитектура стоек обеспечивает высокую пропускную способность инференса при меньших задержках на крупных моделях, это позволяет агентным и мультимодальным ИИ-системам быть более масштабируемыми и эффективными, чем когда-либо, говорит компания. Для масштабирования за пределы стойки используется NVIDIA Quantum-X800 InfiniBand, что гарантирует обучения сверхбольших моделей с применением десятков тысяч ИИ-ускорителей с минимальными накладными расходами на их синхронизацию, что дополнительно повышает производительность.

Источник изображения: Microsoft Передовые системы охлаждения Azure используют автономные теплообменники, чтобы свести к минимуму расход воды и поддерживать температурную стабильность для высокоплотных кластеров. Также продолжается разработка и внедрение новых моделей распределения питания, обеспечивающих высокую энергетическую плотность и динамический баланс нагрузок. Дополнительную помощь в оптимизации работы оказывает и модернизированное программное обеспечение. Ранее Microsoft обладала эксклюзивными правами на предоставление облачных сервисов компании OpenAI, но в январе 2025 года появилась новость, что ИИ-стартапу разрешили пользоваться и облаками других провайдеров, если у Microsoft не хватит собственных мощностей. Разногласия между компаниями продолжают нарастать. Формально первенство по создание кластера на базе GB300 NVL72 принадлежит CoreWeave, имеющей тесные отношения с NVIDIA и обслуживающей OpenAI — как напрямую, так и при посредничестве Microsoft.

06.10.2025 [16:45], Владимир Мироненко

AMD поставит OpenAI ИИ-ускорители на 6 ГВт, а OpenAI получит долю в AMDAMD и OpenAI объявили о заключении многолетнего соглашения о стратегическом партнёрстве, в рамках которого будет построена ИИ-инфраструктура на базе сотен тысяч ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт общей стоимостью, по предварительным оценкам, $60–$80 млрд. После объявления о сделке акции AMD выросли на 28 % до $211,18 в начале торгов, что само по себе тянет на рекорд, пишет Bloomberg. В рамках соглашения AMD предоставила OpenAI возможность покупки до 160 млн обыкновенных акций, которые будут переданы по мере достижения контрольных целей. Первый транш будет предоставлен после развёртывания инфраструктуры на 1 ГВт, которое начнется во II половине следующего года. ИИ-системы будут основаны на чипах AMD Instinct MI450. Последующие транши будут выделяться по мере развёртывания оборудования в ЦОД до итогового показателя мощности в 6 ГВт. Выпуск акций также привязан к достижению AMD целей по цене акций и достижению OpenAI технических и коммерческих целей. Исходя из текущего количества выпущенных акций AMD к завершению сделки у OpenAI будет 10 % её акций. «Мы рассматриваем эту сделку как безусловно преобразующую не только для AMD, но и для динамики всей отрасли», — заявил исполнительный вице-президент AMD Форрест Норрод (Forrest Norrod) агентству Reuters в воскресенье. В AMD также сообщили, что партнёрство с OpenAI принесет компании десятки миллиардов долларов дохода, значительно увеличит прибыль AMD на акцию и ускорит развитие инфраструктуры ИИ OpenAI. Для AMD эта сделка станет отправной точкой для более широкого внедрения её технологий, что может увеличить доход компании в этой области до более чем $100 млрд, заявили руководители компании, не уточняя конкретных сроков, пишет Bloomberg. Для OpenAI сотрудничество с AMD обеспечит более надёжную альтернативу решениям NVIDIA, на которые OpenAI и операторы ЦОД тратят значительную часть своих бюджетов. В прошлом месяце стало известно о соглашении OpenAI с NVIDIA, в рамках которого производитель чипов инвестирует в стартап до $100 млрд, включая поставку ускорителей общей мощностью не менее 10 ГВт. Ускорители AMD будут использоваться преимущественно для инференса, а NVIDIA — для обучения. Попутно OpenAI при поддержке Broadcom разрабатывает собственные ИИ-ускорители, которые должны появиться в 2026 году.

06.10.2025 [08:32], Сергей Карасёв

OpenAI оснастит дата-центры энергетическим оборудованием HitachiКомпании OpenAI и Hitachi, по сообщению Nikkei, подписали меморандум о взаимопонимании с целью развития ИИ-инфраструктуры и создания энергетически эффективных дата-центров в глобальном масштабе. Основными целями партнёрства заявлены ускорение разработки генеративного ИИ и снижение затрат на эксплуатацию ЦОД. В рамках сотрудничества Hitachi будет поставлять передовое оборудование для передачи и распределения электроэнергии в дата-центры OpenAI по всему миру. Ожидается, что эти системы помогут снизить потребление электричества и тем самым сократить расходы на поддержание работы ИИ ЦОД. В свою очередь, OpenAI, по условиям соглашения, предоставит Hitachi свои большие языковые модели (LLM). Они могут быть интегрированы в цифровую платформу Hitachi Lumada, которая представляет собой комплексное решение для индустриального интернета вещей (IIoT). Говорится также, что Hitachi внесёт вклад в проект Stargate — это совместное предприятие OpenAI, SoftBank и Oracle по развитию ИИ-инфраструктуры в США. Предполагается, что суммарные затраты на реализацию Stargate достигнут $500 млрд. Планируется, что OpenAI начнёт закупать IT-оборудование Hitachi, включая СХД. В состав Hitachi, напомним, входит дочерняя структура Hitachi Vantara, которая специализируется на продуктах для управления данными, включая оборудование, ПО и услуги для облачных платформ и дата-центров. Нужно отметить, что недавно в США были введены в эксплуатацию первые ИИ ЦОД флагманского кампуса OpenAI Stargate. Кроме того, OpenAI объявила о намерении построить пять дополнительных дата-центров по всей территории США. Новые объекты расположатся, в частности, в округах Шакелфорд (Shackelford) в штате Техас и Донья-Ана (Doña Ana) в штате Нью-Мексико.

01.10.2025 [18:15], Руслан Авдеев

OpenAI построит ИИ ЦОД Stargate в Южной Корее, а Samsung поможет ей создать плавучие дата-центрыOpenAI подписала с Samsung Electronics и SK hynix письмо о намерениях, предусматривающее поставку чипов памяти знаменитому ИИ-стартапу. Дополнительно сообщается о намерении построить ЦОД Stargate на юго-западе Южной Кореи при участии SK Group. Кроме того, SK Telecom создаёт независимую ИИ-компанию с инвестициями $3,5 млрд в течение пяти лет. В рамках сотрудничества южнокорейские компании планируют нарастить выпуск DRAM — до 900 тыс. пластин в месяц, которые понадобятся для передовых моделей OpenAI. Samsung и её дочерние структуры Samsung SDS, Samsung C&T (Construction and Trading) и Samsung Heavy Industries помогут в реализации проекта Stargate Korea, в том числе со строительством и эксплуатацией ЦОД, облачными сервисами, консалтингом, а также внедрением и управлением сервисами для бизнесов, желающих интегрировать ИИ-модели OpenAI в свои внутренние системы. Упоминаются даже судостроение и морское дело. В частности, сотрудничество предусматривает совместную разработку плавучих ЦОД. Подобные объекты имеют определённые преимущества перед традиционными, поскольку им не требуется свободных участков земли, лишних расходов на охлаждение и углеродные выбросы таких проектов обычно невелики. Компании также изучают возможности создания плавучих электростанций и центров управления.

Источник изображения: Mathew Schwartz/unsplash.com Проект Stargate был запущен OpenAI в январе, при содействии Oracle, SoftBank, и MGX из Абу-Даби и уже заработали его первые ЦОД. Планируется инвестировать $500 млрд в цифровую инфраструктуру в следующие четыре года для обслуживания вычислительных потребностей OpenAI. На прошлой неделе OpenAI анонсировала строительство новых ЦОД Stargate в США, включая дата-центры в Техасе, Нью-Мексико и на Среднем Западе. Планируется реализация проектов Stargate и в других странах помимо Южной Кореи, например — в Великобритании и Норвегии.

01.10.2025 [16:14], Руслан Авдеев

Oracle может потребоваться $100 млрд заёмных средств для поддержки проектов OpenAIПо прогнозам аналитиков KeyBanc Capital Markets, в следующие четыре года Oracle может потребоваться $100 млрд заёмного капитала для финансирования соглашения с OpenAI. На создание облачной вычислительной инфраструктуры уйдёт порядка $25 млрд ежегодно, передаёт Datacenter Dynamics. По данным The Wall Street Journal, речь идёт о контракте на $300 млрд, который был подписан в начале сентября и рассчитан на пять лет. Он должен вступить в силу в 2027 году. Сделка станет одним из крупнейших контрактов в сфере облачных вычислений в истории. В июле сообщалось, что OpenAI арендует у Oracle 4,5 ГВт мощностей ЦОД на $30 млрд в год, начиная с 2028 года. Судя по данным о новом контракте, ежегодная стоимость выросла до $60 млрд. Пока нет данных, почему потребовалось удвоить сумму. Впрочем, не так давно глава OpenAI Сэм Альтман (Sam Altman) заявлял, что его компания намерена потратить «триллионы» на ИИ-инфраструктуру. В мечтах OpenAI — 10 млрд ускорителей, по одному на каждого жителя Земли. О новой сделке стало известно после того, как Oracle отчиталась о результатах I квартала 2026 финансового года. В ходе отчёта компания объявила, что заключила значимые облачные контракты с ведущими бизнесами в сфере ИИ, включая три «многомиллиардных» контракта, полученных в начале 2025 года. Также объявлено, что теперь компания имеет $455 млрд подлежащих исполнению обязательств. В KeyBanc предположили, что сейчас у Oracle нет достаточно средств для создания необходимой по контракту с OpenAI инфраструктуры. На конец августа долгосрочные долговые обязательства Oracle составляли $82,2 млрд, а в начале сентября компания выпустила серию облигаций для привлечения $18 млрд. В последнем финансовом отчёте компания отметила, что располагает $10 млрд в денежных средствах и их эквивалентах; также имелось $9 млрд задолженностей, подлежащих погашению в следующие 12 месяцев.

Источник изображения: Jakub Żerdzicki/unsplash.com Примечательно, что компания уже значительно нарастила инвестиции в развитие инфраструктуры. Только в прошлом квартале капитальные затраты составили $8,5 млрд, на $2,3 млрд больше год к году. Ожидается, что контракт на $300 млрд лишь увеличит соответствующие расходы. Капитальные затраты на 2026 финансовый год составят около $35 млрд, хотя они могут оказаться и несколько выше — новость считается хорошей, поскольку говорит о наращивании мощностей. Помимо средств на расширение бизнеса Oracle, сама OpenAI будет зависеть от возможностей привлечения капитала для финансирования сделки. Компании всё ещё не хватает средств для оплаты контракта на $300 млрд. Выручка стартап в I половине текущего финансового года составила $4,3 млрд, на 16 % больше год к году, но этого всё равно слишком мало для финансирования крупных проектов. Кроме того, OpenAI финансирует проекты, не связанные с Oracle. Не так давно компания расширила соглашение с CoreWeave на $6,5 млрд, доведя общую сумму контракта с неооблачным провайдером до $22,4 млрд. Также у компании имеются долгосрочные контракты с Microsoft, дополнительно она начала использовать Google Cloud. Ранее компания объявила, что только на аренду резервных серверов у облачных провайдеров на периоды пиковых нагрузок в следующие пять лет она потратит $100 млрд. Также подписано письмо о намерениях с NVIDIA о стремлении развернуть в её ЦОД системы компании мощностью не менее 10 ГВт. В обмен на это NVIDIA готовится инвестировать до $100 млрд в OpenAI по мере развёртывания новых ИИ-систем. При этом пока OpenAI не приносит прибыли и перспективы её выхода на самоокупаемость не вполне определённые.

01.10.2025 [13:08], Руслан Авдеев

В США заработали первые ИИ ЦОД флагманского кампуса OpenAI StargateВ Техасе (США) заработал флагманский кампус ЦОД Stargate, построенный Crusoe Energy в интересах OpenAI, Oracle и их партнёров. Crusoe сообщает, что на площадке введены в эксплуатацию первые два объекта — они используются Oracle Cloud Infrastructure (OCI) для OpenAI. Площадь зданий превышает 90 тыс. м2, общая IT-мощность — более 200 МВт. По словам представителя Crusoe, одной из задач сейчас является формирование ИИ-инфраструктуры в масштабах, необходимых для обеспечения потребностей величайших инноваторов в мире. Для этого Crusoe создаёт ИИ-фабрики будущего — вертикально интегрированную инфраструктуру — со скоростью, необходимой для обеспечения победы США в гонке ИИ. Опыт кампуса в Абилине (Abilene) — живой пример новой концепции развития крупных дата-центров. Строительство площадки началось в июне 2024 года, первые стойки NVIDIA GB200 поставлены годом позже и уже работают над обучением и инференсом. По словам представителя OCI, ИИ уже стал двигателем новой эры инноваций, а Oracle создаёт инфраструктуру, благодаря которой новое будущее станет возможным. В компании отметили, что Crusoe доказала лидерство в разработке и строительстве ИИ ЦОД и стала надёжным партнёром Oracle, способным к быстрой и масштабной работе. В марте Crusoe начала работы над второй фазой проекта на территории Lancium Clean Campus в том же городе. В рамках масштабирования планируется добавить шесть зданий, это увеличит общую площадь проекта до более 370 тыс. м2, общая мощность составит до 1,2 ГВт. Ожидается, что работы завершатся к середине 2026 года. Crusoe, Oracle и OpenAI пока не подтвердили, что весь кампус поступит в распоряжение Stargate. Ожидается, что на компанию придётся большинство новых мощностей, если не все. На прошлой неделе OpenAI уже объявила, что создаст ещё пять дата-центров Stargate в США, в том числе в Техасе, Нью-Мексико и где-то на Среднем Западе. |

|