Материалы по тегу: ocp

|

21.10.2025 [16:14], Руслан Авдеев

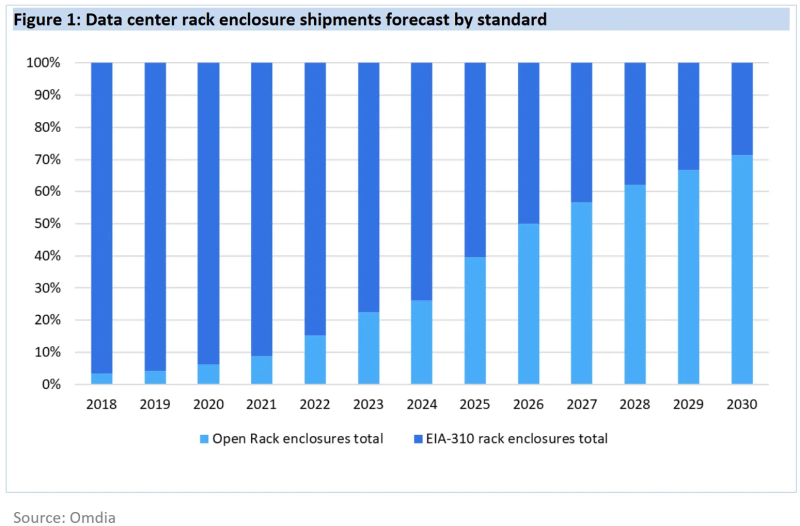

К 2030 году 21″ OCP-стойки станут доминирующим стандартом в ЦОДДата-центры намерены стандартизировать использование более крупных 21″ стоек вместо обычных 19″ к 2030 году. По данным Omdia, гиперскейлеры и производители серверов полностью поддерживают такой переход, а корпоративные ЦОД всё ещё будут придерживаться старого типоразмера, сообщает The Register. По некоторым данным, 19″ стойки (EIA-310) ведут свою «родословную» от релейных шкафов на железных дорогах — там подобный стандарт появился ещё до того, как его приняли телефонные компании, а позже и IT-индустрия. Meta✴ (Facebook✴) ещё в 2012 году столкнулась с ограничениями старого формата и основала OCP для того, чтобы организовать разработку и принятие более эффективных индустриальных стандартов. По прогнозам аналитиков, на более крупный формат, продвигаемый OCP, к концу десятилетия придётся более 70 % поставок, поскольку он активно внедряется крупными вендорами вроде Dell и HPE — одними из лидеров в гонке по выпуску ИИ-оборудования. По данным Omdia, на сегодня все крупнейшие сервис-провайдеры, включая Microsoft, Amazon, Meta✴, Google, ByteDance, Huawei и Oracle уже перешли на использование 21″ стоек в своих ЦОД. Так, Huawei ещё в 2019 году объявила, что её дата-центры будут опираться на 21″ стандарт.

Источник изображения: Meta✴ Преимуществами более крупных стоек является лучшая циркуляция воздуха и возможность устанавливать более крупные массивы вентиляторов, что улучшает охлаждение. Кроме того, такие стойки допускают установку более крупных модулей питания и трубок СЖО, что важно для ИИ-серверов. При этом сохраняется совместимость с 19″ решениями. В Omdia ожидают, что полностью укомплектованные стойки вроде NVIDIA DGX GB200 NVL72 станут фактическим стандартом. Кроме того, Dell и HPE продвигают предложенную OCP модульную серверную архитектуру Data Center Modular Hardware System (DC-MHS), которая позволяет по отдельности обновлять IO-модули и остальное «железо». Omdia прогнозирует, что на долю ИИ-серверов будет приходиться всё большая часть расходов на серверы в целом. Уже в 2024 году речь шла о 66 %, причём ключевые игроки рынка, включая гиперскейлеров и облачных ИИ-провайдеров, поддерживают именно 21″ стандарт, поэтому победа OCP над другими стандартами стала лишь вопросом времени.

16.10.2025 [16:44], Сергей Карасёв

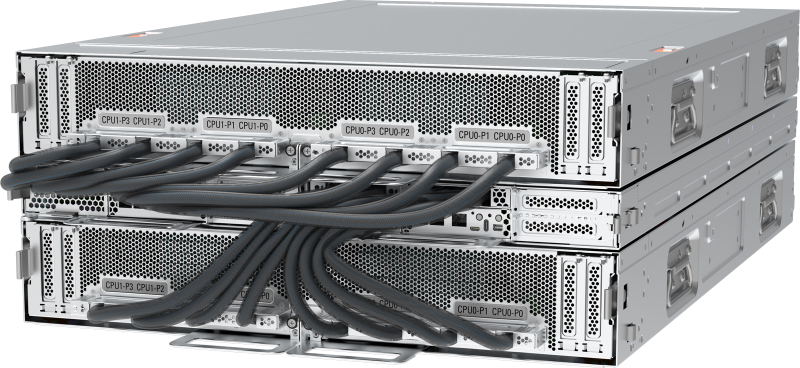

Pegatron представила ИИ-сервер AS501-4A1-16I1 с СЖО и 16 ускорителями AMD Instinct MI355XPegatron анонсировала высокопроизводительный сервер AS501-4A1-16I1 с СЖО для задач НРС, а также ресурсоёмких приложений ИИ, включая инференс и обучение больших языковых моделей. Устройство выполнено в форм-факторе 5OU на аппаратной платформе AMD. До восьми серверов AS501-4A1-16I1 могут быть установлены в стойку RA5100-128I1. Это позволяет сформировать ИИ-систему высокой плотности, насчитывающую до 32 процессоров EPYC 9005 и до 128 ускорителей Instinct MI355X. Конструкция системы включает два CPU-узла и два лотка GPU. Каждая из CPU-секций допускает установку двух процессоров AMD EPYC 9005 Turin с показателем TDP до 500 Вт и 24 модулей оперативной памяти DDR5-6400 RDIMM. Таким образом, в общей сложности могут быть задействованы четыре чипа EPYC и 48 модулей ОЗУ. В свою очередь, каждый из GPU-лотков оснащается восемью ускорителями AMD Instinct MI355X, которые несут на борту 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. В общей сложности реализованы 12 слотов PCIe 5.0 x16 FHHL, в которые установлены десять однопортовых сетевых адаптеров 400GbE и два двухпортовых адаптера 10GbE В оснащение входят контроллер Aspeed AST2600, два сетевых порта 1GbE (RJ45), выделенный сетевой порт управления (RJ45), последовательный порт (разъём Micro-USB), интерфейсы USB 2.0 Type-C и Mini-DP. В дополнение к СЖО имеются десять вентиляторов охлаждения. Применяется шина питания ORv3 на 48 В DC.

16.10.2025 [13:39], Руслан Авдеев

Унификация, стандартизация, совместимость: Google призвала создавать взаимозаменяемые компоненты для ИИ ЦОДВ ходе мероприятия OCP Summit компания Google выступила с общеотраслевой инициативой «переосмысления» архитектуры ЦОД, оптимизированных для эпохи ИИ. В рамках сообщества Open Compute Project (OCP) предлагается создать рабочее направление по разработке «гибких, взаимозаменяемых ЦОД», сообщает пресс-служба компании. Google подчеркнула, что скорость внедрения и неоднородность ИИ-технологий растёт, что затрудняет создание общей системы, проектирования, развёртывания и обслуживания ЦОД. Представленный Google проект предусматривает создание модульных, совместимых друг с другом решений для ЦОД, позволяющих легко адаптироваться к стремительному развитию ИИ и изменению рабочих нагрузок. Говорится о «начале революции» в сфере ИИ — мир радикально изменился и необходимо создавать дата-центры, способные меняться не менее быстро. По данным компании, за последние 24 месяца использование ИИ-ускорителей внутри Google увеличилось в 15 раз, объём хранилищ для машинного обучения Hyperdisk ML — в 37 раз, а количество обработанных токенов — до двух квадрлн/мес. В Google сравнивают исследователей ИИ с исследователями космоса, а участников OCP, строителей инфраструктуры — со строителями ракет. Сама инфраструктура компании, как утверждается, поддерживает ИИ-трансформацию на всех уровнях экосистемы, от пользовательских приложений (на основе Gemini) до корпоративных сервисов и научных изысканий в самых разных областях. Особое внимание уделяется обеспечению взаимозаменяемости и гибкости: модульные компоненты, спроектированные различными участниками отрасли, должны быть совместимы с компонентами и системами других поколений и вендоров, причём принципы унификации должны применяться ко всем компонентам ЦОД, включая электропитание, охлаждение, вычислительное оборудование, сетевые технологии и др. Стратегия самой Google строится вокруг т.н. ИИ-гиперкомпьютера — комплексной архитектуры, в которой все компоненты от чипов до электросетей разработаны с учётом общих особенностей системы для обеспечения максимальной эффективности. Благодаря использованию собственных TPU, оптических коммутаторов и СЖО, компания добилась роста энергоэффективности и снижения затрат в 10–100 раз за последние 10 лет. Google уже развернула мегаваттами инфраструктуры с жидкостным охлаждением. Компания вместе с партнёрами организовала в рамках OCP рабочую группу, целью которой является создание единых стандартов обеспечения модульности и совместимости компонентов, а также общих интерфейсов в области вычислений, сетей, хранилищ, безопасности и устойчивости. В частности, участники OCP договорились о разработке гибких систем электропитания для современных ЦОД. Речь идёт о стандартизации 400-В архитектур и модульных системах Mt. Diablo с использованием твердотельных преобразователей. Также ведутся работы в сфере микросетей и аккумуляторных хранилищ. Всё вместе это позволит сглаживать пики потребления энергии, характерные для обучения ИИ, а в перспективе и возвращать излишки энергии обратно в энергосети. Охлаждение также переосмысливается в эпоху ИИ. В начале 2025 года OCP представлено современное решение для жидкостного охлаждения Project Deschutes. Теперь оно получит широкое распространение среди вендоров, включая поставщиков жидкостного охлаждения вроде Boyd, CoolerMaster, Delta, Envicool, Nidec, nVent и Vertiv. Сообщество работает над унификацией интерфейсов охлаждения, новых теплообменников. Важную роль играет стандартизация компонентов и интерфейсов в колокейшн- и сторонних ЦОД. Наконец, Google подчёркивает необходимость унификации физических стандартов: высоты, ширины, глубины и даже грузоподъёмности стоек; ширины и планировки проходов, интерфейсов стоечного и сетевого оборудования. Также требуются единые стандарты для телеметрии и мехатроники, которые лягут в основу строительства и эксплуатации дата-центров следующего поколения. Совместно с партнёрами по OCP ведутся работы над стандартизацией интеграции телеметрии для сторонних дата-центров. Помимо физической инфраструктуры, по словам Google, необходимо внедрение открытых стандартов для обеспечения масштабируемости и безопасности систем:

Для измерения воздействия на окружающую среду предложена методология измерения потребления энергии, воды и подсчёта выбросов в ходе ИИ-нагрузок. В частности, с их помощью выяснилось, что медианный промпт Gemini тратит менее 5 капель воды и электричество в объёме, достаточном для просмотра телевизора в течение менее девяти секунд. Эти методы подсчёта касаются и других, совместных с OCP проектов, включая выпуск экобезопасного бетона, чистой резервной энергии и др. Google приглашает принять участие в инициативе OCP Open Data Center for AI Strategic для разработки общих стандартов. Наконец, сообщество OCP призвали работать над проектами «ИИ для ИИ» — использованием искусственного интеллекта для разработки ИИ-систем следующего поколения. Так, проект AlphaChip предусматривает использование ИИ для размещения компонентов чипов, что уже позволило улучшить показатели мощности, производительности и др., одновременно сократив время проектирования. Предполагается, что создание ИИ систем с помощью ИИ, от полупроводников до программного обеспечения, позволит достигнуть нового уровня эффективности технологий.

14.10.2025 [19:00], Сергей Карасёв

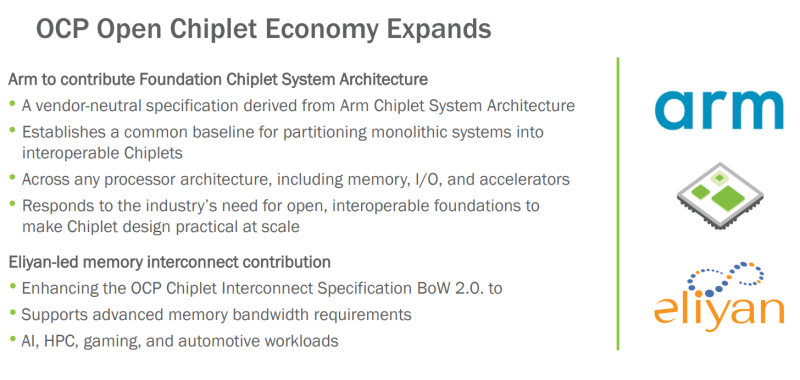

OCP поможет в унификации чиплетов с применением открытых стандартов: Arm и Eliyan поделились наработкамиНекоммерческая организация Open Compute Project Foundation (OCP) сообщила о расширении так называемой «открытой чиплетной экономики» (Open Chiplet Economy). Свои наработки в данной сфере сообществу передали компании Arm и Eliyan. Open Chiplet Economy — это инициатива OCP Server Project Group. Она позволяет разработчикам чиплетов посредством открытого рынка взаимодействовать с производителями продукции. Речь идет о формировании унифицированной экосистемы, за поддержание которой в актуальном состоянии отвечает OCP. В рамках проекта компания Arm передала организации OCP и её участникам архитектуру FCSA (Foundation Chiplet System Architecture), основанную на CSA (Chiplet System Architecture). Она определяет общие базовые стандарты для разделения монолитных систем на чиплеты, которые затем могут использоваться в составе различных изделий, включая память, устройства ввода-вывода и ускорители. Такой подход, как ожидается, упростит создание новых продуктов благодаря повторному использованию уже разработанных блоков. Кроме того, повысится гибкость за счёт отказа от привязки к проприетарным стандартам чиплетов. В свою очередь, Eliyan предоставит сообществу разработки, которые помогут расширить спецификацию интерконнекта для чиплетов OCP BoW 2.0 (Bunch of Wires). В частности, будут добавлены функции для систем, которым требуется высокая пропускная способность: это могут быть приложения ИИ, НРС, игры, автомобильные платформы и пр. Целевым показателем является поддержка скоростей памяти HBM4 (2 Тбайт/с для чтения или записи) вместе с дополнительным каналом связи для сигналов ECC и управления.

14.10.2025 [09:54], Сергей Карасёв

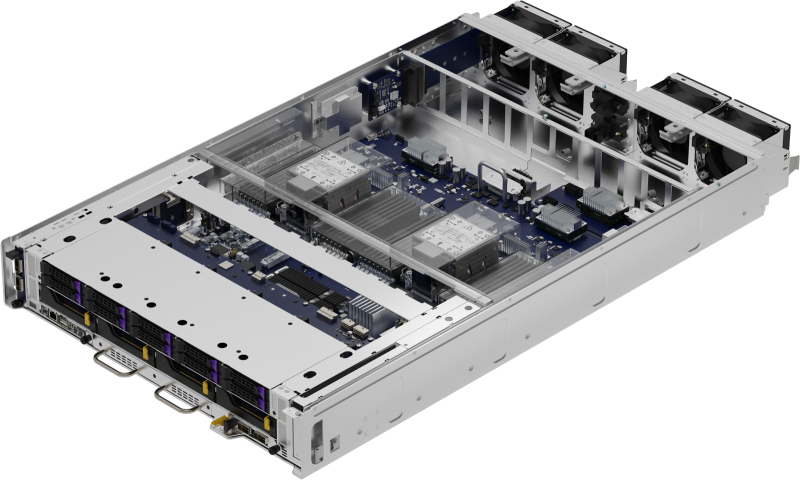

Giga Computing представила ИИ-сервер TO86-SD1 на платформе NVIDIA HGX B200Компания Giga Computing, подразделение Gigabyte, анонсировала высокопроизводительный сервер TO86-SD1 для обучения ИИ-моделей, инференса и ресурсоёмких HPC-задач. Новинка выполнена в форм-факторе 8OU в соответствии со стандартом OCP ORv3. Возможна установка двух процессоров Intel Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400 или MRDIMM 8000). Во фронтальной части предусмотрены отсеки для восьми SFF-накопителей с интерфейсом PCIe 5.0 (NVMe); поддерживается горячая замена. Есть коннектор M.2 2280/22110 для SSD (PCIe 5.0 x4). Упомянута поддержка CXL 2.0. Сервер несёт на борту ИИ-ускорители NVIDIA HGX B200 поколения Blackwell в конфигурации 8 × SXM. Суммарный объём памяти HBM3E составляет 1,4 Тбайт. Доступны 12 слотов PCIe 5.0 x16 для карт расширения FHHL с доступом через лицевую панель корпуса. Говорится о совместимости с NVIDIA BlueField-3 DPU и NVIDIA ConnectX-7 NIC.

Источник изображения: Giga Computing В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на базе Intel X710-AT2, выделенный сетевой порт управления 1GbE, разъёмы USB 3.2 Gen1 Type-C, Micro-USB и Mini-DP. Применяется система воздушного охлаждения с четырьмя 92-мм вентиляторами в области материнской платы и двенадцатью 92-мм кулерами в GPU-секции. Диапазон рабочих температур — от +10 до +35 °C. Заявлена совместимость с Windows Server, RHEL, Ubuntu, Citrix, VMware ESXi.

14.10.2025 [02:00], Сергей Карасёв

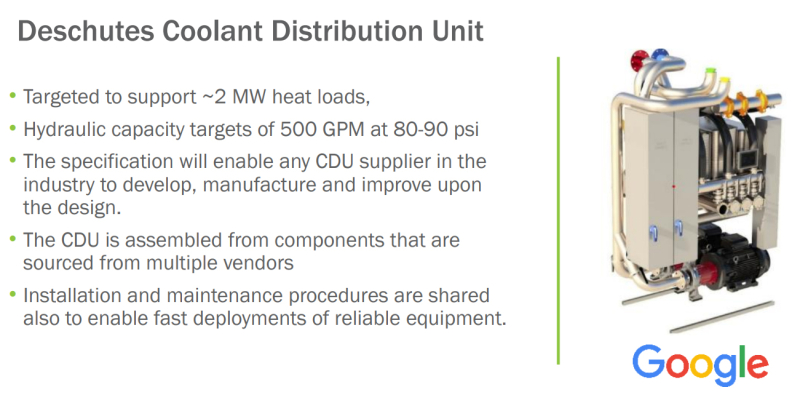

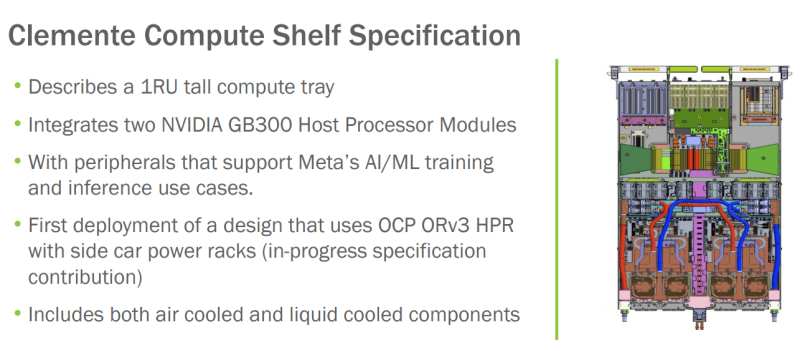

OCP запустила инициативу Open Data Center for AI для стандартизации инфраструктуры передовых ИИ ЦОД с мегаваттными стойкамиНекоммерческая организация Open Compute Project Foundation (OCP) анонсировала инициативу Open Data Center for AI по стандартизации компонентов физической инфраструктуры дата-центров, ориентированных на задачи ИИ и другие ресурсоёмкие нагрузки. Проект Open Data Center for AI является частью программы OCP Open Systems for AI, которая была представлена в январе 2024 года при участии Intel, Microsoft, Google, Meta✴, NVIDIA, AMD, Arm, Ampere, Samsung, Seagate, SuperMicro, Dell и Broadcom. Цель заключается в разработке открытых стандартов для кластеров ИИ и ЦОД, в которых размещаются такие системы. Запуск Open Data Center for AI продиктован быстрым развитием экосистемы дата-центров, результатами, полученными в рамках OCP Open Systems for AI, и новым открытым письмом о сотрудничестве, подготовленным Google, Meta✴ и Microsoft. В настоящее время, как отмечается, отрасль ЦОД сталкивается с проблемами, связанными с тем, что разрозненные усилия её участников, включая гиперскейлеров и колокейшн-провайдеров, порождают различные требования к проектированию инфраструктуры. Это замедляет внедрение инноваций и увеличивает сроки развёртывания передовых площадок. Цель Open Data Center for AI заключается в том, чтобы стандартизовать требования к системам электропитания, охлаждения и телеметрии, а также к механическим компонентам в ЦОД. Предполагается, что это обеспечит взаимозаменяемость элементов физической инфраструктуры дата-центров. При реализации инициативы Open Data Center for AI планируется использовать уже имеющиеся наработки сообщества OCP в области блоков распределения охлаждающей жидкости (CDU) и блоков распределения питания (PDU). Это, в частности, проект Mt. Diablo, который реализуется Meta✴, Microsoft и Google. Он предполагает создание общих стандартов электрических и механических интерфейсов. Идея заключается в разделении стойки на независимые шкафы для компонентов подсистемы питания и вычислительного оборудования. При этом планируется переход от единой шины питания постоянного тока с напряжением 48 В на архитектуру 400 В DC (Diablo 400). Ещё одним проектом, наработки которого пригодятся в рамках Open Data Center for AI, назван CDU Deschutes, разработанный Google. Это решение с резервными теплообменниками и насосами обеспечивает уровень доступности 99,999 %. Система Deschutes рассчитана на тепловые нагрузки до 2 МВт. Открытая спецификация позволит любой компании совершенствовать конструкцию CDU и производить изделия данного типа. Наконец, упоминаются серверные шасси Clemente, разработанные в Meta✴. Это узлы 1U, содержащие два суперчипа NVIDIA Grace Blackwell GB300 для ресурсоёмких ИИ-нагрузок. Платформа предполагает применение жидкостного охлаждения для CPU, GPU и коммутатора, а также воздушного охлаждения для других компонентов.

22.09.2025 [16:44], Сергей Карасёв

OpenYard представила российский GPU-сервер HN203I на базе Intel Xeon 6Российский разработчик и производитель серверного оборудования OpenYard сообщил о создании флагманской системы HN203I на аппаратной платформе Intel Xeon 6. Сервер выполнен в формате 2OU в соответствии со стандартом Open Rack v3.0 (опционально Open Rack v2.2). «HN203I — это технологический скачок для российской серверной индустрии. Мы создаём флагманскую платформу, которая сочетает в себе максимальную производительность, энергоэффективность и простоту эксплуатации», — говорит компания. Возможна установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 с поддержкой изделий RDIMM ёмкостью до 128 Гбайт и 3DS RDIMM ёмкостью до 256 Гбайт. Таким образом, максимальный объём ОЗУ составляет 8 Тбайт. В оснащение входят восемь слотов PCIe 5.0 x16 MCIO и три слота PCIe 5.0 x4 MCIO, разъём OCP 3.0 (PCIe 5.0 x16), два коннектора M.2 M-Key (PCIe 5.0 x2 и PCIe 5.0 x4), а также разъём M.2 Key E (PCIe 5.0 x1). Допускается монтаж десяти SFF-накопителей (NVMe) с возможностью горячей замены и четырёх LFF-устройств с интерфейсом SATA/SAS. Кроме того, могут быть установлены до четырёх PCIe-ускорителей NVIDIA H100/L40/L40S/L4. Модель HN203I располагает контролером ASPEED AST2600, двумя сетевыми портами управления RJ45 (по одному спереди и сзади), двумя портами USB 3.0 Type-A, интерфейсом mini-DP. Применено воздушное охлаждение, а диапазон рабочих температур простирается от +10 до +40 °C. Максимальная мощность блоков питания — 5500 Вт. Габариты составляют 537 × 801,6 × 93 мм. Управление осуществляется через BIOS OpenYard и систему OYBMC. Сервер подходит для ИИ-нагрузок, облачных сервисов, телеком-задач и гиперскейл-инфраструктуры.

22.09.2025 [11:40], Сергей Карасёв

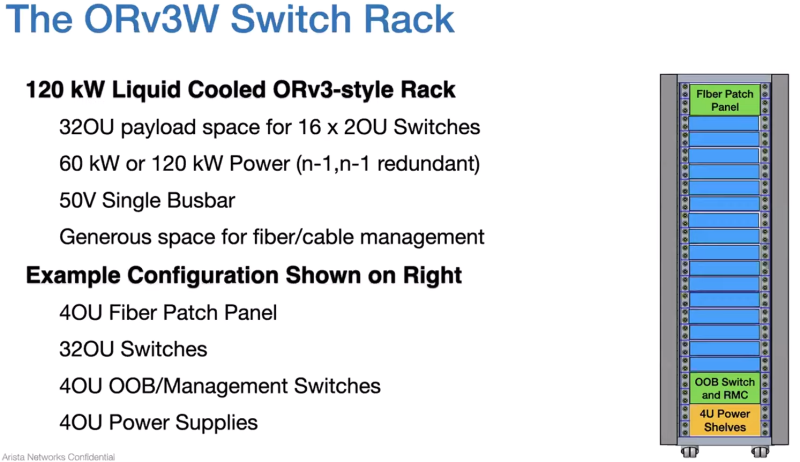

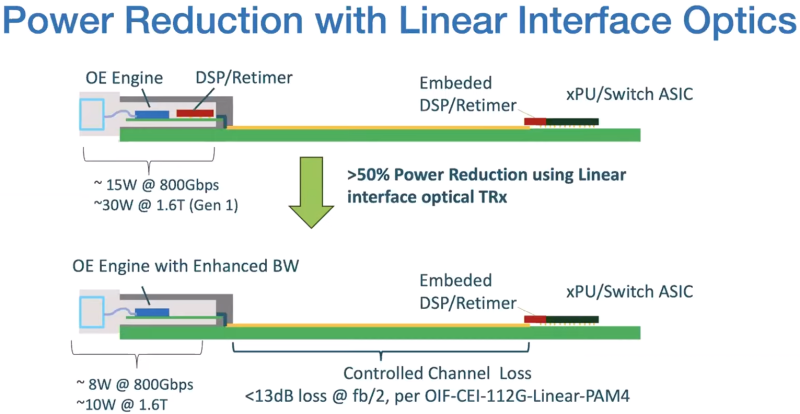

Arista проектирует коммутаторы с СЖО для ИИ ЦОДКомпания Arista, по сообщениям интернет-источников, поделилась планами по созданию оборудования для дата-центров. В разработке в числе прочего находятся коммутаторы и серверные стойки с жидкостным охлаждением. Как рассказал соучредитель Arista Андреас Бехтольшайм (Andreas Bechtolsheim), проектируемые коммутаторы будут на 100 % использовать СЖО. Это, как ожидается, обеспечит экономию электроэнергии на системном уровне от 5 % до 10 % в зависимости от температуры и повысит надёжность из-за отсутствия вибраций, вызываемых вентиляторами. NVIDIA уже анонсировала свои коммутаторы с СЖО. Кроме того, разрабатывается серверная стойка стандарта ORv3W, поддерживающая мощность до 120 кВт. Она сможет вместить до 16 2OU-коммутаторов, а также блоки управления, силовые полки и коммутационные панели. Стойка будет оснащена специальными фитингами для развёртывания СЖО и единой шиной питания. По словам Бехтольшайма, значительная часть разработок Arista связана с новыми системами охлаждения. Применение СЖО позволит создавать конфигурации с высокой плотностью размещения коммутаторов. Это важно в свете строительства ЦОД нового поколения, ориентированных на ресурсоёмкие задачи ИИ и НРС. Соучредитель Arista также затронул тему LPO (Linear Pluggable Optics) — технологии, которая позволяет формировать прямые соединения между оптоволоконными модулями, устраняя необходимость в традиционных компонентах вроде цифровых сигнальных процессоров (DSP). Бехтольшайм отмечает, что LPO может обеспечить дополнительную экономию энергии на 20 % по сравнению с другими оптическими системами. По его мнению, в перспективе данная технология будет востребована в сетях, поддерживающих приложения ИИ.

09.09.2025 [17:50], Сергей Карасёв

Бескабельные серверы и стойки Softbank помогут роботам вытеснить людей из ЦОДКорпорация SoftBank объявила о разработке новой стойки для серверов без кабелей. Это поможет в организации обслуживания ЦОД при помощи специализированных роботов. Стойка упрощает выполнение таких задач, как установка и демонтаж модулей, замена компонентов в случае неисправности и проведение автоматизированных проверок. В современных ЦОД большое количество кабелей внутри серверных стоек является серьёзным препятствием для выполнения тех или иных работ с использованием роботов. Из-за плотной кабельной сети затрудняется точное определение и управление целевым оборудованием в стойке, что негативно отражается на возможностях автоматизации обслуживания. Для решения данной проблемы SoftBank разработала серверную стойку с «бескабельной конструкцией».

Источник изображений: SoftBank Новинка имеет ширину 19″: она выполнена в соответствии со стандартом OCP ORv3 (Open Rack v3). Говорится о совместимости с системами жидкостного охлаждения. Стойка рассчитана на монтаж серверов общего назначения. Питание подаётся по общей шине на задней стороне стойки. В системе охлаждения используется «слепой разъём», упрощающий соединение магистралей СЖО. Для передачи данных служит оптический интерфейс. Таким образом, при установке серверы могут просто задвигаться в стойку без необходимости подключения кабелей.  В настоящее время SoftBank готовится к тестированию стоек в реальных условиях с использованием специализированных роботов для обслуживания. Проект является частью программы SoftBank по внедрению автоматизации в дата-центре для задач ИИ на острове Хоккайдо, открытие которого запланировано на 2026 финансовый год. Нужно отметить, что робототехнические комплексы для выполнения рутинных задач в ЦОД тестируют и многие другие компании. В их число входят Google, Digital Edge, Digital Realty, Scala Data Centers и Oracle. Правда, пока речь идёт в основном о патрулировании и выполнении некоторых простейших с точки зрения человека операций.

01.09.2025 [23:40], Руслан Авдеев

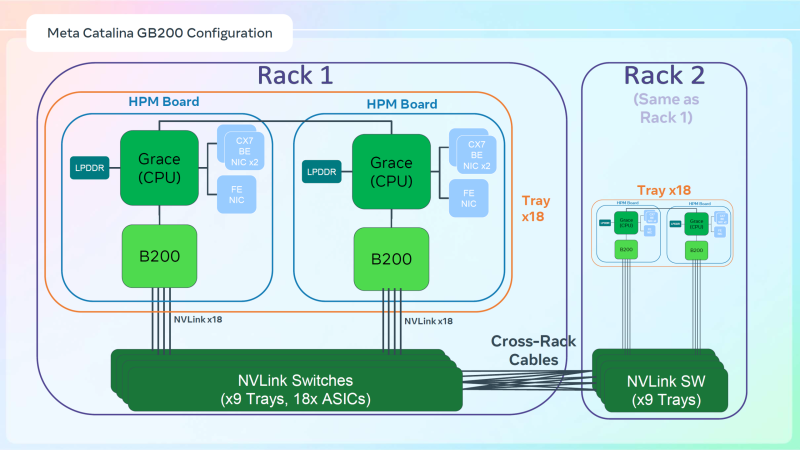

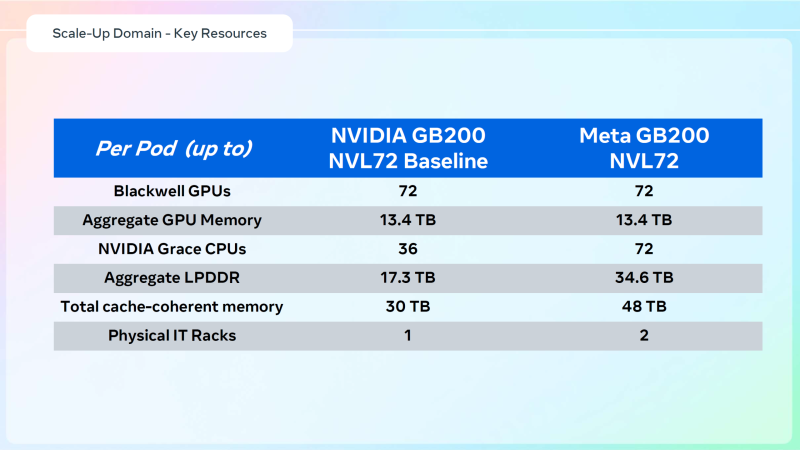

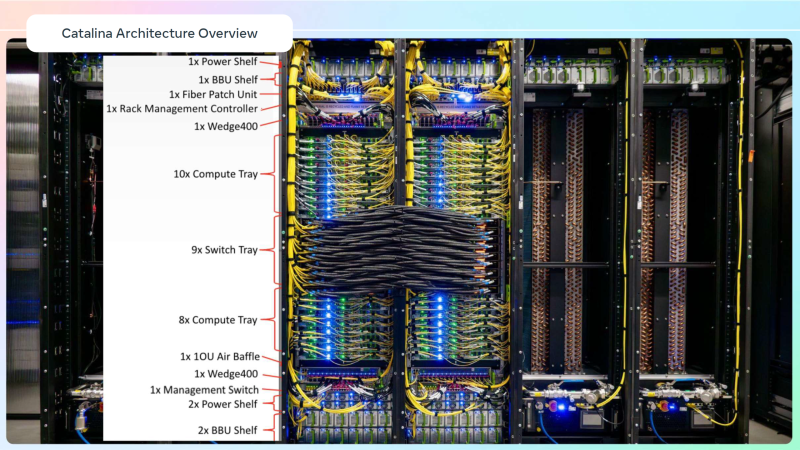

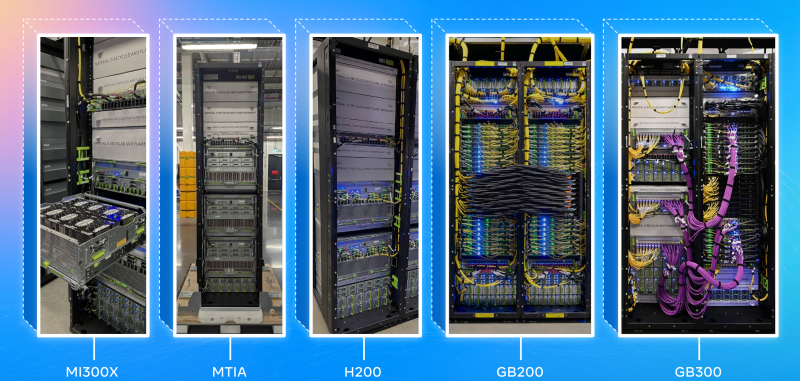

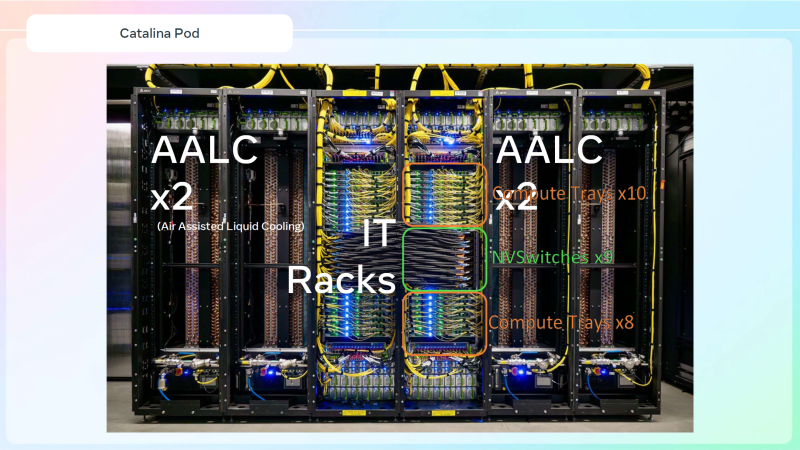

Meta✴ «растянула» суперускорители NVIDIA GB200 NVL36×2 на шесть стоек, чтобы обойтись воздушным охлаждениемДля того, чтобы развернуть в традиционных ЦОД с воздушным охлаждением современные высокоплотные стойки с ИИ-ускорителями, приходится идти на ухищрения. Один из вариантов предложила Meta✴, передаёт Wccftech. Хотя у Meta✴ есть собственный полноценный вариант суперускорителя NVIDIA GB200 NVL72 на базе ORv3-стоек Catalina (до 140 кВт) со встроенными БП и ИБП, компания также разработала также вариант, схожий с конфигурацией NVL36×2, от производства которого NVIDIA отказалась, посчитав его недостаточно эффективным. Ускоритель NVL36×2 задумывался как компромиссный вариант для ЦОД с воздушным охлаждением — одна стойка (плата Bianca, 72 × B200 и 36 × Grace) «растянута» на две.

Источник изображений: Meta✴ via Wccftech Meta✴ пошла несколько иным путём. Она точно так же использует две стойки, одна конфигурация узлов другая. Если в версии NVIDIA в состав одно узла входят один процессор Grace и два ускорителя B200, то у Meta✴ соотношение CPU к GPU уже 1:1. Все вместе они точно так же образуют один домен с 72 ускорителями, но объём памяти LPDDR5 в два раза больше — 34,6 Тбайт вместо 17,3 Тбайт. Эту пару «обрамляют» четыре стойки — по две с каждый стороны. Для охлаждения CPU и GPU по-прежнему используется СЖО, теплообменники которой находятся в боковых стойках и продуваются холодным воздухом ЦОД. Это далеко не самая эффективная с точки зрения занимаемой площади конструкция, но в случае гиперскейлеров оплата в арендуемых дата-центрах нередко идёт за потребляемую энергию, а не пространство. В случае невозможности быстро переделать собственные ЦОД или получить площадку, поддерживающую высокоплотную энергоёмкую компоновоку стоек и готовую к использованию СЖО, это не самый плохой вариант. В конце 2022 года Meta✴ приостановила строительство около дюжины дата-центров для пересмотра их архитектуры и внедрения поддержки ИИ-стоек и СЖО. Первые ЦОД Meta✴, построенные по новому проекту, должны заработать в 2026 году, передаёт DataCenter Dynamics. На сегодня у Meta✴ около 30 действующих или строящихся кампусов ЦОД, большей частью на территории США. Планируются ещё несколько кампусов, включая гигаваттные. Также компания выступает крупным арендатором дата-центров, а сейчас в пылу гонки ИИ и вовсе переключилась на быстровозводимые тенты вместо капитальных зданий, лишённые резервного питания и традиционных систем охлаждения. Собственные версии GB200 NVL72 есть у Google, Microsoft и AWS. Причём все они отличаются от эталонного варианта, который среди крупных игроков, похоже, использует только Oracle. Так, AWS решила разработать собственную СЖО, в том числе из-за того, что ей жизненно необходимо использовать собственные DPU Nitro. Google ради собственного OCS-интерконнекта «пристроила» к суперускорителю ещё одну стойку с собственным оборудованием. Microsoft же аналогично Meta✴ добавила ещё одну стойку с теплообменниками и вентиляторами. |

|