Материалы по тегу: hardware

|

13.08.2025 [13:39], Руслан Авдеев

Британский комитет по борьбе с засухой предложил удалить старые фотографии и письма, чтобы сократить водопотребление ЦОДСпециальная Национальная группа по борьбе с засухой NDG (National Drought Group), координационный проект правительства и промышленности Великобритании, предложила удалять старые фотографии и электронные письма, полагая, что это поможет сэкономить немало воды, которой в стране не хватает — сообщает Datacenter Dynamics. Впрочем, предложены и более традиционные меры, например, сокращение времени принятия душа и устранение утечек из водопроводов на национальном уровне. В NDG входят представители Метеорологического бюро, правительства, регуляторов, водоснабжающих организаций, Национального союза фермеров, экспертов по охране природы и др. Как заявляют в организации, простые действия вроде закрытия вовремя крана или удаления старых писем способствуют снижению спроса на воду и помогают сохранять «здоровье» рек и дикой природы. Официально от засухи страдают пять регионов Англии, ещё шесть переживают самый «продолжительный период сухой погоды» с 1976 года. Засуха ставит под угрозу сельское хозяйство, водно-болотные угодья и реки. Пока неизвестно, сколько воды можно сэкономить, если граждане удалят электронные письма или фотографии. Расход воды в ЦОД не является постоянным, а на объектах часто используются самые разные системы охлаждения, в том числе замкнутого цикла. Сами ЦОД редко предоставляют данные о них, так что информации об общем объём водопотребления в секторе ЦОД в Великобритании попросту нет. Например, дата-центры Microsoft по всему миру в 2024 финансовом году использовали 10,4 млн м³ воды, безвозвратно потребив 5,8 млн м³ — это обеспечило около 5 ГВт вычислительных мощностей. При этом рынок дата-центров Великобритании оценивается примерно в 2 ГВт. В 2022 году британские дата-центры сами пострадали от аномальной жары и засухи. Тогда произошла целая серия сбоев, а некоторые операторы прибегли к нестандартным решениям, например, поливая из шлангов внешние блоки систем кондиционирования ЦОД. Годом позже коммунальная служба Thames Water пригрозила некоторым операторам урезать подачу воду или взвинтить цены, если те не снизят расход. Из-за изменения климата дата-центрам со временем будет всё труднее поддерживать стабильность работы. Стоит отметить, что потребление воды прямо связано и с расходом электричества, тем более что Великобритания намерена превратиться в «ИИ-сверхдержаву». Фактически, как считают эксперты, хранение небольших файлов вроде электронных писем или изображений не приведёт к значительному расходу воды. К этому приведёт эксплуатация ИИ-моделей, которые будут обучаться на сохранённых данных — в совокупности вырастет как расход воды, так и электроэнергии. Британское правительство настойчиво продвигает строительство большего числа ЦОД в стране, к 2030 году предполагается достигнуть уровня порядка 6 ГВт. Королевская инженерная академия (Royal Academy of Engineering) заявила, что правительство должно сделать обязательной для ЦОД отчётность по потреблению энергии, источникам энергии, потреблению и забору воды, источникам водоснабжения, выбросам углерода, переработке электронных отходов и PUE. Правда, на днях сообщалось, что Великобритания не станет соревноваться с США и Китаем в гонке ИИ, а сосредоточится на его внедрении. Возможно, это поможет сэкономить часть ресурсов.

13.08.2025 [13:24], Руслан Авдеев

Южнокорейский разработчик ИИ-чипов DeepX объединился с Baidu для выхода на рынок КНРЮжнокорейская DeepX, разрабатывающая ИИ-ускорители, заключила соглашение с китайским гиперскейлером Baidu. Компании намерены оптимизировать разрабатываемую Bailu ИИ-платформу Ernie LLM для оборудования DeepX, сообщает EE Times. В DeepX заявляют, что речь идёт о первом официальном сотрудничестве компании с одной из ключевых китайских ИИ-экосистем. Интеграция ускорителей DeepX с моделями Baidu PaddlePaddle и Ernie позволят южнокорейской компании получить прямой доступ к одному из крупнейших сообществ разработчиков ИИ в Китае. Это ускорит выход стартапа на китайский рынок и обеспечит надёжную проверку его технологий одним из мировых лидеров в сфере искусственного интеллекта. Недавно компания привлекла Morgan Stanley для управления очередным раундом финансирвоания. В прошлом году в ходе раунда финансирования серии C компания привлекла порядка $80 млн, теперь, по данным Bloomberg, она намерена получить значительно больше — незадолго до выхода на IPO в 2027 году. Компания считает себя конкурентом NVIDIA в некоторых секторах. PaddlePaddle представляет собой открытую платформу для глубокого обучения, разработанную компанией Baidu. Она является ключевым фреймворком для ИИ в Китае и представляет собой аналог западным решениям вроде PyTorch или Jax. PaddlePaddle включает готовые предобученные модели, инструменты для разработки и оптимизации ИИ-приложений. В экосистеме PaddlePaddle более 10 млн разработчиков и 200 тыс. предприятий, которые работают над сценариями использования ИИ для обработки зрения, речи и естественного языка. Также предлагается «бесшовная интеграция» с китайскими облачными платформами.

Источник изображения: DeepX Китай — один из крупнейших быстрорастущих рынков ИИ в мире, особенно в сфере промышленного ИИ, робототехники и умных устройств. Выход на китайский рынок при поддержке Baidu даёт DeepX возможность быстро масштабировать внедрение. Поэтому изначально партнёрство в рамках технологической системы PaddlePaddle будет сосредоточено на промышленном ИИ. Планируется, что компании станут совместно разрабатывать промышленные продукты, обеспечив совместимость технологий. Сообщается, что компании сосредоточатся на промышленных приложениях для распознавания символов (OCR), дронов, робототехники, также изучаются и варианты инновационного использования — в умных городах, автопромышленности и потребительской электронике. Сотрудничество закладывает основу для широкого внедрения ИИ в секторах, где энергоэффективность имеет критически важное значение. Перед подписанием соглашения DeepX продемонстрировала работу ускорителя DX-M1 с моделями Baidu — PP-OCR пятого поколения и VLM. Теперь команды Baidu, включая PaddlePaddle и Ernie, будут адаптировать свои модели для чипов DX-M1 и будущего DX-M2. Прототипы DX-M2, выполненные по 2-нм техпроцессу Samsung, собираются использовать для демонстрации крупной модели ERNIE-4.5-VL-28B-A3B. DeepX также собрала 10 моделей на базе OpenVino для DX-M1, чтобы их можно было использовать совместно с экосистемой PaddlePaddle. По имеющимся данным, существующие клиенты DeepX в Китае работают в сфере промышленных ПК, робототехники и модулей интеллектуальных камер. Благодаря экосистеме Baidu предполагается ускорить коммерческое внедрение, начиная с текущего года.

13.08.2025 [12:28], Сергей Карасёв

CoreWeave продолжает нести убытки, несмотря на трёхкратный рост выручкиКомпания CoreWeave, предоставляющая облачные услуги для ИИ-задач, отрапортовала о работе во II квартале текущего года. Выручка за трёхмесячный период, закончившийся 30 июня, достигла $1,21 млрд. Это примерно в три раза больше по сравнению с результатом годичной давности, когда было получено $395,37 млн. Вместе с тем CoreWeave продолжает нести убытки. Они составили $290,51 млн, или 60 центов в пересчёте на одну ценную бумагу. Для сравнения, во II четверти 2024 года потери находились на уровне $323,02 млн, или $1,62 на акцию. Капитальные затраты достигли исторического максимума в $2,9 млрд, что связано с активным развитием инфраструктуры дата-центров с серверами, оборудованными дорогостоящими ИИ-ускорителями. CoreWeave завершила второй квартал с активными мощностями около 470 МВт и законтрактованными мощностями в 2,2 ГВт в 33 ЦОД. Компания также строит новый кампус в Кенилворте (Kenilworth) в американском штате Нью-Джерси мощностью до 250 МВт: введение этого объекта в эксплуатацию запланировано на 2026 год. В общей сложности с начала 2025-го капитальные затраты CoreWeave достигли $4,8 млрд. «Мы быстро расширяем бизнес, стремясь удовлетворить беспрецедентный спрос на ИИ. Наша специализированная облачная платформа для ИИ продолжает устанавливать новые стандарты производительности и масштабируемости. CoreWeave стала первой компанией, предложившей полный спектр ускорителей NVIDIA Blackwell в масштабе», — говорит Майкл Интратор (Michael Intrator), соучредитель, председатель совета директоров и генеральный директор CoreWeave. Операционная прибыль компании в годовом исчислении сократилась с $77,72 млн до $19,21 млн. Скорректированный показатель EBITDA (прибыль до вычета процентов, налогов и амортизационных отчислений) составил $753,17 млн против $249,84 млн во II четверти 2024 года.

13.08.2025 [11:51], Сергей Карасёв

HPE представила серверы ProLiant с ускорителями NVIDIA RTX Pro 6000 Blackwell Server EditionКомпания HPE анонсировала серверы ProLiant DL385 Gen11 и ProLiant Compute DL380a Gen12, построенные соответственно на аппаратной платформе AMD и Intel. Устройства оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition, которые ориентированы на требовательные приложения ИИ и рендеринг высококачественной графики. Модель ProLiant DL385 Gen11 выполнена в форм-факторе 2U. Она может нести на борту два процессора AMD EPYC 9004 (Genoa) или EPYC 9005 (Turin), а также до 6 Тбайт оперативной памяти DDR5-6000 в конфигурации 12 × 512 Гбайт. Поддерживаются до восьми слотов PCIe 5.0 и до двух слотов OCP. Установлены две карты RTX Pro 6000 Blackwell Server Edition. В зависимости от модификации во фронтальной части могут располагаться до 12 отсеков для накопителей LFF HDD/SSD с интерфейсом SAS/SATA, до 24 отсеков для устройств SFF HDD/SSD (SAS/SATA/NVMe), до 36 посадочных мест для изделий EDSFF E3.S 1T или до 48 отсеков для SFF HDD/SSD.  Внутри могут размещаться до восьми устройств SFF SAS/SATA/NVMe или до четырёх LFF SAS/SATA, сзади — два накопителя SFF SAS/SATA/NVMe или четыре LFF SAS/SATA. Кроме того, есть два коннектора M.2 NVMe. Применяется воздушное охлаждение с возможностью опционального развёртывания прямого жидкостного охлаждения Direct Liquid Cooling (DLC). Мощность блоков питания — до 2200 Вт. Сервер оснащён системой удалённого управления iLO 6.  В свою очередь, ProLiant Compute DL380a Gen12 имеет формат 4U. Это устройство комплектуется двумя чипами Intel Xeon 6, насчитывающими до 144 ядер. Объём оперативной памяти DDR5 достигает 4 Тбайт в виде 32 модулей. Допускается установка до восьми GPU, накопителей SFF (NMVe) и EDSFF. Питание обеспечивают восемь блоков. Упомянута система HPE iLO 7. В продажу данная модель поступит в сентябре текущего года.

13.08.2025 [09:07], Руслан Авдеев

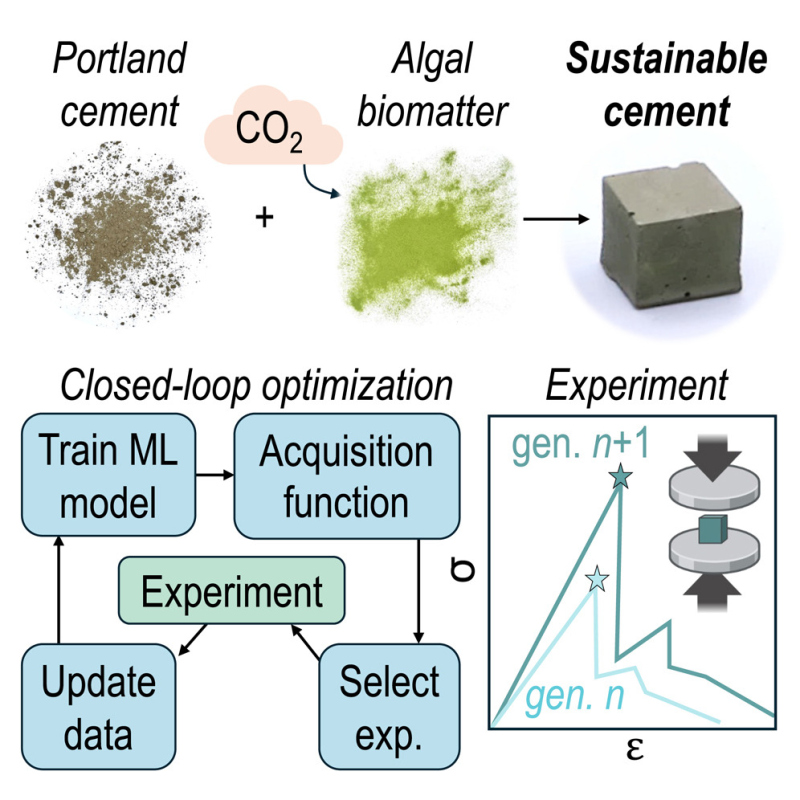

Microsoft и Вашингтонский университет создали «зелёный» цемент из водорослейMicrosoft совместно с Вашингтонским университетом (University of Washington, Сиэтл) занялась созданием низкоуглеродного цемента с использованием водорослей. Часть традиционной смеси исследователи заменили на водоросли, в частности, ульву (Ulva) — быстрорастущее, «углеродно-отрицательное» морское растение, которое можно выращивать без использования наземных площадей, сообщает Datacenter Dynamics. Подробные результаты исследования опубликованы в журнале Matter. Сообщается, что водоросли подвергали обезвоживанию перед добавлением в цементную смесь, что упрощает изготовление последней. Для того, чтобы лучше оценить влияние Ulva на прочность цемента, команда использовала алгоритмы машинного обучения, которые помогли заранее отбросить неудачные комбинации компонентов, а не ждать окончания 28-дневных испытаний каждого варианта смеси.

Источник изображения: University of Washington Учёные смогли подобрать смесь, имеющую на 21 % меньший углеродный след по сравнению с традиционным, сохранив при этом необходимые прочностные характеристики. Кроме того, в ходе 28-дневных испытаний новый процесс проектирования позволил достичь 93 % от максимально возможного сокращения выбросов углерода. По их словам, исследование не только позволило создать более «зелёный» цемент, но и продемонстрировало новую схему для быстрой разработки экоустойчивых материалов с использованием экспериментов, компьютерного моделирования и анализа воздействия на окружающую среду. Утверждается, что такой подход можно расширить для разработки и других экобезопасных материалов с нужными характеристиками.

Источник изображения: University of Washington Цемент является критически важным материалом для строительства дата-центров. В рамках планов по декарбонизации бизнеса некоторые строители ЦОД уже начали изучение «низкоуглеродных» альтернатив. Сама Microsoft ещё в 2023 году опробовала использование низкоуглеродных бетонных смесей при постройке дата-центра в Квинси (Quinsy, Вашингтон). В мае 2025 года компания подписала сделку с Sublime Cement, разрабатывающей низкоуглеродные строительные материалы. Предполагается закупка гиперскейлером 623 тыс. т экологично цемента в течение 6–9 лет для строительства своих объектов, включая ЦОД, там, где это «географически возможно». AWS, Meta✴ и Stack подписали обязательства по использованию низкоуглеродного цемента, но пока оно не носит массовый характер. А Google, Meta✴, Microsoft и Amazon также намерены закупать «зелёную» сталь для своих ЦОД.

12.08.2025 [16:32], Сергей Карасёв

Supermicro представила 4U-сервер на базе NVIDIA HGX B200 с СЖОКомпания Supermicro анонсировала GPU-сервер SYS-422GS-NBRT-LCC для ресурсоёмких нагрузок, включая задачи ИИ, построенный на аппаратной платформе Intel Granite Rapids. Устройство оборудовано системой прямого жидкостного охлаждения DLC-2. Новинка выполнена в форм-факторе 4U. Допускается установка двух процессоров Xeon 6700P с TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти: максимальный объём ОЗУ составляет 4 Тбайт в случае DDR5-6400 ECC и 8 Тбайт при использовании DDR5-5200 ECC. Сервер располагает восемью слотами PCIe 5.0 x16 для низкопрофильных карт расширения и двумя разъёмами PCIe 5.0 x16 для карт полной высоты и половинной длины (FHHL). Сервер оснащён ИИ-ускорителями NVIDIA HGX B200 поколения Blackwell в конфигурации 8 × SXM. Предусмотрены восемь фронтальных отсеков для накопителей E1.S с поддержкой горячей замены, а также два отсека для M.2 NVMe SSD. Имеются два сетевых порта 10GbE (RJ45) на основе контроллера Intel X710-AT2. Система может быть укомплектована восемью однопортовыми адаптерами NVIDIA ConnectX-7 NIC или NVIDIA BlueField-3 SuperNIC, а также двумя двухпортовыми DPU NVIDIA BlueField-3. Реализованы интерфейсы Mini-DP и D-Sub. Питание обеспечивают четыре блока мощностью 6600 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +35 °C. Помимо системы DLC-2, установлены шесть вентиляторов диаметром 80 мм. Габариты сервера составляют 174 × 448 × 991,4 мм, масса — 107 кг.

Источник изображения: Supermicro

12.08.2025 [14:51], Владимир Мироненко

NVIDIA анонсировала компактные ускорители RTX PRO 4000 Blackwell SFF Edition и RTX PRO 2000 BlackwellNVIDIA объявила о предстоящем выходе GPU NVIDIA RTX PRO 4000 Blackwell SFF Edition и NVIDIA RTX PRO 2000 Blackwell, «воплощающих мощь архитектуры NVIDIA Blackwell в компактном и энергоэффективном форм-факторе», которые «обеспечат ИИ-ускорение для профессиональных рабочих процессов в различных отраслях». Новинки отличаются вдвое меньшими размерами по сравнению с традиционными GPU, и при этом оснащены RT-ядрами четвёртого поколения и тензорными ядрами пятого поколения с пониженным энергопотреблением. Как сообщает NVIDIA, новые ускорители разработаны для обеспечения производительности нового поколения для различных профессиональных рабочих процессов, обеспечивая «невероятное» ускорение процессов проектирования, дизайна, создания контента, ИИ и 3D-визуализации. По сравнению с ускорителем предыдущего поколения RTX A4000 SFF, модель RTX PRO 4000 SFF обеспечивает до 2,5 раза более высокую производительность в обработке ИИ-нагрузок и в 1,5 раза более высокую пропускную способность памяти, обеспечивая большую эффективность при том же максимальном энергопотреблении 70 Вт. Ускоритель включает 8960 ядер NVIDIA CUDA, 24 Гбайт памяти GDDR7 ECC со 192-бит шиной и пропускной способностью 432 Гбайт/с. Используется интерфейс PCIe 5.0 x8. ИИ-производительность составляет 770 TOPS, RT-ядер — 73 TOPS, в формате FP32 — 24 TOPS. Доступно 2 движка NVENC девятого поколения и 2 движка NVDEC шестого поколения. Есть 4 разъёма DisplayPort 2.1b. Оптимизированная для массового проектирования и рабочих ИИ-процессов, RTX PRO 2000 обеспечивает до 1,6 раза более быстрое 3D-моделирование, в 1,4 раза более высокую производительность систем автоматизированного проектирования (САПР) и в 1,6 раза более высокую скорость рендеринга по сравнению с предыдущим поколением. Компания отметила, что инженеры САПР, продуктовые инженеры и специалисты творческих профессий по достоинству оценят 1,4-кратный прирост производительности RTX PRO 2000 при генерации изображений и 2,3-кратный прирост производительности при генерации текста, что обеспечивает более быструю итерацию, быстрое прототипирование и бесперебойную совместную работу.  RTX PRO 2000 оснащена 4352 ядрами NVIDIA CUDA, 16 Гбайт памяти GDDR7 ECC со 128-бит шиной и пропускной способностью 288 Гбайт/с. Используется интерфейс PCIe 5.0 x8. ИИ-производительность составляет 545 TOPS, RT-ядер — 54 TOPS, в формате FP32 — 17 TOPS. Доступно по одному движку NVENC девятого поколения и NVDEC шестого поколения. Есть 4 разъёма DisplayPort 2.1b. NVIDIA сообщила, что ускорители NVIDIA RTX PRO 2000 Blackwell и NVIDIA RTX PRO 4000 Blackwell SFF Edition поступят в продажу позже в этом году, не указав конкретные сроки.

12.08.2025 [13:31], Руслан Авдеев

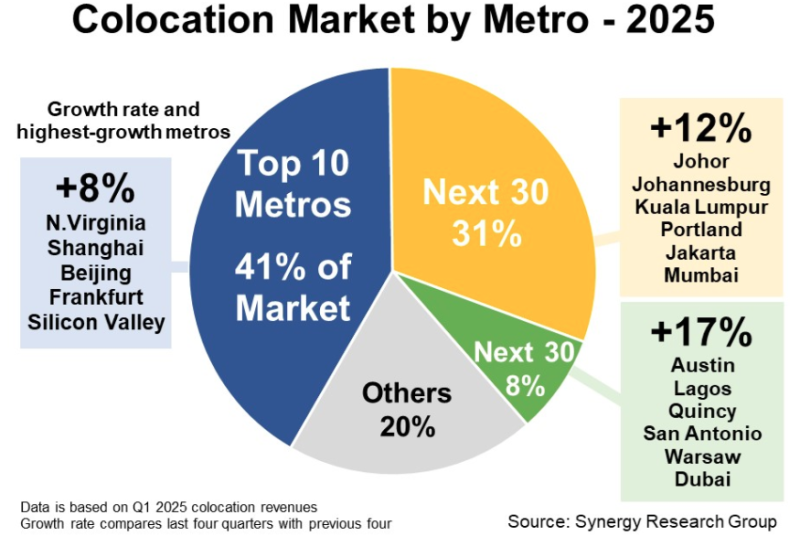

Synergy Research: на второстепенных рынках колокейшн-сервисов зарегистрирован крупнейший рост год к годуВторостепенные (Tier-Two) рынки колокейшн-сервисов испытали сильнейший рост год к году, сообщает Synergy Research Group. Речь идёт об агломерациях, занимающих с 11 по 70-е места по выручке. В их числе — Джохор и Куала-Лумпур в Малайзии, Йоханнесбург (Южная Африка), ряд городов в США, Джакарта в Индонезии, Мумбаи в Индии, Лагос в Нигерии, Варшава в Польше и Дубаи в ОАЭ. Рост рассчитывался с подсчётом выручки колокейшн-проектов за последние четыре квартала в сравнении с предыдущими четырьмя. Средний рост рынков, занимающих с 11 по 40-е места, составил 12 %, а с 41 по 70-е — 17 %. Для сравнения, для десяти важнейших рынков мира рост составил в среднем 8 %. В десятку лидеров входят рынки в Северной Вирджинии, Кремниевой долине, Нью-Йорке, Пекине и Шанхае, Лондоне, Токио и Франкфурте. При этом на первые десять агломераций приходится 41 % рынка, на 11-40 — 31 % рынка, на 41-70 — всего 8 %. По статистике Synergy, ведущими колокейшн-провайдерами являются Equinix, Digital Realty и CyrusOne, NTT и KDDI, а также China Telecom, Chindata и GDS.

Источник изображения: Synergy Research Group По словам экспертов Synergy, близость к клиентам является ключевым драйвером рынка услуг колокации, поэтому дата-центры (ЦОД) должны размещаться на территории городских агломераций (мегаполисов), в которых сконцентрированы крупнейшие компании и ведётся основная коммерческая деятельность. Ожидаемо, десятка лидеров не изменилась с публикации аналогичного доклада год назад, хотя некоторые игроки изменили в числе лидеров свои позиции, например, Шанхай обошёл Лондон. Ещё интереснее то, что развивающиеся рынки демонстрируют лучшие темпы роста, чем развитые. Хотя ведущая десятка в среднем продемонстрировала рост на 8 %, не менее 17 второстепенных рынков выросли на 20 и более процентов. Также аналитки добавили, что по масштабу рынки «второго эшелона» догонят лидеров не скоро. По данным предыдущего доклада Synergy, опубликованного в апреле 2025 года, на ведущие 20 агломераций приходится 60 % мирового рынка услуг колокации по объёму выручки. Меньше месяца назад Synergy выступила с данными о том, что Амстердам и Франкфурт выбыли из первой двадцатки локаций гиперскейлеров, а всего 62 % текущей IT-мощности ЦОД гиперскейлеров приходится на 20 регионов.

12.08.2025 [11:39], Сергей Карасёв

InnoGrit выпустила SSD N3X со сверхнизкой задержкой для ИИ-системКомпания InnoGrit официально представила SSD семейства N3X для ИИ-платформ и периферийных вычислений. Устройства, обладающие повышенной надёжностью, доступны в вариантах вместимостью 800 Гбайт, а также 1,6 и 3,2 Тбайт. О подготовке накопителей InnoGrit-N3X сообщалось в конце мая текущего года. Тогда говорилось, что устройства оснащены контроллером InnoGrit Tacoma IG5669 и чипами памяти Kioxia XL-Flash второго поколения, функционирующими в режиме SLC. Применяется интерфейс PCIe 5.0 x4 (NVMe 2.0). По новой информации, задействован контроллер InnoGrit IG5668. Изделия обладают сверхнизкой задержкой: 13 мкс при чтении и 4 мкс при записи. Показатель при чтении, как утверждается, на 75 % ниже по сравнению со стандартными твердотельными накопителями с интерфейсом PCIe 5.0. Заявленная скорость последовательного чтения достигает 14 Гбайт/с, скорость последовательной записи — 12 Гбайт/с. Показатель IOPS (операций ввода/вывода в секунду) составляет до 1,6 млн при произвольной записи блоков данных по 4 Кбайт — это примерно в четыре раза выше, чем у типичных решений PCIe 5.0 для ЦОД.

Источник изображения: InnoGrit SSD серии InnoGrit-N3X способны выдерживать до 100 полных перезаписей в сутки (100 DWPD): благодаря этому они подходят для использования в составе систем с высокой интенсивностью обмена данными. Реализованы средства сквозной защиты информации и шифрование по алгоритму AES-256. Функция Power Loss Protection (PLP) отвечает за сохранность данных при внезапном отключении питания. Устройства выпускаются в двух форм-факторах — U.2 и E1.S.

11.08.2025 [12:22], Руслан Авдеев

Brookfield: в течение десяти лет мощность ИИ ЦОД вырастет на порядок, а расходы на ИИ-инфраструктуру превысят $7 трлнИнвестиционный гигант Brookfield Asset Management выступил с прогнозом дальнейшего роста рынка дата-центров с небольшим риском «чрезмерного» развития, обусловленного бумом ИИ. Компания уже дала жизнь специальной стратегии развития ИИ-инфраструктуры и опубликовала документ, в котором изложила векторы развития сектора, сообщает Datacenter Dynamics. Сама Brookfield активно вкладывает значительные средства в инфраструктуру ЦОД, только в июне 2025 года она сообщала о готовности выделить $10 млрд на шведский ИИ ЦОД. В феврале она заявляла, что потратит €20 млрд ($23 млрд) на ИИ-инфраструктуру во Франции. Brookfield частично или полностью владеет Compass, Centersquare, Data4, Ascenty, Digtal Connexion и DCI, а также активно инвестирует в энергетику. Основываясь на данных собственного внутреннего исследования, компания пришла к выводу, что общие расходы на ИИ-инфраструктуру превысят $7 трлн в следующие десятилетие. Ранее McKinsey прогнозировала, что на эти цели ещё до конца текущего десятилетия может уйти до до $5 трлн. По прогнозам Brookfield, $4 трлн пойдут на чипы (включая производство и цепочки поставок), $2 трлн — на ЦОД, а $500 млрд — на электроэнергию и сети энергопередачи. Ещё $500 млрд потратят на технологии более общего назначения, вроде выделенных ВОЛС, системы охлаждения и робототехнику. Как сообщают в Brookfield, для ИИ находится всё больше сфер применения, он становится всё более коммерчески привлекательным, а повышение его эффективности приведёт к дальнейшему увеличению спроса. Пока шансы на «перепроизводство» мощностей крайне малы. В компании ожидают, что к концу года ИИ ЦОД («фабрики ИИ») будут располагать мощностями порядка 15 ГВт, тогда как в конце 2024 года речь шла о 7 ГВт.

Источник изображения: Invest Europe/unsplash.com В следующие десять лет мощности должны вырасти ещё на 75 ГВт, так что к 2034 году их общая мощность приблизится к 82 ГВт. Другими словами, за 10 лет мощности вырастут более чем в 10 раз. Установленная база ИИ-ускорителей с 2024 по 2034 гг. вырастет приблизительно в семь раз, с 7 млн в 2024 году до 45 млн к 2034 году. При этом чипы всё чаще будут применяться не для обучения, а для инференса — к 2030 году на инференс придётся порядка 75 % спроса на ИИ-вычисления. В Brookfield отмечают, что появление сложных ИИ-агентов дополнительно увеличит потребность в инференсе, поэтому всё больше проектов ЦОД будут оптимизироваться именно для инференса, а не для обучения ИИ-моделей. Значительная часть соответствующих проектов будет реализована с помощью компаний, предлагающих «ускоритель как услугу» — вроде CoreWeave. Рост соответствующего рынка вырастет с приблизительно $30 млрд в 2025 году до более $250 млрд к 2034 году, поскольку компании разных масштабов стремятся получить доступ к ИИ-вычислениям без капитальных затрат. В Brookfield подчеркнули, что строителям дата-центров уже стоит вносить изменения в их архитектуру с учётом возможных изменений. Оптимальными в долгосрочной перспективе будут модульные подходы, позволяющие быстро модернизировать систему питания и охлаждения по мере развития чипов и прочих технологий. |

|