Материалы по тегу: hardware

|

11.08.2025 [10:55], Руслан Авдеев

NVIDIA и AMD будут выплачивать правительству США 15 % выручки от продажи ИИ-ускорителей в КитаеNVIDIA и AMD пришли к соглашению с американскими властями, в результате которого компании будут обязаны отдавать правительству США 15 % выручки от продажи ИИ-ускорителей в КНР. За это они будут получать лицензии на продажу полупроводников в Поднебесную, сообщает The Financial Times. Как свидетельствуют «осведомлённые источники», экспортные лицензии для китайского рынка получены на днях именно на таких условиях. По словам источника из числа чиновников, NVIDIA согласилась платить за поставки H20 в Китай, AMD придётся раскошелиться за продажи MI308. Как сообщает издание, Министерство торговли США начало выдавать экспортные лицензии на H20 в минувшую пятницу, через два дня после встречи главы NVIDIA Дженсена Хуанга (Jensen Huang) с президентом США Дональдом Трампом (Donald Trump). Ранее Хуанг жёстко раскритиковал ограничения на поставки ИИ-ускорителей в Китай, заявив, что это станет для КНР лишь дополнительным стимулом для развития собственных технологий. По данным источников, лицензии начали выдавать и AMD. Стоит отметить, что такое соглашение считается «беспрецедентным». По словам экспертов, ни одна компания в истории США не соглашалась платить часть выручки за получение экспортных лицензий. Впрочем, вполне вероятно, что администрация США собирает все доступные средства для реиндустриализации самих Соединённых Штатов. Сами вендоры ситуацию не комментируют и лишь заявили, что следуют установленным правительством правилам для обеспечения своего присутствия на мировых рынках.

Источник изображения: Priscilla Du Preez/unsplash.com По словам аналитиков Bernstein, до введения экспортных ограничений прогнозировалось, что NVIDIA могла бы продать в 2025 году Китаю порядка 1,5 млн ускорителей H20, что принесло бы около $23 млрд выручки. В апреле администрация США объявила о запрете поставок H20 в Китай, но этим летом изменила своё решение после встречи с Хуангом. Однако Бюро промышленности и безопасности (BIS) так и не начало выдавать экспортные лицензии до прошлой пятницы. Некоторые американские эксперты по безопасности подчёркивают ошибочность решения, утверждая, что H20 поможет военным КНР и подорвёт лидерство США в сфере ИИ. Некоторые горько шутят, что дальше, вероятно, стоит ожидать продаж Китаю F-35 при условии уплаты 15 % комиссии правительству. Не так давно 20 экспертов по безопасности направили в администрацию письмо, в котором призывали на выдавать лицензии на продажи H20 в Китай. По их словам, это всё ещё достаточно мощный ускоритель, который в конечном счёте будет использоваться китайскими военными. В самой NVIDIA такие предположения опровергают. В субботу, 9 августа, было заявлено, что H20 уже несколько месяцев не поставляются в Китай, но в компании надеются, что экспортные правила позволят Америке конкурировать в Китае и во всём мире. Американский стек ИИ-технологий может стать мировым стандартом при глобальном распространении своих технологий. Сейчас между США и Китаем ведутся торговые переговоры, которые, как надеются в администрации США, будут содействовать организации саммита между президентом Трампом и председателем КНР Си Цзиньпином. Министерству торговли уже приказали заморозить новые меры экспортного контроля в отношении КНР, чтобы не испортить отношения с Пекином. Опасения экспертов возникли на фоне усилий КНР, предпринимаемых чтобы смягчить контроль над поставками HBM-чипов, которые являются важнейшим компонентом современных ИИ-ускорителей. Ещё до ослабления запретов выяснилось, что в КНР «просочились» передовые ускорители NVIDIA на $1 млрд, а в конце июля появилась новость, что NVIDIA заказала у TSMC производство 300 тыс. ИИ-ускорителей H20 в ответ на высокий спрос в Китае — в дополнение к уже имеющимся запасам.

11.08.2025 [10:46], Сергей Карасёв

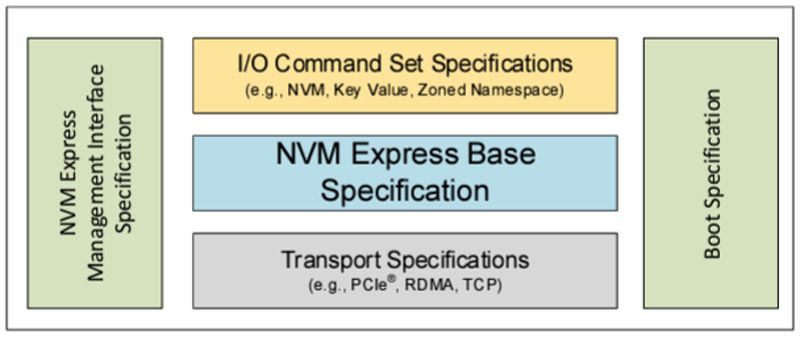

SSD под контролем: консорциум NVM Express обновил спецификации, добавив быстрое восстановление после сбоевКонсорциум NVM Express обнародовал ряд новых спецификаций, призванных ускорить и упростить разработку изделий с архитектурой NVMe. Реализованы функции, которые помогают в решении эксплуатационных задач, предоставляя администраторам улучшенную прозрачность и контроль над хранилищами для критически важных бизнес-приложений и нагрузок в дата-центрах. В частности, обновлены базовая спецификация NVMe 2.3, спецификация набора команд (NVM Command Set 1.2, ZNS Command Set 1.4, Key Value Command Set 1.3, Subsystem Local Memory Command Set 1.2, Computational Programs Command Set 1.2), транспортная спецификация (NVMe over PCIe Transport 1.3, NVMe over RDMA Transport 1.2, NVMe over TCP Transport 1.2), а также спецификации NVM Express Management Interface (NVMe-MI) 2.1 и NVMe Boot 1.3.

Источник изображения: NVM Express Одной из новых функций является восстановление после сбоев Rapid Path Failure Recovery. Этот инструмент обеспечивает связь с подсистемой NVM через альтернативные каналы, что позволяет быстро восстанавливать подключение в случае потери связи с контроллером, избегая повреждения данных и дублирования невыполненных команд. Кроме того, появилась возможность ограничения мощности (Power Limit Config): эта функция обеспечивает полный контроль над максимальной мощностью устройств NVMe, что особенно важно для старых платформ с ограниченным потенциалом в плане питания. В свою очередь, режим Self-reported Drive Power позволяет хосту измерять и контролировать мощность устройства NVMe, а также энергопотребление в течение всего срока его службы. Это помогает в решении вопросов, связанных с обслуживанием хранилищ и устойчивым развитием. Инструмент Sanitize Per Namespace обеспечивает криптографическую очистку отдельных пространств имен, не затрагивая всю подсистему NVM. Кроме того, упомянут механизм индивидуальной настройки устройств Configurable Device Personality.

11.08.2025 [09:55], Руслан Авдеев

Meta✴ выбрала Pimco и Blue Owl для финансирования расширения ЦОД на $29 млрдMeta✴ Platforms назвала Pacific Investment Management (Pimco) и Blue Owl Capital главными инвесторами расширения ЦОД в Луизиане на сумму $29 млрд, сообщает Bloomberg. По словам источников, пожелавших сохранить анонимность, Pimco обеспечит заёмные средства на сумму $26 млрд, а Blue Owl будет отвечать за акционерный капитал на $3 млрд. Заёмная доля, вероятно, будет выпущена в формате инвестиционных облигаций, обеспеченных активами ЦОД. Meta✴ имеет партнёрское соглашение с Morgan Stanley для привлечения средств в рамках конкурентного инвестиционного процесса с привлечением некоторых из крупнейших игроков рынка частных кредитных инвестиций. До финального раунда переговоров за право возглавить раунд финансирование боролись также Apollo Global Management и KKR. На более позднем этапе могут быть привлечены и другие инвесторы. Пока представители Meta✴, Pimco, Blue Owl и Morgan Stanley новости не комментируют. Blue Owl управляет активами приблизительно на $192 млрд. Компания начала активно инвестировать в ЦОД только в прошлом году, заодно приобретая инвестирующие в ЦОД структуры и формируя новые. Так, она уже принимает участите в строительстве дата-центров CoreWeave и Crusoe (OpenAI Stargate). Pimco же является инвестиционной компанией, входящей в Allianz Group, которая имеет немало собственности в Европе. В 2023 году компания запустила там новую платформу ЦОД Apto.

Источник изображения: Samson/unsplash.com По данным Datacenter Dynamics, в последнем отчёте о финансах Meta✴ отметила, что готова привлекать партнёров к созданию ЦОД. Глава компании Марк Цуерберг (Mark Zuckerberg) добавил, что намерен потратить «сотни миллиардов долларов» на ИИ ЦОД — первый кластер Prometheus должны ввести в эксплуатацию в 2026 году. Также готовится 2-ГВт кампус Hyperion в Луизиане недалеко от Монро (Monroe) в Луизиане. Для питания этого кампуса построят ЛЭП за $1,2 млрд. Частные инвестиционные структуры активно стремятся вкладывать капитал в сделки, обеспеченные реальными, физическими активами или — совместно с компаниями с более высоким рейтингом. Это помогает диверсифицировать бизнес. По оценкам консалтинговой McKinsey & Co, к 2030 году дата-центрам потребуется $6,7 трлн для удовлетворения мирового спроса на вычислительную мощность. Финансирование поможет Meta✴ ускорить разработку ИИ, который, как утверждают в компании, уже приносит «значительный» доход. По оценкам Meta✴, в следующем году расходы будут расти быстрее, особенно с учётом повышенного интереса компании к ИИ-инфраструктуре и привлечения узкоспециализированных технических специалистов в соответствующей сфере. В Meta✴ ожидают появления моделей, способных привлечь значительное внешнее финансирование для поддержки крупномасштабных проектов ЦОД. Прочие техногиганты уже взаимодействуют с инвестиционными компаниями для финансирования ИИ ЦОД. Так, Microsoft объединилась с BlackRock, чтобы привлечь $30 млрд инвестиций.

11.08.2025 [09:00], Руслан Авдеев

AWS предложила «дяде Сэму» облачные услуги на $1 млрдПравительство США намерено расширить использование AWS — компания готова предоставить американским властям облачные кредиты на сумму $1 млрд до 31 декабря 2028 года, сообщает The Register. Кредиты можно использовать для внедрения облачных технологий, получения IT-сервисов, обучения и иных услуг, необходимых правительству для «перехода от устаревшей локальной инфраструктуры к облачной». Администрация общего обслуживания США (англ. General Services Administration, GSA), обеспечивающая связью и прочей инфраструктурой другие федеральные ведомства страны, заявило, что соглашение с AWS позволит оптимизировать предоставление критически важных сервисов, поможет внедрению облачных и ИИ-технологий, а также значительно сократить расходы. Это последняя из сделок в рамках стратегии государственных закупок OneGov, о которой GSA объявило в апреле 2025 года. OneGov может изменить порядок закупок товаров и услуг госучреждениями, при этом первый этап программы сосредоточен на IT-продуктах. OneGov во многом предусматривает отказ от разрозненных закупок товаров и услуг в пользу крупных соглашений федерального масштаба со стандартизированными условиями и ценами. Поскольку необходимость согласования каждой закупки отпадёт, ожидается экономия как времени, так и средств. В рамках OneGov уже заключены соглашения, предусматривающее значительные скидки на технологии Oracle для госзаказчиков, а также предоставление государственным ведомствам доступа к ChatGPT Enterprise за символическую сумму в $1. В рамках проекта AWS услуги будут предоставляться любым федеральным правительственным клиентам при посредничестве GSA. Также соглашение предусматривает «оптимизированное взаимодействие» между AWS и федеральными агентствами без посредников и со значительной экономией. Выход AWS на федеральный уровень в облачном сегменте оказался как нельзя кстати. Недавно Microsoft обвинили в привлечении китайских сотрудников для поддержки клиентов Azure из числа американских госструктур. Это может поставить крест на всех усилиях Microsoft, которая потратила годы на завоевание расположения властей США.

10.08.2025 [15:24], Сергей Карасёв

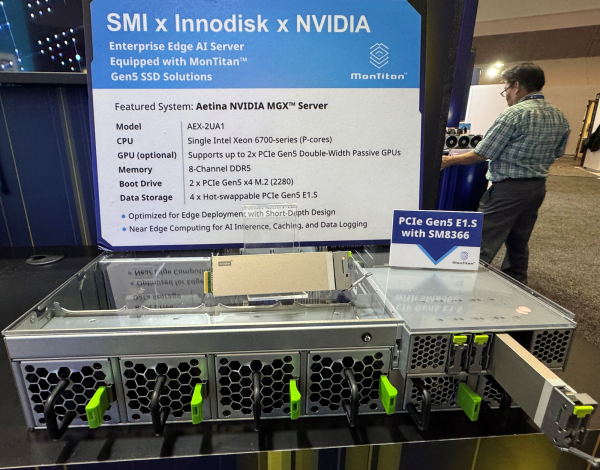

Silicon Motion продемонстрировала решения с SSD на основе контроллера MonTitan SM8366Компания Silicon Motion показала ряд продуктов, оснащённых высокопроизводительными SSD на базе контроллера MonTitan SM8366. Решение MonTitan SM8366 ориентировано на накопители для дата-центров и инфраструктур гиперскейлеров. Обеспечивается поддержка PCIe 5.0 x4, NVMe 2.0a и OCP 2.0. Доступны 16 независимых каналов NAND Flash, а заявленная производительность достигает 2400 MT/s. Скорость последовательной передачи данных может превышать 14,2 Гбайт/с, величина IOPS — 3,5 млн при работе с блоками данных по 4 Кбайт. Возможно создание накопителей в форматах E1.S, E1.L, U.2/3. Поддерживается память DDR4-3200 и DDR5-4800 в одно- и двухканальном режимах. Контроллер выполнен в корпусе FCBGA с размерами 21 × 21 мм. В рамках FMS 2025 продемонстрирована система VAST Data Ceres V2 Dbox, оснащённая накопителями Unigen семейства Cheetah с контроллером MonTitan SM8366. Это, в частности, SSD формата E1.L вместимостью 128 Тбайт на чипах QLC NAND, а также изделия стандарта U.2 ёмкостью 3,2 Тбайт с чипами SLC NAND. Система VAST Data Ceres V2 Dbox выполнена в форм-факторе 1U и наделена DPU NVIDIA BlueField-3. Кроме того, показан сервер небольшой глубины Aetina AEX-2UA1 для периферийных вычислений, в состав которого включены накопители Innodisk 5TS-P на основе MonTitan SM8366. Система построена на модульной платформе NVIDIA MGX. Отмечается, что сервер Aetina AEX-2UA1 предоставляет ИИ-возможности в средах с ограниченным пространством для установки оборудования.

10.08.2025 [15:21], Сергей Карасёв

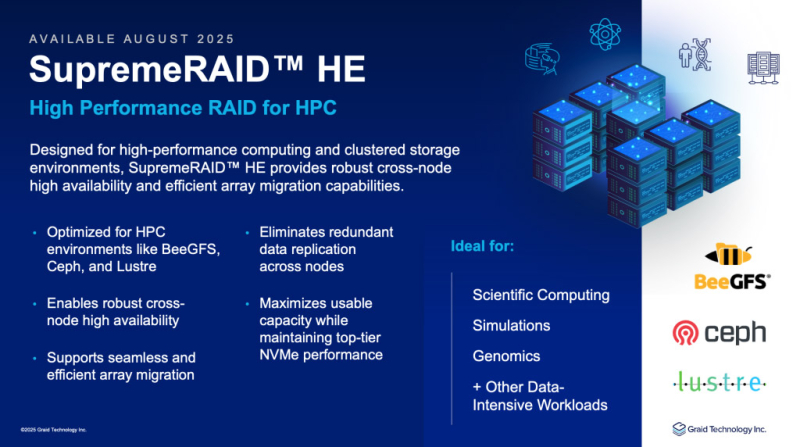

Graid представила платформу SupremeRAID HE: массивы NVMe RAID для НРС-средКомпания Graid Technology объявила о глобальной доступности платформы SupremeRAID HE (HPC Edition), предназначенной для создания программно-определяемых массивов NVMe RAID с ускорением на базе GPU. SupremeRAID HE переносит операции RAID с CPU на GPU, что, как утверждается, позволяет полностью раскрыть потенциал производительности NVMe SSD. Заявлена совместимость с такими параллельными файловыми системами, как Ceph, Lustre, MinIO и IBM SpectrumScale. Возможно развёртывание JBOF в системах с коммутаторами Broadcom. Благодаря GPU-ускорению заявленная пропускная способность достигает 132 Гбайт/с при чтении данных и 83 Гбайт/с при записи (после выполнения RAID-операций). Заявлена поддержка RAID 0/1/5/6/10, NVMe-oF, конфигураций с двумя контроллерами и функции миграции массива. Допускается использование до 32 накопителей. SupremeRAID HE предлагается в виде комплекта из GPU-ускорителя и лицензии на ПО. В качестве аппаратной составляющей могут использоваться карты NVIDIA RTX A1000 (8 Гбайт GDDR6) или NVIDIA RTX 2000 Ada (16 Гбайт GDDR6). «Перенося операции RAID на GPU, мы предоставляем клиентам возможность масштабировать производительность накопителей NVMe, сохраняя при этом высокую доступность узлов — без сложностей репликации и компромиссов», — говорит Леандер Ю (Leander Yu), президент и генеральный директор Graid Technology. Отмечается, что SupremeRAID HE допускает развёртывание в широком спектре инфраструктур, включая платформу Supermicro High Availability Dual Node All-Flash петафлопсного класса. Новое RAID-решение ориентировано на среды с высокими нагрузками, включая НРС. Говорится о совместимости с Ubuntu 20.04–24.04 и RHEL 8.x–9.x.

10.08.2025 [00:10], Владимир Мироненко

Samsung решила возродить сверхбыстрые SSD с памятью Z-NANDКомпания Samsung Electronics возрождает технологию памяти Z-NAND после семилетнего перерыва, позиционируя её как высокопроизводительное решение для ИИ-нагрузок. По данным DigiTimes, следующее поколение памяти Z-NAND получит 15-кратное увеличение производительности по сравнению с современными NVMe SSD и даст ускорителю возможность напрямую обращаться к накопителю Z-NAND с минимальными задержками. Как пишет Tom's Hardware, исполнительный вице-президент Samsung по производству памяти сообщил, что при значительном росте производительности с помощью технологии Z-NAND энергопотребление накопителей будет на 80 % ниже по сравнению с традиционной флеш-памятью NAND. Кроме того, в новом поколении упор сделан на минимизацию задержек. Для этого Samsung внедряет новую технологию GPU-Initiated Direct Storage Access (GIDS), которая позволит ускорителям напрямую обращаться к устройствам хранения Z-NAND, минуя CPU и RAM, тем самым значительно сокращая время доступа. Samsung представила технологию Z-NAND в 2016 году в качестве альтернативы памяти Intel 3D XPoint (Optane). Вышедший в 2018 году твердотельный накопитель Samsung 983 ZET на базе 64-слойной SLC 3D V-NAND предлагал значительно более низкую задержку и высокие скорости в сравнении с обычными NVMe SSD. По производительности он вплотную приблизился к Intel Optane SSD 900P. Обе технологии фактически относятся к SCM (Storage Class Memory), хотя только Intel предлагала PMem-модули в виде DIMM. Однако в итоге разработку 3D XPoint последняя (вместе с Micron) забросила, да и Samsung, ответив выпуском Z-SSD на появление Optane, решила свою технологию не развивать. Примерно в то же время Kioxia (тогда ещё Toshiba) представила свой вариант сверхбыстрой SLC NAND — XL-Flash. Её она тоже довольно долго особенно не развивала, но планирует уже в следующем году представить XL-Flash SSD с переработанным контроллером, который обеспечит более 10 млн IOPS, особенно на небольших транзакциях. Для точной настройки SSD с целью повышения производительности при запуске ресурсоёмких ИИ-приложений компания сотрудничает с ведущими производителями ускорителей. Phison также предлагает eSLC-накопители PASCARI с технологией aiDAPTIV+. SLC-накопители также есть у Solidigm и Micron. Впрочем, широкая востребованность Z-SSD может оказаться под вопросом. Уже анонсированы быстрые SSD с интерфейсом PCIe 6.0. CXL же позволяет относительно недорого наращивать объём памяти, хотя и в ущерб задержкам. Так что Samsung придётся сделать новые Z-SSD не только быстрыми, но и экономически эффективными.

09.08.2025 [13:22], Сергей Карасёв

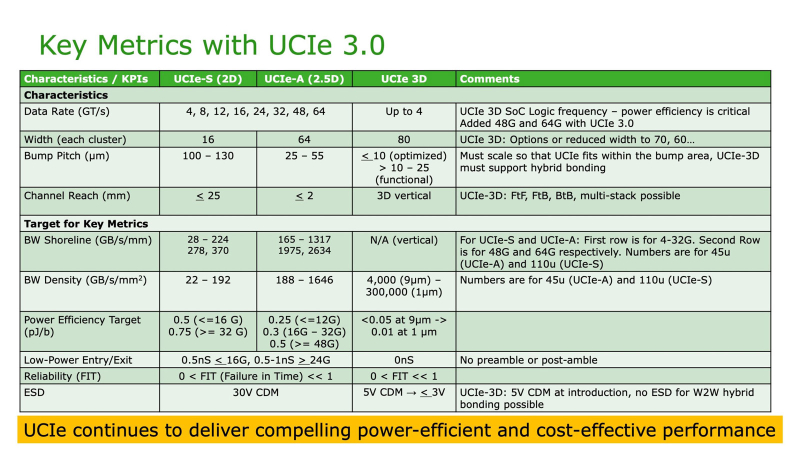

До 64 ГТ/с: обнародована спецификация UCIe 3.0 для объединения чиплетовКонсорциум Universal Chiplet Interconnect Express (UCIe) объявил о выпуске спецификации UCIe 3.0 для соединения чиплетов в составе высокопроизводительных систем, таких как платформы аналитики данных, HPC и ИИ. Напомним, консорциум UCIe был сформирован в 2022 году с целью создания стандартного интерконнекта, позволяющего объединять в одном корпусе чиплеты разных производителей, обладающие различными функциями и изготовленные на разных предприятиях. В состав консорциума вошли Intel, AMD, Qualcomm и TSMC, а также ведущие гиперскейлеры, включая Google Cloud, Meta✴ и Microsoft. Обнародованная спецификация UCIe 3.0 предусматривает удвоение скорости по сравнению со стандартом предыдущего поколения — до 48 и 64 ГТ/с для вариантов UCIe-S (стандартная упаковка 2D) и UCIe-A (передовая упаковка 2.5D). Таким образом, достигается более высокая пропускная способность в расчёте на соединение, что имеет большое значение, когда для обмена данными между кристаллами может быть задействовано строго ограниченное количество соединений. В случае UCIe 3D скорость ограничивается 4 ГТ/с.

Для UCIe 3.0 заявлена обратная совместимость со спецификациями предыдущих поколений. Упомянута улучшенная перекалибровка во время выполнения, обеспечивающая снижение энергопотребления каналов передачи данных и чиплетов. Предусмотрены и другие усовершенствования, ориентированные на повышение плотности полосы пропускания, энергоэффективности и управляемости на системном уровне. В целом, спецификация UCIe 3.0 обеспечивает более высокую масштабируемость, гибкость и совместимость, что, как считают участники консорциума, поможет ускорить инновации в области модульной полупроводниковой архитектуры. Вместе с тем некоммерческая организация Open Compute Project Foundation (OCP) выпустила новую спецификацию Universal D2D Transaction и Link-Layer, которая охватывает в том числе UCIe.

09.08.2025 [13:19], Сергей Карасёв

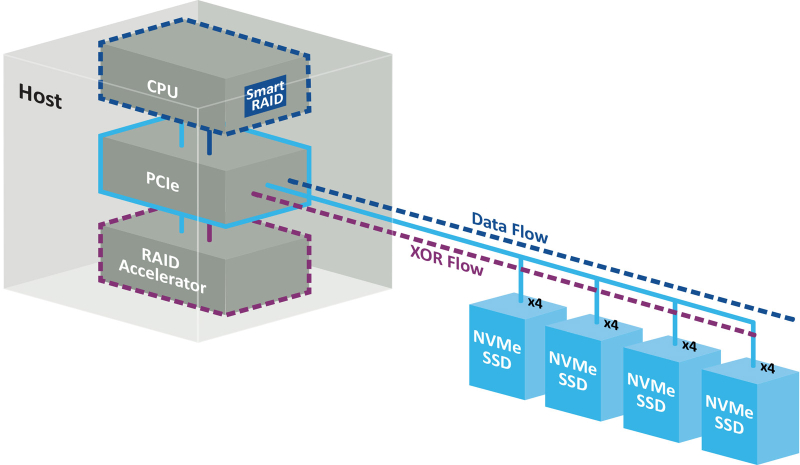

Беспортовый контроллер: Microchip представила RAID-ускорители Adaptec SmartRAID 4300 для NVMe-хранилищКомпания Microchip Technology анонсировала ускорители Adaptec SmartRAID 4300 для дата-центров, поддерживающих ресурсоёмкие нагрузки, в том числе связанные с ИИ. Решения предназначены для работы с массивами NVMe RAID в составе программно-определяемых хранилищ (SDS). Концепция Adaptec SmartRAID 4300 предполагает разделение платформы Microchip Smart Storage на программные и аппаратные компоненты. В данном случае CPU отвечает за непосредственную запись данных на твердотельные накопители, полноценно используя скоростные возможности интерфейса PCIe. Вместе с тем дополнительные расчёты (в том числе XOR-операции) переносятся с хост-процессора на RAID-ускоритель. Такой подход, как утверждается, устраняет узкие места, присущие традиционным решениям с последовательным подключением. В результате, достигается высокий уровень гибкости и масштабируемости. Возможно подключение до 32 устройств NVMe SSD с интерфейсом PCIe 4.0 х4 или PCIe 5.0 х4. По оценкам Microchip, изделия Adaptec SmartRAID 4300 обеспечивают семикратное увеличение производительности ввода-вывода (I/O) по сравнению с решениями предыдущего поколения. В частности, в средах Windows показатель IOPS в режимах RAID 0 и RAID 5 достигает 5 млн при произвольном чтении данных блоками по 4 Кбайт и соответственно 4,8 млн и 2,3 млн при произвольной записи. Скорость последовательного чтения составляет до 317 Гбайт/с (RAID 0) и 291 Гбайт/с (RAID 5), скорость последовательной записи — до 120 Гбайт/с (RAID 0) и 26 Гбайт/с (RAID 5). При работе с Linux скорости значительно выше. Так, величина IOPS в режимах RAID 0 и RAID 5 при произвольном чтении достигает 27,2 млн и 27,3 млн соответственно, при произвольной записи — 22,4 млн и 5,1 млн. Скорость последовательного чтения — до 300 и 291 Гбайт/с, последовательной записи — до 196 и 155 Гбайт/с. Ускорители выполнены в виде низкопрофильной (HHHL) карты расширения с интерфейсом PCIe 4.0 х16. Поддерживаются массивы RAID 0/1/5/10/50. Габариты составляют 68,9 × 167,65 мм. Значение MTBF (средняя наработка на отказ) — до 3 млн часов при температуре до +40 °C. Гарантирована совместимость с Windows Server, Red Hat Enterprise Linux, SuSE Linux Enterprise Server, Oracle Linux.

08.08.2025 [18:41], Руслан Авдеев

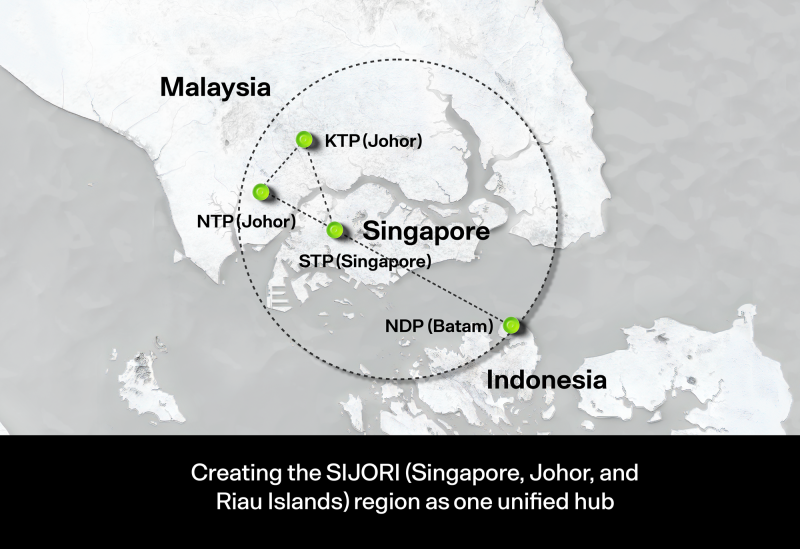

Во II квартале 2025 года штат Джохор (Малайзия) одобрил 42 проекта строительства ЦОДМалайзия взяла курс на ускоренную цифровизацию. Только штат Джохор (Johor) во II квартале 2025 года одобрил 42 проекта строительства дата-центров. Местные власти считают, что это позиционирует штат как лидера в области инвестиций в цифровую инфраструктуру страны, сообщает The Edge Malaysia. По словам представителя местного Комитета по жилищному строительству и самоуправлению, дата-центры служат ключевым драйвером развития особой экономической зоны Johor-Singapore Special Economic Zone (JS-SEZ), а также других проектов в регионе, в том числе призванных преобразовать экономику приграничных районов штата.

Источник изображения: Ven Jiun (Greg) Chee/unsplash.com Сообщается, что на заседании целевой группы по развитию ЦОД Джохора с участием высших руководителей страны, были рассмотрены и семь новых заявок на строительство дата-центров в районе Большого Джохор-Бару (Greater Johor Bahru). Правительство отдаёт приоритет строительству ЦОД в промышленных зонах вроде Ibrahim Technopolis (IBTEC) в Кулаи (Kulai), Sedenak и Pasir Gudang — эти места предлагают стратегические преимущества, в том числе прямой доступ к основным автомагистралям, энергоёмким электросетям, стабильному водоснабжению и близость к портам и международным аэропортам. Сообщается, что всего для строительства было выделено более 3 тыс. га территорий под разными юрисдикциями, в т.ч. зоны ASM Green, Rising Gateway, Iskandar Halal Hub, Kosmo и Keck Seng, а также IBTEC. В частности, в технополисе IBTEC более 240 га выделено специально для строительства дата-центров. Правительство штата намерено ограничить выдачу разрешений на строительство ЦОД на некоторых территориях вблизи жилых районов. Власти подчёркивают, что процесс утверждения проектов строительства ЦОД отличается высокой прозрачностью и основан на «реальных технических требованиях». Каждая заявка должна соответствовать требованиям по уровню шума и контроля тепловыделения, архитектурным стандартам, требованиям к энергетической ёмкости, безопасности для окружающей среды и др. Отмечается, что Джохор стал первым штатом в Малайзии, получившим ЦОД уровня Tier IV, а также технологии переработки сточных вод, разработанные совместно с Indah Water Konsortium и Johor Special Water. Ещё в 2023 году сообщалось, что Малайзия может захотеть стать новым IT-хабом Юго-Восточной Азии и постепенно теснит Сингапур, страдающий от нехватки свободных площадей и дефицита энергии. Конкуренцию ей пытается составить Индонезия. |

|