Материалы по тегу: ии

|

13.09.2025 [13:54], Сергей Карасёв

Затраты на строительство дата-центров в США бьют рекордыИсследование, проведённое специалистами Института Банка Америки (Bank of America Institute), говорит о том, что затраты на строительство дата-центров в США в июне нынешнего года достигли исторического максимума, составив около $40 млрд. Это на 30 % больше по сравнению с предыдущим годом, когда расходы находились на уровне $30,8 млрд. Причём в июне 2024-го отмечался рост на 50 % в годовом исчислении. Отмечается, что стремительное увеличение затрат в области ЦОД обусловлено бумом в сфере генеративного ИИ и машинного обучения. Для оптимизации больших языковых моделей (LLM) и инференса требуются огромные вычислительные ресурсы, что побуждает гиперскейлеров вкладывать десятки миллиардов долларов в соответствующую инфраструктуру. В частности, Microsoft намерена инвестировать в 2025 финансовом году до $80 млрд в создание ЦОД для задач ИИ в глобальном масштабе: более половины от этой суммы придётся на объекты в США. В свою очередь, Amazon в 2025-м вложит в расширение инфраструктуры рекордные $118 млрд. Google планирует потратить на наращивание мощностей дата-центров для поддержки ИИ около $85 млрд. Meta✴ готова выделить «сотни миллиардов долларов» на мультигигаваттные ИИ ЦОД, только в этом году уйдёт до $72 млрд. Основным сдерживающим фактором является нехватка электроэнергии. Согласно прогнозам Goldman Sachs, быстрое развитие ИИ приведёт к тому, что к 2030 году потребление энергии дата-центрами увеличится более чем вдвое. С другой стороны, говорится в исследовании BofA, повышение энергопотребления в сегменте ЦОД не отражает всю картину. Аналитики утверждают, что к 2030-му основная часть ожидаемого роста спроса на электроэнергию в США будет обусловлена такими факторами, как распространение электромобилей, отопление, перенос промышленных предприятий в новые зоны и электрификация зданий.

13.09.2025 [13:43], Сергей Карасёв

Microsoft расширит вычислительные мощности для обучения собственных ИИ-моделейКорпорация Microsoft, по сообщению Bloomberg, намерена расширить свою вычислительную инфраструктуру для обучения собственных моделей ИИ, которые, как ожидается, смогут составить конкуренцию решениям OpenAI, Anthropic и других ведущих игроков соответствующего рынка. На общем собрании сотрудников Microsoft руководитель потребительского направления ИИ Мустафа Сулейман (Mustafa Suleyman) заявил, что корпорация сделает «значительные инвестиции» в собственные ИИ-кластеры. По его словам, для Microsoft важно иметь возможность быть самодостаточной в области ИИ, если того потребует рыночная ситуация. Вместе с тем, как подчёркивает Сулейман, Microsoft придерживается подхода, предполагающего создание собственных ИИ-продуктов при одновременном углублении связей с OpenAI и поддержании отношений с другими участниками отрасли. В частности, Microsoft и OpenAI останутся партнёрами как минимум до 2030 года. Это сотрудничество предполагает, что OpenAI продолжит использовать облачные сервисы Azure, тогда как Microsoft сохранит доступ к интеллектуальной собственности OpenAI, включая ИИ-модели. Впрочем, компании ещё могут пересмотреть договор. Сулейман, являющийся соучредителем Google DeepMind, присоединился к Microsoft в 2024 году. В прошлом месяце редмондская корпорация представила первые собственные ИИ-модели — MAI-Voice-1 и MAI-1-preview, которые были созданы под руководством Сулеймана. Их обучение проходило на 15 тыс. ускорителей NVIDIA H100. Подчёркивается, что конкуренты вроде Meta✴, Google и xAI для выполнения таких задач используют кластеры в 6–10 раз больше: это, по мнению Microsoft, говорит о высокой эффективности её ИИ-моделей. В целом, Microsoft в 2025 финансовом году намерена инвестировать около $80 млрд в создание дата-центров для ИИ-нагрузок. Кроме того, корпорация подписала пятилетнее соглашение стоимостью почти $20 млрд на использование вычислительной ИИ-инфраструктуры компании Nebius (бывшая Yandex N.V.).

12.09.2025 [23:07], Владимир Мироненко

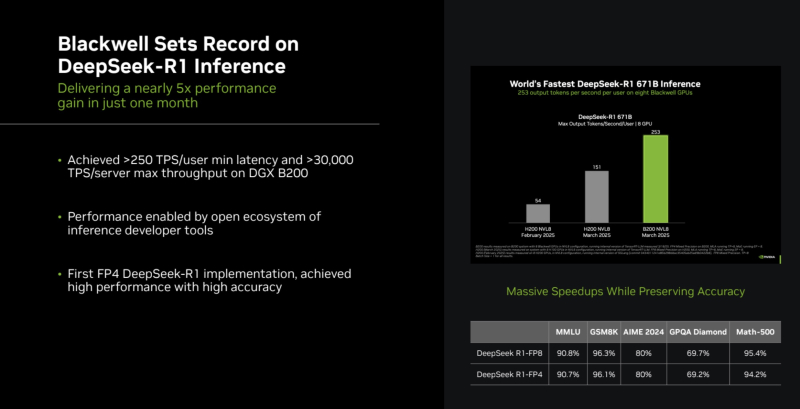

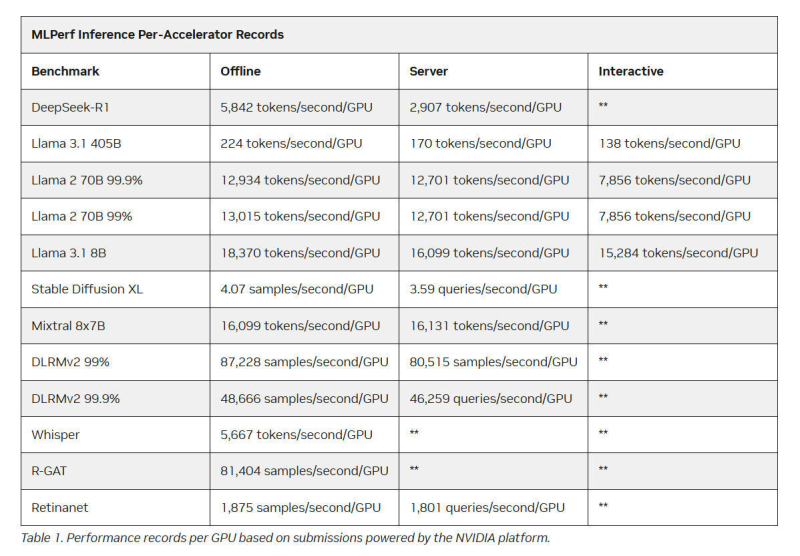

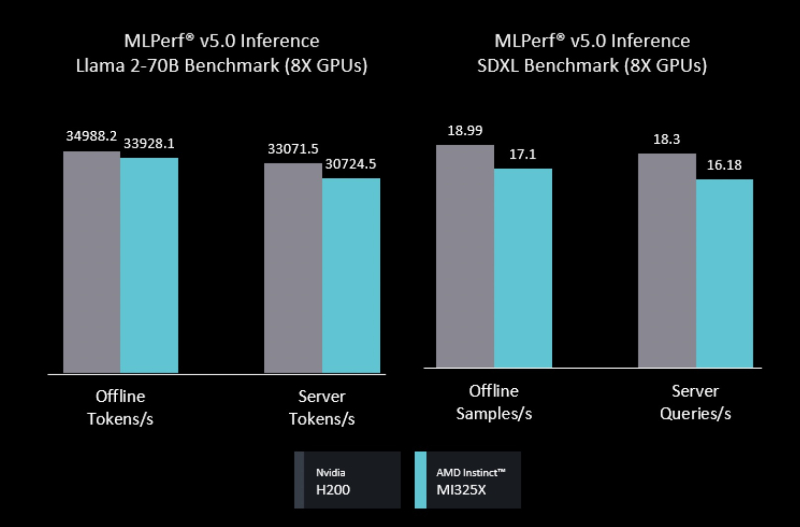

Intel Arc Pro впервые поучаствовали в бенчмарках MLPerf Inference, но в лидерах предсказуемо осталась NVIDIAMLCommons объявил результаты набора бенчмарков MLPerf Inference v5.1. Последний раунд демонстрирует, насколько быстро развивается инференс и соответствующие бенчмарки, пишет ресурс HPCwire. В этом раунде было рекордное количество заявок — 27. Представлены результаты сразу пяти новых ускорителей: AMD Instinct MI355X, Intel Arc Pro B60 48GB Turbo, NVIDIA GB300, NVIDIA RTX 4000 Ada 20GB, NVIDIA RTX Pro 6000 Blackwell Server Edition. Всего же количество результатов MLPerf перевалило за 90 тыс. результатов. В текущем раунде были представлены три новых бенчмарка: тест рассуждений на основе модели DeepSeek-R1, тест преобразования речи в текст на основе Whisper Large v3 и небольшой тест LLM на основе Llama 3.1 8B. Как отметил ресурс IEEE Spectrum, бенчмарк на основе модели Deepseek R1 671B (671 млрд параметров), более чем в 1,5 раза превышает самый крупный бенчмарк предыдущего раунда на основе Llama 3.1 405B. В модели Deepseek R1, ориентированной на рассуждения, большая часть вычислений выполняется во время инференса, что делает этот бенчмарк ещё более сложным. Что касается самого маленького бенчмарка, основанного на Llama 3.1 8B, то, как поясняют в MLCommons, в отрасли растёт спрос на рассуждения с малой задержкой и высокой точностью. SLM отвечают этим требованиям и являются отличным выбором для таких задач, как реферирование текста или периферийные приложения. В свою очередь бенчмарк преобразования голоса в текст, основанный на Whisper Large v3, был разработан в ответ на растущее количество голосовых приложений, будь то смарт-устройства или голосовые ИИ-интерфейсы. NVIDIA вновь возглавила рейтинг MLPerf Inference, на этот раз с архитектурой Blackwell Ultra, представленной платформой NVIDIA GB300 NVL72, которая установила рекорд, увеличив пропускную способность DeepSeek-R1 на 45 % по сравнению с предыдущими системами GB200 NVL72 (Blackwell). NVIDIA также продемонстрировала высокие результаты в бенчмарке Llama 3.1 405B, который имеет более жёсткие ограничения по задержке. NVIDIA применила дезагрегацию, разделив фазы работы с контекстом и собственно генерацию между разными ускорителями. Этот подход, поддерживаемый фреймворком Dynamo, обеспечил увеличение в 1,5 раза пропускной способности на один ускоритель по сравнению с традиционным обслуживанием на системах Blackwell и более чем в 5 раз по сравнению с системами на базе Hopper. NVIDIA назвала «дезагрегированное обслуживание» одним из ключевых факторов успеха, помимо аппаратных улучшений при переходе к Blackwell Ultra. Также свою роль сыграло использованием фирменного 4-бит формата NVFP4. «Мы можем обеспечить точность, сопоставимую с BF16», — сообщила компания, добавив, что при этом потребляется значительно меньше вычислительной мощности. Для работы с контекстом NVIDIA готовит соускоритель Rubin CPX. В более компактных бенчмарках решения NVIDIA также продемонстрировали рекордную пропускную способность. Компания сообщила о более чем 18 тыс. токенов/с на один ускоритель в бенчмарке Llama 3.1 8B в автономном режиме и 5667 токенов/с на один ускоритель в Whisper. Результаты были представлены в офлайн-, серверных и интерактивных сценариях, при этом NVIDIA сохранила лидерство в расчете на GPU во всех категориях. AMD представила результаты AMD Instinct MI355X только в «открытой» категории, где разрешены программные модификации модели. Ускоритель MI355X превзошёл в бенчмарке Llama 2 70B ускоритель MI325X в 2,7 раза по количеству токенов/с. В этом раунде AMD также впервые обнародовала результаты нескольких новых рабочих нагрузок, включая Llama 2 70B Interactive, MoE-модель Mixtral-8x7B и генератор изображений Stable Diffusion XL. В число «закрытых» заявок AMD входили системы на базе ускорителей AMD MI300X и MI325X. Более продвинутый MI325X показал результаты, схожие с показателями систем на базе NVIDIA H200 на Llama 2 70b, в комбинированном тесте MoE и тестах генерации изображений. Кроме того, компанией была представлена первая гибридная заявка, в которой ускорители AMD MI300X и MI325X использовались для одной и той же задачи инференса — бенчмарка на базе Llama 2 70b. Возможность распределения нагрузки между различными типами ускорителей — важный шаг, отметил IEEE Spectrum. В этом раунде впервые был представлен и ускоритель Intel Arc Pro. Для бенчмарков использовалась видеокарта MaxSun Intel Arc Pro B60 Dual 48G Turbo, состоящая из двух GPU с 48 Гбайт памяти, в составе платформы Project Battlematrix, которая может включать до восьми таких ускорителей. Система показала результаты на уровне NVIDIA L40S в небольшом тесте LLM и уступила ему в тесте Llama 2 70b. Следует также отметить, что в этом раунде, как и в предыдущем, участвовала Nebius (ранее Yandex N.V.). Компания отметила, что результаты, полученные на односерверных инсталляциях, подтверждают, что Nebius AI Cloud обеспечивает «высочайшие» показатели производительности для инференса базовых моделей, таких как Llama 2 70B и Llama 3.1 405B. В частности, Nebius AI Cloud установила новый рекорд производительности для NVIDIA GB200 NVL72. По сравнению с лучшими результатами предыдущего раунда, её однохостовая инсталляция показала прирост производительности на 6,7 % и 14,2 % при работе с Llama 3.1 405B в автономном и серверном режимах соответственно. «Эти два показателя также обеспечивают Nebius первое место среди других разработчиков MLPerf Inference v5.1 для этой модели в системах GB200», — сообщила компания.

12.09.2025 [11:39], Сергей Карасёв

OpenAI и NVIDIA инвестируют миллиарды долларов в британские дата-центрыКомпании OpenAI и NVIDIA, по сообщению Bloomberg News, намерены в ближайшее время объявить о масштабных инвестициях в инфраструктуру дата-центров в Великобритании. Речь идёт о вложениях в размере «миллиардов долларов». Ожидается, что анонс будет сделан на следующей неделе во время второго государственного визита президента США Дональда Трампа в Великобританию, который пройдёт с 17 по 19 сентября. Король Карл III и королева Камилла примут американского лидера и его жену Меланию в Виндзорском замке в графстве Беркшир. В состав делегации США войдут руководители ряда американских корпораций, включая генерального директора OpenAI Сэма Альтмана (Sam Altman) и главу NVIDIA Дженсена Хуанга (Jensen Huang). Ожидается, что эти компании в рамках финансирования развития британских ЦОД объединят усилия с лондонской фирмой Nscale Global Holdings Ltd. В целом, как ожидается, во время предстоящего визита Трампа американские компании из различных отраслей объявят о десятках миллиардов долларов инвестиций в Великобританию. Представители OpenAI и NVIDIA ситуацию пока никак не комментируют. OpenAI стремится укрепить позиции в Европе, где она сталкивается с гораздо более строгим регулированием, нежели в США. С мая нынешнего года компания реализует программу OpenAI for Countries, которая предполагает создание ИИ ЦОД по всему миру. Первым европейским дата-центром, создающимся в рамках этой инициативы, станет объект Stargate Norway в Норвегии. На начальном этапе мощность этого ЦОД составит 230 МВт с возможностью последующего добавления ещё 290 МВт. Интерес к развитию инфраструктуры дата-центров в Великобритании проявляют и другие американские компании. В частности, в конце прошлого года стало известно о том, что Cloud HQ, CyrusOne, CoreWeave и ServiceNow намерены вложить около $8,22 млрд в строительство ЦОД в этой стране.

12.09.2025 [11:35], Сергей Карасёв

150 кВт на стойку для тестов: Digital Realty открыла лабораторию DRIL для ускорения внедрения ИИ и гибридного облакаОператор дата-центров Digital Realty объявил об открытии лаборатории инноваций DRIL (Digital Realty Innovation Lab) — специализированной тестовой площадки, призванной ускорить внедрение ИИ и гибридного облака. Партнёрами в рамках данного проекта являются Lenovo, AMD, Cisco и CommScope, которые предоставляют различные аппаратные и инфраструктурные решения. Отмечается, что ИИ оказывает преобразующее влияние на самые разные отрасли. Однако при его масштабном развёртывании предъявляются высокие требования к инфраструктуре ЦОД в плане обеспечения необходимой производительности при одновременной оптимизации энергопотребления. Площадка DRIL призвана помочь компаниям в создании сложных архитектур, ориентированных на ресурсоёмкие задачи ИИ. DRIL предоставляет партнёрам и клиентам полностью поддерживаемую реальную тестовую среду для апробации ИИ-развёртываний и гибридных облачных сред перед их масштабированием. Компании могут запускать собственные рабочие нагрузки с целью проверки эффективности и оптимизации.

Источник изображения: Digital Realty Лаборатория DRIL сформирована на базе кампуса Digital Realty в Северной Вирджинии. На площадке, оснащённой серверами с процессорами AMD EPYC и ускорителями AMD Instinct, могут тестироваться рабочие нагрузки ИИ и HPC. Говорится о высокоплотном размещением оборудования — свыше 150 кВт на серверную стойку. Задействована технология прямого жидкостного охлаждения (DLC) Lenovo Neptune. Лаборатория DRIL, как подчёркивается, позволяет компаниям раскрыть весь потенциал ИИ и корпоративных рабочих нагрузок, даже если у них нет собственного дата-центра с современным оборудованием. Используя DRIL, клиенты могут снизить риски, оптимизировать конфигурацию своих систем и ускорить переход от этапа проверки концепции к фактическому внедрению. Предприятия могут тестировать различные сценарии задержек в разных локациях, оценивать требования к питанию, охлаждению и GPU-ресурсам, а также управлять ИИ-нагрузками.

12.09.2025 [07:26], Сергей Карасёв

Kioxia и NVIDIA разрабатывают SSD нового типа для ИИ-систем в качестве альтернативы HBMКомпании Kioxia и NVIDIA, по сообщению Nikkei, разрабатывают SSD нового типа для ИИ-систем, которые по показателю IOPS (операций ввода/вывода в секунду) будут превосходить современные изделия практически в 100 раз. Предполагается, что такие устройства смогут стать альтернативой HBM при расширении памяти ИИ-ускорителей. Коити Фукуда (Koichi Fukuda), главный инженер подразделения твердотельных накопителей Kioxia, рассказал, что компания проектирует устройства в соответствии с требованиями NVIDIA. Речь идёт об SSD следующего поколения с интерфейсом PCIe 7.0. Предполагается, что такие изделия смогут демонстрировать показатель IOPS на уровне 100 млн, что позволит применять их в том числе для ИИ-инференса. Более того, NVIDIA стремится к достижению значения IOPS в 200 млн. Такого результата Kioxia рассчитывает добиться путём объединения в массив двух SSD нового типа. Особенностью этих накопителей станет то, что они смогут обмениваться данными с GPU напрямую, не вовлекая в эти операции CPU, как в случае с традиционными решениями. Пробные поставки устройств планируется организовать во II половине 2026 года, тогда как на коммерческом рынке накопители нового типа могут появиться в 2027-м. Согласно прогнозам Kioxia, к 2029 году почти половина спроса на NAND-память, которая применяется в SSD, будет связана с системами ИИ. Участники рынка также говорят о возобновлении инвестиций в разработку NAND-продуктов после двухлетнего затишья. Восстановление активности среди производителей объясняется растущей потребностью в высокоскоростных накопителях большой вместимости с высокими показателями быстродействия при произвольном доступе. Одним из перспективных направлений названо создание решений на основе флеш-памяти с высокой пропускной способностью HBF (High Bandwidth Flash): разработки в данной сфере, в частности, ведёт SanDisk.

11.09.2025 [23:19], Владимир Мироненко

Nebius привлекла $3,75 млрд после заключения контракта с MicrosoftПоставщик облачных решений для ИИ Nebius (бывшая материнская структура «Яндекса» Yandex N.V.) привлёк $3,75 млрд благодаря размещению конвертируемых облигаций и продаже акций. Ранее сообщалось, что компания намерена увеличить капитальные затраты в 2025 году. В ходе размещения компания увеличила предложение конвертируемых ценных бумаг с первоначально объявленной суммы $2,0 млрд до $2,75 млрд, распределив её поровну между двумя траншами по $1,375 млрд в рамках закрытого предложения квалифицированным институциональным покупателям в соответствии с Правилом 144A Закона о ценных бумагах 1933 года. Первый транш со ставкой купона 1,0 % должен быть погашен в 2030 году, второй со ставкой купона 2,75 % подлежит погашению в 2032 году. Цена конвертации облигаций составляет $138,75 за единицу, что соответствует 50-% премии к цене их размещения. Также было продано акций класса А по цене $92,5 за единицу на сумму $1,0 млрд. Согласно пресс-релизу Nebius, привлечённые средства будут использованы «для финансирования дальнейшего роста бизнеса, включая приобретение дополнительных вычислительных мощностей и оборудования, приобретение стратегически важных высококачественных и удобно расположенных земельных участков у надежных поставщиков, расширение сети своих центров обработки данных, а также для общих корпоративных целей». Привлечение средств Nebius последовало после заключения крупного контракта с Microsoft на предоставление технологическому гиганту в течение пяти лет доступа к выделенной ИИ-инфраструктуре в новом ЦОД в Винеленде (Vineland) в Нью-Джерси (на изображении выше). Стоимость контракта составляет $17,4 млрд с возможностью увеличения суммы сделки до $19,4 млрд за счёт увеличения предоставляемых мощностей и услуг. О планах Nebius по созданию ЦОД в Нью-Джерси, который теперь будет по крайней мере частично сдан в аренду Microsoft, стало известно в марте. Первоначальная мощность ЦОД составляет 300 МВт с возможностью расширения ещё на 400 МВт. Также у компании есть площадки в Финляндии, где она в прошлом году пообещала увеличить мощность до 75 МВт, и во Франции. Как сообщает Datacenter Dynamics, компания также развёртывает кластеры в ЦОД Patmos в Канзас-Сити (штат Миссури), в ЦОД Verne Global в Исландии, в ЦОД Ark в Великобритании и на новом объекте в Израиле.

11.09.2025 [14:09], Сергей Карасёв

Разработчик квантовых технологий Infleqtion выйдет на биржуКомпания Infleqtion, занимающаяся разработкой квантовых систем, по сообщению Datacenter Dynamics, намерена выйти на биржу Nasdaq. Ожидается, что эта процедура принесёт более $540 млн, что позволит ускорить разработку продуктов и укрепить рыночное положение. Infleqtion была основана в 2007 году под именем ColdQuanta на базе Университета Колорадо (CU) в США. Она разрабатывает приборы и системы на основе квантовых технологий. Это, в частности, квантовые компьютеры Sqale, а также компактные оптические атомные часы Tiqker, которые можно использовать для позиционирования, навигации и синхронизации времени (PNT). Выход на биржу планируется осуществить посредством SPAC-сделки с Churchill Capital Corp X. По сути SPAC (Special-Purpose Acquisition Company) — это компания-пустышка, которая уже торгуется на бирже. Слияние с такой структурой позволяет ускорить и упростить процедуру выхода на биржу по сравнению с традиционным первичным публичным размещением акций (IPO). Советы директоров Infleqtion и Churchill Capital Corp X единогласно одобрили сделку. Предполагается, что она принесёт Infleqtion около $416 млн на трастовом счете Churchill Capital Corp X и более $125 млн в виде полностью подписанного договора PIPE (private investment in public equity, частные инвестиции в публичный капитал) от таких инвесторов, как Maverick Capital, Counterpoint Global (Morgan Stanley), Glynn Capital, BOKA Capital, LCP Quantum и др. После закрытия сделки объединенная компания продолжит работать под названием Infleqtion и, как ожидается, будет котироваться на бирже Nasdaq под тикером INFQ. Отмечается, что на сегодняшний день Infleqtion продала три квантовых компьютера и сотни квантовых датчиков. Выручка компании за двенадцать месяцев по состоянию на конец июня 2025 года составила около $29 млн. Infleqtion рассчитывает получить примерно $50 млн от готовящихся и уже оформленных заказов к концу 2025 года.

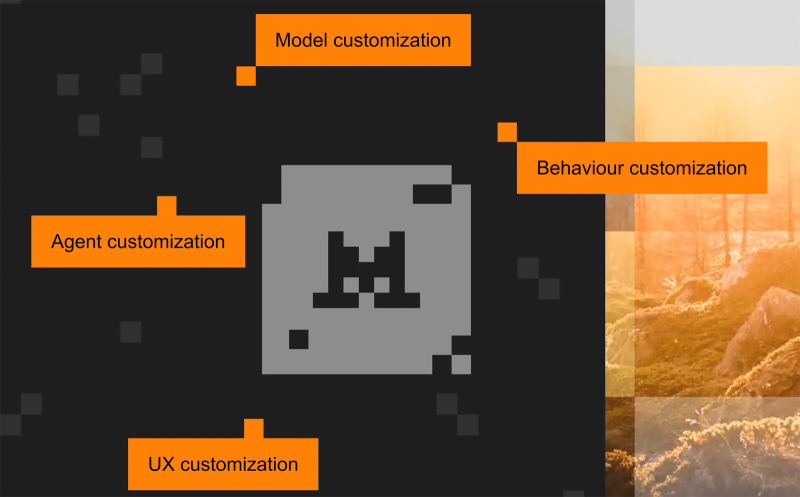

11.09.2025 [14:04], Сергей Карасёв

Стартап Mistral AI привлёк на развитие €1,7 млрд при участии ASMLФранцузская компания Mistral AI, специализирующаяся на технологиях ИИ и разработке больших языковых моделей (LLM), провела раунд финансирования Series C, в ходе которого на развитие привлечено €1,7 млрд. При этом стартап получил оценку на уровне €11,7 млрд. Mistral AI была основана в 2023 году. Она рассматривается в качестве европейского конкурента таким крупным американским компаниям в области ИИ, как OpenAI и Anthropic. В число разработок Mistral AI входит интеллектуальный чат-бот Le Chat. Кроме того, стартап вместе с NVIDIA представил большую языковую модель (LLM) Mistral NeMo 12B, которая насчитывает 12 млрд параметров и использует контекстное окно в 128 тыс. токенов. Эта модель предназначена для решения различных задач корпоративного уровня. Изначально Mistral AI использовала инфраструктуру Microsoft Azure и Google Cloud для обучения и запуска своих моделей ИИ, а впоследствии обратилась к услугам CoreWeave. Кроме того, Mistral AI управляет собственным облаком ИИ — Mistral Compute. В феврале нынешнего года компания объявила о размещении своего ИИ-кластера на площадке французского оператора модульных дата-центров Eclairion. Помимо этого, Mistral AI объявила об объединении усилий с инвестиционным банком Bpifrance, инвестиционным фондом ОАЭ MGX и NVIDIA для строительства ИИ ЦОД мощностью 1,4 ГВт в районе Парижа: этот объект планируется ввести в эксплуатацию к 2028 году. Раунд финансирования Series C возглавил нидерландский производитель литографического оборудования для микроэлектронной промышленности ASML. Кроме того, в инвестиционной программе приняли участие DST Global, Andreessen Horowitz, Bpifrance, General Catalyst, Index Ventures, Lightspeed и NVIDIA. Полученные средства стартап намерен направить на дальнейшее развитие передовых технологий ИИ для «решения критически важных и сложных технологических задач, стоящих перед стратегическими отраслями».

11.09.2025 [14:01], Сергей Карасёв

OpenAI заключила контракт стоимостью $300 млрд на покупку вычислительных мощностей у OracleКомпания OpenAI, по сообщению газеты The Wall Street Journal, заключила пятилетнее соглашение о приобретении вычислительных мощностей у Oracle для задач ИИ. Стоимость контракта составляет $300 млрд, что многократно превышает годовую выручку OpenAI, которая по итогам 2025-го ожидается на уровне $12,7 млрд. Сама Oracle на днях сообщила, что объём заказов (RPO) достиг почти $0,5 трлн. Стартап OpenAI в настоящее время использует облачную инфраструктуру Microsoft Azure, но этих ресурсов недостаточно для обслуживания масштабных ИИ-нагрузок. В сложившейся ситуации в марте нынешнего года OpenAI заключила соглашение по использованию облачной инфраструктуры CoreWeave: договор стоимостью $11,9 млрд подписан на пять лет. Позднее OpenAI заключила ещё одну сделку с CoreWeave — на $4 млрд. Вместе с тем OpenAI активно развивает партнёрские отношения с Oracle. В октябре прошлого года сообщалось, что ИИ-стартап намерен арендовать у Oracle кампус ЦОД мощностью 2 ГВт. Кроме того, OpenAI объявила о заключении соглашения с Oracle о строительстве дополнительных дата-центров мощностью 4,5 ГВт в США в рамках расширенного партнёрства, что является частью масштабного проекта Stargate. Сама Oracle рассчитывает найти для OpenAI 5 ГВт на обучение ИИ к концу 2026 года. Как отмечает The Wall Street Journal, контакт на $300 млрд между OpenAI и Oracle является одной из крупнейших сделок в истории облачных вычислений. Соглашение вступит в силу в 2027 году. По оценкам, речь идёт о мощностях на уровне 4,5 ГВт, что сопоставимо с суммарным потреблением энергии примерно 4 млн среднестатистических домохозяйств. Ресурс TechCrunch подчёркивает, что OpenAI остро нуждается в дополнительных вычислительных ресурсах, в связи с чем активно заключает партнёрские соглашения. Так, минувшим летом стартап подписал договор об использовании облачной платформы Google Cloud для обработки своих ИИ-нагрузок — несмотря на то, что Google является прямым конкурентом OpenAI в сфере ИИ. Предполагается, Google Cloud поможет в поддержании операций OpenAI в США, Великобритании, Нидерландах, Норвегии и Японии. |

|