Материалы по тегу: ии

|

06.10.2025 [14:00], Сергей Карасёв

HP представила компактный «ИИ-суперкомпьютер» ZGX Nano G1n AI Station на основе NVIDIA GB10Компания HP анонсировала рабочую станцию ZGX Nano G1n AI Station небольшого форм-фактора, предназначенную для работы с ИИ, включая «тонкую» настройку языковых моделей, инференс и агентные приложения. Основой новинки служит суперчип NVIDIA GB10 Grace Blackwell. В целом решение практически не отличается от систем на базе GB10 других вендоров. Устройство заключено в корпус с габаритами 150 × 150 × 51 мм, а масса составляет 1,25 кг. В состав чипа GB10 входят 20-ядерный процессор Grace (10 × Arm Cortex-X925 и 10 × Arm Cortex-A725) и ускоритель Blackwell. Имеется 128 Гбайт унифицированной системной памяти LPDDR5x, пропускная способность которой достигает 273 Гбайт/с. Компьютер может быть оборудован SSD типоразмера M.2 вместимостью 1 или 4 Тбайт (NVMe OPAL). В оснащение входят сетевой контроллер 10GbE (Realtek RTL8127), адаптер NVIDIA ConnectX-7 200GbE, беспроводной модуль MediaTek MT7925 с поддержкой Wi-Fi 7 (2×2) / Bluetooth 5.4. В тыльной части корпуса располагаются разъём USB Type-C для подачи питания, три порта USB Type-C (20 Гбит/с), гнездо RJ45 (10GbE), два порта QSFP и интерфейс HDMI 2.1a.

Источник изображения: HP На устройстве применяется программная платформа NVIDIA DGX OS на базе Ubuntu, оптимизированная специально для задач ИИ. Заявленная производительность достигает 1000 TOPS на операциях FP4. Возможна работа с ИИ-моделями, насчитывающими до 200 млрд параметров. Кроме того, два экземпляра ZGX Nano G1n AI Station могут быть объединены в одну систему, что позволит использовать ИИ-модели, оперирующие 405 млрд параметров. Продажи компактного ИИ-суперкомпьютера начнутся текущей осенью.

06.10.2025 [08:32], Сергей Карасёв

OpenAI оснастит дата-центры энергетическим оборудованием HitachiКомпании OpenAI и Hitachi, по сообщению Nikkei, подписали меморандум о взаимопонимании с целью развития ИИ-инфраструктуры и создания энергетически эффективных дата-центров в глобальном масштабе. Основными целями партнёрства заявлены ускорение разработки генеративного ИИ и снижение затрат на эксплуатацию ЦОД. В рамках сотрудничества Hitachi будет поставлять передовое оборудование для передачи и распределения электроэнергии в дата-центры OpenAI по всему миру. Ожидается, что эти системы помогут снизить потребление электричества и тем самым сократить расходы на поддержание работы ИИ ЦОД. В свою очередь, OpenAI, по условиям соглашения, предоставит Hitachi свои большие языковые модели (LLM). Они могут быть интегрированы в цифровую платформу Hitachi Lumada, которая представляет собой комплексное решение для индустриального интернета вещей (IIoT). Говорится также, что Hitachi внесёт вклад в проект Stargate — это совместное предприятие OpenAI, SoftBank и Oracle по развитию ИИ-инфраструктуры в США. Предполагается, что суммарные затраты на реализацию Stargate достигнут $500 млрд. Планируется, что OpenAI начнёт закупать IT-оборудование Hitachi, включая СХД. В состав Hitachi, напомним, входит дочерняя структура Hitachi Vantara, которая специализируется на продуктах для управления данными, включая оборудование, ПО и услуги для облачных платформ и дата-центров. Нужно отметить, что недавно в США были введены в эксплуатацию первые ИИ ЦОД флагманского кампуса OpenAI Stargate. Кроме того, OpenAI объявила о намерении построить пять дополнительных дата-центров по всей территории США. Новые объекты расположатся, в частности, в округах Шакелфорд (Shackelford) в штате Техас и Донья-Ана (Doña Ana) в штате Нью-Мексико.

06.10.2025 [00:17], Руслан Авдеев

Meta✴ построит ещё один «палаточный» ИИ ЦОДНеобходимость быстрой реализации кампуса ИИ ЦОД Prometheus в Огайо сподвигла Meta✴ на использование «палаток» — быстровозводимых тентов с алюминиевым каркасом, покрытым водонепроницаемой тканью, устойчивой к повреждениям. На днях компания получила разрешение от властей Теннеси на создание аналогичного «палаточного городка» в Галлатине (Gallatin), Datacenter Dynamics. Как и Prometheus, он расположится на территории уже действующего кампуса ЦОД с более традиционными капитальными постройками. Площадь нового объекта должна составить 12 542 м2. В июле появилась информация, что компания начала размещать кластеры ИИ-ускорителей стоимостью в несколько миллиардов долларов в тентах, лишённых даже резервного питания и готовых к отлючению из-за сбоев питания и охлаждения. На тот момент считалось, что тенты будут использоваться временно, пока не построят постоянные корпуса ЦОД. Впрочем, глава Meta✴ Марк Цукерберг (Mark Zuckerberg) заявил, что в компании есть сильная команда, занимающаяся разработкой ЦОД, и он хотел бы, чтобы они не просто строили большие бетонные здания по четыре года каждое. Из-за этого и родилась идея с тентами.

Источник изображения: Meta✴ Кампус в Галлатине официально открылся в ноябре 2024 года. Изначально планировалось построить на территории дата-центр площадью 91 300 м2 и сопутствующую инфраструктуру на участке площадью 325 га. Впоследствии проект получил ещё 58 250 м2 площадей ЦОД и 4180 м2 офисных помещений. А уже в этом году компания приступила к строительству ещё одного здания, что увеличит общую полезную площадь кампуса до 176 516 м2. Дополнительно Meta✴ стремится наращивать возможности в сфере ИИ с помощью аренды ускорителей у других компаний. На днях она подписала облачное соглашение на $14,2 млрд с CoreWeave, которая предоставит IT-гиганту доступ к собственным ИИ-чипам. В августе 2025 года она заключила договор с Google Cloud на сумму $10 млрд сроком на шесть лет. Сейчас компания ведёт переговоры и с Oracle — об облачном соглашении на $20 млрд.

04.10.2025 [12:56], Сергей Карасёв

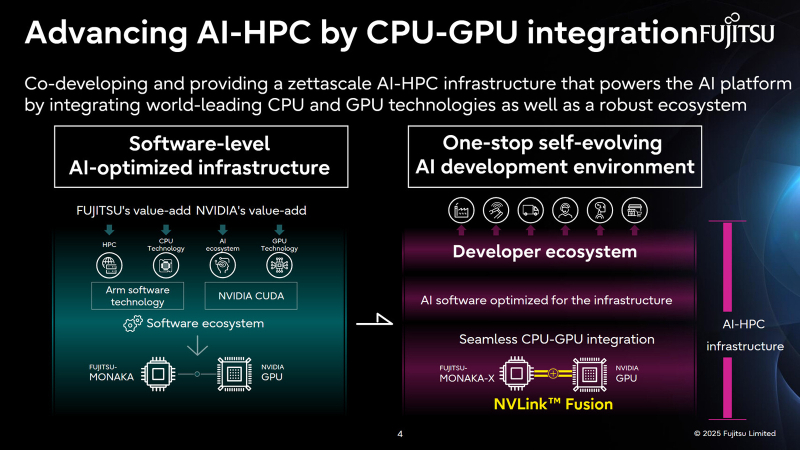

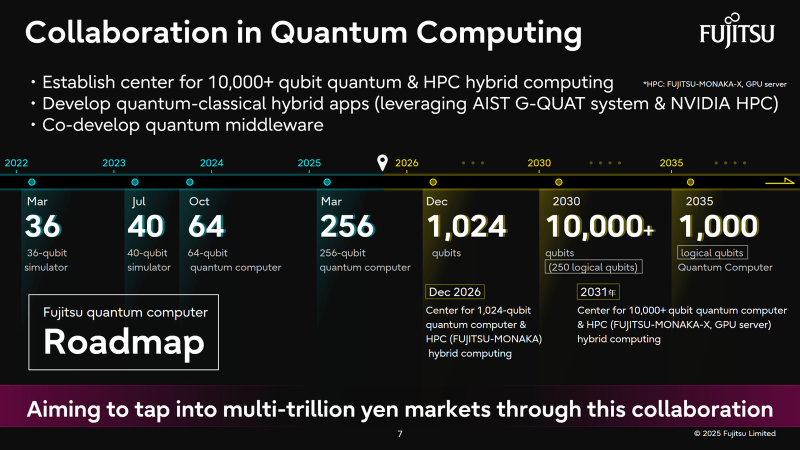

Fujitsu и NVIDIA создадут вычислительную ИИ-инфраструктуру нового поколенияЯпонская корпорация Fujitsu объявила о расширении стратегического сотрудничества с NVIDIA с целью создания полнофункциональной инфраструктуры ИИ следующего поколения, в состав которой войдут ИИ-агенты. Предполагается, что инициатива поможет ускорить развитие таких отраслей, как здравоохранение, производство, робототехника и др. Партнёры намерены работать по ряду направлений. В частности, Fujitsu и NVIDIA займутся созданием передовой вычислительной инфраструктуры для задач ИИ. Речь идёт об объединении серверных процессоров Fujitsu Monaka на архитектуре Arm с высокопроизводительными GPU разработки NVIDIA. Для этого будет задействована технология NVLink Fusion, позволяющая применять скоростные интерконнекты NVLink со сторонними чипами. Конечной целью является предоставление комплексной экосистемы HPC-ИИ с интегрированным софтом Fujitsu для Arm-процессоров и NVIDIA CUDA. Кроме того, сотрудничество предусматривает создание «саморазвивающейся» платформы ИИ-агентов. Она, как ожидается, обеспечит высокую производительность и безопасность. Планируется внедрение механизма, который позволит агентам и моделям ИИ развиваться автономно с возможностью оптимизации под запросы конкретных отраслей. В конечном итоге, такие агенты будут предоставляться заказчикам в виде микросервисов NVIDIA NIM. Ещё одним направлением сотрудничества названо формирование партнёрской экосистемы для расширения использования агентов и моделей ИИ. Планируется также разработка передовых квантовых технологий, включая гибридные квантово-классические вычислительные системы на основе чипов Monaka и НРС-решений NVIDIA. В целом, как отмечается, к 2030 году спрос на вычислительные мощности для ИИ в Японии вырастет в 320 раз по сравнению с 2020-м. На этом фоне местные компании, включая Fujitsu, SoftBank и KDDI, активно реализуют различные проекты, направленные на развитие рынка ИИ.

03.10.2025 [15:57], Руслан Авдеев

Задержки поставок ИИ-чипов в ОАЭ на десятки миллиардов долларов расстраивают NVIDIAСпустя пять месяцев после заключения многомиллиардной сделки по поставке ИИ-ускорителей в ОАЭ, процесс её реализации фактически заморожен. Это обескураживает как главу NVIDIA Дженсена Хуанга (Jensen Huang), так и некоторых чиновников из Белого дома, сообщает The Wall Street Journal. В рамках сделки, анонсированной в мае, ОАЭ пообещали инвестировать в США большие средства в обмен на обещание поставок сотен тысяч ИИ-ускорителей ежегодно. Однако спустя месяцы после переговоров инвестиции так и не стартовали. Будущее соглашения сейчас в руках министра торговли США Говарда Лютника (Howard Lutnick), в своё время поддержавшего сделку. Разрешение Министерства торговли имеет критическое значение, поскольку именно оно должно дать NVIDIA и другим производителям право на поставку ИИ-чипов в ОАЭ. По некоторым данным, министр оказывает давление на Эмираты, чтобы те, наконец, вложили в экономику США обещанные средства — иначе судьба поставок ускорителей в страну окажется под вопросом. Президент США Дональд Трамп (Donald Trump) одобрил сделку с ОАЭ в ходе майского турне, в надежде продвинуть собственные ИИ-технологии вместо китайских. На тот момент было заявлено, что Белый дом подготовил сделки с ОАЭ на сумму $200 млрд, включая соглашение о помощи в развитии американских технологий и производства. Результаты переговоров имеют немалое значение для Лютника, поскольку того и так критикуют за введение высоких импортных пошлин и платы $100 тыс. за визу H-1B, по которой в США въезжали попадали многие технические специалисты. Давление оказывает и NVIDIA, которая крайне заинтересована в расширении поставок. Хуанг и его соратники неоднократно жаловались на политику Лютника и медленный прогресс в одобрении экспорта. Правда, точных данных о том, что именно он заморозил поставки, пока нет. В ОАЭ придерживаются позиции, что в ответ на миллиардные инвестиции в страну должны поставлять ускорители NVIDIA на миллиарды долларов. По данным чиновников, как минимум $1 млрд будет вложен в США в обмен на поставки чипов на $1 млрд к концу года. По некоторым сведениям, за чипы ОАЭ будет расплачиваться отдельно и без учёта инвестиций. ОАЭ демонстрирует приверженность идее инвестиций в американские ЦОД и даже вели дела с представителями семьи самого Трампа. Что касается инвестиций, США стремятся поощрять вложения в американскую экономику не только со стороны Эмиратов. Так, недавно была заключена сделка с Японией, которая обязалась инвестировать в США $550 млрд, в специальный фонд поднадзорный министру торговли. Тем временем NVIDIA стремится добиться экспортных лицензий на поставку чипов и в Китай. В своё время у производителей потребовали отчислять 15 % от выручки за поставки в эту страну урезанных версий ускорителей. В рамках соглашения с ОАЭ, большинство чипов в страну будет поставляться представительствам американских компаний. Некоторые чиновники бьют тревогу в связи с участием в сделке G42 из Абу-Даби. Есть опасения, что прямые поставки чипов ей приведут к перепродаже их в Китай, с которым у компании были довольно тесные связи. Пока Министерство торговли не планирует поставок G42, но это не исключено в будущем.

03.10.2025 [08:58], Сергей Карасёв

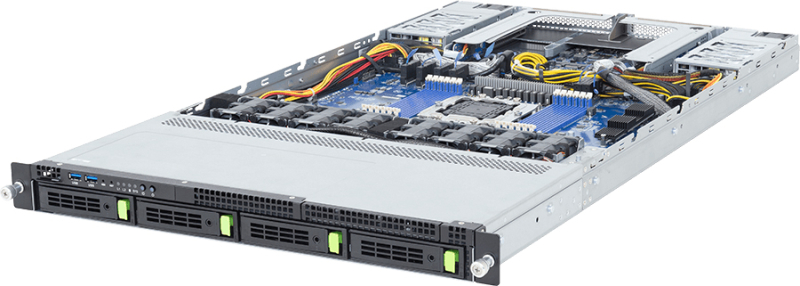

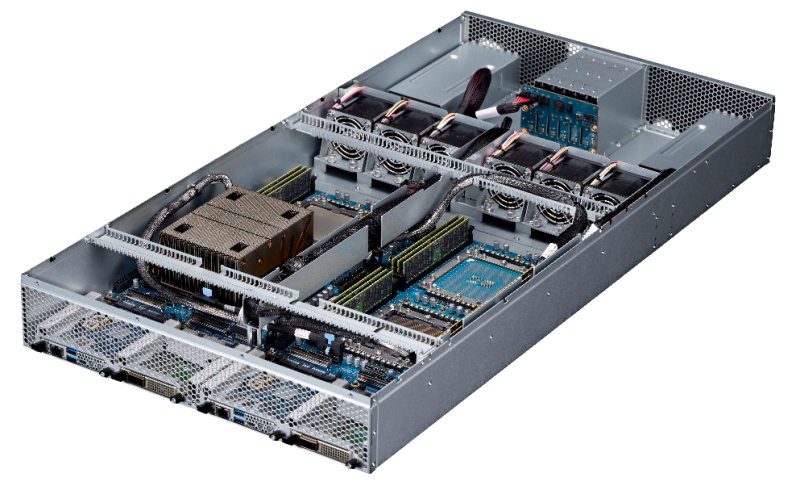

Giga Computing представила серверы с Arm-чипами AmpereOne M для ИИ-инференсаКомпания Giga Computing, подразделение Gigabyte, анонсировала серверы R1A3-T40 и R2A3-T40, построенные на процессорах AmpereOne M, которые спроектированы специально для поддержания ресурсоёмких ИИ-нагрузок в дата-центрах. Представленные системы подходят для инференса, облачных приложений и пр. Модель R1A3-T40 выполнена в форм-факторе 1U, устройство R2A3-T40 — в корпусе 2U. В обоих случаях допускается установка одного чипа AmpereOne M, который может содержать до 192 кастомизированных 64-бит ядер на базе Arm v8.6+. Показатель TDP — до 425 Вт. Есть 12 слотов для модулей оперативной памяти DDR5-5600. Младшая версия располагает четырьмя фронтальными отсеками для накопителей LFF/SFF с интерфейсом SATA/SAS-4 или PCIe 5.0 (NVMe). Доступны два слота PCIe 5.0 x16 для карт расширения типоразмера FHHL и два разъёма OCP NIC 3.0 PCIe 5.0 x16. Сервер 2U, в свою очередь, оснащён 12 посадочными местами для SFF-накопителей (SATA/SAS-4 или PCIe 5.0), одним слотом PCIe 5.0 x16 и одним разъёмом OCP NIC 3.0 PCIe 5.0 x16. Новинки несут на борту контроллер ASPEED AST2600 и сетевой адаптер Intel I210-AT стандарта 1GbE. Есть выделенный сетевой порт управления 1GbE, а также коннектор M.2 для SSD формата 2242/2260/2280/22110 с интерфейсом PCIe 5.0 x4. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 PLUS Titanium. Предусмотрены три порта USB 3.2 Gen1 Type-A (два располагаются на лицевой панели), порт Micro-USB, интерфейс Mini-DP, гнёзда RJ45 для сетевых кабелей и аналоговый разъём D-Sub (только у модели R2A3-T40). Применена система воздушного охлаждения. Диапазон рабочих температур — от +10 до +35 °C.

02.10.2025 [21:02], Владимир Мироненко

Microsoft потратит $33 млрд на доступ к 100+ тыс. NVIDIA GB300 в неооблаках, но со временем хочет перейти на свои ИИ-ускорителиВ Сети появились новые подробности о сделке стоимостью до $19,4 млрд, заключённой Microsoft с Nebius Group NV в начале сентября. Как сообщает Bloomberg со ссылкой на информированные источники, Microsoft получит пятилетний доступ к выделенной инфраструктуре на базе более чем 100 тыс. суперускорителей NVIDIA GB300. Ранее сообщалось, что речь идёт о мощностях нового ЦОД Nebius в Вайнленде (Нью-Джерси, США). Как пишет Forbes, Nebius отличается от многих облачных провайдеров тем, что фокусируется только на рабочих нагрузках ИИ и МО, что позволяет лучше оптимизировать архитектуру ЦОД в отличие от гиперскейлеров, которые занимаются решением множества задач. Кроме того, Nebius отличается от других неооблаков, таких как CoreWeave, тем, что предоставляет инструменты и сервисы для разработчиков, которые позволяют совершенствовать ИИ-модели, выполнять инференс и разрабатывать кастомные решения, а не просто фокусируется на «чистой» вычислительной мощности. При этом Nebius начала наращивать вычислительные мощности ещё до того, как возник спрос на эти ресурсы, отметил Forbes. Подобные контракты Microsoft заключила с ещё несколькими неооблаками (neocloud), включая CoreWeave, Nscale и Lambda, на общую сумму в $33 млрд, и они обеспечивают её большую выгоду. Вместо того, чтобы тратить огромные ресурсы на строительство собственных ЦОД, Microsoft обращается к проверенному поставщику ИИ-инфраструктуры, благодаря чему может быстрее совершенствовать свою ИИ-инфраструктуру с меньшими первоначальными затратами, используя высвободившиеся мощности для предоставления клиентам прибыльных услуг на базе ИИ. Вдобавок такой подход позволяет Microsoft быстрее менять стратегию, чем при использовании собственных дата-центров. В начале бума ИИ Microsoft арендовала мощности даже у Oracle, своего прямого конкурента, для поддержки ИИ-функций в поиске Bing. Эти сделки также устраняют для Microsoft значительную часть финансовых рисков, связанных со строительством собственных ЦОД. Она не только сразу получает необходимые мощности для своих ИИ-сервисов, вместо того чтобы тратить годы на строительство ЦОД, но и перекладывает на других вопросы строительства, финансирования и управление этими ЦОД, что даёт компании большую финансовую гибкость. Так, Microsoft может отнести некоторые затраты к операционным, а не капитальным, что, по словам аналитика Bernstein Марка Мёрдлера (Mark Moerdler), даёт потенциальные преимущества для денежного потока, налогообложения и способа представления прибыли в финотчётах. Компания использует серверы неооблаков не только для обучения ИИ-моделей, но и для сложного инференса. Сделки с неооблаками становятся популярными и у конкурентов Microsoft, хотя им далеко до её масштабов. В мае 2025 года OpenAI расширила с конкурирующей с Nebius компанией CoreWeave контракт стоимостью $11,9 млрд на $4 млрд, после чего заключила ещё одно соглашение на $6,5 млрд, увеличив общую сумму соглашений до $22,4 млрд. Ещё один технологический гигант Meta✴ подписал сделку с CoreWeave на сумму в $14,2 млрд, обеспечив себе доступ к её облачным ИИ-сервисов на период до 2031 года. Вместе с тем в долгосрочной перспективе Microsoft намерена переключиться на ИИ-ускорители собственной разработки, которые обеспечивают лучший показатель TCO, передаёт CNBC. Два года назад компания представила первые ИИ-чипы Maia 100. Следующее поколение этих чипов, как ожидается, появится в 2026 году. При этом компания сосредоточится не на чипах в отдельности, а будет использовать более системный подход, учитывающий вопросы охлаждения, интерконнекта и т.д. Пока что, признаёт Microsoft, в течение многих лет решения NVIDIA обеспечивали лучшее соотношение цены к производительности.

02.10.2025 [14:49], Руслан Авдеев

$1,5 млрд за неделю: Nscale получила ещё $443 млн инвестиций, едва закрыв прошлый раунд финансирования на $1,1 млрдСтартап Nscale в рамках предварительного раунда финансирования SAFE серии C (соглашение об инвестициях в обмен на акции в будущем) привлёк $433 млн. Это случилось практически сразу после закрытия раунда B, который принёс компании $1,1 млрд, сообщает Datacenter Dynamics. В число инвесторов нового раунда вошли Blue Owl Managed Funds, Dell, NVIDIA и Nokia — все они принимали участие в раунде серии B. Также к ним присоединились и новые инвесторы. В Nscale утверждают, что «потрясены» проявленным интересом, и именно это позволило запустить очередной раунд всего через несколько дней после завершения раунда B. Успех последнего — убедительное подтверждение правильности стратегии компании по созданию независимой масштабируемой инфраструктуры для эпохи ИИ. Nscale основана в 2024 году, но корни её лежат в сфере майнинга криптовалют. Пока что у компании есть только один собственный дата-центр, расположенный в норвежском Гломфьорде (Glomfjord). Он запитан от местной ГЭС и использует естественное охлаждение, остаётся единственным объектом в собственности компании. В последние месяцы она оказалась в центре внимания благодаря контрактам OpenAI и Microsoft. До того, как состоялся раунд B, сообщалось, что Nscale рассчитывает привлечь $2,7 млрд. В январе 2025 года Nscale сообщила о намерении инвестировать $2,5 млрд ($3 млрд) в ИИ-инфраструктуру в Великобритании. Дата-центр планировалось построить в городе Лоутон (Loughton, Эссекс). Там разместится суперкомпьютер Microsoft. В Норвегии Nscale заключила договор с OpenAI для реализации проекта Stargate Norway. Для него у Nscale будут арендовать мощности в дата-центре в Квандале (Kvanndal) близ Нарвика (Narvik), строительством которого занимается компания Aker. Клиентом Nscale и Aker в Норвегии намерена стать и Microsoft, заключившая на пять лет договор на закупку вычислительных мощностей на $6,2 млрд. Собственное соглашение с Nscale заключила и Nokia. В последней уверены, что спрос на создание безопасной масштабируемой инфраструктуры в Европе и мире растёт, а интеллектуальная собственность Nokia и её опыт в области оптических сетей позволит компаниям внедрять инновации, необходимые для ИИ-инфраструктуры будущего.

02.10.2025 [13:10], Руслан Авдеев

Meta✴ приобрела Rivos, разработчика RISC-V-ускорителей, совместимых с CUDAMeta✴ Platforms приобрела занимающийся разработкой ИИ-чипов на базе RISC-V стартап Rivos. Это должно ускорить разработку собственных полупроводников и снизить зависимость от сторонних поставщиков, сообщает Silicon Angle. Условия покупки пока неизвестны, но ключевой инвестор стартапа, Walden Catalyst, с гордостью сообщил о сделке, а нынешний генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan), имевший прямое отношение к созданию и развитию стартапа, поздравил команду. Стартап был основан в 2021 году, а в 2023-м к нему присоединились около полусотни бывших инженеров Apple. Meta✴ будет использовать опыт Rivos для расширения работ над семейством собственных ИИ-ускорителей Meta✴ Training and Inference Accelerator (MTIA). Впрочем, Rivos использовала комплексный подход, разрабатывая CPU и GPUGPU-чипы с кеш-когерентностью и унифицированным доступом к памяти (DDR и HBM), дополненные интегрированным 800G-интерконнектом на базе Ultra Ethernet. Это похоже на подход NVIDIA при создании суперускорителей. В 2025 году Rivos выпустила на TSMC тестовый чип, работающий на частоте 3,1 ГГц и программный стек, совместимый с NVIDIA CUDA. Изначальная стратегия предполагала создание энергоэффективного ИИ-ускорителя с частотой до 3,5 ГГц, совместимого с существующей экосистемой, который планировалось продавать гиперскейлерам (хотя бы одному). Первую коммерческую платформу компания собиралась выпустить в следующем году, она позволила бы перекомпилировать, а не переписывать с нуля приложения, созданные для платформ NVIDIA. Компания также принимала участие в создании RISC-V RVA23 Profile. Хотя Meta✴ не раскрыла стоимость сделки, вероятно, речь идёт о миллиардных тратах. В августе сообщалось, что стартап вёл переговоры с инвесторами о возможном раунде финансирования в объёме $300–$400 млн, а то и $500 млн, что повысило бы оценку стоимости компании до более чем $2 млрд. ИИ-проекты Meta✴ полагаются преимущественно на сторонние аппаратные решения. Компания потратила миллиарды долларов на покупку ускорителей, в основном NVIDIA, и потратит ещё миллиарды на аренду ИИ-инфраструктуры у сторонних игроков. В частности, буквально на днях она подписала новую сделку с CoreWeave на $14,2 млрд. В этом году капзатраты могут достигнуть $72 млрд, а выпуск собственных чипов позволил бы компании сэкономить миллиарды долларов, снизив зависимость от NVIDIA и облачных операторов. По словам Constellation Research, Meta✴ является единственным крупным ИИ-предприятием, почти полностью зависящим от инфраструктурных решений NVIDIA. Имеются данные, что компания уже взаимодействовала с Rivos некоторое время, поэтому и решила приобрести стартап целиком. Если инициатива увенчается успехом, это поможет Meta✴ снизить расходы как на обучение, так и на инференс. Также сообщается, что Meta✴ работает с TSMC над выпуском своего нового чипа, и уже отправила на производство необходимую документацию для выпуска пробных образцов для оценки их эффективности.

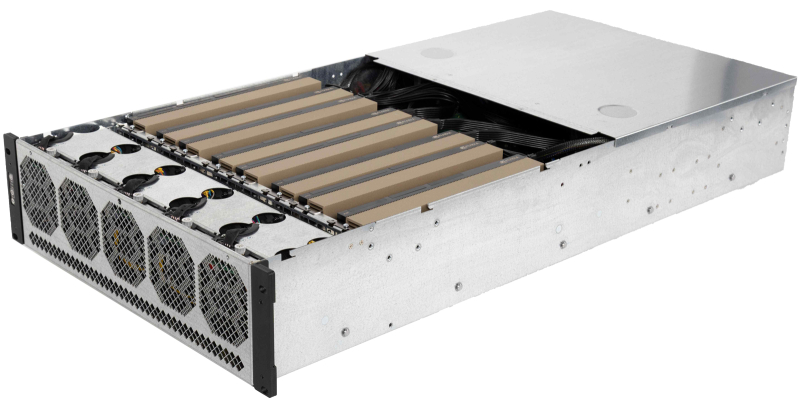

02.10.2025 [10:56], Сергей Карасёв

РСК представила внешний JBOG-массив RSC ScaleStream-CГруппа компаний РСК представила на международной конференции «Суперкомпьютерные дни в России», прошедшей в МГУ имени Ломоносова, внешний массив PCIe-коммутации RSC ScaleStream-C (JBOG). Это решение предназначено для установки ускорителей GPU/TPU с целью повышения производительности серверов при работе с различными ресурсоёмкими приложениями, включая задачи ИИ и НРС. Решение RSC ScaleStream-C выполнено в форм-факторе 3U. Допускается установка до десяти карт с интерфейсом PCIe x16 (до 600 Вт), связанных интерконнектом NVLink. При использовании ускорителей на базе GPU применяется гибридное охлаждение, при работе с TPU — воздушное. Питание обеспечивают четыре блока мощностью 2200 Вт каждый. Массив может монтироваться в стандартную 19″ серверную стойку. Задействованы средства управления и мониторинга на базе Redfish, RESTful API, GUI разработки РСК. К системе RSC ScaleStream-C могут быть подсоединены до четырёх серверов посредством внешних кабелей на базе стандарта PCIe 4.0 x16. Ресурсы GPU/TPU могут динамически перераспределяться между подключенными серверами, что, как утверждается, обеспечивает уникальные возможности по созданию оптимальных конфигураций под конкретную нагрузку. Благодаря этому достигается наиболее эффективное использование вычислительных мощностей ИИ-ускорителей, используемых в составе массива. РСК заявляет, что утилизация GPU в некоторых случаях повышается на десятки процентов по сравнению с применением ускорителей в составе традиционных серверных платформах. В целом, RSC ScaleStream-C обеспечивает производительность до 300 ТФлопс (FP64) на массив в случае применения десяти ускорителей NVIDIA H200. При установке карт LinQ HPQ, разработанных российской компании «ХайТэк», быстродействие достигает 960 TOPS на операциях INT8. Среди ключевых сфер применения новинки названы: машинное обучение и ИИ (инференс и работа с большими языковыми моделями), НРС-нагрузки (научные исследования и моделирование), анализ больших данных, виртуализация, криптография и блокчейн (майнинг криптовалют и задачи распределенных реестров). |

|