Материалы по тегу: ии

|

01.10.2025 [16:14], Руслан Авдеев

Oracle может потребоваться $100 млрд заёмных средств для поддержки проектов OpenAIПо прогнозам аналитиков KeyBanc Capital Markets, в следующие четыре года Oracle может потребоваться $100 млрд заёмного капитала для финансирования соглашения с OpenAI. На создание облачной вычислительной инфраструктуры уйдёт порядка $25 млрд ежегодно, передаёт Datacenter Dynamics. По данным The Wall Street Journal, речь идёт о контракте на $300 млрд, который был подписан в начале сентября и рассчитан на пять лет. Он должен вступить в силу в 2027 году. Сделка станет одним из крупнейших контрактов в сфере облачных вычислений в истории. В июле сообщалось, что OpenAI арендует у Oracle 4,5 ГВт мощностей ЦОД на $30 млрд в год, начиная с 2028 года. Судя по данным о новом контракте, ежегодная стоимость выросла до $60 млрд. Пока нет данных, почему потребовалось удвоить сумму. Впрочем, не так давно глава OpenAI Сэм Альтман (Sam Altman) заявлял, что его компания намерена потратить «триллионы» на ИИ-инфраструктуру. В мечтах OpenAI — 10 млрд ускорителей, по одному на каждого жителя Земли. О новой сделке стало известно после того, как Oracle отчиталась о результатах I квартала 2026 финансового года. В ходе отчёта компания объявила, что заключила значимые облачные контракты с ведущими бизнесами в сфере ИИ, включая три «многомиллиардных» контракта, полученных в начале 2025 года. Также объявлено, что теперь компания имеет $455 млрд подлежащих исполнению обязательств. В KeyBanc предположили, что сейчас у Oracle нет достаточно средств для создания необходимой по контракту с OpenAI инфраструктуры. На конец августа долгосрочные долговые обязательства Oracle составляли $82,2 млрд, а в начале сентября компания выпустила серию облигаций для привлечения $18 млрд. В последнем финансовом отчёте компания отметила, что располагает $10 млрд в денежных средствах и их эквивалентах; также имелось $9 млрд задолженностей, подлежащих погашению в следующие 12 месяцев.

Источник изображения: Jakub Żerdzicki/unsplash.com Примечательно, что компания уже значительно нарастила инвестиции в развитие инфраструктуры. Только в прошлом квартале капитальные затраты составили $8,5 млрд, на $2,3 млрд больше год к году. Ожидается, что контракт на $300 млрд лишь увеличит соответствующие расходы. Капитальные затраты на 2026 финансовый год составят около $35 млрд, хотя они могут оказаться и несколько выше — новость считается хорошей, поскольку говорит о наращивании мощностей. Помимо средств на расширение бизнеса Oracle, сама OpenAI будет зависеть от возможностей привлечения капитала для финансирования сделки. Компании всё ещё не хватает средств для оплаты контракта на $300 млрд. Выручка стартап в I половине текущего финансового года составила $4,3 млрд, на 16 % больше год к году, но этого всё равно слишком мало для финансирования крупных проектов. Кроме того, OpenAI финансирует проекты, не связанные с Oracle. Не так давно компания расширила соглашение с CoreWeave на $6,5 млрд, доведя общую сумму контракта с неооблачным провайдером до $22,4 млрд. Также у компании имеются долгосрочные контракты с Microsoft, дополнительно она начала использовать Google Cloud. Ранее компания объявила, что только на аренду резервных серверов у облачных провайдеров на периоды пиковых нагрузок в следующие пять лет она потратит $100 млрд. Также подписано письмо о намерениях с NVIDIA о стремлении развернуть в её ЦОД системы компании мощностью не менее 10 ГВт. В обмен на это NVIDIA готовится инвестировать до $100 млрд в OpenAI по мере развёртывания новых ИИ-систем. При этом пока OpenAI не приносит прибыли и перспективы её выхода на самоокупаемость не вполне определённые.

01.10.2025 [14:01], Руслан Авдеев

Meta✴ подписала контракт на $14,2 млрд с ИИ-облаком CoreWeaveIT-гигант Meta✴ намерен потратить $14,2 млрд на облачные ИИ-сервисы CoreWeave до 14 декабря 2031 года. Компания станет очередным крупным клиентом «неооблачных» провайдеров, услугами которых уже пользуются Microsoft, NVIDIA и OpenAI, сообщает Datacenter Dynamics. Как заявляют в CoreWeave, соглашение подчёркивает, что за каждым технологическим прорывом в области ИИ стоят бизнес-партнёрства, которые делают его возможным. Ранее на прошой неделе CoreWeave расширила соглашение с OpenAI на $6,5 млрд, доведя общую сумму контрактов до $22,4 млрд. В августе NVIDIA объявила о намерении выкупить все нераспроданные вычислительные мощности CoreWeave до 2032 года на сумму $6,3 млрд. Microsoft же и так была якорным заказчиком компании, хотя и действовала в интересах OpenAI. CoreWeave намерена расширить клиентскую базу после того, как в ходе IPO весной её раскритиковали на концентрацию бизнеса на малом числе клиентов. Meta✴ стремится как увеличить собственные вычислительные мощности, так и облачную инфраструктуру. Компания давно создаёт собственную инфраструктуру дата-центров, и сейчас строит ЦОД мощностью более 1 ГВт. На очереди — гигантская площадка на 5 ГВт. В 2025 году прогнозируются капитальные затраты на уровне $66–$72 млрд, значительный рост затрат ожидается в 2026 году. В то же время Meta✴ остаётся крупным оптовым арендатором и клиентом облачных сервисов. В 2021 году Meta✴ объявила, что намерена расширить партнёрство с Amazon, чтобы использовать платформу для покупок компаний, уже пользующихся сервисами AWS, а также для исследований и разработок в сфере ИИ. В августе 2025 года она подписала контракт с Google Cloud на сумму $10 млрд сроком на шесть лет. Сейчас компания ведёт переговоры и с Oracle — об облачном соглашении на $20 млрд.

01.10.2025 [13:08], Руслан Авдеев

В США заработали первые ИИ ЦОД флагманского кампуса OpenAI StargateВ Техасе (США) заработал флагманский кампус ЦОД Stargate, построенный Crusoe Energy в интересах OpenAI, Oracle и их партнёров. Crusoe сообщает, что на площадке введены в эксплуатацию первые два объекта — они используются Oracle Cloud Infrastructure (OCI) для OpenAI. Площадь зданий превышает 90 тыс. м2, общая IT-мощность — более 200 МВт. По словам представителя Crusoe, одной из задач сейчас является формирование ИИ-инфраструктуры в масштабах, необходимых для обеспечения потребностей величайших инноваторов в мире. Для этого Crusoe создаёт ИИ-фабрики будущего — вертикально интегрированную инфраструктуру — со скоростью, необходимой для обеспечения победы США в гонке ИИ. Опыт кампуса в Абилине (Abilene) — живой пример новой концепции развития крупных дата-центров. Строительство площадки началось в июне 2024 года, первые стойки NVIDIA GB200 поставлены годом позже и уже работают над обучением и инференсом. По словам представителя OCI, ИИ уже стал двигателем новой эры инноваций, а Oracle создаёт инфраструктуру, благодаря которой новое будущее станет возможным. В компании отметили, что Crusoe доказала лидерство в разработке и строительстве ИИ ЦОД и стала надёжным партнёром Oracle, способным к быстрой и масштабной работе. В марте Crusoe начала работы над второй фазой проекта на территории Lancium Clean Campus в том же городе. В рамках масштабирования планируется добавить шесть зданий, это увеличит общую площадь проекта до более 370 тыс. м2, общая мощность составит до 1,2 ГВт. Ожидается, что работы завершатся к середине 2026 года. Crusoe, Oracle и OpenAI пока не подтвердили, что весь кампус поступит в распоряжение Stargate. Ожидается, что на компанию придётся большинство новых мощностей, если не все. На прошлой неделе OpenAI уже объявила, что создаст ещё пять дата-центров Stargate в США, в том числе в Техасе, Нью-Мексико и где-то на Среднем Западе.

01.10.2025 [11:51], Сергей Карасёв

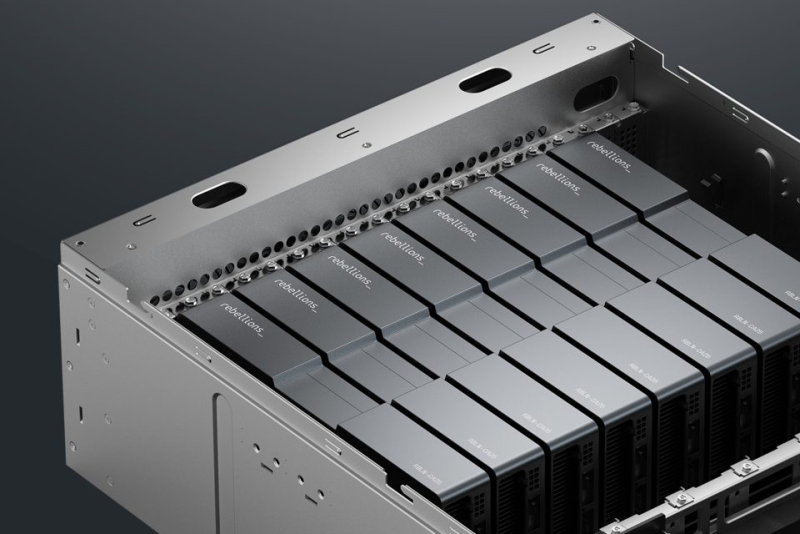

ИИ-стартап Rebellions привлёк финансирование от Arm и Samsung, получив оценку в $1,4 млрдЮжнокорейский разработчик ИИ-чипов Rebellions, по сообщению Datacenter Dynamics, провёл раунд финансирования Series C, в ходе которого на развитие привлечено $250 млн. В число инвесторов вошли Arm и Samsung Ventures. В результате стартап получил оценку на уровне $1,4 млрд. Фирма Rebellions, основанная в 2020 году, создаёт ускорители для ИИ-инференса, которые обеспечивают энергоэффективность и высокую производительность при небольших задержках. В 2023 году Rebellions начала массовое производство серверных ускорителей Atom и Atom Max для запуска больших языковых моделей (LLM) в дата-центрах. А в мае нынешнего года стартап представил ускоритель Rebel-Quad, оснащённый 144 Гбайт памяти HBM3e с пропускной способностью до 4,8 Тбайт/с. Это изделие, как утверждается, обеспечивает ИИ-производительность до 1 Пфлопс в режиме FP16 и до 2 Пфлопс на операциях FP8. Устройство выполнено в виде карты расширения с интерфейсом PCIe 5.0 x16. Заявленное энергопотребление — до 600 Вт. Rebellions отмечает, что по эффективности (количеству транзакций на 1 Вт затрачиваемой энергии) ускоритель Rebel-Quad приблизительно в 3,2 раза превосходит изделие NVIDIA H200. В инвестиционном раунде Series C, помимо Arm и Samsung Ventures, приняли участие Korea Development Bank и Korelya Capital. Полученные средства будут направлены в том числе на организацию массового производства Rebel-Quad, а также на укрепление позиций на рынках США, Европы и Азиатско-Тихоокеанского региона. По заявлениям Rebellions, её решения уже применяются клиентами в Японии, Саудовской Аравии и США. Нужно отметить, что в январе 2024 года Rebellions осуществила раунд финансирования Series B, в ходе которого было получено $124 млн. Позднее компания привлекла $15 млн от Wa’ed Ventures, венчурного подразделения саудовского нефтегазового и химического гиганта Aramco. А в июне 2024-го стартап объявил о слиянии с разработчиком ИИ-чипов Sapeon Korea, который был выделен из SK Telecom в 2016 году.

01.10.2025 [11:01], Сергей Карасёв

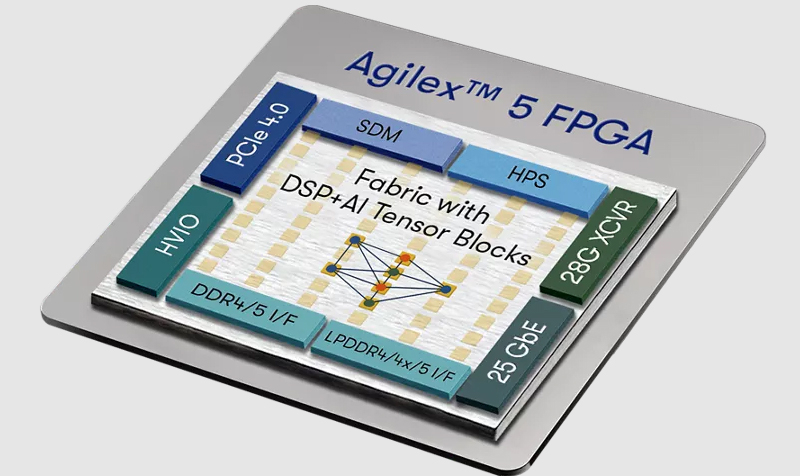

Altera улучшила характеристики FPGA семейства Agilex 5 и приступила к их массовому производствуКомпания Altera, контролирующая доля в которой недавно перешла частной инвестиционной компании Silver Lake, объявила о начале массового производства FPGA Agilex всех ключевых семейств, включая Agilex 5 и Agilex 3. При этом характеристики некоторых изделий были улучшены. Напомним, решения Agilex 3, дебютировавшие в марте нынешнего года, объединяют ПЛИС с возможностями ИИ и два ядра Arm Cortex-A55 с тактовой частотой 800 МГц. Поддерживается работа с памятью LPDDR4-2133. В свою очередь, решения Agilex 5 содержат ПЛИС с ИИ-архитектурой, а также по два ядра Arm Cortex-A76 и Cortex-A55 с частотой до 1,8 и 1,5 ГГц соответственно. Допускается использование памяти DDR4/5 и LPDDR4/5.

Источник изображения: Altera Altera сообщила об апгрейде изделий Agilex 5 D-Series среднего уровня. В частности, плотность логики в таких устройствах повышена в 2,5 раза — до 1,6 млн элементов. Благодаря этому достигается более высокая производительность при решении ИИ-задач на периферии, обработке видео в форматах 4K/8K, при построении сетей связи 5G/6G и др. Кроме того, внесены изменения в спецификацию памяти Agilex 5 D-Series: если раньше была реализована поддержка DDR5-4000 и LPDDR5-4267, то теперь заявлена совместимость с DDR5-5600 и LPDDR5-5500. Таким образом, прирост быстродействия памяти превышает 25 % по сравнению с оригинальными версиями. Помимо этого, Altera анонсировала выход программного обеспечения для разработчиков Quartus Prime версии 25.3, которое предоставляет доступ к новым инструментам проектирования, ускоряющим создание ПЛИС и вывод продукции на рынок. Новая редакция Quartus Prime в числе прочего позволяет использовать интеграционный инструментарий Visual Designer Studio на основе удобного интерфейса с функцией перетаскивания блоков.

01.10.2025 [10:46], Сергей Карасёв

Компактный ИИ-компьютер Orange Pi AI Studio оснащён ускорителем Huawei Ascend 310Команда Orange Pi анонсировала компьютер небольшого форм-фактора AI Studio, разработанный для ИИ-приложений. Устройство несёт на борту ускоритель Huawei Ascend 310, а заявленная ИИ-производительность достигает 176 TOPS (по всей видимости, на операциях INT8). Новинка заключена в корпус с габаритами 132,6 × 110,9 × 39 мм. Объём оперативной памяти LPDDR4X-4266 может составлять 48 или 96 Гбайт. Кроме того, предусмотрено 32 Мбайт памяти SPI Flash. Питание подаётся через DC-гнездо (5,5/2,5 мм) от адаптера мощностью 120 Вт. Кроме того, дебютировала модификация компьютера под названием Orange Pi AI Studio Pro. Она фактически представляет собой связку из двух базовых версий устройства. Таким образом, задействованы два ускорителя Huawei Ascend 310, благодаря чему обеспечивается ИИ-быстродействие до 352 TOPS. Объём памяти LPDDR4X-4266 — 96 или 192 Гбайт. Присутствуют два модуля SPI Flash на 32 Мбайт каждый. Мощность блока питания увеличена до 240 Вт. Размеры этого компьютера составляют 207,7 × 132,6 × 40 мм. Набор разъёмов у обоих устройств сведён к минимуму: доступен лишь единственный порт USB 4.0 Type-C. Говорится о совместимости с Ubuntu 22.04.5 и Linux 5.15.0.126, а в перспективе планируется добавить поддержку Windows и OpenEuler. Модель Orange Pi AI Studio предлагается по цене $955 и $1100 за варианты с 48 и 96 Гбайт памяти соответственно. Версия Orange Pi AI Studio Pro обойдётся в $1909 в комплектации с 96 Гбайт ОЗУ и в $2200 в исполнении со 192 Гбайт памяти.

30.09.2025 [13:53], Руслан Авдеев

Blue Owl заключила соглашение о строительстве ЦОД с Инвестиционным управлением Катара (QIA)Управляющая альтернативными инвестициями Blue Owl заключила стратегическое соглашение с суверенным фондом — Инвестиционным управлением Катара (QIA). В рамках партнёрства Blue Owl намерена заняться строительством новых ЦОД, сообщает Datacenter Dynamics. QIA и Blue Owl Capital анонсировали соглашение о создании «цифровой инфраструктурной платформы». Пока она не получила названия, но должна обеспечить быстрое расширение мощностей дата-центров гиперскейлеров для удовлетворения стремительно растущего спроса со стороны облачных провайдеров и ИИ-компаний. Деталей о том, что за ЦОД будут строиться, пока нет. QIA объявило, что его вклад в партнёрство должен помочь запустить платформу с более $3 млрд первоначальных активов, со временем их портфель должен вырасти. В управлении заявили, что партнёрство соответствует стратегии QIA, предусматривающей взаимодействие с ведущими мировыми компаниями, стремящимися удовлетворить растущий спрос в дата-центрах. QIA и Blue Owl намерены масштабировать цифровую инфраструктуру, которая позволит ответить на растущий спрос на хранение данных и вычислительные мощности по всему миру, с особенным фокусом на расширение возможностей по передаче данных.

Источник изображения: Samuel Regan-Asante/unsplash.com Основанное в 2005 году Инвестиционное управление Катара ранее объявляло, что намерено расширить сферу инвестиций за пределы рынка традиционной недвижимости, организовав вложение средств в дата-центры и складские помещения. Госкомпания является частью консорциума, желающего провести делистинг с биржи публичной компании ESR — крупного игрока на рынке недвижимости с Азиатско-Тихоокеанском регионе, переведя её в частную собственность. Blue Owl имеет в управлении активы приблизительно на $192 млрд. Исторически сложилось так, что она не является крупным игроком на рынке ЦОД, но недавно Blue Owl приобрела компанию IPI (Infrastructure Partners Inc.), которой принадлежит крупная ЦОД-платформа Stack. Кроме того, компания делает и другие инвестиции в сектор ЦОД. В августе 2024 года компания анонсировала создание совместного предприятия с Chirisa и PowerHouse стоимостью в $5 млрд для строительства «под ключ» ИИ/HPC ЦОД для CoreWeave и других клиентов. Также у инвестиционной компании имеется бизнес Beale Infrastructure, занимающийся реализацией проектов ЦОД в Аризоне и Канзасе. Недавно компания инвестировала в британский ЦОД-стартап Nscale и, по некоторым данным, приняла участие в финансировании мегапроектов ИИ ЦОД для Meta✴.

29.09.2025 [17:53], Владимир Мироненко

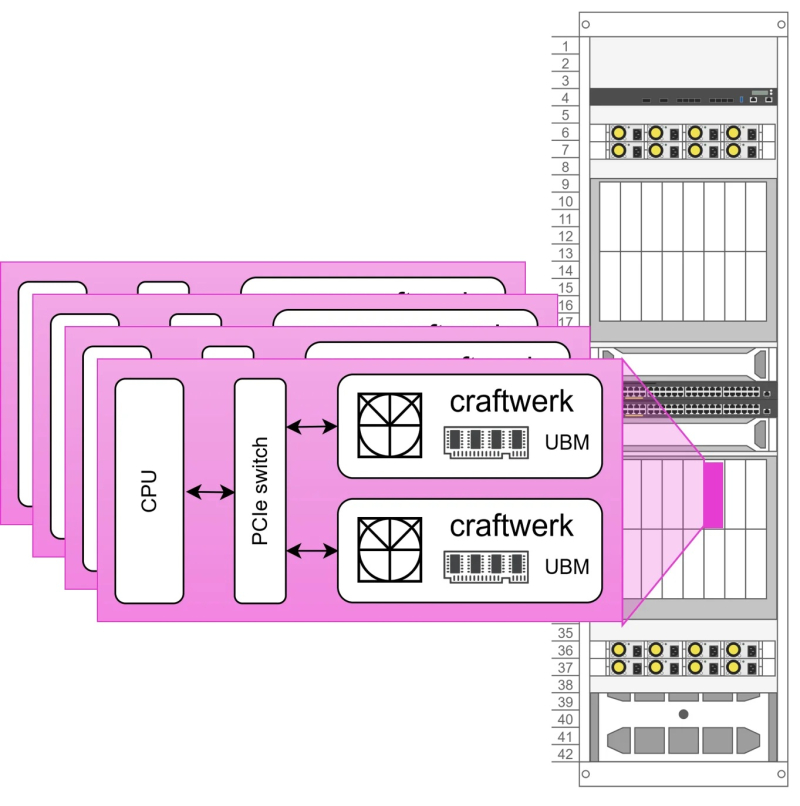

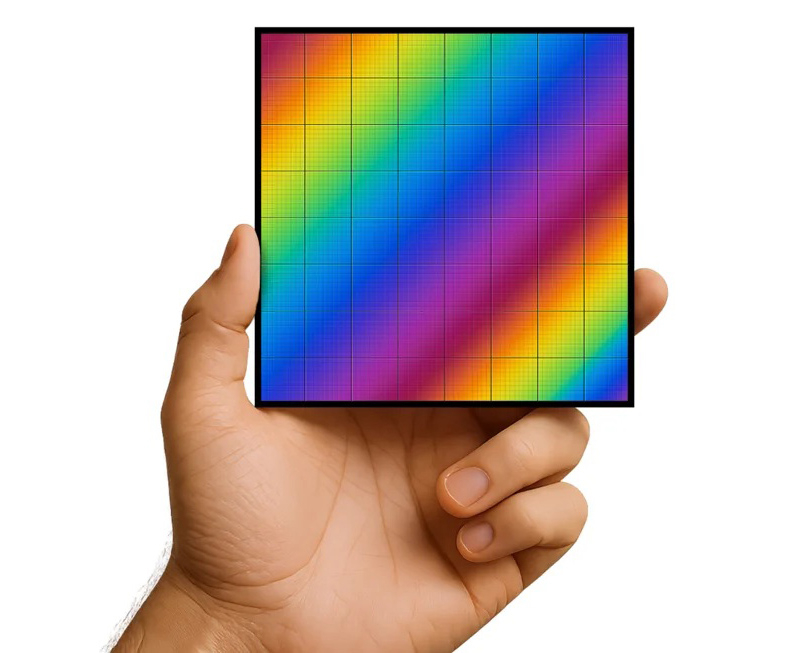

Euclyd разрабатывает ИИ-ускоритель Craftwerk с фирменной памятью UBM: 1 Тбайт и 8 Пбайт/сСтартап Euclyd, вышедший из скрытого режима (stealth mode), рассказал на саммите AI Infra Summit некоторые подробности о разрабатываемом чипе, который обеспечит более низкое энергопотребление и более низкую стоимость в расчёте на токен по сравнению с существующими решениями, пишет ресурс EE Times. Сама компания называет его первым в мире «кремнием» для агентного ИИ. Ингольф Хелд (Ingolf Held), соучредитель и вице-президент по продуктам Euclyd, сообщил ресурсу EE Times, что чип представляет собой огромную конструкцию из множества чиплетов, объединённых в модуль SiP (System-in-Package) под названием Craftwerk. Он будет включать 16 384 SIMD-блоков и обеспечивать производительность до 8 Пфлопс (FP16) или 32 Пфлопс (FP4). Эти вычислительные элементы разработаны Euclyd с нуля. В устройстве будет использоваться кремниевый интерпозер с максимально крупными размерами (примерно 100 × 100 мм) с 2,5D- и 3D-компонентами.

Источник изображений: Euclyd «Мы разработаем его сами — мы не будем наследовать ничего от Arm или RISC-V, и он будет полностью программируемым с помощью наших собственных инструментов», — сказал он. По словам Хелда, дизайн будет поддерживать программируемость, чтобы гарантировать возможность ускорения будущих нагрузок, будь то мультимодальный инференс, логические рассуждения, рекуррентные модели, модели пространства состояний или диффузионные модели. Euclyd объединит вычислительные чиплеты с кастомной памятью Ultra Bandwidth Memory (UBM) — 1 Тбайт DRAM с пропускной способностью 8000 Тбайт/с в той же упаковке Craftwerk. По словам Хелда, ИИ-ускорители со SRAM работают быстро, но при их использовании приходится разделять обработку ИИ-нагрузки между множеством чипов из-за малого объёма такой памяти. HBM имеет достаточную ёмкость, но её пропускная способность мала для решения задач, поставленных Euclyd. И хотя UBM от Euclyd отличается кастомным дизайном, для её изготовления не потребуется какой-то экзотический технологический процесс. Craftwerk позволит реализовать многоагентные рабочие процессы на одном кристалле кремния с TDP в пределах 3 кВт, отметил Хелд. По словам компании, NVIDIA DGX-B200 может обрабатывать 1038 токенов/с для одного пользователя Llama4-Maverick (400B), Cerebras предлагает 2554 токена/с для одного пользователя, а один SiP Craftwerk будет обрабатывать 20 тыс. токенов/с для одного пользователя. Стойка Euclyd будет включать 16 хост-процессоров и 32 модуля Craftwerk в шасси с жидкостным охлаждением с общим TDP 125 кВт. По оценкам Euclyd, в типичном многопользовательском сценарии эта система будет предлагать 7,68 млн токенов/с для Llama4-Maverick. На данный момент у Euclyd три частных инвестора: Питер Веннинк (Peter Wennink, бывший генеральный директор ASML), Федерико Фаггин (Federico Faggin, один из изобретателей микропроцессора и основатель Zilog и Synaptics) и Стивен Шурман (Steven Schuurman, основатель Elastic). В ближайшее время компания планирует привлечь венчурный капитал для запуска производства и масштабирования, но, по словам Хелда, посевного финансирования должно быть достаточно для демонстрации работоспособности кремниевых чипов. Сооснователь и консультант Euclyd Атул Синха (Atul Sinha) заявил EE Times, что Европа лучшее место для талантливых дизайнеров, чем Кремниевая долина. Он подтвердил, что Euclyd планирует оставаться в юрисдикции Нидерландов со штаб-квартирой ИТ-кампусе Эйндховена, где также находится штаб-квартира NXP. «Чего люди не понимают, так это то, что в Европе есть места, где действительно есть значительный набор технологий и кадровая база, — сказал Синха. — Для полупроводников Эйндховен, безусловно, на первом месте. Я бы сказал, что лучше места нет».

29.09.2025 [14:59], Владимир Мироненко

Закрытие угольных электростанций в США забуксовало из-за спроса на энергию для ИИ ЦОДГлава министерства энергетики США (DoE) Крис Райт (Chris Wright) сообщил агентству Reuters, что правительство планирует отложить вывод из эксплуатации большинства электростанций страны, работающих на угольном топливе, чтобы удовлетворить спрос на электроэнергию для ИИ ЦОД. Администрация Белого дома также готова использовать чрезвычайные полномочия для продления срока службы угольных электростанций, сказал он. «Энергетическая трезвость вернулась в Вашингтон. Мы сосредоточены на американцах, ценах на коммунальные услуги и предотвращении отключений электроэнергии, — заявил Райт. — Мы должны предотвратить вывод из эксплуатации существующих гарантированных мощностей». В настоящее время в США общая мощность угольных электростанций составляет порядка 190 ГВт, часть которых предполагалось вывести из эксплуатации в течение следующих нескольких лет. Райт продлил действие чрезвычайного указа, чтобы продолжить эксплуатацию электростанции J.H. Campbell на угле в Мичигане, несмотря на то что компания-оператор планировала её закрыть по экономическим причинам. Министерство энергетики США также распорядилось о продолжении работы электростанции в Пенсильвании, работающей на газе и мазуте, которую тоже планировали закрыть. Райт заявил, что по другим угольным электростанциям страны тоже могут выйти аналогичные распоряжения с соответствии с положениями об обеспечении стабильности энергосистемы Федерального закона об электроэнергетике США. Несколько предприятий уже продлили срок службы угольных электростанций в этом году в связи со спросом на электроэнергию со стороны провайдеров ЦОД. Например, компания Southern Company в феврале объявила о решении продлить срок эксплуатации трёх электростанций общей мощностью 8,2 ГВт с 2028 до 2035 года. Райт заявил, что США также будут стремиться к более эффективному использованию существующей энергосистемы, постоянно используя резервные электростанции и генераторы, а не только при резком росте спроса на электроэнергию. Как отметил ресурс Data Center Dynamics, поддержка администрацией Дональда Трампа (Donald Trump) энергетики с использованием угольного топлива резко контрастирует с устойчивым снижением спроса на этот вид топлива за последнюю четверть века. Доля угля в энергобалансе США упала примерно до 15 % по сравнению с уровнем 2001 года, когда на него приходилось 51 % всей энергии в США. Большое внимание уделяется и развитию атомной энергетики, хотя развивать АЭС сложнее, чем ТЭС. Согласно недавнему отчету аналитического центра Ember, в США теперь вырабатывается больше электроэнергии с помощью ветра и солнца, чем с использованием угля. Производство солнечной энергии в США увеличилось на 64 ТВт·ч, с использованием энергии ветра — на 32 ТВт·ч, с использованием угля — на 22 ТВт·ч. Кроме того, согласно исследованию Energy Innovation, проведённому в 2023 году, 99 % существующих угольных электростанций в США обходятся дороже в эксплуатации, чем новые солнечные или ветровые электростанции. Несмотря на это, администрация Трампа сворачивает стимулирование развития возобновляемой энергетики. Помимо законопроекта «One Big Beautiful Bill», сокращающего налоговые льготы для новых проектов в области возобновляемой энергетики, по словам Райта, Министерство энергетики США должно «вернуть более $13 млрд свободных средств», выделенных Конгрессом на финансирование проектов в области чистой энергетики. Это может ударить по провайдерам ЦОД, поскольку многие из них связаны долгосрочными соглашениями о поставках возобновляемой энергии для обеспечения своей деятельности. DoE не уточнило, финансирование каких проектов будет прекращено.

29.09.2025 [14:00], Руслан Авдеев

315 млн ИИ-ядер и 1,4 квадрлн транзисторов: Cerebras открыла в США 10-МВт ЦОД на царь-чипах WSE-3Разработчик ИИ-ускорителей Cerebras Systems развернул новый дата-центр в Оклахома-Сити — столице штата Оклахома (США). Объект мощностью 10 МВт создан совместно со Scale Datacenters, сообщает Datacenter Dynamics. На объекте применяются замкнутые системы прямого жидкостного охлаждения. По данным компании, каждый потреблённый киловатт-час компенсируется покупкой энергии из возобновляемых источников. По словам представителя Cerebras, в 2023 году компания построила свой первый ИИ-суперкомпьютер Andromeda с 13,5 млн ИИ-ядер, на тот момент — крупнейший в своём роде. Новый кластер в Оклахома-Сити на базе систем CS-3 с царь-чипами WSE-3 обеспечивает ИИ-производительность 44 Эфлопс (точность вычислений не указана) и поддерживает крупнейшие из когда-либо созданных ИИ-моделей. Кластер включает 315 млн ИИ-ядер и 1,4 квадрлн транзисторов. Scale Datacenter подготовила для Cerebras саму площадку и сопутствующую инфраструктуру. В Scale подчеркнули, что рады сотрудничеству с Cerebras, оно позволит создать в Оклахома-Сити ИИ-инфраструктуру мирового класса. В мае 2025 года появилась информация о покупке Scale Datacenter ЦОД площадью 7,6 тыс. м2 в Оклахома-Сити у компании Expand Energy. Ранее Cerebras объявила о намерении запустить шесть новых ИИ ЦОД в Северной Америке и Европе, в том числе с использованием более 300 систем CS-3 на объекте в Оклахома-Сити. У Cerebras есть кластеры для инференса в Санта-Кларе (Santa Clara) и Стоктоне (Stockton) в Калифорнии, последний расположен на барже-ЦОД Nautilus. Также имеется объект в Далласе (Dallas, Техас). Компания занимается созданием собственных кластеров в Миннеаполисе (Minneapolis, Миннесота), Монреале (Montreal, Канада — на объекте Bit Digital), а также в некоторых локациях на Среднем Западе США и в Европе. Cerebras уже разместила оборудование в Эдинбургском университете, Сандийских национальных лабораториях (США), лабораториях Лос-Аламоса, мощностях G42/Core42, и др. |

|