Материалы по тегу: maia

|

02.10.2025 [21:02], Владимир Мироненко

Microsoft потратит $33 млрд на доступ к 100+ тыс. NVIDIA GB300 в неооблаках, но со временем хочет перейти на свои ИИ-ускорителиВ Сети появились новые подробности о сделке стоимостью до $19,4 млрд, заключённой Microsoft с Nebius Group NV в начале сентября. Как сообщает Bloomberg со ссылкой на информированные источники, Microsoft получит пятилетний доступ к выделенной инфраструктуре на базе более чем 100 тыс. суперускорителей NVIDIA GB300. Ранее сообщалось, что речь идёт о мощностях нового ЦОД Nebius в Вайнленде (Нью-Джерси, США). Как пишет Forbes, Nebius отличается от многих облачных провайдеров тем, что фокусируется только на рабочих нагрузках ИИ и МО, что позволяет лучше оптимизировать архитектуру ЦОД в отличие от гиперскейлеров, которые занимаются решением множества задач. Кроме того, Nebius отличается от других неооблаков, таких как CoreWeave, тем, что предоставляет инструменты и сервисы для разработчиков, которые позволяют совершенствовать ИИ-модели, выполнять инференс и разрабатывать кастомные решения, а не просто фокусируется на «чистой» вычислительной мощности. При этом Nebius начала наращивать вычислительные мощности ещё до того, как возник спрос на эти ресурсы, отметил Forbes. Подобные контракты Microsoft заключила с ещё несколькими неооблаками (neocloud), включая CoreWeave, Nscale и Lambda, на общую сумму в $33 млрд, и они обеспечивают её большую выгоду. Вместо того, чтобы тратить огромные ресурсы на строительство собственных ЦОД, Microsoft обращается к проверенному поставщику ИИ-инфраструктуры, благодаря чему может быстрее совершенствовать свою ИИ-инфраструктуру с меньшими первоначальными затратами, используя высвободившиеся мощности для предоставления клиентам прибыльных услуг на базе ИИ. Вдобавок такой подход позволяет Microsoft быстрее менять стратегию, чем при использовании собственных дата-центров. В начале бума ИИ Microsoft арендовала мощности даже у Oracle, своего прямого конкурента, для поддержки ИИ-функций в поиске Bing. Эти сделки также устраняют для Microsoft значительную часть финансовых рисков, связанных со строительством собственных ЦОД. Она не только сразу получает необходимые мощности для своих ИИ-сервисов, вместо того чтобы тратить годы на строительство ЦОД, но и перекладывает на других вопросы строительства, финансирования и управление этими ЦОД, что даёт компании большую финансовую гибкость. Так, Microsoft может отнести некоторые затраты к операционным, а не капитальным, что, по словам аналитика Bernstein Марка Мёрдлера (Mark Moerdler), даёт потенциальные преимущества для денежного потока, налогообложения и способа представления прибыли в финотчётах. Компания использует серверы неооблаков не только для обучения ИИ-моделей, но и для сложного инференса. Сделки с неооблаками становятся популярными и у конкурентов Microsoft, хотя им далеко до её масштабов. В мае 2025 года OpenAI расширила с конкурирующей с Nebius компанией CoreWeave контракт стоимостью $11,9 млрд на $4 млрд, после чего заключила ещё одно соглашение на $6,5 млрд, увеличив общую сумму соглашений до $22,4 млрд. Ещё один технологический гигант Meta✴ подписал сделку с CoreWeave на сумму в $14,2 млрд, обеспечив себе доступ к её облачным ИИ-сервисов на период до 2031 года. Вместе с тем в долгосрочной перспективе Microsoft намерена переключиться на ИИ-ускорители собственной разработки, которые обеспечивают лучший показатель TCO, передаёт CNBC. Два года назад компания представила первые ИИ-чипы Maia 100. Следующее поколение этих чипов, как ожидается, появится в 2026 году. При этом компания сосредоточится не на чипах в отдельности, а будет использовать более системный подход, учитывающий вопросы охлаждения, интерконнекта и т.д. Пока что, признаёт Microsoft, в течение многих лет решения NVIDIA обеспечивали лучшее соотношение цены к производительности.

16.11.2023 [02:43], Алексей Степин

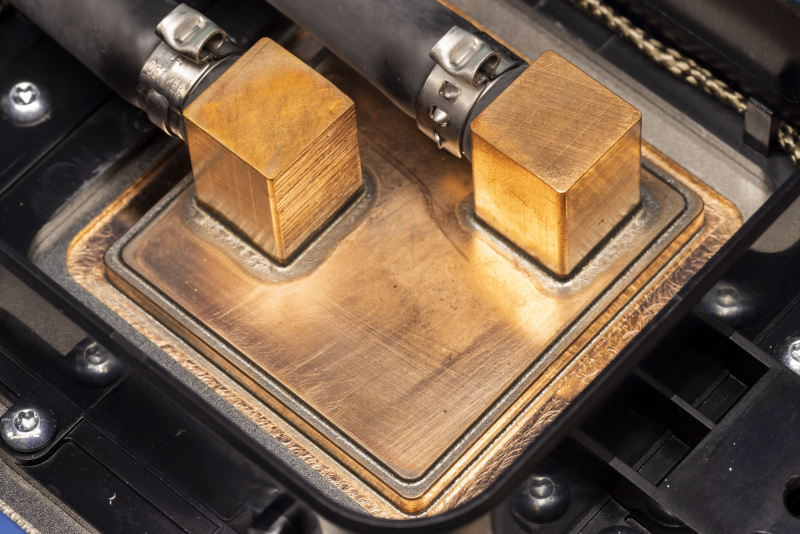

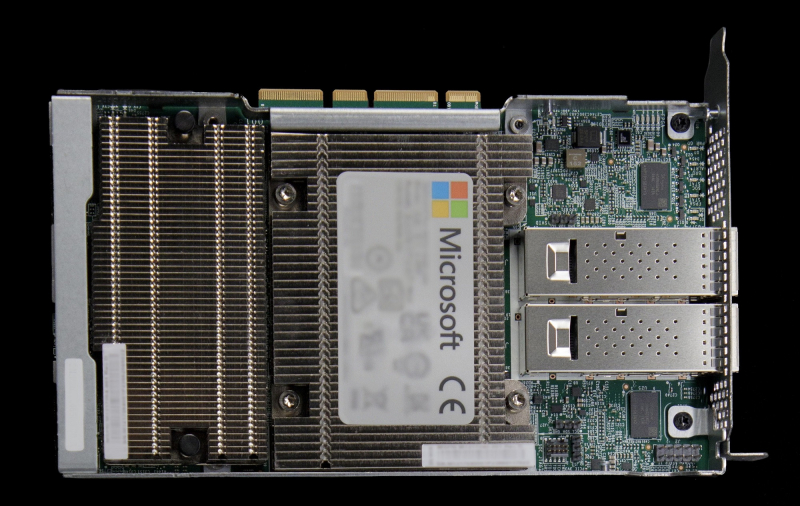

Microsoft представила 128-ядерый Arm-процессор Cobalt 100 и ИИ-ускоритель Maia 100 собственной разработкиГиперскейлеры ради снижения совокупной стоимости владения (TCO) и зависимости от сторонних вендоров готовы вкладываться в разработку уникальных чипов, изначально оптимизированных под их нужды и инфраструктуру. К небольшому кругу компаний, решившихся на такой шаг, присоединилась Microsoft, анонсировавшая Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100. Первопроходцем в этой области стала AWS, которая разве что память своими силами не разрабатывает. У AWS уже есть три с половиной поколения Arm-процессоров Graviton и сразу два вида ИИ-ускорителей: Trainium для обучения и Inferentia2 для инференса. Крупный китайский провайдер Alibaba Cloud также разработал и внедрил Arm-процессоры Yitian и ускорители Hanguang. Что интересно, в обоих случаях процессоры оказывались во многих аспектах наиболее передовыми. Наконец, у Google есть уже пятое поколение ИИ-ускорителей TPU. Microsoft заявила, что оба новых чипа уже производятся на мощностях TSMC с использованием «последнего техпроцесса» и займут свои места в ЦОД Microsoft в начале следующего года. Как минимум, в случае с Maia 100 речь идёт о 5-нм техпроцессе, вероятно, 4N. В настоящее время Microsoft Azure находится в начальной стадии развёртывания инфраструктуры на базе новых чипов, которая будет использоваться для Microsoft Copilot, Azure OpenAI и других сервисов. Например, Bing до сих пор во много полагается на FPGA, а вся ИИ-инфраструктура Microsoft крайне сложна. Microsoft приводит очень мало технических данных о своих новинках, но известно, что Azure Cobalt 100 имеет 128 ядер Armv9 Neoverse N2 (Perseus) и основан на платформе Arm Neoverse Compute Subsystem (CSS). По словам компании, процессоры Cobalt 100 до +40 % производительнее имеющихся в инфраструктуре Azure Arm-чипов, они используются для обеспечения работы служб Microsoft Teams и Azure SQL. Oracle, вложившаяся в своё время в Ampere Comptuing, уже перевела все свои облачные сервисы на Arm. Чип Maia 100 (Athena) изначально спроектирован под задачи облачного обучения ИИ и инференса в сценариях с использованием моделей OpenAI, Bing, GitHub Copilot и ChatGPT в инфраструктуре Azure. Чип содержит 105 млрд транзисторов, что больше, нежели у NVIDIA H100 (80 млрд) и ставит Maia 100 на один уровень с Ponte Vecchio (~100 млрд). Для Maia организован кастомный интерконнект на базе Ethernet — каждый ускоритель располагает 4,8-Тбит/с каналом для связи с другими ускорителями, что должно обеспечить максимально эффективное масштабирование. Сами Maia 100 используют СЖО с теплообменниками прямого контакта. Поскольку нынешние ЦОД Microsoft проектировались без учёта использования мощных СЖО, стойку пришлось сделать более широкой, дабы разместить рядом с сотней плат с чипами Maia 100 серверами и большой радиатор. Этот дизайн компания создавала вместе с Meta✴, которая испытывает аналогичные проблемы с текущими ЦОД. Такие стойки в настоящее время проходят термические испытания в лаборатории Microsoft в Редмонде, штат Вашингтон. В дополнение к Cobalt и Maia анонсирована широкая доступность услуги Azure Boost на базе DPU MANA, берущего на себя управление всеми функциями виртуализации на манер AWS Nitro, хотя и не целиком — часть ядер хоста всё равно используется для обслуживания гипервизора. DPU предлагает 200GbE-подключение и доступ к удалённому хранилищу на скорости до 12,5 Гбайт/с и до 650 тыс. IOPS. Microsoft не собирается останавливаться на достигнутом: вводя в строй инфраструктуру на базе новых чипов Cobalt и Maia первого поколения, компания уже ведёт активную разработку чипов второго поколения. Впрочем, совсем отказываться от партнёрства с другими вендорами Microsoft не намерена. Компания анонсировала первые инстансы с ускорителями AMD Instinct MI300X, а в следующем году появятся инстансы с NVIDIA H200. |

|