Материалы по тегу: ии

|

08.10.2025 [11:21], Сергей Карасёв

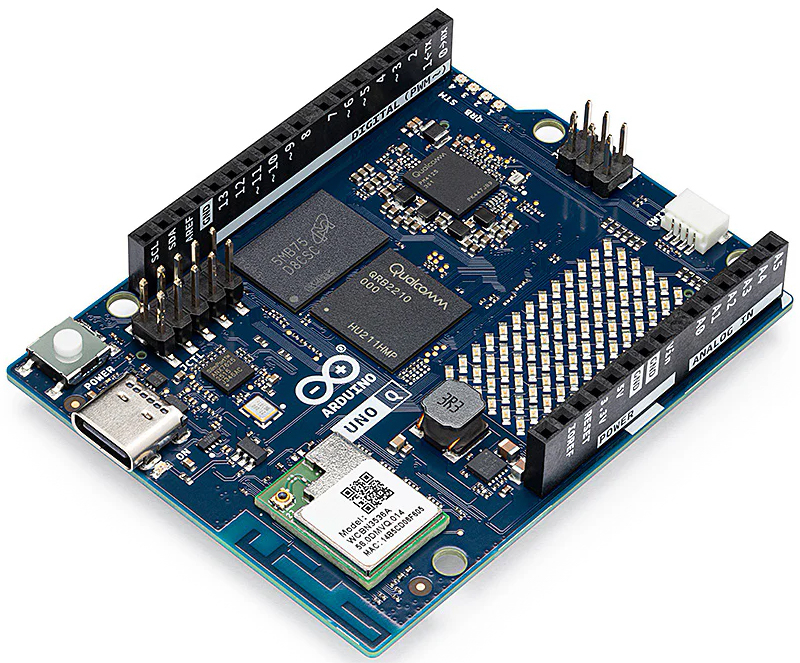

Вышел одноплатный компьютер Arduino UNO Q на платформе Qualcomm для роботов и IoT-устройствКомпания Qualcomm, объявившая накануне о приобретении Arduino, анонсировала одноплатный компьютер Arduino UNO Q, предназначенный для построения робототехнических устройств, оборудования интернета вещей (IoT) и других решений с ИИ-функциями. В основу новинки положен процессор Qualcomm Dragonwing QRB2210: он содержит четыре вычислительных ядра Arm Cortex-A53 с тактовой частотой 2 ГГц, графический ускоритель Adreno 702 с частотой 845 МГц, а также два процессора обработки изображений. Заявлена совместимость с Debian Linux. Кроме того, в состав одноплатного компьютера входит микроконтроллер реального времени STMicro STM32U585 на основе ядра Arm Cortex-M33 с частотой до 160 МГц, работающего в связке с 786 Кбайт памяти SRAM и 2 Мбайт флеш-памяти. Микроконтроллер STMicro STM32U585 подключён к разъёмам формата Arduino UNO на верхней стороне платы, в то время как чип Qualcomm Dragonwing QRB2210 управляет парой высокоплотных коннекторов на нижней стороне, которые, как сообщается, будут совместимы с рядом вспомогательных модулей расширения, в том числе с дисплеем.

Источник изображения: Arduino Новинка будет предлагаться в модификациях с 2 и 4 Гбайт LPDDR4, оснащённых накопителем eMMC вместимостью 16 и 32 Гбайт соответственно. Говорится о возможности обработки двух 13-мегапиксельных или одного 25-мегапиксельного видеопотока со скоростью 30 к/с. Предусмотрены четыре встроенных управляемых RGB-светодиода и массив синих светодиодов 8 × 13. Изделие Arduino UNO Q несёт на борту чип беспроводной связи WCBN3536A, обеспечивающий поддержку Bluetooth 5.1 (с интегрированной антенной) и Wi-Fi 5 в частотных диапазонах 2,4/5 ГГц. Упомянуты интерфейсы I2C, I3C, SPI, CAN, UART, PSSI и GPIO. Одноплатный компьютер имеет размеры 53,34 × 68,58 мм. Питание подаётся через разъём USB Type-C. Устройство доступно для заказа по ориентировочной цене от €48.

08.10.2025 [08:53], Владимир Мироненко

HPE отдала Nokia «ненужные» технологии Juniper Networks для мобильных сетей, часть сотрудников и одного вице-президентаNokia объявила о сделке с HPE, в рамках которой она лицензировала технологии для развития своих решений для мобильных сетей и сетевой автоматизации на базе ИИ. Nokia получит доступ к технологиям, касающимся интеллектуальных контроллеров (RIC) сетей радиодоступа (RAN) и платформы по управлению и оркестрации сервисов (SMO) компании Juniper Networks, приобретённой HPE за $14 млрд. 1 октября 2025 года большая часть соответствующей команды разработчиков перешла в Nokia Mobile Networks, а вместе с ней и Константин Полихронопулос (Constantine Polychronopoulos), вице-президент группы Juniper Networks, о чём пишет Data Center Dynamics. Лицензированные технологии будут интегрированы с решениями платформы Nokia MantaRay для управления сервисами и оркестрации (SMO) и автоматизации сетей. MantaRay SMO — комплексное решение Nokia для автоматизации на базе ИИ без участия оператора, способное достичь 4-го уровня автономных сетей TM Forum. Решение также полностью совместимо с Open RAN и поддерживает открытый интерфейс R1 для rApps. Как сообщает tele.net.in, за последние пять лет Juniper создала «лучшую в своем классе» платформу RIC, а также решение SMO, обеспечивающее сквозную динамическую «нарезку» сети (end-to-end dynamic network slicing) по требованию. По всей видимости, HPE решила, что бизнес SMO/RIC для неё не является целевым, подобно Broadcom, отказавшейся от разработки RIC в VMware, пишет ресурс The Mobile Network. RIC функционирует в процессе развёртывания Open RAN, выступая своего рода связующим звеном. Это позволяет операторам развёртывать xApps- и rApps-приложения для контроля и проектирования функций RAN, обеспечивая административный суверенитет RAN над функциями, которые обычно реализуются как проприетарные на базовых станциях. RIC также позволяет телекоммуникационным компаниям комбинировать сторонние сетевые приложения, такие как отключение базовых станций или перенаправление трафика из перегруженных сот, с радиоустройствами Ericsson или Nokia, предоставляя оператору больше контроля над своими средами Open RAN. Томми Уитто (Tommi Uitto), президент подразделения мобильных сетей Nokia, отметил, что сделка с HPE расширит возможности Nokia по предложению клиентам «автоматизации, оркестрации и открытых экосистем на базе ИИ, что позволит им эффективнее управлять сетями разных производителей и подготовиться к переходу с 5G на 6G».

07.10.2025 [23:17], Владимир Мироненко

Qualcomm купила Arduino: бренд и экосистему обещают сохранитьQualcomm объявила о приобретении Arduino, итальянской компании-разработчика, известной своей open source экосистемой решений на базе микроконтроллеров и ПО. Qualcomm отметила, что сделка позволит ускорить реализацию стратегии по расширению возможностей разработчиков за счёт упрощения доступа к её портфелю передовых технологий и продуктов, а также укрепить свои позиции в области периферийных и ИИ-вычислений. О сделке объявили через несколько дней после победы Qualcomm над Arm в суде. «Объединяя принципы open source с портфолио Qualcomm Technologies, мы помогаем миллионам разработчиков создавать интеллектуальные решения быстрее и эффективнее», — заявил Накул Дуггал (Nakul Duggal), генеральный менеджер подразделения автомобильных, промышленных и встраиваемых решений для Интернета вещей Qualcomm Technologies, передаёт TechRadar. Arduino с сообществом из более чем 33 млн активных пользователей сохранит свой бренд и продолжит поддерживать широкий спектр микроконтроллеров, а также разрабатывать решения для различных направлений: от любительских роботов и простых проектов домашней автоматизации до корпоративных платформ Интернета вещей. Финансовые подробности сделки не разглашаются. Её завершение зависит от получения одобрения регулирующих органов и других стандартных условий оформления сделки. В марте 2024 года Qualcomm приобрела компанию Foundries.io, занимающуюся периферийными вычислениями, а в марте 2025 года объявила о приобретении Edge Impulse, разработчика платформы для создания периферийных ИИ-решений. Как отметил ресурс CNBC, Qualcomm стремится диверсифицировать бизнес, поскольку рынок смартфонов стагнирует, а Apple начала переход на собственные модемы. В последнем квартале на долю бизнеса Qualcomm в сфере IoT, включающем в себя многие из её текущих чипов, которые могут использоваться в промышленных или робототехнических продуктах, и автомобильного бизнеса пришлось в общей сложности 30 % от общей выручки от продажи чипов. Несмотря на то, что Qualcomm неоднократно подчёркивала, что Arduino продолжит существовать как самостоятельная экосистема, всегда существует опасение, что крупная компания, покупая любой небольшой открытый проект, в конечном итоге начнёт ограничивать экосистему, пишет Ars Technica. Это может привести к сокращению или прекращению выпуска аппаратных и программных проектов для сообщества разработчиков или снижение поддержки чипов сторонних производителей. Также это может означать перенос фокуса на крупных корпоративных клиентов Qualcomm в ущерб преподавателям и разработчикам из сообщества Arduino. Впрочем, приверженность Arduino принципам open source может стать страховкой от таких попыток Qualcomm в будущем.

07.10.2025 [15:52], Сергей Карасёв

Китайские компании укрепляют позиции на местном рынке ИИ-ускорителей — часть основана выходцами из AMD и NVIDIAРазработчики из Китая, как сообщает TrendForce, добились существенных успехов в создании ускорителей. Речь идёт о решениях на основе ASIC и GPU, призванных составить конкуренцию картам NVIDIA, поставки которых в КНР ограничены в связи с американскими санкциями. Разработкой ИИ-ускорителей в КНР, помимо Huawei HiSilicon с её решениями Ascend, занимаются несколько других крупных игроков, быстро укрепляющих позиции. В их число входят Moore Threads, MetaX и Cambricon. Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) недавно отметил значительные достижения Китая в плане разработки и производства микросхем, заявив, что страна отстаёт от США на «наносекунды». По его словам, доля NVIDIA на китайском рынке ИИ-ускорителей за последние годы сократилась с 95 % до 50 %. Хуан отмечает, что более половины мировых ИИ-исследователей сосредоточены в Китае, что говорит о большом потенциале страны в соответствующей области. Moore Threads заявляет, что является единственной в Китае компанией, которая в настоящее время серийно производит полнофункциональные GPU. Эта фирма уже представила четыре продуктовых семейства, включая Sudi (2021 год), Chunxiao (2022), Quyuan (2023) и Pinghu (2024). Решения первых двух серий применяются в настольных системах и рабочих станциях, двух других — в составе ИИ-платформ. Отмечается, что основатель и генеральный директор Moore Threads Джеймс Чжан Цзяньчжун (James Zhang Jianzhong) в течение 14 лет работал в NVIDIA, в частности, занимал должность вице-президента и генерального менеджера этой компании по операциям в Китае. В MetaX трудятся выходцы из AMD. Так, основатель MetaX Чэнь Вэйлян (Chen Weiliang) с 2007 года работал в качестве старшего директора в шанхайском представительстве AMD, откуда ушел в 2020-м. Технические директора MetaX Пэн Ли (Peng Li) и Ян Цзянь (Yang Jian) также имеют опыт работы в AMD. Компания MetaX предлагает ускорители для обучения ИИ-моделей и инференса, а также GPU-серверы. В 2024 году на эти продукты пришлось соответственно 68,99 % и 28,29 % от общей выручки компании. Однако, ни MetaX, ни Moore Threads пока не вышли на уровень прибыльности. В свою очередь, фирма Cambricon, основанная в 2016 году братьями Чэнь Юньцзи (Chen Yunji) и Чэнь Тяньши (Chen Tianshi), в I половине 2025 года показала чистую прибыль в размере примерно ¥1 млрд ($140 млн) против ¥530 млн убытков годом ранее. В сентябре Cambricon получила одобрение со стороны регулирующих органов КНР на размещение акций на сумму ¥3,99 млрд (около $559,6 млн). Компания прогнозирует, что её выручка в текущем году увеличится на 317–483 % и составит от ¥5 до ¥7 млрд. Компания проектирует свой флагманский ИИ-ускоритель Siyuan 690, который, как ожидается, по производительности будет сопоставим с NVIDIA H100.

07.10.2025 [13:25], Руслан Авдеев

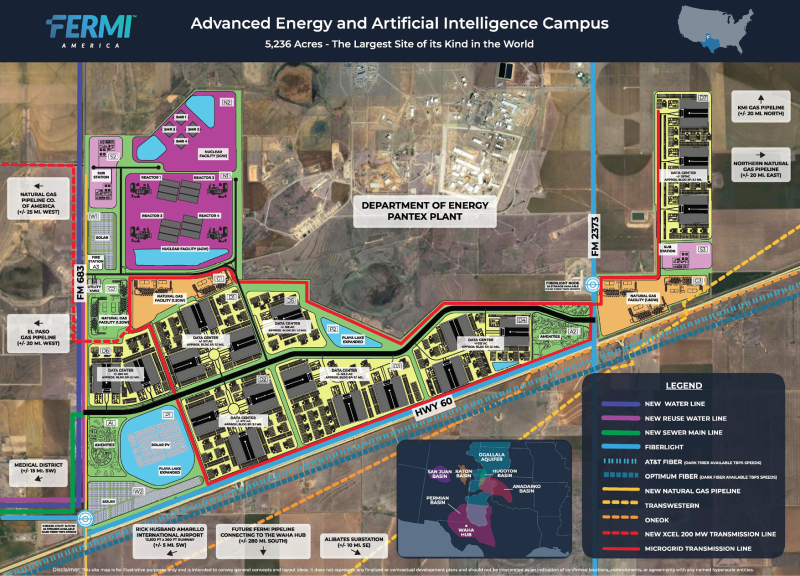

Парадокс Ферми: Fermi America бывшего министра энергетики США успешно дебютировала на бирже, хотя пока не построила ни одного ИИ ЦОДКомпания Fermi America, стоящая за проектом 11-ГВт кампуса HyperGrid (Project Matador) в техасском Амарилло (Amarillo), дебютировала на бирже Nasdaq. Теперь её стоимость оценивается почти в $15 млрд, сообщает Datacenter Dynamics, хотя ни одного обещанного ИИ ЦОД она пока не построила. Выход на биржу оказался намного успешнее прогнозов — акции Fermi на старте торгов оказались на 19 % дороже ожидаемого, в результате капитализация достигла $14,8 млрд. Сама компания рассчитывала добиться рыночной оценки в $13,6 млрд. Акции начали торговаться по $25, на $4 выше цены размещения $21, а в пике доходили до почти $37. Впрочем, сейчас диапазон составляет $28–$28. Всего в рамках IPO компания бывшего министра энергетики США Рика Перри (Rick Perry) привлекла $682,5 млн. Средства, полученные в результате IPO, Fermi намерена использовать совместно с уже имеющимися активами для роста бизнеса, в т.ч. расширения штата сотрудников и повышения финансовой гибкости в рамках запланированного проекта ЦОД. В сентябре она уже привлекла $100 млн в рамках раунда C, возглавленного Macquarie Group. Также Fermi получила от Macquarie кредитную линию на $250 млн, на момент закрытия сделки $100 млн из которых уже были освоены.

Источник изображения: U.S. Securities and Exchange Comission Сейчас компания занимается реализацией Project Matador совместно с Техасским технологическим университетом, на территории которого и намерены разместить гигантский кампус ЦОД. Площадь должна составить 16,7 га, кампус обеспечит мощность до 11 ГВт. Энергия будет поставляться из локальных источников (в т.ч. планируется использовать природный газ, солнечную, ветряную и ядерную энергию). Fermi уже подписаны несколько соглашений в области энергетики. Недавно компания подписала с Siemens соглашение о намерениях, предусматривающее поставку газовых турбин мощностью до 1,1 ГВт для обеспечения объекта электричеством. В июле 2025 года компания приобрела мощности по генерации электроэнергии на природном газе в рамках двух отдельных соглашений. В том числе речь шла о покупке девяти газовых турбин, которые могут дать 1 ГВт уже в 2026 году. Первые объекты суммарной мощностью 1 ГВт должны заработать к концу 2026 года. Хотя предполагается, что в краткосрочной перспективе главным источником энергии для Fermi станет газовая генерация, компания подписала соглашения и с несколькими поставщиками атомной энергии. Ранее в этом году Fermi объявляла о намерении установить четыре реактора Westinghouse AP1000 поколения III+ с выходной мощностью около 1,1 ГВт. Fermi подписала и два других соглашения, тоже связанных с «ядерными» амбициями. Речь идёт о меморандумах о взаимопонимании с южнокорейскими Hyundai и Doosan Enerbility, предполагающих размещение реакторов на территории кампуса.

07.10.2025 [13:07], Руслан Авдеев

Консалтинговый гигант Deloitte вернёт австралийским властям часть средств за аналитику с фейковыми ИИ-цитатамиКонсалтинговая компания Deloitte выразила готовность вернуть часть средств, полученных в результате контракта с австралийским правительством — компания признала факт использования генеративного ИИ для создания отчёта, полного поддельных цитат, недействительных ссылок и даже выдержки из постановления Австралийского федерального суда, оказавшейся полностью «выдуманной» ИИ, сообщает The Register. Deloitte подтвердила, что вернёт часть средств, полученных в рамках соглашения на сумму AU$440 тыс. ($291 245) с Министерством занятости и трудовых отношений Австралии (DEWR). Это произошло после того, как министерство на прошлой неделе опубликовало исправленную версию отчёта. Из новой версии удалили более десятка ложных ссылок и сносок, переписали текст, исправили опечатки и т.п., но суть материала не изменилась, утверждают власти. Заказанная в прошлом декабре работа касалась правительственной IT-системы, связанной с наказанием получателей социальных пособий, не выполняющих свои обязательства по поиску работы. Впервые отчёт опубликовали в июле, но учёные Сиднейского университета обнаружили в нём «фальсификации», из-за чего Deloitte пришлось провести специальное расследование. То, что в ошибках виновен чат-бот, учёные предполагали изначально, но Deloitte на тот момент отказалась подтвердить это предположение.

Источник изображения: Deloitte В новой версии Deloitte указывает, что использовала инструменты на базе ИИ-модели Azure OpenAI GPT-4o. Бот помог с анализом и перекрёстными ссылками. По словам учёных, нельзя доверять рекомендациям, если сама основа отчёта построена на ошибочной и «неэкспертной» методологии. Deloitte, в своё время хвалившаяся достижениями в области искусственного интеллекта и предлагавшая клиентам тренинги по «ответственному использованию» ИИ, теперь оказалась в неловкой ситуации — из-за ИИ ошибки оказались в её собственном отчёте. При этом компания зарабатывает более $70 млрд/год по всему миру, а всё большая часть получаемых средств поступает от консультаций по вопросам, связанным с внедрением ИИ — этикой, политикой его внедрения и применения. В этом контексте выявленные ложные цитаты являются наихудшей рекламой деятельности компании. Среди удалённых материалов — ссылки на вымышленные доклады австралийских профессоров и даже выдуманный отрывок из дела Amato v Commonwealth, с упоминанием конкретного судьи. Несмотря на скандал, DEWR настаивает, что суть независимого обзора сохранилась, изменений в рекомендациях не предусмотрено. По некоторым данным, внутренняя проверка Deloitte показала, что причина появления некачественного материала — человеческий фактор, а не злоупотребление ИИ. Тем не менее, для клиентов консалтинговых компаний «Большой четвёрки» (Deloitte, PwC, Ernst & Young и KPMG) новость — повод без лишнего шума проверить полученные за немалые деньги выкладки экспертов на достоверность и наличие «творчества» ИИ. Примечательно, что в июне Deloitte предрекала рост потребность ИИ ЦОД в США в энергии к 2035 году может вырасти в 30 раз — до 123 ГВт с 4 ГВт в 2024 году. Пока неизвестно, насколько активно использовался ИИ при составлении прогноза и можно ли ему верить.

06.10.2025 [17:20], Руслан Авдеев

Caterpillar стала неожиданным бенефециаром ИИ-бумаНередко в ходе «золотой лихорадки» основные капиталы зарабатывали не золотоискатели, а бизнесы, поставлявшие им оборудование. То же случилось во время ИИ-бума: одним из бенефициаров стала компания Caterpillar (CAT), выпускающая традиционное промышленное оборудование, в том числе — турбины для генерации электричества, сообщает Bloomberg. Хотя американская компания хорошо известна своими экскаваторами и бульдозерами, закрыть сентябрь с рекордными показателями ей помогли именно турбины из-за ненасытного спроса ИИ на электроэнергию. Изначально развитие ИИ спровоцировало стремительный рост акций производителей полупроводников и разработчиков ПО, но по мере роста спроса на электроэнергию для ЦОД начался бум акций коммунальных компаний и предприятий, строящих дата-центры. Наконец, инвесторы стали искать и другие сферы применения средств, хлынувших сотнями миллиардов долларов в экономику, связанную со сферой ИИ. В сентябре 2025 года акции Caterpillar выросли в цене на 14 % — это лучший показатель с 2023 года. В результате в годовом исчислении рост акций составил 32 %, что значительно выше роста индекса Nasdaq 100, а также роста на 19 % в группе из семи крупнейших высокотехнологичных компаний США. В прошлую среду акции выросли ещё на 0,8 % — инвесторов не испугали даже новости о продаже акций на €387 млн ($455 млн) пенсионным фондом ABP из Нидерландов.

Источник изображения: Caterpillar Рост не в полной мере связан с деятельностью Caterpillar по выпуску турбин. Хотя акции резко упали после объявления в августе о миллиардных расходах в связи с новыми тарифами США, ряд факторов, смягчивших финансовые показатели, от снижения налогов до снижения ставки ФРС, позволили удержаться на плаву. Сентябрьский «триумф» CAT во многом обусловлен объявлением Oracle, представившей неожиданно оптимистичный прогноз для своего бизнеса, связанного с облачными вычислениями — он потребует очень много электроэнергии и вычислительных мощностей. Инвесторы ставят на то, что для удовлетворения спроса в электричестве потребуются турбины Caterpillar. В частности, первый ЦОД OpenAI Stargate, в развитии которого принимает участие Oracle, получит 29 газовых турбин. xAI также использует турбины Caterpillar для питания Colossus 2. По мнению экспертов Oppenheimer, рынок осознаёт важность ЦОД на фоне снижения процентных ставок, что, как ожидается, станет катализатором строительства жилой и коммерческой недвижимости. Впрочем, Caterpillar заработает не только на турбинах, но и, например, на оборудовании для добычи меди, которая тоже очень востребована при строительстве ЦОД. Также тяжёлое оборудование компании потребуется и для непосредственного строительства дата-центров. Вместе с тем производители газовых турбин пока опасаются расширять производство. Не так давно Bank of America повысил целевую цену акций компании Caterpillar с $495 до $517, сославшись на использование продуктов Caterpillar в секторе ЦОД. Caterpillar не публикует финансовые результаты подразделения Solar Turbines, отвечающего за решения для генерации энергии, что несколько затрудняет оценки бизнеса инвесторами. В Bank of America считают это подразделение «самым прибыльным продуктом CAT с устойчивыми перспективами роста». Эксперты подчёркивают, что CAT известна прежде всего строительным и горнодобывающим оборудованием, но движущей силой очередного цикла модернизации, вероятно, станет энергетика — в которой инвесторы разбираются меньше всего. Пока Уолл-Стрит следит за тем, не снизится ли рентабельность компании из-за роста издержек. На клиентов CAT может оказать давление и инфляция в других сегментах рынка. Сейчас акции компании торгуются выше средней целевой цены Уолл-Стрит, поэтому их дальнейший рост, вероятно, будет затруднительным. При этом «мультипликатор» P/E (цена/прибыль) на ближайшие 12 месяцев составляет 23, что является максимальным значением с 2021 года. В то же время, по мнению экспертов, оценка даже занижена по сравнению с другими компаниями, выигравшими от спроса на ИИ-технологии, поэтому не исключено, что у ценных бумаг сохранился потенциал роста. Среди компаний, выпускающих энергетическое оборудование, акции Vertiv Holdings и GE Vernova торгуются с мультипликаторами 36 и 53 P/E соответственно благодаря росту их акций на 40 % и 100 % в текущем году. В то же время акции Caterpillar торгуются с дисконтом по сравнению с крупнейшими ИИ-игроками вроде Microsoft и NVIDIA. Прошедшие в минувшую среду торги акциями техасской Fermi Inc. показали, что интерес инвесторов к вложениям в ИИ ещё не угас. Акции компании, рассчитывающей на строительство огромного кампуса для ЦОД и энергомощностей, в ходе первой торговой сессии после выхода на биржу взлетели на 55 %. По словам экспертов, пока рынком в сфере ИИ и ЦОД движет «иррациональное начало» и акции той же Caterpillar могут оказаться в «петле положительной обратной связи».

06.10.2025 [16:45], Владимир Мироненко

AMD поставит OpenAI ИИ-ускорители на 6 ГВт, а OpenAI получит долю в AMDAMD и OpenAI объявили о заключении многолетнего соглашения о стратегическом партнёрстве, в рамках которого будет построена ИИ-инфраструктура на базе сотен тысяч ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт общей стоимостью, по предварительным оценкам, $60–$80 млрд. После объявления о сделке акции AMD выросли на 28 % до $211,18 в начале торгов, что само по себе тянет на рекорд, пишет Bloomberg. В рамках соглашения AMD предоставила OpenAI возможность покупки до 160 млн обыкновенных акций, которые будут переданы по мере достижения контрольных целей. Первый транш будет предоставлен после развёртывания инфраструктуры на 1 ГВт, которое начнется во II половине следующего года. ИИ-системы будут основаны на чипах AMD Instinct MI450. Последующие транши будут выделяться по мере развёртывания оборудования в ЦОД до итогового показателя мощности в 6 ГВт. Выпуск акций также привязан к достижению AMD целей по цене акций и достижению OpenAI технических и коммерческих целей. Исходя из текущего количества выпущенных акций AMD к завершению сделки у OpenAI будет 10 % её акций. «Мы рассматриваем эту сделку как безусловно преобразующую не только для AMD, но и для динамики всей отрасли», — заявил исполнительный вице-президент AMD Форрест Норрод (Forrest Norrod) агентству Reuters в воскресенье. В AMD также сообщили, что партнёрство с OpenAI принесет компании десятки миллиардов долларов дохода, значительно увеличит прибыль AMD на акцию и ускорит развитие инфраструктуры ИИ OpenAI. Для AMD эта сделка станет отправной точкой для более широкого внедрения её технологий, что может увеличить доход компании в этой области до более чем $100 млрд, заявили руководители компании, не уточняя конкретных сроков, пишет Bloomberg. Для OpenAI сотрудничество с AMD обеспечит более надёжную альтернативу решениям NVIDIA, на которые OpenAI и операторы ЦОД тратят значительную часть своих бюджетов. В прошлом месяце стало известно о соглашении OpenAI с NVIDIA, в рамках которого производитель чипов инвестирует в стартап до $100 млрд, включая поставку ускорителей общей мощностью не менее 10 ГВт. Ускорители AMD будут использоваться преимущественно для инференса, а NVIDIA — для обучения. Попутно OpenAI при поддержке Broadcom разрабатывает собственные ИИ-ускорители, которые должны появиться в 2026 году.

06.10.2025 [14:41], Руслан Авдеев

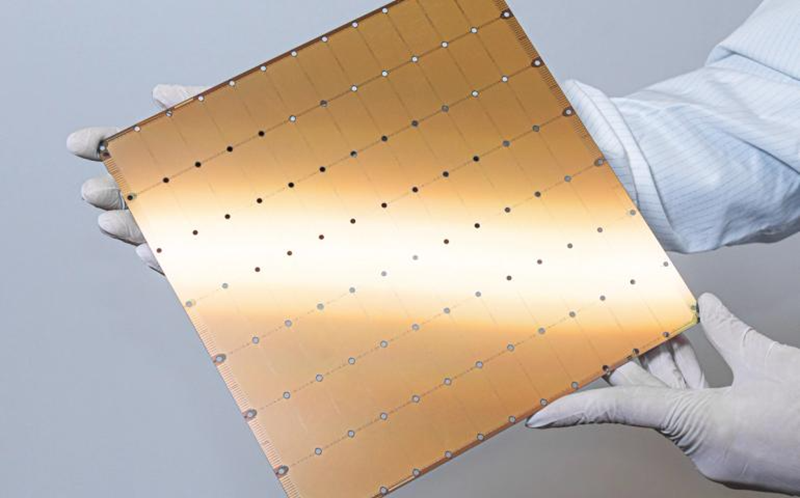

Разработчик царь-ускорителей Cerebras Systems отозвал заявку на IPOCerebras Systems решила отозвать заявку о выходе на публичные торги — информация об IPO компании впервые появилась около года назад. Оператор ЦОД и разработчик ИИ-чипов сообщил, что документы об IPO ещё не были одобрены регуляторами, сообщает Bloomberg. Всего несколько дней назад компания закрыла раунд финансирования G на $1,1 млрд, что подняло её стоимость до $8,1 млрд. На тот момент руководство заявляло, что привлечённые средства никак не скажутся на планах выхода на публичные торги. Сообщалось, что они будет потрачены на расширение технологического портфолио, включая разработку ИИ-ускорителей, упаковку, создание ИИ-суперкомпьютеров и др. Раунд финансирования Cerebras стал последним в череде инвестиций в технологическую индустрию, которая тратит миллиарды на новую ИИ-инфраструктуру, призванную преобразить мировую экономику. В последние недели на рынке IPO в США наблюдается оживление. В частности, успешно дебютировали технологические компании Netskope и Figure Technology Solutions, акции которых выросли более чем на 20 % от цены размещения.

Источник изображения: Cerebras Cerebras подала заявку о выходе на IPO в сентябре 2024 года, но выход на биржу так и не состоялся. Это связывается с позицией американских регуляторов, занявшихся расследованием инвестиций G42 из Абу-Даби на $335 млн. 87 % выручки Cerebras за первые шесть месяцев 2024 года поступили от G42, а строящиеся в США дата-центры предназначены для использования именно компанией из ОАЭ, имеющей связи с Китаем. Впрочем, в марте Cerebras объявила, что разрешила все спорные вопросы с регулятором CFIUS. Последний раунд финансирования возглавили Fidelity Management & Research и Atreides Management. В числе инвесторов — Tiger Global, Valor Equity Partners и венчурный капиталист 1789 Capital, также приняли участие и прежние инвесторы, включая Altimeter Capital Management and Benchmark. На днях Cerebras запустила новый ЦОД в Оклахома-Сити (Oklahoma City, Оклахома) при сотрудничестве со Scale Datacenters. Также компания имеет действующие кластеры для инференса в Санта-Кларе (Santa Clara) и Стоктоне (Stockton) в Калифорнии (последний в плавучем ЦОД Nautilus), а также в Далласе (Dallas, Техса). Также компания создаёт кластеры в Миннеаполисе (Миннесота), Монреале (Канада) на объекте Bit Digital, а также в некоторых локациях на Среднем Западе США и в Европе. Компания внедрила оборудование в Эдинбургском университете (University of Edinburgh), Сандийскийх национальных лабораториях (Sandia National Labs), в лабораториях Лос-Аламоса (Los Alamos Labs), на мощностях G42/Core42 и др.

06.10.2025 [14:00], Сергей Карасёв

HP представила компактный «ИИ-суперкомпьютер» ZGX Nano G1n AI Station на основе NVIDIA GB10Компания HP анонсировала рабочую станцию ZGX Nano G1n AI Station небольшого форм-фактора, предназначенную для работы с ИИ, включая «тонкую» настройку языковых моделей, инференс и агентные приложения. Основой новинки служит суперчип NVIDIA GB10 Grace Blackwell. В целом решение практически не отличается от систем на базе GB10 других вендоров. Устройство заключено в корпус с габаритами 150 × 150 × 51 мм, а масса составляет 1,25 кг. В состав чипа GB10 входят 20-ядерный процессор Grace (10 × Arm Cortex-X925 и 10 × Arm Cortex-A725) и ускоритель Blackwell. Имеется 128 Гбайт унифицированной системной памяти LPDDR5x, пропускная способность которой достигает 273 Гбайт/с. Компьютер может быть оборудован SSD типоразмера M.2 вместимостью 1 или 4 Тбайт (NVMe OPAL). В оснащение входят сетевой контроллер 10GbE (Realtek RTL8127), адаптер NVIDIA ConnectX-7 200GbE, беспроводной модуль MediaTek MT7925 с поддержкой Wi-Fi 7 (2×2) / Bluetooth 5.4. В тыльной части корпуса располагаются разъём USB Type-C для подачи питания, три порта USB Type-C (20 Гбит/с), гнездо RJ45 (10GbE), два порта QSFP и интерфейс HDMI 2.1a.

Источник изображения: HP На устройстве применяется программная платформа NVIDIA DGX OS на базе Ubuntu, оптимизированная специально для задач ИИ. Заявленная производительность достигает 1000 TOPS на операциях FP4. Возможна работа с ИИ-моделями, насчитывающими до 200 млрд параметров. Кроме того, два экземпляра ZGX Nano G1n AI Station могут быть объединены в одну систему, что позволит использовать ИИ-модели, оперирующие 405 млрд параметров. Продажи компактного ИИ-суперкомпьютера начнутся текущей осенью. |

|