Материалы по тегу: sc23

|

15.11.2023 [15:52], Сергей Карасёв

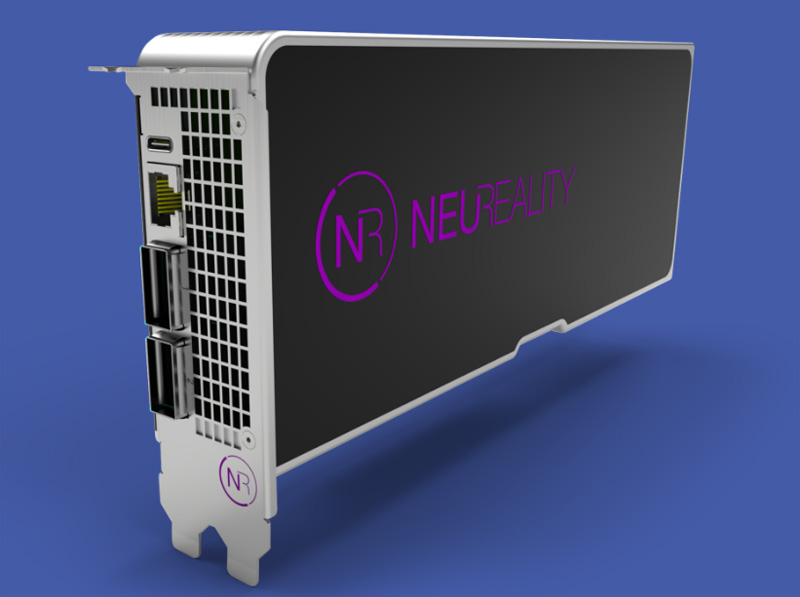

NeuReality представила «сервер на чипе» и другие аппаратные ИИ-решения для инференсаКомпания NeuReality на конференции по высокопроизводительным вычислениям SC23 представила полностью интегрированное решение NR1 AI Inference, предназначенное для ИИ-платформ. Изделие спроектировано специально для ускорения инференса и снижения нагрузки на аппаратные ресурсы. Утверждается, что благодаря использованию технологий NeuReality операторы крупных дата-центров могут на 90 % сократить затраты на выполнение операций ИИ. При этом производительность по сравнению с традиционными системами на основе CPU больше на порядок. Впрочем, конкретные цифры не приводятся.

Источник изображений: NeuReality В продуктовое семейство NeuReality входит решение NR1, которое разработчик называет «сервером на чипе» со встроенным нейросетевым движком. По заявлениям NeuReality, это первый в мире «сетевой адресуемый процессор» — NAPU (Network Addressable Processing Unit). Этот специализированный чип, ориентированный на задачи инференса, обладает возможностями виртуализации и сетевыми функциями.  Изделие NR1 является основой вычислительного модуля NR1-M AI Inference Module, выполненного в виде полноразмерной двухслотовой карты расширения PCIe. Модуль может подключаться к внешнему ускорителю глубокого обучения (DLA). Наконец, анонсирован сервер NR1-S AI Inference Appliance, который оснащается картами NR1-M AI Inference Module. NeuReality отмечает, что данная система позволяет снизить стоимость и энергопотребление почти в 50 раз на операциях инференса по сравнению со стандартными платформами.

15.11.2023 [13:57], Сергей Карасёв

Французский суперкомпьютер Adastra одним из первых получит новейшие ускорители AMD Instinct MI300AФранцузское национальное агентство по высокопроизводительным вычислениям (GENCI), по сообщению HPCwire, проводит масштабное обновление суперкомпьютера Adastra, о запуске которого было объявлено два года назад. После апгрейда система сможет решать сложные задачи в области ИИ. Комплекс Adastra находится под управлением Национального вычислительного центра высшего образования Франции (CINES). Система использует платформу HPE Cray EX235A с оптимизированными процессорами AMD EPYC Milan (64 ядра; 2,0 ГГц) и ускорителями AMD Instinct MI250X. Апгрейд предусматривает использование гибридных чипов Instinct MI300A в составе платформы HPE Cray EX4000, оснащённой 14 серверами HPE Cray EX255a Accelerator Blade. В общей сложности будут задействованы 28 узлов, каждый из которых содержит четыре чипа Instinct MI300A. Таким образом, суммарное количество использованных изделий Instinct MI300A равно 112. Задействован 200G-интерконнект HPE Slingshot 11. Об итоговой производительности обновлённого суперкомпьютера Adastra данных пока нет. Но в прежнем виде система занимает 17-ю строку в ноябрьском рейтинге TOP500 с быстродействием 46,1 Пфлопс (FP64). А в мировом рейтинге самых энергоэффективных НРС-систем GREEN500 комплекс Adastra находится на третьей позиции с показателем 58,021 Гфлопс/Вт.

15.11.2023 [02:15], Владимир Мироненко

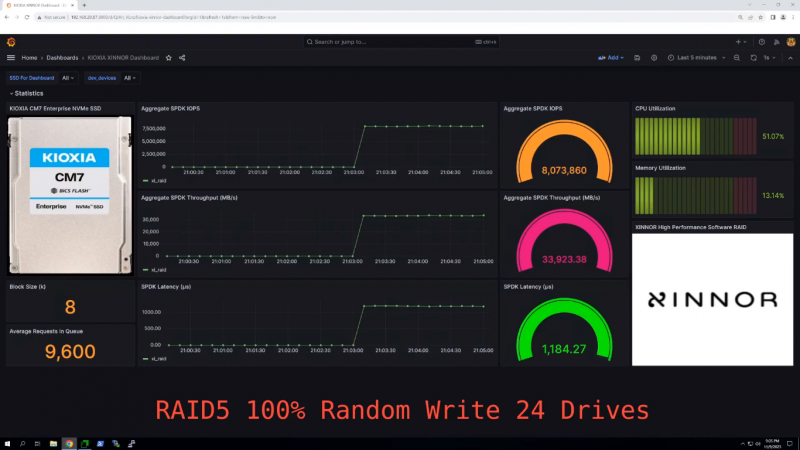

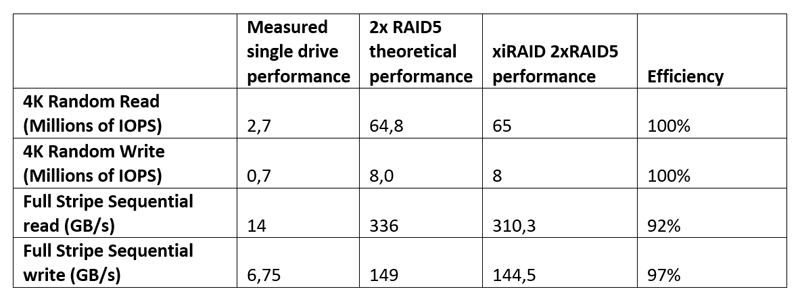

Xinnor xiRAID установил новый рекорд производительности среди NVMe-массивов с PCIe 5.0 SSD от KioxiaВ августе этого года израильская компания Xinnor, специализирующаяся на решениях для хранения данных, в том числе программного RAID для современных NVMe SSD, сообщила в ходе саммита Flash Memory Summit о мировом рекорде производительности, установленном с использованием ПО Xinnor xiRAID и 12-ти NVMe SSD Kioxia CM7-R (PCIe 5.0). На SC23 компания обновила рекорд. На этот раз в тесте были задействованы сразу 24 накопителя Kioxia CM7-V (PCIe 5.0, NVMe). Каждый диск имеет скорость последовательного чтения 14 Гбайт/с и последовательной записи 6,75 Гбайт/с, а на случайных операциях производительность составляет 2,7 млн IOPS и более 600 тыс. IOPS соответственно. При развёртывании множества таких SSD в системе первостепенное значение приобретает обеспечение надлежащей масштабируемости производительности и целостности данных. Xinnor выполнила тест на сервере Supermicro с двумя 64-ядерными процессорами AMD EPYC Genoa 9534 и 768 Гбайт RAM. Чтобы избежать узких мест, Xinnor создала две группы RAID 5 по 12 дисков так, что каждый массив находился в рамках одного NUMA-домена. Такая конфигурация обеспечивает наивысшую производительность и одновременно защиту данных в случае сбоя диска для каждого RAID, говорит Xinnor. Сообщается, что в последовательных рабочих нагрузках рекордные показатели (см. таблицу ниже) были достигнуты при использовании лишь 16 из 128 доступных ядер, а на случайных операциях xiRAID нагружал на 3–9 % лишь половину ядер. Низкая нагрузка на CPU и универсальность xiRAID, по словам компании, значительно упрощает развёртывание массивов и позволяет эффективно использовать имеющееся оборудование. Xinnor также проверила работу в деградированном режиме, когда из массива RAID 5 «выпадает» один накопитель. Даже в этом случае производительность остаётся достаточно высокой: более 34 млн и 6 млн IOPS при произвольных чтении и записи соответственно, что эквивалентно 52 % и 75 % от нормальной производительности. При последовательных операциях доступа Xinnor зафиксировала производительность выше 70 % от нормальной.  Заодно Xinnor также протестировала ту же систему, создав 2 группы RAID 6 (2 × 10 + 2). При чтении производительность была сравнима с RAID 5: 64 млн IOPS и 310 Гбайт/с. При записи производительность была ниже: 5,2 млн IOPS и 128 Гбайт/с. Впрочем, по словам Xinnor, xiRAID быстрее, чем любое другое альтернативное решение RAID.

14.11.2023 [19:26], Сергей Карасёв

TACC получит ИИ-суперкомпьютер Vista с суперчипами NVIDIA GH200 Grace HopperТехасский центр передовых вычислений (TACC) при Техасском университете в Остине (США) на конференции по высокопроизводительным вычислениям SC23 анонсировал суперкомпьютер Vista, ориентированный на задачи ИИ и машинного обучения. Запуск этого комплекса в эксплуатацию запланирован на начало 2024 года. Отмечается, что Vista станет связующим звеном между нынешним суперкомпьютером TACC Frontera и будущей системой TACC Horizon, проект которой финансируется Национальным научным фондом (NSF). Ввод Horizon в строй намечен на 2025 год: ожидается, что этот комплекс будет на порядок быстрее Frontera. Что касается Vista, то эта система знаменует собой переход от традиционной архитектуры х86, которая применяется во Frontera и системах Stampede, в пользу Arm. В частности, будут задействованы суперчипы NVIDIA GH200 Grace Hopper, которые содержат 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H200. В составе Vista чипами GH200 будут оборудованы немногим более половины всех вычислительных узлов. Оставшиеся узлы получат процессор NVIDIA Grace CPU Superchip, содержащий два кристалла Grace в одном модуле (144 ядра).

Источник изображения: TACC Для Vista предусмотрено использование 400G-интерконнекта NVIDIA Quantum-2 InfiniBand. Компания VAST Data предоставит для суперкомпьютера высокопроизводительное флеш-хранилище, подключенное к Stampede3. Вычислительные узлы будут производиться компанией Gigabyte, а интеграцию обеспечит Dell.

14.11.2023 [18:50], Сергей Карасёв

Запущены суперкомпьютеры Dawn, SuperMUC-NG и Crossroads на базе Intel Data Center GPU Max и Xeon Sapphire Rapids

hardware

hpc

intel

intel max

intel xe

sapphire rapids

sc23

xeon

великобритания

германия

суперкомпьютер

сша

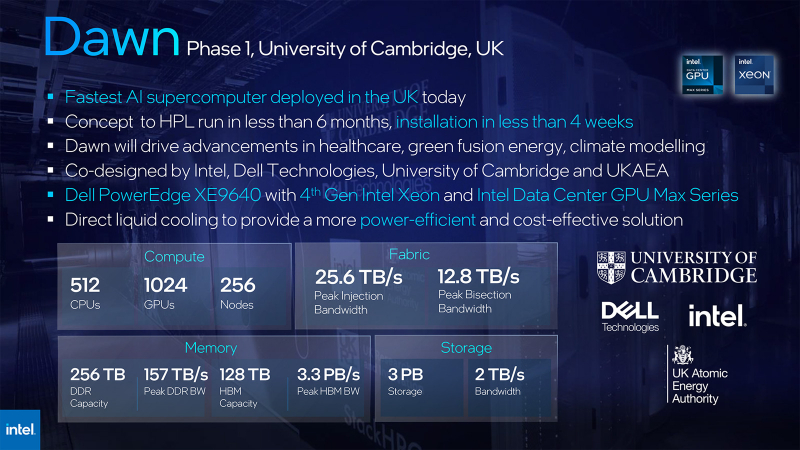

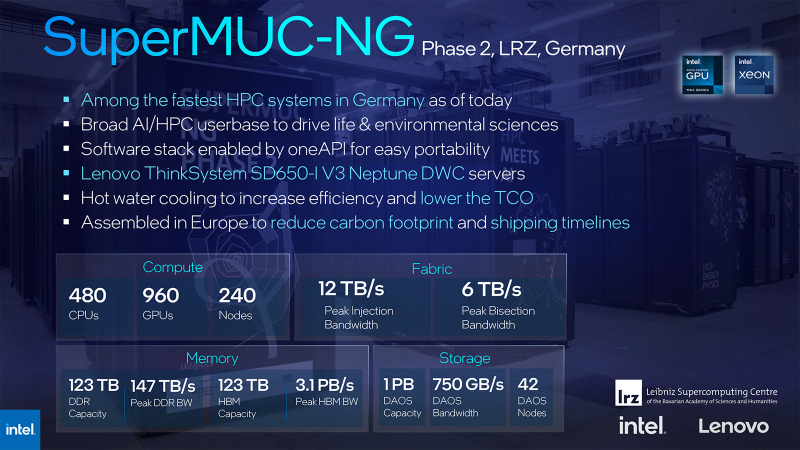

Корпорация Intel на конференции по высокопроизводительным вычислениям SC23 рассказала о новых суперкомпьютерах, попавших в ноябрьский рейтинг TOP500. Речь, в частности, идёт о вычислительных комплексах Dawn (Phase 1), SuperMUC-NG (Phase 2) и Crossroads. Система Dawn, созданная специалистами Intel, Dell Technologies и Кембриджского университета, рассчитана на задачи ИИ. В основу положены серверы Dell PowerEdge XE9640 с жидкостным охлаждением. В общей сложности задействованы 256 узлов, в состав которых входят 512 процессоров Intel Xeon Sapphire Rapids — Platinum 8468 с 48 ядрами (96 потоков; 2,1–3,8 ГГц; 350 Вт). Суперкомпьютер Dawn использует 1024 ускорителя Intel Data Center GPU Max 1550. Общий объём памяти DDR составляет 256 Тбайт, а её пропускная способность достигает 157 Тбайт/с. Кроме того, задействовано 128 Тбайт памяти НВМ с пропускной способностью до 3,3 Пбайт/с. Подсистема хранения данных вместимостью 3 Пбайт обеспечивает скорость до 2 Тбайт/с. Агрегированная пропускная способность сети — до 25,6 Тбайт/с. Заявленная производительность достигает 19,46 Пфлопс (FP64). Это соответствует 41-му месту в ноябрьском рейтинге ТОР500. Пиковое быстродействие — 53,85 Пфлопс. Система установлена в лаборатории Cambridge Open Zettascale Lab (Великобритания). В свою очередь, комплекс SuperMUC-NG (Phase 2) смонтирован в Суперкомпьютерном центре Лейбница Баварской академии наук (Германия). Этот суперкомпьютер базируется на серверах Lenovo ThinkSystem SD650-I V3 Neptune DWC с прямым жидкостным охлаждением. Установлены 240 узлов, в состав которых входят в общей сложности 480 процессоров Intel Xeon Platinum 8480L (56 ядер; 112 потоков; 2,0–3,8 ГГц; 350 Вт) и 960 ускорителей Data Center GPU Max. Комплекс SuperMUC-NG (Phase 2) оперирует 123 Тбайт памяти DDR с пропускной способностью до 147 Тбайт/с. Память НВМ такого же объёма обеспечивает пропускную способность до 3,1 Пбайт/с. Применено хранилище на 1 Пбайт со скоростью 750 Гбайт/с. Пропускная способность сети — до 12 Тбайт/с. Суперкомпьютер обладает производительностью 17,19 Пфлопс (FP64): в списке ТОР500 система располагается на 52-й строке. Наконец, суперкомпьютер Crossroads размещён в Лос-Аламосской национальной лаборатории (LANL) Министерства энергетики США. Система обладает производительностью 30,03 Пфлопс (FP64). Задействованы 2600 чипов Intel Xeon CPU Max 9480 с 56 ядрами и памятью HBM. Система находится на 24-м месте рейтинга ТОР500. Всего же в новой редакци рейтинга есть 20 новых машин на базе Sapphire Rapids, из которых пять используют Max-версию процессоров, а также четыре системы с ускорителями Data Center GPU Max.

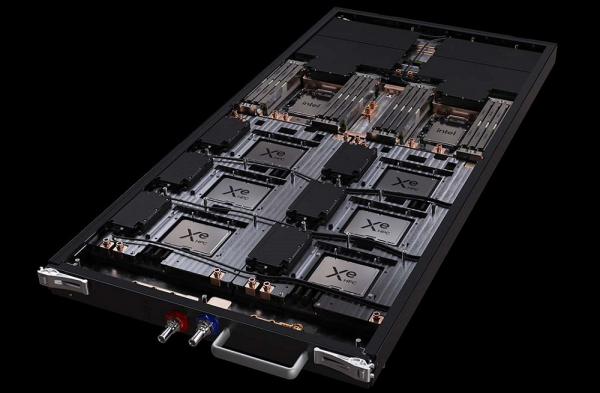

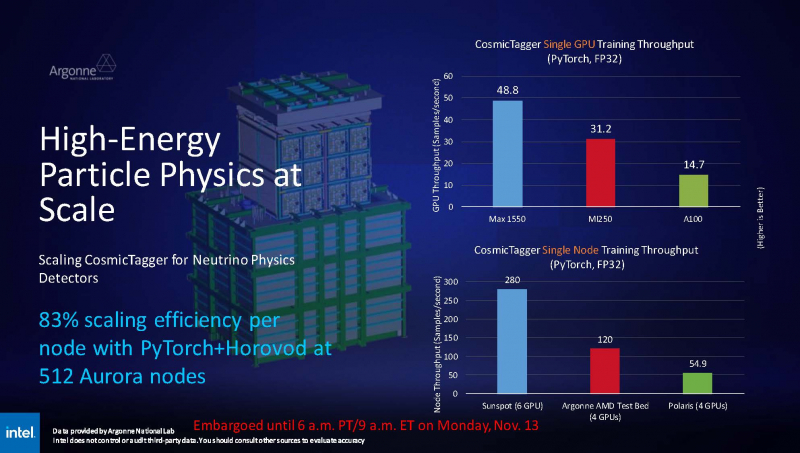

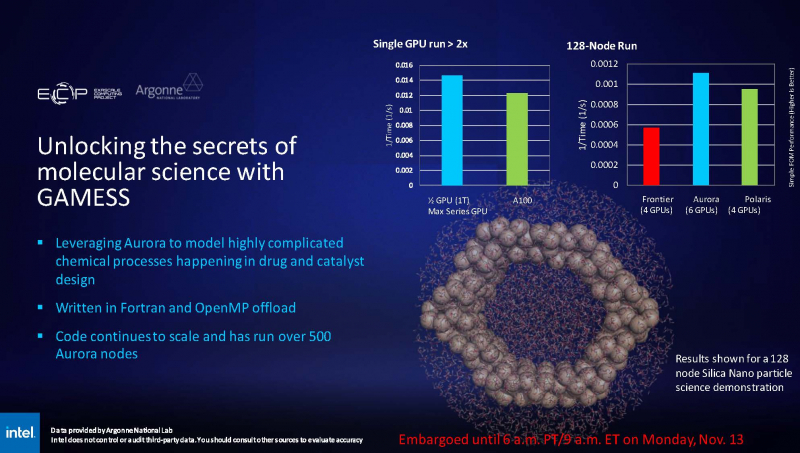

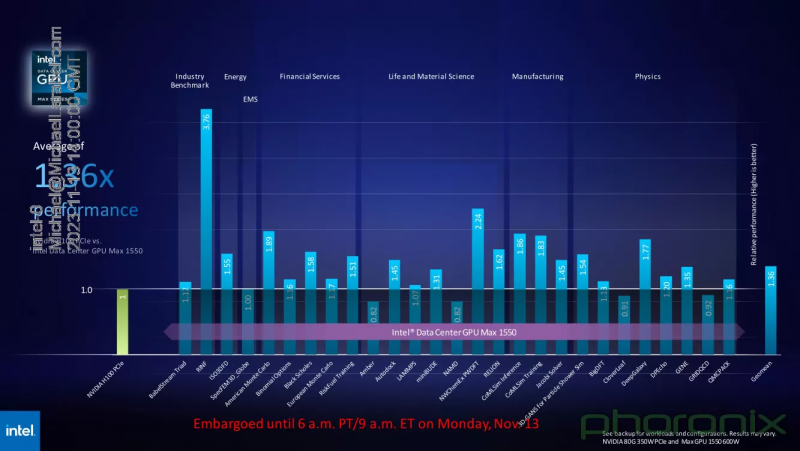

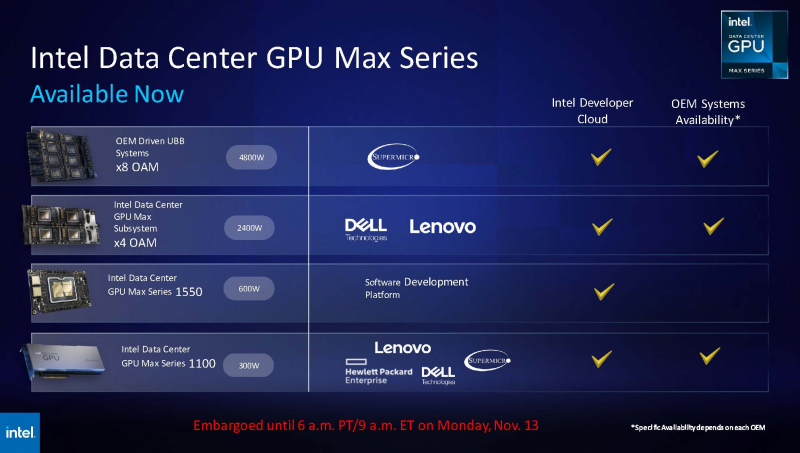

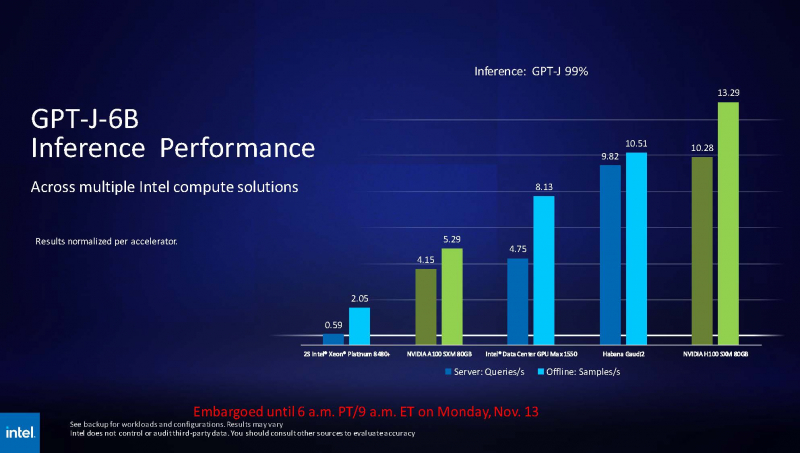

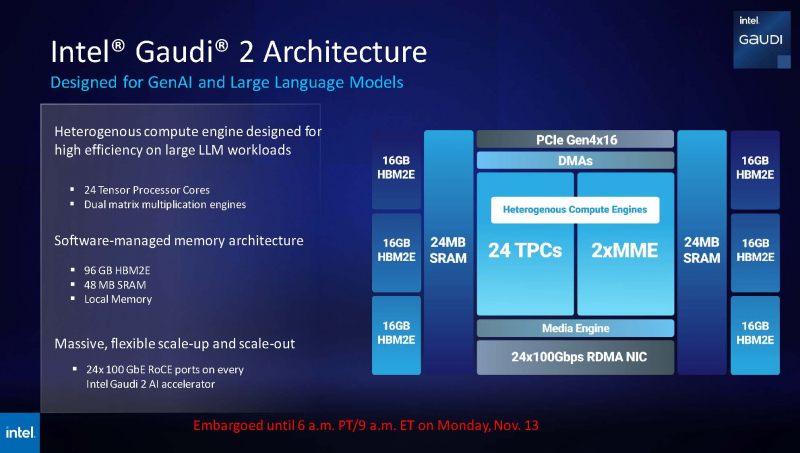

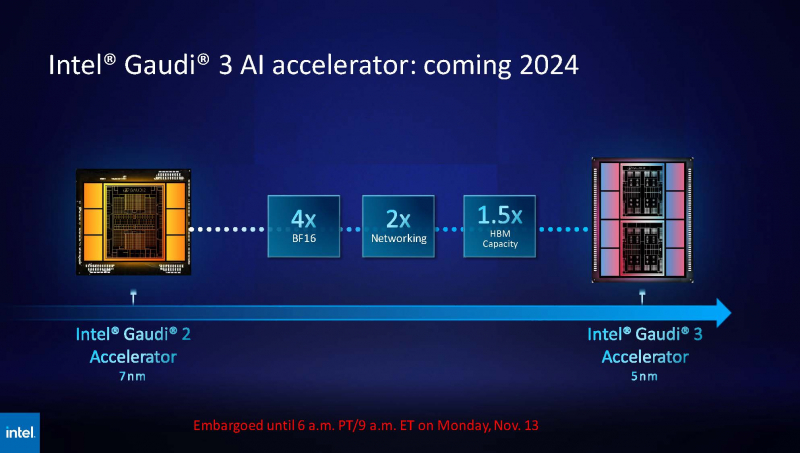

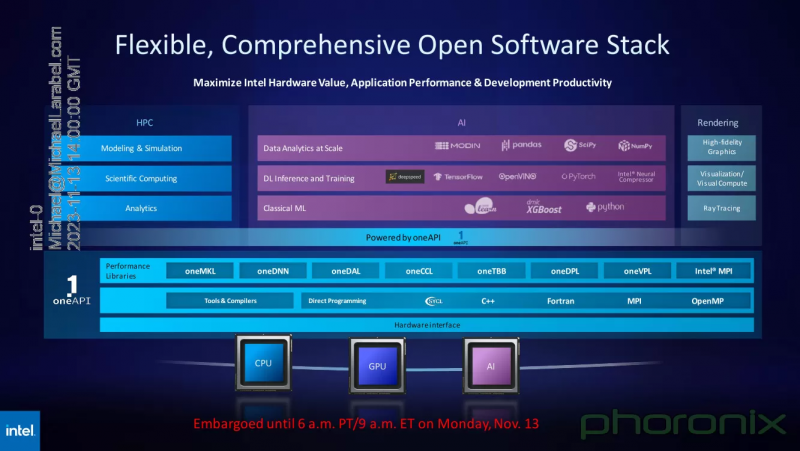

14.11.2023 [03:20], Алексей Степин

Intel показала результаты тестов ускорителя Max 1550 и рассказала о будущих чипах Gaudi3 и Falcon ShoresВ рамках SC23 корпорация Intel продемонстрировала ряд любопытных слайдов. На них присутствуют результаты тестирования ускорителя Max 1550 с архитектурой Xe, а также планы относительно следующего поколения ИИ-ускорителей Gaudi. При этом компания применила иной подход, нежели обычно — вместо демонстрации результатов, полученных в стенах самой Intel, слово было предоставлено Аргоннской национальной лаборатории Министерства энергетики США, где летом этого года было завершён монтаж суперкомпьютера экза-класса Aurora, занимающего нынче второе место в TOP500.  В этом HPC-кластере применены OAM-модули Max 1550 (Ponte Vecchio) с теплопакетом 600 Вт. Они содержат в своём составе 128 ядер Xe и 128 Гбайт памяти HBM2E. Интерфейс Xe Link позволяет общаться напрямую восьми таким модулям, что обеспечивает более эффективную масштабируемость. Хотя настройка вычислительного комплекса Aurora ещё продолжается, уже имеются данные о производительности Max 1550 в сравнении с AMD Instinct MI250 и NVIDIA A100. В тесте физики высоких частиц, использующих сочетание PyTorch+Horovod (точность вычислений FP32), ускорители Intel уверенно заняли первое место, а также показали 83% эффективность масштабирования на 512 узлах Aurora. В тесте, симулирующем поведение комплекса кремниевых наночастиц, ускорители Max 1550, также оказались первыми как в абсолютном выражении, так и в пересчёте на 128-узловой тест в сравнении с системами Polaris (четыре A100 на узел) и Frontier (четыре MI250 на узел). Написанный с использованием Fortran и OpenMP код доказал работоспособность и при масштабировании до более чем 500 вычислительных узлов Aurora. В целом, ускорители Intel Max 1550 демонстрируют хорошие результаты и не уступают NVIDIA H100: в некоторых задачах их относительная эффективность составляет не менее 0,82, но в большинстве других тестов этот показатель варьируется от 1,0 до 3,76. Очевидно, что у H100 появился достойный соперник, который, к тому же, имеет меньшую стоимость и большую доступность. Но сама NVIDIA уже представила чипы (G)H200, а AMD готовит Instinct MI300. Системы на базе Intel Max доступны в различном виде: как в облаке Intel Developer Cloud, так и в составе OEM-решений. Supermicro предлагает сервер с восемью модулями OAM, а Dell и Lenovo — решения с четырьями ускорителями в этом же формате. PCIe-вариант Max 1100 доступен от вышеуказанных производителей, а также у HPE. Помимо ускорителей Max, Intel привела и новые данные о производительности ИИ-сопроцессоров Gaudi2. Компания продолжает активно совершенствовать и оптимизировать программную экосистему Gaudi. В результате, в инференс-системе на базе модели GPT-J-6B результаты ускорителей Gaudi2 уже сопоставимы с NVIDIA H100 (SXM 80 Гбайт), а A100 существенно уступает как Gaudi2, так и Max 1550. Но самое интересное — это сведения о планах относительно следующего поколения Gaudi. Теперь известно, что Gaudi3 будет производиться с использованием 5-нм техпроцесса. Новый чип будет в четыре раза быстрее в вычислениях BF16, а также получит вдвое более мощную подсистему памяти и в 1,5 раза больше памяти HBM. Увидеть свет он должен в 2024 году. Заодно компания напомнила, что процессоры Xeon Emerald Rapids будут представлены ровно через месяц, а Granite Rapids появятся в 2024 году. В 2025 появится чип Falcon Shores, который теперь должен по задумке Intel сочетать в себе GPU и ИИ-сопроцессор. Он объединит архитектуры Habana и Xe в единое решение с тайловой компоновкой, памятью HBM3 и полной поддержкой CXL. Следует отметить, что такая унификация вполне реальна: Intel весьма активно развивает универсальный, гибкий и открытый стек технологий в рамках проекта oneAPI. В него входят все необходимые инструменты — от компиляторов и системных библиотек до средств интеграции с популярными движками аналитики данных, моделями и библиотеками искусственного интеллекта.

14.11.2023 [02:35], Игорь Осколков

Ноябрьский TOP500: запоздалый рассвет IntelСвежая, 62-ая по счёту редакция рейтинга TOP500 самых производительных суперкомпьютеров мира среди тех, кто пожелал в нём участвовать (это снова отсылка к Китаю) принесла не очень много изменений, но зато интересных. Первое место по-прежнему удерживает AMD-система Frontier с показателем 1,194 Эфлопс и всё такой же приличной энергоэффективностью на уровне 52,59 Гфлопс/Вт, которая с лета обновлений не получала. А вот второе место… Второе место, наконец-то, досталось суперкомпьютеру Aurora, с анонса которого прошло восемь лет, а архитектура и заявленная производительность неоднократно пересматривались. Формально машина, использующая процессоры Intel Xeon Max с HBM-памятью и ускорители Data Center GPU Max (Ponte Vecchio), объединённых интерконнектом HPE Slingshot 11 (как у Frontier), была смонтирована ещё летом этого года, но процесс ввода в эксплуатацию этой уникальной системы завершится только в 2024 году. К тому моменту Aurora должна достичь заявленной производительности 2 Эфлопс. Столько же предложит AMD-система El Capitan. Но для Intel и Аргоннской национальной лаборатории (ANL) попадание в лидеры TOP500, похоже, стало делом принципа — за потраченные деньги (суммарно $500 млн) и время надо отчитаться. Поэтому в тесте участвовала лишь половина машины, которая добралась до отметки 585,34 Пфлопс. При этом разница между фактической и теоретической пиковой производительностью составляет почти два раза, а сама система уже потребляет больше Frontier и в Green500 находится в конце третьего десятка с показателем 23,71 Гфлопс/Вт. Так что простор для оптимизаций ещё есть. В целом, в свежем рейтинге сразу два десятка из полсотни новичков рейтинга используют Sapphire Rapids, причём пять систем ещё и Xeon Max, но ускорителями Intel Xe обзавелось лишь четыре системы. У AMD же сейчас есть десяток систем с Instinct MI250X (и ещё одна с MI210) и пять систем EPYC Genoa. Всего на EPYC’ах разных поколений базируется 140 систем против 331 на базе Xeon. Ускорителями NVIDIA оснащено 166 машин в списке, из которых только десять имеют новые H100, причём одна в необычной конфигурации. Без акселераторов обходятся 314 машин. Третье место заняла облачная система, которые в TOP500 встречаются всё чаще, а в будущем и вовсе станут неизбежны. Эта Microsoft Azure Eagle на базе инстансов NDv5 (Intel Xeon Platinum 8480C + NVIDIA H100 + Infiniband NDR400) набрала 561,2 Пфлопс. Впрочем, технически классические и облачные HPC-системы становятся всё ближе — суперкомпьютер NVIDIA EOS, который построен на ровно тех же компонентах, что Eagle, и который в TOP500 занял девятое место (121,4 Пфлопс), фактически тоже использует облачную архитектуру. А на примере MLPerf обе компании показали эффективность масштабирования нагрузок. Пятое место досталось финской системе LUMI, которая после очередного апгрейда набрала 379,7 Пфлопс. Наконец, на восьмом месте с показателем 138,2 Пфлопс закрепился европейский суперкомпьютер MareNostrum 5 с непростой судьбой. Точнее, его GPU-часть (ACC), поскольку CPU-часть (GPP) набрала 40,1 Пфлопс. ACC использует узлы Eviden BullSequana XH3000 с Intel Xeon Platinum 8460Y+ и ускорителями NVIDIA H100, но с 64 Гбайт памяти. GPP базируется на узлах Lenovo ThinkSystem SD650 v3 с Intel Xeon Platinum 8480+. Объединяет всю систему интерконнект Infiniband NDR200. Fugaku, некогда самая мощная машина, да ещё и на Arm, опустилась на четвёртую строчку рейтинга. Правда, в HPCG ей равных всё равно нет (16 Пфлопс), а второе и третье места достались Frontier (14,05 Пфлопс) и LUMI (4,59 Пфлопс). В Green500 семь машин из первой десятки представлены опять-таки связками AMD EPYC + Instinct, хотя лидерство всё ещё за Henri (Intel Xeon Ice Lake-SP + NVIDIA H100). Результаты HPL-MxP (ранее HPL-AI) с июня не обновлялись, так что в тройку лидеров входят Frontier (9,95 Эфлопс), LUMI (2,35 Эфлопс) и Fugaku (2 Эфлопс). Тройка лидеров среди производителей по количеству машин включает Lenovo (169 шт.), HPE (103 шт.) и Eviden (48 шт.), но по производительности с большим отрывом лидирует HPE (34,9 %), а за ней уже идут Eviden (9,8 %) и Lenovo (8,6 %). Впрочем, Китай, где как раз много однотипных машин Lenovo, направляет всё меньше заявок на включение в рейтинг, а США — всё больше. По суммарной производительности суперкомпьютеров Штаты тоже лидируют — 53 % от всего списка.

13.11.2023 [22:05], Сергей Карасёв

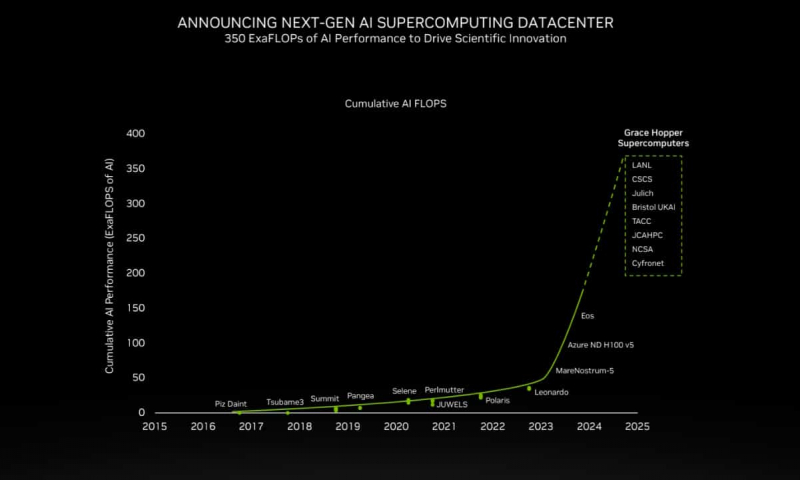

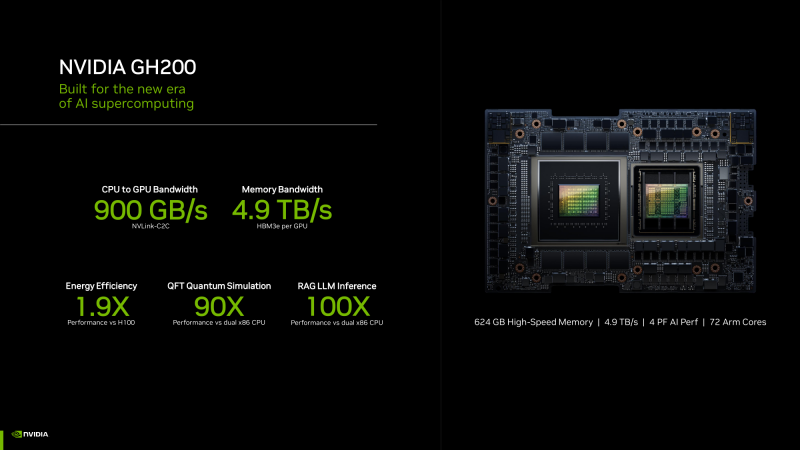

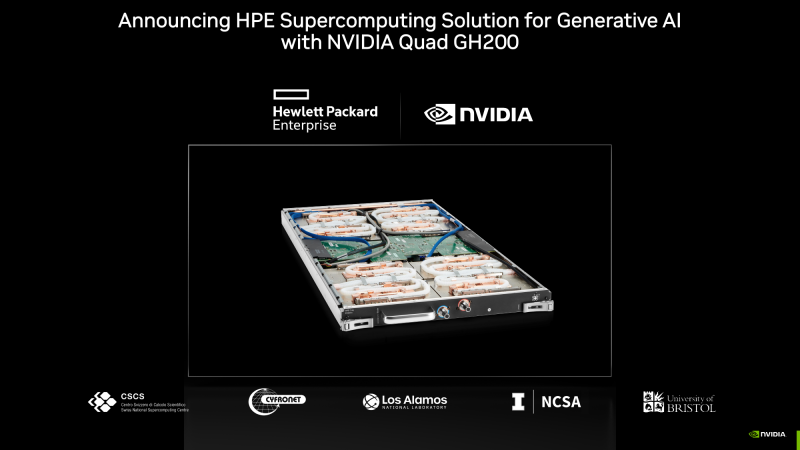

200+ Эфлопс: суперчип NVIDIA Grace Hopper ляжет в основу более 40 ИИ-суперкомпьютеровКомпания NVIDIA сообщила о том, что её суперчип GH200 Grace Hopper ляжет в основу более чем 40 ИИ-суперкомпьютеров по всему миру, которые используются в исследовательских центрах, на облачных площадках и пр. Отмечается, что в скором времени станут доступны десятки новых НРС-систем на базе GH200. Этот суперчип позволяет решать самые сложные научные задачи на базе ИИ, которые требуют обработки терабайт данных. В совокупности вычислительные системы на базе GH200, как сообщается, обеспечат ИИ-производительность около 200 Эфлопс. В частности, HPE объявила, что интегрирует GH200 в суперкомпьютеры HPE Cray. Узлы EX254n оснащаются двумя модулями Quad GH200 с четырьмя суперчипами в каждом, обеспечивая возможность масштабирования до десятков тысяч узлов. Аналогичный подход используется и в платформе Eviden BullSequana XH3000, которую Юлихский исследовательский центр (FZJ) в Германии получит в составе Jupiter — первого европейского суперкомпьютера экзафлопсного класса. Объединённый центр передовых высокопроизводительных вычислений в Японии (JCAHPC) намерен использовать суперчип в своём суперкомпьютере следующего поколения. Техасский центр передовых вычислений при Техасском университете в Остине (США) оборудует суперчипами НРС-систему Vista. Национальный центр суперкомпьютерных приложений при Университете Иллинойса в Урбане-Шампейне будет использовать решения GH200 в составе ИИ-платформы DeltaAI. А Британия получит ИИ-суперкомпьютер Isambard-AI на основе этого суперчипа, который разместится в Бристольском университете. Все эти системы присоединяются к ранее анонсированным платформам на базе GH200 от Швейцарского национального суперкомпьютерного центра (CSCS) и SoftBank Corp. GH200 уже доступен у некоторых поставщиков облачных услуг, таких как Lambda и Vultr. CoreWeave объявила о планах открыть инстансы GH200 в I квартале 2024 года. Другие производители систем, такие как ASRock Rack, ASUS, Gigabyte и Ingrasys, начнут поставки серверов с этими суперчипами к концу года.

13.11.2023 [17:42], Владимир Мироненко

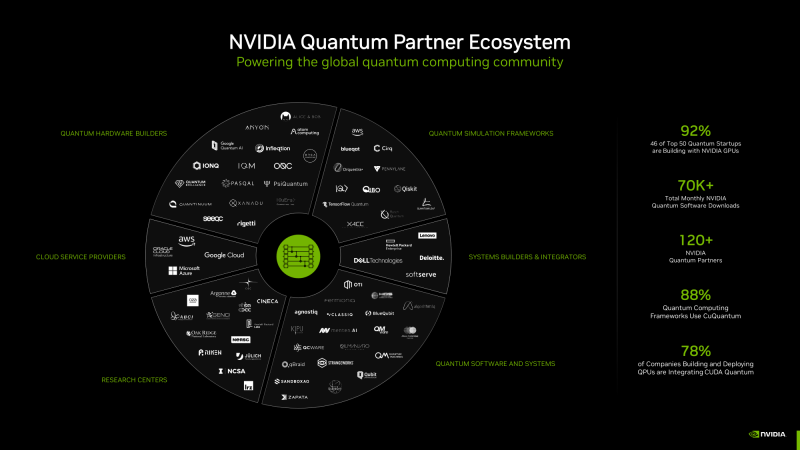

NVIDIA CUDA Quantum позволяет выполнять моделирование процессов, невозможное на обычных компьютерных системахКрупнейшая в мире химическая компания BASF продемонстрировала, как квантовый алгоритм позволяет сделать то, чего не может традиционное моделирование — проверить ключевые свойства перспективного химического соединения FeNTA, с помощью которого можно удалять из городских сточных вод токсичные металлы, такие как железо. Команда BASF смоделировала с помощью ускорителей NVIDIA 24-кубитный квантовый компьютер и продемонстрировала, как он может справиться с новыми задачами. Исследователи BASF полагаются в работе на облако NVIDIA DGX Cloud с ускорителями NVIDIA H100. Вдобавок они уже протестировали первые 60-кубитные симуляции на суперкомпьютере NVIDIA EOS. «Это самая масштабная симуляция квантового алгоритма, которую мы когда-либо запускали», — отметил Майкл Кун (Michael Kuehn) из BASF.

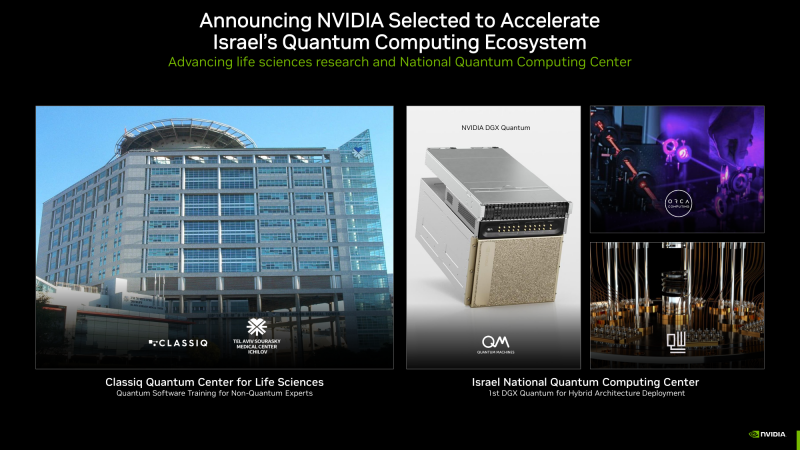

Изображения: NVIDIA BASF выполняет моделирование посредством NVIDIA CUDA Quantum, открытой платформы для интеграции и программирования CPU, ускорителей вычислений (GPU) и квантовых компьютеров (QPU). Разработчик Давид Водола (Davide Vodola) охарактеризовал платформу как «очень гибкую и удобную в использовании, позволяющую создавать сложную симуляцию квантовой схемы из относительно простых строительных блоков <…> Без CUDA Quantum было бы невозможно запустить это моделирование», — сказал он. В дополнение к работе в области химии команда BASF разрабатывает варианты использования квантовых вычислений в машинном обучении, а также для оптимизации логистики и планирования. Другие компании тоже используют CUDA Quantum в научных исследованиях. Например, в SUNY Stony Brook исследователи используют платформу в области физики высоких энергий для моделирования сложных взаимодействий субатомных частиц. «CUDA Quantum позволяет нам проводить квантовое моделирование, которое в противном случае было бы невозможно», — сказал Дмитрий Харзеев, профессор SUNY и научный сотрудник Брукхейвенской национальной лаборатории. В свою очередь, Hewlett Packard Labs применяет суперкомпьютер Perlmutter для крупнейших симуляций в области квантовой химии, которую обычными инструментами реализовать очень сложно. «По мере прогресса в практическом применении квантовых компьютеров классическое HPC-моделирование станет ключевым для создания прототипов новых квантовых алгоритмов, — говорит Кирк Брезникер (Kirk Bresniker), главный архитектор Hewlett Packard Labs. — Моделирование и обучение на основе квантовых данных являются перспективными путями использования потенциала квантовых вычислений». Израильский стартап Classiq, чей новый подход к написанию квантовых программ использует более 400 университетов, объявил о создании вместе с NVIDIA исследовательского центра в Тель-Авивском медицинском центре Сураски. Здесь будут обучать экспертов в области естественных наук написанию квантовых программ, которые помогут в диагностике заболеваний и создании новых лекарств. Classiq создал ПО для проектирования, которое автоматизирует низкоуровневые задачи, позволяя разработчикам не вникать в детали функционирования квантового компьютера. Сейчас его софт интегрируют с CUDA Quantum. Швейцарская Terra Quantum разрабатывает гибридные квантовые приложения для науки о жизни, энергетики и финансов, которые будут работать на CUDA Quantum. Поддержку платформы своим QPU обеспечила и компания IQM из Финляндии. Также известно, что несколько компаний, включая Oxford Quantum Circuits, будут использовать суперчипы NVIDIA Grace Hopper для обеспечения своих гибридных квантовых разработок. Компания Quantum Machines объявила, что Израильский национальный квантовый центр в Тель-Авиве станет первым местом развёртывания NVIDIA DGX Quantum на базе Grace Hopper. Центр будет использовать DGX Quantum в работе квантовых компьютеров от Quantware, ORCA Computing и других компаний. Кроме того, qBraid из Чикаго (США) применяет Grace Hopper в работе над созданием квантового облачного сервиса, а Fermioniq из Амстердама (Нидерланды) — в разработке новых алгоритмов.

13.11.2023 [17:00], Игорь Осколков

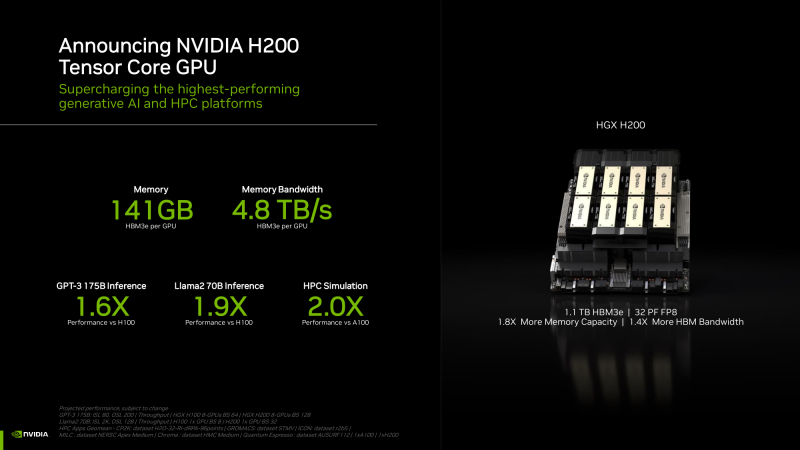

NVIDIA анонсировала ускорители H200 и «фантастическую четвёрку» Quad GH200NVIDIA анонсировала ускорители H200 на базе всё той же архитектуры Hopper, что и их предшественники H100, представленные более полутора лет назад. Новый H200, по словам компании, первый в мире ускоритель, использующий память HBM3e. Вытеснит ли он H100 или останется промежуточным звеном эволюции решений NVIDIA, покажет время — H200 станет доступен во II квартале следующего года, но также в 2024-м должно появиться новое поколение ускорителей B100, которые будут производительнее H100 и H200.

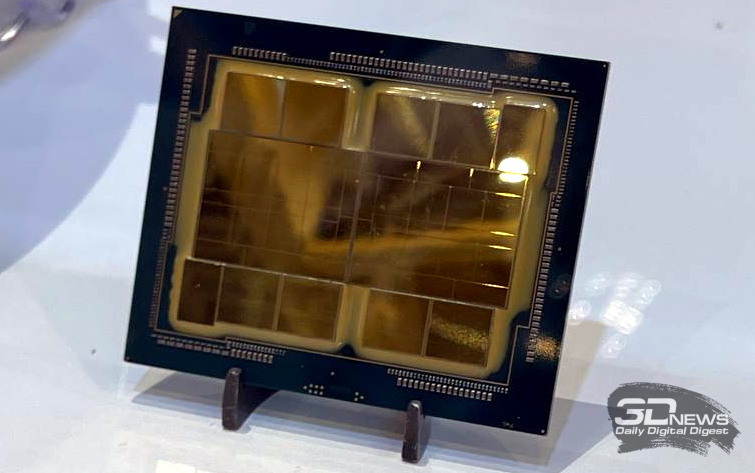

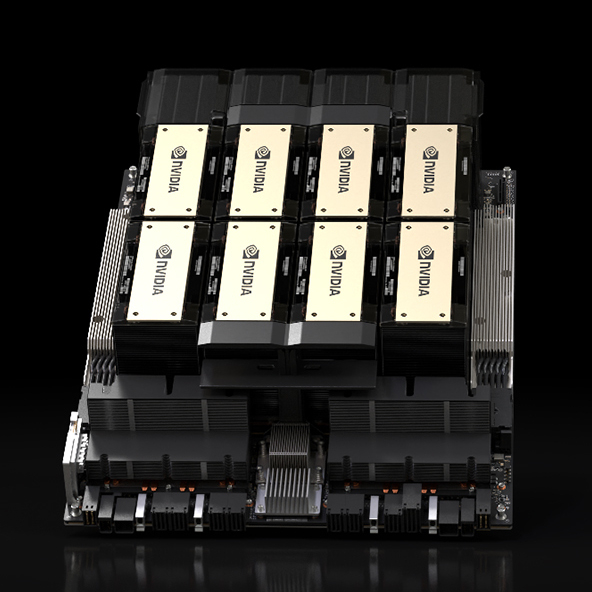

HGX H200 (Источник здесь и далее: NVIDIA) H200 получил 141 Гбайт памяти HBM3e с суммарной пропускной способностью 4,8 Тбайт/с. У H100 было 80 Гбайт HBM3, а ПСП составляла 3,35 Тбайт/с. Гибридные ускорители GH200, в состав которых входит H200, получат до 480 Гбайт LPDDR5x (512 Гбайт/с) и 144 Гбайт HBM3e (4,9 Тбайт/с). Впрочем, с GH200 есть некоторая неразбериха, поскольку в одном месте NVIDIA говорит о 141 Гбайт, а в другом — о 144 Гбайт HBM3e. Обновлённая версия GH200 станет массово доступна после выхода H200, а пока что NVIDIA будет поставлять оригинальный 96-Гбайт вариант с HBM3. Напомним, что грядущие конкурирующие AMD Instinct MI300X получат 192 Гбайт памяти HBM3 с ПСП 5,2 Тбайт/с. На момент написания материала NVIDIA не раскрыла полные характеристики H200, но судя по всему, вычислительная часть H200 осталась такой же или почти такой же, как у H100. NVIDIA приводит FP8-производительность HGX-платформы с восемью ускорителями (есть и вариант с четырьмя), которая составляет 32 Пфлопс. То есть на каждый H200 приходится 4 Пфлопс, ровно столько же выдавал и H100. Тем не менее, польза от более быстрой и ёмкой памяти есть — в задачах инференса можно получить прирост в 1,6–1,9 раза. При этом платы HGX H200 полностью совместимы с уже имеющимися на рынке платформами HGX H100 как механически, так и с точки зрения питания и теплоотвода. Это позволит очень быстро обновить предложения партнёрам компании: ASRock Rack, ASUS, Dell, Eviden, GIGABYTE, HPE, Lenovo, QCT, Supermicro, Wistron и Wiwynn. H200 также станут доступны в облаках. Первыми их получат AWS, Google Cloud Platform, Oracle Cloud, CoreWeave, Lambda и Vultr. Примечательно, что в списке нет Microsoft Azure, которая, похоже, уже страдает от недостатка H100. GH200 уже доступны избранным в облаках Lamba Labs и Vultr, а в начале 2024 года они появятся у CoreWeave. До конца этого года поставки серверов с GH200 начнут ASRock Rack, ASUS, GIGABYTE и Ingrasys. В скором времени эти чипы также появятся в сервисе NVIDIA Launchpad, а вот про доступность там H200 компания пока ничего не говорит. Одновременно NVIDIA представила и базовый «строительный блок» для суперкомпьютеров ближайшего будущего — плату Quad GH200 с четырьмя чипами GH200, где все ускорители связаны друг с другом посредством NVLink по схеме каждый-с-каждым. Суммарно плата несёт более 2 Тбайт памяти, 288 Arm-ядер и имеет FP8-производительность 16 Пфлопс. На базе Quad GH200 созданы узлы HPE Cray EX254n и Eviden Bull Sequana XH3000. До конца 2024 года суммарная ИИ-производительность систем с GH200, по оценкам NVIDIA, достигнет 200 Эфлопс. |

|