Материалы по тегу: схд

|

10.10.2025 [01:23], Владимир Мироненко

Ложная надежда: Synology смягчила требования к использованию сторонних HDD/SSD, но профессиональных систем это не коснулосьSynology объявила о выпуске системы DiskStation Manager (DSM) 7.3, которая, как указано в пресс-релизе, обеспечивает повышенную эффективность хранения, усиленную безопасность и надёжность, а также получила новые функции для повышения производительности. Вместе с тем компания под давлением пользователей ослабила политику ограничения использования сторонних накопителей в своих NAS. Однако поблажки сделаны только для SOHO-пользователей. Как отметил ресурс NAScompares.com, с выпуском DSM 7.3 компания официально представила самый подробный на сегодняшний день пакет политик совместимости с указанием, какие жёсткие диски и твердотельные накопители поддерживаются в её экосистеме. Ограничения DSM 7.2 на использование накопителей сторонних брендов, сделавшее жёсткие диски Seagate, Toshiba и WD, практически непригодными для использования в новых моделях серии DiskStation Plus вызвало серьёзную негативную реакцию со стороны пользователей, которые полагались на гибкий выбор дисков. Представленный в DSM 7.3 фреймворк HCL 5.0 частично смягчает введенные ранее ограничения для DiskStation Plus и серии J 2025 модельного года, возвращая возможность использования неперечисленных в списке совместимых HDD и SSD с интерфейсом SATA для создания пулов. Synology описала это как прагматичную эволюцию своей политики, которая соответствует ожиданиям клиентов. Компания продолжит сотрудничать с основными производителями накопителей для проверки дополнительных моделей. С точки зрения Synology есть три типа накопителей:

Источник изображения: Synology DSM 7.3 теперь отображает более понятные уведомления в диспетчере хранения, различая совместимые, несовместимые и прочие диски, что позволяет оценить влияние выбора оборудования на работу системы до создания томов и кешей. Кроме того, Synology пояснила, что для прохождения сертификации и попадания в список совместимых накопители должны пройти тесты на термические нагрузки, устойчивость к циклам вкл./выкл. и аварийное выключение. В DSM 7.3 Synology пересмотрела подход своих NAS к работе с SATA-дисками, которых нет в списке совместимых и нет в списке несовместимых. Для моделей DS+ Plus 2025 года, включая DS1525+, DS925+ и DS725+, эти диски теперь считаются полностью функциональными и в работе ничем не отличаются от официально совместимых накопителей, поддерживая установку, создание/расширение пулов/томов, работу со снимками и шифрование, использование HyperBackup и т.д., а DSM больше не «ругается» на них. DSM 7.2 блокировала создание пула, если установленный диск не входил в список совместимых. С M.2 NVMe SSD ситуация особая. Для создания новых кешей или пулов хранения требуются только накопители из списка совместимых, поскольку такие диски подвергаются более высоким постоянным нагрузкам записи и выделяют больше тепла при непрерывной работе NAS. Ранее сконфигурированные NVMe SSD по-прежнему можно использовать только при миграции со старых NAS на новые. Гарантия предоставляется в полном объёме, но техподдержка Synology может отказать в помощи с проблемами, которые, как доказано, вызваны оборудованием, не входящим в список совместимых. В то же время корпоративные серии СХД Synology FS, HD, SA, UC, XS+, XS, RS+, RS и DP продолжают работать в соответствии с более строгими правилами, согласно которым для полноценной работы требуются только диски SAS/SATA/NVMe из списка совместимых. SATA-накопители, не входящие в список совместимых, можно использовать только для миграции. Кеширующие накопители вне списка совместимых также запрещены к использованию. Synology объясняет это тем, что для корпоративных нагрузок требуются надёжные накопители с устойчивостью к различным сбоям, в том числе в многоузловых конфигурациях, способностью к корректному восстановлению после сбоев и с заданным уровнем производительности. Похожие аргументы приводятся и в пользу допустимости использования в СХД DVR/NVR SATA-накопителей вне списка совместимых только для миграции данных со старых систем. Совместимые накопители также должны пройти отдельные тесты на возможность непрерывной записи с малым временем отклика. Проблема в том, что Synology не спешит сертифицировать сторонние накопители. Так, Seagate IronWolf/SkyHawk и WD Purple в списках толком нет. Параллельно Synology подталкивает к использованию фирменных накопителей HAT/HAS/SAT. При покупке NAS/СХД вместе с ними можно получить расширенную гарантию сроком до пяти лет. Также Synology запустила программу экспресс-замены, позволяющую производить немедленную замену дисков в течение гарантийного срока, не дожидаясь отправки и проверки неисправного устройства.

26.09.2025 [09:53], Сергей Карасёв

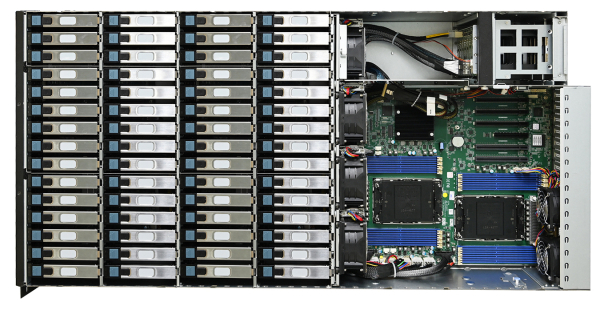

Сервер хранения AIC SB407-VA допускает установку 60 накопителей LFF SATA/SASКомпания AIC представила сервер хранения данных SB407-VA, выполненный в форм-факторе 4U на аппаратной платформе Intel. Новинка допускает установку в общей сложности 70 накопителей разных типов, что позволяет сформировать массив большой ёмкости для таких задач, как аналитика данных, периферийные ИИ-приложения и пр. Сервер может комплектоваться двумя процессорами Xeon Sapphire Rapids или Emerald Rapids. Доступны 16 слотов для модулей DDR5-5600/4800 суммарным объёмом до 4 Тбайт (3DS RDIMM). Предусмотрены четыре слота расширения PCIe x16 и один разъём PCIe x8: во всех случаях могут монтироваться карты формата FHHL. Предусмотрены посадочные места для 60 накопителей LFF с интерфейсом SATA/SAS и возможностью горячей замены. Кроме того, могут быть установлены восемь SFF-устройств в конфигурации 6 × NMVe (PCIe 4.0) и 2 × SATA с поддержкой горячей замены. Плюс к этому есть два коннектора M.2 M Key 2280 для SSD с интерфейсом PCIe 4.0. Модель AIC SB407-VA наделена контроллером Aspeed AST2600. Реализованы два сетевых порта 1GbE на базе Broadcom BCM5720 и выделенный сетевой порт управления 1GbE на основе Realtek RTL8211FS. Во фронтальной части расположен один порт USB3.0 Type-A, в тыльной — три гнезда RJ45 для сетевых кабелей, два разъёма USB 3.1 Gen1 Type-A и коннектор D-Sub. Габариты составляют 434 × 853 × 176 мм. Питание обеспечивают четыре блока мощностью 800 Вт с сертификатом 80 Plus Platinum/Titanium. Задействовано воздушное охлаждение, а диапазон рабочих температур простирается от 0 до +35 °C.

29.08.2025 [23:15], Владимир Мироненко

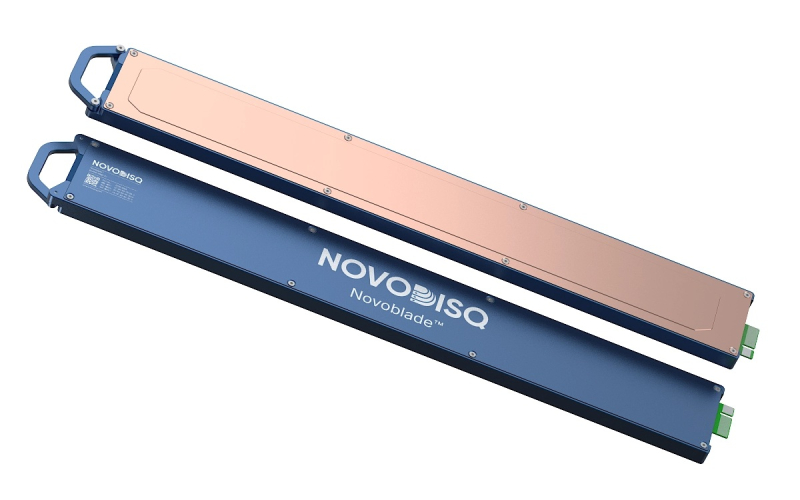

11,5 Пбайт в 2U: Novodisq представил блейд-сервер для ИИ и больших данныхСтартап Novodisq представил блейд-сервер формата 2U ёмкостью 11,5 Пбайт с функцией ускорения ИИ и др. задач. Гиперконвергентная кластерная система разработан для замены или дополнения традиционных решений NAS, SAN и публичных облачных сервисов. Новинка поддерживает платформы Ceph, MinIO и Nextcloud (также планируется поддержка DAOS), предлагая доступ по NFS, iSCSI, NVMe-oF и S3. Сервер содержит до 20 модулей Novoblade с фронтальной загрузкой. В каждом из них имеется до четырёх встроенных E2 SSD Novoblade объёмом 144 Тбайт каждый, на базе TLC NAND с шиной PCIe 4.0 x4. Накопители поддерживают NVMe v2.1 и ZNS, обеспечивая последовательную производительность чтения/записи до 1000 Мбайт/с, а на случайных операциях — до 70/30 тыс. IOPS. Надёжность накопителей составляет до 24 PBW. Энергопотребление: от 5 до 10 Вт. Система Novoblade предназначена для «тёплого» и «холодного» хранения данных. Модули Novoblade объединяют вычислительные возможности, ускорители и хранилища. Основной модулей являются гибридные SoC AMD Versal AI Edge Gen 2 (для ИИ-нагрузок) или Versal Prime Gen 2 (для традиционных вычислений) c FPGA, 96 Гбайт DDR5, 32 Гбайт eMMC, модулем TPM2 и двумя интерфейсам 10/25GbE с RoCE v2 RDMA и TSN. Энергопотребление не превышает 60 Вт. Есть функции шифрования накопителей, декодирования видео, ускорения ИИ-обработки, оркестрации контейнеров и т.д. Платформа специально разработана для задач с большими объёмами данных, таких как геномика, геопространственная визуализация, видеоархивация и периферийные ИИ-вычисления. Сервер может работать под управлением стандартных дистрибутивов Linux (RHEL и Ubuntu LTS) с поддержкой Docker, Podman, QEMU/KVM, Portainer и OpenShift. 2U-шасси глубиной 1000 мм рассчитано на установку до двадцати модулей Novodisq и оснащено двумя (1+1) БП мощностью 2600 Вт каждый (48 В DC). Возможно горизонтальное масштабирование с использованием каналов 100–400GbE. В базовой конфигурации шасси включает четыре 200GbE-модуля с возможностью горячей замены, каждый из которых имеет SFP28-корзины, а также управляемый L2-коммутатор. Предусмотрен набор средств управления, включая BMC с веб-интерфейсом, CLI и поддержкой API Ansible, SNMP и Redfish. Novoblade поддерживает локальное и удалённое управление, может интегрироваться в существующий стек или предоставляться с помощью инструментов «инфраструктура как код» (Infrastructure-as-Code). По словам разработчика, система Novoblade обеспечивает плотность размещения примерно в 10 раз выше, чем у сервера на основе жестких дисков, и снижает энергопотребление на 90–95 % без необходимости в механическом охлаждении. Novodisq утверждает, что общая стоимость владения системой «обычно на 70–90 % ниже, чем у традиционных облачных или корпоративных решений в течение 5–10 лет». «Это обусловлено несколькими факторами: уменьшенным пространством в стойке, низким энергопотреблением, отсутствием платы за передачу данных, минимальным охлаждением, длительным сроком службы и значительным упрощением управления. В отличие от облака, ваши расходы в основном фиксированы, а значит, предсказуемы, и, в отличие от традиционных систем, Novodisq не требует дорогостоящих лицензий, внешних контроллеров или постоянных циклов обновления. Вы получаете высокую производительность, долгосрочную надёжность и более высокую экономичность с первого дня», — приводит Blocks & Files сообщение компании. Для сравнения, узлы Dell PowerScale F710 и F910 на базе 144-Тбайт Solidigm SSD ёмкостью 122 Тбайт, 24 отсеками в 2U-шасси и коэффициентом сжатия данных 2:1 обеспечивают почти 6 Пбайт эффективной емкости, что почти вдвое меньше, чем у сервера Novoblade.

05.08.2025 [11:28], Владимир Мироненко

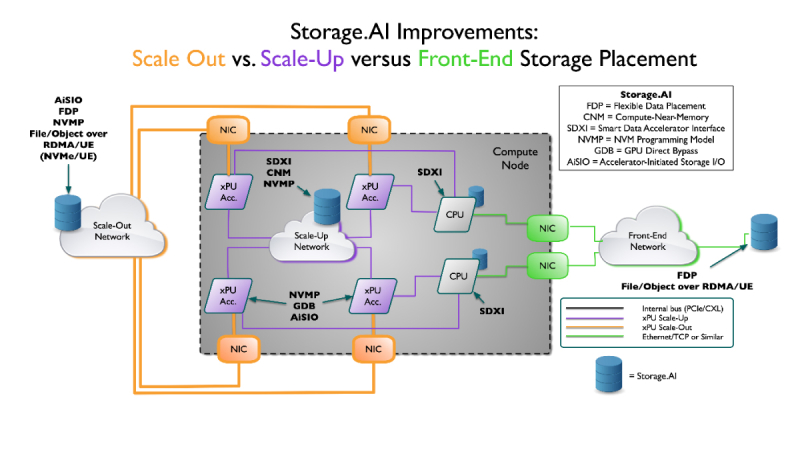

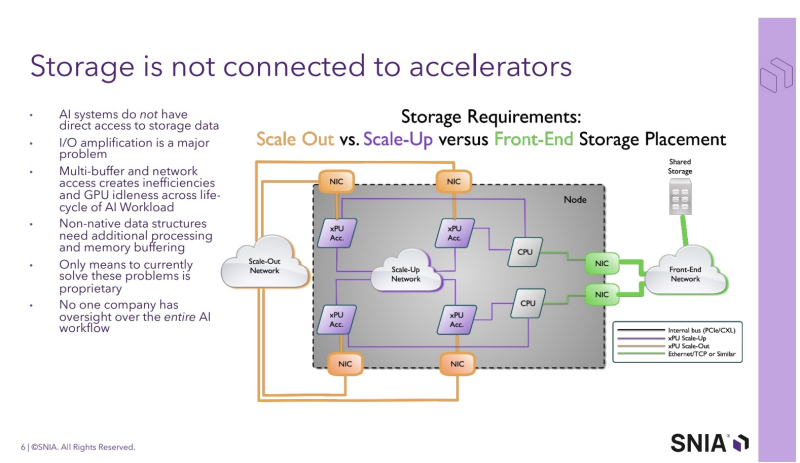

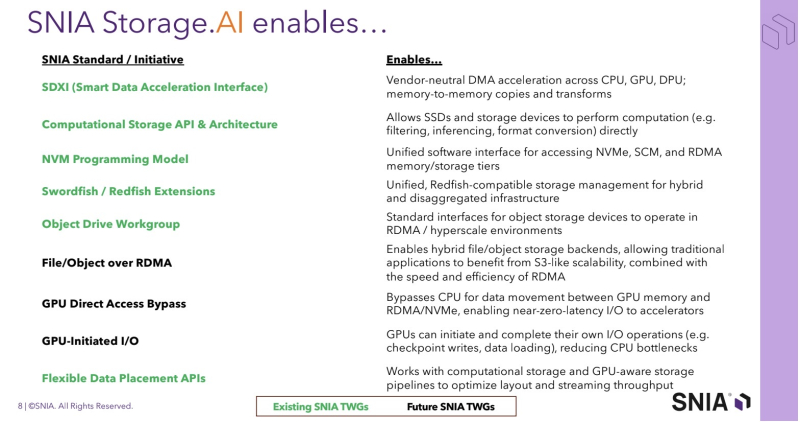

SNIA анонсировала проект Storage.AI для стандартизации обработки ИИ-нагрузокStorage Networking Industry Association (SNIA) — некоммерческая организация, специализирующаяся на технологиях обработки и оптимизации данных — анонсировала проект Storage.AI, основанный на открытых стандартах для эффективных сервисов обработки данных, связанных с рабочими ИИ-нагрузками. Проект будет сфокусирован на стандартных для отрасли, непатентованных и нейтральных подходах к решению задач, связанных с обработкой данных для ИИ, с целью оптимизации производительности, энергоэффективности и экономичности соответствующих рабочих процессов. К инициативе уже присоединились AMD, Cisco, DDN, Dell, IBM, Intel, KIOXIA, Microchip, Micron, NetApp, Pure Storage, Samsung, Seagate, Solidigm и WEKA. Отдельно отмечается отсутствие NVIDIA — крупнейшего поставщика ИИ-ускорителей. Как указано в пресс-релизе, рабочие ИИ-нагрузки чрезвычайно сложны и ограничены такими факторами, как задержки, доступное пространство, энергопотребление и охлаждение, объём памяти и стоимость. Решение этих проблем в рамках открытой отраслевой инициативы рассматривается как наиболее быстрый путь к оптимизации и широкому внедрению ИИ. По словам Дж. Метца (J Metz), председателя SNIA, беспрецедентные требования со стороны ИИ требуют целостного взгляда на весь конвейер данных — от храненилищ и памяти до сетевых технологий и вычислений. Он подчеркнул, что Storage.AI предоставляет отраслевому сообществу независимую от вендоров платформу, предназначенную для координации широкого спектра сервисов обработки данных и создания эффективных, открытых решений, необходимых для ускоренного внедрения ИИ-технологий. Инициатива координирует ряд технических спецификаций, которые до сих пор существовали обособленно и не были адаптированы под нужды ИИ-нагрузок. Первоначальный набор спецификаций включает:

Предполагается, что в рамках проекта Storage.AI будет создана открытая экосистема эффективных сервисов обработки данных, способных справляться с наиболее сложными задачами, связанными с ИИ-нагрузками, и устранять текущие пробелы в обработке и доступе к данным. В обеспечении широкой поддержки экосистемы также примут участие партнёры SNIA, включая UEC, NVM Express, OCP, OFA, DMTF и SPEC.

23.07.2025 [09:37], Владимир Мироненко

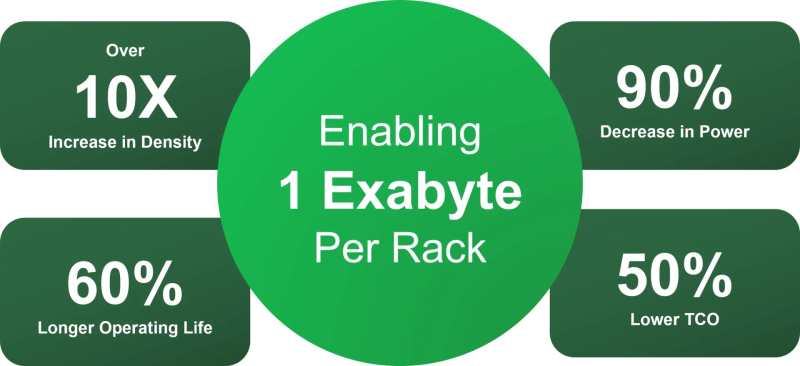

SSD не нужны: OFP обещает на порядок повысить плотность All-Flash СХД и наполовину снизить расходы на инфраструктуруИнициатива Open Flash Platform (OFP) призвана полностью пересмотреть работу с флеш-памятью в ИИ ЦОД. Участники OFP — Hammerspace, Linux Foundation, Лос-Аламосская национальная лаборатория (LANL), ScaleFlux, SK hynix и Xsight Systems — намерены отказаться от традиционных All-Flash хранилищ и контроллеров. Вместо них предложено использовать флеш-картриджи с минимумом аппаратной начинки, а доступ к таким массивам предоставлять посредством DPU и pNFS. Как отмечено в пресс-релизе, OFP отвечает многим фундаментальным требованиям, возникающим в связи со следующим этапом развития СХД для ИИ. Для ИИ требуются поистине огромные массивы данных, но вместе с тем ЦОД сталкиваются с дефицитом энергии, повышением температуры и недостатком свободного места. Именно поэтому в OFP решили, что инфраструктуры хранения для ИИ лучше разработать с чистого листа. Если 10 лет назад технология NVMe вывела флеш-память на новый уровень производительности благодаря отказу от устаревших шин данных и контроллеров, то теперь OFP обещает раскрыть возможности флеш-памяти, исключив посредников в виде серверов хранения и проприетарных программных стеков. OFP же опирается на открытые стандарты и open source решения, в частности, Parallel NFS (pNFS) и стандартный Linux, для размещения флеш-памяти непосредственно в SAN. А отказ от традиционных СХД обеспечит на порядок большую плотность размещения данных, существенную экономию энергии и значительно более низкую совокупную стоимость владения. OFP отметила, что существующие решения изначально привязаны к модели сервера хранения, которая требует чрезмерных ресурсов для повышения производительности и возможностей. Конструкции всех современных поставщиков AFA не оптимизированы для достижения максимальной плотности размещения флеш-памяти и привязаны к сроку службы CPU (обычно пять лет), тогда как срок службы флеш-памяти в среднем составляет восемь лет. Эти серверы хранения также предлагают проприетарные структуры и уровни хранения данных, что приводит к увеличению количества копий данных и добавлению расходов на лицензирование для каждого узла. Комментируя инициативу, ресурс Blocks & Files отметил, что Pure Storage и другие поставщики AFA уже предлагают оптимизированные схемы лицензирования и подписки, в том числе с обновлением контроллеров и дисковых полок. Та же Pure Storage предлагает более высокую плотность хранения, чем многие другие поставщики, хотя и использует проприетарные решения. Поддержкой DPU тоже удивить нельзя. Например, VAST Data уже поддерживает работу своего ПО на NVIDIA BlueField-3. А большинство поставщиков флеш-массивов и так поддерживают RDMA и GPUDirect. OFP выступает за открытый, основанный на стандартах подход, включающий несколько основных элементов:

Благодаря использованию открытых архитектур и компонентов, соответствующих отраслевым стандартам, реализация OFP приведёт к значительному повышению эффективности хранения данных, утверждают основатели инициативы. Так, обещано десятикратное увеличение плотности размещения данных, что позволит «упаковать» в одну стойку 1 Эбайт, попутно снизив энергопотребление на 90 %, увеличив срок службы флеш-памяти на 60 % и уменьшив совокупную стоимость владения (TCO) на 60 % по сравнению со стандартными массивами хранения. По мнению Blocks & Files, в текущем виде OFP выглядит скорее как маркетинговая инициатива, от которой в первую очеред выиграют её участники. Концепция же «сетевых» SSD сама по себе не нова. Весной Kioxia показала SSD с «оптикой». Да, тут речь идёт скорее о блочном доступе и NVMe-oF, но, например, Nimbus Data в прошлом году представила ExaDrive EN с поддержкой NFS.

22.07.2025 [19:19], Руслан Авдеев

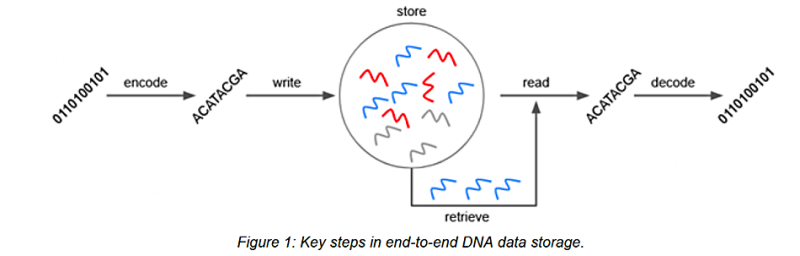

Компактно, но дорого и медленно: ДНК-накопителям до коммерциализации пока ещё далекоDNA Data Storage Alliance, сообщество при ассоциации SNIA (Storage Networking Industry Association), подготовило обзор технологии хранения данных на основе синтетических ДНК. В числе прочего, рассматриваются технологии кодирования/декодирования информации, метрики готовности к коммерческому использованию и основные вызовы, сообщает Blocks & Files. Данные в ДНК кодируются с помощью четырёх нуклеотидов: аденина (A), гуанина (G), цитозина (C) и тимина (T). Они формируют спираль биополимерной молекулы. Данные в этом случае могут храниться в очень небольшом объёме и веками. Хранение данных в ДНК уже неоднократно опробовано экспериментально, но невысокая скорость записи и чтения, а также размеры оборудования для этого, его большая сложность и высокая стоимость пока не позволяют даже мечтать о коммерчески успешном продукте.

Источник изображения: SNIA В обзорном документе выделены пять ключевых вызовов:

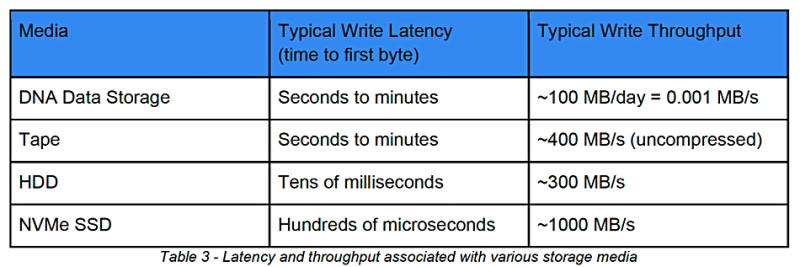

Авторы доклада подчёркивают, что скорость передачи данных в традиционных накопителях заметно выше и значительно превышает возможности биотехнологических методов чтения и записи ДНК. Увеличение скорости — одна из фундаментальных задач. Поскольку речь идёт о медленных химических реакциях, достигнуть роста скорости можно было бы масштабированием параллельных операций записи/чтения. Кроме того, нужно уменьшать совокупную стоимость владения. Документ заключает, что технология хранения данных в ДНК находится на ранней стадии развития и пока далека от коммерциализации, но базовые процессы записи/чтения, а также хранения информации уже доказали работоспособность и возможность масштабирования платформ. Более того, непрекращающиеся инвестиции в технологии работы с ДНК помогут дальнейшим инновациям.

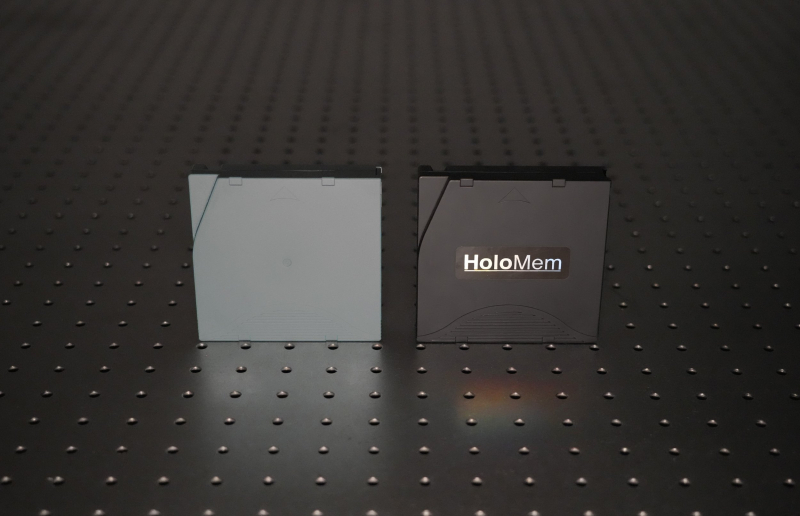

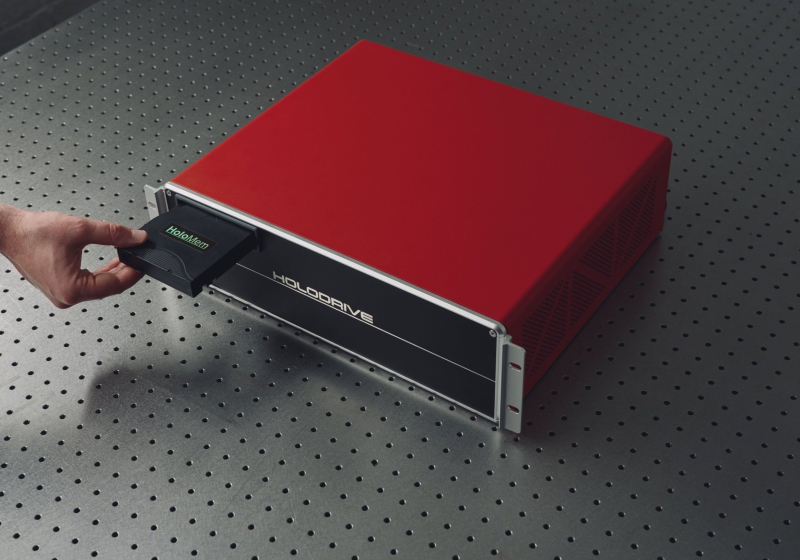

Источник изображения: SNIA Ожидается, что ДНК-хранилища дополнят, а не заменят существующие технологии архивирования, позволяя создавать относительно недорогие долгосрочные хранилища зеттабайтного уровня. Предполагается, что сценарии прикладного использования технологии появятся в ближайшие три-пять лет. По оценкам Blocks & Files, ключевыми игроками станут Biomemory, Catalog и Atlas Data Storage. Есть и другие перспективные альтернативы. Так, HoloMem предложила недорогую и эффективную замену LTO и другим системам — 200-Тбайт картриджи HoloDrive, которые прослужат не менее 50 лет.

14.07.2025 [18:03], Владимир Мироненко

200 Тбайт ёмкости и 50 лет сохранности: HoloMem предложила недорогую и эффективную замену LTO — картриджи HoloDriveБританский стартап HoloMem разработал технологию голографического долгосрочного холодного хранения данных HoloDrive, способную вытеснить традиционные ленточные накопители благодаря преимуществу по целому ряду показателей. Основатель компании Чарли Гейл (Charlie Gale) в интервью ресурсу Blocks & Files сообщил, что технология HoloMem использует недорогие готовые компоненты — лазерный диод стоимостью $5 и серийно выпускаемые полимерные листы — что позволяет создать надёжные и доступные накопители и шасси без дорогостоящих высокотехнологичных элементов. В отличие от решений компаний Cerabyte и Microsoft Project Silica, в HoloDrive используется лента с оптическим считыванием для устойчивого хранения данных на протяжении более 50 лет, а не более хрупкие керамические или стеклянные пластины или диски. Проприетарные ленты также используют Piql и Archiflix, но они применяют традиционную схему записи изображения. HoloDrive использует полимерную ленту с многослойной голографической записью изображений (разновидность QR-кодов).

Источник изображений: HoloMem Лента изготавливается из серийно выпускаемого светочувствительного полимера, разработанного для автомобильной промышленности для использования в лобовых стёклах и проекционных дисплеях. Полимер толщиной 16 мк помещается между двумя слоями ПЭТ, так что итоговая толщина ленты составляет 120 мк. Также лента отличается высокой прочностью с возможностью эксплуатации при температуре от –40 до +160 C°. Кроме того, она невосприимчива к электромагнитным импульсам, что позволит использовать её для архивных хранилищ, связанных с обороной. Длина ленты внутри картриджа составляет примерно 100 м, она вмещает до 200 Тбайт данных, рассчитана на WORM-нагрузки и рассчитана на работу в течение полувека без ухудшения сохранности данных. Для сравнения, длина ленты LTO-10 составляет 1000 м, ёмкость — до 75 Тбайт (со сжатием). Срок службы LTO составляет 15–30 лет при соблюдении строго контролируемых условий, причём лента подвержена деградации данных со временем, что отражается на читаемости в худшую сторону. Картридж HoloDrive очень похож на обычный LTO-картридж. Строго говоря, прототипы и являются LTO-картриджами, в которых заменена лента. Таким образом, накопители совместимы с существующими роботизированными LTO-библиотеками, не нужно даже изменений в ПО. Также для нового решения нет необходимости в климат-контроле, и оно обеспечивает сохранение читаемости без деградации на протяжении всего срока службы. Как сообщил Гейл ресурсу tech.eu, HoloDrive обеспечивает высокоскоростное хранение высокой плотности, снижающее энергопотребление на 90 % и годовые затраты примерно на 99 %. «Чем это устройство не может похвастаться, так это высочайшей плотностью данных. Мы намеренно снизили параметры системы, чтобы сделать её надёжной и устойчивой», — говорит Гейл. Скорость чтения нового решения примерно такая же, как у LTO-9. Как сообщил Blocks & Files, HoloMem не имеет венчурного финансирования. В марте 2023 года компания получила грант в размере £350 тыс. ($472 тыс.) от Национального агентства по исследованиям и инновациям Великобритании (UK Research and Innovation, UKRI). В июне организация Innovate UK выделила HoloMem грант в размере £550 тыс. ($742 тыс.) на проект HoloDrive, реализуемый в партнёрстве с консалтинговой компанией TechRe. «Наше решение HoloDrive разработано для интеграции с устаревшими системами с минимальными нарушениями работы оборудования и ПО, и этот грант от Innovate UK поможет нам завершить разработку и полностью проверить эту революционную технологию», — заявил Гейл. TechRe развернёт прототипы HoloDrive в LTO-библиотеках своих британских ЦОД для тестирования производительности, надёжности и отказоустойчивости продукта. Также HoloMem сотрудничает с Qstar, что предполагает интеграцию её накопителей с продуктами QStar Archive Manager (для одного сервера) и Global ArchiveSpace (для нескольких серверов). Это позволит потенциальным клиентам Qstar тестировать ранние версии продукта в своих средах. В мае этого года HoloMem присоединилась к британской Коалиции по сохранению цифровых данных (Digital Preservation Coalition, DPC).

08.07.2025 [18:49], Руслан Авдеев

Британская полиция выделит £75 млн на оцифровку своих архивов VHS-видеокассетПолиция Великобритании намерена закупить технологии и услуги для оцифровки своего архива видеокассет VHS. На эти цели планируется потратить £75 млн ($102 млн), сообщает The Register. Полиции нужны или собственные технологии для оцифровки VHS-контента, или возможность отдать соответствующие задачи на аутсорсинг. Органы правопорядка хотят не только преобразовать в «цифру» записи с аналоговых носителей, но и, что немаловажно, перенести метаданные в цифровую систему управления уликами. Формат VHS появился в 1970-х годах и стал очень популярным по всему миру не только у коммерческих и домашних пользователей, но и у полицейских разных стран, например, для проведения оперативной съёмки. В 1990-х годах на смену видеокассетам пришли DVD, но переносить видео с VHS на новые носители спешили не все. Первый лот тендера НКО BlueLight Commercial, которая отвечает за закупки для экстренных служб, предусматривает приобретение ПО для оцифровки видео с VHS-носителей, закупку оборудования и обучение сотрудников полиции процессу конвертации аналогового видео в цифровые файлы. На это готовы выделить до £50 млн ($68 млн) в течение четырёх лет (без учёта НДС). Второй лот предусматривает передачу VHS-носителей третьим лицам для конвертации видео в «цифру» с передачей полученных файлов безопасным способом. Этот контракт оценивается в сумму до £25 млн ($34 млн) за аналогичный период. Ещё столько же готовы выделить на преобразование в файлы данных с микрофильмов, CD, DVD и других медиа. BlueLight Commercial была основана в 2020 году Министерством внутренних дел Великобритании для совместной работы с экстренными службами и является национальной структурой. Она финансируется государством и работает на некоммерческой основе. Госсектор Великобритании часто не торопится отказываться от технологий докомпьютерной эпохи. Например, только в 2020 году Национальная служба здравоохранения решила заменить пейджеры в больницах.

07.07.2025 [14:05], Сергей Карасёв

Суперкомпьютер Doudna получит смешанное All-Flash хранилище IBM и VAST DataНациональная лаборатория им. Лоуренса в Беркли (Berkeley Lab), принадлежащая Министерству энергетики США (DOE), сообщила о том, что суперкомпьютер Doudna получит передовую подсистему хранения данных на основе технологий IBM и VAST Data. Эта платформа сможет с высокой эффективностью справляться с интенсивными нагрузками, связанными с обучением ИИ-моделей и инференсом. НРС-комплекс Doudna (NERSC-10) расположится в Национальном вычислительном центре энергетических исследований США (NERSC) в составе Berkeley Lab. Основой суперкомпьютера послужат системы Dell Integrated Rack Scalable Systems и серверы PowerEdge с ускорителями NVIDIA Vera Rubin. По предварительным данным, машина обеспечит FP64-быстродействие до 790 Пфлопс при потреблении 5,8–8,7 МВт. С целью достижения стабильной и предсказуемой производительности в задачах, требующих анализа данных в режиме, близком к реальному времени, для Doudna выбрана гибридная подсистема хранения, включающая зоны QSS (Quality-of-service Storage System) и PSS (Platform Storage System). Первая ориентирована прежде всего на ИИ-нагрузки: предполагается применение решений VAST Data, включая платформу VAST AI OS. Эта платформа, как утверждается, «объединяет возможности хранения информации, базы данных, вычислений, обмена сообщениями и рассуждений в единую инфраструктуру, созданную с нуля для ИИ и программных агентов». В свою очередь, PSS использует в качестве основы программно-определяемое решение IBM Storage Scale: этот сегмент будет функционировать как быстродействующая параллельная файловая система. Говорится о высокой производительности, масштабируемости и эффективности, что поможет устранить узкие места и оптимизировать рабочие процессы, связанные с обработкой данных. Для обоих сегментов СХД предусмотрено использование архитектуры All-Flash, то есть, будут задействованы исключительно SSD. Как отмечает Berkeley Lab, гибридная подсистема хранения обеспечит в пять раз более высокую производительность, нежели нынешний НРС-комплекс NERSC. Это позволит справляться с крупномасштабными рабочими нагрузками в таких областях исследований, как молекулярная динамика и геофизическое моделирование. Ввести суперкомпьютер в эксплуатацию планируется в 2026 году.

04.07.2025 [23:55], Руслан Авдеев

Плотнее, быстрее, дешевле: керамические накопители Cerabyte готовятся составить конкуренцию LTOCerabyte занимается разработкой керамических накопителей ёмкостью от 100 Пбайт, обеспечивающих скорость передачи данных 2 Гбайт/с с задержкой доступа менее 10 с. На днях она сообщила о намерении обеспечить готовность архивных накопителей к 2030 году, сообщает Blocks & Files. На мероприятии A3 Tech Live в Мюнхене компания анонсировала решение, способное заменить LTO-хранилища. Компания использует технологию записи данных на покрывающей стекло керамике с помощью фемтосекундных лазерных импульсов. Стеклянные субстраты хранятся в картриджах, а роботизированные системы перемещают картриджи между полками хранилища, а также на станции записи и чтения, как это происходит и в обычных ленточных библиотеках. Компания ведёт разработки в партнёрстве и при финансовой помощи Pure Storage, Western Digital и In-Q-Tel. Также в проекте принимает участие фонд Европейского совета по инновациям (European Innovation Council, EIC). Решение конкурирует с продвигаемым Microsoft проектом Project Silica, тоже предусматривающим использование стеклянных пластин для записи информации, а также Holomem, Piql, Archiflix и др. Суммарно Cerabyte привлекла около $10 млн в ходе начального финансирования и более $4 млн в виде грантов. Теперь компания работает над привлечением средств в ходе венчурного финансирования в ходе раунда серии А. В Cerabyte утверждают, что её технология позволяет хранить данные дольше и дешевле, чем на лентах — более 100 лет против 7–15. Кроме того, скорость передачи данных составляет 1–2 Гбайт/с против 1 Гбайт/с у ленточных решений. Стоимость хранения составляет $1/Тбайт против $2/Тбайт у LTO. Наконец, по словам компании, глобальные углеродные выбросы от хранилищ данных можно будет снизить с 2 % от мировых сейчас до 1,25 % в будущем благодаря замене ленточных и иных решений на продукты Cerabyte.

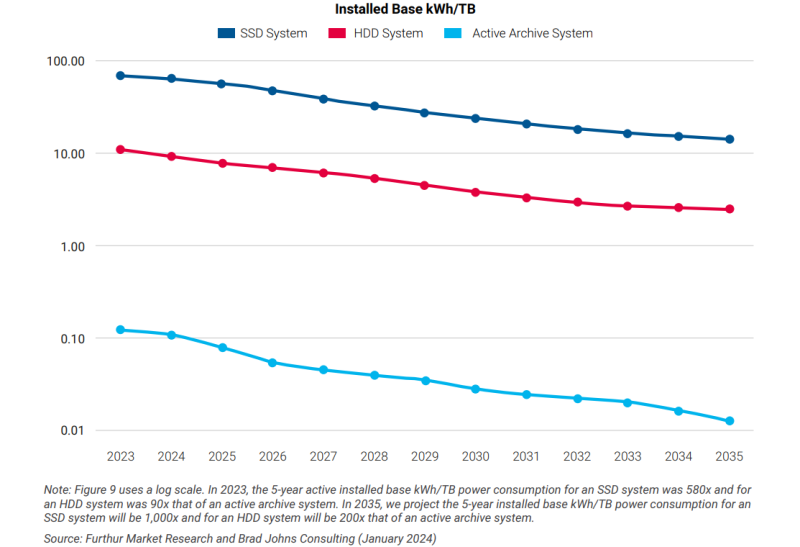

Источник: Furthur Market Research В 2025–2026 гг. планируется представить пилотную систему ёмкостью 1 Пбайт на стойку, скоростью передачи данных 100 Мбайт/с и задержкой доступа на уровне 90 с. В 2029–2030 гг. технология позволит разместить более 100 Пбайт в одной стойке, скорость передачи увеличится до 2 Гбайт/с, а задержка доступа к данным сократится до 10 с. За эти пять лет совокупная стоимость владения (TCO) 1 Пбайт упадёт с $7–$8 тыс. до $6–$8. В Cerabyte рассчитывают, что прогресс лазерных технологий в будущем позволит использовать для записи пучок ионов гелия, что снизит размер бита с 300 нм до 3 нм к 2045 году. В результате можно будет создавать стойки ёмкостью 100 Эбайт. LTO таких значений вряд ли успеет добиться. Более того, даже при внедрении LTO-10 компании уже отстают от намеченных планов по ёмкости картриджей. |

|