Материалы по тегу: nvidia

|

22.07.2024 [15:57], Руслан Авдеев

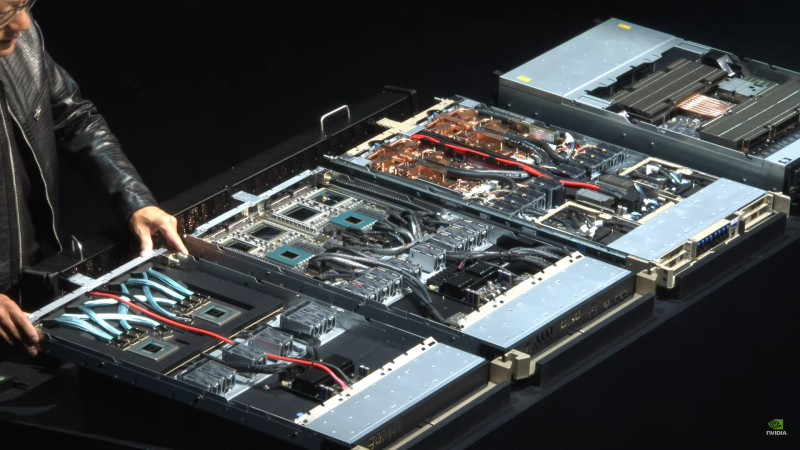

Поставки суперускорителей с чипами NVIDIA GB200 могут задержаться из-за протечек СЖОNVIDIA уже готовилась начать продажи систем на базе новейших ИИ-суперускорителей GB200, однако столкнулась с непредвиденной проблемой — TweakTown сообщает, что в системах жидкостного охлаждения этих серверов начали появляться протечки. Судя по всему, серверы на основе GB200 использовали дефектные компоненты систем СЖО охлаждения, поставляемые сторонними производителями: разветвители, быстросъёмные соединители и шланги. Некорректная работа любого из этих компонентов может привести к утечке охлаждающей жидкости. В случае с моделью GB200 NVL72 стоимостью в $3 млн это может перерасти в большую проблему. К счастью, нарушения в работе новых систем NVIDIA GB200 NVL36 и NVL72 обнаружили до начала массового производства в преддверии запуска поставок ключевым покупателям ИИ-решений. Предполагается, что на сроках поставок проблема не скажется, поскольку её успеют устранить. Впрочем, по данным источников, теперь крупные провайдеры облачных сервисов «нервничают».

Источник изображения: NVIDIA NVIDIA предлагают свою продукцию всё больше тайваньских производителей, способных заменить бракованные компоненты для серверных систем с GB200. Однако сертификация компонентов — процесс довольно сложный, поскольку многие тайваньские компании не специализировались на их выпуске ещё в недавнем прошлом. Тем не менее, когда NVIDIA объявила, что ускорители следующего поколения получат жидкостное охлаждение, многие производители решили попробовать себя в этой сфере. Тайваньские Shuanghong и Qihong уже имеют хороший опыт в выпуске водоблоков, а теперь расширили спектр разрабатываемых товаров, предлагая разветвители, быстросъемные соединители и шланги. Именно эти компании по некоторым данным сейчас предоставляют необходимые комплектующие для замены бракованных в новых суперускорителях NVIDIA GB200 NVL36 и NVL72. Лидером на рынке серверных СЖО остаётся CoolIT, но её услугами NVIDIA, видимо, решила не пользоваться.

22.07.2024 [12:51], Руслан Авдеев

NVIDIA готовит урезанную версию флагманского ИИ-чипа Blackwell для КитаяNVIDIA работает над новым вариантом представленного весной флагманского ИИ-ускорителя серии Blackwell — теперь для китайского рынка, находящегося под давлением американских санкций. По данным Reuters, вендор работает над тем, чтобы привести оборудование в соответствие с техническими требованиями властей США к поставляемым в Китай полупроводникам. Серию Blackwell компания представила в марте 2024 года. Массовое производство планируется позже в текущем году. Выпускаемый в рамках нового семейства ускоритель B200 до 30 раз производительнее своего предшественника при выполнении некоторых задач. Над выпуском и поставками упрощённого для Китая чипа B20 вендор будет работать совместно с одним из своих крупнейших дистрибьюторов в Китае — компанией Inspur. Источники Reuters пожелали остаться неизвестными, в самой NVIDIA новость пока не комментируют, предпочитают молчать и в Inspur. Вашингтон в очередной раз ужесточил контроль над поставками передовых чипов в Китай в 2023 году, пытаясь предотвратить развитие в Поднебесной собственных суперкомпьютеров. С тех пор NVIDIA разработала три чипа, специально оптимизированных для китайского рынка. Примечательно, что американские санкции помогли компаниям вроде китайского техногиганта Huawei и стартапам вроде Enflame добиться некоторых успехов на китайском рынке ИИ-ускорителей. Появление версии чипа серии Blackwell для Китая, вероятно, поможет NVIDIA избавиться от конкуренции на одном из ключевых рынков. Из-за санкций США за год, закончившийся в январе, выручка NVIDIA в Китае составила 17 % от общемировой, для сравнения, двумя годами ранее на страну приходилось 26 % всех продаж компании. Изначально предназначенный для Китая чип H20, продажи которого начались в этом году, раскупался довольно слабо, поэтому вендору пришлось снизить цену, чтобы сделать его дешевле конкурирующего решения Huawei. Теперь, по данным источников, продажи растут быстрыми темпами. По оценкам экспертов SemiAnalysis, в этом году NVIDIA намерена продать в Китае более 1 млн чипов H20 на сумму свыше $12 млрд. При этом высока вероятность, что американские власти и дальше продолжат ужесточать экспортный контроль, ограничивая поставки передовых ускорителей в КНР. Более того, США хотят, чтобы Нидерланды и Япония всё активнее включались в санкционный процесс, ограничивая с Китаем сотрудничество в области оборудования для производства полупроводников. Также, как сообщают источники, имеются предварительные планы ограничить доступ к наиболее передовым ИИ-моделям. Акции полупроводниковых компаний упали на прошлой неделе на фоне новостей о том, что США оценивают целесообразность введения правила, позволяющего просто запрещать продажи продуктов, выпущенных с помощью американских технологий. UPD: Inspur отрицает совместную работу с NVIDIA над ускорителями B20.

22.07.2024 [08:57], Сергей Карасёв

Mistral AI и NVIDIA представили корпоративную ИИ-модель Mistral NeMo 12B со «здравым смыслом» и «мировыми знаниями»Корпорация NVIDIA и французская компания Mistral AI анонсировали большую языковую модель (LLM) Mistral NeMo 12B, специально разработанную для решения различных задач корпоративного уровня — чат-боты, обобщение данных, работа с программным кодом и пр. Mistral NeMo 12B насчитывает 12 млрд параметров и использует контекстное окно в 128 тыс. токенов. Для инференса применяется формат данных FP8, что, как утверждается, позволяет уменьшить размер требуемой памяти и ускорить развёртывание без какого-либо снижения точности ответов. При обучении модели была задействована библиотека Megatron-LM, являющаяся частью платформы NVIDIA NeMo. При этом использовались 3072 ускорителя NVIDIA H100 на базе DGX Cloud. Утверждается, что Mistral NeMo 12B отлично справляется с многоходовыми диалогами, математическими задачами, программированием и пр. Модель обладает «здравым смыслом» и «мировыми знаниями». В целом, говорится о точной и надёжной работе применительно к широкому спектру приложений. Модель выпущена под лицензией Apache 2.0 и предлагается в виде NIM-контейнера. На внедрение LLM, по словам создателей, требуются считанные минуты, а не дни. Для запуска модели достаточно одного ускорителя NVIDIA L40S, GeForce RTX 4090 или RTX 4500. Среди ключевых преимуществ развёртывания посредством NIM названы высокая эффективность, низкая стоимость вычислений, безопасность и конфиденциальность. UPD 21.08.2024: компании представили Mistral-NeMo-Minitron 8B, более компактную, но не менее эффективную, по словам создателей, версию Mistral NeMo 12B, которая может работать даже на ускорителе NVIDIA RTX.

20.07.2024 [14:40], Сергей Карасёв

Разработчик сетевых решений для гиперскейлеров Arrcus привлёк $30 млнКомпания Arrcus, разработчик программных решений для гиперскейлеров, объявила о проведении раунда финансирования на сумму $30 млн, в котором приняла участие NVIDIA. В число других инвесторов вошли Prosperity7 Ventures, Lightspeed, Hitachi Ventures, Liberty Global, Clear Ventures и General Catalyst. Arrcus была основана в 2016 году. Ранее Arrcus привлекла на развитие $138 млн от различных инвесторов. В число партнёров компании входят Amazon Web Services (AWS), Equinix, Edgecore networks, CoreSite и др. Компания специализируется на передовых сетевых технологиях: в числе её продуктов — платформа Leaf-Spine Fabric и решение ACE-AI на основе ArcOS для обслуживания распределенных рабочих нагрузок ИИ. Сетевая платформа ACE (Arrcus Connected Edge), использующая NVIDIA BlueField DPU, позволяет эффективно разгружать, ускорять и изолировать ресурсоемкие приложения, такие как системы обеспечения безопасности или средства управления трафиком. По сути, Arrcus оптимизирует использование распределённой вычислительной инфраструктуры, охватывающей дата-центры, периферийные узлы и гибридные/мультиоблачные среды. Отмечается, что решения Arrcus в сочетании с ИИ-инфраструктурой на базе компонентов NVIDIA позволят обеспечить максимальную эффективность для заказчиков. Кроме того, сотрудничество компаний поможет расширить архитектуру традиционных ЦОД до распределённых конфигураций, основанных на модульной платформе NVIDIA MGX, специально разработанной для построения ИИ-систем на базе CPU, GPU и DPU.

18.07.2024 [22:35], Владимир Мироненко

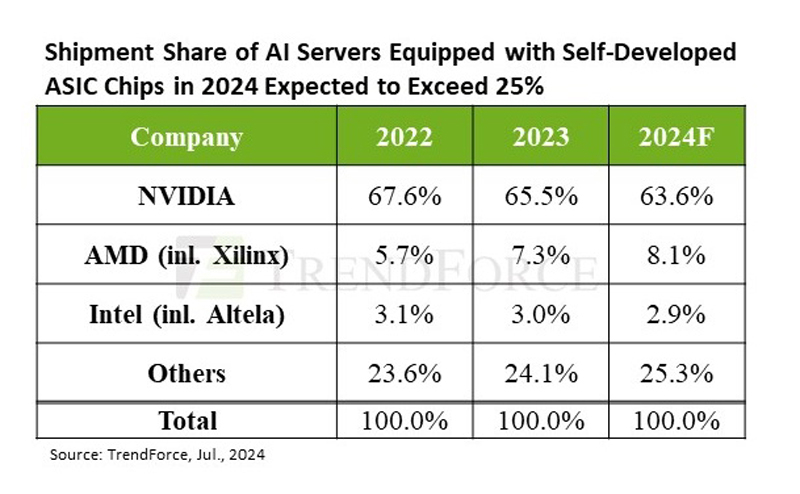

TrendForce прогнозирует высокий спрос на ИИ-серверы до конца 2025 годаСогласно прогнозу аналитической компании TrendForce, высокий спрос на ИИ-серверы со стороны крупных провайдеров облачных услуг и других клиентов сохранится до конца 2024 года. Постепенное расширение производства компаниями TSMC, SK hynix, Samsung и Micron позволило значительно уменьшить дефицит во II квартале и, как следствие, время выполнения заказа на NVIDIA H100 сократилось с прежних 40–50 недель до менее чем 16. По оценкам TrendForce, поставки ИИ-серверов во II квартале выросли почти на 20 % по сравнению с предыдущим кварталом. Аналитики в своём свежем отчёте пересмотрели прогноз поставок на весь год до 1,67 млн ИИ-серверов (рост на 41,5 % в годовом исчислении). Объём рынка ИИ-серверов в 2024 году в денежном выражении, как ожидают в TrendForce, превысит $187 млрд при темпах роста 69 %, что составит 65 % от рыночной стоимости всех поставленных серверов. В отчёте также отмечено, что в этом году крупные провайдеры облачных услуг продолжают концентрироваться на закупке ИИ-серверов, что негативно отражается на темпах роста поставок серверов общего назначения. У последних ежегодные темпы роста поставок составят всего 1,9 %. Как ожидают в TrendForce, доля ИИ-серверов в штучном выражении в общем объёме поставок достигнет 12,2 %, что больше на 3,4 п.п. по сравнению с 2023 годом. Аналитики отметили, что североамериканские гиперскейлеры постоянно расширяют выпуск собственных ASIC, впрочем, как и китайские компании, такие как Alibaba, Baidu и Huawei. Ожидается, что благодаря этому доля ASIC-серверов на рынке ИИ-серверов вырастет до 26 % в 2024 году, в то время как у ИИ-серверов с ускорителями доля будет около 71 %. При этом NVIDIA сохранит абсолютное лидерство с около 90 % рынка ИИ-серверов с ускорителями, в то время как доля AMD составит лишь около 8 %. Если же учитывать вообще все чипы, используемые в ИИ-серверах (GPU, ASIC, FPGA), то доля рынка NVIDIA в этом году составит около 64 %, ожидают в TrendForce. По оценкам аналитической фирмы Tech Insights, NVIDIA в 2023 году отгрузила приблизительно 3,76 млн серверных ускорителей на базе GPU, захватив 98 % рынка GPU для ЦОД. TrendForce считает, что спрос на передовые ИИ-серверы сохранится и в 2025 году, учитывая тот факт, что NVIDIA Blackwell (включая GB200, B100/B200) заменит Hopper. Это также будет стимулировать спрос на CoWoS (2.5D-упаковка от TSMC) и память HBM. Производственная мощность TSMC в области CoWoS, по оценкам TrendForce, достигнет 550–600 тыс. единиц к концу 2025 года, при этом темпы роста достигнут 80 %.

Источник изображения: TrendForce Тем не менее, ускоритель H100 получит в 2024 году наибольшее распространение. К 2025 году такие ускорители, как Blackwell Ultra от NVIDIA или MI350 от AMD, будут оснащены HBM3e ёмкостью до 288 Гбайт, что утроит количество компонентов памяти. Ожидается, что общее предложение HBM удвоится к 2025 году на фоне высокого спроса на ИИ-серверы. При этом не все уверены в светлом будущем ИИ. Так, венчурный фонд Sequoia Capital и аналитики Goldman Sachs указывают на сверхвысокие расходы на ИИ-оборудование и вместе с тем отсутсвие реальной финансовой отдачи от вложений в ИИ-решения. С другой стороны, венчурный фонд Andreessen Horowitz (a16z) уверен, что ИИ не станет очередным финансовым пузырём и сам закупает ИИ-ускорители, чтобы привлечь стартапы. А некоторые ИИ-стартапы сами приходят к крупным игрокам, поскольку не способны окупить затраты на оборудование.

18.07.2024 [18:23], Руслан Авдеев

Четвёртый за год: NVIDIA приобрела ещё один облачный стартап — Brev.devNVIDIA приобрела стартап, помогающий ИИ-разработчикам найти среди предложений облачных провайдеров наиболее подходящий по соотношению цена/качество доступ к ускорителям. Как сообщает портал CRN, это уже четвёртая заметная покупка NVIDIA с начала года. Представитель NVIDIA подтвердил, что сделка по приобретению Brev.dev действительно состоялась, но сумму и условия сделки не сообщил. Brev.dev предоставляет платформу для создания, обучения и внедрения ИИ-моделей в облаках. Целью Brev.dev, по словам самого стартапа, является поиск простейшего способа использования ускорителей для разработчиков систем ИИ и машинного обучения. Сотрудничество с NVIDIA обеспечит выполнение этой миссии, с комбинацией максимально возможно производительной аппаратной составляющей с самым передовым программным обеспечением. На сайте Brev.dev официальными партнёрами стартапа названы NVIDIA, Intel и AWS. Там же говорится, что платформа служит единым интерфейсом для взаимодействия AWS, Google Cloud Platform, Fluidstack и прочими облаками с ИИ-ускорителями. Это позволяет разработчикам искать подходящие инстансы на основе их цены и доступности. Хотя NVIDIA поставляет GPU и ИИ-ускорители облачным провайдерам более десяти лет, в последние годы компания уделяет немало внимания расширению собственного бизнеса в сфере облачных инфраструктур.

Источник изображения: NVIDIA В прошлом году компания запустила сервис DGX Cloud, который развёрнут в облачной инфраструктуре других провайдеров и на собственных мощностях и ИИ-суперкомпьютерах. Ранее в этом году NVIDIA купила ещё два стартапа для развития возможностей DGX Cloud. В конце апреля компания анонсировала покупку израильского стартапа Run:ai, занимающегося решениями для оркестрации ИИ-инфраструктур. Его планируется интегрировать в DGX Cloud, а также с DGX- и HGX-серверами. По имеющимся данным, покупка Run:ai обошлась в $700 млн. Практически одновременно с Run:ai компания приобрела ещё один израильский стартап — Deci, предлагающий ПО, способное на любом железе ускорить инференс ИИ-моделей, сохраняя точность данных. Сделку, по слухам, оценили приблизительно в $300 млн. Наконец, месяц назад NVIDIA купила калифорнийский стартап Shoreline.io, основанный бывшим управленцем AWS — компания разрабатывает ПО для автоматического устранения проблем в инфраструктуре ЦОД. По некоторым данным, команда Shoreline присоединилась к DGX Cloud, а покупка обошлась в $100 млн.

17.07.2024 [23:33], Игорь Осколков

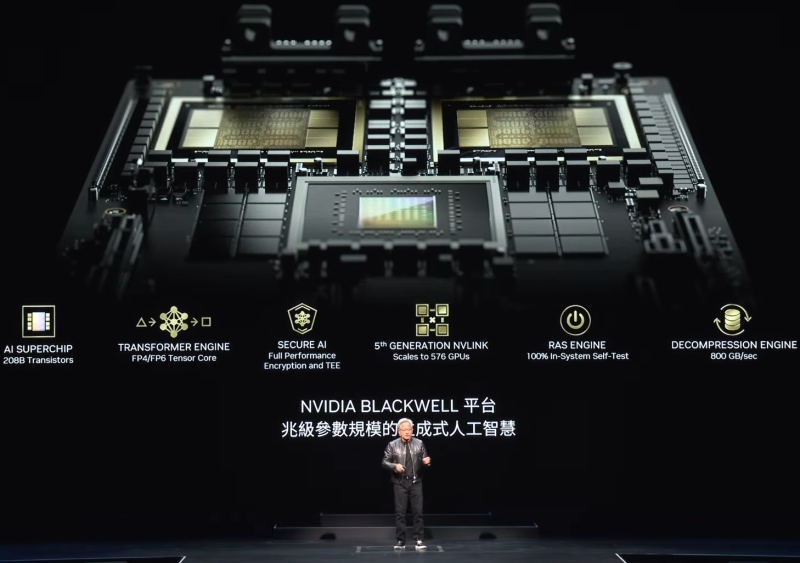

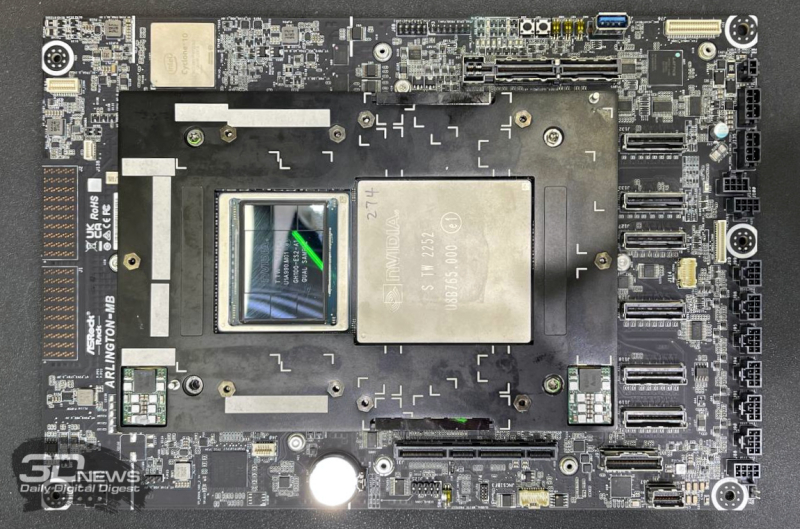

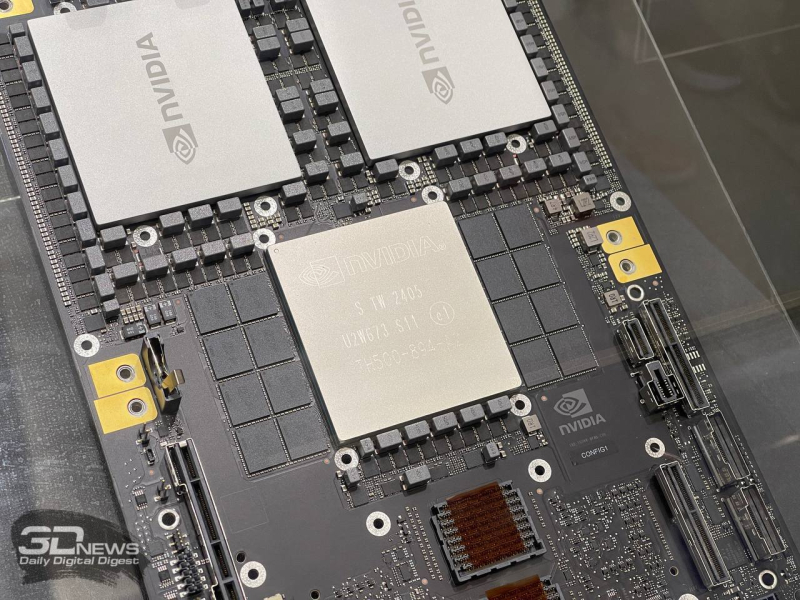

Суперускоритель по суперцене — NVIDIA GB200 NVL72, вероятно, будет стоить $3 млнКомпания NVIDIA значительно увеличила заказ на ускорители Blackwell у TSMC, сообщает TrendForce со ссылкой на United Daily News (UDN). По данным источника, NVIDIA намерена получить уже не 40 тыс., а 60 тыс. суперускорителей нового поколения, причём 50 тыс. из них придётся на стоечные системы GB200 NVL36. При этом Blackwell всё равно будут в дефиците, как и обещал ещё зимой глава NVIDIA Дженсен Хуанг (Jensen Huang). B200 включает два тайла, объединённых 2,5D-упаковкой CoWoS-L и соединённых интерконнектом NV-HBI. Чип имеет 208 млрд транзисторов, изготовленных по кастомному техпроцессу TSMC 4NP. GB200 объединяет два ускорителя B200 и один 72-ядерный Arm-процессор Grace. А суперускоритель GB200 NVL72, в свою очередь, объединяет в рамках одной стойки сразу 18 1U-узлов с парой GB200 в каждом (плата Bianca, 72 × B200 и 36 × Grace), провязанных шиной NVLink 5. Вся эта система потребляет порядка 120 кВт, оснащена СЖО и единой DC-шиной питания. Однако у GB200 NVL72 довольно специфические требования к окружению, поэтому NVIDIA предлагает суперускоритель попроще — GB200 NVL36, который как раз и должен стать наиболее массовым в данной серии. Эта платформа точно так же занимает целую стойку, но использует 2U-узлы с теми же платами Bianca (суммарно 36 × B200 и 18 × Grace), потребляя всего 66 кВт. При этом всё равно подразумевается использование двух стоек GB200 NVL36, объединённых интерконнектом, так что GB200 NVL72 всё равно получается более энергоэффективным решением. Как отмечает SemiAnalysis, GB200 NVL36 также будет доступен в варианте с платами Ariel, имеющими по одному чипу B200 и Grace. Наконец, во II квартале 2025 года появятся системы B200 NVL72 и B200 NVL36 с x86-процессорами (Miranda). Кроме того, NVIDIA представила и отдельные MGX-узлы GB200 NVL2 с парой GB200. В общем, ускорителей B200 компании понадобится много, чтобы наверняка удержать лидерство на рынке. По словам UDN, GB200 NVL36 будет стоить порядка $1,8 млн, а GB200 NVL72 обойдётся уже в $3 млн. Одиночный GB200 будет стоить $60–$70 тыс., а самый простой ускоритель B100 оценён в $30–$35 тыс. Нужно подчеркнуть, что это оценки сторонних аналитиков. Сама компания официально не раскрывает стоимость своих продуктов. Это устоявшаяся практика на данном рынке, против которой пошла только Intel, публично назвавшая стоимость ИИ-ускорителей Gaudi. Впрочем, ранее глава NVIDIA намекнул, что B200 будет стоить приблизительно $30–$40 тыс.

15.07.2024 [09:23], Владимир Мироненко

HPE построит самый мощный в Японии ИИ-суперкомпьютер ABCI 3.0 на базе NVIDIA H200Японский национальный институт передовых промышленных наук и технологий (AIST) объявил о планах по строительству в Касива (Kashiwa, префектура Тиба) нового суперкомпьютера AI Bridging Cloud Infrastructure 3.0 (ABCI 3.0), представляющего собой очередное обновление ИИ-платформы ABCI, запущенной в 2018 году. Новый суперкомпьютер будет предлагаться в качестве облачного сервиса как государственным, так и частным организациям страны, сообщается в блоге NVIDIA. В качестве подрядчика выступает HPE, которая построит систему с использованием платформы Cray XD с ускорителями NVIDIA H200, объединённых 200G-интерконнектом NVIDIA Quantum-2 InfiniBand. HPE не стала раскрывать подробности об общем количестве узлов, стоимости системы и сроках её ввода в эксплуатацию. Как полагает ресурс The Register, речь идёт о системе с 5U-узлами Cray XD670, способными вместить восемь ускорителей NVIDIA H200/H100 и пару Intel Xeon Emerald Rapids. Кроме того, готовится машина ABCI-Q на базе ускорителей NVIDIA H100, ориентированная на исследования в области квантовых и гибридных вычислений. HPE сообщила, что ABCI 3.0, как ожидается, станет самым быстрым ИИ-суперкомпьютером в Японии — примерно 6,2 Эфлопс (FP16?) или 410 Пфлопс (FP64). Проект ABCI 3.0 реализуется при поддержке Министерства экономики, торговли и промышленности Японии (METI) с целью укрепления вычислительных ресурсов страны через Фонд экономической безопасности. Это часть более широкой инициативы METI стоимостью $1 млрд, которая включает в себя как программу ABCI, так и инвестиции в облачные вычисления на базе ИИ.

10.07.2024 [10:59], Руслан Авдеев

Венчурный инвестор Andreessen Horowitz (a16z) запасается ИИ-ускорителями, чтобы привлечь ИИ-стартапыВенчурная инвестиционная компания Andreessen Horowitz (a16z) получила тысячи современных ускорителей, включая большое количество NVIDIA H100. The Information сообщает, что компания создаёт собственные запасы для привлечения к сотрудничеству ИИ-стартапов. Компания явно не согласна с позицией венчурного фонда Sequoia Capital и аналитиков Goldman Sachs, которые опасаются, что нынешний бум ИИ — лишь пузырь. Инвестор имеет в управлении активы на $42 млрд. Как сообщают СМИ со ссылкой на источники, знакомыми с делами компании, своим подопечным компания сдаёт в аренду запасённые ускорители. Пока нет сведений, идёт ли речь о наполнении складов или компания только арендует их для передачи в субаренду. В будущем Andreessen Horowitz намерена получить более 20 тыс. ускорителей. Компания рассматривает оборудование как критически важный актив для дальнейшего развития бизнеса.

Источник изображения: NVIDIA На запросы журналистов Andreessen Horowitz и NVIDIA пока не отвечают. Уже не в первый раз ИИ-ускорители используются не вполне традиционным способом по мере того, как нарастает ажиотаж на рынке ресурсоёмких вычислений, связанных с искусственным интеллектом. Например, в прошлом августе облачный стартап CoreWeave, поддерживаемый NVIDIA, получил в долг $2,3 млрд под залог крупной партии NVIDIA H100 для покупки ещё большего количества ускорителей. В условиях дефицита ускорителей стартапам предлагаются различные варианты решения проблемы. Так, Alibaba Cloud предлагает ИИ-стартапам GPU-мощности в обмен на долю в компании, а AWS готова выделить им миллионы долларов, но в виде кредитов для оплаты ресурсов в своём же облаке. Некоторые стартапы сами готовы поделиться интеллектуальной собственностью в обмен на доступ к ускорителям.

09.07.2024 [23:33], Владимир Мироненко

$10-млрд сделка между Oracle и xAI сорваласьИИ-стартап Илона Маска (Elon Musk) xAI отказался от планов по расширению сотрудничества с Oracle. Как пишет The Wall Street Journal, во вторник миллиардер сообщил в соцсети X, что xAI прекратил переговоры с облачным провайдером о сделке на $10 млрд по поводу расширения аренды вычислительных мощностей, поскольку стартап сам построит «самый мощный кластер для обучения [ИИ-моделей] в мире с большим запасом». Сообщивший ранее о срыве сделки ресурс The Information рассказал, что многолетнее соглашение об аренде у Oracle запланированного к строительству суперкомпьютера на чипах NVIDIA уже было на стадии подписания, но переговоры зашли в тупик из-за того, что Маска не устроили сроки строительства, предложенные Oracle. Oracle же заявила об отсутствии доступа к адекватному источнику энергии для работы ИИ-суперкомпьютера в выбранном xAI регионе.

Источник изображения: xAI В итоге Маск заявил, что «самый мощный суперкомпьютер в мире» будет построен стартапом в Мемфисе (штат Теннесси, США) и начнёт работу осенью 2025 года. Ранее Маск сообщил, что в течение следующих нескольких месяцев xAI развернёт кластер из 100 тыс. ускорителей NVIDIA H100 с жидкостным охлаждением, а летом следующего года запустит ещё один кластер из 300 тыс. ускорителей NVIDIA B200. Как отметил ресурс Data Center Dynamics, xAI уже арендует у Oracle около 16 тыс. ускорителей NVIDIA, что делает его одним из крупнейших клиентов провайдера облачных услуг. Стартап также использует для работы сервисы AWS и резервные мощности в ЦОД соцсети X (Twitter). Oracle также предоставляет свою ИИ-инфраструктуру Microsoft и OpenAI. |

|