Материалы по тегу: оркестрация

|

08.10.2025 [08:53], Владимир Мироненко

HPE отдала Nokia «ненужные» технологии Juniper Networks для мобильных сетей, часть сотрудников и одного вице-президентаNokia объявила о сделке с HPE, в рамках которой она лицензировала технологии для развития своих решений для мобильных сетей и сетевой автоматизации на базе ИИ. Nokia получит доступ к технологиям, касающимся интеллектуальных контроллеров (RIC) сетей радиодоступа (RAN) и платформы по управлению и оркестрации сервисов (SMO) компании Juniper Networks, приобретённой HPE за $14 млрд. 1 октября 2025 года большая часть соответствующей команды разработчиков перешла в Nokia Mobile Networks, а вместе с ней и Константин Полихронопулос (Constantine Polychronopoulos), вице-президент группы Juniper Networks, о чём пишет Data Center Dynamics. Лицензированные технологии будут интегрированы с решениями платформы Nokia MantaRay для управления сервисами и оркестрации (SMO) и автоматизации сетей. MantaRay SMO — комплексное решение Nokia для автоматизации на базе ИИ без участия оператора, способное достичь 4-го уровня автономных сетей TM Forum. Решение также полностью совместимо с Open RAN и поддерживает открытый интерфейс R1 для rApps. Как сообщает tele.net.in, за последние пять лет Juniper создала «лучшую в своем классе» платформу RIC, а также решение SMO, обеспечивающее сквозную динамическую «нарезку» сети (end-to-end dynamic network slicing) по требованию. По всей видимости, HPE решила, что бизнес SMO/RIC для неё не является целевым, подобно Broadcom, отказавшейся от разработки RIC в VMware, пишет ресурс The Mobile Network. RIC функционирует в процессе развёртывания Open RAN, выступая своего рода связующим звеном. Это позволяет операторам развёртывать xApps- и rApps-приложения для контроля и проектирования функций RAN, обеспечивая административный суверенитет RAN над функциями, которые обычно реализуются как проприетарные на базовых станциях. RIC также позволяет телекоммуникационным компаниям комбинировать сторонние сетевые приложения, такие как отключение базовых станций или перенаправление трафика из перегруженных сот, с радиоустройствами Ericsson или Nokia, предоставляя оператору больше контроля над своими средами Open RAN. Томми Уитто (Tommi Uitto), президент подразделения мобильных сетей Nokia, отметил, что сделка с HPE расширит возможности Nokia по предложению клиентам «автоматизации, оркестрации и открытых экосистем на базе ИИ, что позволит им эффективнее управлять сетями разных производителей и подготовиться к переходу с 5G на 6G».

20.06.2025 [00:00], Владимир Мироненко

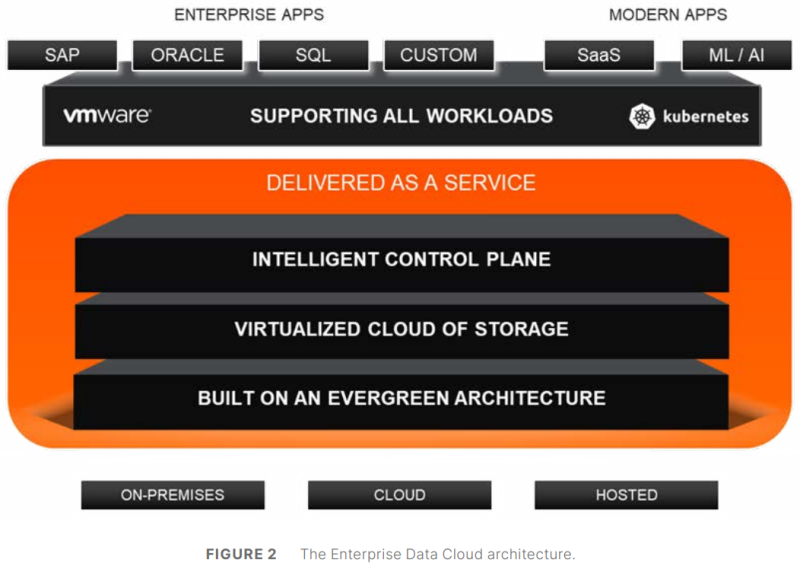

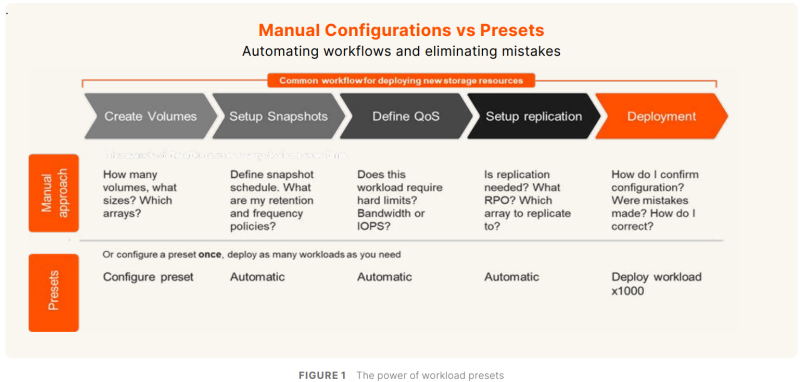

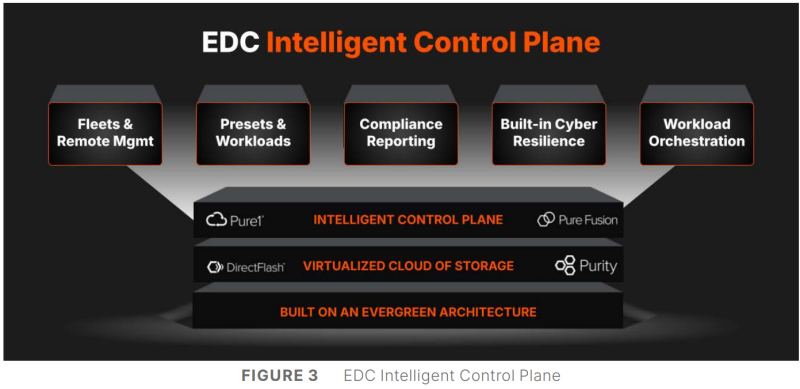

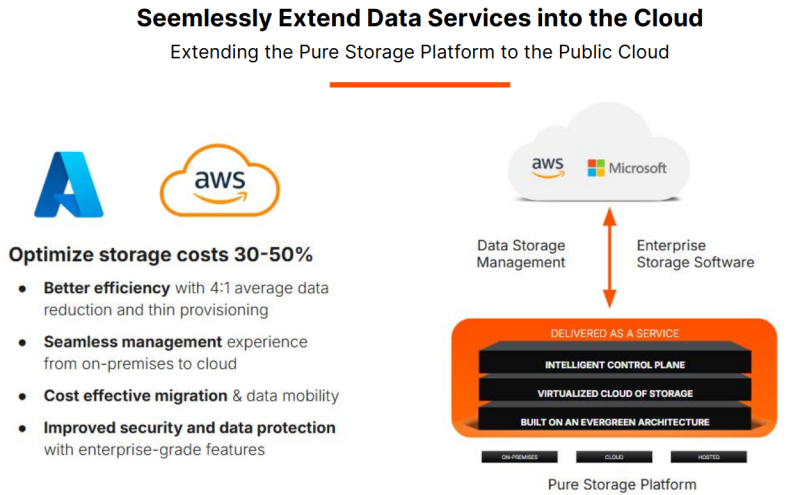

Управлять данными, а не хранилищами: Pure Storage представила унифицированную облачную платформу Enterprise Data CloudPure Storage представила платформу Enterprise Data Cloud (EDC), которая предлагает простой, гибкий и унифицированный способ управления данными и хранилищами, позволяя организациям сосредоточиться на бизнес-задачах, а не на инфраструктуре. EDC позволяет управлять блочными, файловыми и объектными нагрузками в локальных, облачных и гибридных средах. Компания отметила, что использование традиционных моделей хранения влечёт за собой фрагментацию, разрозненность и неконтролируемое разрастание данных. Enterprise Data Cloud (EDC) предназначена для решения этих проблем, предоставляя виртуализированное облако данных с единым контролем, охватывающим различные среды. Такой подход обеспечивает интеллектуальное, автономное управление данными и управление во всём массиве данных, позволяя компаниям снизить риски, затраты и эксплуатационную неэффективность. «Пришло время прекратить управлять хранилищем и начать управлять данными. Поскольку ИИ увеличивает потенциальную ценность корпоративных данных, а киберугрозы ставят их под угрозу, архитектуры хранения данных и инструменты для управления данными не поспевают за развитием», — сообщил в пресс-релизе председатель и генеральный директор Pure Storage Чарльз Джанкарло (Charles Giancarlo). Как отметил ресурс Computer Weekly, EDC представляет собой объединение существующих архитектурных элементов и систем Pure Storage: Purity OS, которая является общей для всех массивов компании; Fusion, которая позволяет обнаруживать и управлять ресурсами хранения; Pure1, которая позволяет управлять парком оборудования с точки зрения производительности и детального управления ресурсами; подписка Evergreen. В основе платформы лежит решение Pure Fusion, объединяющее хранилища как пул адаптируемых ресурсов и рассматривающее все массивы как конечные точки в единой сети данных. Это позволяет администраторам управлять парком СХД через единый интерфейс и развёртывать рабочие нагрузки с использованием интеллектуальных шаблонов, которые автоматизируют такие параметры, как качество обслуживания, уровни защиты и требования к производительности. Слой Fusion изначально встроен в массивы Pure. Администраторы получили большую гибкость в реагировании на конкретные потребности каждой рабочей нагрузки и больше не должны предварительно планировать и настраивать развёртывания, что снижает риск несоответствия и повышает отказоустойчивость, гарантируя, что ресурсы для рабочих нагрузок будут подготовлены правильно с самого начала. Чтобы устранить проблемы, возникающие из-за ручных операций по подготовке, миграции и многого другого, автоматизация охватывает весь стек платформы с возможностями оркестрации на основе политик и самообслуживания. Встроенное соответствие требованиям и улучшенная киберустойчивость ещё больше минимизируют риск путём использования политик безопасности и управления. Эти новые возможности полностью переопределяют интеллектуальное управление хранением, считает компания. EDC поддерживает готовые сценарии для формирования рабочих процессов, которые интегрируют хранилище с вычислениями, сетями и приложениями, чтобы обеспечить сложные развёртывания, такие как репликация базы данных в нескольких ЦОД и в публичном облаке в рамках одной задачи. Чад Кенни (Chadd Kenney), вице-президент Pure Storage по технологиям, рассказал, что автоматизированные функции решают некоторые из рутинных задач развёртывания. «Если у кого-то есть приложение, которому требуется Oracle, администратор должен изучить парк массивов хранения, выяснить, какой из них способен принять новую рабочую нагрузку, а затем настроить его, убедившись в работоспособности репликации, наличии снапшотов и корректности политики качества обслуживания, — говорит Кенни. — Шаблоны позволяют вам задавать все конфигурации разом». Платформа предоставляет организованные шаблоны для рабочих процессов, созданные на основе тысяч существующих коннекторов для сторонних приложений и продуктов, в том числе от Cisco, Microsoft, VMware, ServiceNow и Slack. Шаблоны охватывают конфигурации хранилищ, вычислительных ресурсов, сетей, баз данных и приложений. Можно использовать готовые шаблоны от самой Pure и партнёров или создавать свои. Платформа включает в себя центр оркестрации с шаблонами автоматизации для таких функций, как DRaaS и предоставление данных, и имеет интеграцию с Rubrik Security Cloud и Crowdstrike Logscale. Например, Pure Fusion по сигналу от Rubrik автоматически маркирует снимки, отправляет их на сканирование и быстро выявляет среди них наиболее подходящие для восстановления. В случае с CrowdStrike компания предлагает первое в своём роде проверенное, локальное, устойчивое, безопасное и высокопроизводительное хранилище для Falcon LogScale. Кроме того, платформа предлагает расширенные возможности восстановления сред VMware. Наконец, интеллектуальный помощник компании AI Copilot, отслеживает в реальном времени телеметрию всего EDC, что позволяет ему мгновенно реагировать на запросы по производительности на уровне парка, предоставлять сценарии конфигурации и поддерживать быструю корректировку политики без вмешательства человека, заявила Pure Storage. «В течение 10 секунд он обработает все данные 100 различных систем, даст вам ответ и предоставит сценарий для развёртывания нагрузки», — рассказал Кенни.

23.04.2025 [16:15], Руслан Авдеев

GPU под роспись: Amazon резко ужесточила использование дефицитных ИИ-ускорителей внутри компании в рамках Project GreenlandВ прошлом году ретейл-бизнес Amazon столкнулся с острой нехваткой ИИ-ускорителей для внутреннего пользования. Это привело к задержкам при реализации ключевых проектов. На фоне глобального бума ИИ-технологий и дефицита чипов NVIDIA компания вынужденно пересмотрела принципы доступа к ускорителям для собственных нужд, сообщает Business Insider. В июле 2024 года началась реализация т. н. Project Greenland. Фактически речь идёт о платформе для централизованного распределения ресурсов ускорителей. Платформа позволяет отслеживать их использование, перераспределяет мощности в случае простоя и даёт возможность оперативно реагировать на изменения спроса. Теперь все заявки на доступ к ускорителям подаются только через Greenland, а приоритет получают проекты с высоким уровнем возврата инвестиций (ROI), чётким графиком и заметным влиянием на снижение затрат или рост выручки. У проектов с низкой эффективностью доступ к вычислительным мощностям могут вообще отозвать в пользу более перспективных инициатив. Amazon выделила восемь принципов распределения ускорителей среди сотрудников компании:

Источник изображения: Centre for Ageing Better/unsplash.com Amazon уже активно использует искусственный интеллект в различных проектах. В числе ключевых инициатив:

По оценкам Amazon, ИИ-проекты розничного подразделения в 2024 году принесли $2,5 млрд операционной прибыли, попутно сэкономив $670 млн. В 2025 году ретейл-подразделение Amazon намерено вложить $1 млрд в ИИ-проекты розничного сегмента и увеличить расходы на облако AWS до $5,7 млрд (с $4,5 млрд в 2024 году). Если во II полугодии 2024 года розница Amazon нуждалась в более 1 тыс. дополнительных инстансов P5 с NVIDIA H100, то в 2025 году ситуация, как свидетельствуют внутренние прогнозы, должна стабилизироваться. А к концу года внутренние запросы полностью удовлетворят с помощью чипов собственной разработки Amazon Tranium, «но не раньше». Тем не менее, в Amazon не теряют бдительности, постоянно задаваясь вопросом: «Как получить больше ускорителей?».

04.04.2025 [12:37], Руслан Авдеев

«Агрегатор ускорителей» Parasail анонсировал ИИ-гипероблакоСтартап Parasail привлёк $10 млн стартового капитала и выступил с необычным для рынка ИИ предложением. Компания стала своеобразным «агрегатором ускорителей», создав для инференса сеть, позволяющую свести вместе владельцев вычислительных мощностей и их клиентов с максимальной простотой, сообщает The Next Platform. Раунд финансирования возглавили Basis Set Ventures, Threshold Ventures, Buckley Ventures и Black Opal Ventures. Компанию основали Майк Генри (Mike Henry), ранее основавший производителя ИИ-решений Mythic и работавший одним из топ-менеджеров в Groq, и Тим Харрис (Tim Harris), генеральный директор Swift Navigation. Прежний опыт Майка Генри на рынке IT позволил заметить, что в последнее время ландшафт облачных сервисов стремительно меняется — если ранее на нём безраздельно доминировали гиперскейлеры вроде AWS, Microsoft Azure и Google Cloud, то с приходом ИИ они, казалось бы, сохраняют ведущие позиции, но на сцену выходят и новые облачные игроки, чья инфраструктура изначально рассчитана на ИИ-задачи, от обучения до инференса. В конце 2023 года бизнесмены основали компанию Parasail, которая совсем недавно заявила о себе, заодно собрав $10 млн финансирования. Фактически бизнес рассчитан на клиентов, которые заинтересованы в простом доступе к ИИ-технологиям — он будет связывать тех, кто располагает ими, и тех, кто в них нуждается.

Источник изображения: Campaign Creators/unsplash.com Parasail намеревается использовать рост облачных ИИ-провайдеров вроде CoreWeave (недавно вышедшей на IPO) и Lambda Labs. Для этого создана сеть AI Deployment Network, объединяющая их вычислительные ресурсы в единую инфраструктуру, которая масштабнее, чем Oracle Cloud Infrastructure (OCI). Компания применяет собственный «движок» для оркестрации процессов в этом гипероблаке. Ключевым преимуществом является низкая стоимость услуг — утверждается, что компании, желающие отказаться от сервисов вроде OpenAI и Anthropic, могут рассчитывать на экономию в 15–30 раз, а в сравнении с клиентами провайдеров open source моделей — в 2–5 раз. На настройку уходит несколько часов, а инференс после этого можно начать за считанные минуты. Сегодня Parasail предлагает в облаке ресурсы NVIDIA H200, H100 и A100, а также видеокарт NVIDIA GeForce RTX 4090. Цены составляют от $0,65 до $3,25 за час использования. Parasail столкнулась с проблемой несовместимости инфраструктур: разные облачные платформы используют уникальные подходы к вычислениям, хранению данных, сетевому взаимодействию, а также имеют различия в настройке, биллинге и автоматизации. Хотя Kubernetes и контейнеризация могли бы частично решить эти проблемы, их реализация у разных провайдеров сильно отличается, а Kubernetes изначально не предназначается для работы с несколькими кластерами, регионами или провайдерами одновременно. Чтобы обойти ограничения, Parasail разработала собственную систему, которая объединяет ускорители из разных облаков в единую глобальную сеть. Их решение позволяет централизованно управлять распределёнными узлами, игнорируя различия в инфраструктуре провайдеров. Если один облачный провайдер выйдет из строя, система автоматически заменяет его ресурсы другими, минимизируя простои. Дополняя эту систему автоматизированным динамическим выделением ускорителей, Parasail создаёт масштабируемую и эффективную глобальную инфраструктуру, способную оперативно адаптироваться к нагрузкам и сбоям. Оркестрация и оптимизация рабочих нагрузок в ИИ-инфраструктуре усложняются из-за огромного разнообразия моделей, архитектур, типов GPU и ASIC, а также множества способов их комбинирования. Parasail решает эту проблему с помощью гибридного подхода, сочетающего математическое моделирование, ИИ-алгоритмы и участие живых специалистов, что позволяет эффективно масштабироваться даже с небольшой командой.

Источник изображения: Campaign Creators/unsplash.com Закрытое бета-тестирование началось в январе, а позже спрос только вырос до той степени, что Parasail достигла семизначного ежегодного регулярного дохода (ARR). Теперь технология доступна всем, в числе клиентов — производитель чипов SambaNova, ИИ-платформа Oumi, ИИ-стартап Rasa и Elicit, позволяющий автоматизировать научные изыскания. В будущем стартап намерен быстро расширить штат из 12 работников, рассматриваются и варианты добавления в портфолио новых доступных ускорителей — сейчас там безусловно лидирует NVIDIA, но рынок вполне может измениться. В то же время отмечается парадоксальная ситуация, когда на рынке наблюдается и дефицит ускорителей, и простой мощностей в некоторых ЦОД одновременно. Предполагается, что дело в плохой оптимизации процессов на рынке ИИ. При этом в компании отмечают, что в данное время спрос на ИИ-приложения «почти бесконечен» и главная проблема — эффективно их использовать. Платформа Parasail для инференса максимально упрощает масштабное внедрение ИИ.

21.03.2025 [19:13], Руслан Авдеев

Стартап Nerdio, развивающий систему управления VDI в Microsoft Azure, привлёк $500 млн, а его капитализация выросла до $1 млрд

microsoft 365

microsoft azure

software

vdi

автоматизация

администрирование

облако

оркестрация

финансы

Стартап Nerdio Inc., обеспечивающий компаниям работу с виртуальными рабочими столами в облаке Microsoft Azure, привлёк $500 млн новых инвестиций в раунде серии C. Капитализация разработчика ПО достигла $1 млрд, что в четыре раза больше, чем два года назад, сообщает Silicon Angle. Продукты Nerdio используют 15 тыс. организаций, в 2022 году речь шла о 5 тыс. Среди клиентов — Comcast, PayPal и другие крупные компании. Платформа доступна в Azure Marketplace. В Nerdio утверждают, что это позволит избежать долгих процедур, сопровождающих корпоративные закупки ПО. Платформа может работать напрямую в облачных средах клиентов, что помогает повысить уровень безопасности. Платформа интегрирована в два VDI-сервиса Azure: AVD (Azure Virtual Desktop) и Windows 365. Nerdio обещает упростить процесс создания виртуальных рабочих столов. По данным компании, в некоторых случаях первоначальная настройка и развёртывание занимают недели. Платформа компании ускоряет процесс в отдельных случаях на 80 %. Платформа включает инструменты, которые упрощают выявление проблем с производительностью виртуальных рабочих столов, а также отключают аккаунты, демонстрирующие потенциально вредоносное поведение.

Источник изображения: Nerdio Встроенный инструмент автоматического масштабирования поможет снизить использование инфраструктуры. Эта функция позволяет автоматически назначить оборудование для выполнения задач в том объёме, в котором это действительно необходимо. В компании считают, что её ПО может снизить стоимость вычислений и хранения данных на 80 % при лучшем сценарии. Компания сохранила прибыльность и, как сообщает её пресс-служба, расширила присутствие в регионах EMEA и APAC. Теперь она намерена использовать полученные средства, чтобы нанять новых разработчиков для расширения функциональности платформы.

23.01.2025 [20:21], Владимир Мироненко

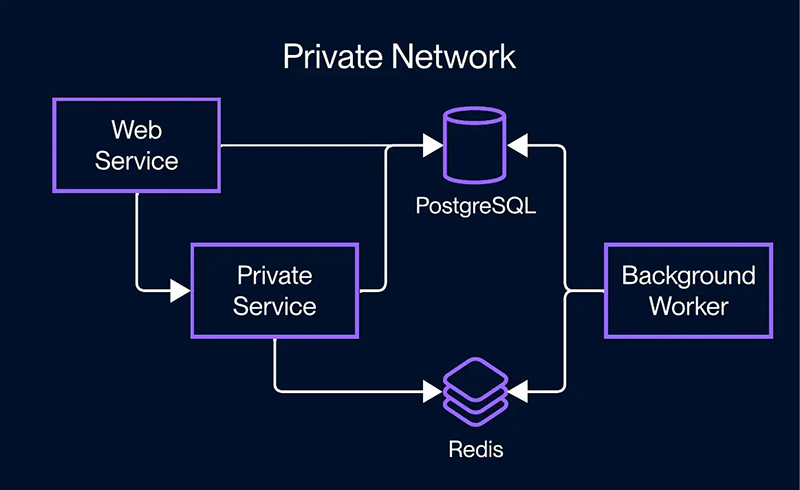

Стартап Render, готовый бросить вызов традиционным облакам, привлёк $80 млн на развитие своей платформы для разработчиковСтартап Render Services объявил о привлечении $80 млн инвестиций в рамках раунда финансирования серии C, доведя общий объём финансирования до $157 млн. Раунд возглавила Georgian. Также в нём приняли участие 01A, Avra наряду с существующими инвесторами Addition, Bessemer Venture Partners, General Catalyst и South Park Commons Fund. Также стартап сообщил о том, что количество разработчиков, использующих его платформу, превысило 2 млн. Как утверждает Render, с помощью его платформы разработчикам гораздо проще запускать приложения, сервисы и веб-сайты в облачной инфраструктуре по сравнению с традиционными платформами, такими как AWS. Платформа Render устраняет необходимость для разработчиков разбираться со сложными конфигурациями и настройками облачных инфраструктур. Она автоматизирует рутинные задачи по управлению инфраструктурой, позволяя разработчикам сосредоточиться исключительно на своих приложениях. Разработчикам достаточно подключить свой репозиторий GitHub или GitLab, и платформа тут же предложит команды для развёртывания приложения.

Источник изображения: Render Основатель и гендиректор Render Анураг Гоэл (Anurag Goel) сообщил SiliconANGLE, что платформа компании гибче, чем традиционные бессерверные решения, и способна поддерживать гораздо более полный набор рабочих нагрузок, в том числе выполняющихся очень долго. Он отметил, что многие клиенты переходят на платформу Render с других платформ, потому что им нужно использовать LLM API и веб-сокеты, а традиционные FaaS и бессерверные решения не отвечают их потребностям. В числе преимуществ Render Гоэл назвал более быстрое развёртывание и возможность простого масштабирования. Render автоматизирует необходимую подготовку инфраструктуры, не заставляя разработчиков возиться с настройкой Kubernetes или других сред, говорит глава стартапа. Также у платформы Render ниже стоимость владения по сравнению с конкурентами. Хольгер Мюллер (Holger Mueller) из Constellation Research отметил, что Render облегчает работу разработчиков, поскольку большинство публичных облаков стали невероятно сложными в управлении и эксплуатации. «Управление инфраструктурой отнимает у разработчиков много времени и ресурсов, поэтому приятно видеть альтернативу, такую как Render, которая справляется с этим», — заявил аналитик.

21.12.2024 [14:00], Сергей Карасёв

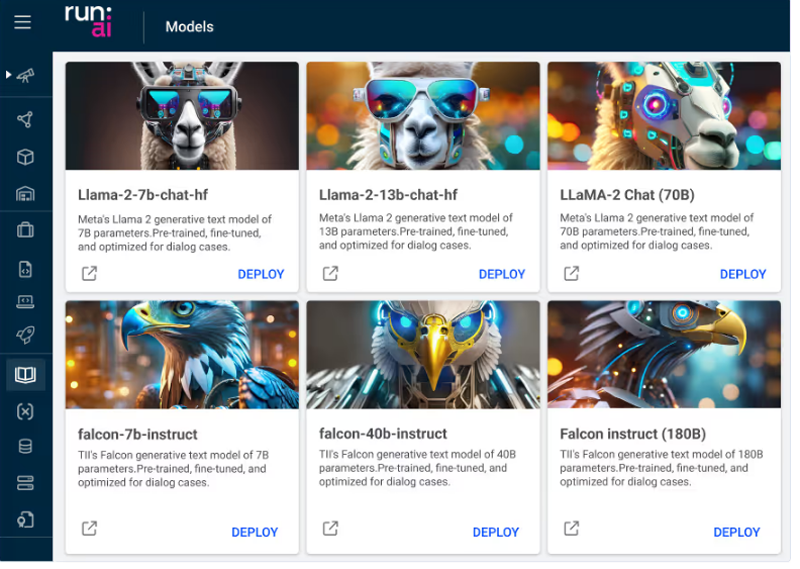

Еврокомиссия разрешила NVIDIA купить израильский стартап Run:aiЕвропейская комиссия одобрила сделку по приобретению компанией NVIDIA стартапа Run:ai из Тель-Авива (Израиль), который специализируется на разработке ПО для управления рабочими нагрузками ИИ и оркестрации на базе Kubernetes. Регуляторы пришли к выводу, что слияние не создаст проблем с конкуренцией в Европейской экономической зоне. Стартап Run:ai основан в 2018 году. В марте 2022-го он получил $75 млн в ходе раунда финансирования Series C. Компания создаёт специализированные инструменты, которые позволяют более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями. NVIDIA объявила о планах по поглощению Run:ai в апреле нынешнего года. Тогда говорилось, что стоимость сделки может составлять до $1 млрд. Вместе с тем израильская газета Calcalist оценила актив в $700 млн. Изучением возможных последствий слияния занялись регулирующие органы в США и Европе. В частности, американское Министерство юстиции заподозрило, что NVIDIA покупает Run:ai с тем, чтобы в дальнейшем «похоронить» технологии этого стартапа. Дело в том, что платформа Run:ai позволяет уменьшить потребность в вычислительных ресурсах при работе с ИИ, а следовательно, снизить количество необходимых ускорителей. Это может привести к тому, что некоторые клиенты станут покупать меньше продуктов NVIDIA.

Источник изображения: Run:ai Еврокомиссия дала сделке зелёный свет. В официальном заявлении регулятора сказано, что деятельность NVIDIA и Run:ai не пересекается. Подчёркивается, что NVIDIA занимает доминирующее положение на мировом рынке GPU. Однако у этой компании не будет «ни технических возможностей, ни стимулов для того, чтобы препятствовать совместимости своих GPU с конкурирующим ПО для оркестрации». Кроме того, как отмечается, Run:ai сейчас «не занимает существенной позиции» на рассматриваемом рынке ПО. Клиенты по-прежнему будут иметь доступ к альтернативным продуктам с функциями, аналогичными тем, что предлагает Run:ai. «Комиссия пришла к выводу, что предлагаемое приобретение не вызовет проблем с конкуренцией ни на одном из рассмотренных рынков в Европейской экономической зоне. Поэтому сделка безоговорочно одобрена», — сказано в заявлении регулятора.

18.07.2024 [18:23], Руслан Авдеев

Четвёртый за год: NVIDIA приобрела ещё один облачный стартап — Brev.devNVIDIA приобрела стартап, помогающий ИИ-разработчикам найти среди предложений облачных провайдеров наиболее подходящий по соотношению цена/качество доступ к ускорителям. Как сообщает портал CRN, это уже четвёртая заметная покупка NVIDIA с начала года. Представитель NVIDIA подтвердил, что сделка по приобретению Brev.dev действительно состоялась, но сумму и условия сделки не сообщил. Brev.dev предоставляет платформу для создания, обучения и внедрения ИИ-моделей в облаках. Целью Brev.dev, по словам самого стартапа, является поиск простейшего способа использования ускорителей для разработчиков систем ИИ и машинного обучения. Сотрудничество с NVIDIA обеспечит выполнение этой миссии, с комбинацией максимально возможно производительной аппаратной составляющей с самым передовым программным обеспечением. На сайте Brev.dev официальными партнёрами стартапа названы NVIDIA, Intel и AWS. Там же говорится, что платформа служит единым интерфейсом для взаимодействия AWS, Google Cloud Platform, Fluidstack и прочими облаками с ИИ-ускорителями. Это позволяет разработчикам искать подходящие инстансы на основе их цены и доступности. Хотя NVIDIA поставляет GPU и ИИ-ускорители облачным провайдерам более десяти лет, в последние годы компания уделяет немало внимания расширению собственного бизнеса в сфере облачных инфраструктур.

Источник изображения: NVIDIA В прошлом году компания запустила сервис DGX Cloud, который развёрнут в облачной инфраструктуре других провайдеров и на собственных мощностях и ИИ-суперкомпьютерах. Ранее в этом году NVIDIA купила ещё два стартапа для развития возможностей DGX Cloud. В конце апреля компания анонсировала покупку израильского стартапа Run:ai, занимающегося решениями для оркестрации ИИ-инфраструктур. Его планируется интегрировать в DGX Cloud, а также с DGX- и HGX-серверами. По имеющимся данным, покупка Run:ai обошлась в $700 млн. Практически одновременно с Run:ai компания приобрела ещё один израильский стартап — Deci, предлагающий ПО, способное на любом железе ускорить инференс ИИ-моделей, сохраняя точность данных. Сделку, по слухам, оценили приблизительно в $300 млн. Наконец, месяц назад NVIDIA купила калифорнийский стартап Shoreline.io, основанный бывшим управленцем AWS — компания разрабатывает ПО для автоматического устранения проблем в инфраструктуре ЦОД. По некоторым данным, команда Shoreline присоединилась к DGX Cloud, а покупка обошлась в $100 млн.

24.04.2024 [23:45], Владимир Мироненко

NVIDIA приобрела за $700 млн платформу оркестрации ИИ-нагрузок Run:aiКомпания NVIDIA объявила о приобретении стартапа Run:ai из Тель-Авива (Израиль), занимающегося разработкой ПО для управления рабочими нагрузками и оркестрации на базе Kubernetes, которое позволяет более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями. Стоимость сделки не раскрывается. По данным TechCrunch, покупка обошлась NVIDIA в $700 млн. Это одно из крупнейших приобретений Nvidia с момента покупки Mellanox за $6,9 млрд в марте 2019 года. Два года назад NVIDIA купила Bright Computing, разработчика решений для управления НРС-кластерами. NVIDIA отметила, что развёртывание ИИ-приложениЙ становится всё более сложным. Оркестрация генеративного ИИ, рекомендательных и поисковых систем, а также других рабочих нагрузок требует сложного планирования для оптимизации производительности. ПО Run:ai позволяет управлять и оптимизировать вычислительную инфраструктуру как локально, так и в облаке или в гибридных средах.

Источник изображения: NVIDIA Созданная стартапом открытая платформа поддерживает все популярные варианты Kubernetes и интегрируется со сторонними инструментами и платформами ИИ. Компании из различных отраслей используют платформу Run:ai для управления кластерами ускорителей в масштабе ЦОД. Как сообщается, на относительно раннем этапе деятельности Run:ai удалось создать большую клиентскую базу из компаний из списка Fortune 500, что позволило привлечь венчурные инвестиции. Перед сделкой Run:ai привлекла капитал в размере $118 млн от ряда инвесторов, включая Insight Partners, Tiger Global, S Capital и TLV Partners. NVIDIA заявила, что в ближайшем будущем продолжит предлагать продукты Run:ai в рамках той же бизнес-модели, а также продолжит инвестировать в развитие Run:ai в рамках платформы NVIDIA DGX Cloud, предоставляющей корпоративным клиентам доступ к вычислительной инфраструктуре и ПО для обучения моделей генеративного и других форм ИИ. Решения Run:ai уже интегрированы с NVIDIA DGX, NVIDIA DGX SuperPOD, NVIDIA Base Command, контейнерами NGC, ПО NVIDIA AI Enterprise и другими продуктами. По словам NVIDIA, пользователи серверов и рабочих станций NVIDIA DGX, а также DGX Cloud также получат доступ к возможностям Run:ai, что особенно полезно при развёртывании генеративного ИИ в нескольких ЦОД.

11.01.2024 [13:34], Андрей Крупин

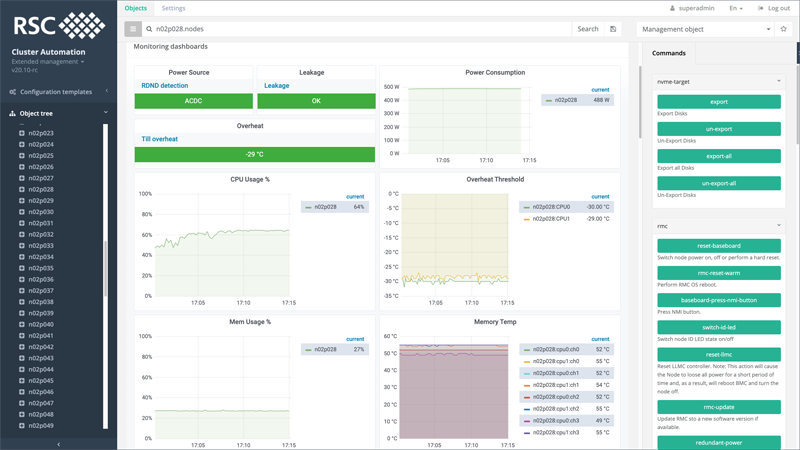

Система «РСК БазИС 4» для мониторинга и управления кластерами включена в реестр отечественного ПОКомпания «РСК Технологии» сообщила о включении в реестр отечественного программного обеспечения платформы «РСК БазИС» (RSC BasIS). «РСК БазИС» представляет собой набор интегрированных друг с другом компонентов с открытыми исходным кодом. Система предназначена для автоматизации задач управления и обслуживания кластерного высокопроизводительного вычислительного комплекса (суперкомпьютера, центра обработки данных), в том числе с помощью интуитивно понятного веб-интерфейса. Ядром продукта является централизованная база данных объектов управления и методов работы с ними, основанная на использовании иерархических топологий. Отличительными особенностями «РСК БазИС» являются единая расширяемая экосистема микросервисов, функционирующих с использованием технологий контейнеризации, система управления конфигурациями ресурсов на основе настраиваемых шаблонов, а также встроенные инструменты инженерного мониторинга, обеспечивающие сбор, обработку и отображение критически важных параметров состояния объектов управления.  В сочетании с аппаратными платформами «РСК Технологии» программный комплекс «РСК БазИС» позволяет создавать гиперконвергентные решения для высокопроизводительных вычислений и эффективной обработки больших объёмов данных. Включение в реестр подтверждает российское происхождение системы «РСК БазИС» и позволяет коллективу разработчиков компании «РСК Технологии» рассчитывать на государственные меры поддержки, оказываемой поставщикам отечественного ПО. На сегодняшний день в реестре российского ПО зарегистрированы более 19,8 тысяч продуктов. С полным перечнем представленных в реестре программных решений можно ознакомиться на сайте Министерства цифрового развития, связи и массовых коммуникаций Российской Федерации. |

|