Материалы по тегу: hpc

|

25.06.2024 [17:01], Сергей Карасёв

Второй в Европе экзафлопсный суперкомпьютер Alice Recoque разместится во Франции, а его создание обойдётся в €544 млнЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о подписании соглашения с французским национальным агентством высокопроизводительных вычислений (GENCI) о размещении второго в Европе суперкомпьютера экзафлопсного класса. Напомним, первым европейским HPC-комплексом с производительностью более 1 Эфлопс станет Jupiter, который расположится в Юлихском исследовательском центре (FZJ) в Германии. В создании системы участвуют NVIDIA, ParTec, Eviden и SiPearl. В состав суперкомпьютера войдут модули NVIDIA Quad GH200, а также энергоэффективные высокопроизводительные Arm-процессоры SiPearl Rhea. Машина будет развёрнута на базе модульного ЦОД. Ввод в эксплуатацию запланирован в 2024 году. Второй в Европе экзафлопсный суперкомпьютер получил имя Alice Recoque) — в честь французского учёного, компьютерного инженера и специалиста по компьютерной архитектуре. Она работала над созданием мини-компьютеров в 1970-х годах и руководила исследованиями, связанными с ИИ. Стоимость создания машины оценивается в €544 млн. Управление суперкомпьютером возьмёт на себя Французская комиссия по альтернативным источникам энергии и атомной энергии (CEA). Комплекс будет смонтирован на территории Брюйер-ле-Шатель, к юго-западу от Парижа. Для размещения и эксплуатации машины выбран французско-нидерландский консорциум Жюля Верна. Известно, что в основу суперкомпьютера ляжет модульная энергоэффективная архитектура. По мере необходимости в состав системы могут добавляться дополнительные узлы на базе GPU или квантовых процессоров. Комплекс, в частности, будет построен на Arm-чипах SiPearl Rhea2, которые в настоящее время находятся в разработке. Не исключается также применения высокопроизводительных RISC-V процессоров EPI EPAC. Запуск Alice Recoque предварительно намечен на 2026 год, но может затянуться до 2027–2028 гг. Система будет доступна академическим организациям, государственным структурам и промышленным предприятиям. Использовать её планируется для выполнения ресурсоёмких задач в области ИИ и НРС.

21.06.2024 [12:05], Сергей Карасёв

«ИИ-гигафабрику» для xAI построят Dell и SupermicroОборудование для мощнейшего ИИ-суперкомпьютера компании xAI, курируемой Илоном Маском (Elon Musk), как сообщает Datacenter Dynamics, будут поставлять Dell и Supermicro. Речь идёт о серверах, оборудованных высокопроизводительными ускорителями NVIDIA. После анонса акции обеих компаний выросли в цене. Напомним, что xAI реализует проект по созданию самого мощного в мире вычислительного комплекса, ориентированного на задачи ИИ. Строительство суперкомпьютера будет осуществляться в несколько этапов. Так, в ближайшее время должна быть запущена система, содержащая 100 тыс. ускорителей NVIDIA H100. А летом 2025 года планируется ввести в эксплуатацию кластер из 300 тыс. новейших ускорителей NVIDIA B200. О том, что участие в масштабном проекте xAI принимает корпорация Dell, сообщил её генеральный директор Майкл Делл (Michael Dell). Эти сведения подтвердил и сам Маск: по его словам, Dell «соберёт половину стоек, которые войдут в состав суперкомпьютера». За строительство оставшейся части системы будет отвечать Supermicro. По имеющейся информации, огромный дата-центр xAI, прозванный «ИИ-гигафабрикой», расположится в окрестностях Мемфиса (штат Теннесси). О том, в какой пропорции работы по строительству машины будут распределены между Dell и Supermicro, на данный момент нет. Стоимость проекта оценивается в миллиарды долларов. xAI в настоящее время арендует около 16 тыс. ускорителей NVIDIA H100 в облаке Oracle Cloud, а также использует веб-сервисы Amazon и свободные мощности на ЦОД-площадках X/Twitter. В мае 2024 года стартап осуществил раунд финансирования Series B, в ходе которого было привлечено $6 млрд. В результате, рыночная стоимость xAI достигла $24 млрд. Создаваемый суперкомпьютер будет использоваться в том числе для поддержания работы чат-бота xAI Grok следующего поколения.

17.06.2024 [22:49], Илья Коваль

Три квантовых компьютера, NVIDIA DGX Quantum, немножко HPC и облако: в Израиле открыт уникальный центр квантовых вычислений IQCC

aws

gh200

grace

hardware

hpc

nvidia

quantum machines

израиль

квантовые вычисления

квантовый компьютер

облако

разработка

Стартап Quantum Machines, разработчик систем управления квантовыми компьютерами, открыл Израильский центр квантовых вычислений (Israeli Quantum Computing Center, IQCC). Площадка, создание которой было частично профинансировано правительством страны, располагается в Тель-Авивском университете. По словам основателей, это первый в мире центр, располагающий квантовыми компьютерами разных типов, которые интегрированы с системой NVIDIA DGX Quantum, HPC-инфраструктурой и облаком. Приоритетный доступ со скидкой получат исследовательские организации Израиля, но в целом центр будет открыт для компаний со всего света. Как говорят создатели, IQCC — это лучший в мире полигон для создания новых технологий в области квантовых вычислений, а открытая архитектура площадки позволяет регулярно проводить обновления и упрощает дальнейшее масштабирование возможностей и вычислительных мощностей. Сейчас в IQCC установлены 21-кубитный компьютер Galilee от Quantware на сверхпроводящих кубитах (ещё один такой же используется в качестве тестовой платформы) и фотонный компьютер Negev от ORCA (8 кумод). Системы управляются контроллерами OPX1000 от самой Quantum Machines. HPC-инфраструктура представлена DGX A100, четырьмя GH200 и 128 vCPU на базе AMD EPYC 9334 (Genoa). Дополнительные ресурсы можно арендовать в облаке AWS. Для Galilee и Negev доступна интеграция с DGX Quantum, платформой для гибридных квантово-классических вычислений, которая была создана NVIDIA и Quantum Machines и впервые в мире развёрнута именно в IQCC. Управлять компьютерами и разрабатывать ПО можно с использованием Qiskit, QUA, OpenQASM3, QBridge, а также Classiq. К системе организован облачный доступ. В ближайшие месяцы в IQCC будут развёрнуты ещё несколько квантовых компьютеров и QPU.

16.06.2024 [16:25], Сергей Карасёв

Холодный приём: новый национальный суперкомпьютер Норвегии разместят в руднике и охладят водой из фьордаВласти Норвегии, по сообщению ресурса HPC Wire, подписали контракт стоимостью Kr225 млн ($21 млн) с корпорацией HPE, предусматривающий создание нового национального суперкомпьютера A2 (постоянное имя системе дадут позже). Он станет самым мощным в истории страны и значительно ускорит исследования и разработки в различных областях, в том числе в сфере ИИ. За закупку и эксплуатацию НРС-систем в Норвегии отвечает государственная компания Sigma2 AS. Вычислительные услуги предоставляются в сотрудничестве с университетами Бергена, Осло, Тромсё, а также Норвежским университетом естественных и технических наук (NTNU) в рамках проекта NRIS. В основу нового суперкомпьютера ляжет платформа HPE Cray EX4000. Известно, что в состав комплекса войдут 76 узлов с четырьмя гибридными суперчипами NVIDIA GH200 (всего 304 ускорителя), 252 узла с двумя 128-ядерными AMD EPYC Turin (64 512 ядер) и 5,3-Пбайт хранилище HPE Cray ClusterStor E1000. Узлы объединит интерконнект HPE Slingshot. Ожидаемая производительность системы составит порядка 10 Пфлопс. Монтаж системы планируется выполнить в течение весны–лета 2025 года. Машина расположится в дата-центре Лефдаль (Lefdal Mine Datacenter, LMD), развёрнутом на базе бывшего рудника. Этот объект имеет большую площадь и предоставляет гибкие возможности в плане масштабирования. Новый суперкомпьютер HPE станет первой национальной высокопроизводительной системой, установленной в этом ЦОД.

Источник изображения: Sigma2 Несмотря на то, что готовящийся комплекс будет значительно мощнее высокопроизводительных вычислительных систем Sigma2 предыдущего поколения, его энергопотребление окажется меньше примерно на 30 %. Для охлаждения будет использоваться холодная вода из близлежащего фьорда. Нагретая вода затем может быть направлена на нужды местных предприятий, в том числе, например, рыбных ферм. Ожидается, что суперкомпьютер сможет удовлетворить потребности Норвегии в НРС-ресурсах в течение следующих пяти лет. Он будет доступен исследователям по всей стране. В дальнейшем суперкомпьютер может дополнительно получить 119 808 CPU-ядер и/или 224 ускорителя. В целом же Норвегия рассчитывает, что современные ЦОД станут для страны «новой нефтью».

15.06.2024 [18:04], Владимир Мироненко

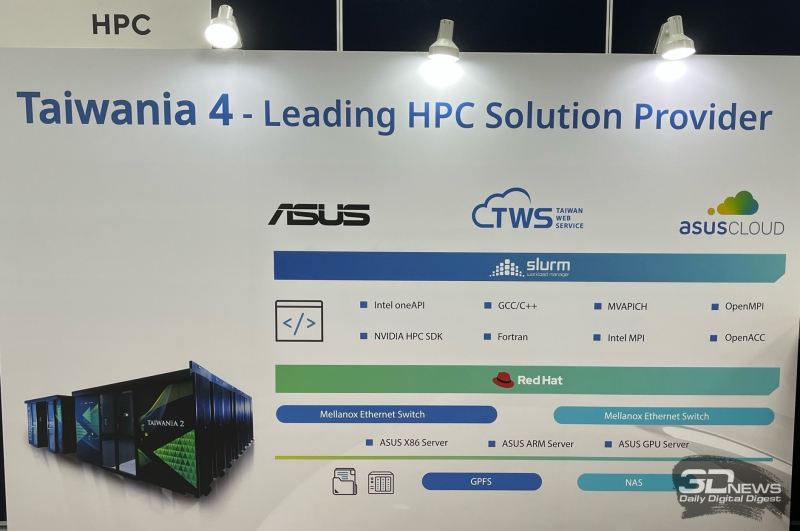

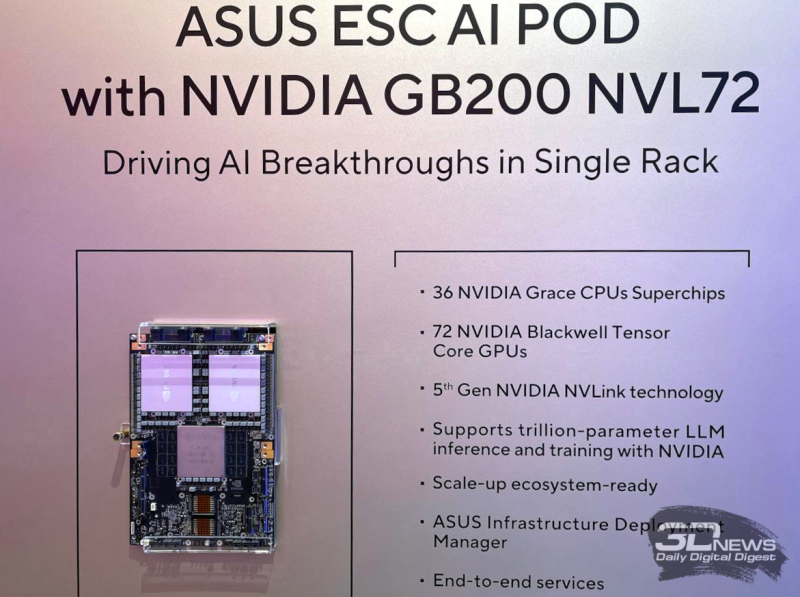

ASUS осваивает строительство суперкомпьютеров, ЦОД и комплексных ИИ-системПроизводитель потребительской электроники ASUS уже давно работает на рынке серверов и ЦОД. Пока он занимает на нём не очень большую долю, но как сообщил ресурсу The Register старший вице-президент ASUS Джеки Сюй (Jackie Hsu), высокопроизводительных вычислений (HPC) и серверов стал для компании «областью большого роста». Сюй рассказал, что ASUS участвовала в строительстве на Тайване суперкомпьютера Taiwania 2 производительностью 9 Пфлопс, занявшего в рейтинге TOP500 двадцатую позицию после дебюта в 2018 году. А в прошлом году ASUS выиграла тендер на участие в создании суперкомпьютера Taiwania 4. Сюй сообщил, что ASUS построила ЦОД для Taiwania 4. Причём PUE новой площадки составляет 1,17, что является неплохим показателем для любого подобного объекта, а тем более для Тайваня, отличающегося климатом с высокими температурой и влажностью. Также ASUS участвовала в ряде проектов в области ИИ, включая разработку собственной большой языковой модели (LLM) Formosa Foundation со 176 млрд параметров. Модель была обучена на наборах данных на местном языке для генерации текста с традиционной китайской семантикой. Благодаря накопленному опыту ASUS начала предлагать услуги на рынке ИИ. Компания уже заключила несколько контрактов, в рамках которых она проектирует и создаёт мощные системы для работы с ИИ, предлагая большую часть программного и аппаратного стека, необходимого для обработки ИИ-нагрузок. Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) назвал ASUS в числе компаний, с кем NVIDIA будет сотрудничать в работе над созданием так называемых фабрик ИИ. На Computex 2024 компания представила новые серии серверов ASUS RS700-E12 и RS720-E12 с процессорами Intel Xeon 6, разработанные специально для обработки высокопроизводительных рабочих нагрузок, а также серверы хранения семейства VS320D, предназначенные для использования в составе инфраструктур SAN для работы с базами данных, системами виртуализации и пр. Также ASUS представила ИИ-систему ESC AI POD на базе суперускорителей NVIDIA GB200 NVL72.

14.06.2024 [14:05], Сергей Карасёв

Срок эксплуатации суперкомпьютеров растёт, несмотря на прекращение поддержки оборудованияНаучные учреждения и организации, по сообщению HPC Wire, увеличивают период эксплуатации установленных суперкомпьютеров, несмотря на то что их поставщики прекращают поддержку соответствующего оборудования. В результате, срок службы НРС-комплексов может достигать уже 10 лет. Типичный жизненный цикл суперкомпьютера составляет около пяти–шести лет. После этого требуется замена в связи с моральным устареванием, а также в свете появления более производительных и энергоэффективных компонентов. Кроме того, по прошествии примерно пяти лет дальнейшее обслуживание оборудования обычно становится слишком дорогим. Однако японский Институт физико-химических исследований (RIKEN) намерен эксплуатировать существующую систему Fugaku в течение десяти лет. Этот вычислительный комплекс на базе Arm-процессоров Fujitsu A64FX в 2020 году стал самым производительным суперкомпьютером в мире. В текущем рейтинге ТОР500 система занимает четвёртое место с быстродействием приблизительно 442 Пфлопс. Таким образом, Fugaku продолжит активно использоваться вплоть до 2030 года, когда ожидается появление суперкомпьютера FugakuNEXT. Сатоши Мацуока (Satoshi Matsuoka), директор японского Центра вычислительных наук RIKEN, отметил, что зачастую НРС-системы всё ещё годны для эксплуатации спустя пять лет после запуска. Но организациям приходится устанавливать новые комплексы, поскольку производители попросту прекращают поддержку имеющихся платформ. Мацуока подчёркивает, что подобная практика должна быть прекращена. Ливерморская национальная лаборатория им. Э. Лоуренса (LLNL) Министерства энергетики США также заявляет о том, что некоторые её НРС-системы служат в течение 7–10 лет. Большое значение для продления срока службы суперкомпьютеров имеет оптимизация ПО. Отмечается, что средний возраст систем в списке ТОР500 по состоянию на июнь 2024 года составляет около 35 месяцев, что является рекордным показателем. Для сравнения: в период с 1995 по 2011 год это значение варьировалось в среднем от 5 до 10 месяцев. В целом, суперкомпьютеры эксплуатируются дольше, поскольку создание новых систем обходится очень дорого. А некоторые эксперты полагают, что нынешнее поколение сверхкрупных машин и вовсе будет последним в своём роде.

11.06.2024 [11:55], Сергей Карасёв

ParTec обвинила Microsoft в нарушении патентов в области ИИ-суперкомпьютеровНемецкая компания по производству суперкомпьютерного оборудования ParTec и её лицензионный агент BF exaQC AG, по сообщению ресурса HPC Wire, подали иск против Microsoft. Редмондская корпорация обвиняется в нарушении патентов на технологии, которые применяются при создании мощных современных суперкомпьютеров для задач ИИ. В материалах дела речь идёт о разработках, связанных с динамической модульной системной архитектурой (dMSA). Технология обеспечивает эффективное взаимодействие CPU, GPU и других чипов в составе НРС-систем. Отмечается, что dMSA имеет основополагающее значение при построении мощных вычислительных комплексов для обучения ИИ-моделей и инференса. Важность патентов ParTec AG подтверждается использованием соответствующих разработок в ведущих европейских суперкомпьютерах, таких как Leonardo в Болонье (Италия), Jupiter в Юлихе (Германия) и Meluxina в Люксембурге. Все они построены с применением dMSA и признаны новаторскими платформами, говорит компания.

Источник изображения: pixabay.com Кроме того, ParTec ведёт переговоры о лицензировании своих технологий с известным американским производителем чипов. А с властями США компания обсуждает возможность использования разработок в строящемся крупнейшем в мире суперкомпьютере экзафлопсного уровня. Вероятно, имеется в виду система El Capitan, которая обеспечит производительность более 2 Эфлопс (FP64). Ввод комплекса в эксплуатацию намечен на середину нынешнего года. В рамках разбирательства с Microsoft компания ParTec просит суд наложить запрет на дальнейшее незаконное использование запатентованных технологий. Кроме того, немецкий разработчик требует обязать ответчиков выплатить компенсацию. Корпорация Microsoft ситуацию никак не комментирует.

07.06.2024 [15:42], Руслан Авдеев

«ИИ-гигафабрика» xAI разместится в гигантском дата-центре в ТеннесиИИ-стартап xAI, курируемый Илоном Маском (Elon Musk), намерен построить гигантский дата-центр с самым производительным в мире ИИ-суперкомпьютером. По данным Datacenter Dynamics, ЦОД разместится в окрестностях Мемфиса (штат Теннесси), а пока ожидает одобрения властей. В обозримом будущем компания должна получить сотни тысяч ускорителей для обучения новых моделей, в частности, чат-бота Grok, предлагаемого, например, по подписке в социальной сети X (Twitter). Ранее в Сеть утекла информация, что NVIDIA передаст xAI чипы, изначально предназначавшиеся для Tesla — Маск весьма вольно распоряжается активами подконтрольных ему бизнесов, часто вызывая недовольство инвесторов. Пока проект ожидает окончательного разрешения от местного бизнес-инкубатора Memphis Shelby County Economic Development Growth Engine (EDGE), а также муниципальных и федеральных властей. Впрочем, гораздо важнее дождаться одобрения энергетической компании Tennessee Valley Authority (TVA). Реализация проекта сулит появление высокооплачиваемых рабочих мест и увеличение доходов штата, что поможет поддерживать и модернизировать местную инфраструктуру. Муниципальные власти уже назвали проект «крупнейшей мультимиллиардной инвестицией в истории Мемфиса, а Маск окрестил ЦОД «гигафабрикой для вычислений» по аналогии с Tesla Gigafactory. По данным местных СМИ, приглянувшаяся Маску площадка принадлежит инвесткомпании Phoenix Investors, сотрудничающей с xAI и местными властями. Ранее объект управлялся компанией Electrolux. Неизвестно, насколько масштабной будет первая фаза проекта и сколько средств на неё потратят. Ранее Маск заявлял, что xAI развернёт в ближайшие месяцы 100 тыс. ускорителей NVIDIA H100, а кластер из ещё 300 тыс. B200 введут в эксплуатацию следующим летом. Считается, что xAI арендует около 16 тыс. H100 у Oracle Cloud, также компания пользуется услугами AWS и свободными мощностями X (Twitter).

06.06.2024 [13:37], Сергей Карасёв

QCT анонсировала серверы QuantaGrid на базе AMD EPYC 9004 для ИИ и НРСКомпания Quanta Cloud Technology (QCT) представила серверы семейства QuantaGrid на аппаратной платформе AMD EPYC 9004 (Genoa). Новинки предназначены для облачных приложений, задач ИИ и НРС. В частности, дебютировали модели QuantaGrid S44NL-1U и QuantaGrid D44N-1U типоразмера 1U. Они рассчитаны на установку соответственно одного и двух процессоров EPYC 9004 с показателем TDP до 400 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-4800. В зависимости от варианта исполнения возможно использование 12 накопителей SFF NVMe/SATA/SAS SSD или 12/16 устройств E1.S NVMe SSD. Опционально могут монтироваться два модуля M.2 2230/2280 с интерфейсом PCIe 3.0.

Источник изображений: QCT Слоты расширения могут быть выполнены по схеме 3 × PCIe 5.0 x16 HHHL и 2 × PCIe 5.0 x16 OCP 3.0 SFF, 2 × PCIe 5.0 x16 HHHL и 2 × PCIe 5.0 x16 OCP 3.0 SFF или 2 × PCIe 5.0 x16 FHHL и 2 × PCIe 5.0 x16 OCP 3.0 SFF. Доступен выделенный сетевой порт управления 1GbE. В оснащение входит контроллер AST2600. Допускается развёртывание системы жидкостного охлаждения. Питание обеспечивают два блока с сертификатом 80 PLUS Titanium мощностью до 1600 Вт у младшей версии и до 2000 Вт у старшей.  Кроме того, представлен мощный сервер QuantaGrid D74A-7U формата 7U. Он рассчитан на два процессора EPYC 9004 с TDP до 400 Вт. Во фронтальной части находятся 18 отсеков для SFF-накопителей NVMe. В максимальной конфигурации могут быть задействованы восемь ускорителей в составе платы NVIDIA HGX H100. Реализованы два слота PCIe 5.0 x16 OCP 3.0 SFF и десять слотов PCIe 5.0 x16 OCP 3.0 TSFF. В оснащение включён выделенный сетевой порт управления 1GbE.

06.06.2024 [08:19], Илья Коваль

Supermicro: использование СЖО вырастет на тысячи процентов в ближайшие два годаГлава Supermicro Чарльз Лян (Charles Liang) ожидает, что 30 % стоек, которые компания поставит в следующем году, будут оснащены СЖО. Как передаёт The Register, компания теперь способна выпускать до 1 тыс. стоек с СЖО ежемесячно и готова отправлять их клиентам всего через 2–4 недели после получения заказа, хотя ранее сроки поставок такого оборудования могли составлять от четырёх месяцев до одного года. Уже в этом году 15 % отгруженных компанией стоек будут оснащены СЖО, а в 2025 году этот показатель удвоится. По словам Ляна, настал звёздный час СЖО, хотя за предыдущие 30 лет эта технология смогла завоевать только 1 % рынка. Естественно, взрывной рост связан активным освоением генеративного ИИ, который требует всё большего количества всё более плотно упакованных ускорителей, для которых TDP на уровне 1 кВт становится нормой. DLC-системы Supermicro позволяют добиться плотности 80–100 кВт на стойку. При этом Лян снова повторяет всё те же тезисы, что звучали уже не раз. Так, СЖО позволят частично избавиться от не слишком подходящего при таких TDP воздушного охлаждения, сэкономить место в стойках, повысить общую «продуктивность» и энергоэффективность ЦОД, а значит — ещё больше приблизиться к идеалам устойчивого развития и экологичности индустрии в целом. Компания готовит 4U-платформы с СЖО для HGX B200, но предложит и 10U-вариант с воздушным охлаждением. Также стоит ожидать «воздушную» систему на базе HGX B100 и собственную реализацию GB200 NVL72. А чтобы удовлетворить растущий спрос на свои серверы, компания к концу году откроет в Малайзии новый завод, способный выпускать до 5 тыс. полностью укомплектованных стоек каждый месяц. |

|