Материалы по тегу: hbm

|

03.12.2024 [18:42], Руслан Авдеев

Довести до беспамятства: США запретили китайским структурам покупать HBM для ИИ-ускорителейУходящая администрация действующего президента США Джо Байдена (Joe Biden) объявила об ограничениях экспорта в Китай высокопроизводительной HBM-памяти, критически важной для производства ИИ-ускорителей. Запрет коснётся более сотни китайских организаций, сообщает The Register. Ограничения, обновлённые и анонсированные Бюро промышленности и безопасности (BIS) в минувший понедельник, препятствуют экспорту HBM в ряд стран, в частности — в КНР. Модули такой памяти производятся всего несколькими поставщиками в мире, включая южнокорейские Samsung и SK Hynix, а также американскую Micron. В модулях HBM применяются передовые технологии упаковки, недоступные КНР. В Китае активно ведутся работы по импортозамещению технологий. В частности, над собственными HBM-модулями трудится ChangXin Memory Technologies (CXMT). HBM чрезвычайно важна для обучения ИИ и инференса и гораздо эффективнее (G)DDR, хотя она дороже и потребляет больше энергии. В последних поколениях оборудования память порой даже важнее FP-производительности. Например, в версиях NVIDIA H200 и AMD MI325X HBM3 заменена на более быструю HBM3e. Особенно результаты заметны при эксплуатации больших языковых моделей (LLM). Однако для моделей поменьше достаточно более простых и доступных ускорителей NVIDIA и AMD с памятью GDDR. По новым правилам производители памяти должны будут получать специальные экспортные лицензии для продажи HBM китайскому бизнесу. Как показал опыт Cerebras и Groq, при выполнении некоторых технических условий можно обойтись и SRAM. Оба разработчика добились отличных показателей при инференсе, даже в сравнении с решениями с HBM. Пока неизвестно, сможет ли SMIC предложить собственное решение аналогичного класса. В любом случае, запрет на экспорт в Китай HBM не означает завершение масштабных китайских ИИ-проектов. При Байдене США уже ввели множество ограничений на экспорт, чтобы лишить Китай доступа к технологиям, связанным с передовыми полупроводниками и ИИ-ускорителями, в том числе на поставки высокопроизводительных чипов и литографических EUV-машин для их выпуска. Тем не менее, успехи КНР в сфере ИИ ставят под сомнение эффективность санкций.

27.11.2024 [10:39], Владимир Мироненко

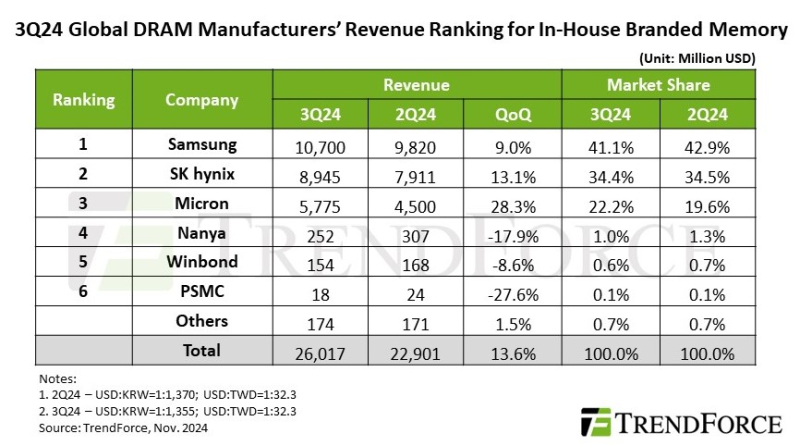

TrendForce: высокий спрос на память DDR5 и HBM для ЦОД подстегнул рост доходов отрасли в III кварталеСогласно оценкам аналитической компании TrendForce, в III квартале 2024 года глобальный доход производителей памяти DRAM достиг $26,02 млрд (последовательный рост на 13,6 %) на фоне растущего спроса на память DDR5 и HBM для ЦОД, несмотря на снижение поставок памяти LPDDR4 и DDR4 из-за сокращения запасов китайскими брендами смартфонов и расширения мощностей китайскими поставщиками DRAM. Как и в предыдущем квартале средняя цена продажи (ASP) продолжала расти, чему способствовало, в том числе, вытеснение памятью HBM производства обычной DRAM. При этом контрактные цены выросли на 8–13 %. В IV квартале TrendForce ожидает квартальный рост общих поставок DRAM в битах, полагая при этом, что ограничения мощностей, вызванные производством HBM, окажут более слабое, чем ожидалось, влияние на цены. Кроме того, расширение мощностей китайскими поставщиками может побудить производителей ПК и бренды смартфонов активно расходовать имеющиеся запасы, чтобы пополнять их более дешёвой DRAM. Это может привести к снижению контрактных цен на обычную DRAM.

Источник изображения: SK hynix Благодаря росту контрактных цен на DRAM для серверов и ПК в III квартале увеличились доходы трёх крупнейших производителей памяти. Samsung сохранила лидерство с доходом в $10,7 млрд, что на 9 % больше показателя предыдущего квартала. В связи со стратегическим снижением запасов LPDDR4 и DDR4 поставки компанией памяти в битах остались на уровне предыдущего квартала. На втором месте по-прежнему находится SK hynix с доходом в $8,95 млрд (последовательный рост на 13,1 %). Несмотря на рост поставок HBM3e, более слабые продажи LPDDR4 и DDR4 привели к снижению показателя поставок в битах на 1–3% в квартальном исчислении. Доход Micron вырос на 28,3 % в квартальном исчислении до $5,78 млрд благодаря значительному росту поставок серверной памяти DRAM и HBM3e, что привело к увеличению поставок в битах на 13 % по сравнению с предыдущим кварталом. Тайваньские поставщики DRAM, столкнувшиеся в III квартале с падением выручки, значительно отстали от тройки лидеров. У Nanya Technology было отмечено падение поставок в битах более чем на 20 % в квартальном исчислении из-за более слабого спроса на потребительскую DRAM и усиления конкуренции на рынке DDR4 со стороны китайских поставщиков. Операционная прибыль ещё больше снизилась (с -23,4 % до -30,8 %) из-за инцидента с отключением электроэнергии. Выручка Winbond снизилась в квартальном исчислении на 8,6 % до $154 млн на фоне падения спроса на потребительскую DRAM снизился, что также негативно отразилось на объёме поставок в битах. Наконец, PSMC сообщила о падении выручки от собственного производства потребительской DRAM на 27,6 %. Однако, с учётом полупроводникового производства, её общая выручка от поставок DRAM выросла на 18 % в квартальном исчислении, что обусловлено продолжающимся пополнением запасов клиентами в сфере производства полупроводников.

20.11.2024 [10:56], Сергей Карасёв

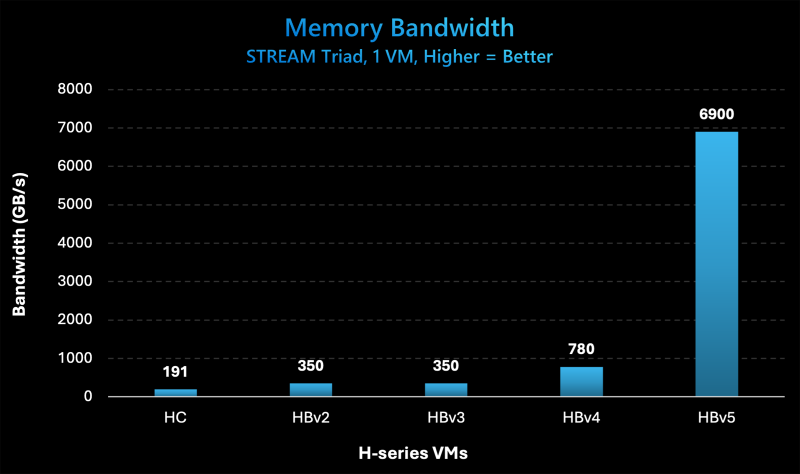

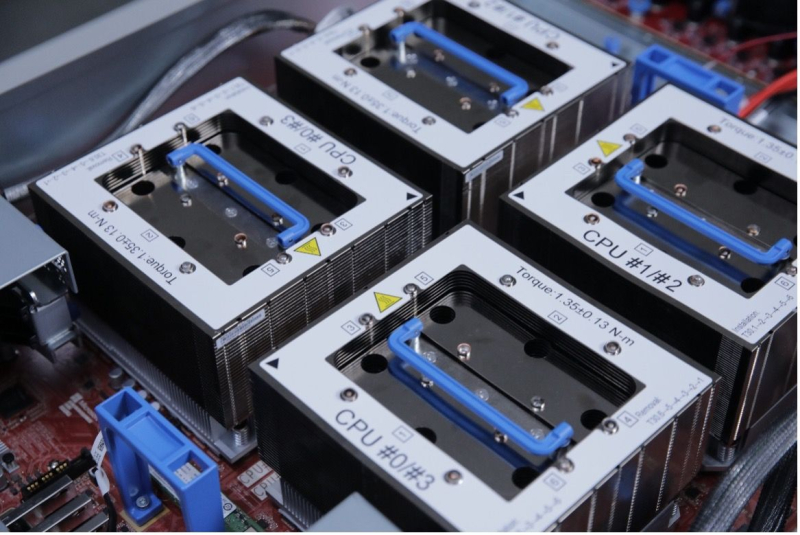

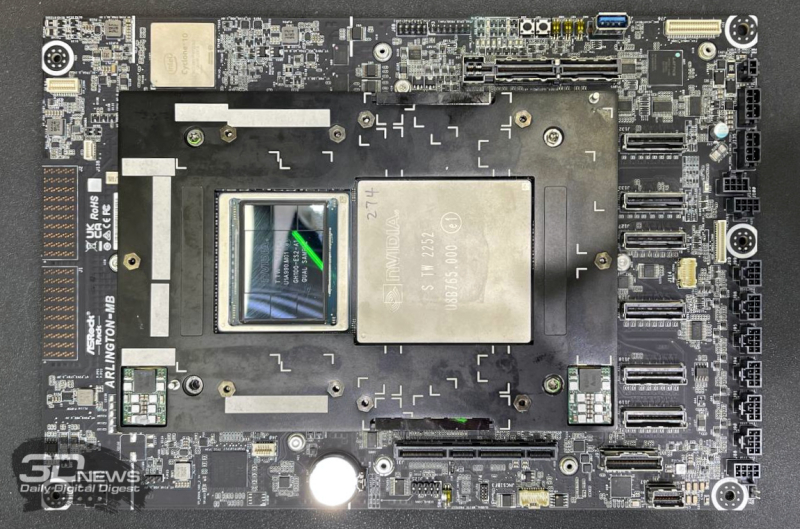

Microsoft представила инстансы Azure HBv5 на основе уникальных чипов AMD EPYC 9V64H с памятью HBM3Компания Microsoft на ежегодной конференции Ignite для разработчиков, IT-специалистов и партнёров анонсировала облачные инстансы Azure HBv5 для HPC-задач, которые предъявляют наиболее высокие требования к пропускной способности памяти. Новые виртуальные машины оптимизированы для таких приложений, как вычислительная гидродинамика, автомобильное и аэрокосмическое моделирование, прогнозирование погоды, исследования в области энергетики, автоматизированное проектирование и пр. Особенность Azure HBv5 заключается в использовании уникальных процессоров AMD EPYC 9V64H (поколения Genoa). Эти чипы насчитывают 88 вычислительных ядер Zen4, тактовая частота которых достигает 4 ГГц. Ближайшим родственником является изделие EPYC 9634, которое содержит 84 ядра (168 потоков) и функционирует на частоте до 3,7 ГГц. По данным ресурса ComputerBase.de, чип EPYC 9V64H также фигурирует под именем Instinct MI300C: по сути, это процессор EPYC, дополненный памятью HBM3. При этом клиентам предоставляется возможность кастомизации характеристик. Отметим, что ранее x86-процессоры с набортной памятью HBM2e были доступны в серии Intel Max (Xeon поколения Sapphire Rapids). Каждый инстанс Azure HBv5 объединяет четыре процессора EPYC 9V64H, что в сумме даёт 352 ядра. Система предоставляет доступ к 450 Гбайт памяти HBM3, пропускная способность которой достигает 6,9 Тбайт/с. Задействован интерконнект NVIDIA Quantum-2 InfiniBand со скоростью передачи данных до 200 Гбит/с в расчёте на CPU. Применены сетевые адаптеры Azure Boost NIC второго поколения, благодаря которым пропускная способность сети Azure Accelerated Networking находится на уровне 160 Гбит/с. Для локального хранилища на основе NVMe SSD заявлена скорость чтения информации до 50 Гбайт/с и скорость записи до 30 Гбайт/с. Отмечается, что по показателю пропускной способности памяти виртуальные машины Azure HBv5 примерно в 8 раз превосходят новейшие альтернативы bare-metal и cloud, в 20 раз опережают инстансы Azure HBv3 и Azure HBv2 (на базе EPYC Milan-X и EPYC Rome) и в 35 раз обходят HPC-серверы возрастом 4–5 лет, жизненный цикл которых приближается к завершению. Машины Azure HBv5 станут доступны в I половине 2025 года.

20.11.2024 [01:40], Владимир Мироненко

Microsoft представила кастомные чипы Azure Boost DPU и Integrated HSM, уникальный AMD EPYC 9V64H с HBM и собственный вариант NVIDIA GB200 NVL72

amd

azure arc

azure stack

dpu

epyc

gb200

hardware

hbm

hpc

microsoft

microsoft azure

nvidia

гибридное облако

ии

информационная безопасность

облако

ускоритель

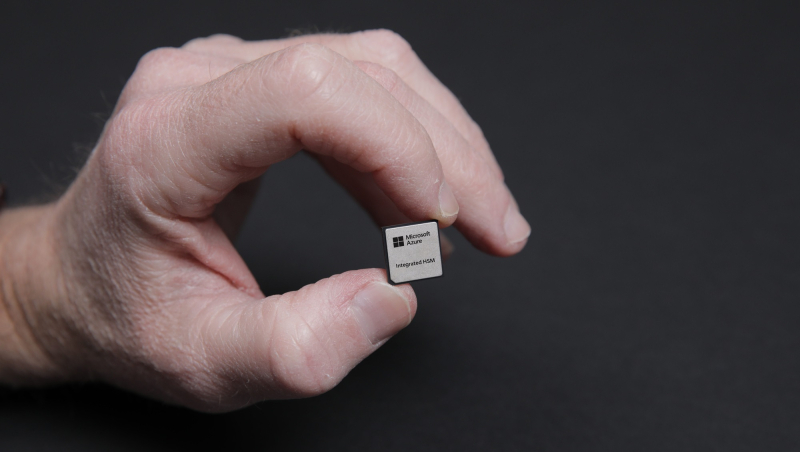

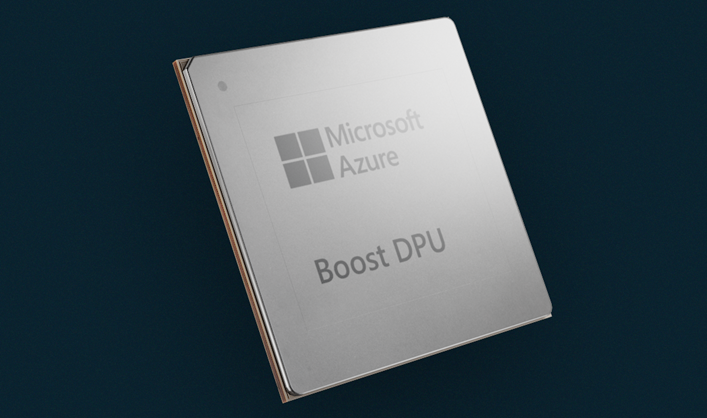

Microsoft представила на конференции Microsoft Ignite новые специализированные чипы Azure Boost DPU и Azure integrated Hardware Security Module (HSM), предназначенные для использования в ЦОД с целью поддержки рабочих нагрузок в облаке Azure и повышения безопасности.

Источник изображений: Microsoft Чтобы снизить зависимость от поставок чипов сторонних компаний, Microsoft занимается разработкой собственных решений для ЦОД. Например, на прошлогодней конференции Microsoft Ignite компания представила Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100 собственной разработки. Azure Boost DPU включает специализированные ускорители для работы с сетью и хранилищем, а также предлагает функции безопасности. Так, скорость работы с хранилищем у будущих инстансов Azure будет вчетверо выше, чем у нынешних, а энергоэффективность при этом вырастет втрое. Не вызывает сомнений, что в разработке Azure Boost DPU участвовали инженеры Fungible, производителя DPU, который Microsoft приобрела в декабре прошлого года. Как отмечает TechCrunch, в последние годы популярность DPU резко увеличилась. AWS разработала уже несколько поколений Nitro, Google совместно с Intel создала IPU, AMD предлагает DPU Pensando, а NVIDIA — BlueField. Есть и другие нишевые игроки. Согласно оценкам Allied Analytics, рынок чипов DPU может составить к 2031 году $5,5 млрд. Ещё один кастомный чип — Azure integrated Hardware Security Module (HSM) — отвечает за хранение цифровых криптографических подписей и ключей шифрования в защищённом модуле «без ущерба для производительности или увеличения задержки». «Azure Integrated HSM будет устанавливаться на каждом новом сервере в ЦОД Microsoft, начиная со следующего года, чтобы повысить защиту всего парка оборудования Azure как для конфиденциальных, так и для общих рабочих нагрузок», — заявила Microsoft. Azure Integrated HSM работает со всем стеком Azure, обеспечивая сквозную безопасность и защиту. Microsoft также объявила, что задействует ускорители NVIDIA Blackwell и кастомные серверные процессоры AMD EPYC. Так, инстансы Azure ND GB200 v6 будут использовать суперускорители NVIDIA GB200 NVL 72 в собственном исполнении Microsoft, а интерконнект Quantum InfiniBand позволит объединить десятки тысяч ускорителей Blackwell. Компания стремительно наращивает закупки этих систем. А инстансы Azure HBv5 получат уникальные 88-ядерные AMD EPYC 9V64H с памятью HBM, которые будут доступны только в облаке Azure. Каждый инстанс включает четыре таких CPU и до 450 Гбайт памяти с агрегированной пропускной способностью 6,9 Тбайт/с. Кроме того, Microsoft анонсировала новое решение Azure Local, которое заменит семейство Azure Stack. Azure Local — это облачная гибридная инфраструктурная платформа, поддерживаемая Azure Arc, которая объединяет локальные среды с «большим» облаком Azure. По словам компании, клиенты получат обновление до Azure Local в автоматическом режиме. Наконец, Microsoft анонсировала новые возможности в Azure AI Foundry, новой «унифицированной» платформе приложений ИИ, где организации смогут проектировать, настраивать и управлять своими приложениями и агентами ИИ. В числе новых опций — Azure AI Foundry SDK (пока в виде превью).

05.11.2024 [11:11], Сергей Карасёв

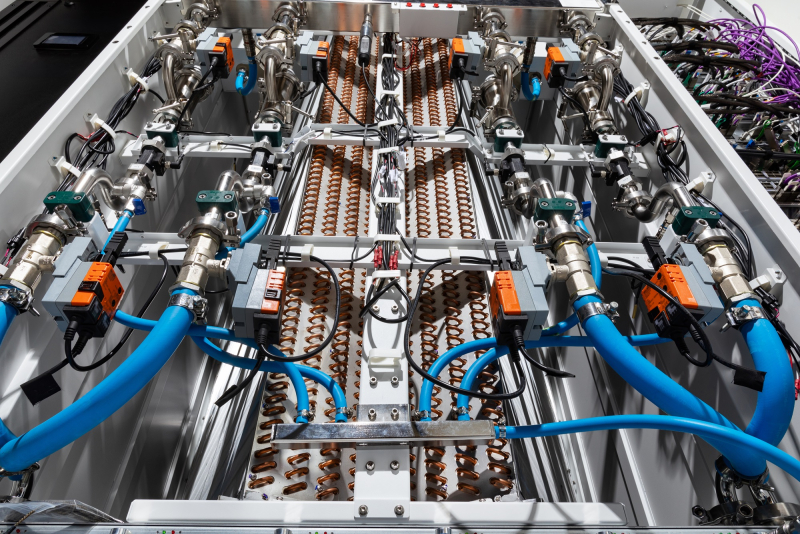

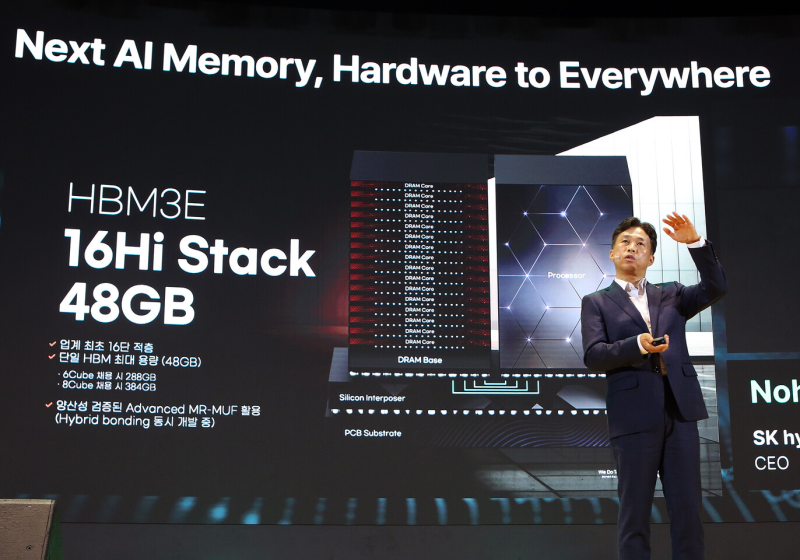

SK hynix представила первые в отрасли 16-ярусные чипы HBM3E ёмкостью 48 ГбайтКомпания SK hynix на мероприятии SK AI Summit в Сеуле (Южная Корея) сообщила о разработке первых в отрасли 16-ярусных чипов памяти HBM3E, ёмкость которых составляет 48 Гбайт. Клиенты получат образцы таких изделий в начале 2025 года. Генеральный директор SK hynix Квак Но-Джунг (Kwak Noh-Jung) сообщил, что компания намерена трансформироваться в поставщика ИИ-памяти «полного стека». Ассортимент продукции будет охватывать изделия всех типов — от DRAM до NAND. При этом планируется налаживание тесного сотрудничества с заинтересованными сторонами. При производстве 16-Hi HBM3E компания будет применять передовую технологию Advanced MR-MUF, которая ранее использовалась при изготовлении 12-слойных продуктов. Память рассчитана на высокопроизводительные ИИ-ускорители. Утверждается, что 16-ярусные изделия по сравнению с 12-слойными аналогами обеспечивают прирост быстродействия на 18 % при обучении ИИ-моделей и на 32 % при инференсе. SK hynix намерена предложить заказчикам кастомизируемые решения HBM с оптимизированной производительностью, которые будут соответствовать различным требованиям к ёмкости, пропускной способности и функциональности. Плюс к этому SK hynix планирует интегрировать логику непосредственно в кристаллы HBM4. Ранее говорилось, что компания рассчитывает начать поставки памяти HBM4 заказчикам во II половине 2025 года. В числе других готовящихся продуктов SK hynix упоминает модули LPCAMM2 (Compression Attached Memory Module 2) для ПК и ЦОД, решения LPDDR5 и LPDDR6 с технологией производства 1c-класса, SSD с интерфейсом PCIe 6.0, накопители eSSD и UFS 5.0 большой вместимости на основе чипов флеш-памяти QLC NAND.

23.10.2024 [16:57], Владимир Мироненко

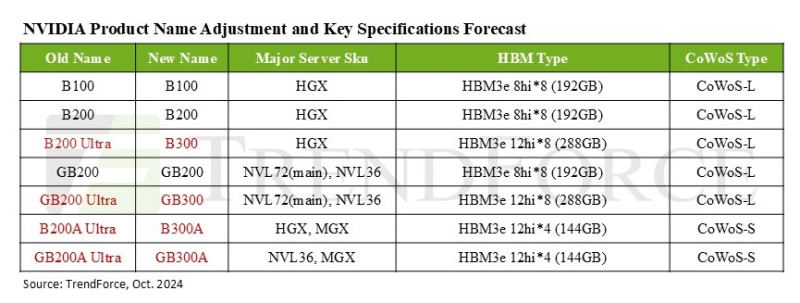

NVIDIA переименовала будущие ИИ-ускорители Blackwell Ultra в B300Согласно данным аналитической компании TrendForce, NVIDIA решила переименовать продукты семейства Blackwell Ultra в серию B300. В связи с этим ускоритель B200 Ultra стал B300, а GB200 Ultra теперь называется GB300. Кроме того, B200A Ultra и GB200A Ultra получили имена B300A и GB300A соответственно. Серия ускорителей B300, как ожидается, выйдет в I–II квартале 2025 года, а поставки (G)B200 начнутся не позднее I квартал 2025 года. TrendForce отметила, что NVIDIA совершенствует сегментацию чипов Blackwell, чтобы лучше соответствовать требованиям по стоимости и производительности со стороны облачных провайдеров (CSP) и OEM-производителей серверов и смягчить требования к цепочкам поставок. Так, модель B300A нацелена на OEM-клиентов, её массовое производство планируется начать во II квартале 2025 года после пика поставок H200. Изначально NVIDIA хотела предложить данному сегменту упрощённый вариант B200A, но, судя по всему, спрос на него оказался более слабом, чем ожидалось. Вместе с тем переход с GB200A на GB300A для стоечных решений может привести к увеличению первоначальных затрат для корпоративных клиентов, что также может отразиться на спросе. Сейчас компания вкладывает значительные средства в улучшение стоечных решений NVL, помогая поставщикам серверных систем с оптимизацией производительности и жидкостным охлаждением для систем NVL72, а AWS и Meta✴ настоятельно призывают перейти с NVL36 на NVL72. TrendForce также ожидает, что предложение топовых ускорителей NVIDIA будет расширяться, а их общая доля в поставках, как ожидается, достигнет около 50 % в 2024 году, то есть вырастет на 20 п.п. год к году. Ожидается, что выпуск ускорителей Blackwell увеличит этот показатель до 65 % в 2025 году. Аналитики также отметили роль NVIDIA в стимулировании спроса на технологию упаковки CoWoS. Благодаря Blackwell спрос на данный тип упаковки вырастет более чем на 10 п.п. в годовом исчислении. NVIDIA, скорее всего, сосредоточится на поставках чипов B300 и GB300 крупным североамериканским гиперскейлерам — оба варианта используют технологию CoWoS-L. Компания активно наращивает закупки HBM — согласно прогнозам, в 2025 году на NVIDIA придётся более 70 % мирового рынка HBM (рост на 10 п.п. год к году). TrendForce также отмечает, что все чипы серии B300 будут оснащены памятью HBM3e 12Hi, производство которой начнётся не позднее I квартал 2025 года. Но поскольку это будут первые массовые продукты с таким типом памяти, поставщикам, как ожидается, потребуется не менее двух кварталов для отработки процессов и стабилизации объёмов производства.

07.09.2024 [11:41], Сергей Карасёв

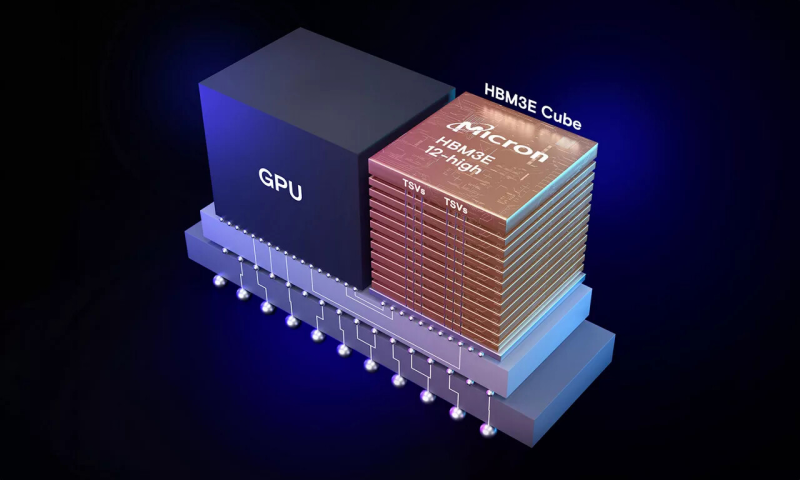

Micron представила 12-ярусные чипы HBM3E: 36 Гбайт и 1,2 Тбайт/сКомпания Micron Technology сообщила о начале пробных поставок 12-ярусных (12-Hi) чипов памяти HBM3E, предназначенных для высокопроизводительных ИИ-ускорителей. Изделия проходят квалификацию в экосистеме отраслевых партнёров, после чего начнутся их массовые отгрузки. Новые чипы имеют ёмкость 36 Гбайт, что на 50 % больше по сравнению с существующими 8-слойными вариантами HBM3E (24 Гбайт). При этом, как утверждает Micron, достигается значительно более низкое энергопотребление. Благодаря применению 12-ярусных чипов HBM3E крупные модели ИИ, такие как Llama 2 с 70 млрд параметров, могут запускаться на одном ускорителе. Заявленная пропускная способность превышает 9,2 Гбит/с на контакт, что в сумме обеспечивает свыше 1,2 Тбайт/с. Появление новой памяти поможет гиперскейлерам и крупным операторам дата-центров масштабировать растущие рабочие нагрузки ИИ в соответствии с запросами клиентов. Реализована полностью программируемая функция MBIST (Memory Built-In Self Test), которая способна работать на скоростях, соответствующих системному трафику. Это повышает эффективность тестирования, что позволяет сократить время вывода продукции на рынок и повысить надёжность оборудования. При изготовлении памяти HBM3E компания Micron применяет современные методики упаковки чипов, включая усовершенствованную технологию сквозных соединений TSV (Through-Silicon Via). Нужно отметить, что о разработке 12-слойных чипов HBM3E ёмкостью 36 Гбайт в начале 2024 года объявила компания Samsung. Эти решения обеспечивают пропускную способность до 1,28 Тбайт/с. По данному показателю, как утверждается, чипы более чем на 50 % превосходят доступные на рынке 8-слойные стеки HBM3. Наконец, старт массового производства 12-Hi модулей HBM3E от SK hynix с ПСП 1,15 Тбайт/с намечен на октябрь.

07.08.2024 [12:28], Руслан Авдеев

Китайские компании набивают склады HBM-памятью Samsung в ожидании новых американских санкцийКитайские техногиганты, включая игроков вроде Huawei и Baidu, а также стартапы активно запасают HBM-чипы Samsung Electronics. По данным агентства Reuters, это делается в ожидании новых ограничений со стороны США на поставки в КНР чипов, использующих американские технологии. Как сообщают источники издания, компании наращивают закупки соответствующих чипов ещё с начала 2024 года, на долю китайских покупателей придётся порядка 30 % выручки Samsung от продаж HBM в I половине 2024 года. Экстренные меры наглядно демонстрируют нежелание Китая отказываться от технологических амбиций даже на фоне торговых войн с США и их союзниками. Ранее Reuters сообщало, что американские власти намерены представить новые санкционные ограничения ещё до конца текущего месяца. Они призваны ограничить возможности китайской полупроводниковой индустрии. Источники сообщают, что в документах будут заданы и параметры для ограничений на поставки HBM-памяти. Министерство торговли США отказалось от комментариев, но на прошлой неделе заявило, что постоянно обновляет правила экспортного контроля для защиты национальной безопасности США и технологической экосистемы страны.

Источник изображения: Samsung HBM-чипы считаются критически важными компонентами при разработке передовых ИИ-ускорителей. Возможности выпуска HBM пока доступны только трём производителям: южнокорейским SK Hynix и Samsung, а также американской Micron Technology. По данным информаторов Reuters, в Китае особым спросом пользуется вариант HBM2E, который отстаёт от передового HBM3E. Глобальный бум ИИ-технологий привёл к дефициту наиболее передовых решений. По мнению экспертов, поскольку собственные китайские технологии в этой области ещё не слишком зрелые, спрос китайских компаний и организаций на сторонние HBM-чипы чрезвычайно велик, а Samsung оставалась единственной опцией, поскольку производственные мощности других производителей уже забронированы американскими ИИ-компаниями. Хотя объёмы и стоимость запасённых Китаем HBM-чипов оценить нелегко, известно, что они используются компаниями самого разного профиля, а Huawei, например, применяет Samsung HBM2E для выпуска передовых ИИ-ускорителей Ascend. Впрочем, Huawei и CXMT уже сфокусировали внимание на разработке чипов HBM2 — они на три поколения отстают от HBM3E. Тем не менее, американские санкции могут помешать новым китайским проектам. Более того, от них может больше пострадать Samsung, чем её ключевые соперники, которые меньше связаны с китайским рынком. Micron не продаёт HBM-чипы в Китай с прошлого года, а SK Hynix, чьими ключевыми клиентами являются компании вроде NVIDIA, специализируются на более современных решениях.

01.08.2024 [00:53], Игорь Осколков

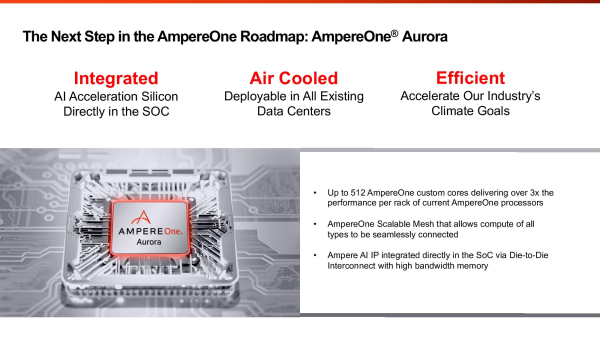

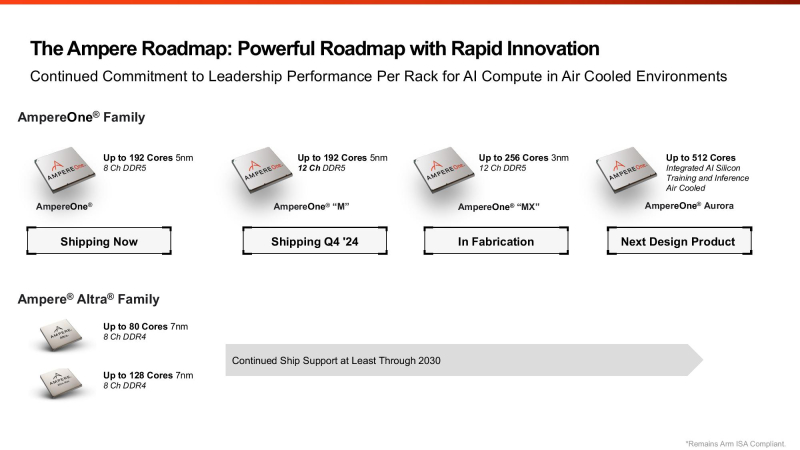

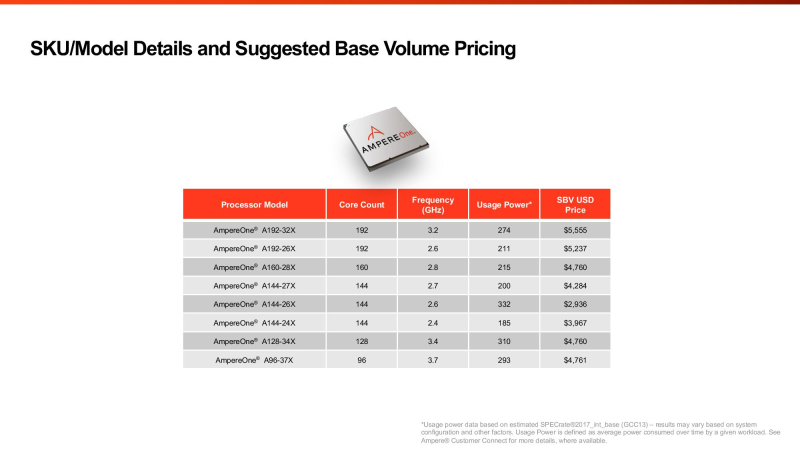

Ampere анонсировала 512-ядерные Arm-процессоры AmpereOne Aurora с HBM-памятью и встроенным ИИ-ускорителемAmpere Computing анонсировала процессоры AmpereOne Aurora, которые получат до 512 однопоточных Arm-ядер собственной разработки, набортную HBM-память и фирменные IP-блоки для обучения и инференса ИИ-моделей. Речь, судя по всему, идёт о чиплетной компоновке, поскольку компания говорит не только о фирменном меш-интерконнекте для вычислительных блоков, но и об объединении разных кристаллов в рамках SoC. Предполагается, что Aurora появятся где-то на рубеже 2025–2026 гг. Что интересно, для Aurora обещана возможность использования воздушного охлаждения. Для гиперскейлеров, на которых Ampere по-прежнему ориентируется, это важный пункт. Впрочем, больше никаких подробностей о новинках компания не сообщила, отметив лишь, что встроенный ускоритель сгодится для RAG и векторных баз данных. Ну и сообщив, что по количеству ядер и производительности её ещё не выпущенный чип обгоняет все остальные чипы: 144-ядерные Intel Xeon 6 (Sierra Forest), которые вскоре станут 288-ядерными (при этом все варианты без Hyper-Threading), и 128-ядерные AMD EPYC Bergamo (256 потоков), которым на смену придут 192-ядерные EPYC Turin Dense (384 потока). До Aurora компания выпустит ещё две серии процессоров AmpereOne: M в конце 2024 года и MX в 2025 году. 5-нм AmpereOne M получат до 192 ядер и 12-канальный контроллер памяти DDR5. 3-нм AmpereOne MX получат такой же контроллер и до 256 ядер. Заодно компания опубликовала прайс-лист актуальных CPU. В нём нет изначально заявлявшихся 136- и 172-ядерных моделей. Кроме того, остальные процессоры несколько подорожали в сравнении с прошлым поколением Altra Max, но по цене всё ещё привлекательнее решений AMD и Intel — $5555 за 192 ядра. Следует учесть, что в таблице приведён не привычный показатель TDP, а усреднённое энергопотребление чипа, из-за чего сравнивать процессоры Ampere с другими чипами затруднительно. Насколько Aurora станет популярным у гиперскейлеров и других заказчиков, покажет время. У Ampere есть якорный заказчик в лице Oracle, но другие IT-гиганты уже сами разрабатывают собственные Arm-процессоры. AWS в Graviton4 довела количество ядер до 96, Microsoft анонсировала 128-ядерный Cobalt 100, Alibaba массово внедряет 128-ядерные Yitian 710, а Google готовит Axion. Fujitsu к 2027 году подготовит 144-ядерные MONAKA, которые тоже получат поддержку ИИ-нагрузок, но упор в них сделан не на HBM, а на SRAM. Собственно говоря, HBM есть только у HPC-процессоров: Fujitsu A64FX, SiPearl Rhea1 и C-DAC AUM. Даже NVIDIA Grace, которые в основном ассистируют ускорителям, обходятся LPDDR5x.

18.07.2024 [22:35], Владимир Мироненко

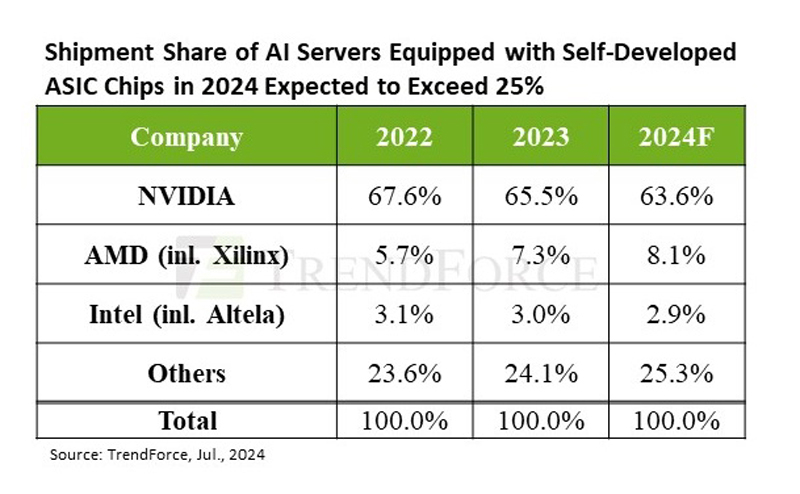

TrendForce прогнозирует высокий спрос на ИИ-серверы до конца 2025 годаСогласно прогнозу аналитической компании TrendForce, высокий спрос на ИИ-серверы со стороны крупных провайдеров облачных услуг и других клиентов сохранится до конца 2024 года. Постепенное расширение производства компаниями TSMC, SK hynix, Samsung и Micron позволило значительно уменьшить дефицит во II квартале и, как следствие, время выполнения заказа на NVIDIA H100 сократилось с прежних 40–50 недель до менее чем 16. По оценкам TrendForce, поставки ИИ-серверов во II квартале выросли почти на 20 % по сравнению с предыдущим кварталом. Аналитики в своём свежем отчёте пересмотрели прогноз поставок на весь год до 1,67 млн ИИ-серверов (рост на 41,5 % в годовом исчислении). Объём рынка ИИ-серверов в 2024 году в денежном выражении, как ожидают в TrendForce, превысит $187 млрд при темпах роста 69 %, что составит 65 % от рыночной стоимости всех поставленных серверов. В отчёте также отмечено, что в этом году крупные провайдеры облачных услуг продолжают концентрироваться на закупке ИИ-серверов, что негативно отражается на темпах роста поставок серверов общего назначения. У последних ежегодные темпы роста поставок составят всего 1,9 %. Как ожидают в TrendForce, доля ИИ-серверов в штучном выражении в общем объёме поставок достигнет 12,2 %, что больше на 3,4 п.п. по сравнению с 2023 годом. Аналитики отметили, что североамериканские гиперскейлеры постоянно расширяют выпуск собственных ASIC, впрочем, как и китайские компании, такие как Alibaba, Baidu и Huawei. Ожидается, что благодаря этому доля ASIC-серверов на рынке ИИ-серверов вырастет до 26 % в 2024 году, в то время как у ИИ-серверов с ускорителями доля будет около 71 %. При этом NVIDIA сохранит абсолютное лидерство с около 90 % рынка ИИ-серверов с ускорителями, в то время как доля AMD составит лишь около 8 %. Если же учитывать вообще все чипы, используемые в ИИ-серверах (GPU, ASIC, FPGA), то доля рынка NVIDIA в этом году составит около 64 %, ожидают в TrendForce. По оценкам аналитической фирмы Tech Insights, NVIDIA в 2023 году отгрузила приблизительно 3,76 млн серверных ускорителей на базе GPU, захватив 98 % рынка GPU для ЦОД. TrendForce считает, что спрос на передовые ИИ-серверы сохранится и в 2025 году, учитывая тот факт, что NVIDIA Blackwell (включая GB200, B100/B200) заменит Hopper. Это также будет стимулировать спрос на CoWoS (2.5D-упаковка от TSMC) и память HBM. Производственная мощность TSMC в области CoWoS, по оценкам TrendForce, достигнет 550–600 тыс. единиц к концу 2025 года, при этом темпы роста достигнут 80 %.

Источник изображения: TrendForce Тем не менее, ускоритель H100 получит в 2024 году наибольшее распространение. К 2025 году такие ускорители, как Blackwell Ultra от NVIDIA или MI350 от AMD, будут оснащены HBM3e ёмкостью до 288 Гбайт, что утроит количество компонентов памяти. Ожидается, что общее предложение HBM удвоится к 2025 году на фоне высокого спроса на ИИ-серверы. При этом не все уверены в светлом будущем ИИ. Так, венчурный фонд Sequoia Capital и аналитики Goldman Sachs указывают на сверхвысокие расходы на ИИ-оборудование и вместе с тем отсутсвие реальной финансовой отдачи от вложений в ИИ-решения. С другой стороны, венчурный фонд Andreessen Horowitz (a16z) уверен, что ИИ не станет очередным финансовым пузырём и сам закупает ИИ-ускорители, чтобы привлечь стартапы. А некоторые ИИ-стартапы сами приходят к крупным игрокам, поскольку не способны окупить затраты на оборудование. |

|