Материалы по тегу: hbm

|

01.07.2024 [16:36], Владимир Мироненко

SK hynix инвестирует $74,6 млрд в развитие HBM и ИИ-решенийЮжнокорейская компания SK hynix планирует выделить в период до 2028 года ₩103 трлн ($74,6 млрд) в укрепление своего бизнеса по производству чипов, сосредоточив внимание на ИИ-направлении, пишет агентство Reuters со ссылкой на заявление холдинга SK Group. Как сообщает Bloomberg, значительная часть этой суммы — ₩82 трлн ($59,5 млрд) — будет инвестирована в производство памяти HBM. Дочерние предприятия SK Telecom и SK Broadband в рамках развёртывания ИИ-технологий инвестируют ₩3,4 трлн ($2,5 млрд) в свои ЦОД. В свою очередь, SK Group планирует привлечь к 2026 году ₩80 трлн ($56 млрд) для инвестиций в основном в ИИ и полупроводники, стремясь закрепить позицию своего подразделения по производству чипов в качестве ключевого поставщика памяти для NVIDIA и других игроков рынка ИИ. Второй по величине конгломерат Южной Кореи объявил, что в результате двухдневной встречи топ-менеджеров с участием главы SK Group Чей Тэ Вона (Chey Tae-won) в минувшие выходные было решено, что холдинг будет использовать средства, полученные за счёт повышения прибыльности и оптимизации структуры бизнеса для инвестиций в производство памяти HBM и чипов, а также в ЦОД и персонализированных ИИ-ассистентов. «Поскольку наступил новый переходный период, нам нужны упреждающие и существенные изменения, чтобы подготовиться к будущему», — заявил Чей Тэ Вон.

Источник изображения: SK hynix SK hynix является основным поставщиком чипов HBM для ускорителей NVIDIA. Её акции в этом году подскочили на 65 %, в то время как у её более крупного конкурента Samsung Electronics акции выросли в цене с начала года на 4 %. Samsung, крупнейший в мире производитель чипов памяти, также выпускает HBM, равно как и американская компания Micron, которая также стремится увеличить долю на этом рынке. Аналитики утверждают, что SK hynix по-прежнему лидирует в области технологии стекирования микросхем, которая используется в HBM. В ходе встречи топ-менеджеры также договорились предпринять поэтапные шаги по доведению количества дочерних компаний в SK Group до «управляемого диапазона», не уточнив масштабы сокращения. Как сообщает Nikkei Asia со ссылкой на правительственные данные, по состоянию на май у холдинга было 219 «дочек» с совокупными активами в ₩334,4 трлн (около $240 млрд). В частности, по настоянию SK hynix будут объединены ИИ-стартапы Sapeon и Rebellions.

16.05.2024 [01:05], Игорь Осколков

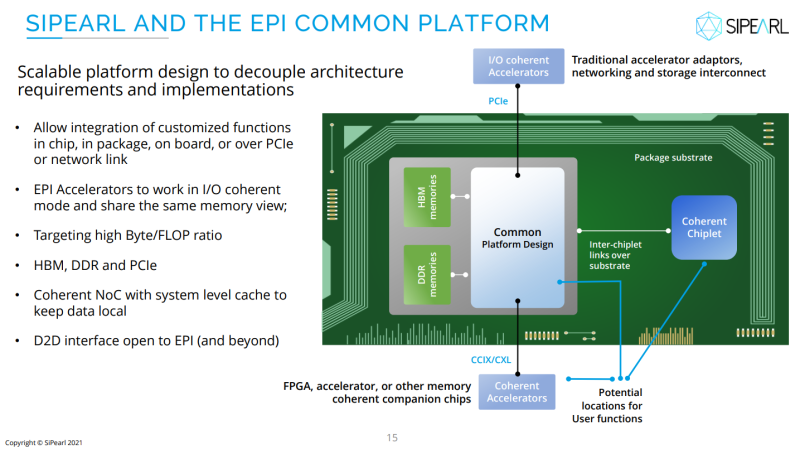

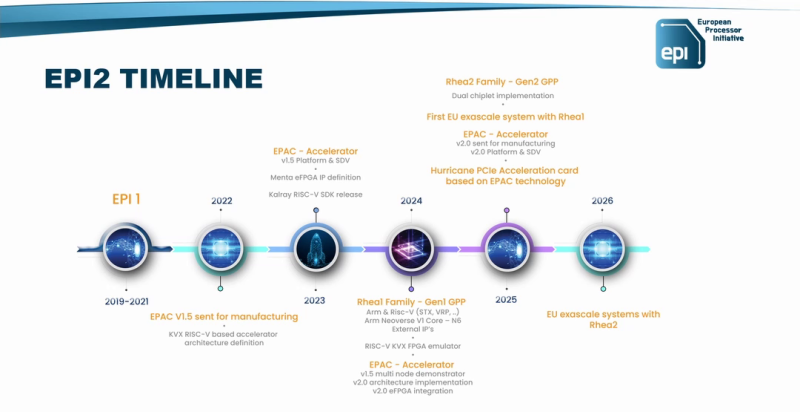

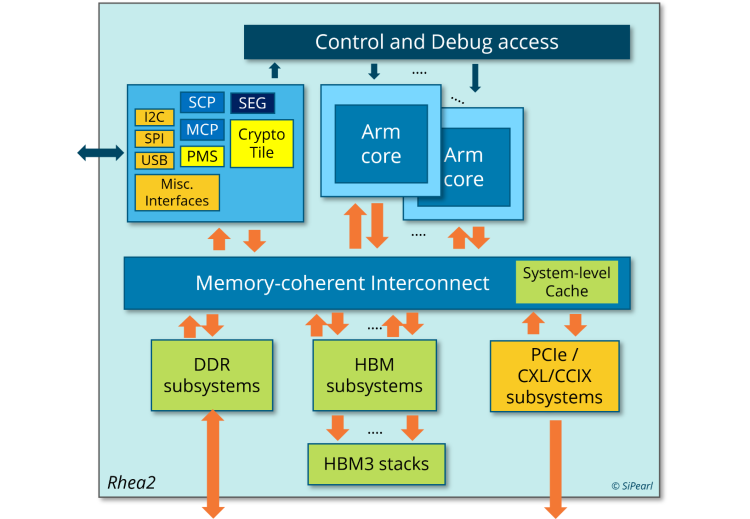

И для ИИ, и для HPC: первые европейские серверные Arm-процессоры SiPearl Rhea1 получат HBM-памятьКомпания SiPearl уточнила спецификации разрабатываемых ею серверных Arm-процессоров Rhea1, которые будут использоваться, в частности, в составе первого европейского экзафлопсного суперкомпьютера JUPITER, хотя основными чипами в этой системе будут всё же гибридные ускорители NVIDIA GH200. Заодно SiPearl снова сдвинула сроки выхода Rhea1 — изначально первые образцы планировалось представить ещё в 2022 году, а теперь компания говорит уже о 2025-м. При этом существенно дизайн процессоров не поменялся. Они получат 80 ядер Arm Neoverse V1 (Zeus), представленных ещё весной 2020 года. Каждому ядру полагается два SIMD-блока SVE-256, которые поддерживают, в частности, работу с BF16. Объём LLC составляет 160 Мбайт. В качестве внутренней шины используется Neoverse CMN-700. Для связи с внешним миром имеются 104 линии PCIe 5.0: шесть x16 + две x4. О поддержке многочиповых конфигураций прямо ничего не говорится. Очень похоже на то, что SiPearl от референсов Arm особо и не отдалялась, поскольку Rhea1 хоть и получит четыре стека памяти HBM, но это будет HBM2e от Samsung. При этом для DDR5 отведено всего четыре канала с поддержкой 2DPC, а сам процессор ожидаемо может быть поделён на четыре NUMA-домена. И в такой конфигурации к общей эффективности работы с памятью могут быть вопросы. Именно наличие HBM позволяет говорить SiPearl о возможности обслуживать и HPC-, и ИИ-нагрузки (инференс). На примере Intel Xeon Max (Sapphire Rapids c 64 Гбайт HBM2e) видно, что наличие сверхбыстрой памяти на борту даёт прирост производительности в означенных задачах, хотя и не всегда. Однако это другая архитектура, другой набор инструкций (AMX), другая же подсистема памяти и вообще пока что единичный случай. С Fujitsu A64FX сравнения тоже не выйдет — это кастомный, дорогой и сложный процессор, который, впрочем, доказал эффективность и в HPC-, и даже в ИИ-нагрузках (с оговорками). В MONAKA, следующем поколении процессоров, Fujitsu вернётся к более традиционному дизайну. Пожалуй, единственный похожий на Rhea1 чип — это индийский 5-нм C-DAC AUM, который тоже базируется на Neoverse V1, но предлагает уже 96 ядер (48+48, два чиплета), восемь каналов DDR5 и до 96 Гбайт HBM3 в четырёх стеках, а также поддержку двухсокетных конфигураций. AWS Graviton3E, который тоже ориентирован на HPC/ИИ-нагрузки, вообще обходится 64 ядрами Zeus и восемью каналами DDR5. Наконец, NVIDIA Grace и Grace Hopper в процессорной части тоже как-то обходятся интегрированной LPDRR5x, да и ядра у них уже Neoverse V2 (Demeter), и своя шина для масштабирования имеется. В любом случае в 2025 году Rhea1 будет выглядеть несколько устаревшим чипом. Но в этом же году SiPearl собирается представить более современные чипы Rhea2 и обещает, что их разработка будет не столь долгой как Rhea1. Компанию им должны составить европейские ускорители EPAC, тоже подзадержавшиеся. А пока Европа будет обходиться преимущественно американскими HPC-технологиями, от которых стремится рано или поздно избавиться.

05.05.2024 [13:59], Сергей Карасёв

SK hynix продала всю память HBM, запланированную к выпуску в 2024–2025 гг.Компания SK hynix, по сообщению The Register, получила заказы на весь объём памяти HBM, запланированный к выпуску в 2024 году, и на основную часть этих чипов, которые будут произведены в 2025-м. Спрос на изделия HBM быстро растёт на фоне стремительного развития ИИ-рынка. SK hynix объявила на пресс-конференции в своей штаб-квартире в Ичхоне (Южная Корея) о намерении расширить производство микросхем HBM. Генеральный директор компании Квак Но-чжун (Kwak Noh-jung) заявил, что выпуск изделий данного типа удастся значительно нарастить после завершения строительства новых предприятий в Южной Корее и США.

Источник изображения: SK hynix SK hynix является основным поставщиком памяти HBM для ускорителей NVIDIA, с поставками которых наблюдаются сложности из-за высокого спроса со стороны облачных провайдеров и операторов дата-центров, ориентированных на ИИ-нагрузки. Квак Но-чжун прогнозирует, что в среднесрочной и долгосрочной перспективе среднегодовой прирост потребности в чипах HBM будет составлять около 60 %. Это связано с увеличением объёмов генерируемых данных и повышением сложности ИИ-моделей. До конца мая SK hynix планирует предоставить клиентам образцы памяти HBM пятого поколения — 12-слойные изделия HBM3E. Массовый выпуск такой продукции компания наметила на III квартал 2024 года. Недавно SK hynix заявила, что планирует инвестировать более $14,5 млрд в новый корейский завод M15X по производству чипов памяти. Первоначально планировалось, что это предприятие будет выпускать изделия NAND, но затем было решено переориентировать его мощности под выпуск DRAM. В марте сообщалось, что компания Micron Technology, приступившая в феврале к массовому производству памяти HBM3E, уже получила контракты на весь объём поставок этих изделий до конца 2024 года, а также на большую часть поставок в 2025 году.

02.05.2024 [15:33], Алексей Разин

Micron начала поставки RDIMM-модулей DDR5 объёмом 128 Гбайт на базе 32-Гбит чиповПредставив чипы памяти типа DDR5 ёмкостью 32 Гбит ещё прошлой осенью, компания Micron Technology только сейчас сертифицировала модули RDIMM объёмом 128 Гбайт на основе этих чипов на совместимость с оборудованием ключевых игроков серверного рынка. Клиенты Micron смогут получить такие модули памяти в июне. Также компания объявила о поставках восьмиярусных стеков памяти HBM3E. Американский производитель памяти подчёркивает, что и 128-Гбайт модули DDR5-5600 RDIMM, и HBM3E-память Hi-8 наилучшим образом проявят себя в серверной инфраструктуре, ориентированной на обслуживание ИИ-систем. Кого именно из производителей ускорителей вычислений Micron снабжает памятью типа HBM3E, не уточняется, но конкурирующие Samsung и SK hynix уже готовы поставлять клиентам 12-ярусные чипы HBM3E. Впрочем, ещё в феврале Micron сообщил о готовности начать во II квартале поставки чипов HBM3E объёмом 24 Гбайт для ускорителей NVIDIA H200.

Источник изображения: Micron Technology Серверные модули DDR5 объёмом 128 Гбайт со скоростью 5600 МТ/с на основе монолитных 32-Гбит чипов памяти, по данным Micron, позволяют на 45 % поднять плотность хранения данных в пересчёте на один контакт, на 22 % поднять энергетическую эффективность, и на 16 % снизить задержки при передаче информации по сравнению с немонолитными чипами DDR5. Micron отметила, что в этом году начнёт поставки модулей со скоростью 4800, 5600 и 6400 MT/с, а в будущем намерена предложить решения со скоростью до 8000 MT/с. AMD и Intel подтвердили совместимость новых модулей Micron со своими современными серверными платформами. Со следующего месяца Micron начнёт продавать новую память через своих торговых партнёров.

11.04.2024 [22:27], Алексей Степин

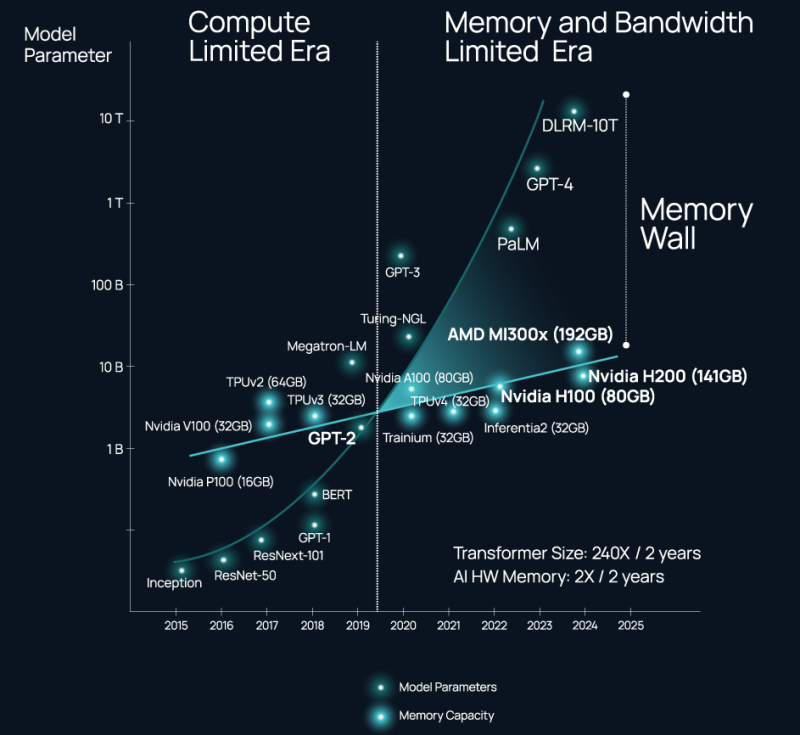

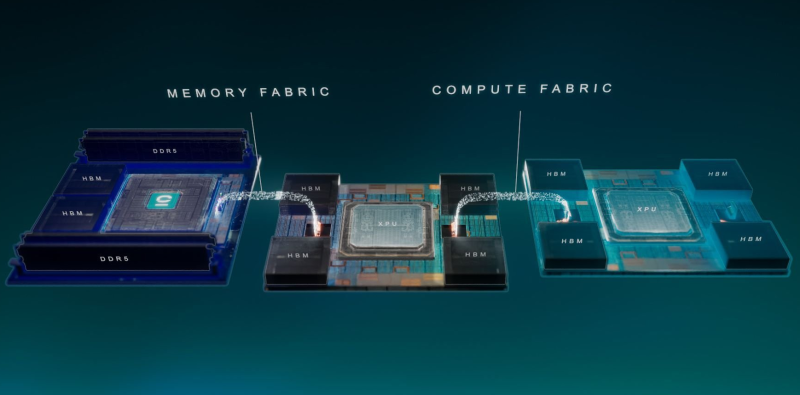

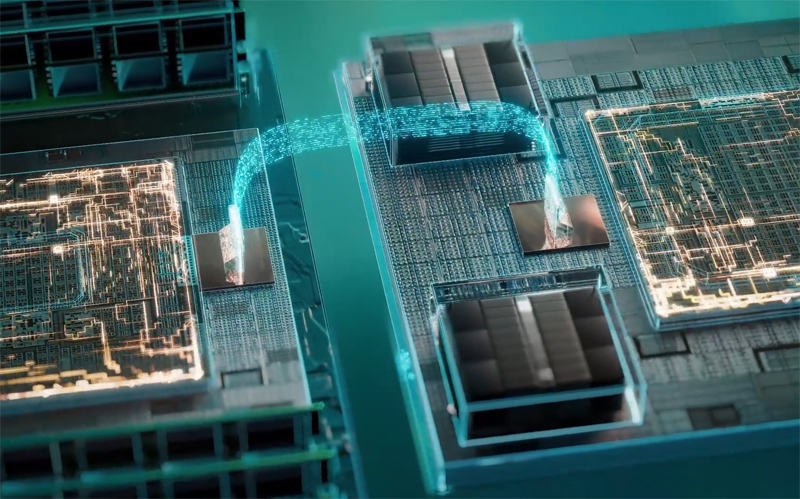

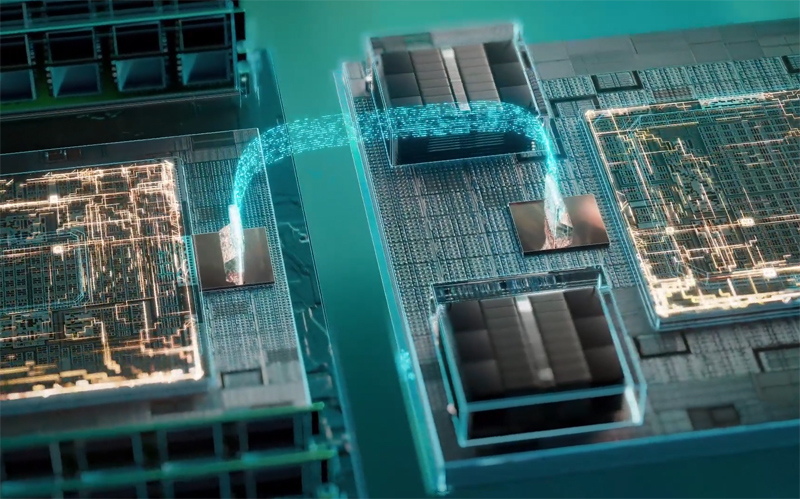

ИИ-ускорители NVIDIA являются самими дорогими в мире контроллерами памяти — Celestial AI предлагает связать оптикой HBM, DDR5 и процессорыВ 2024 году нельзя пожаловаться на отсутствие подходящего интерконнекта, если целью является «сшивка» в единую систему сотен, тысяч или даже десятков тысяч ускорителей. Есть NVIDIA NVLink и InfiniBand. Google использует оптические коммутаторы OCS, AMD вскоре выведет Infinity Fabric на межузловой уровень, да и старый добрый Ethernet отнюдь не собирается сдавать позиций и обретает новую жизнь в виде Ultra Ethernet. Проблема не в наличии и выборе подходящего интерконнекта, а в резкой потере пропускной способности за пределами упаковки чипа (т.н. Memory Wall). Да, память HBM быстра, но намертво привязана к вычислительным ресурсам, а в итоге, как отметил глава Celestial AI в комментарии изданию The Next Platform, индустрия ИИ использует ускорители NVIDIA в качестве самых дорогих в мире контроллеров памяти. Celestial AI ещё в прошлом году объявила, что ставит своей целью создание универсального «умного» интерконнекта на основе фотоники, который смог бы использоваться во всех нишах, требующих активного обмена большими потоками данных, от межкристалльной (chip-to-chip) до межузловой (node-to-node). Недавно она получила дополнительный пакет инвестиций объёмом $175 млн.

Источник изображений здесь и далее: Celestial AI Технология, названная Photonic Fabric, если верить заявлениям Celestial AI, способна в 25 раз увеличить пропускную способность и объёмы доступной памяти при на порядок меньшем энергопотреблении в сравнении с существующими системами соединений. Развивается она в трёх направлениях: чиплеты, интерпозеры и оптический аналог технологии Intel EMIB под названием OMIB. Наиболее простым способом интеграции своей технологии Celestial AI справедливо считает чиплеты. В настоящее время разработанный компанией модуль обеспечивает пропускную способность за пределами чипа на уровне 14,4 Тбит/с (1,8 Тбайт/с), а по размерам он немного уступает стандартной сборке HBM. Но это лишь первое поколение: во втором поколении Photonic Fabric 56-Гбит/с SerDes-блоки SerDes будут заменены на блоки класса 112 Гбит/с (PAM4). Поскольку речь идёт о системах с дезагрегацией ресурсов, проблему быстрого доступа к большому объёму памяти Celestial AI предлагает решить следующим образом: новый чиплет, содержащий помимо интерконнекта две сборки HBM общим объёмом 72 Гбайт, получит также поддержку четырёх DDR5 DIMM суммарным объёмом до 2 Тбайт. С использованием 5-нм техпроцесса такой чиплет сможет легко превратить HBM в быстрый сквозной кеш (write through) для DDR5. Фактически речь идёт об относительно простом и сравнительно доступном способе превратить любой процессор с чиплетной компоновкой в дезагрегированный аналог Intel Xeon Max или NVIDIA Grace Hopper. При этом латентность при удалённом обращении к памяти не превысит 120 нс, а энергозатраты в данном случае составят на порядок меньшую величину, нежели в случае с NVLink — всего 6,2 пДж/бит против 62,5 пДж/бит у NVIDIA. Таким образом, с использованием новых чиплетных контроллеров памяти становятся реальными системы, где все чипы, от CPU до сетевых процессоров и ускорителей, будут объединены единым фотонным интерконнектом и при этом будут иметь общий пул памяти DDR5 большого объёма с эффективным HBM-кешированием. По словам Celestial AI, она уже сотрудничает с некоторыми гиперскейлерами и с одним «крупным производителем процессоров». По словам руководителя Celestial AI, образцы чиплетов с поддержкой Photonic Fabric появятся во II половине 2025 года, а массовое внедрение начнется уже в 2027 году. Однако это может оказаться гонкой на выживание: Ayar Labs, другой разработчик фотоники, получившая поддержку со стороны Intel, уже показала прототип процессора с интегрированным фотонным интерконнектом. А Lightmatter ещё в декабре получила финансирование в объёме $155 млн на разработку фотонного интерпозера Passage и якобы уже сотрудничает с клиентами, заинтересованными в создании суперкомпьютера с 300 тыс. узлов. Нельзя сбрасывать со счетов и Eliyan, предлагающую вообще отказаться от технологии интерпозеров и заменить её на контроллеры физического уровня NuLink.

28.03.2024 [20:42], Сергей Карасёв

Оптика для HBM: стартап Celestial AI получил ещё $175 млн инвестиций, в том числе от AMD и SamsungКомпания Celestial AI, занимающаяся созданием технологий оптического интерконнекта, сообщила о проведении раунда финансирования Series C, в ходе которого привлечено $175 млн. Деньги будут использованы для ускорения разработки и вывода передовых продуктов на коммерческий рынок. Летом прошлого года Celestial AI объявила о разработке технологии Photonic Fabric. Она ориентирована на ИИ-платформы и системы НРС. Благодаря оптическому интерконнекту нового типа ИИ-чипы могут быть соединены с большим пулом высокопроизводительной памяти HBM3, а в перспективе — и HBM4. Таким образом, решается проблема ограниченного объёма памяти HBM в составе ИИ-ускорителей. По заявлениям Celestial AI, технология Photonic Fabric обеспечивает повышение пропускной способности и объёма доступной памяти более чем в 25 раз при одновременном снижении задержек и энергопотребления примерно в 10 раз по сравнению с существующими оптическими альтернативами и традиционными медными соединениями. Таким образом, можно масштабировать нагрузки ИИ.

Источник изображения: Celestial AI В июне 2023 года Celestial AI провела раунд финансирования Series B на сумму в $100 млн. Тогда средства предоставили IAG Capital Partners, Koch Disruptive Technologies (KDT), Temasek Xora Innovation, Samsung Catalyst, Smart Global Holdings (SGH), Porsche Automobil Holding SE, The Engine Fund, imec.xpand, M Ventures и Tyche Partners. Инвестиционная программа Series C проведена под предводительством Фонда инновационных технологий США (USIT) миллиардера Томаса Талла (Thomas Tull), основателя Legendary Entertainment. В программе также приняли участие AMD Ventures, KDT, Temasek, Xora Innovation, IAG Capital Partners, Samsung Catalyst, SGH, Porsche Automobil Holding SE, Engine Ventures, M-Ventures и Tyche Partners.

23.03.2024 [22:29], Владимир Мироненко

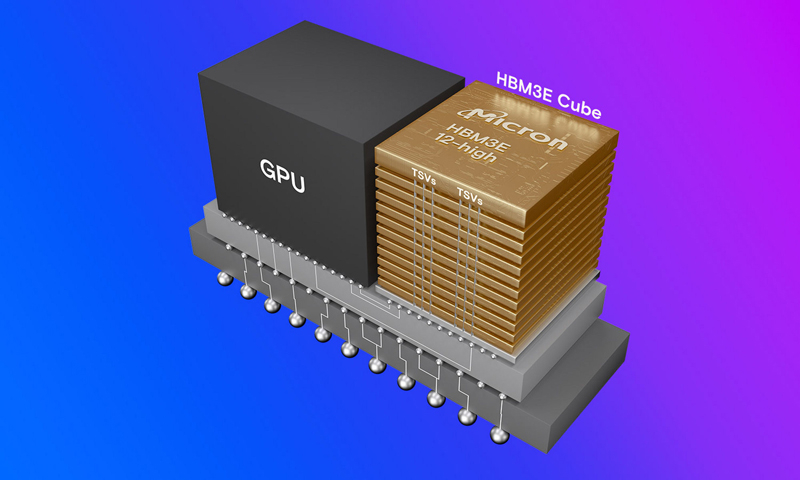

Micron уже продала всю HBM3E-память, которую выпустит в 2024 году и распределила заказы на 2025 годКомпания Micron Technology, приступившая в феврале к массовому производству передовой памяти HBM3E, сообщила, что уже имеет на руках контракты на весь объём поставок до конца 2024 года, а также на большую часть поставок в 2025 году. Память Micron HBM3E (Micron называет её HBM3 Gen2) одной из первых получила сертификацию для использования в ускорителях NVIDIA (G)H200, так что, по всей видимости, Micron станет ключевым поставщиком для NVIDIA, пишет AnandTech. «Наша HBM распродана на 2024 календарный год и подавляющая часть наших поставок на 2025 год уже распределена, — сообщил глава Micron Санджей Мехротра (Sanjay Mehrotra) в комментариях к отчёту за II квартал 2024 финансового года. Первый продукт HBM3E от Micron представляет собой сборку 8-Hi ёмкостью 24 Гбайт с 1024-бит интерфейсом и общей пропускной способностью 1,2 Тбайт/с. NVIDIA H200 использует шесть таких модулей. Micron также начала поставки образцов сборок 12-Hi ёмкостью 36 Гбайт.

Источник изображения: Micron В отчёте за II квартал 2024 финансового года Micron похвасталась результатами, которые оказались значительно выше прогнозов. Напомним, что до этого у компании были убытки пять кварталов подряд. В отчётном квартале Micron получила выручку в размере $5,82 млрд, превысив на 58 % на результат II квартала 2023 финансового года, равный $3,69 млрд, и на 23 % — результат предыдущего квартала, равный $4,73 млрд. При этом доля в общей выручке продаж DRAM составила 71 %, NAND — 27 %. Поставки подразделения сетевых и вычислительных решений (Compute and Networking, CNBU) выросли год к году на 59 % до $2,2 млрд, мобильного подразделения (Mobile, MBU) — на 69 % до $1,6 млрд, у подразделения встраиваемых решений (Embedded, EBU) зафиксирован рост на 28 % до $1,11 млрд, у подразделения решений для СХД — рост на 79 % до $905 млн. Компания сообщила о прибыли в размере $793 млн или $0,71 на акцию, в то время как годом ранее у неё были убытки (GAAP) в $2,31 млрд или $2,12 на акцию. Скорректированная прибыль (non-GAAP) составила $0,42 на акцию по сравнению с убытком в $1,91 на акцию годом ранее. Согласно прогнозу аналитиков, опрошенных FactSet, у Micron должны были быть убытки (non-GAAP) в размере $0,25 на акцию при выручке в $5,35 млрд. В текущем квартале Micron ожидает получить скорректированную прибыль (non-GAAP) в размере $0,42 на акцию при выручке в $6,6 млрд. Аналитики Уолл-стрит прогнозируют в III финансовом квартале прибыль (non-GAAP) в размере $0,09 на акцию при выручке в $6 млрд.

28.02.2024 [15:31], Сергей Карасёв

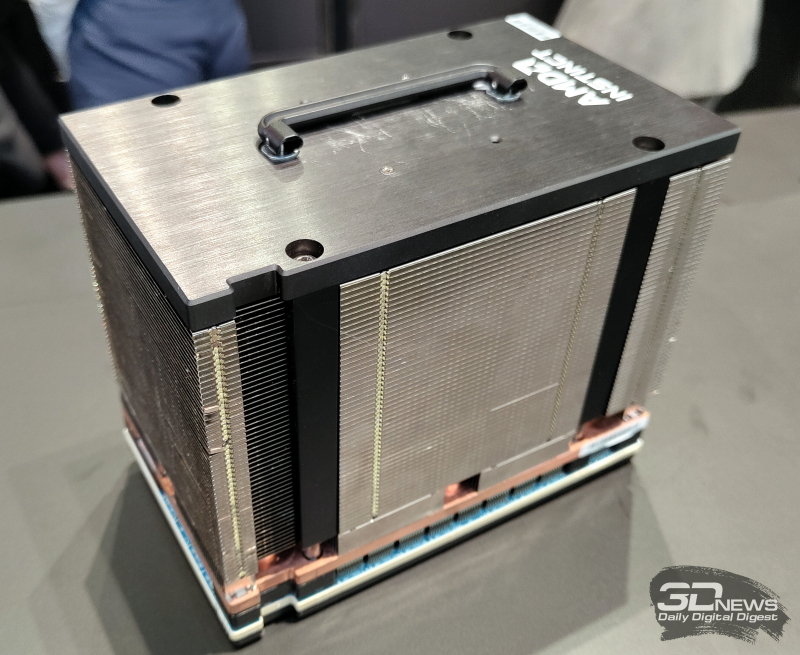

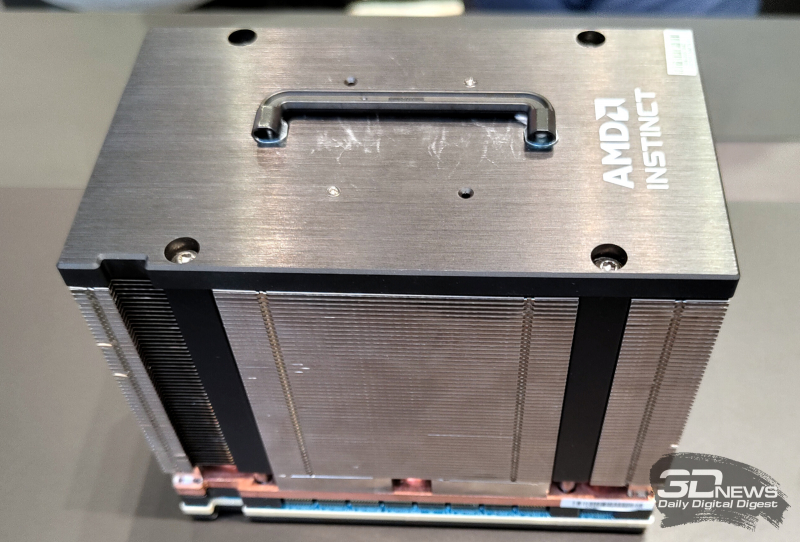

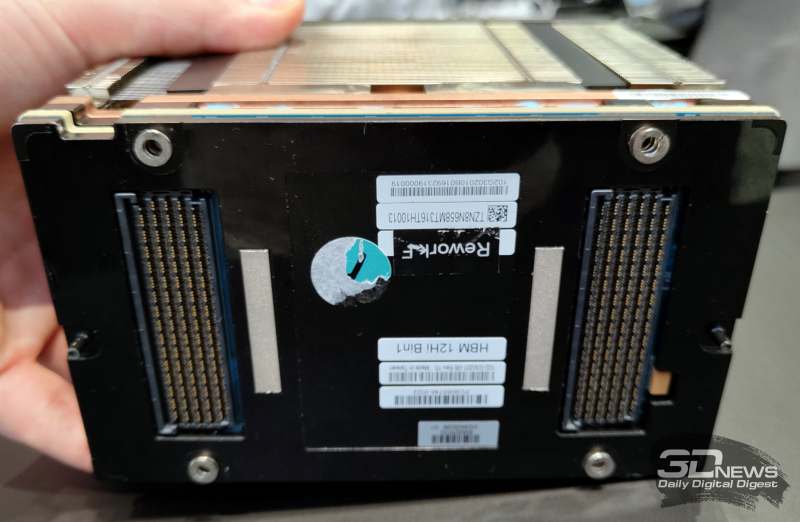

На MWC 2024 замечен первый образец ускорителя AMD Instinct MI300X с 12-слойной памятью HBM3EКомпания AMD готовит новые модификации ускорителей семейства Instinct MI300, которые ориентированы на обработку ресурсоёмких ИИ-приложений. Изделия будут оснащены высокопроизводительной памятью HBM3E. Работу над ними подтвердил технический директор AMD Марк Пейпермастер (Mark Papermaster), а уже на этой неделе на стенде компании на выставке MWC 2024 был замечен образец обновлённого ускорителя. На сегодняшний день в семейство Instinct MI300 входят модификации MI300A и MI300X. Первая располагает 228 вычислительными блоками CDNA3 и 24 ядрами Zen4 на архитектуре x86. В оснащение входят 128 Гбайт памяти HBM3. На более интенсивные вычисления ориентирован ускоритель MI300X, оборудованный 304 блоками CDNA3 и 192 Гбайт HBM3. Но у этого решения нет ядер Zen4. Недавно компания Micron сообщила о начале массового производства 8-слойной памяти HBM3E ёмкостью 24 Гбайт с пропускной способностью более 1200 Гбайт/с. Эти чипы будут применяться в ИИ-ускорителях NVIDIA H200, которые выйдут на коммерческий рынок во II квартале нынешнего года. А Samsung готовится к поставкам 12-слойных чипов HBM3E на 36 Гбайт со скоростью передачи данных до 1280 Гбайт/с. AMD подтвердила намерение применять память HBM3E в обновлённых ускорителях Instinct MI300, но в подробности вдаваться не стала. В случае использования 12-слойных чипов HBM3E ёмкостью 36 Гбайт связка из восьми модулей обеспечит до 288 Гбайт памяти с высокой пропускной способностью. Наклейка на демо-образце недвусмысленно указывает на использование именно 12-слойной памяти. Впрочем, это может быть действительно всего лишь стикер, поскольку представитель AMD уклонился от прямого ответа на вопрос о спецификациях представленного изделия. Ожидается также, что в 2025 году AMD выпустит ИИ-ускорители следующего поколения серии Instinct MI400. Между тем NVIDIA готовит ускорители семейства Blackwell для ИИ-задач: эти изделия, по заявлениям самой компании, сразу после выхода на рынок окажутся в дефиците.

28.02.2024 [14:04], Сергей Карасёв

В Samsung разработаны первые в отрасли 12-слойные чипы HBM3E ёмкостью 36 ГбайтКомпания Samsung Electronics объявила о разработке первых в отрасли чипов высокопроизводительной памяти HBM3E в виде 12-ярусных стеков общей ёмкостью 36 Гбайт. Изделия ориентированы на применение в системах ИИ с большой вычислительной нагрузкой. Новые чипы Samsung HBM3E обеспечивают пропускную способность до 1280 Гбайт/с. По этому показателю, как утверждается, решения более чем на 50 % превосходят доступные на рынке 8-слойные стеки HBM3. При изготовлении чипов Samsung применяет технологию термокомпрессии в комплексе с диэлектрической плёнкой. В результате, суммарная высота полученных 12-слойных изделий эквивалентна высоте 8-слойных. Samsung добилась наименьших в отрасли зазоров в стеке — всего 7 мкм, а также устранила пустоты между слоями. Это позволило поднять плотность вертикальной компоновки более чем на 20 % по сравнению с 8-слойными продуктами HBM3. Кроме того, при производстве стеков Samsung использует между слоями памяти контактные выступы разного размера. Небольшие выступы служат для передачи сигналов, тогда как более крупные улучшают отвод тепла. Такой подход, по заявлениям Samsung, также способствует снижению доли брака. В целом, как утверждается, внедрение 12-слойной памяти HBM3E по сравнению с 8-слойными изделиями даёт возможность увеличить скорость обучения ИИ-моделей на 34 %, тогда как количество одновременно обслуживаемых пользователей систем инференса может вырасти в 11,5 раз. Пробные поставки новых чипов уже начались, а массовое производство намечено на I половину 2024 года. Нужно отметить, что буквально на днях компания Micron объявила о начале массового производства 8-слойной памяти HBM3E на 24 Гбайт с пропускной способностью более 1,2 Тбайт/с. Кроме того, Micron уже в марте начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт.

27.02.2024 [13:25], Сергей Карасёв

Micron начала массовое производство памяти HBM3E для ускорителей NVIDIA H200Компания Micron Technology объявила о начале массового производства передовой памяти HBM3E. Речь идёт об изделиях ёмкостью 24 Гбайт, предназначенных для ИИ-ускорителей NVIDIA H200, которые появятся на коммерческом рынке во II квартале нынешнего года. Чипы Micron HBM3E выполнены в виде 8-ярусного стека. Заявленная скорость передачи данных превышает 9,2 Гбит/с на контакт, а общая пропускную способность сборки превосходит 1,2 Тбайт/с. Вместе с тем, как утверждается, изделия потребляют примерно на 30 % меньше энергии по сравнению с решениями конкурентов. Micron подчёркивает, что чипы HBM3E объёмом 24 Гбайт позволяют дата-центрам беспрепятственно масштабировать различные ИИ-нагрузки — от обучения сложных нейронных сетей до ускорения инференса. Изделия выполнены по технологии 1β (1-бета) — самому передовому техпроцессу компании. Кроме того, применены другие современные методики упаковки чипов, включая усовершенствованную технологию сквозных соединений TSV (Through-Silicon Via). Micron также сообщила, что уже в марте нынешнего года начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт. Они, как и изделия на 24 Гбайт, обеспечат пропускную способность свыше 1,2 Тбайт/с при высокой энергетической эффективности. |

|