Материалы по тегу: hardware

|

16.11.2023 [16:15], Сергей Карасёв

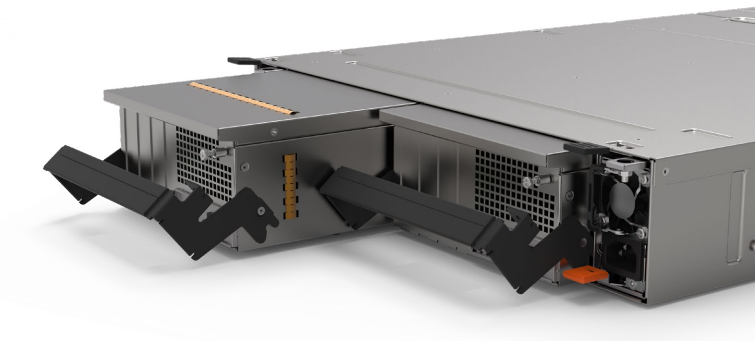

iXsystems представила двухконтроллерные All-Flash СХД TrueNAS F-Series на базе NVMe SSDКомпания iXsystems анонсировала СХД семейства TrueNAS F-Series в форм-факторе 2U. Устройства выполнены на основе NVMe SSD и оснащены двумя контроллерами, а заявленная доступность достигает 99,999 %. Изделия подходят для решения задач в области ИИ, машинного обучения, виртуализации и пр. В серию вошли модификации F60 и F100. Они выполнены в корпусе глубиной 686 мм. Допускается установка 24 накопителей SFF. Каждый из контроллеров наделён 512 Гбайт DRAM-кеша. Предусмотрены два сетевых порта 10GbE и порт управления. Модель TrueNAS F60 располагает четырьмя оптическими портами 40/100GbE, модификация TrueNAS F100 — шестью. Максимальная пропускная способность хранилищ составляет соответственно 20 Гбайт/с и 30 Гбайт/с.

Источник изображения: iXsystems Вместимость достигает 720 Тбайт при использовании SSD на 30 Тбайт. При использовании СХД и дополнительных полок максимальная общая ёмкость составляет 2,1 Пбайт у F60 (две полки) и 3,5 Пбайт у F100 (четыре полки), а эффективная ёмкость послек компресии и дедупликации — 4 Пбайт и 7 Пбайт соответственно.

Источник изображения: iXsystems Реализована поддержка SMB v1/2/3, NFSv3/v4, AFP, FTP, WebDAV, iSCSI, OpenStack Cinder, S3, Minio. Для СХД доступно обновлённое ПО TrueNAS SCALE версии 23.10, основанное на ядре Linux 6.1 и OpenZFS 2.2. Оно предлагает возможности виртуализации KVM, поддержку контейнеров, интеграцию с Kubernetes и функции масштабирования до 1200 накопителей. В версии TrueNAS SCALE 23.10 улучшен пользовательский интерфейс. Габариты СХД составляют 686 × 483 × 89 мм, вес — 19,5 кг без установленных накопителей. Диапазон рабочих температур — от +5 до +35 °C. Пробные поставки СХД TrueNAS F-Series уже начались. Стоимость версии F60 начинается с $60 тыс., модификации F100 — со $100 тыс.

16.11.2023 [15:29], Сергей Карасёв

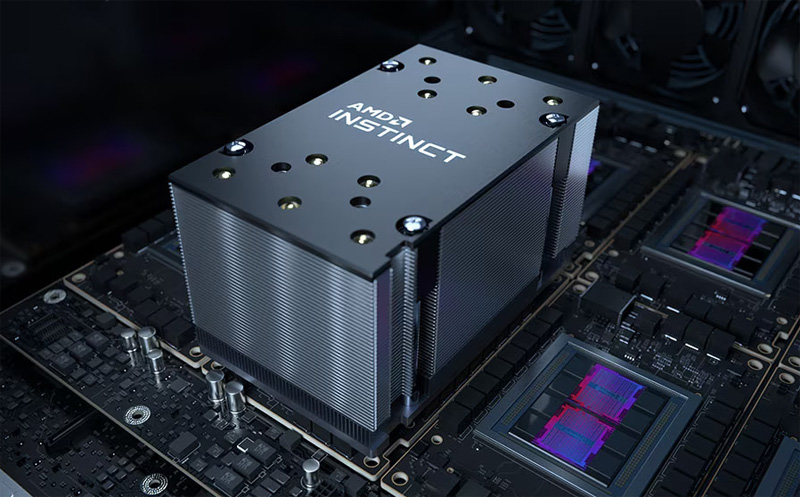

В Microsoft Azure появились инстансы ND MI300X v5 с восемью ускорителями AMD Instinct и процессорами Intel XeonКомпания Microsoft анонсировала инстансы Azure ND MI300X v5 на основе ускорителей AMD Instinct MI300X, представленных летом нынешнего года. Эти ВМ ориентированы на ресурсоёмкие ИИ-нагрузки, в частности, на решение задач инференса. Изделия Instinct MI300X несут на борту 192 Гбайт памяти HBM3 с пропускной способностью до 5,2 Тбайт/с. В составе одной виртуальной машины ND MI300X v5 объединены восемь ускорителей, соединённых между собой посредством Infinity Fabric 3.0, а с хостом — по PCIe 5.0. В сумме это даёт 1,5 Тбайт памяти HBM3, что, как отмечает Microsoft, является самой большой ёмкостью HBM, доступной в облаке. Виртуальные машины Azure ND — это дополнение к семейству решений на базе GPU, такие машины специально предназначены для рабочих нагрузок ИИ и глубокого обучения. Microsoft подчёркивает, что в случае ND MI300X v5 используется та же аппаратная платформа, которая применяется и для других ВМ семейства. Она включает процессоры Intel Xeon Sapphire Rapids, 16 каналов оперативной памяти DDR5, а также подключение NVIDIA Quantum-2 CX7 InfiniBand с пропускной способностью 400 Гбит/с на каждый ускоритель и 3,2 Тбит/с на виртуальную машину.

Источник изображения: AMD По заявлениям Microsoft, на базе ND MI300X v5 могут запускаться самые крупные модели ИИ. Клиенты могут быстро перейти на новые инстансы с других решений серии ND благодаря тому, что открытая платформа AMD ROCm содержит все библиотеки, компиляторы, среды выполнения и инструменты, необходимые для ускорения ресурсоемких приложений.

16.11.2023 [02:43], Алексей Степин

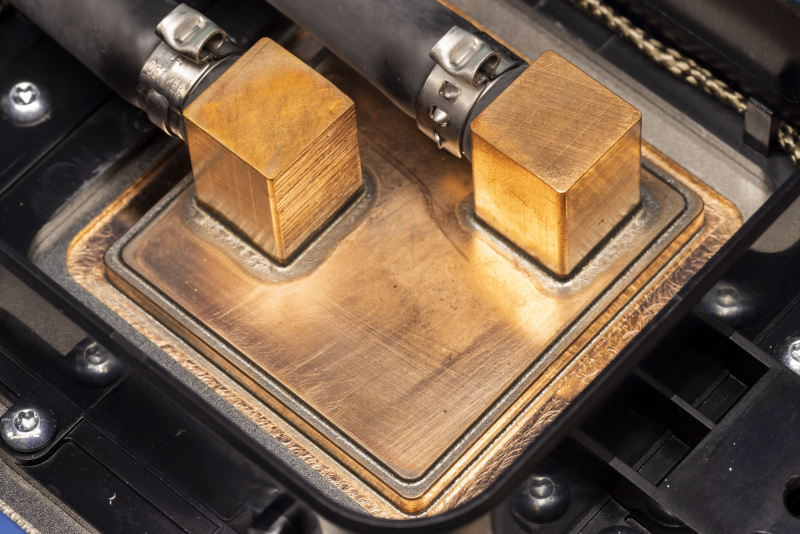

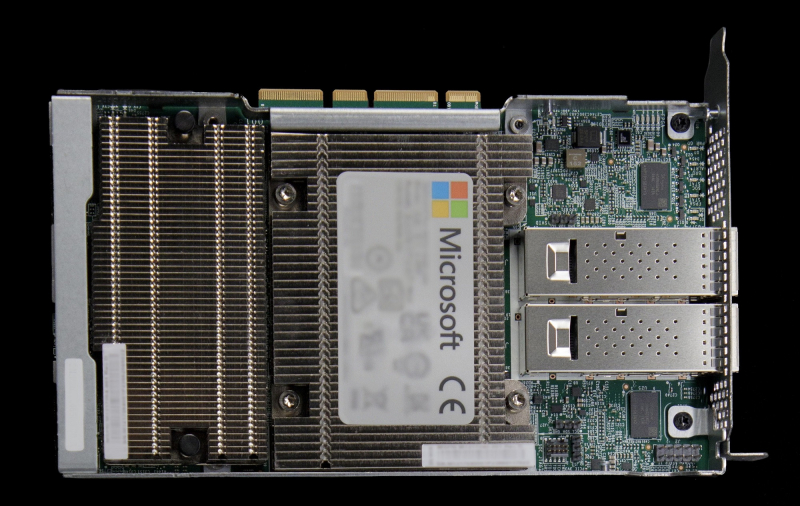

Microsoft представила 128-ядерый Arm-процессор Cobalt 100 и ИИ-ускоритель Maia 100 собственной разработкиГиперскейлеры ради снижения совокупной стоимости владения (TCO) и зависимости от сторонних вендоров готовы вкладываться в разработку уникальных чипов, изначально оптимизированных под их нужды и инфраструктуру. К небольшому кругу компаний, решившихся на такой шаг, присоединилась Microsoft, анонсировавшая Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100. Первопроходцем в этой области стала AWS, которая разве что память своими силами не разрабатывает. У AWS уже есть три с половиной поколения Arm-процессоров Graviton и сразу два вида ИИ-ускорителей: Trainium для обучения и Inferentia2 для инференса. Крупный китайский провайдер Alibaba Cloud также разработал и внедрил Arm-процессоры Yitian и ускорители Hanguang. Что интересно, в обоих случаях процессоры оказывались во многих аспектах наиболее передовыми. Наконец, у Google есть уже пятое поколение ИИ-ускорителей TPU. Microsoft заявила, что оба новых чипа уже производятся на мощностях TSMC с использованием «последнего техпроцесса» и займут свои места в ЦОД Microsoft в начале следующего года. Как минимум, в случае с Maia 100 речь идёт о 5-нм техпроцессе, вероятно, 4N. В настоящее время Microsoft Azure находится в начальной стадии развёртывания инфраструктуры на базе новых чипов, которая будет использоваться для Microsoft Copilot, Azure OpenAI и других сервисов. Например, Bing до сих пор во много полагается на FPGA, а вся ИИ-инфраструктура Microsoft крайне сложна. Microsoft приводит очень мало технических данных о своих новинках, но известно, что Azure Cobalt 100 имеет 128 ядер Armv9 Neoverse N2 (Perseus) и основан на платформе Arm Neoverse Compute Subsystem (CSS). По словам компании, процессоры Cobalt 100 до +40 % производительнее имеющихся в инфраструктуре Azure Arm-чипов, они используются для обеспечения работы служб Microsoft Teams и Azure SQL. Oracle, вложившаяся в своё время в Ampere Comptuing, уже перевела все свои облачные сервисы на Arm. Чип Maia 100 (Athena) изначально спроектирован под задачи облачного обучения ИИ и инференса в сценариях с использованием моделей OpenAI, Bing, GitHub Copilot и ChatGPT в инфраструктуре Azure. Чип содержит 105 млрд транзисторов, что больше, нежели у NVIDIA H100 (80 млрд) и ставит Maia 100 на один уровень с Ponte Vecchio (~100 млрд). Для Maia организован кастомный интерконнект на базе Ethernet — каждый ускоритель располагает 4,8-Тбит/с каналом для связи с другими ускорителями, что должно обеспечить максимально эффективное масштабирование. Сами Maia 100 используют СЖО с теплообменниками прямого контакта. Поскольку нынешние ЦОД Microsoft проектировались без учёта использования мощных СЖО, стойку пришлось сделать более широкой, дабы разместить рядом с сотней плат с чипами Maia 100 серверами и большой радиатор. Этот дизайн компания создавала вместе с Meta✴, которая испытывает аналогичные проблемы с текущими ЦОД. Такие стойки в настоящее время проходят термические испытания в лаборатории Microsoft в Редмонде, штат Вашингтон. В дополнение к Cobalt и Maia анонсирована широкая доступность услуги Azure Boost на базе DPU MANA, берущего на себя управление всеми функциями виртуализации на манер AWS Nitro, хотя и не целиком — часть ядер хоста всё равно используется для обслуживания гипервизора. DPU предлагает 200GbE-подключение и доступ к удалённому хранилищу на скорости до 12,5 Гбайт/с и до 650 тыс. IOPS. Microsoft не собирается останавливаться на достигнутом: вводя в строй инфраструктуру на базе новых чипов Cobalt и Maia первого поколения, компания уже ведёт активную разработку чипов второго поколения. Впрочем, совсем отказываться от партнёрства с другими вендорами Microsoft не намерена. Компания анонсировала первые инстансы с ускорителями AMD Instinct MI300X, а в следующем году появятся инстансы с NVIDIA H200.

15.11.2023 [21:31], Сергей Карасёв

Toshiba несёт убытки на фоне негативных показателей бизнеса Kioxia и сокращения спроса на HDDКорпорация Toshiba обнародовала показатели деятельности в I полугодии 2023 финансового года, которое было закрыто 30 сентября. Выручка за шесть месяцев составила ¥1,5 трлн ($9,98 млрд) против ¥1,6 трлн годом ранее. Таким образом, падение в годовом исчислении зафиксировано на уровне 6 %. Впрочем, негативные тенденции рынка отразились и на Seagate с Western Digital. За рассматриваемый период компания понесла чистые убытки в размере ¥52,14 млрд ($347,57 млн). Для сравнения: в течение первого полугодия 2022 финансового года Toshiba показала чистую прибыль около ¥100,66 млрд. Если рассматривать только II квартал 2023 финансового года, то Toshiba получила ¥26,7 млрд (примерно $176,77 млн) чистых убытков. Для сравнения: годом ранее была продемонстрирована чистая прибыль в размере ¥74,77 млрд. При этом квартальная выручка в годовом исчислении снизилась с ¥854,56 млрд до ¥793,54 млрд, то есть, на 7,1 %.

Источник изображения: Toshiba Негативные результаты Toshiba объясняются двумя основными причинами — сокращением спроса на HDD и отрицательными показателями подразделения по выпуску флеш-памяти Kioxia. Операционные убытки Kioxia во II четверти 2023 финансового года составили ¥100,8 млрд ($664,5 млн), что связано прежде всего со снижением продаж чипов флеш-памяти для смартфонов и накопителей. Отмечается, что в I квартале текущего финансового года операционные потери Kioxia были выше — приблизительно ¥130,8 млрд. Между тем переговоры о слиянии Kioxia и бизнеса флеш-памяти Western Digital развалились на фоне противодействия со стороны SK hynix.

15.11.2023 [16:56], Сергей Карасёв

Российская «дочка» HPE договорилась с дистрибьютором OCS — взыскания на 2 млрд рублей отмененыДевятый арбитражный апелляционный суд, по сообщению «Интерфакса», отменил два решения Арбитражного суда Москвы, который ранее удовлетворил иски дистрибутора OCS Distribution (ООО «О-си-эс-центр») в отношении российского подразделения корпорации Hewlett Packard Enterprise (HPE) — ООО «Хьюлетт паккард энтерпрайз». Стороны заключили мировые соглашения. Российская «дочка» HPE в сложившейся геополитической обстановке прекратила деятельность на российском рынке. При этом компания не выполнила обязательства по договорам и осталась должна партнёрам миллиарды рублей. В этой связи против поставщика оборудования корпоративного класса посыпались многочисленные судебные иски.

Источник изображения: pixabay.com Со стороны ООО «О-си-эс-центр» к российской структуре HPE были поданы два иска: на 1,44 млрд руб. от 31 октября 2022 года и на 551 млн руб. от 5 апреля 2023-го. Оба были полностью удовлетворены минувшим летом. Однако со стороны ООО «Хьюлетт паккард энтерпрайз» была подана апелляция. Как теперь стало известно, оба постановления отменены: суд объявил о прекращении производств по этим делам и утверждении мировых соглашений. Подробности договорённостей между сторонами не раскрываются, поскольку слушания проходили в закрытом режиме. Между тем к российской «дочке» HPE недавно были поданы новые крупные иски на сотни миллионов рублей. Среди них — претензии ООО «Компания Комплит» на сумму 4 859 645,7 руб., ООО «Треолан» на сумму 653 291 714,32 руб. и ООО «Компинтегро» на сумму 2 035 715,33 руб.

15.11.2023 [15:52], Сергей Карасёв

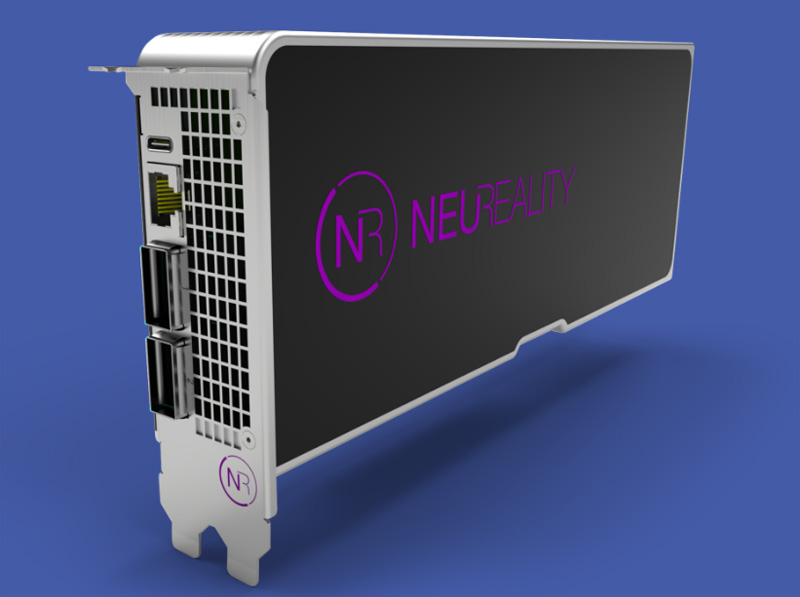

NeuReality представила «сервер на чипе» и другие аппаратные ИИ-решения для инференсаКомпания NeuReality на конференции по высокопроизводительным вычислениям SC23 представила полностью интегрированное решение NR1 AI Inference, предназначенное для ИИ-платформ. Изделие спроектировано специально для ускорения инференса и снижения нагрузки на аппаратные ресурсы. Утверждается, что благодаря использованию технологий NeuReality операторы крупных дата-центров могут на 90 % сократить затраты на выполнение операций ИИ. При этом производительность по сравнению с традиционными системами на основе CPU больше на порядок. Впрочем, конкретные цифры не приводятся.

Источник изображений: NeuReality В продуктовое семейство NeuReality входит решение NR1, которое разработчик называет «сервером на чипе» со встроенным нейросетевым движком. По заявлениям NeuReality, это первый в мире «сетевой адресуемый процессор» — NAPU (Network Addressable Processing Unit). Этот специализированный чип, ориентированный на задачи инференса, обладает возможностями виртуализации и сетевыми функциями.  Изделие NR1 является основой вычислительного модуля NR1-M AI Inference Module, выполненного в виде полноразмерной двухслотовой карты расширения PCIe. Модуль может подключаться к внешнему ускорителю глубокого обучения (DLA). Наконец, анонсирован сервер NR1-S AI Inference Appliance, который оснащается картами NR1-M AI Inference Module. NeuReality отмечает, что данная система позволяет снизить стоимость и энергопотребление почти в 50 раз на операциях инференса по сравнению со стандартными платформами.

15.11.2023 [13:57], Сергей Карасёв

Французский суперкомпьютер Adastra одним из первых получит новейшие ускорители AMD Instinct MI300AФранцузское национальное агентство по высокопроизводительным вычислениям (GENCI), по сообщению HPCwire, проводит масштабное обновление суперкомпьютера Adastra, о запуске которого было объявлено два года назад. После апгрейда система сможет решать сложные задачи в области ИИ. Комплекс Adastra находится под управлением Национального вычислительного центра высшего образования Франции (CINES). Система использует платформу HPE Cray EX235A с оптимизированными процессорами AMD EPYC Milan (64 ядра; 2,0 ГГц) и ускорителями AMD Instinct MI250X. Апгрейд предусматривает использование гибридных чипов Instinct MI300A в составе платформы HPE Cray EX4000, оснащённой 14 серверами HPE Cray EX255a Accelerator Blade. В общей сложности будут задействованы 28 узлов, каждый из которых содержит четыре чипа Instinct MI300A. Таким образом, суммарное количество использованных изделий Instinct MI300A равно 112. Задействован 200G-интерконнект HPE Slingshot 11. Об итоговой производительности обновлённого суперкомпьютера Adastra данных пока нет. Но в прежнем виде система занимает 17-ю строку в ноябрьском рейтинге TOP500 с быстродействием 46,1 Пфлопс (FP64). А в мировом рейтинге самых энергоэффективных НРС-систем GREEN500 комплекс Adastra находится на третьей позиции с показателем 58,021 Гфлопс/Вт.

15.11.2023 [13:16], Сергей Карасёв

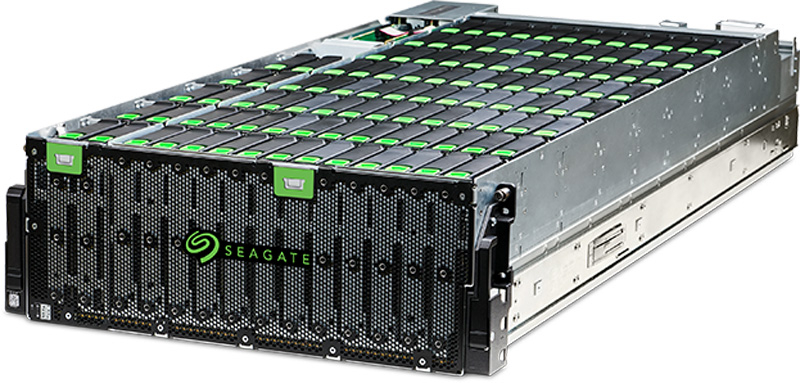

2,5 Пбайт с HAMR: Seagate представила СХД Exos Corvault 4U106Компания Seagate, по сообщению ресурса HPCwire, анонсировала СХД Exos Corvault 4U106 на основе HDD, выполненных по технологии магнитной записи с подогревом (HAMR). Причём накопители отдельно от СХД пока не предоставляются. Система будет предлагаться в модификациях суммарной вместимостью 2,0 и 2,5 Пбайт. Стоечная СХД Exos Corvault 4U106 выполнена в формате 4U и рассчитана на установку 106 накопителей LFF. Применены два контроллера VelosCT, которые функционируют в режиме активный — активный. Для каждого из контроллеров предусмотрены четыре порта mini-SAS-3 HD. Фирменная технология Autonomous Drive Regeneration (ADR) минимизирует время простоя и сокращает количество компьютерных отходов благодаря восстановлению сбойных накопителей. Функция Autonomic Distributed Allocation Protection Technology (ADAPT) повышает надёжность и способствует более эффективному использованию СХД. Возможно шифрование информации. Пропускная способность достигает 12 Гбайт/с при последовательном чтении данных и 10 Гбайт/с при последовательной записи.

Источник изображения: Seagate Габариты системы составляют 176,4 × 441 × 1139 мм, вес — 131,5 кг. Предусмотрен интерфейс 1GbE. Максимальное заявленное энергопотребление — 2000 Вт. Диапазон рабочих температур простирается от +5 до +35 °C. Приём предварительных заказов на СХД Exos Corvault 4U106 с накопителями HAMR начнётся в текущем месяце, а поставки будут организованы к концу декабря.

14.11.2023 [19:26], Сергей Карасёв

TACC получит ИИ-суперкомпьютер Vista с суперчипами NVIDIA GH200 Grace HopperТехасский центр передовых вычислений (TACC) при Техасском университете в Остине (США) на конференции по высокопроизводительным вычислениям SC23 анонсировал суперкомпьютер Vista, ориентированный на задачи ИИ и машинного обучения. Запуск этого комплекса в эксплуатацию запланирован на начало 2024 года. Отмечается, что Vista станет связующим звеном между нынешним суперкомпьютером TACC Frontera и будущей системой TACC Horizon, проект которой финансируется Национальным научным фондом (NSF). Ввод Horizon в строй намечен на 2025 год: ожидается, что этот комплекс будет на порядок быстрее Frontera. Что касается Vista, то эта система знаменует собой переход от традиционной архитектуры х86, которая применяется во Frontera и системах Stampede, в пользу Arm. В частности, будут задействованы суперчипы NVIDIA GH200 Grace Hopper, которые содержат 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H200. В составе Vista чипами GH200 будут оборудованы немногим более половины всех вычислительных узлов. Оставшиеся узлы получат процессор NVIDIA Grace CPU Superchip, содержащий два кристалла Grace в одном модуле (144 ядра).

Источник изображения: TACC Для Vista предусмотрено использование 400G-интерконнекта NVIDIA Quantum-2 InfiniBand. Компания VAST Data предоставит для суперкомпьютера высокопроизводительное флеш-хранилище, подключенное к Stampede3. Вычислительные узлы будут производиться компанией Gigabyte, а интеграцию обеспечит Dell.

14.11.2023 [19:04], Владимир Мироненко

Ускорители NVIDIA GH200 появились во всех облачных регионах VultrVultr, крупнейший в мире частный облачный провайдер, объявил о доступности суперчипа NVIDIA GH200 Grace Hopper во всех своих 32 облачных регионах. Портфолио провайдера также включает предложения на базе HGX H100, A100, L40S, A40 и A16. Vultr видит свою миссию в том, чтобы сделать HPC-решения простыми в использовании и доступными для предприятий и разработчиков по всему миру. Ускорители NVIDIA интегрированы с широким спектром предложений Vultr в области виртуализированных облачных платформ и bare metal, а также с управляемыми кластерами Kubernetes, управляемыми базами данных, блочными и объектными хранилищами и многим другим. Этот комплексный набор продуктов и услуг делает Vultr предпочтительным универсальным облачным поставщиком для предприятий любого размера с критически важными инициативами в области ИИ и машинного обучения, считает компания.

Источник изображения: Vultr Vultr также объявила о получении статуса NVIDIA Elite в партнёрской сети NVIDIA в области вычислений — NVIDIA Partner Network for Compute Competency. Статус ориентирован на партнёров, которые предоставляют вычислительные платформы с ускорителями NVIDIA для корпоративных заказчиков. Партнёры по Compute должны обеспечивать высокую производительность, масштабируемость и безопасность для каждой платформы. |

|