Материалы по тегу: разработка

|

17.06.2025 [14:36], Владимир Мироненко

NVIDIA поможет Германии в создании индустриальных ИИ-облаков для европейских производителейNVIDIA объявила о планах по созданию первого в мире промышленного ИИ-облака для европейских производителей, базирующегося в Германии. ИИ-фабрики, которые развернут по всей стране, будут поддерживать разработку суверенных ИИ-приложений в государственном и частном секторах, в том числе для малых и средних компаний страны, известных как Mittelstand. На Mittelstand приходится 99 % всех предприятий в Германии и более половины экономического производства страны. ИИ-фабрика, построенная на системах NVIDIA DGX B200 и серверах NVIDIA RTX PRO с 10 тыс. ускорителей NVIDIA Blackwell позволит лидерам промышленности Европы ускорить работу индустриальных приложений, включая системы проектирования, инжиниринга и моделирования, цифровых двойников и робототехнику, сообщила компания. ИИ-фабрика будет построена в соответствии с концепцией NVIDIA Omniverse Blueprint. В Юлихском исследовательском центре (FZJ) в Германии идёт сборка суперкомпьютера JUPITER, который станет первой в Европе экзафлопсной системой. Благодаря 24 тыс. суперчипов GH200 с интерконнектом Quantum-2 InfiniBand JUPITER получит вдвое большую вычислительную мощность по сравнению с предыдущим самым мощным общедоступным суперкомпьютером континента. С его помощью исследователи смогут обучать большие языковые модели (LLM) с более чем 100 млрд параметров, заниматься моделированием климата, исследовать квантовых вычисления и разрабатывать лекарства. Во II половине 2026 года в Суперкомпьютерный центр Лейбница (LRZ) в Германии будет запущен суперкомпьютер Blue Lion с чипами NVIDIA Vera Rubin, предназначенный для ускорения исследований в области климата, физики и машинного обучения. NVIDIA также займётся созданием исследовательского центр в Германии в рамках программы NVIDIA AI Technology Center. Баварский ИИ-центр, который планируется создать в сотрудничестве с консорциумом BayernKI, будет продвигать исследования в таких областях, как цифровая медицина, устойчивая диффузия AI и платформы робототехники с открытым исходным кодом для содействия глобальному сотрудничеству. Технологии NVIDIA широко используются немецкими компаниями всех масштабов. В частности, ИИ-компания DeepL из Кёльна развёртывает кластер на базе DGX SuperPOD GB200, который позволит ей переводить весь контент в интернете всего за 18 дней вместо нынешних 194. А модели серии FLUX от Black Forest Labs из Фрайбурга включены в NVIDIA AI Blueprint. Немецкие разработчики систем робототехники, автоматизации и сенсорных систем, включая Agile Robots, idealworks, Neura Robotics и SICK, интегрируют платформу NVIDIA Isaac. Наконец, Finanz Informatik использует инфраструктуру и ПО NVIDIA AI Enterprise для разработки ИИ-ассистента для помощи сотрудникам в обработке банковских данных. Mercedes-Benz использует Omniverse для создания цифровых двойников своих заводов и NVIDIA DRIVE AV/AGX в своих автомобилях. Технологии NVIDIA применяют BMW Group и Continental. NVIDIA также назвала в числе немецких компаний, внедряющих её ИИ-технологии, KION Group, занимающуюся решениями в сфере цепочек поставок, ИИ-стартап в сфере юриспруденции Noxtua и компанию по кибербезопасности Security Networks AG.

Источник изображения: NVIDIA Чтобы инициировать трансформацию ИИ на всех уровнях экономики страны, необходимо обширное сообщество разработчиков в сфере ИИ, отметила NVIDIA. Поэтому Германия инвестирует в образование и повышение квалификации специалистов в области ИИ через некоммерческие организации, университеты и отраслевое сотрудничество. Одной из таких инициатив является appliedAI, крупнейшая в Европе инициатива по применению доверенного ИИ. В её рамках малым компаниям предоставляется доступ к современной инфраструктуре и ПО NVIDIA, практическому обучению и возможность подключения к экосистеме партнёров NVIDIA. Выступая на прошлом неделе с докладом на мероприятии GTC NVIDIA в Париже, гендиректор компании Дженсен Хуанг (Jensen Huang) заявил, что мощности для ИИ-вычислений в Европе вырастут в течение следующих двух лет на порядок. После фактической потери из-за санкций США доступа к рынку Китая, NVIDIA стремится расширить присутствие на новых рынках. Компания уже договорилась о сотрудничестве с французским стартапом Mistral, который построит ИИ-облако на базе 18 тыс. чипов NVIDIA Grace Blackwell. NVIDIA также объявила о запуске инфраструктурных проектов в Италии и Армении. Кроме того, компания заключила соглашения о сотрудничестве с такими телекоммуникационными компаниями, как Orange и Telefonica. В Европе компания уделяет особое внимание «суверенному ИИ», что подразумевает нахождение на территории ЕС дата-центров и серверов, предоставляющих услуги гражданам блока. NVIDIA также объявила о так называемых «технологических центрах» в Европе для передовых исследований, повышения квалификации рабочей силы и ускорении научных прорывов в таких странах, как Великобритания, Франция, Испания и Германия. NVIDIA также расширила возможности GPU-маркетплейса NVIDIA DGX Cloud Lepton.

15.06.2025 [23:29], Владимир Мироненко

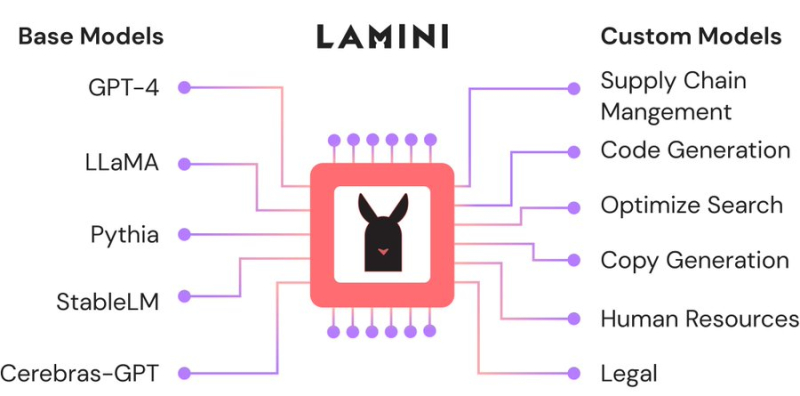

Большая жатва: AMD назначила вице-президентом по ИИ гендиректора ИИ-стартапа Lamini, в который сама же и вложиласьAMD продолжает укреплять команду специалистов в сфере ИИ за счёт привлечения талантливых разработчиков, а также поглощения ИИ-стартапов. На минувшей неделе Шарон Чжоу (Sharon Zhou, вторая справа на фото ниже), соучредитель и гендиректор ИИ-стартапа Lamini (PowerML Inc.) сообщила в соцсети X, что она и несколько сотрудников присоединяются к AMD. Комментируя переход, представитель AMD сообщил ресурсу CRN, что это было наймом специалистов, а не приобретением команды, как это было в случае с разработчиком ИИ-чипов Untether AI, который фактически прекратил существование после сделки. В настоящее время неизвестно, какой будет дальнейшая судьба Lamini, которую в прошлом году покинул Грег Диамос (Greg Diamos), бывший архитектор ПО NVIDIA CUDA, основавший компанию вместе с Чжоу в 2022 году. До основания Lamini Чжоу работала менеджером по ML-продуктам в Google, менеджером по продуктам в ИИ-стартапах Kensho Technologies и Tamr, а также занимала должность внештатного преподавателя компьютерных наук в Стэнфордском университете, где она получила докторскую степень по этой же специальности. В AMD её назначили на должность вице-президента по ИИ. Платформа Lamini позволяет компаниям настраивать и кастомизировать большие языковые модели (LLM) с использованием собственных данных. В частности, Lamini предложила новый подход под названием Mixture of Memory Experts (MoME), направленный на повышение производительности LLM и фактической точности путем радикального снижения частоты галлюцинаций с 50 % до 5 %. Утверждается, что этот подход позволяет значительно сократить объём вычислительных ресурсов для обучения LLM, а также продолжительность этого процесса. В 2023 году AMD представила Lamini как одного из первых независимых поставщиков ПО, поддержавших её ускорители Instinct. В сентябре того же года Lamini сообщила, что использует более чем 100 ускорителей серии Instinct MI200 и что платформа AMD ROCm «достигла программного паритета» с NVIDIA CUDA. До определённого момента ИИ-платформа Lamini была единственной коммерческой платформой, целиком и полностью работающей на базе AMD Instinct. В прошлом году стартап привлек финансирование в размере $25 млн от нескольких инвесторов, включая венчурное подразделение AMD, Эндрю Ына (Andrew Ng), гендиректора Dropbox Дрю Хьюстона (Drew Houston), и Лип-Бу Тана (Lip-Bu Tan), который в начале этого года стал гендиректором Intel. Помимо команды Untether AI, AMD приобрела в течение последних нескольких неделе разработчика систем кремниевой фотоники Enosemi и стартапа Brium, специализирующегося на инструментах оптимизации ИИ ПО для различной аппаратной инфраструктуры.

14.06.2025 [17:04], Владимир Мироненко

Scale AI получила от Meta✴ более $14 млрд, но потеряла гендиректора и рискует лишиться крупных контрактов с Gooogle, Microsoft, OpenAI и xAIИИ-стартап Scale AI, занимающийся подготовкой, оценкой и разметкой данных для обучения ИИ-моделей, объявил о крупной инвестиционной сделке с Meta✴, по результатм которой его рыночная стоимость превысила $29 млрд. Сделка существенно расширит коммерческие отношения Scale и Meta✴. Также её условиями предусмотрен переход гендиректора Scale AI Александра Ванга (Alexandr Wang) и ещё ряда сотрудников в Meta✴. Вместо Ванга, который останется в совете директоров стартапа, временно исполняющим обязанности гендиректора Scale AI назначен Джейсон Дроги (Jason Droege), директор по стратегии, имеющий «20-летний опыт создания и руководства знаковыми технологическими компаниями, включая Uber Eats и Axon». Представитель Scale AI уточнил в интервью ресурсу CNBC, что Meta✴ вложит в компанию $14,3 млрд, в результате чего получит в ней 49-% долю акций, но без права голоса. «Мы углубим совместную работу по созданию данных для ИИ-моделей, а Александр Ванг присоединится к Meta✴ для работы над нашими усилиями по созданию суперинтеллекта», — рассказал представитель Meta✴. Переманивая Ванга, который не имея опыта в R&D, сумел с нуля создать крупный бизнес в сфере ИИ, гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) делает ставку на его организаторские способности, полагая, что укрепить позиции Meta✴ в сфере ИИ под силу опытному бизнес-лидеру, больше похожему на Сэма Альтмана (Sam Altman), чем на учёных, стоящих у руля большинства конкурирующих ИИ-лабораторий, пишет Reuters. Инвестиции в Scale AI станут вторыми по величине в истории Meta✴ после приобретения WhatsApp за $19 млрд. Однако сделка может оказаться не совсем выгодной для Scale AI, предупреждает Reuters, поскольку многие компании, являющиеся клиентами Scale AI, могут отказаться от дальнейшего сотрудничества из-за опасений по поводу того, что Ванг, оставаясь в совете директоров стартапа, будет предоставлять Meta✴ внутреннюю информацию о приоритетах конкурентов. Представитель Scale AI заверил, что инвестиции Meta✴ и переход Ванга не повлияют на клиентов стартапа, и что Meta✴ не будет иметь доступа к его какой-либо деловой информации или данным. Тем не менее, по словам источников Reuters, Google, один их крупнейших клиентов Scale AI, планирует разорвать отношения со стартапом. Источники сообщили, что Google планировала потратить $200 млн только в этом году на услуги Scale AI по подгтовке и разметке данных людьми. После объявления о сделке поисковый гигант уже провёл переговоры с несколькими конкурентами Scale AI. Scale AI получила в 2024 году размере $870 млн, из них около около $150 млн от Google, утверждают источники. По их словам, другие крупные клиенты, включая Microsoft, OpenAI и xAI, тоже планируют отказаться от услуг Scale AI. Официальных подтверждений этой информации пока не поступало. А финансовый директор OpenAI заявил в пятницу, что компания, которой источники тоже приписывают намерение отказаться от услуг Scale AI, продолжит работать со стартапом, как с одним из своих многочисленных поставщиков данных.

09.06.2025 [14:02], Руслан Авдеев

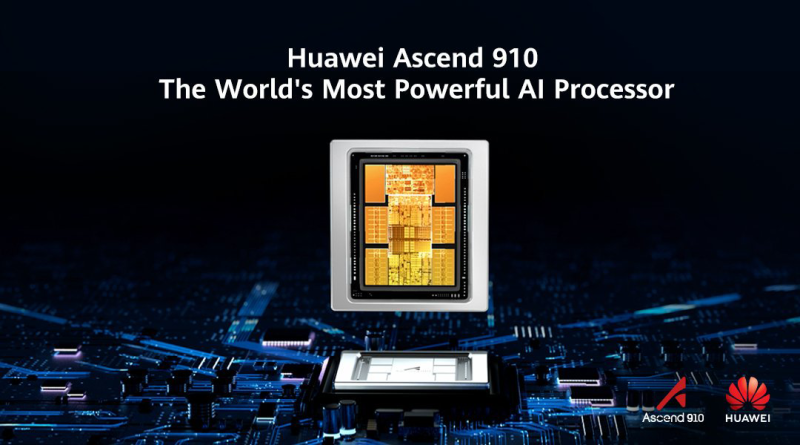

Перегрев, плохое ПО и сила привычки: китайские компании не горят желанием закупать ИИ-ускорители HuaweiНесмотря на дефицит передовых ИИ-ускорителей на китайском рынке, китайская компания Huawei, выпустившая модель Ascend 910C, может столкнуться с проблемами при её продвижении. Она рассчитывала помочь китайскому бизнесу в преодолении санкций на передовые полупроводники, но перспективы нового ускорителя остаются под вопросом, сообщает The Information. Китайские гиганты вроде ByteDance, Alibaba и Tencent всё ещё не разместили крупных заказов на новые ускорители. Основная причина в том, что экосистема NVIDIA доминирует во всём мире (в частности, речь идёт о программной платформе CUDA), а решения Huawei недостаточно развиты. В результате компания продвигает продажи государственным структурам (при поддержке самих властей КНР) — это косвенно свидетельствует о сложности выхода на массовый рынок. Китайский бизнес годами инвестировал в NVIDIA CUDA для ИИ- и HPC-задач. Соответствующий инструментарий, библиотеки и сообщество разработчиков — настолько развитая экосистема, что альтернатива в лице Huawei CANN (Compute Architecture for Neural Networks) на её фоне выглядит весьма слабо. У многих компаний всё ещё хранятся огромные запасы ускорителей NVIDIA, накопленные в преддверии очередного раунда антикитайских санкций, поэтому у их владельцев нет стимула переходить на новые и незнакомые решения. Они скорее предпочтут оптимизировать программный стек, как это сделала DeepSeek, чтобы повысить утилизацию имеющегося «железа». Если бы, например, та же DeepSeek перешла на ускорители Huawei, это подтолкнуло бы к переходу и других разработчиков, но пока этого не происходит. Кроме того, некоторые компании вроде Tencent и Alibaba не желают поддерживать продукты конкурентов, что усложняет Huawei продвижение её ускорителей. Есть и технические проблемы. Самый передовой ускоритель Huawei Ascend 910C периодически перегревается, поэтому возникла проблема доверия к продукции. Поскольку сбои во время длительного обучения модели обходятся весьма дорого. Кроме того, он не поддерживает ключевой для эффективного обучения ИИ формат FP8. Ascend 910С представляет собой сборку из двух чипов 910B. Он обеспечивает производительность на уровне 800 Тфлопс (FP16) и пропускную способность памяти 3,2 Тбайт/с, что сопоставимо с параметрами NVIDIA H100. Также Huawei представила кластер CloudMatrix 384. Наконец, проблема в собственно американских санкциях. В мае 2025 года Министерство торговли США предупредило, что использование чипов Huawei без специального разрешения может расцениваться, как нарушение экспортных ограничений — якобы в продуктах Huawei незаконно используются американские технологии. Такие ограничения особенно важны для компаний, ведущих международный бизнес — даже если они китайского происхождения. Хотя NVIDIA ограничили продажи в Китае, она по-прежнему демонстрирует рекордные показатели. По данным экспертов UBS, у компании есть перспективные проекты суммарной мощностью «десятки гигаватт» — при этом, каждый гигаватт ИИ-инфраструктуры, по заявлениям NVIDIA, приносит ей $40–50 млрд. Если взять вероятную очередь проектов на 20 ГВт с периодом реализации два-три года, то только сегмент ЦОД может обеспечить NVIDIA около $400 млрд годовой выручки. Это подчеркивает доминирующее положение компании на рынке аппаратного обеспечения для ИИ.

06.06.2025 [18:46], Руслан Авдеев

AMD продолжает шоппинг: компания купила стартап Brium для борьбы с доминированием NVIDIAВ последние дни компания AMD активно занимается покупками компаний, так или иначе задействованных в разработке ИИ-технологий. Одним из последних событий стала покупка стартапа Brium, специализирующегося на инструментах разработки и оптимизации ИИ ПО, сообщает CRN. AMD, по-видимому, всерьёз обеспокоилась развитием программной экосистемы после того, как выяснилось, что именно ПО не даёт раскрыть весь потенциал ускорителей Instinct. О покупке Brium, в состав которой входят «эксперты мирового класса в области компиляторов и программного обеспечения для ИИ», было объявлено в минувшую среду. Финансовые условия сделки пока не разглашаются. По словам представителя AMD, передовое ПО Brium укрепит возможности IT-гиганта «поставлять в высокой степени оптимизированные ИИ-решения», включающие ИИ-ускорители Instinct, которые играют для компании ключевую роль в соперничестве с NVIDIA. Дополнительная информация изложена в пресс-релизе AMD. В AMD уверены, что разработки Brium в области компиляторных технологий, фреймворков для выполнения моделей и оптимизации ИИ-инференса позволят улучшить эффективность и гибкость ИИ-платформы нового владельца. Главное преимущество, которое AMD видит в Brium — способность стартапа оптимизировать весь стек инференса до того, как модель начинает обрабатываться аппаратным обеспечением. Это позволяет снизить зависимость от конкретных конфигураций оборудования и обеспечивает ускоренную и эффективную работу ИИ «из коробки». В частности, команда Brium «немедленно» внесёт вклад в ключевые проекты вроде OpenAI Triton, WAVE DSL и SHARK/IREE, имеющие решающее значение для более быстрой и эффективной эксплуатации ИИ-моделей на ускорителях AMD Instinct. У технического директора Brium Квентина Коломбета (Quentin Colombet) десятилетний опыт разработки и оптимизации компиляторов для ускорителей в Google, Meta✴ и Apple.

Источник изображения: AMD Компания сосредоточится на внедрении новых форматов данных вроде MX FP4 и FP6, которые уменьшают объём вычислений и снижают энергопотребление, сохраняя приемлемую точность моделей. В результате разработчики могут добиться более высокой производительности ИИ-моделей, снижая затраты на оборудование и повышая энергоэффективность. Покупка Brium также поможет ускорить создание open source инструментов. Это даст возможность AMD лучше адаптировать свои решения под специфические потребности клиентов из разных отраслей. Так, Brium успешно адаптировала Deep Graph Library (DGL) — фреймворк для работы с графовыми нейронными сетями (GNN) — под платформу AMD Instinct, что дало возможность эффективно запускать передовые ИИ-приложения в области здравоохранения. Такого рода компетенции повышают способность AMD предоставлять оптимальные решения для отраслей с высокой добавленной стоимостью и расширять охват рынка. Brium — лишь одно из приобретений AMD за последние дни для усиления позиций в соперничестве с NVIDIA, доминирование которой на рынке ИИ позволило получить в прошлом году выручку, более чем вдвое превышавшую показатели AMD и Intel вместе взятых. В числе последних покупок — стартап Enosemi, работающий над решениями в сфере кремниевой фотоники, поставщик инфраструктуры ЦОД ZT Systems, а также софтверные стартапы Silo AI, Nod.ai и Mipsology. Кроме того, совсем недавно компания купила команду Untether AI, не став приобретать сам стартап.

21.05.2025 [12:57], Руслан Авдеев

ИИ-платформа Microsoft Discovery создала жидкость для СЖО за 200 часов вместо нескольких месяцев

hpc

microsoft

microsoft azure

software

ии

ии-агент

квантовые вычисления

погружное охлаждение

разработка

сжо

химия

Компания Microsoft запустила для корпоративных пользователей в тестовом режиме ИИ-платформу Microsoft Discovery, использующую ИИ-агентов и HPC для помощи учёным, которым не придётся самостоятельно писать код для своих исследований. Потенциал системы продемонстрировали на примере самой Microsoft — ИИ помог создать новейшую жидкость для погружного охлаждения всего за 200 часов вместо нескольких месяцев или даже лет, сообщает VentureBeat. Microsoft Discovery использовали для поиска охлаждающей жидкости без «вечных» PFAS-химикатов, часто применяемых в иммерсионных СЖО. Регуляторы во всём мире всё чаще запрещают производство и использование этого класса вещества. ИИ Microsoft проверил 367 тыс. веществ-кандидатов, после чего химикат синтезировал один из партнёров компании. Однако сфера применения такого ИИ простирается далеко за пределы создания охлаждающих жидкостей — новые материалы и химикаты требуются в самых разных сферах, но на их поиск часто уходят годы. Microsoft Discovery позволяет взаимодействовать с «невероятными возможностями» ИИ, используя естественный язык, что полностью меняет весь процесс исследований, говорит компания. Обычно учёным приходилось изучать программирование для того, чтобы создавать вычислительные инструменты. Такая демократизация науки сыграет на руку малым исследовательским группам, у которых нет ресурсов на изучение программирования или привлечения сторонних специалистов в этой сфере. Более того, со временем платформа научится работать и с квантовыми компьютерами, написание кода для которых — ещё более сложная задача.

Источник изображения: National Cancer Institute/unsplash.com Работа выполняется с помощью специальных ИИ-агентов, специально обученных для выполнения отдельных научных задач — от написания литературного обзора до создания компьютерной симуляции. По словам Microsoft, ИИ-агенты — это чуть ли не целая команда учёных с докторскими степенями в различных науках. Платформа интегрирует друг с другом базовые модели, занимающиеся общим планированием, и модели, специализирующиеся на физике, химии или, например, биологии. Также Microsoft Discovery позволяет комбинировать закрытые исследовательские данные и результаты уже опубликованных научных исследований по разным дисциплинам, сохраняя прозрачность моделей и контролируя процесс «рассуждений». Для работы с платформой используется интерфейс Copilot, который занимается оркестрацией агентов. Одновременно интерфейс служит и центральным хабом, в котором учёные управляют своей виртуальной ИИ-командой.

Источник изображения: National Cancer Institute/unsplash.com В платформу встроены защитные механизмы — системе заданы «этические координаты». Также применяется модерация контента с проактивным подходом к выявлению злоупотреблений возможностями платформы — маркируются потенциально вредоносные алгоритмы и действия, поскольку все ИИ-инструменты фактически имеют «двойное назначение». С их помощью можно изобретать не только лекарства, но и опасные биологически опасные субстанции. Для своей платформы Microsoft выстраивает экосистему с участием представителей самых разных отраслей, от фармацевтики (GSK) до индустрии красоты (Estée Lauder). NVIDIA интегрирует с Discover микросервисы ALCHEMI и BioNeMo NIM для биотехнологий и фармацевтики. В полупроводниковой сфере Microsoft планирует интеграцию решений Synopsys для ускорения разработки чипов. Адаптацией под конкретные отраслевые задачи, развёртыванием и масштабированием платформы займутся Accenture и Capgemini.

Источник изображения: Microsoft Успех Microsoft Discovery будет зависеть от того, насколько эффективно систему смогут интегрировать в текущие научные процессы — многие учёные скептически относятся к новым методикам, так что компании придётся показать всё, на что способен ИИ. По словам Microsoft, будущее науки именно за сочетанием умственных возможностей человека и масштабного ИИ. Microsoft уже провела предварительную демонстрацию Discovery для ограниченного круга структур. Цены на платформу пока не названы, но доступ к к ней будет организован посредством Azure.

21.05.2025 [10:39], Владимир Мироненко

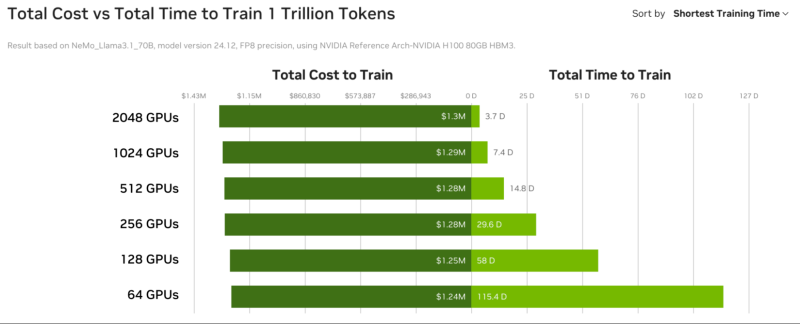

GPU-маркетплейс NVIDIA DGX Cloud Lepton упростит доступ к дефицитным ИИ-ускорителямNVIDIA анонсировала GPU-маркетплейс NVIDIA DGX Cloud Lepton, которая позволит разработчикам со всего мира, создающим агентские и другие ИИ-приложения использовать NVIDIA Blackwell и другие модели ускорителей в глобальной сети партнёрских облаков (NCP): CoreWeave, Crusoe, Firmus, Foxconn, GMI Cloud, Lambda, Nebius, Nscale, Softbank и Yotta Data Services. Ожидается, что ведущие провайдеры облачных услуг и другие GPU-маркетплейсы также присоединятся к DGX Cloud Lepton. Разработчики смогут использовать вычислительные мощности ускорителй в определённых регионах как для вычислений по требованию, так и на постоянной основе. «NVIDIA DGX Cloud Lepton свяжет нашу сеть глобальных поставщиков облачных GPU с разработчиками в сфере ИИ, — заявил основатель и генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang). — Вместе с нашими NCP мы строим ИИ-фабрику планетарного масштаба». По замыслу NVIDIA, платформа DGX Cloud Lepton поможет решить критическую задачу обеспечения разработчиков надёжными, высокопроизводительными ресурсами ускорителей путём унификации доступа к облачным ИИ-сервисам и мощностям собственных ускорителей. Платформа интегрирована с программным стеком NVIDIA, включая микросервисы NIM и NeMo, Blueprints и Cloud Functions. В числе основных преимуществ новой платформы компания назвала:

А для самих провайдеров, участвующих в DGX Cloud Lepton, предоставляется ПО для управления, которое обеспечивает диагностику состояния ускорителей в реальном времени и автоматизирует анализ первопричин возникших проблем, избавляя от ручной диагностики и сокращая время простоев. NVIDIA также анонсировала инициативу Exemplar Clouds, предназначенную для стандартизации прозрачного сравнительного анализа облачной ИИ-инфраструктуры. Это предложение должно решить серьёзную проблему, с которой сталкиваются разработчики и предприятия, развёртывающие рабочие ИИ-нагрузки — прогнозирование эффективности, надёжности и ценовой эффективности облачной платформы. Exemplar Clouds использует NVIDIA DGX Cloud Benchmarking, комплексный набор инструментов и рекомендаций для оптимизации производительности облачных ИИ-нагрузок и количественной оценки связи между стоимостью и производительностью.

19.05.2025 [08:49], Владимир Мироненко

На одном ИИ не выедешь: США рискуют потерять лидерство в HPC

hardware

hpc

top500

государство

дефицит

ии

кадры

квантовые вычисления

обучение

прогноз

разработка

суперкомпьютер

сша

ускоритель

финансы

энергоэффективность

Проблемы, связанные с высокопроизводительными вычислениями (HPC), угрожают инновациям в США, утверждает Джек Донгарра (Jack Dongarra), лауреат премии А. М. Тьюринга и один создателей рейтинга самых мощных суперкомпьютеров в мире TOP500, чьи разработки и реализации многих библиотек, включая EISPACK, LINPACK, BLAS, LAPACK и ScaLAPACK, сыграли важную роль в продвижении HPC. В статье, опубликованной The Conversation, Донгарра рассказал о прогрессе HPC и проблемах с инновациями в США. Учёный отметил, что HPC являются одной из самых важных технологий в современном мире, позволяющей решать различные задачи — от прогнозирования погоды до поиска новых лекарств и обучения ИИ-моделей, которые слишком сложны или слишком велики для обычных компьютеров. Сейчас HPC находятся на переломном этапе, и выбор, который правительство США, исследователи и технологическая отрасль делают сегодня, может повлиять на будущее инноваций, национальной безопасности и мирового лидерства, предупреждает Донгарра. Используя тысячи и даже миллионы чипов с передовыми системами памяти и хранения для быстрого перемещения и сохранения огромных объёмов данных, HPC-платформы позволять выполнять чрезвычайно подробные симуляции и вычисления, говорит Донгарра. Важность HPC ещё больше возросла с развитием ИИ-технологий, требующих огромных вычислительных мощностей для обучения. «В результате ИИ и HPC теперь тесно сотрудничают, подталкивая друг друга вперёд», — отметил учёный. По словам Донгарра, сегмент HPC находится под большим давлением, чем когда-либо, с более высокими требованиями к системам по скорости, данным и энергопотреблению. Также он отметил, что HPC сталкиваются с некоторыми серьёзными техническими проблемами. Донгарра назвал одной из ключевых проблем разрыв между производительностью чипов и подсистем памяти. «Представьте себе, что у вас есть сверхбыстрый автомобиль, но вы застряли в пробке — мощность бесполезна, если дорога не может с ней справиться», — говорит учёный. Точно так же подсистемы памяти не способны «прокормить» вычислительные блоки, которые простаивают, что отражается на эффективности всей вычислительной системы. Ещё одна проблема HPC — энергопотребление. Закон масштабирования Деннарда, согласно которому с уменьшением размеров транзистора уменьшается и энергопотребление при росте производительности, прекратил своё действие в 2006 году. Теперь, чем мощнее компьютеры, тем больше они потребляют энергии. Чтобы исправить это, исследователи ищут новые способы проектирования как аппаратного, так и программного обеспечения HPC. Также существует проблема с типами производимых чипов, отметил учёный. Сейчас индустрия чипов в основном сосредоточена на ИИ, который отлично работает с вычислениями с низкой точностью. Однако для многих научных приложений по-прежнему требуется FP64-вычисления. В частности, NVIDIA сделала ставку исключительно на ИИ, поэтому FP64-производительность новейших GB300 почти в 30 раз меньше, чему GB200. У AMD, по слухам, в следующем поколении Instinct будет сразу два варианта ускорителей MI430X с поддержкой FP64 и MI450X, полностью лишённый тензорных ядер с FP64. Но и она может сделать ставку только на ИИ. Если производители прекратят выпускать чипы, которые требуются учёным, это негативно отразится на выполнении важных исследований. Таким образом тенденции в производстве полупроводников и коммерческие приоритеты могут разниться с потребностями научного сообщества, а отсутствие специализированного оборудования может помешать прогрессу в исследованиях. Можно попытаться создавать специализированные чипы для HPC, но это дорого и сложно. Исследователи, тем не менее, изучают возможность применения новых конструкций для изготовления чипов, включая чиплеты, чтобы сделать их более доступными. В прошлом у США было преимущество в области HPC благодаря государственному финансированию, поддержке и открытости разработок, но теперь многие страны вкладывают значительные средства в HPC в стремлении снизить зависимость от иностранных технологий и выйти на лидирующие позиции в таких областях, как моделирование климата и персонализированная медицина. В Европе развивают программу EuroHPC, у Японии есть собственный суперкомпьютер Fugaku (а скоро будет ещё один), а у Китая — целая серия «автохтонных» машин. Правительства стран понимают, что HPC являются ключом к их национальной безопасности, экономической мощи и научному лидерству, отметил Донгарра, подчеркнув, что у США всё ещё нет чёткого долгосрочного плана на будущее. Другие страны развивают это направление быстро, а без национальной стратегии США рискуют отстать, предупредил он: «Национальная стратегия США должна включать финансирование создания новых машин и обучение людей их использованию. Она также должна включать партнёрство с университетами, национальными лабораториями и частными компаниями. Самое главное, что план должен быть сосредоточен не только на оборудовании, но и на ПО и алгоритмах, которые делают HPC полезными», — заявил учёный. Он отметил, что некоторые шаги в этом направлении уже предприняты, включая принятие в 2022 году «Закона о чипах и науке» (CHIPS and Science Act) и создание управления, которое поможет превратить научные исследования в реальные продукты. В 2025 году также была сформирована целевая группа Vision for American Science and Technology, призванная объединить некоммерческие организации, академические круги и промышленность для помощи правительству в принятии решений. Кроме того, получили развитие квантовые вычисления. Но они пока находятся на ранних стадиях и, скорее всего, будут дополнять, а не заменять традиционные HPC. Поэтому важно продолжать инвестировать в оба вида вычислений. Донгарра назвал это правильными шагами, но они не решат проблему поддержки HPC в долгосрочной перспективе. Помимо краткосрочного финансирования и инвестиций в инфраструктуру, учёный предложил:

Донгарра отметил, что HPC — это больше, чем просто быстрые суперкомпьютеры. Это основа научных открытий, экономического роста и национальной безопасности. Если США примут предложенные меры, то можно гарантировать, что HPC продолжат поддерживать инновации в течение десятилетий.

14.05.2025 [00:23], Владимир Мироненко

Саудовская Аравия всерьёз намерена стать лидером в ИИ: госстартап Humain договорился о многомиллиардном партнёрстве с NVIDIA, AMD и AWSНаследный принц Саудовской Аравии Мухаммед ибн Салман аль-Сауд (Mohammed bin Salman Al Saud) основал новую компанию Humain по разработке ИИ-технологий, пишет Reuters. Развитие этого направления является одним из приоритетов при трансформации экономики страны в соответствии с целями программы «Видение – 2030» (Vision 2030), призванной снизить её зависимость от добычи ископаемого топлива. На сегодняшней встрече Мухаммеда ибн Салмана с президентом США Дональдом Трампом (Donald Trump), находящимся с четырёхдневным визитом в регионе, которая прошла при участии миллиардера Илона Маска (Elon Musk), а также на совместном саудовско-американском инвестиционном форуме в Эр-Рияде, ИИ был одной из центральных тем повестки дня. Humain возглавляет сам наследный принц в качестве председателя. Гендиректором назначен Тарек Амин (Tareq Amin). Компания принадлежит Суверенному фонду Саудовской Аравии, взявшему на себя обязательство вложить значительные средства в развитие ИИ-технологий в стране. Как пишет Bloomberg со ссылкой на агентство Saudi Press Agency, новая компания займётся запуском ЦОД, развертыванием ИИ-инфраструктуры и облачных сервисов, а также разработкой больших языковых моделей (LLM) с поддержкой арабского языка. Компания намерена создать полностью готовую интегрированную ИИ-платформу для решения практических задач. В заявлении компании также указано, что она станет ИИ-центром для таких секторов, как энергетика, здравоохранение, производство и финансовые услуги страны. Поможет ей в этом целый ряд американских технологических компаний. В частности, было объявлено о сотрудничестве с NVIDIA, в рамках которого компании «будут использовать платформы и опыт NVIDIA, чтобы сделать Саудовскую Аравию мировым лидером в области ИИ, облачных GPU-вычислений и цифровой трансформации для стимулирования инноваций и роста во всем мире». В течение следующих пяти лет Humain произведёт крупные инвестиции в строительство ИИ-фабрик в Саудовской Аравии мощностью до 500 МВт, использующих сотни тысяч передовых ускорителей NVIDIA. На первом этапе будет установлено 18 тыс. суперускорителей NVIDIA GB300 с интерконнектом NVIDIA InfiniBand. Эти ИИ ЦОД предоставят надёжную базовую инфраструктуру для обучения и развёртывания суверенных ИИ-моделей, что позволит Саудовской Аравии и другим странам ускорить инновации и цифровую трансформацию, отмечено в пресс-релизе. Сообщается, что Humain также развернёт платформу NVIDIA Omniverse, что позволит таким отраслям, как производство, логистика и энергетика, создавать полностью интегрированные цифровые двойники, повышая эффективность, безопасность и устойчивость производств, а также ускоряя движение страны к «Индустрии 4.0». Также было объявлено о партнёрстве Humain с AMD, в рамках которого будет инвестировано в течение пяти лет до $10 млрд в развертывание в стране ИИ-инфраструктуры мощностью 500 МВт. «Вместе мы создаём глобально значимую ИИ-платформу, которая обеспечивает производительность, открытость и охват на беспрецедентном уровне», — заявила генеральный директор AMD Лиза Су (Lisa Su). Предполагается, что часть мощностей будет введена в эксплуатацию в 2026 году. Humain будет предоставлять услуги клиентам, а AMD — поставлять чипы и ПО. Также Humain подписала соглашение о сотрудничестве с AWS с целью реализации проекта по созданию «Зоны ИИ» (AI Zone) в Саудовской Аравии стоимостью $5 млрд, пишет TechCrunch. Зона будет включать специализированную ИИ-инфраструктуру AWS, серверы, сети. Упомянуты и программы обучения и сертификации. Humain сообщила о планах разрабатывать решения в области ИИ с использованием технологий AWS и работать с AWS над предоставлением доступа к инструментам и ПО для ИИ-стартапов из Саудовской Аравии. Саудовская Аравия обязала компании и ИИ-сервисы хранить данные на территории королевства, стимулируя провайдеров размещать свои объекты в стране, чтобы не потерять имеющиеся контракты. В частности, Google и Oracle объявили о планах по расширению присутствия в регионе. Ранее страна ообъявила о $14,9 млрд инвестиций в ИИ-сектор.

13.05.2025 [09:16], Руслан Авдеев

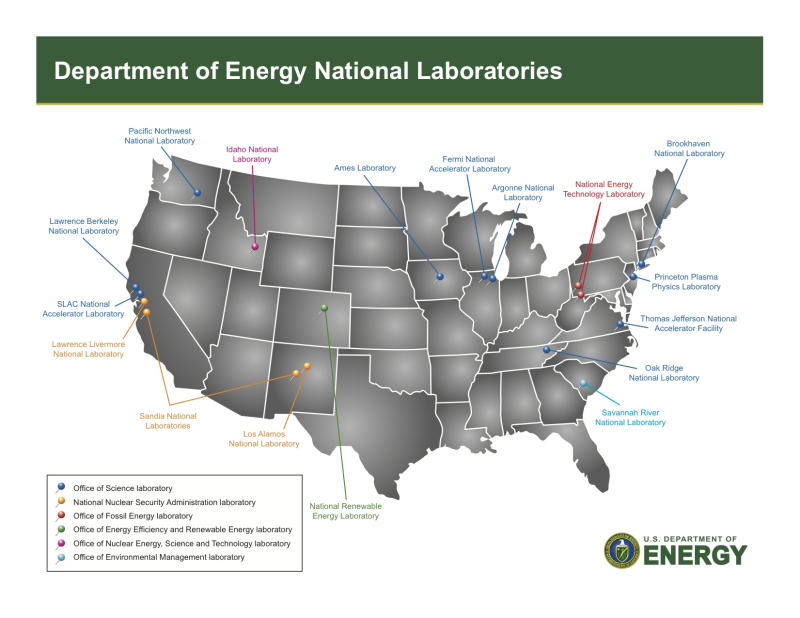

Microsoft надеется, что ИИ ускорит создание термоядерных реакторов, которые смогут запитать ещё больше ЦОД для ИИВ Microsoft уверены, что искусственный интеллект способен помочь ускорить разработку экономически эффективных коммерческих термоядерных реакторов, которые смогут обеспечить энергией сами ИИ ЦОД, сообщает The Register. Пока что ни одного такого реактора не существует. По словам Microsoft Research, стремление использовать ядерный синтез как источник безграничной и чистой энергии «уже давно является одной из самых амбициозных научных целей человечества». Исследователи подчёркивают, что до появления масштабируемой термоядерной энергетики ещё много лет, но уже сейчас изучается вопрос, как ИИ мог бы помочь ускорить разработки. На первом саммите Microsoft Research Fusion Summit, посвящённом термоядерному синтезу, представитель Microsoft Research Accelerator подчеркнул перспективность использования ИИ для дальнейших исследований в области обеспечения экоустойчивости. В настоящее время ИИ-технологии экоустойчивыми не считаются. ООН в прошлому году отмечала, что ИИ ЦОД генерируют электронные отходы, потребляют много воды, критически важных минералов и редкоземельных элементов, при добыче которых также нередко применяют не особенно экобезопасные технологии. И, главное, такие ЦОД используют огромное количество электроэнергии, стимулируя выбросы парниковых газов. Microsoft пытается компенсировать воздействие ЦОД на окружающую среду углеродными кредитами, покупкой «чистой» энергии, оптимизацией оборудования и ПО. Ускоренное развитие технологий ядерного синтеза могло бы компенсировать воздействие бизнеса компании на экологию. По словам представителя Принстонской лаборатории физики плазмы (Princeton Plasma Physics Laboratory, PPPL) Стивена Коули (Steven Cowley), выступившего на Fusion Summit с основным докладом, необходимы дополнительные исследования, чтобы понять, является ли ИИ ключевым звеном для поиска оптимальных решений в термоядерной энергетике. Впрочем, придётся запастись терпением — считается, что до запуска экспериментальных термоядерных установок в эксплуатацию пройдёт не менее десятилетия. Как считают в Национальных академиях наук, инженерии и медицины США (National Academies of Sciences, Engineering, and Medicine, NASEM), частные и государственные инвестиции позволят создать пилотную термоядерную электростанцию 2035–2040 гг. Это приблизительно совпадает с планируемой датой начала работы международного проекта ITER (International Thermonuclear Experimental Reactor). Microsoft надеется, что её наработки в области ИИ для материаловедения, для решения дифференциальных уравнений и для других исследовательских задач помогут найти способ экономически эффективного термоядерного синтеза. Лаборатория Коули уже заключила меморандум о взаимопонимании с Microsoft. Учёные уверены, что ИИ поможет сократить время разработок необходимого профиля. Во всяком случае ИИ является хорошей альтернативой десятилетиям разработки методом проб и ошибок. Microsoft не одинока в своих стремлениях. Например, разработчик атомных технологий Type One Energy и государственная компания Tennessee Valley Authority (TVA) заключили соглашение о совместной разработке планов строительства термоядерной электростанции. OpenAI намерена закупать термоядерную энергию у компании Helion в «огромных объёмах». Последняя в конце января привлекла $425 млн. |

|