Материалы по тегу: ии

|

08.09.2025 [12:11], Сергей Карасёв

Бывший гендиректор AWS Адам Селипски назначен на пост консультанта KKR по ИИИнвестиционная компания KKR, по сообщению ресурса Datacenter Dynamics, назначила на должность старшего консультанта по стратегиям в области технологий и ИИ Адама Селипски (Adam Selipsky), который ранее занимал пост генерального директора облачного провайдера Amazon Web Services (AWS). Селипски с 1995-го по 2005 год работал в компании RealNetworks. Затем стал вице-президентом по маркетингу и поддержке AWS: в этой корпорации он проработал 11 лет, после чего в 2016 году возглавил разработчика ПО для визуализации данных Tableau. В 2021 году вернулся в Amazon, начав исполнять обязанности гендиректора AWS. В KKR Селипски займётся вопросами стратегии, распределения капитала и управления бизнесом Real Assets стоимостью $179 млрд. Речь идёт об активах в сферах дата-центров, оптоволоконных и беспроводных сетей, а также энергетики. В настоящее время KKR владеет и управляет большим количеством ЦОД — 155 объектов по всему миру, а также имеет проектные мощности на 15 ГВт. В активе KKR — двенадцать компаний, которые специализируются на оптоволоконных сетях, обслуживающих почти 30 млн домохозяйств. Компания управляет более чем 130 тыс. объектов беспроводной инфраструктуры по всей Европе и в Азиатско-Тихоокеанском регионе.

Источник изображения: AWS Кроме того, KKR является владельцем фирмы CoolIT, специализирующейся на разработке систем прямого жидкостного охлаждения. В начале текущего года KKR инвестировала средства в Gulf Data Hub — одного из крупнейших операторов дата-центров на Ближнем Востоке. KKR также подписала соглашение на $50 млрд о стратегическом партнёрстве с американской инвестиционной компанией Energy Capital Partners (ECP) с целью строительства ЦОД и реализации энергетических проектов. Ранее KKR в партнёрстве с T-Mobile приобрела поставщика услуг широкополосного доступа в интернет Metronet. Плюс к этому KKR является совладельцем оператора ЦОД CyrusOne. Сообщается также, что KKR ведёт переговоры о приобретении ST Telemedia Global Data Centres, в которой ей принадлежит доля в 15 %, и финансировании дата-центров Meta✴.

08.09.2025 [09:29], Сергей Карасёв

DE-CIX запустила первую в мире платформу обмена ИИ-трафикомОператор точек обмена трафиком DE-CIX объявил о запуске первой в мире специализированной платформы, призванной обеспечить высокоскоростное и надёжное взаимодействие между агентами, сетями и приложениями на базе ИИ. Инфраструктура сформирована в рамках первой фазы проекта AI Internet Exchange (AI-IX). К платформе уже подключены более 50 сетей, ориентированных на задачи ИИ. Это, в частности, провайдеры инференс-услуг и GPUaaS, а также поставщики облачных сервисов. AI-IX, как утверждается, обеспечивает отказоустойчивое и высокозащищённое соединение с низкими задержками, специально предназначенное для сценариев использования ИИ в режиме реального времени. Это могут быть мультимодальные агенты, робототехнические устройства, системы автономного вождения и пр. Платформа использует проприетарную масштабируемую систему маршрутизации. Вторая фаза проекта AI-IX предполагает поддержку Ultra Ethernet для формирования географически распределённой среды обучения ИИ. Задачей консорциума Ultra Ethernet, созданного в июле 2023 года, является разработка ИИ/HPC-интерконнекта на базе Ethernet. DE-CIX отмечает, что с появлением Ultra Ethernet меняется подход к проектированию инфраструктуры для ресурсоёмких вычислений. Становится возможным объединение географически распределённых узлов, что предоставляет компаниям новые возможности в плане создания отказоустойчивой и более экономичной частной инфраструктуры ИИ. В целом, как подчёркивает DE-CIX, пиринговые сети ИИ предлагают ряд преимуществ как для задач инференса, так и для обучения моделей. Среди них — снижение затрат, повышение безопасности, увеличение производительности и повышение гибкости.

08.09.2025 [08:47], Руслан Авдеев

Из грязи в князи: Fluidstack, в штате которой было всего 10 человек, получила многомиллиардный контракт на создание «атомного» ИИ-облака во ФранцииНе самый известный британский стартап Fluidstack в феврале этого года подписал соглашение с французскими властями о создании в стране ИИ-кластера на 1 ГВт, запитанного от французских АЭС. Fluidstack, в которой в 2024 году работало всего 10 штатных сотрудников, стала неожиданным для экспертов исполнителем проекта по созданию «атомного» ИИ ЦОД за $11,6 млрд для 500 тыс. ускорителей, сообщает Forbes. В июне Fluidstack заявила, что общий бюджет проекта французских ЦОД может превысить $46 млрд. Сделка — лишь часть пакета инвестиций в ИИ-инфраструктуру на $113 млрд, которые Макрон анонсировал в феврале. Многомиллиардные обязательства в соответствующей сфере взяли на себя канадский пенсионный фонд Brookfield, французский государственный инвестиционный банк BPIFrance и ИИ-фонд MGX из ОАЭ. Основанная в 2017 году Fluidstack потратила годы на освоения рынка ИИ. Сначала стартап буквально сводил вместе обладателей простаивающих ускорителей и клиентов с небольшими бюджетами. В 2022 году выручка компании составила $1,8 млн, тогда же был запущен ChatGPT. В 2023 году она выросла до $30 млн, а в 2024-м — до 66,2 млн. Правда, за тот же период финансовые показатели изменились с $1,72 млн прибыли до убытков в размере $735 тыс. В 2024 году около половины выручки пришлось на сделки с компаниями из США. Сообщалось о сделках с Meta✴, европейскими Mistral, Black Forest Labs и Poolside.

Источник изображения: Razvan Chisu/unspalsh.com После объявления о сделке с французским правительством компания создала подразделения для операций во Франции, Исландии, Норвегии, Аргентине и США. Fluidstack позиционируется как европейский конкурент американским «неооблакам» вроде CoreWeave или Lambda и традиционным облачным гигантам, включая Google, AWS, Microsoft и Oracle. Стартап всё ещё арендует помещения и ускорители у других компаний. В прошлом месяце заключена сделка с майнером TeraWulf на $3,2 млрд, связанная с арендой 360-МВт ИИ ЦОД в штате Нью-Йорк. Сделку поддержала Google, взявшая на себя обязательство финансово подстраховать Fluidstack и нарастившая долю в Terawulf. Уникальность сделки ещё и в том, что Google, по-видимому, впервые предложила развернуть фирменные ИИ-ускорители TPU не в собственном облаке. Для Fluidstack, публично сообщавшей о привлечении лишь $4,5 млн, это огромная сделка. Годовая отчётность показала, что стартап привлёк в ходе ранее не разглашавшегося раунда SAFE $24,7 млн, а также займы на $37,5 млн в 2024 году. Имена инвесторов и кредиторов не разглашаются. Также сообщалось, что компания ведёт переговоры о привлечении до $200 млн. Впрочем, сумма всё равно невелика в сравнении со средствами, которые привлекли другие игроки вроде CoreWeave, Nebius или Crusoe.

Источник изображения: Guille Álvarez/unsplash.com Для финансирования Fluidstack, похоже, обратилась не к венчурным капиталистам. В апреле она заключила соглашение с австралийским инвестиционным банком Macquarie и другими кредиторами, в рамках которой может получить до $10 млрд под залог ускорителей. CoreWeave первой прибегла к схеме финансирования, при которой ИИ-ускорители используются в качестве обеспечения по кредитам и могут быть изъяты кредитором, и получила суммарно около $8,1 млрд. CoreWeave стала своеобразным индикатором для всего сектора. В июне капитализация компании взлетела до $88 млрд, но сейчас её акции упали. Также усилились опасения инвесторов из-за покупки Core Scientific за $9 млрд, растущих убытков, непогашенной задолженности в размере $7,5 млрд и грядущих расходов на оборудование. Кроме того, более ¾ выручки компании принесли всего два клиента: Microsoft (в интересах OpenAI) и NVIDIA. Банк UBS рассчитал, что в 2025 году компании по всему миру потратят на ИИ-инфраструктуру $375 млрд. В начале сентября сообщалось, что Goldman Sachs допускает крах «пузыря» ИИ на фоне бума в сфере ЦОД. Исследование компании свидетельствует, что к 2027 году мощность ЦОД вырастет на 50 % благодаря спросу на ИИ, а энергопотребление сектора удвоится уже к 2030 году. При этом эксперты отмечают, что массовое внедрение ИИ может не оправдать ожиданий инвесторов.

07.09.2025 [13:29], Руслан Авдеев

OpenAI намерена потратить $115 млрд к 2029 годуOpenAI значительно увеличила прогноз затрат до 2029 года. Поскольку компания наращивает расходы на поддержку ИИ-проектов, общая сумма в этот период составит до $115 млрд, сообщает Reuters со ссылкой на данные The Information. Согласно новым данным, ожидаемые расходы увеличатся на $80 млрд. Согласно отчёту компании, OpenAI, ставшая одним из ключевых арендаторов ИИ-серверов в мире, рассчитывает потратить в текущем году более $8 млрд — приблизительно на $1,5 млрд больше, чем ожидалось ранее. В самой компании не отреагировали на вопросы журналистов. По данным The Information, в следующем году расходы вырастут до более чем $17 млрд, на $10 млрд выше, чем OpenAI рассчитывала ранее. В 2027 году будет потрачено $35 млрд, а в 2028 году — $45 млрд. Для того, чтобы обуздать растущие расходы, OpenAI разрабатывает собственные ИИ-чипы, а также оборудования для обеспечения работы своих решений. Ускоритель, разрабатываемый совместно с Broadcom, должен появиться в 2026 году. По словам Financial Times, OpenAI намерена использовать чип для обеспечения потребностей в вычислениях самой компании, без продажи его третьим лицам. Впрочем, Google, также создавшая ускорители TPU для собственных нужд, начала продвижение своих ускорителей на «внешнем» рынке. OpenAI углубила свои связи с Oracle в июле 2025 года, запланированная арендная мощность ЦОД составляет 4,5 ГВт в рамках инициативы Stargate. Проект предусматривает траты до $500 млрд и создание мощностей до 10 ГВт с участием SoftBank Group. В число поставщиков вычислительных мощностей добавили и Google Cloud.

07.09.2025 [01:30], Владимир Мироненко

NVIDIA потратит $1,5 млрд на аренду собственных ИИ-ускорителей у Lambda, в которую сама же и инвестировалаNVIDIA, являющаяся поставщиком и инвестором Lambda, стала её крупнейшим клиентом. Как сообщает ресурс The Information, компания заключила соглашения со стартапом на общую сумму $1,5 млрд, которая пойдёт на аренду серверов, оснащённых её собственными ускорителями. По данным источников The Information, NVIDIA заключила соглашение под кодовым названием Project Comet об аренде 10 тыс. ускорителей NVIDIA сроком на четыре года на сумму около $1,3 млрд, а также отдельную сделку на $200 млн на аренду еще 8 тыс. ускорителей NVIDIA (возможно, более низкого класса или более старых моделей). Похожую сделку по аренде собственных ускорителей NVIDIA ранее заключила с CoreWeave в которую до этого она же и инвестировала. Такие сделки относятся к разряду «циклических» финансовых соглашений, используемых NVIDIA для продвижения своих чипов и оказания помощи небольшим поставщикам облачных услуг в конкуренции с традиционными гиперскейлерами. В режиме «внутреннего круговорота» ИИ-рынка NVIDIA одновременно выступает поставщиком, инвестором и заказчиком, поддерживая несколько неооблаков. По неофициальным данным, точно такая же ситуация и у AMD с TensorWave. Эти циклические соглашения подчёркивают, насколько ограниченным стало предложение мощных ускорителей. Несмотря на то, что NVIDIA доминирует в разработке и производстве чипов, она предпочитает сотрудничать с более мелкими игроками, такими как Lambda и CoreWeave, чтобы обеспечить себе доступ к готовой ИИ-инфраструктуре. Бизнес-модель Lambda такая же, как у CoreWeave. Она включает в себя аренду площадей в ЦОД, развёртывание серверов, оснащённых ускорителями NVIDIA, с последующим предоставлением мощностей в аренду. Что примечательно, NVIDIA, подобно Amazon и Microsoft, будет использовать арендуемые у Lambda серверы для собственных исследований. Контракты с Amazon и Microsoft принесли Lambda во II квартале почти $114 млн дохода. Как сообщает futunn.com, Lambda ожидает, что её выручка от облачных технологий превысит $1 млрд к 2026 году и $20 млрд к 2030 году и надеется на контракты с крупными разработчиками в сфере ИИ, такими как OpenAI, Google, Anthropic и xAI. Lambda также ожидает, что к 2030 году её мощности достигнут почти 3 ГВт, тогда как во II квартале она составляла всего 47 МВт. К этому моменту компания рассчитывает получить в своё распоряжение 1 млн ускорителей NVIDIA. Сейчас Lambda готовится к выходу на биржу, что упростит расширение деятельность за счёт заёмного финансирования. С Lambda связана и ещё одна необычная сделка — в прошлом году Supermicro, которая является одним из ключевых поставщиков Lambda, впервые арендовала дата-центр и тут же сдала его в субаренду Lambda. По словам экспертов, NVIDIA высоко оценивает сотрудничество с Lambda из-за нескольких факторов, один из которых заключается в том, что Lambda привлекает всё больше клиентов к переходу на её ускорители. Например, недавно Lambda подписала годовое соглашение со стартапом Midjourney, которое позволило ему перейти от ИИ-чипов Google TPU к ускорителям NVIDIA Blackwell. При этом Google, по слухам, тоже предлагает неооблаками свои фирменные ускорители.

06.09.2025 [14:47], Владимир Мироненко

Broadcom получила нового клиента с заказом на $10 млрд — акции взлетели на 15 %Компания Broadcom сообщила результаты III квартала 2025 финансового года, завершившегося 3 августа. Основные показатели компании за квартал превысили прогнозы Уолл-стрит благодаря сохраняющемуся высокому спросу на ИИ-решения. Хок Тан (Hock Tan, на фото ниже), президент и гендиректор Broadcom, которому, согласно поданным в марте в регулирующие органы документам, в этом году исполнилось 73 года, заявил, что намерен возглавлять компанию как минимум ещё пять лет. Как сообщает Reuters, эта новость была позитивно воспринята инвесторами. Ещё больше восторга вызвало заявление Тана о том, что компания получила заказ от нового клиента на разработку и поставку кастомного ИИ-чипа на сумму более $10 млрд, после чего акции компании взлетели в пятницу на 15 %, пишет CNBC. По мнению аналитиков, речь идёт об OpenAI. Это подтвердил со ссылкой на информированные источники ресурс The Financial Times, сообщивший, что новый чип, созданный в результате партнёрства двух компаний, выйдет в 2026 году. Ранее в этом году Тан намекал, что у компании в дополнение к трём существующим крупным клиентам есть ещё четыре крупных потенциальных клиента, проявляющих интерес к разработке кастомных ИИ-решений. Хотя Broadcom не раскрывает названия своих крупных клиентов в сфере ИИ-технологий, ещё в прошлом году аналитики утверждали, что это Google, Meta✴ и ByteDance (TikTok). «Один из этих потенциальных клиентов разместил заказ на производство в Broadcom, и мы охарактеризовали его как квалифицированного клиента для XPU», — сообщил, по данным ресурса SiliconANGLE, Тан. Он добавил, что этот заказ стал основанием для повышения прогноза Broadcom по выручке от ИИ-решений в следующем году, когда начнутся поставки. Выручка Broadcom в III финансовом квартале составила $15,95 млрд, превысив на 22 % результат аналогичного квартала годом ранее и консенсус-прогноз аналитиков, опрошенных LSEG, в размере $15,83 млрд. Скорректированная прибыль (Non-GAAP) на акцию равняется $1,69, что выше целевого показателя Уолл-стрит в $1,65 на акцию. Чистая прибыль (GAAP) составила $4,14 млрд или $0,85 на акцию, тогда как годом ранее у компании были убытки в $1,88 млрд или $0,40 на акцию, вызванные единовременным налоговым возмещением в размере $4,5 млрд, связанным с передачей интеллектуальной собственности в США. Скорректированный показатель EBITDA увеличился на 30 % до $10,70 млрд с $8,22 млрд в прошлом году, составив 67 % выручки. «Свободный денежный поток составил рекордные $7,0 млрд, увеличившись на 47 % по сравнению с аналогичным периодом прошлого года», — отметила в пресс-релизе Кирстен Спирс (Kirsten Spears), финансовый директор Broadcom. Тан сообщил, что выручка от ИИ-продуктов выросла год к году на 63 % до $5,2 млрд, добавив, что в IV финансовом квартале компания ожидает получить выручку по этому направлению в размере $6,2 млрд, «что обеспечит одиннадцать кварталов роста подряд,». Вместе с тем Тан отметил слабость в сегменте полупроводников, не связанных с ИИ: продажи корпоративных решений в области сетей и хранилищ последовательно снизились. Объём продаж группы полупроводниковых решений Semiconductor Solutions составил $9,17 млрд (+26 % г/г), а выручка от инфраструктурного ПО выросла до $6,79 млрд (+17 % г/г) благодаря VMware. В IV финансовом квартале Broadcom ожидает получить выручку в размере $17,4 млрд, что выше прогноза Уолл-стрит в $17,02 млрд. Как сообщает ресурс Converge! Network Digest, Broadcom также ожидает, что рост выручки от ИИ-чипов на уровне около 60 % в годовом исчислении в текущем финансовом году сохранится и в 2026 финансовом году благодаря росту потребности в рабочих нагрузках обучения и инференса. Компания также подтвердила свои предыдущие прогнозы по развёртыванию многомиллионных ИИ-кластеров тремя основными клиентами в 2027 году.

06.09.2025 [13:42], Сергей Карасёв

Состоялся официальный запуск первого в Европе экзафлопсного суперкомпьютера JUPITERВ Юлихском исследовательском центре (FZJ) в Германии официально введён в эксплуатацию суперкомпьютер JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research) — первый в Европе вычислительный комплекс экзафлопсного класса. Система будет использоваться в том числе для исследований в области климата, нейробиологии и квантового моделирования. Контракт на создание JUPITER подписан между Европейским совместным предприятием по развитию высокопроизводительных вычислений (EuroHPC JU) и консорциумом, в который входят Eviden (Atos) и ParTec. Суперкомпьютер состоит из блока Booster для решения ресурсоёмких задач и универсального блока cCuster. В основу Booster положена платформа BullSequana XH3000 с прямым жидкостным охлаждением. Используются около 6000 вычислительных узлов с гибридными ускорителями NVIDIA Quad GH200 и интерконнектом InfiniBand NDR200 (4×200G на узел, DragonFly+). В общей сложности задействованы почти 24 тыс. суперчипов NVIDIA GH200 (Grace Hopper). В июньском рейтинге TOP500 блок JUPITER Booster располагался на четвёртом месте: на тот момент его FP64-производительность составляла 793,4 Пфлопс. Теперь показатель преодолел рубеж в 1 Эфлопс. При этом ИИ-производительность, как ожидается, будет находиться на уровне 90 Эфлопс. «С запуском первого в Европе эксафлопсного суперкомпьютера мы открываем новую главу в развитии науки, искусственного интеллекта и инноваций. JUPITER укрепляет цифровой суверенитет Европы и ускоряет научные исследования», — отмечает Екатерина Захариева (Ekaterina Zaharieva), еврокомиссар по стартапам, исследованиям и инновациям. JUPITER планируется использовать для прогнозирования погоды и моделирования изменений климата, работы с европейскими большими языковыми моделями (LLM) и генеративным ИИ, разработки лекарственных препаратов и картирования человеческого мозга, моделирования молекулярной динамики и пр. Ожидается, что JUPITER сможет побить мировой рекорд по скорости обработки кубитов в квантовых вычислениях. Между тем продолжается создание блока cCuster. В его состав войдут энергоэффективные высокопроизводительные Arm-процессоры SiPearl Rhea1. Эти чипы содержат 80 ядер Neoverse V1 (Zeus), 64 Гбайт HBM2e и четыре интерфейса DDR5. Модуль cCuster будет оснащён двумя такими процессорами на каждый вычислительный узел, 512 Гбайт DDR5 (в отдельных узлах 1 Тбайт) и одним NDR200-подключением. Общее количество узлов составит около 1300. Ожидаемая FP64-производительность — 5 Пфлопс. Хранилище суперкомпьютера включает быструю СХД ExaFLASH и ёмкую ExaSTORE. ExaFLASH включает 20 All-Flash СХД IBM Storage Scale 6000: 21 Пбайт («сырая» 29 Пбайт), запись до 2 Тбайт/с, чтение до 3 Тбайт/с. В ExaSTORE под хранение будет выделена «сырая» ёмкость 300 Пбайт, а для резервного копирования и архивов будет использоваться ленточная библиотека ёмкостью 700 Пбайт. По оценкам, суммарные расходы на JUPITER и его эксплуатацию в течение шести лет достигнут примерно €500 млн. Половину от этой суммы предоставит EuroHPC, а остальную часть покроют Федеральное министерство образования и научных исследований Германии (BMBF) и Министерство культуры и науки земли Северный Рейн-Вестфалия (MKW NRW). Машина размещена в модульном ЦОД, что упростит дальнейшую модернизацию. Нужно отметить, что на сегодняшний день только три суперкомпьютера в мире официально преодолели планку в 1 Эфлопс. Это машины El Capitan, Frontier и Aurora: все они установлены в лабораториях Министерства энергетики США (DoE). Впрочем, Китай о своих HPC-комплексах публично практически не говорит уже несколько лет, так что реальный список экзафлопсных систем гораздо больше.

05.09.2025 [15:30], Руслан Авдеев

«Мрачная научная фантастика»: США намерены заставить NVIDIA и AMD продавать ИИ-ускорители американцам в приоритетном порядкеАмериканские законодатели намерены применить принцип «Америка превыше всего» к продаже передовых полупроводников, предполагающий право преимущественного приобретения чипов местными компаниями, сообщает The Register. В законопроекте «О гарантиях доступа и инноваций для национального ИИ» (GAIN AI Act), представляющим собой поправки в «Закон о национальной обороне», заявляется, что организации США, включая стартапы и университеты, должны получать наилучшие возможности для инноваций и использования потенциала искусственного интеллекта. Если законопроект будет одобрен Конгрессом США и президентом, экспортёров ждут важные изменения. Желающие получить экспортные лицензии в страны, «вызывающие обеспокоенность», должны будут подтвердить, что весь внутренний спрос на их продукцию удовлетворён, а американские покупатели имели приоритетный доступ к чипам. Министерство торговли США будет отказывать в выдаче лицензий на экспорт наиболее производительных ИИ-чипов, если американские организации ожидают поставок. При этом, согласно новым правилам, под экспортные ограничения попадут не только серверные ускорители, но и игровые GPU класса RTX 5090. Вполне ожидаемо, в NVIDIA не восторге от возможных изменений. В компании называют такие правила «мрачной научной фантастикой» — продажи по всему миру якобы ничего не лишают американских клиентов, а лишь расширяют рынок для многих американских бизнесов и целых отраслей. «Подкидывающие» Конгрессу фейковые новости эксперты лишают Америку шанса на лидерство в сфере ИИ, заявляют в NVIDIA. Глава компании Дженсен Хуанг (Jensen Huang) неоднократно говорил, что запреты только помогают Китаю развивать собственные ИИ-компетенции.

Источник изображения: Joe Richmond/unsplash.com NVIDIA считает, что GAIN AI Act опирается на ошибочную логику и фундаментальное непонимание работы цепочек поставок. В документе утверждается, что спрос на ускорители сейчас значительно превышает предложение, но именно так, по мнению NVIDIA, и должен работать свободный рынок. Более того, сами по себе чипы бесполезны, если их негде развернуть. Нужны современные ЦОД, оснащённые современными же системами охлаждения, электропитания и др. По словам Хуанга, NVIDIA отдаёт приоритет покупателям, готовым внедрять новые решения, а иначе ускорители и оборудование будут без дела лежать на складах. Стоит отметить, что законопроект GAIN AI Act запрещает и производство передовых чипов специально для стран, «вызывающих обеспокоенность». Это весьма недвусмысленная отсылка к урезанным ускорителям NVIDIA H20 и AMD MI308 для китайского рынка. Летом США одобрила возобновление их экспорта в обмен на 15 % от всей выручки таких поставок. В GAIN AI Act также утверждается, что большее количество чипов для КНР означает меньшее количество чипов для США, но в законопроекте не учитывается, насколько слабее «оптимизированные» для КНР. H20 основана на технологии трёхлетней давности и практически на порядок менее производителен, чем чипы Blackwell, продаваемые американским клиентам. Более того, H20 опирается на старый техпроцессе TSMC, который не может использоваться для выпуска Blackwell (как рассчитывают авторы законопроекта). Другими словами, новый закон может лишь закрыть крупный рынок для NVIDIA и AMD, в то же время способствуя появлению всё более конкурентоспособных китайских полупроводников.

05.09.2025 [12:34], Руслан Авдеев

Трансформаторы для трансформеров: Hitachi Energy вложит $1 млрд в выпуск энергооборудования для ИИ ЦОД в СШАHitachi Energy вложит $1 млрд в выпуск критически важных компонентов энергосетей в США в связи с растущим спросом на электричество со стороны ИИ ЦОД. Шаг является частью глобального инвестиционного плана компании, в рамках которого она намерена потратить $9 млрд на развитие производства, НИОКР и работу с партнёрами. Большая часть инвестиций в США — $457 млн — пойдёт на новый завод электротрансформаторов в Южном Бостоне (штат Вирджиния). Это крупнейшее предприятие такого рода в стране, и вложения позволят создать 825 новых рабочих мест. Также средства будут направлены расширения уже действующих в стране предприятий Hitachi Energy — это должно укрепить цепочки поставок высоковольтного оборудования в США. Инвестиции уже поддержали администрация президента США, руководство штата Вирджиния и члены Конгресса. Они приветствовали снижение зависимости от импорта и повышение энергетической безопасности страны на фоне развития ИИ-технологий и сопутствующего роста спроса на электричество. Новый объект в Вирджинии поможет модернизации электросетей, предложив силовые трансформаторы для ИИ ЦОД, крупных производственных проектов и высоковольтных ЛЭП. Hitachi заявила, что тысячи рабочих мест будут созданы по всей территории США, а не только в Вирджинии.

Источник изображения: Ferdinando/unsplash.com Массовое строительство ИИ ЦОД меняет приоритеты энергетической инфраструктуры США, а трансформаторы являются для неё критически важным элементом. При этом сроки поставок трансформаторов иногда растягиваются на годы. Размещая производство непосредственно в США, Hitachi решит проблему уязвимости цепочки поставок и сможет быстрее удовлетворить неотложные потребности гиперскейлеров. Siemens Energy и GE Vernova также наращивают мощности по выпуску трансформаторов, что свидетельствует об общей тенденции в отрасли, делающей ставку на выпуск критически важного электрооборудования в стране. В июне Deloitte сообщала, что прожорливость ИИ ЦОД может привести к перегрузке энергетической инфраструктуры США. Потребность американских ИИ ЦОД в энергии к 2035 году может вырасти в 30 раз, до 123 ГВт с 4 ГВт в 2024 году. При этом работающие с ИИ-оборудованием дата-центры требуют гораздо больше энергии на единицу площади, чем классические. Впрочем, с перспективами рынка не всё просто — Goldman Sachs допустила крах «пузыря» ИИ на фоне бума в сфере ЦОД.

05.09.2025 [11:39], Сергей Карасёв

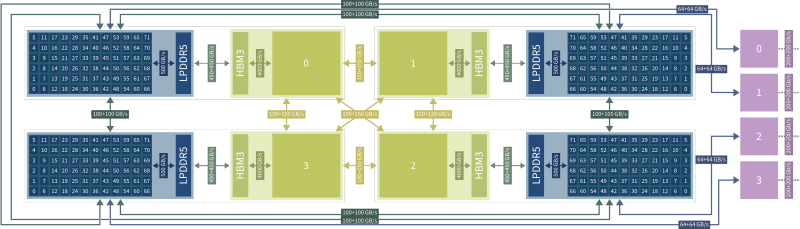

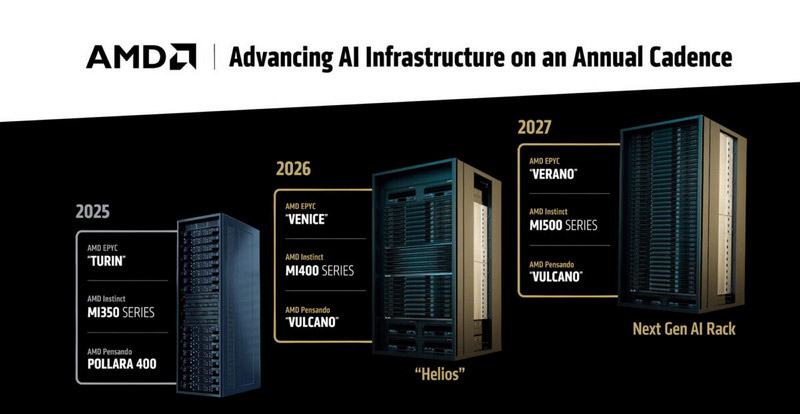

AMD готовит суперускоритель Mega Pod с 256 ускорителями Instinct MI500Компания AMD, по сообщению ресурса Tom's Hardware, готовит платформу MI500 Scale Up MegaPod для наиболее ресурсоёмких нагрузок ИИ. Эта система, как ожидается, выйдет в 2027 году и составит конкуренцию стоечным решениям NVIDIA следующего поколения. Известно, что в основу MI500 Scale Up MegaPod лягут 64 процессора EPYC поколения Verano и 256 ускорителей серии Instinct MI500. Для сравнения: платформа AMD Helios, выход которой запланирован на 2026 год, сможет объединять до 72 ускорителей Instinct MI400, тогда как в состав системы NVIDIA NVL576 на основе стойки Kyber войдут 144 ускорителя поколения Rubin Ultra. В конструктивном плане MI500 Scale Up MegaPod, согласно имеющейся информации, будет представлять собой платформу с тремя серверными стойками. В боковых разместятся по 32 вычислительных лотка с одним процессором EPYC Verona и четырьмя ИИ-ускорителями Instinct MI500, тогда как центральная стойка получит 18 лотков, предназначенных для коммутаторов UALink. В целом, в состав системы войдут 64 узла, насчитывающих в общей сложности 256 ускорителей.

Источник изображения: AMD По сравнению с NVIDIA NVL576 со 144 ускорителями новая платформа AMD обеспечит примерно на 78 % больше карт в расчёте на систему. Однако пока не ясно, сможет ли AMD MI500 Scale Up MegaPod превзойти решение NVIDIA по производительности: NVL576, как ожидается, получит 147 Тбайт памяти HBM4, тогда как быстродействие этой системы будет достигать 14 400 Пфлопс на операциях FP4. Отмечается также, что для AMD MI500 Scale Up MegaPod предусмотрено использование исключительно жидкостного охлаждения — как для вычислительных, так и для сетевых узлов. Предполагается, что система поступит в продажу в конце 2027 года — примерно в то же время, когда, вероятно, дебютирует NVIDIA NVL576. |

|