Материалы по тегу: ии

|

05.09.2025 [09:33], Руслан Авдеев

Внедрение Microsoft 365 Copilot не подняло производительность британских чиновников

copilot

microsoft

microsoft 365

microsoft office

software

великобритания

госзакупки

ии

исследование

чат-бот

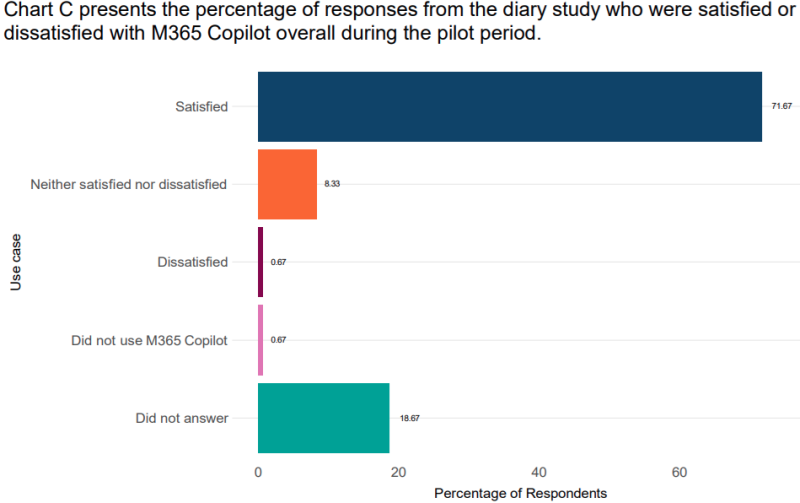

Британское правительство провело трёхмесячное тестирование ИИ-помощника Microsoft M365 Copilot и не выявило заметного роста производительности чиновников. Хотя выполнение некоторых задач ускорилось, другие стали только труднее из-за низкого качества предоставляемых ИИ материалов, сообщает The Register. Впрочем, тестирование проводилось почти год назад, за прошедшее время ИИ-помощник должен был «поумнеть». Департамент бизнеса и торговли Великобритании (Department for Business and Trade) получил 1 тыс. лицензий на использование соответствующего Copilot с октября по декабрь 2024 года. Большую часть лицензий разобрали добровольцы, 30 % участников отобрали случайным образом. Около 300 испытуемых дали согласие на анализ своих данных. Выяснилось, что 72 % пользователей были «удовлетворены» или «очень удовлетворены» работой ИИ-помощника и не особенно обрадовались, когда тест завершился. Тем не менее, реальный рост производительности оказался неоднозначным. Около ⅔ участников эксперимента использовали Microsoft 365 Copilot не менее раза в неделю, 30 % — не реже раза в день. В Великобритании стоимость ежемесячной подписки составляет от £4,90 до £18,10 за пользователя, так что в масштабах государственной машины затраты могут быть значительными.

Источник изображения: Департамент бизнеса и торговли Великобритании При этом в среднем на одного пользователя приходилось всего 72 взаимодействия с Copilot за 63 рабочих дня, т.е. примерно по 1,14/день. Чаще всего Copilot использовали в Word, Teams и Outlook, значительно реже — в PowerPoint и Excel, а реже всего — в Loop и OneNote. Три самых популярных задания: расшифровка или подведение итогов встречи, написание электронных писем и создание резюме записей. Именно эти задачи и вызвали «удовлетворение». Реже всего Copilot просили составить расписание, проверить программный код и сгенерировать изображение. Время, затраченное на выполнение задачи с помощью Copilot, регистрировалось и сравнивалось со временем выполнения сотрудниками задач вручную. Оказалось, пользователи M365 Copilot составляли сводки отчётов и писали электронные письма быстрее, качественнее и точнее, чем те, кто не пользовался ботом. Но, например, экономия времени при написании e-mail была крайне незначительной. Анализ данных в Excel выполнялся ботом медленнее и с худшим качеством и точностью, чем вручную. Слайды PowerPoint создавались в среднем на 7 мин. быстрее, но качество и точность были хуже, а результаты приходилось исправлять вручную.

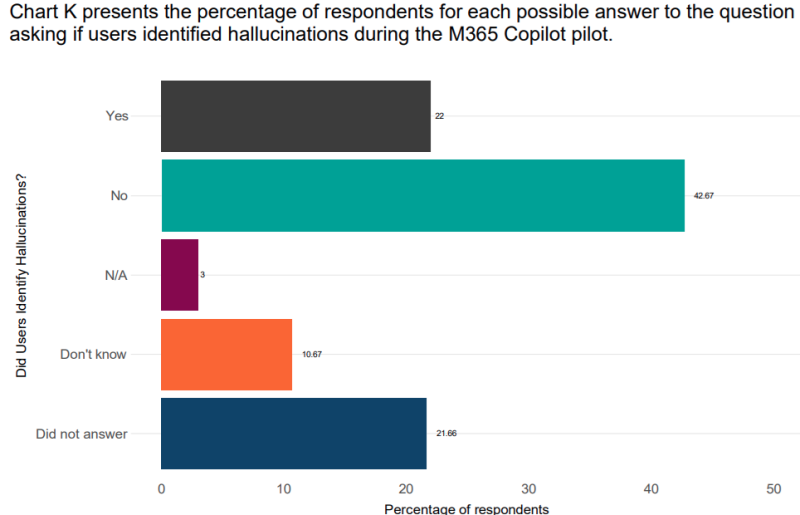

Источник изображения: Департамент бизнеса и торговли Великобритании По словам участников эксперимента, рутинные административные задачи эффективнее выполнять с помощью Microsoft 365 Copilot, высвобождая время на более важные задачи. Некоторые другие участники эксперимента сообщили, что использовали сэкономленное время для посещения обучающих занятий или прогулок в обеденный перерыв. Но всё это не означает, что ИИ-помощник действительно повысил производительность работы чиновников, хотя сама Microsoft при продвижении Copilot делает упор именно на экономию времени. Кроме того, 22 % участников отметили наличие «галлюцинаций» у ИИ-помощники, 43 % их не заметили, ещё 11 % не смогли уверенно сказать, были ли «галлюцинации» во время тестирования, а остальные отмолчались. При этом отношение со стороны коллег к пользователям Copilot тоже были неоднозначным — некоторые отнеслись к участникам эксперимента с некоторой степенью «прохладцы». До принятия окончательного решения о массовом внедрении Microsoft 365 Copilot Департамент проведёт анализ экологических издержек и расчёт соотношения цены и качества сервиса.

04.09.2025 [17:27], Руслан Авдеев

Китай ввёл антидемпинговые пошлины до 78,2 % на оптоволокно из СШАКитай начал вводить пошлины на импорт некоторых типов оптического волокна из США. Это произошло после того, как шестимесячное расследование показало, что американские компании обходили антидемпинговые меры КНР, сообщает Bloomberg. Министерство торговли Китая сообщает, что пошлины в размере от 33,3 % до 78,2 % вступили в силу в четверг по пекинскому времени в отношении одномодового волокна со смещённой отсечкой. Среди компаний, попавших под действие новых пошлин — Corning (теперь платит сбор в размере 37,9 %), OFS Fitel (33,3 %) и Draka Communications Americas — 78,2%. Акции Corning в среду и четверг торговались с колебаниями приблизительно в 2–3 %, в итоге даже отыграв потери с небольшим повышением. В отдельном заявлении, опубликованном 4 сентября 2025 года, Министерство торговли сообщило, что это первое расследование, связанное с обходом мер антидемпинговой защиты, из когда-либо инициированных Китаем. Подчёркивается, что процедуры расследования были открытыми, а права и интересы всех заинтересованных сторон полностью защищены. Китайская сторона утверждает, что американские производители и экспортёры оптоволокна изменили механизмы торговли, чтобы обойти существующие пошлины. В КНР это расценили как уклонение от соблюдения антидемпинговых правил страны.

Источник изображения: JJ Ying/unspalsh.com Аналогичные пошлины Китай уже ввёл в апреле 2023 года в отношении стандартного одномодового волокна. Новые пошлины будут действовать до 21 апреля 2028 года, как и в случае с тарифами первой очереди. Хотя расследование инициировали ещё в марте текущего года, решение о введении новых пошлин последовало только после введения администрацией США ограничений, призванных помешать производству чипов в Китае. По словам экспертов Evercore ISI, решение, вероятно, стало ответом на отмену США поставки в Китай чипов с американскими технологиями. Другими словами, это может служить напоминанием» о том, что Вашингтону необходимо воздержаться от действий, подрывающих взаимное доверие и портящих атмосферу торговых переговоров. Министерство торговли КНР также заявило, что компании, которых коснулся новый сбор, могут оспорить решение, подав властям заявление о пересмотре новых тарифов или иски в суд. Заградительные пошлины, в частности, на оптоволокно — довольно распространённое явление. В октябре 2023 года сообщалось, что Великобритания введёт новые пошлины на дешёвое китайское оптоволокно. В 2024 году Corning также была оштрафована ФАС РФ.

04.09.2025 [16:33], Руслан Авдеев

AWS инвестирует $4,4 млрд в новозеландские облачные ЦОДAmazon (AWS) анонсировала открытие в Новой Зеландии облачного региона, а также намерение потратить более NZ$7,5 млрд ($4,4 млрд) на местные дата-центры. Впервые о плане было объявлено ещё в 2021 году, а теперь он получил «второе дыхание», сообщает Bloomberg. Для страны это достаточно значимая инвестиция. AWS создаст облачный регион AWS Asia Pacific, чтобы удовлетворить растущий спрос на облачные сервисы по всей стране. Как сообщают в AWS, строительство, эксплуатация и обслуживание дата-центров позволит ежегодно создавать более 1 тыс. рабочих мест с полной занятостью. Кроме того, увеличится валовый внутренний продукт Новой Зеландии — приблизительно на NZ$10,8 млрд. (более $6.3 млрд). Сроки инвестиций не называются. Новая Зеландия стремится стать новым «магнитом» для иностранных инвестиций в ЦОД, чтобы придать импульс местной экономике, в прошлом году погрузившейся в глубокую рецессию и до сих пор не восстановившейся. Власти специально реформировали градостроительные законы, желая ускорить выдачу разрешений на новые проекты. Кроме того, для привлечения иностранных инвесторов и предпринимателей скорректирован визовый режим. Власти отметили, что по данным Amazon, строительство в Новой Зеландии на 20 % дороже, чем в соседней Австралии, поэтому необходимо менять законы. Новый облачный регион обеспечит уже имеющимся клиентам вроде Xero и Kiwibank возможность локального выполнения любых рабочих нагрузок, локального же хранения данных и предоставления цифровых услуг с малой задержкой. Это, по мнению AWS, позволит быстрее создавать новые облачные продукты. В Новой Зеландии постепенно реализуют всё новые проекты, связанные с дата-центрами и сопутствующей инфраструктурой. Одним из важнейших стал анонсированный весной 2025 года проект Google и Vocus, желающих дотянуть до побережья страны подводный интернет-кабель Honomoana.

04.09.2025 [14:47], Руслан Авдеев

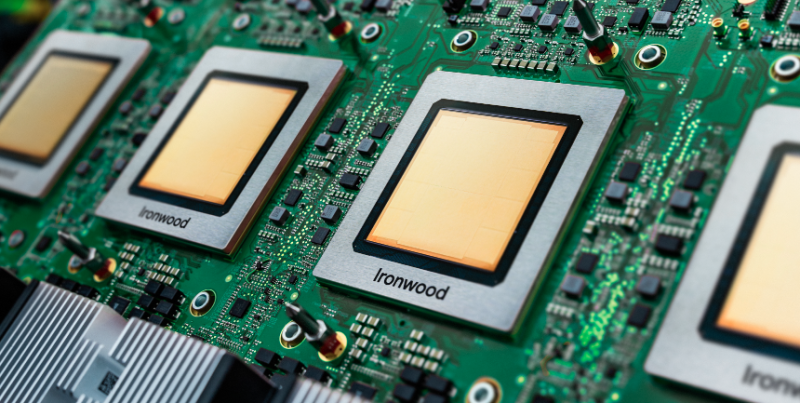

Google бросила вызов NVIDIA, предложив малым облачным провайдерам собственные ИИ-ускорители TPUПо последним данным, Google обратилась к небольшим облачным провайдерам, обычно сдающим в аренду чипы NVIDIA, с необычным предложением — сдавать в аренду её собственные ИИ-ускорители TPU, ранее доступные только в облаке самой Google, сообщает Trendforce со ссылкой на The Information. Это может привести к прямой конкуренции с NVIDIA. Сообщается, что Google уже заключила соглашение как минимум с одним поставщиком облачных сервисов — лондонской Fluidstack. Предполагается разместить TPU в нью-йоркском дата-центре последней. Fluidstack предложены льготы для расширения бизнеса за счёт TPU. Если компания не сможет покрыть расходы на аренду ЦОД в Нью-Йорке, Google обещает предоставить поддержку в объёме до $3,2 млрд. Как утверждается в отчёте, Google ориентируется на молодые компании, в основном на поставщиков облачных услуг, активных пользователей ускорителей NVIDIA. Сообщается, что она уже пыталась заключить аналогичные договоры с другими поставщиками, в настоящее время отдающими предпочтение NVIDIA — включая такие перспективные компании как Crusoe, которая строит ЦОД для OpenAI. Также возможно сотрудничество с CoreWeave, сдающей оборудование NVIDIA в аренду Microsoft (в основном для OpenAI) и также имеющей прямой контракт с OpenAI.

Источник изображения: Google Google довольно давно работает над созданием ИИ-ускорителей. По данным источников The Information, компания рассматривала возможности расширения связанного с TPU бизнеса, чтобы увеличить выручку и снизить зависимость от чипов NVIDIA. По оценкам Morningstar, совокупную стоимость бизнеса TPU и подразделения DeepMind составляет приблизительно $900 млрд. Отмечается, что вышедшие в декабре 2024 года TPU Trillium шестого поколения, весьма востребованы, ожидается и рост спроса на седьмое поколение ускорителей — TPU Ironwood. Это первая модель, разработанная для масштабного инференса. Ранее Google в основном применяла TPU для собственных проектов. Однако некоторое время назад доступность TPU для внешних заказчиков в рамках Google Cloud стала намного выше. Эти чипы использует, например, Apple. Впрочем, и она теперь хочет получить ускорители NVIDIA.

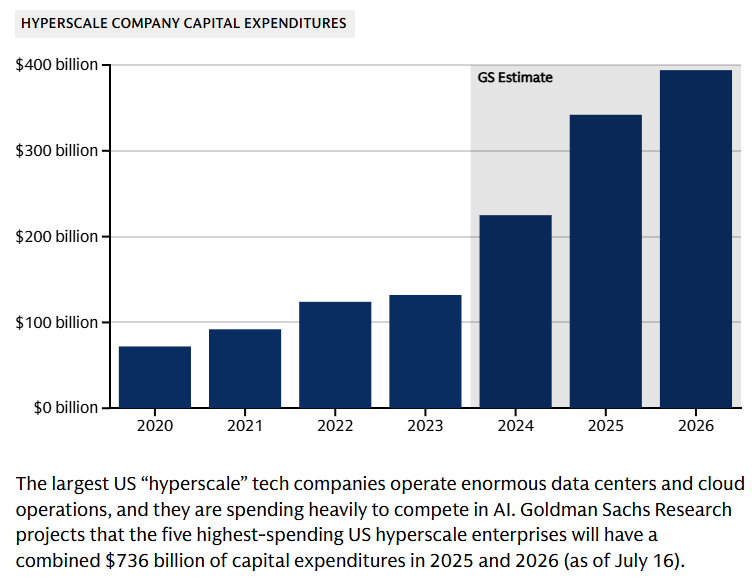

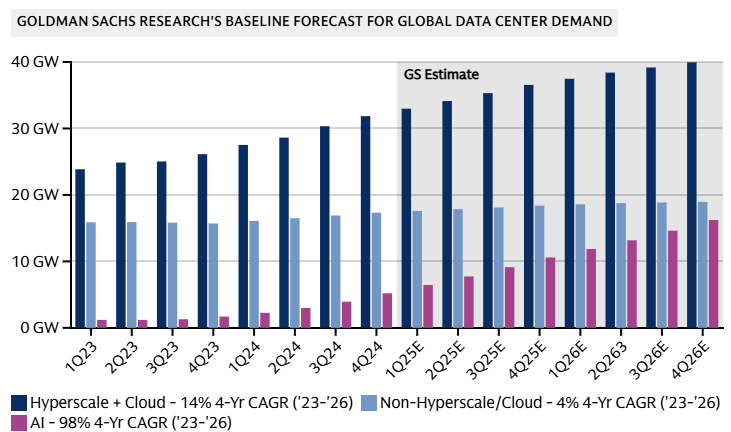

04.09.2025 [09:37], Руслан Авдеев

Goldman Sachs допускает крах «пузыря» ИИ на фоне бума в сфере ЦОДИсследование Goldman Sachs свидетельствует, что к 2027 году мощность ЦОД вырастет на 50 % благодаря спросу на ИИ, а энергопотребление сектора удвоится к 2030 году. При этом финансисты отмечают, что повсеместное внедрение ИИ может не оправдать ожиданий инвесторов, сообщает The Register — ИИ-бум породил «лихорадочную атмосферу», в которой крупные технологические компании находятся в постоянном страхе из-за вероятных изменений рынка. По оценкам компании, сегодня глобальная мощность дата-центров составляет порядка 62 ГВт, на облачные нагрузки приходится 58 %, на традиционные нагрузки — 29 % и лишь 13 % — на искусственный интеллект. В начале 2023 года доля ИИ-нагрузок была околонулевой, а к 2027 году она достигнет уже 28 %. Доля облачных нагрузок сократится до 50 %, традиционных — до 21 %. Конечно, сократится лишь доля от общей мощности, а не сами нагрузки из-за активного развития ИИ. По данным Omdia, расходы на ЦОД уже сопоставимы со средними по размеру мировыми экономиками — одна Amazon инвестирует в ЦОД около $118 млрд, что приблизительно равно ВВП Коста-Рики. В Counterpoint Research допускают, что бум ИИ ЦОД может привести к удвоению мировых доходов полупроводниковой промышленности с 2024 по 2030 гг. до более $1 трлн. Большая часть спроса, вероятно, будет приходиться на решения гиперскейл-уровня в краткосрочной и долгосрочной перспективе.

Источник изображения: Lanju Fotografie/unsplash.com Обучение ИИ требует специального оборудования, что приводит к кардинальным изменениям рынка. По данным Goldman Sachs, если два года назад на передовой сервер приходилось по восемь ИИ-ускорителей, то к 2027 году речь будет идти о 576 экземплярах, потребляющих 600 кВт — речь про стойки Kyber с суперускорителями NVIDIA Rubin Ultra NVL576.

Источник изображения: Goldman Sachs Research В результате к 2030 году потребление дата-центрами электричества в мире должно вырасти на 165 %, т.е. с 1–2 % в 2023 году до 3–4 % к концу текущего десятилетия. Ожидается, что за счёт возобновляемых источников будет обеспечено 40 % дополнительной энергии для ЦОД. Поможет и ядерная энергетика, но не так кардинально. Оставшиеся 60 % придётся на генерацию на природном газе, что увеличит выбросы парниковых газов к концу текущего десятилетия на 215–220 млн т — эквивалент 0,6 % от общемировых выбросов, связанных с энергетикой.

Источник изображения: Goldman Sachs Research Хотя прогнозы экспертов относительно рынка ЦОД обычно оптимистичны, финансовые эксперты тщательно следят за любыми негативными изменениями на рынке. Риски включают потенциальные проблемы с монетизацией ИИ. К ним же относится и вариант, при котором инновации значительно удешевят разработку и коммерциализацию моделей. Базовый сценарий предполагает CAGR моoностей ЦОД на уровне 17 % — 92 ГВт к 2027 году. При этом разные сценарии прогнозируют рост в 14 % (если ИИ будет не так интересен бизнесу, как ожидается) до 20 % — если ситуация будет развиваться более оптимистично. Опасения финансовых магнатов отражают «ИИ-скептицизм», присутствующий в более широком масштабе. Глава OpenAI Сэм Альтман (Sam Altman) недавно констатировал, что в отрасли наблюдается «ИИ-пузырь», а эксперты компании McKinsey ещё в начале года предупредили, что никто не может с высокой достоверностью прогнозировать спрос на ИИ в будущем.

03.09.2025 [16:32], Владимир Мироненко

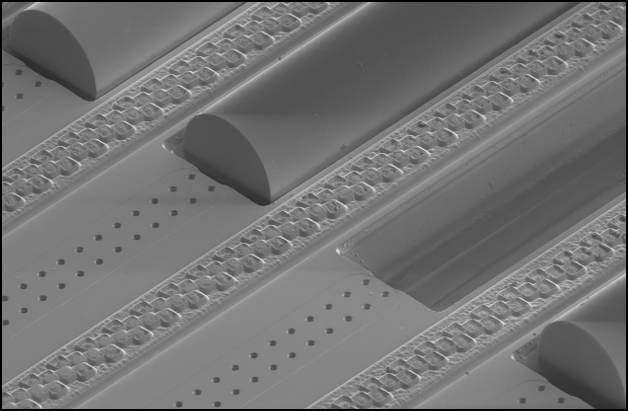

GlobalFoundries объявила о готовности к массовому развёртыванию решений в сфере кремниевой фотоникиАмериканский контрактный производитель полупроводников GlobalFoundries вывел свою платформу кремниевой фотоники в отдельную линейку продуктов и удвоил инвестиции в её развитие, сообщил Кевин Соукуп (Kevin Soukup), старший вице-президент. Он сравнил текущее состояние внедрения технологии с «режимом запуска» Tesla, характеризующимся готовностью к ускоренному массовому развёртыванию, пишет Converge! Network Digest. По словам Соукупа спрос на кремниевую фотонику в ЦОД определяют три взаимосвязанных фактора: взрывной рост объёмов данных, развитие ИИ и LLM с триллионами параметров, а также стремительное увеличение энергопотребления. По его оценкам, к 2030 году глобальное энергопотребление ЦОД может удвоиться, и только в США на ИИ ЦОД будет приходиться 10–15 % всего потребления электроэнергии страны. При этом многие ASIC простаивают до 75 % времени в связи с низкой скоростью передачи данных между чипами. «Кремниевая фотоника снижает энергопотребление и задержку, обеспечивая при этом возможность масштабирования архитектур как в горизонтальном, так и в вертикальном направлении для GPU и ASIC», — сказал он.

Источник изображения: GlobalFoundries GlobalFoundries опубликовала программу развития, охватывающую три ключевых подхода к оптической связи. В категории подключаемой оптики традиционные оптические модули с пропускной способностью 200 Гбит/с на линию, подключаемые к сетевым коммутаторам, широко используются в ЦОД уже сейчас. Модули с поддержкой 400 Гбит/с на линию пройдут тестирование к концу 2025 года. Выпуск прототипов намечен на 2026 год, запуск массового производства — на 2027 год. В категории линейной оптики (LPO) — оптических решений, в которых цифровая обработка сигнала перенесена с оптического модуля на хост-схему ASIC, что снижает энергопотребление и задержку, GlobalFoundries планирует развёртывания в ближайшей перспективе с партнерами по экосистеме. В категории интегрированной фотоники (CPO) основное внимание уделяется передовым корпусам, многоволоконным соединениям, отсоединяемым (detachable) оптическим интерфейсам и стекированию фотонных и электронных схем. Соукуп сообщил, что компанией была создана серьёзная экосистема для развитя фотоники, включая новый Центр упаковки передовых фотонных модулей (APPC) в Мальте (штат Нью-Йорк) для производства оптических модулей в стране. Intel и Broadcom также активно продвигают LPO- и CPO-решения, а Marvell инвестирует в подключаемые решения на базе DSP. Отрасль вступает в критическую фазу, когда гиперскейлеры должны выбирать оптическую архитектуру, которая обеспечивает баланс между масштабируемостью, эффективностью и рисками развёртывания, отметил Converge! Network Digest.

03.09.2025 [14:11], Сергей Карасёв

Acer представила компактную ИИ-станцию Veriton GN100 за $4000 с суперчипом NVIDIA GB10Компания Acer анонсировала рабочую станцию небольшого форм-фактора Veriton GN100 AI Mini Workstation, предназначенную для решения задач в области ИИ. Новинка, в частности, обеспечивает возможность локального запуска моделей с большим количеством параметров, снижая зависимость от облачной инфраструктуры. Устройство выполнено в корпусе с габаритами 150 × 150 × 50,5 мм. Основой служит суперчип NVIDIA GB10 Grace Blackwell, который объединяет ускоритель Blackwell с тензорными ядрами пятого поколения и 20-ядерный процессор Grace (10 × Arm Cortex-X925 и 10 × Arm Cortex-A725). Заявленная ИИ-производительность достигает 1000 TOPS на операциях FP4. Новинка несёт на борту 128 Гбайт памяти LPDDR5x, а вместимость SSD формата M.2 (NVMe) может достигать 4 Тбайт (поддерживается шифрование данных). В оснащение входят адаптеры Wi-Fi 7 и Bluetooth 5.1, а также сетевой контроллер NVIDIA ConnectX-7 SmartNIC. Предусмотрены четыре порта USB 3.2 Type-C, интерфейс HDMI 2.1b и разъём RJ45 для сетевого кабеля. Весит устройство около 1,5 кг. В качестве программной платформы применяется NVIDIA DGX OS — модификации Ubuntu, адаптированная специально для работы с ИИ. Две рабочие станции Veriton GN100 AI Mini Workstation посредством ConnectX-7 могут быть объединены в одну систему, что позволит работать с ИИ-моделями, насчитывающими до 405 млрд параметров. Говорится о поддержке таких инструментов, как PyTorch, Jupyter и Ollama. Приобрести новинку можно будет по ориентировочной цене $4000 или €4000 в зависимости от региона продаж.

03.09.2025 [13:39], Руслан Авдеев

SAP инвестирует более €20 млрд в суверенное облако для поддержки европейских клиентовКрупнейший немецкий разработчик ПО — компания SAP объявила о намерении инвестировать в течение 10 лет более €20 млрд ($23,3 млрд) в свою суверенную облачную инфраструктуру в Европе, сообщает CNBC. Компания предложит IaaS на базе собственных дата-центров. Дополнительно будет представлена новая локальная опция, которая позволит пользоваться инфраструктурой SAP в дата-центрах заказчика. В Германии также будет доступно облако Delos Cloud. Цель новой инициативы — обеспечить хранение данных клиентов на территории Евросоюза для соблюдения правил защиты местных данных, включая GDPR. По словам SAP, инновации и суверенитет нераздельны. Он добавил, что европейским компаниям важно получить доступ к новейшим технологиям вроде ИИ в «контексте полного суверенитета». За последний год тема суверенитета стала особенно популярной, на фоне геополитических противоречий компаниям пришлось провести переоценку зависимости от иностранных технологий. Государства всё чаще стараются полагаться на локальную инфраструктуру, необходимую для обучения и эксплуатации ИИ. В результате AWS, Google и Microsoft объявили о новых сервисах в сфере суверенных облаков, призванных хранить европейские данные в ЕС. При этом Microsoft и Google выразили готовность защищать интересы европейских клиентов перед американским правительством.

Источник изображения: Carl Gruner/unsplash.com ЕС считает развитие ИИ одним из приоритетов региона — блок стремиться составить конкуренцию США и Китаю, от которых пока значительно отстаёт в этом отношении. Ранее Еврокомиссия рассказала о планах инвестировать €20 млрд в создание «ИИ-гигабафрик», оснащённых мощнейшими ИИ-суперкомпьютерами. В SAP объявили, что тесно участвуют в создании таких фабрик, но компания не будет в проекте ведущим партнёром. Представитель SAP добавил, что её инвестиции в объёме более €20 млрд, предусматриваемые для европейского суверенного облака, не повлияют на капитальные затраты компании на следующий год, они уже заложены в её финансовые планы. SAP является одним из ключевых европейских игроков в IT-сфере — компания стала самым дорогим публичным бизнесом в Европе. Примечательно, что ещё в июне 2025 года сообщалось, что SAP не видит смысла в строительстве Европой собственной облачной инфраструктуры в противовес американским гиперскейлерам. В конце мая появилась новость, что Евросоюз готов признать, что отказаться от американских облаков «почти невозможно», а в июле Synergy Research Group заявила, что доля европейских облачных провайдеров на местном рынке снизилась до 15 % и остаётся на этом уровне годами.

03.09.2025 [08:53], Руслан Авдеев

«Фантомные» ИИ ЦОД ещё не построены, но уже мешают энергокомпаниям СШАДата-центры США отчаянно нуждаются в электроэнергии, но пока нет точных данных, сколько их будет построено в итоге и сколько электричества им действительно необходимо. Американские коммунальные компании сообщают о взрывном росте запросов на присоединение к сетям со стороны будущих ИИ ЦОД, причём в некоторых случаях их аппетиты многократно превышает текущее энергопотребление региона, сообщает The Wall Street Journal. Так, American Electric Power (AEP), обслуживающая 11 штатов, и техасские Oncor (Sempra) с CenterPoint Energy суммарно получили от дата-центров запросы на фантастические 400 ГВт. Проблема отчасти в том, что нередко потребности одного и того же дата-центра многократно учитываются разными коммунальными службами — застройщики направляют запросы самым разным поставщикам электричества, одновременно подыскивая лучшие места для будущих ЦОД. При этом по факту многие проекты так и останутся на бумаге, поскольку на присоединение к энергосетям уходят годы, а за это время могут поменяться законы, правила зонирования и т.д. Такие объекты уже прозвали «фантомными ЦОД». Поэтому коммунальные службы не хотят рисковать, наспех строя лишние электростанции и ЛЭП, поскольку не исключено, что ИИ-бум представляет собой очередной «мыльный пузырь», платить за который придётся остальными потребителям.

Источник изображения: American Public Power Association/unsplash.com По данным Министерства труда, цены на электроэнергию по всей стране за год уже выросли на 5,5 %. Спрос на электричество в США не менялся почти 20 лет, приблизительно до 2020 года, но сейчас он растёт по всей стране примерно на 2 % в год. Во многом это связано с ажиотажем вокруг ИИ с его фантастически выросшими запросами. Быстрее всего спрос растёт в местах вроде Северной Вирджинии и Техаса, где строятся крупные ЦОД и развивается производство. Например, к концу у Oncor было 552 запроса на присоединение к сети от крупных клиентов, включая ЦОД и производственные предприятия, т.е. почти на треть больше, чем в конце марта. Пиковый уровень потребления электричества клиентами компании составляет 31 ГВт. При этом ЦОД просят ещё 186 ГВт, а промышленные предприятия — порядка 19 ГВт. Если раньше типичный запрос составлял менее 100 МВт, то сейчас этот показатель приблизился к 700 МВт. Энергосистема AEP оценивается в 37 ГВт, уже заключены соглашения ещё на 24 ГВт. При этом в очереди на рассмотрении находятся заявки на колоссальные 190 ГВт. В компании полагают, что не все проекты будут реализованы. Наконец, потребление клиентов CenterPoint Energy в районе Хьюстона (Техас) составляет чуть больше 22 ГВт, и это один из самых высоких показателей для мегаполиса США. Запросы на подключение составляют 53 ГВт, из них 25 ГВт приходится на ЦОД. При этом год назад ЦОД было нужно всего 1 ГВт. По оценкам компании, по факту понадобится лишь пятая часть запрошенных мощностей. Как сообщало в апреле Международное энергетическое агентство (IEA), энергопотребление ЦОД к 2030 году в мире вырастет более чем вдвое. В конце 2024 года появился отчёт Национальной лаборатории Лоуренса в Беркли (LBNL), где сообщалось, что в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны. В конце июля 2025 года Anthropic предрекла, что к 2028 году только для ИИ в США потребуется 50 ГВт. Впрочем, ИИ-чипов может на всех и не хватить.

02.09.2025 [14:47], Руслан Авдеев

OpenAI построит в Индии дата-центр мощностью более 1 ГВтOpenAI намерена построить в Индии дата-центр мощностью не менее 1 ГВт. Компания ищет местных партнёров для сотрудничества в рамках нового проекта, сообщает Silicon Angle со ссылкой на Bloomberg. Кроме того, партнёров ищут и для продвижения ChatGPT на местном рынке. По предварительным оценкам, новый ИИ ЦОД сможет разместить почти 60 тыс. чипов NVIDIA B200. Пока нет данных, входит ли новый ЦОД в инициативу компании OpenAI for Countries. Программа, запущенная в 2025 году, предполагает создание ИИ ЦОД по всему миру. OpenAI уже заключила контракты на создание инфраструктуры в ОАЭ и Норвегии. Впрочем, речь идёт не только о дата-центрах. Компания предлагает помощь в запуске локальных версий ChatGPT и поддержку местных ИИ-стартапов, в том числе инвестиции в некоторые из них. В феврале 2025 года глава OpenAI Сэм Альтман (Sam Altman) встретился с представителями индийских властей, чтобы обсудить создание «недорогой» ИИ-платформы. Недавно компания запустила новый тариф ChatGPT специально для Индии — подписка ChatGPT Go стоит всего около $4,5/мес. и позволяет обрабатывать в сутки в 10 раз больше запросов, чем в бесплатной версии. Также компания намерена распространить среди местных преподавателей и студентов около 500 тыс. лицензий на использование ChatGPT. До конца года OpenAI намерена открыть офис в Нью-Дели. Создание собственного ЦОД в Индии позволит сократить задержку доступа для местных пользователей. Кроме того, такой проект способен помочь и в борьбе за местных корпоративных клиентов. Особенно это касается организаций, которым необходимо хранить данные локально, обеспечивая информационную безопасность и конфиденциальность. Данные о строительстве ЦОД в Индии появились через несколько недель после заключения соглашения с Oracle о строительстве в США дата-центра на 4,5 ГВт. В следующие четыре года OpenAI намерена ввести в эксплуатацию в США не менее 5,5 ГВт дополнительных мощностей, что обойдётся, вероятно, в $500 млрд. |

|