Материалы по тегу: ускоритель

|

04.03.2024 [20:32], Руслан Авдеев

NVIDIA признала в Huawei потенциального соперника на ниве ИИ-ускорителейКитайская Huawei вновь попала в центр внимания СМИ после того, как глава NVIDIA признал её достижения в сфере ИИ-решений. По данным SCMP, хотя в отношении Китая Соединённые Штаты ввели жёсткие санкции, Huawei смогла предложить в материковом Китае альтернативу высокопроизводительным ускорителям NVIDIA. Ускоритель Ascend 910B уже доступен в Поднебесной и, по данным отраслевых экспертов, его производительность сравнима с характеристиками NVIDIA A100. По мнению экспертного сообщества, новинка выпускается ведущим контрактным производителем полупроводников Китая — компанией SMIC, тоже находящейся под американскими санкциями. Выпуск осуществляется в соответствии с 7-нм техпроцессом. В самой Huawei слухи о своих ускорителях не комментируют, хотя и признают, что ИИ является ключевой частью стратегии компании. Хотя ещё в 2019 году против Huawei введены США жёсткие санкции, компания сумела «перегруппироваться», нашла новых поставщиков в Китае, а летом прошлого года представила свой первый за несколько лет 5G-смартфон — Mate 60 Pro на базе флагманского 7-нм чипсета Kirin 9000, без лишнего шума разработанном под санкциями. Уже тогда «возрождение» Huawei оказалось в центре внимания СМИ, политиков и бизнеса. ИИ-чип Huawei появился приблизительно в то же время, а китайский поисковый гигант Baidu заказал сразу 1600 таких ускорителей. К нему присоединились и другие компании из КНР, занимающиеся ИИ-проектами и обучением больших языковых моделей (LLM). В прошлом месяце глава NVIDIA Дженсен Хуанг (Jensen Huang) признал значимость конкурента, назвав в одном из интервью Huawei «очень, очень хорошей компанией». По его словам, Huawei, испытывая проблемы с доступом к современным технологиям, тем не менее, может объединять в кластеры многочисленные ускорители собственной разработки, чтобы повысить производительность обработки ИИ-задач. Пока, по данным китайских источников, новые чипы можно заказать, но с поставками наблюдаются некоторые трудности. По имеющимся сведениям, сервер с восемью ускорителями Ascend 910B стоит около ¥1,5 млн или немногим более $208 тыс. — приблизительно за столько же на местном чёрном рынке можно приобрести контрабандный сервер с NVIDIA A100. Эксперты не спешат комментировать возможную конкуренцию Huawei и NVIDIA, ограничиваясь замечаниями о том, что американская сторона имеет большой опыт ещё со времён разработки игровых GPU и предлагает целую экосистему на базе CUDA. Вероятно, Huawei придётся вложить средства в развитие программной экосистемы или делегировать это другим компаниям, сосредоточившись на разработке «железа». Но конкуренция с NVIDIA в любом случае не будет лёгкой.

04.03.2024 [17:00], Руслан Авдеев

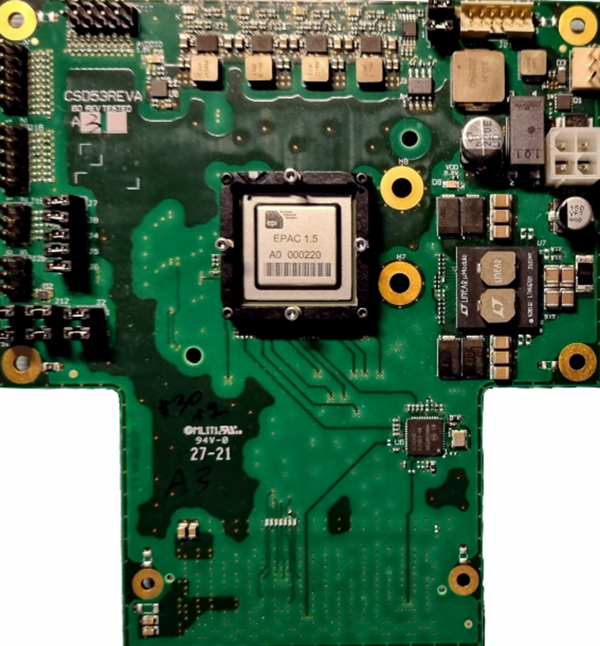

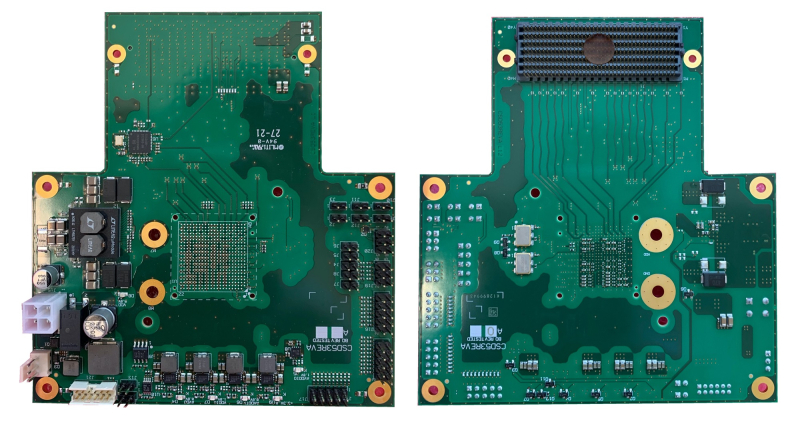

Евросоюз намерен добиться полупроводникового суверенитета, используя архитектуру RISC-VВ Евросоюзе активно инвестируют в инициативы, призванные обеспечить полупроводниковый суверенитет благодаря использованию открытой архитектуры RISC-V. EE Times сообщает, что инициативу курирует Барселонский суперкомпьютерный центр (Barcelona Supercomputing Center или BSC) — пионер в разработке европейских решений RISC-V. Страны ЕС беспокоит полупроводниковая зависимость от иностранных компаний, и это беспокойство усугубляется относительно недавним дефицитом чипов в мире. В то же время за использование в своих решениях архитектуры RISC-V никому не надо платить и ни у кого не нужно получать разрешений на её применение, поэтому технология так привлекательна для разработчиков. BSC представляет собой один из ведущих исследовательских центров Европы. Он играет ключевую роль в разработке чипов на архитектуре RISC-V и возглавляет несколько проектов, связанных с этой технологией, в частности, European Processor Initiative (EPI). В рамках инициативы EPI стоимостью €70 млн разрабатывается новое поколение высокопроизводительных процессоров. Связанная с BSC компания OpenChip должна найти коммерческое применение разработанным технологиям. BSC начал создавать собственные чипы семейства Lagarto довольно давно — первые 65-нм варианты представили ещё в мае 2019 года. Сегодня речь идёт уже о четвёртом поколении, которое будет выпускаться в соответствии с 7-нм техпроцессом. Центр работает и с другими европейскими компаниями и исследовательскими организациями над созданием комплексной экосистемы RISC-V, включающей ПО, ОС и компиляторы. Подобные инициативы должны снизить зависимость Евросоюза от американских и азиатских производителей — отсутствие в ЕС зрелой индустрии высокопроизводительных чипов расценивается как значимая уязвимость. Европа считает, что RISC-V — идеальная платформа для достижения суверенитета, при этом бесплатная. Впрочем, эксперты признают, что о полной независимости не может быть речи из-за сложности экосистемы полупроводниковой индустрии. Но у Европы есть большая база знаний и потенциал разработки новых решений, предпринимаются и шаги к организации производства. В BSC уже экспериментировали с Arm-процессорами, но после Brexit и приобретения компании Arm группой Softbank, выяснилось, что собственной региональной технологии у ЕС нет, тогда и обратили внимание на общедоступную RISC-V. В 2019 году Еврокомиссию убедили в необходимости начать выпуск чипов на этой архитектуре для суперкомпьютеров. В числе других европейских компаний, предлагающих RISC-V продукты, есть Gaiser, Esperanto Technologies, Semidynamics и Codasip, но они уделяют больше внимания процессорам и ускорителям, а не конечным готовые решения. По оценкам экспертов, в Евросоюзе компаний, работающих с RISC-V, пока недостаточно. Тем не менее, организаторы новых инициатив предостерегают от нереалистичных ожиданий и призывают к стратегическому сотрудничеству — для производства требуются не только разработки, но и сырьё, высокоточное оборудование, и др. Европа может рассчитывать на выпуск решений в пределах 7-нм, более современные техпроцессы пока слишком дороги. Впрочем, ЕС уже добился значительного прогресса в достижении полупроводникового суверенитета с помощью RISC-V.

03.03.2024 [21:59], Сергей Карасёв

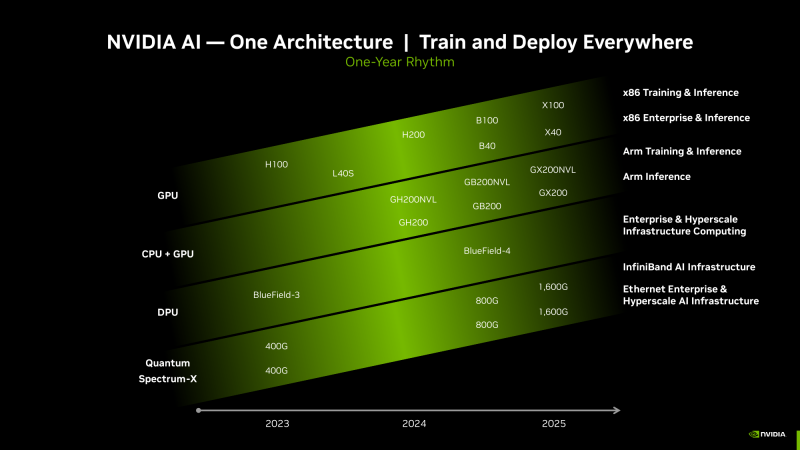

Киловаттный ускоритель NVIDIA B200 Blackwell появится в 2025 годуКомпания Dell во время конференции, посвящённой квартальному отчёту, подтвердила подготовку ускорителя нового поколения NVIDIA B200 семейства Blackwell для ресурсоёмких ИИ-задач и НРС-приложений, на что обратил внимание ресурс Videocardz. Ожидается, что это изделие появится в следующем году. Официальный анонс решений Blackwell состоится в этому году. Причём в NVIDIA прогнозируют, что ускорители окажутся в дефиците сразу после выхода. Объясняется это стремительным ростом рынка ИИ, в том числе быстрым развитием генеративных сервисов. Известно, что в семейство Blackwell войдут флагманское изделие B100 для ИИ и HPC-задач, модель B40 для корпоративных заказчиков, гибридное решение GB200, сочетающее чип B100 и Arm-процессор Grace, а также GB200 NVL для обработки больших языковых моделей (LLM). Теперь говорится, что также готовится ускоритель B200: отмечается, что это может быть название конечного продукта. По данным Dell, показатель TDP в случае B200 может достигать 1000 Вт. Для сравнения: ускоритель NVIDIA H100 в форм-факторе SXM обладает TDP в 700 Вт. На подготовку B200 намекнул операционный директор Dell Джефф Кларк (Jeff Clarke). По его словам, инженерная команда компании будет готова к появлению продукта. Таким образом, можно предположить, что Dell уже проектирует серверы нового поколения, рассчитанные на установку ускорителей B200. Отмечается также, что акции Dell по состоянию на 1 марта 2024 года выросли в цене на 32 %, тогда как капитализация NVIDIA превысила $2 трлн. При этом Dell является одним из ключевых партнёров NVIDIA в сегменте дата-центров.

28.02.2024 [15:54], Руслан Авдеев

Доступность ускорителей NVIDIA H100 повысилась, что привело к появлению вторичного рынкаСроки поставок ускорителей NVIDIA H100 значительно сократилось, с 8–11 мес. до всего 3-4. По данным Tom’s Hardware, в результате многие компании, ранее сделавшие огромные запасы, пытаются продать излишки. Кроме того, стало намного легче арендовать ускорители в облаках Amazon, Google и Microsoft. Впрочем, разработчики ИИ-моделей до сих пор испытывают проблемы с доступом к ресурсам ускорителей, поскольку спрос превышает предложение. Как сообщают СМИ, некоторые компании пытаются перепродать доставшиеся им H100, а другие стали заказывать меньше в связи с высокой стоимостью обслуживания складских запасов и окончанием паники на рынке. В прошлом году приобрести подобные ускорители было чрезвычайно сложно. Отчасти улучшение ситуации на рынке связано с тем, что провайдеры облачных сервисов вроде Amazon (AWS) и других крупных игроков упростили аренду H100. Несмотря на то, что доступ к H100 упростился, желающим обучать LLM добраться до ресурсов по-прежнему непросто, во многом потому, что им требуются ускорители в невероятных количествах, в некоторых случаях речь идёт о сотнях тысяч экземпляров, поэтому цены на них до сих пор не упали, а NVIDIA продолжает получать сверхприбыли. При этом рост доступности привёл к тому, что компании всё чаще пытаются сэкономить, ведут себя более избирательно при выборе предложений продажи или аренды, стараются приобрести более мелкие кластеры и внимательнее оценивают их экономическую целесообразность для бизнеса. Кроме того, альтернативные решения становятся все более распространёнными и всё лучше поддерживаются ПО. Это ведёт к формированию сбалансированной ситуации на рынке. Так или иначе, спрос на ИИ-чипы по-прежнему высок, а с учётом того, что LLM становятся всё масштабнее, требуется больше вычислительных мощностей. Поэтому крупные игроки, которые зависят от поставок решений NVIDIA, занялись созданием собственных ускорителей. Среди них Microsoft, Meta✴ и OpenAI.

28.02.2024 [15:31], Сергей Карасёв

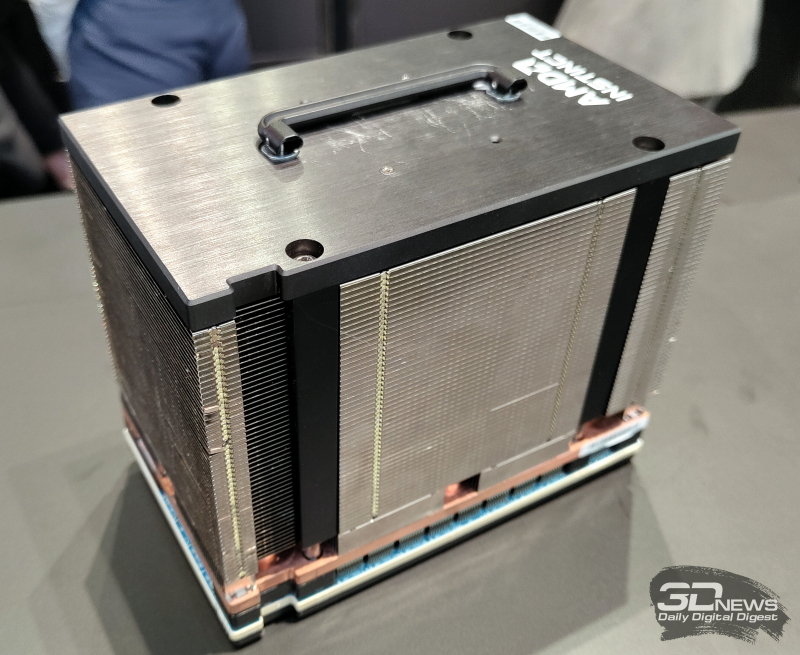

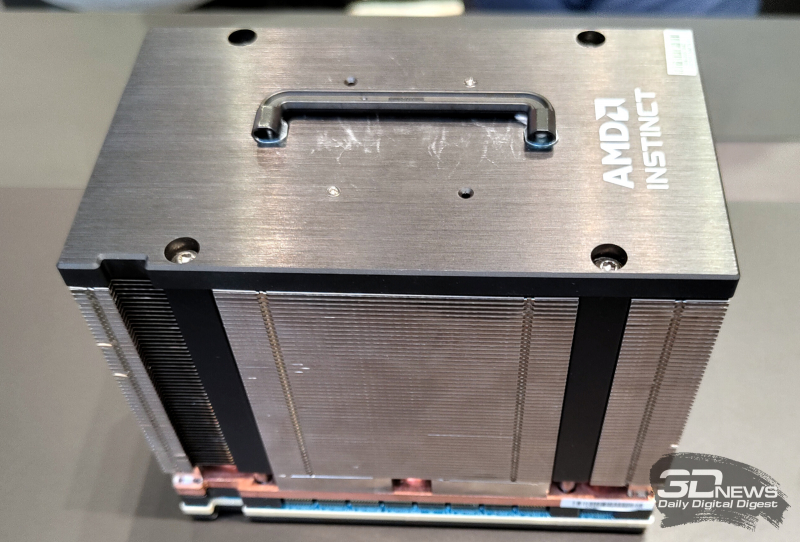

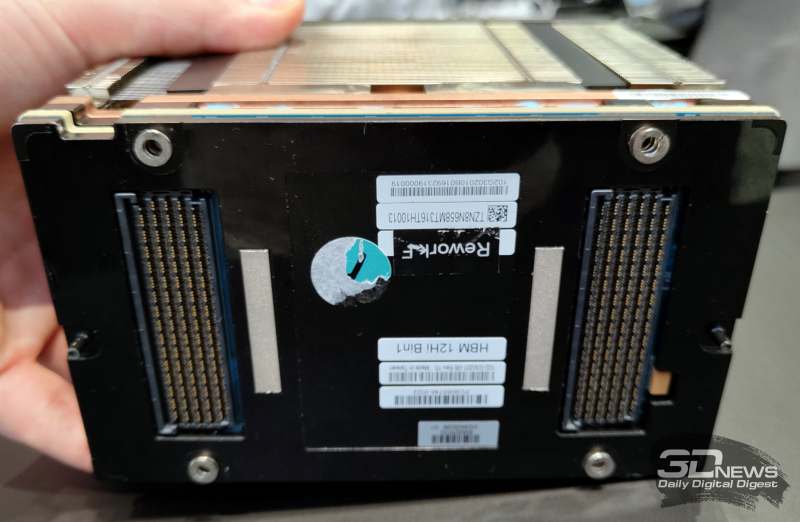

На MWC 2024 замечен первый образец ускорителя AMD Instinct MI300X с 12-слойной памятью HBM3EКомпания AMD готовит новые модификации ускорителей семейства Instinct MI300, которые ориентированы на обработку ресурсоёмких ИИ-приложений. Изделия будут оснащены высокопроизводительной памятью HBM3E. Работу над ними подтвердил технический директор AMD Марк Пейпермастер (Mark Papermaster), а уже на этой неделе на стенде компании на выставке MWC 2024 был замечен образец обновлённого ускорителя. На сегодняшний день в семейство Instinct MI300 входят модификации MI300A и MI300X. Первая располагает 228 вычислительными блоками CDNA3 и 24 ядрами Zen4 на архитектуре x86. В оснащение входят 128 Гбайт памяти HBM3. На более интенсивные вычисления ориентирован ускоритель MI300X, оборудованный 304 блоками CDNA3 и 192 Гбайт HBM3. Но у этого решения нет ядер Zen4. Недавно компания Micron сообщила о начале массового производства 8-слойной памяти HBM3E ёмкостью 24 Гбайт с пропускной способностью более 1200 Гбайт/с. Эти чипы будут применяться в ИИ-ускорителях NVIDIA H200, которые выйдут на коммерческий рынок во II квартале нынешнего года. А Samsung готовится к поставкам 12-слойных чипов HBM3E на 36 Гбайт со скоростью передачи данных до 1280 Гбайт/с. AMD подтвердила намерение применять память HBM3E в обновлённых ускорителях Instinct MI300, но в подробности вдаваться не стала. В случае использования 12-слойных чипов HBM3E ёмкостью 36 Гбайт связка из восьми модулей обеспечит до 288 Гбайт памяти с высокой пропускной способностью. Наклейка на демо-образце недвусмысленно указывает на использование именно 12-слойной памяти. Впрочем, это может быть действительно всего лишь стикер, поскольку представитель AMD уклонился от прямого ответа на вопрос о спецификациях представленного изделия. Ожидается также, что в 2025 году AMD выпустит ИИ-ускорители следующего поколения серии Instinct MI400. Между тем NVIDIA готовит ускорители семейства Blackwell для ИИ-задач: эти изделия, по заявлениям самой компании, сразу после выхода на рынок окажутся в дефиците.

26.02.2024 [23:34], Владимир Мироненко

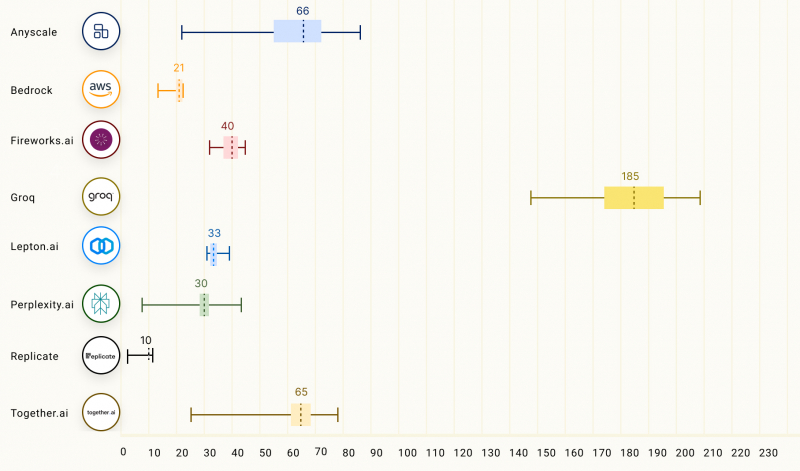

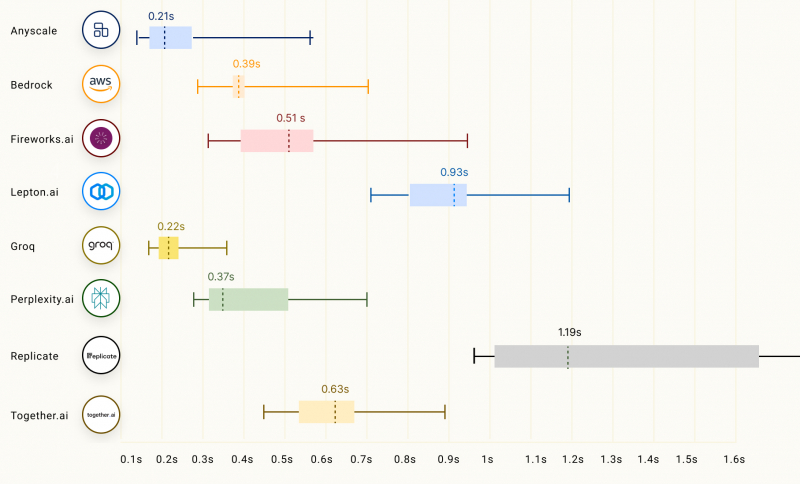

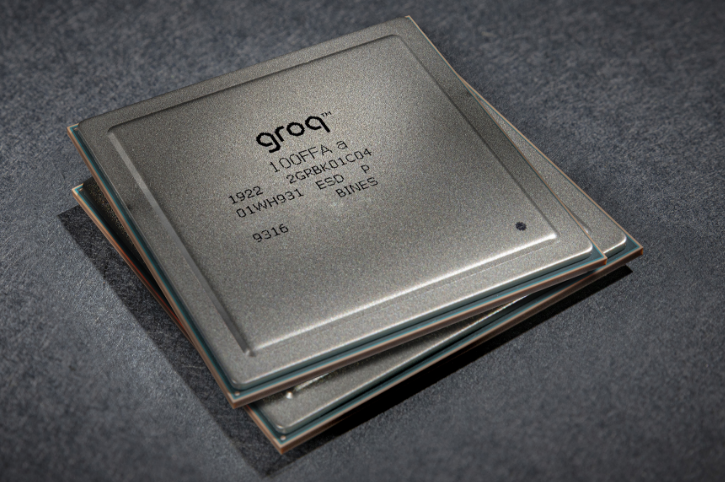

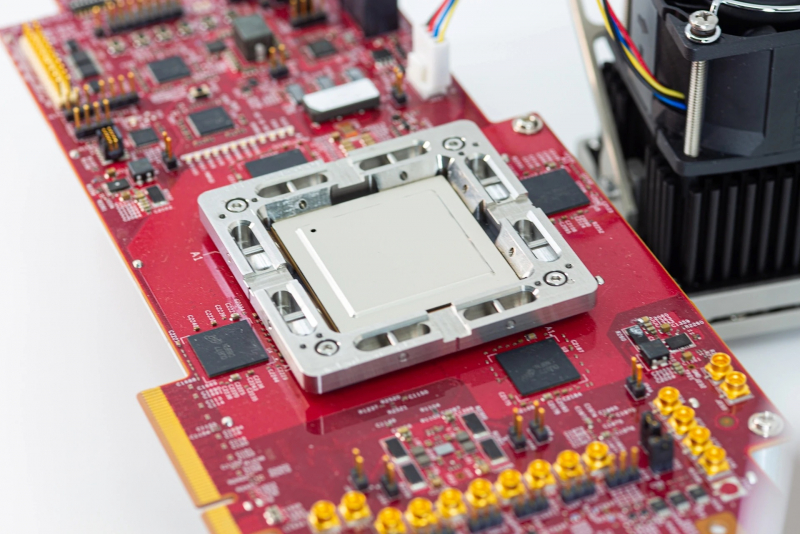

Groq LPU способен успешно конкурировать с ускорителями NVIDIA, AMD и IntelСтартап Groq сообщил о значительных достижениях в области инференса с использованием ускорителя LPU, разработанного для запуска больших языковых моделей (LLM), таких как GPT, Llama и Mistral. Groq LPU имеет один массивно-параллельный тензорный процессор TSP, который обеспечивает производительность до 750 TOPS INT8 и до 188 Тфлопс FP16. LPU Groq оснащён локальной SRAM объемом 230 Мбайт с пропускной способностью 80 Тбайт/с. Как сообщает компания, при запуске модели Mixtral 8x7B ускоритель LPU обеспечил скорость инференса 480 токенов в секунду, что является одним из ведущих показателей инференса в отрасли. В таких моделях, как Llama 2 70B с длиной контекста 4096 токенов, Groq может обеспечить скорость инференса 300 токенов/с, тогда как в меньшей модели Llama 2 7B с 2048 токенами контекста скорость инференса составляет 750 токенов/с.

Изображение: Groq Согласно рейтингу бенчмарка LLMPerf, LPU Groq превосходит результаты систем облачных провайдеров на базе традиционных ИИ-ускорителей в деле запуска LLM Llama в конфигурациях от 7 до 70 млрд параметров. Groq лидирует по скорости инференса и занимает второе место по показателю задержки. Для сравнения, бесплатный чат-бот ChatGPT на базе GPT-3.5 обеспечивает обработку около 40 токенов/с. Текущие LLM с открытым исходным кодом, такие как Mixtral 8x7B, могут превосходить GPT 3.5 в большинстве тестов, и теперь могут работать со скоростью почти 500 токенов/с. Опубликованные данные наглядно подтверждают, что предлагаемый Groq ускоритель LPU Groq значительно превосходит системы для инференса, предлагаемые NVIDIA, AMD и Intel, говорит компания. Groq не раскрывает имена своих заказчиков, но в настоящее время её ИИ-решения используются, например, Аргоннской национальной лабораторией Министерства энергетики США.

24.02.2024 [19:46], Сергей Карасёв

ИИ-ускорители NVIDIA Blackwell сразу будут в дефицитеКомпания NVIDIA, по сообщению ресурса Seeking Alpha, прогнозирует высокий спрос на ИИ-ускорители следующего поколения Blackwell. Поэтому сразу после выхода на рынок эти изделия окажутся в дефиците, и их поставки будут ограничены. «На все новые продукты спрос превышает предложение — такова их природа. Но мы работаем так быстро, как только можем, чтобы удовлетворить потребности заказчиков», — говорит глава NVIDIA Дженсен Хуанг (Jensen Huang). Из-за стремительного развития генеративного ИИ на рынке сформировалась нехватка нынешних ускорителей NVIDIA H100 поколения Hopper. Срок выполнения заказов на серверы с этими изделиями достигает 52 недель. Аналогичная ситуация, вероятно, сложится и с ускорителями Blackwell, анонс которых ожидается в течение нынешнего года. «Полагаем, что отгрузки наших продуктов следующего поколения будут ограниченными, поскольку спрос намного превышает предложение», — сказала Колетт Кресс (Colette Kress), финансовый директор NVIDIA. Главный вопрос заключается в том, насколько быстро NVIDIA сможет организовать массовое производство Blackwell B100, а также серверов DGX на их основе. Дело в том, что это совершенно новые продукты, в которых используются другие компоненты. По имеющейся информации, Blackwell станет первой архитектурой NVIDIA, предусматривающей чиплетную компоновку. Это может упростить производство ускорителей на уровне кремния, но в то же время усложнит процесс упаковки. В дополнение к флагманскому чипу B100 для ИИ и HPC-задач компания готовит решение B40 для корпоративных заказчиков, гибридный ускоритель GB200, сочетающий ускоритель B100 и Arm-процессор Grace, а также GB200 NVL для обработки больших языковых моделей.

23.02.2024 [19:06], Сергей Карасёв

Meta✴ ищет в Индии и США специалистов для разработки ИИ-ускорителей и SoC для дата-центровКомпания Meta✴, по сообщению The Register, опубликовала множество объявлений о поиске специалистов для разработки интегральных схем специального назначения (ASIC). Речь идёт о создании собственных ускорителей для машинного обучения и ИИ, а также SoC для дата-центров. Сейчас для ИИ-задач Meta✴ массово применяет решения NVIDIA. Кроме того, компания присматривается к ускорителям AMD Instinct MI300. С целью снижения зависимости от сторонних поставщиков и сокращения расходов Meta✴ также проектирует собственные аппаратные компоненты. В частности, весной прошлого года Meta✴ анонсировала свой первый кастомизированный процессор, разработанный специально для ИИ-нагрузок. Изделие под названием MTIA v1 (Meta✴ Training and Inference Accelerator) представляет собой ASIC в виде набора блоков, функционирующих параллельно. Задействованы 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра RISC-V. Кроме того, компания создала чип MSVP (Meta✴ Scalable Video Processor) для обработки видеоматериалов. В разработке также находятся собственные ИИ-ускорители Artemis.

Источник изображения: Meta✴ Как теперь сообщается, Meta✴ ищет ASIC-инженеров с опытом работы в области архитектуры, дизайна и тестирования. Необходимы специалисты в Бангалоре (Индия) и Саннивейле (Калифорния, США). В некоторых вакансиях работодателем указана собственно Мета✴, тогда как в других случаях указан Facebook✴. От кандидатов в числе прочего требуется «глубокий опыт в одной или нескольких ключевых сферах, связанных с созданием сложных SoC для дата-центров». Тестировщикам необходимо иметь опыт проверки проектов для ЦОД, связанных с машинным обучением, сетевыми технологиями и пр. Некоторые вакансии были впервые опубликованы в соцсети LinkedIn в конце декабря 2023 года и обновлены в феврале нынешнего года. Претендентам обещаны неплохие зарплаты. Для каких именно задач компании Meta✴ требуются аппаратные решения, не уточняется. Но сетевые источники отмечают, что это может быть инференс, создание новых ИИ-платформ и т.п.

04.02.2024 [21:02], Сергей Карасёв

Meta✴ намерена активно внедрять собственные ИИ-ускорители Artemis в качестве альтернативы решениям NVIDIA и AMDВ 2024 году компания Meta✴, по сообщению The Register, после многих лет разработки может начать массовое внедрение собственных ИИ-чипов. Они станут альтернативой ускорителям NVIDIA и AMD, что поможет снизить зависимость от продукции сторонних поставщиков. В 2024 году компания намерена потратить до $37 млрд на развитие своей инфраструктуры. В настоящее время для поддержания ИИ-нагрузок Meta✴ применяет такие решения, как NVIDIA H100. Ожидается, что к концу 2024 года компания будет иметь в своём распоряжении 350 тыс. этих ускорителей. Вместе с тем Meta✴ проявляет интерес и к изделиям AMD Instinct MI300. Ранее компания высоко оценила возможности Qualcomm Cloud AI 100, но отказалась от них из-за несовершенства ПО. Не приглянулись Meta✴ и чипы Esperanto. Сейчас Meta✴ ведёт разработку собственных ИИ-ускорителей.

Источник изображения: Meta✴ Весной 2023 года стало известно, что компания создала свой первый ИИ-процессор. Чип под названием MTIA (Meta✴ Training and Inference Accelerator; на изображении) представляет собой ASIC в виде набора блоков, функционирующих в параллельном режиме. Задействованы 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра с архитектурой RISC-V. Конструкция включает 128 Мбайт памяти SRAM, а также до 64/128 Гбайт памяти LPDDR5. Показатель TDP равен 25 Вт. Заявленная производительность на операциях INT8 достигает 102,4 TOPS, на операциях FP16 — 51,2 Тфлопс. Процессор производится по 7-нм технологии TSMC.

Источник изображения: Meta✴ Как теперь сообщается, в 2024-м Meta✴ намерена начать активное использование собственных ИИ-ускорителей с кодовым именем Artemis. В их основу лягут компоненты MTIA первого поколения. Чип Artemis, оптимизированный для инференса, будет применяться наряду с ускорителями сторонних поставщиков. При этом, как отметили представители компании, изделия Artemis обеспечат «оптимальное сочетание производительности и эффективности при рабочих нагрузках, специфичных для Meta✴».

Источник изображения: Meta✴ Компания пока не раскрывает ни архитектуру Artemis, ни конкретные рабочие нагрузки, которые будет поддерживать чип. Участники рынка полагают, что Meta✴ будет запускать готовые ИИ-модели на собственных специализированных ASIC, чтобы высвободить ресурсы ускорителей для развивающихся приложений. По данным SemiAnalysis, Artemis получит улучшенные ядра, а компоненты LPDDR5 уступят место более быстрой памяти, использующей технологию TSMC CoWoS. Нужно добавить, что Amazon и Google уже несколько лет используют собственные чипы для ИИ-задач. Например, Amazon недавно ИИ-ускорители Trainium2 и Inferenetia2, тогда как Google в 2023 году представила сразу два новых ускорителя: Cloud TPU v5p и TPU v5e. А Microsoft сообщила о создании ИИ-ускорителя Maia 100.

02.02.2024 [13:13], Сергей Карасёв

Цена ИИ-ускорителя NVIDIA H20 для Китая составляет $12–$15 тыс.Компания NVIDIA, по сообщению Reuters, начала принимать предварительные заказы на новый ИИ-ускоритель H20, разработанный специально для Китая. Утверждается, что данное изделие стоит примерно столько же, сколько конкурирующий продукт Huawei — Ascend 910B. Отмечается, что в последние недели NVIDIA оценивает решение H20 в диапазоне от $12 тыс. до $15 тыс. Некоторые китайские дистрибьюторы уже предлагают этот ускоритель за $15 500. Для сравнения: Ascend 910B на местном рынке стоит приблизительно $16 900. Ради обхода санкционных ограничений, введённых властями США, компании NVIDIA пришлось снизить производительность H20 по сравнению со своими флагманскими чипами. По некоторым ключевым параметрам H20 уступает карте Ascend 910B. Вместе с тем, согласно имеющимся данным, H20 превосходит конкурирующее изделие Huawei с точки зрения скорости передачи данных между ускорителями внутри готовой системы.

Источник изображения: NVIDIA Reuters также сообщает, что серверы, оснащённые восемью ускорителями H20, доступны в Китае для заказа по цене примерно $197 тыс. Это практически на треть меньше по сравнению с системами, оборудованными восемью чипами H800: такие устройства в прошлом году стоили около $282 тыс. Китайские дистрибьюторы сообщили, что смогут начать поставлять ускорители H20 небольшими партиями в текущем квартале, тогда как массовые отгрузки запланированы на II четверть 2024 года. При этом любое ужесточение санкций со стороны США может поставить крест на продажах новинок. |

|