Лента новостей

|

14.10.2025 [17:24], Руслан Авдеев

ABB поддержит NVIDIA во внедрении 800 В питания для мегаваттных ИИ-стоекКомпания ABB Group, специализирующаяся на электрификации и автоматизации, объявила об ускоренной разработке новых решений для дата-центров совместно с NVIDIA. В первую очередь речь идёт о создании и внедрении передовых энергетических решений, необходимых для эффективной и масштабируемой подачи энергии, сообщает пресс-служба ABB. ABB будет развивать платформу 800 В DC для мегаваттных серверных стоек. Прогнозируется, что мировой спрос на ЦОД вырастет с 80 ГВт в 2024 году до около 220 ГВт к 2030 году. Капитальные затраты, по мнению экспертов, превысят $1 трлн, сообщает Dell'Oro Group. На рабочие нагрузки ИИ придётся порядка 70 % этого роста. Чтобы эффективно обеспечивать мощность такого уровня, потребуются новые технологии и архитектура распределения электроэнергии. Будущие ЦОД получат комбинацию источника бесперебойного питания среднего напряжения (MV) и систему распределения постоянного тока в серверных с использованием твердотельных преобразователей, заменяющих классические трансформаторы и иные компоненты.

Источник изображения: Frames For Your Heart/unsplash.com В ABB заявляют, что компания возглавляет разработку новых технологий распределения электричества, позволяющих создавать дата-центры нового поколения. Утверждается, что она одной из первых стала инвестировать в новые ИБП, DC-системы и твердотельные компоненты. Портфолио решений ABB для дата-центров включает интеллектуальные системы распределения электроэнергии, специальные решения для резервного питания ЦОД, средства цифрового мониторинга и прочие ключевые технологии, обеспечивающие бесперебойную работу оборудования и оптимизирующие использование энергии для ИИ-серверов. Около 40 % научных исследований ABB в сфере электроснабжения приходится на тематики, имеющие решающее значение для ЦОД нового поколения — это касается работ в области электрической архитектуры, систем защиты, распределения постоянного тока и охлаждения. В конце мая сообщалось, что Infineon Technologies объединит усилия с NVIDIA для разработки централизованной архитектуры высоковольтного питания постоянным током (HVDC) на 800 В для нужд ИИ ЦОД.

14.10.2025 [16:15], Сергей Карасёв

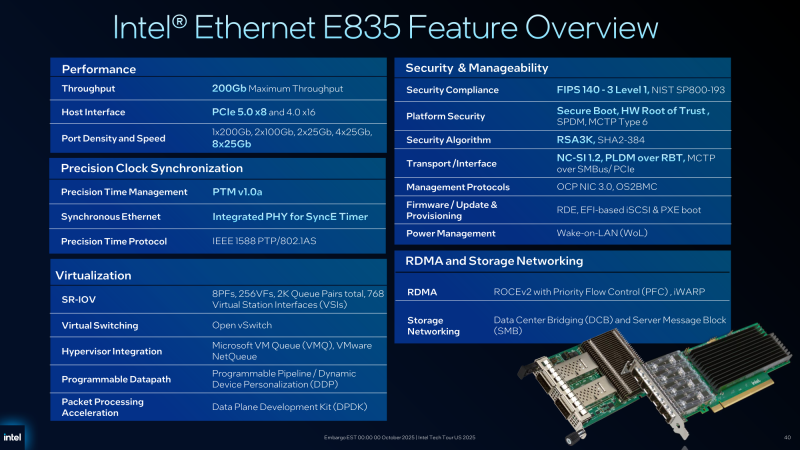

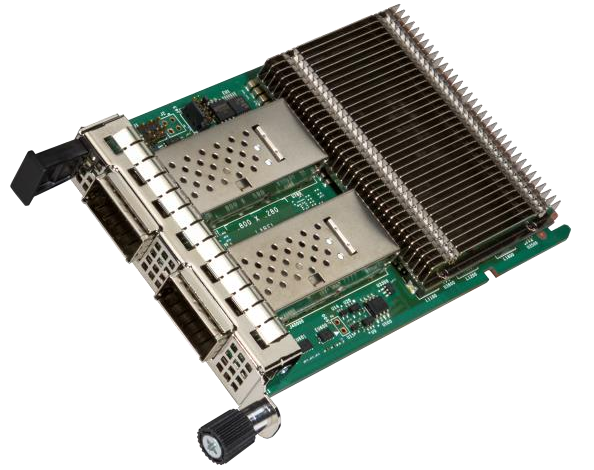

Intel подготовила 200GbE-адаптеры серии E835 для дата-центровВ начале текущего года корпорация Intel анонсировала сетевые контроллеры и адаптеры семейства Ethernet E830 с поддержкой стандарта 200GbE для корпоративных, облачных и периферийных развёртываний. А теперь появилась информация об изделиях серии Ethernet E835 с улучшенными характеристиками.

Источник изображений: Intel Новые адаптеры ориентированы на дата-центры и телекоммуникационные инфраструктуры. Заявлена поддержка хост-интерфейсов PCIe 5.0 х8 и PCIe 4.0 х16. Intel предложит варианты в конфигурациях с портами 1 × 200GbE, 2 × 100GbE, 2 × 25GbE, 4 × 25GbE и 8 × 25GbE. Реализована поддержка протоколов управления OS2BMC и OCP NIC 3.0, средств безопасности Secure Boot, SPDM (Security Protocol and Data Model), MCTP Type 6 и Root of Trust (на аппаратном уровне), а также стандартов FIPS 140-3 Level 1 и NIST SP800-193. Как и в случае с решениями Ethernet E830, имеется поддержка PTM (Precision Time Measurement), 1588 PTP и SyncE. Судя по представленному изображению, устройства серии Ethernet E835 оборудованы пассивным охлаждением на основе крупного радиатора. Среди прочего говорится о совместимости с RDMA iWARP и RoCE v2. Сетевые адаптеры оптимизированы для использования в системах с процессорами Xeon 6. От решений Ethernet E830 унаследованы такие технологии, как Virtual Machine Device Queues (VMDq), Flexible Port Partitioning (FPP), Intel Data Direct I/O и др.

14.10.2025 [15:45], Руслан Авдеев

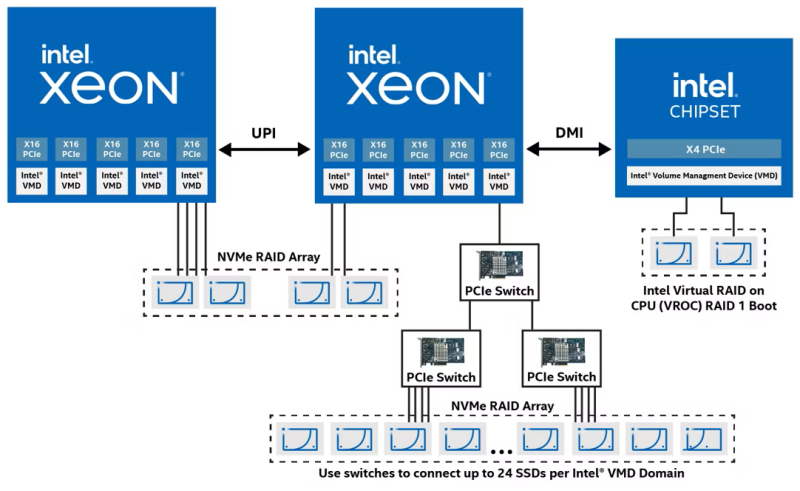

Intel продала компании Graid технологию VROC: будут временные перебои с продажами и техподдержкойТехнология Intel VROC (Virtual RAID on CPU) со времён Xeon Skylake-SP позволяет создавать программно-аппаратные RAID-массивы из NVMe-накопителей в серверных системах без необходимости приобретать RAID-контроллеры сторонних производителей. С выходом Xeon Sapphire Rapids компания намеревалась прекратить поддержку VROC, но столкнулась с возмущением клиентов — многие компании всё ещё использовали старые, но стабильные системы. В результате Intel продолжила поддержку, но приняла решение продать бизнес на сторону. Новым владельцем стала Graid Technology. Это может вызвать ряд технических проблем до конца ноября, сообщает портал Serve The Home. Graid, которая сама занимается созданием программно-аппаратных NVMe RAID с GPU-ускорением, продолжит поддержку Intel VROC. В октябре и ноябре 2025 года будут периоды, во время которых заказы новых ключей и техническая поддержка будут недоступны, но этот период продлится не очень долго, после чего GRAID сама будет отвечать за связанный бизнес. 23 октября — последний день подачи заявки на получение нового аппаратного ключа VROC в рамках RMA в случае поломки. 30 октября — последний день, чтобы отправить сломанный ключ в компанию. До 30 ноября можно будет заказать аппаратные ключи самой Intel (про ключи OEM-партнёров ничего не говорится). С 8 по 23 ноября планируется полная остановка продаж новых ключей и гарантийного обслуживания, только с 24 ноября Graid приступит к обслуживанию старых клиентов Intel и собственных новых клиентов. Поскольку бизнес передаётся независимой компании, вполне вероятно, что она может поменять ценовую политику. Впрчоем, для клиентов Intel даже такой сценарий может оказаться очень выигрышным, поскольку это — лучшая альтернатива полному отключению. Многие клиенты всё ещё используют VROC в старых платформах. Graid тоже должна выиграть, поскольку получит список активных клиентов, которым можно продать собственные, более современные решения. Для Intel же это повод избавиться от устаревших активов.

14.10.2025 [13:26], Руслан Авдеев

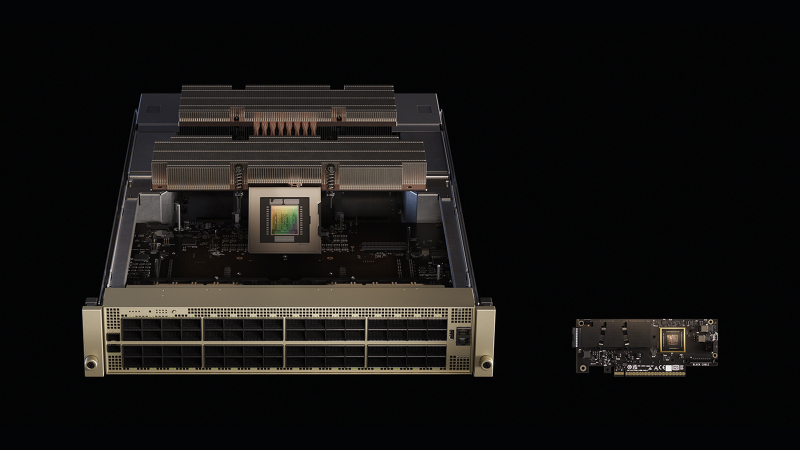

«Нервная система» ИИ-фабрик: Meta✴ и Oracle развернут сетевые платформы NVIDIA Spectrum-X Ethernet в своих ЦОДNVIDIA объявила, что Meta✴ и Oracle развернут в своих ИИ ЦОД Ethernet-платформы NVIDIA Spectrum-X. В NVIDIA подчёркивают, что модели на триллионы параметров трансформируют дата-центры в ИИ-фабрики гигаваттного уровня, а лидеры индустрии стандартизируют использование решений Spectrum-X Ethernet в качестве одного из драйверов промышленной революции. По словам компании, речь идёт не просто о быстром Ethernet, а о «нервной системе» ИИ-фабрик, позволяющей гиперскейлерам объединять миллионы ИИ-ускорителей в гигантские кластеры для обучения крупнейших за всю историю моделей. Oracle намерена строить ИИ-гигафабрики из ускорителей NVIDIA Vera Rubin с интерконнектами Spectrum-X Ethernet. В Oracle подчёркивают, что инфраструктура Oracle Cloud «с нуля» строится для ИИ-задач, и партнёрство с NVIDIA способствует лидерству Oracle в сфере ИИ. Использование Spectrum-X Ethernet позволит клиентам связывать миллионы ускорителей и быстрее обучать, внедрять и пользоваться благами генеративных и «рассуждающих» ИИ нового поколения. Meta✴ намерена интегрировать коммутаторы в свою сетевую инфраструктуру для программной платформы Facebook✴ Open Switching System (FBOSS), как раз разработанной для управления и контроля массивами сетевых коммутаторов. Интеграция решений ускорит масштабное внедрение для повышения эффективности ИИ-проектов. Интеграция NVIDIA Spectrum Ethernet в коммутатор Minipack3N и использование FBOSS позволит повысить эффективность и предсказуемость, необходимые для обучения крупнейших в истории ИИ-моделей и доступа к ИИ-приложениям миллионам людей.

Источник изображения: NVIDIA Платформа NVIDIA Spectrum-X Ethernet включает как собственно коммутаторы Spectrum-X Ethernet, так и адаптеры Spectrum-X Ethernet SuperNIC. Spectrum-X Ethernet уже продемонстрировала рекордную эффективность, позволившую крупнейшему в мире суперкомпьютеру Colossus компании xAI добиться использования 95 % возможной полосы, тогда как обычные Ethernet-платформы обеспечивают лишь 60 %, утверждает NVIDIA.

Источник изображения: Meta✴ В июне сообщалось, что продажи Ethernet-коммутаторов NVIDIA за год выросли на 760 % благодаря росту спроса на ИИ, а в последнем квартале рост составил +98 %. Акции Arista, одного из ключевых поставщиков коммутаторов для Meta✴, упали после анонса NVIDIA и объявления Meta✴, что коммутаторы Minipack3N теперь используют ASIC Spectrum-4 и производятся Accton.

14.10.2025 [12:46], Владимир Мироненко

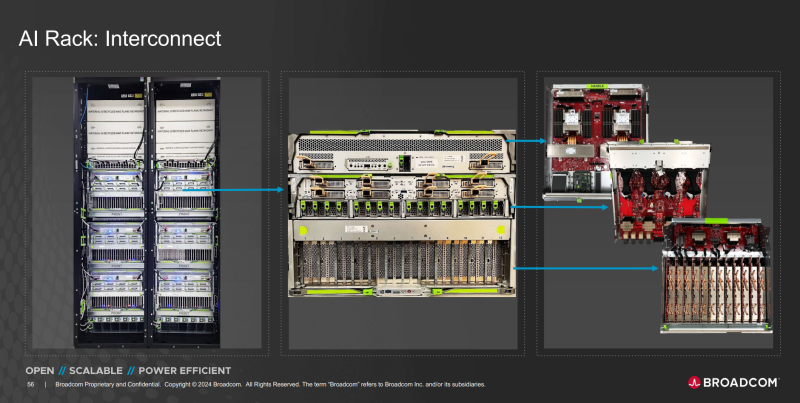

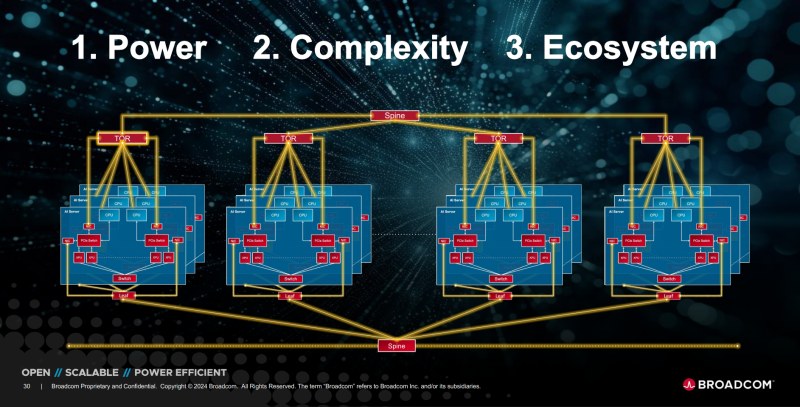

OpenAI и Broadcom совместно разработают и развернут ИИ-ускорители на 10 ГВтOpenAI и Broadcom объявили о заключении соглашения о стратегическом сотрудничестве с целью совместного создания и дальнейшего развёртывания кастомных ИИ-ускорителей общей мощностью 10 ГВт. Речь идёт об вертикально интегрированных решениях уровня стоек и ЦОД. OpenAI отметила в пресс-релизе, что при разработке собственных чипов и систем сможет интегрировать имеющиеся достижения в создании передовых моделей и продуктов непосредственно в аппаратное обеспечение. «Стойки, полностью масштабируемые с использованием Ethernet и других сетевых решений Broadcom, удовлетворят растущий глобальный спрос на ИИ и будут развёрнуты на объектах OpenAI и в партнёрских ЦОД», — сообщила компания. Начало развертывания систем запланировано на II половину 2026 года, а завершение — на конец 2029 года. «Партнёрство с Broadcom — критически важный шаг в создании инфраструктуры, необходимой для раскрытия потенциала ИИ и предоставления реальных преимуществ людям и бизнесу», — заявил Сэм Альтман (Sam Altman), соучредитель и генеральный директор OpenAI. Он отметил, что разработка собственных ускорителей дополняет более широкую экосистему партнёров, которые вместе создают потенциал, «необходимый для расширения возможностей ИИ на благо всего человечества». Чарли Кавас (Charlie Kawwas), президент группы полупроводниковых решений Broadcom сообщил, что кастомные ускорители «прекрасно сочетаются со стандартными сетевыми решениями Ethernet для масштабирования и горизонтального масштабирования», позволяя создать оптимизированную по стоимости и производительности ИИ-инфраструктуру нового поколения. По его словам, стойки будут включать комплексный набор решений Broadcom для Ethernet, PCIe и оптических соединений. Как пишет The Register, президент OpenAI Грег Брокман (Greg Brockman) рассказал, что при разработке ускорителя компания смогла использовать собственные ИИ-модели, которые позволили оптимизировать и ускорить процесс. По его словам, благодаря этому удалось увеличить плотность размещения компонентов. «Вы берёте компоненты, которые уже оптимизированы людьми, просто указываете для них вычислительные мощности, и модель сама предлагает решение», — цитирует Брокмана SiliconANGLE. Компании не уточнили, какие именно продукты Broadcom будут использоваться в рамках партнёрства. Вполне возможно, что это будет анонсированный на прошлой неделе Ethernet-коммутатор TH6-Davisson, оптимизированный для ИИ-кластеров и обеспечивающий пропускную способность до 102,4 Тбит/с, что, по заявлению компании, вдвое превышает показатели изделий ближайшего конкурента. Также Broadcom поставляет линейку PCIe-коммутаторов серии PEX и ретаймеры. Ранее в этом месяце OpenAI заключила соглашение с AMD на поставку ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт для обеспечения своей ИИ-инфраструктуры. По предварительным оценкам, стоимость контракта составляет $60–$80 млрд. В сентябре NVIDIA объявила о соглашении с OpenAI на поставку ускорителей для развёртывания ИИ-инфраструктуры мощностью не менее 10 ГВт с сопутствующими инвестициями в размере $100 млрд. Broadcom в сентябре сообщила о получении заказа от нового клиента на разработку и поставку кастомного ИИ-чипа на сумму более $10 млрд. По мнению аналитиков, речь шла как раз об OpenAI. Создание сети взаимозависимостей означает, что несколько технологических компаний с оборотом в миллиарды долларов кровно заинтересованы в успехе OpenAI, отметил The Register. При этом OpenAI заявляет, что у неё не будет положительного денежного потока ещё четыре года и вместе с тем планирует в течение этого периода значительно увеличить расходы на инфраструктуру ЦОД. Такой подход вызывает опасения у экспертов, заявляющих, что подобные сделки указывают на своего рода пузырь на ИИ-рынке, поскольку компании оперируют такими терминами, как гигаватты и токены, вместо таких «скучных старых терминов», как выручка или доход.

14.10.2025 [09:54], Сергей Карасёв

Giga Computing представила ИИ-сервер TO86-SD1 на платформе NVIDIA HGX B200Компания Giga Computing, подразделение Gigabyte, анонсировала высокопроизводительный сервер TO86-SD1 для обучения ИИ-моделей, инференса и ресурсоёмких HPC-задач. Новинка выполнена в форм-факторе 8OU в соответствии со стандартом OCP ORv3. Возможна установка двух процессоров Intel Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400 или MRDIMM 8000). Во фронтальной части предусмотрены отсеки для восьми SFF-накопителей с интерфейсом PCIe 5.0 (NVMe); поддерживается горячая замена. Есть коннектор M.2 2280/22110 для SSD (PCIe 5.0 x4). Упомянута поддержка CXL 2.0. Сервер несёт на борту ИИ-ускорители NVIDIA HGX B200 поколения Blackwell в конфигурации 8 × SXM. Суммарный объём памяти HBM3E составляет 1,4 Тбайт. Доступны 12 слотов PCIe 5.0 x16 для карт расширения FHHL с доступом через лицевую панель корпуса. Говорится о совместимости с NVIDIA BlueField-3 DPU и NVIDIA ConnectX-7 NIC.

Источник изображения: Giga Computing В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на базе Intel X710-AT2, выделенный сетевой порт управления 1GbE, разъёмы USB 3.2 Gen1 Type-C, Micro-USB и Mini-DP. Применяется система воздушного охлаждения с четырьмя 92-мм вентиляторами в области материнской платы и двенадцатью 92-мм кулерами в GPU-секции. Диапазон рабочих температур — от +10 до +35 °C. Заявлена совместимость с Windows Server, RHEL, Ubuntu, Citrix, VMware ESXi.

14.10.2025 [02:00], Сергей Карасёв

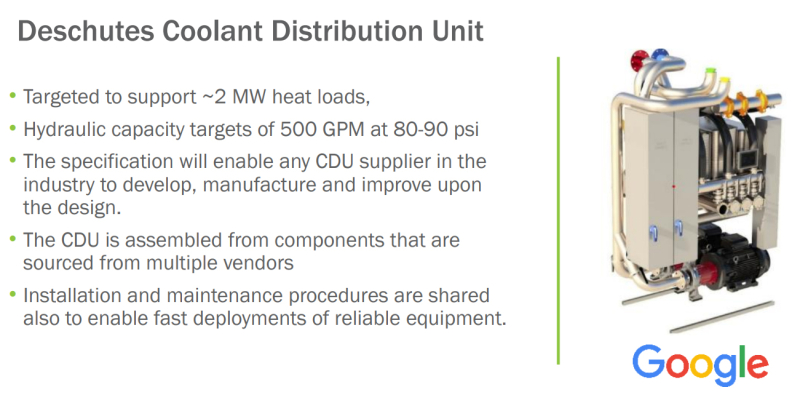

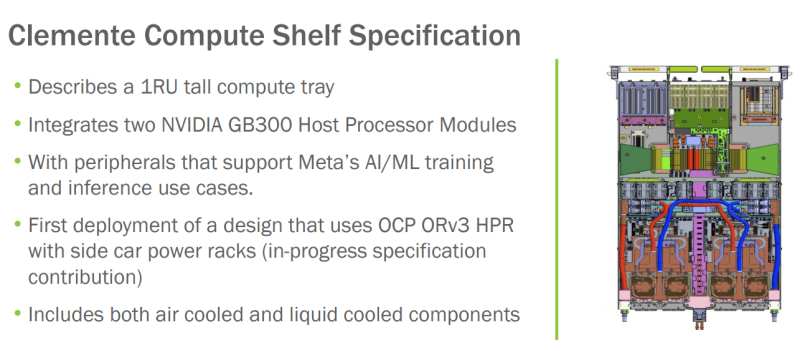

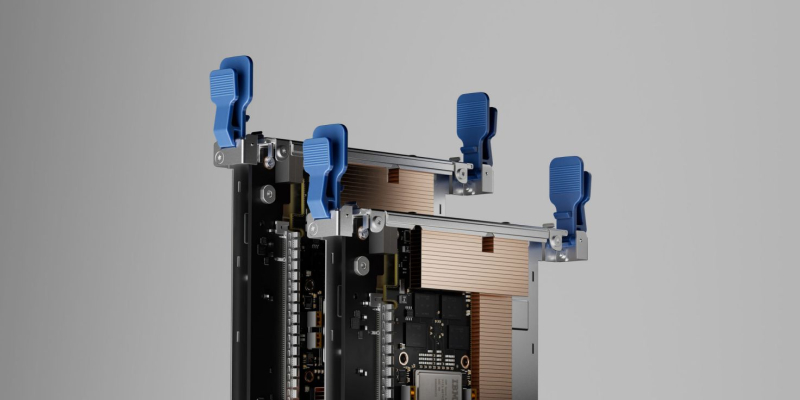

OCP запустила инициативу Open Data Center for AI для стандартизации инфраструктуры передовых ИИ ЦОД с мегаваттными стойкамиНекоммерческая организация Open Compute Project Foundation (OCP) анонсировала инициативу Open Data Center for AI по стандартизации компонентов физической инфраструктуры дата-центров, ориентированных на задачи ИИ и другие ресурсоёмкие нагрузки. Проект Open Data Center for AI является частью программы OCP Open Systems for AI, которая была представлена в январе 2024 года при участии Intel, Microsoft, Google, Meta✴, NVIDIA, AMD, Arm, Ampere, Samsung, Seagate, SuperMicro, Dell и Broadcom. Цель заключается в разработке открытых стандартов для кластеров ИИ и ЦОД, в которых размещаются такие системы. Запуск Open Data Center for AI продиктован быстрым развитием экосистемы дата-центров, результатами, полученными в рамках OCP Open Systems for AI, и новым открытым письмом о сотрудничестве, подготовленным Google, Meta✴ и Microsoft. В настоящее время, как отмечается, отрасль ЦОД сталкивается с проблемами, связанными с тем, что разрозненные усилия её участников, включая гиперскейлеров и колокейшн-провайдеров, порождают различные требования к проектированию инфраструктуры. Это замедляет внедрение инноваций и увеличивает сроки развёртывания передовых площадок. Цель Open Data Center for AI заключается в том, чтобы стандартизовать требования к системам электропитания, охлаждения и телеметрии, а также к механическим компонентам в ЦОД. Предполагается, что это обеспечит взаимозаменяемость элементов физической инфраструктуры дата-центров. При реализации инициативы Open Data Center for AI планируется использовать уже имеющиеся наработки сообщества OCP в области блоков распределения охлаждающей жидкости (CDU) и блоков распределения питания (PDU). Это, в частности, проект Mt. Diablo, который реализуется Meta✴, Microsoft и Google. Он предполагает создание общих стандартов электрических и механических интерфейсов. Идея заключается в разделении стойки на независимые шкафы для компонентов подсистемы питания и вычислительного оборудования. При этом планируется переход от единой шины питания постоянного тока с напряжением 48 В на архитектуру 400 В DC (Diablo 400). Ещё одним проектом, наработки которого пригодятся в рамках Open Data Center for AI, назван CDU Deschutes, разработанный Google. Это решение с резервными теплообменниками и насосами обеспечивает уровень доступности 99,999 %. Система Deschutes рассчитана на тепловые нагрузки до 2 МВт. Открытая спецификация позволит любой компании совершенствовать конструкцию CDU и производить изделия данного типа. Наконец, упоминаются серверные шасси Clemente, разработанные в Meta✴. Это узлы 1U, содержащие два суперчипа NVIDIA Grace Blackwell GB300 для ресурсоёмких ИИ-нагрузок. Платформа предполагает применение жидкостного охлаждения для CPU, GPU и коммутатора, а также воздушного охлаждения для других компонентов.

13.10.2025 [16:45], Руслан Авдеев

Microsoft не хватает ЦОД и серверов в США, причём не только для ИИПроблемы с дата-центрами Microsoft сохранятся дольше, чем рассчитывала компания. Это подчёркивает трудности, с которыми она сталкивается в своём стремлении удовлетворить спрос на облачные технологии, сообщает Bloomberg. Источники, знакомые с внутренними прогнозами Microsoft, сообщают, что во многих облачных регионах на территории США не хватает физического пространства и/или серверов. В некоторых ключевых регионах, включая Северную Вирджинию и Техас, новые подписки на сервисы Azure ограничат до I половины 2026 года. Это дольше, чем компания заявляла ранее. В июле её представитель сообщал, что действующие ограничения сохранятся до конца 2025 года. Нехватка мощностей касается как оборудования с ИИ-ускорителями, так и традиционных серверов, долгое время бывших костяком классических облачных сервисов. Двигателем роста Microsoft является облачное подразделение Azure, которое в 2025 финансовом году принесло более $75 млрд. По темпам развития оно опережает крупнейших конкурентов AWS и Google Cloud. Нехватка серверов для сдачи в аренду клиентам постоянно препятствует выполнению планов гиперскейлеров. В ходе шести последних квартальных отчётов Microsoft последовательно заявляла о неспособности удовлетворить спрос на облачные услуги, у AWS и Google проблемы очень похожие. Представитель Microsoft, впрочем, заявлял, что Azure в США имеет достаточно ресурсов для роста, на пиковые периоды компания может использовать специальные методы распределения мощностей, позволяющие распределить нагрузку между ЦОД, чтобы обеспечить стабильную работу всех пользователей, избегая дефицита ресурсов в отдельных регионах. В норме клиенты Azure выбирают облачные регионы с учётом их физической близости и доступных сервисов, но в некоторых случаях, если ресурсов недостаточно, менеджеры Microsoft рекомендуют другие объекты. Тем не менее такие обходные пути могут усложнить работу и увеличить время передачи данных между ЦОД и клиентом. В Hexaware Technologies сообщают, что те, кому не хватает ресурсов Azure, переносят нагрузки в другие места, используют несколько регионов Azure или отправляют в облако только критически важные нагрузки до высвобождения ресурсов. В исключительных случаях Microsoft даже компенсирует дополнительные непредвиденные расходы. По имеющимся данным, Microsoft только за последний год увеличила мощность ЦОД более чем на 2 ГВт. Интенсивные вычислительные потребности ИИ привели к необходимости создания новых дата-центров. Впрочем, сегодня Microsoft не достаёт и ресурсов традиционной облачной инфраструктуры. По словам источников, OpenAI сегодня является крупнейшим облачным клиентом Microsoft, использующим серверы на основе CPU. Кроме того, такие машины применяет и сама Microsoft для обеспечения работы своих приложений. По слухам, некоторые внутренние проекты закрываются в проблемных регионах для экономии ресурсов. На ввод в эксплуатацию нового ЦОД «с нуля» могут уйти годы. Впрочем, за пределами США доступность ЦОД значительно выше. Например, многие европейские регионы Microsoft могут регистрировать новых клиентов без ограничений. По словам Microsoft, если в январе 2025 года она надеялась, что соотношение спроса и предложения в США улучшится к июню, то позже в компании стали говорить, что оптимистичным сценарием будет улучшение ситуации к декабрю. Впрочем, развитие компании не прекращается. Недавно пресс-служба отчиталась о введении в действие новых мощностей в Азии. Кроме того, Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72. Сейчас компания достраивает «самый передовой» ИИ ЦОД в мире Fairwater, а потом потратит $4 млрд на ещё один такой же.

13.10.2025 [13:50], Руслан Авдеев

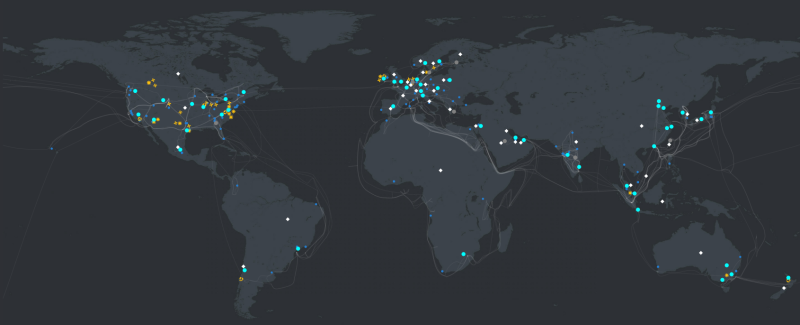

Microsoft запустила новые облачные регионы в Малайзии и Индонезии и откроет дополнительные в Индии и на ТайванеMicrosoft активно участвует в цифровой трансформации Азии, расширяя свою облачную инфраструктуру в регионе. В 2025 году компания запустила новые мощности Azure в Малайзии и Индонезии и планирует дальнейшее расширение с открытием новых облачных регионов в Индии и на Тайване в 2026 году, сообщает пресс-служба компании. Дополнительно IT-гигант намерен открыть второй регион в Малайзии — Southeast Asia 3. На азиатских рынках компания вкладывает миллиарды долларов в расширение собственной ИИ-инфраструктуры, внедряя передовые вычислительные и сетевые технологии, а также системы хранения. Инвестиции позволят бизнесам по всей Азии легко масштабироваться и использовать новые возможности для роста. Глобальная инфраструктура Microsoft охватила более 70 регионов 33 стран — это больше, чем у любого поставщика облачных услуг, утверждает компания. В Азии, где местный бизнес глубоко интегрирован в мировую экономику, дата-центры Microsoft обеспечивают бесперебойную масштабируемость, низкие задержки и соблюдение необходимых нормативов. Имея в распоряжении десяток регионов ЦОД в Азии, компания вкладывает значительные средства в расширение присутствия на континенте.

Источник изображения: Esmonde Yong/unspalsh.com В Восточной Азии исторически сложился рынок в Японии и Корее, который, как ожидается, продемонстрирует дальнейший рост и расширение. В апреле 2025 года компания запустила зоны доступности Azure в регионе Japan West, повысив надёжность и эффективность инфраструктуры в рамках двухлетнего плана инвестиций в ИИ и облачную инфраструктуру в стране. Дополнительно компания объявила о запуске Microsoft 365 и связанных решений для коммерческих клиентов в облачном регионе Taiwan North. Сервисы Azure также доступны в регионе некоторым клиентам, а в 2026 году, как ожидается, к ним получат доступ все желающие. В Юго-Восточной Азии компания тоже усиливает свои позиции, наращивая инвестиции. В мае 2025 года она запустила облачные регионы в Индонезии и Малайзии: ЦОД гиперскейл-уровня, готовность к ИИ-проектам, три зоны доступности и малая задержка для местных клиентов. Недавно введённый в эксплуатацию регион Indonesia Central — долгожданное для бизнеса дополнение, предлагающее комплексные сервисы Azure и локальную доступность Microsoft 365. Ожидается, что постоянные инвестиции в Индонезию приведут к значительному расширению местных кластеров, что позволит региону стать одним из крупнейших в Азии. Ещё весной 2024 года компания обещала вложить $1,7 млрд в облака и ИИ в Индонезии.

Источник изображения: Ernests Vaga/unsplash.com Malaysia West является первым облачным регионом в стране, с Azure и Microsoft 365. Возможностями региона уже пользуются нефтегазовый гигант из Малайзии — PETRONAS. В Малайзии Microsoft намерена открыть новый регион Southeast Asia 3 в городе Джохор-Бару (Johor Bahru). Когда регион нового поколения запустят, он будет предлагать наиболее современные и важные облачные сервисы Microsoft для сложных рабочих нагрузок. Дополнительно в 2024 году Microsoft объявила о развитии облачных технологий и ИИ-сервисов в Таиланде. В Индии уже есть несколько действующих регионов ЦОД, присутствие компании в стране будет только расширяться с запуском региона India South Central в Хайдарабаде (Hyderabad) в 2026 году. Это часть инвестиций в объёме $3 млрд, которые компания направит в течение двух лет на индийскую облачную и ИИ-инфраструктуру. В Microsoft утверждают, что инвестиции компании в инфраструктуру в Азии обусловлены потребностью в большей гибкости и оперативности в современной облачной среде. Благодаря значительным инвестициям в Азию, Microsoft может предлагать новые и более экономичные регионы Azure, подходящие как для малых, так и для крупных организаций. Новые регионы вроде Indonesia Central позволяют компаниям оптимизировать расходы на облака, сохраняя высокую производительность и доступность.

13.10.2025 [12:14], Сергей Карасёв

IBM представила ускоритель Spyre Accelerator для ИИ-инференсаКорпорация IBM объявила о том, что с конца текущего месяца специализированные ИИ-ускорители Spyre Accelerator станут доступны в составе серверов z17 и LinuxONE 5. А в начале декабря такими картами начнут комплектоваться системы POWER11. О подготовке Spyre Accelerator стало известно в августе прошлого года. Это детище исследовательского подразделения IBM Research. Ускоритель ориентирован на задачи инференса с низкой задержкой. В частности, устройство подходит для работы с генеративными приложениями и ИИ-агентами.

Источник изображения: IBM Изделие представляет собой плату расширения с интерфейсом PCIe 5.0 x16, в состав которой входит нейропроцессор IBM с 32 ядрами. Кроме того, есть 128 Гбайт памяти LPDDR5. Ускоритель насчитывает в общей сложности 25,6 млрд транзисторов; при производстве применяется 5-нм технология. Заявленное энергопотребление находится на уровне 75 Вт. IBM отмечает, что при использовании традиционных CPU и GPU для решения ресурсоёмких задач в области ИИ возникают сложности с масштабированием и эффективностью. Изделия Spyre Accelerator проектировались с тем, чтобы помочь в устранении указанных недостатков. При необходимости можно объединить до 16 плат в кластер в системе POWER11 и до 48 плат в составе z17. Вкупе с процессорами Telum II, которые лежат в основе z17 и LinuxONE 5, компании смогут одновременно запускать несколько ИИ-моделей. При этом возможен локальный инференс, что минимизирует обращения к сторонним сервисам: это сокращает задержки и способствует повышению безопасности. В качестве потенциальных заказчиков Spyre Accelerator называются финансовые организации, предприятия розничной торговли, государственные структуры, учреждения из сферы здравоохранения, промышленные предприятия и пр. |

|