Лента новостей

|

30.06.2023 [21:39], Владимир Мироненко

Глава Oracle считает, что архитектура Intel x86 теряет актуальность для серверовВ 2023 году Oracle планирует потратить значительные средства на приобретение чипов AMD и Ampere Computing для новой инфраструктуры, отметив, что «старая архитектура Intel x86 достигает своего предела». «В этом году Oracle купит GPU и CPU у трёх компаний, — сообщил на прошедшем в среду мероприятии глава Oracle Ларри Эллисон (Larry Ellison). — Мы будем покупать GPU у NVIDIA, мы покупаем у неё на миллиарды долларов США. И потратим в три раза больше на центральные процессоры от Ampere и AMD. Мы по-прежнему тратим больше денег на традиционные чипы». Oracle сообщила, что впервые за 14 лет существования специализированных ПАК Exadata для СУБД она полностью отказалась от процессоров Intel в пользу чипов AMD. В платформе 12-го поколения Exadata X10M в рамках двух предложений Oracle Exadata Machine и управляемого решения Oracle Exadata Cloud@Customer будут использоваться AMD EPYC Genoa. Одной из причин такого перехода, пусть и далеко не самой важной, считается отказ Intel от Optane.

Источник изображения: Oracle С момента запуска Exadata в 2008 году Oracle полагалась на процессоры Intel Xeon. Но ситуация начала меняться c выходом X9M в 2021 году. Для Oracle Exadata Machine и Oracle Exadata Cloud@Customer компания выбрала чипы Intel Xeon Ice Lake-SP, а в начале 2022 года для облачного решения Oracle Exadata Cloud Infrastructure решила использовать чипы AMD. При этом EPYC Milan использовались в серверах для обеспечения работы баз данных, а Ice Lake-SP — для СХД. Кроме того, на днях Oracle сделала важный шаг — перенесла свою флагманскую СУБД Oracle Database на архитектуру Arm, т.е. на процессоры компании Ampere Computing, в которую в своё время инвестировала. Эллисон отметил, что чипы Ampere Altra намного энергоэффективнее решений AMD и NVIDIA, что поможет ЦОД Oracle соответствовать будущим регуляциям. «Мы перешли на новую архитектуру и к новому поставщику, — сообщил Эллисон. — Мы думаем, что это будущее. Старая архитектура Intel x86 после многих десятилетий на рынке подошла к своему пределу». Тем не менее, эксперты полагают, что ставка Oracle на архитектуру Arm не помешает её отношениям с AMD в ближайшее время, тем более что Intel и AMD планируют бороться с Arm-процессорами с помощью оптимизированных для облачных платформ чипов с высокой плотностью ядер и улучшенной энергоэффективностью: EPYC Bergamo и Xeon Sierra Forest. Кроме того, разработка, перенос и рефакторинг ПО для Arm требует времени и средств. В свою очередь, представитель Intel сообщил ресурсу CRN в четверг, что компания поставляет Oracle процессоры Xeon Sapphire Rapids «в течение многих месяцев и планирует продолжать поставки Xeon текущего и следующего поколения в будущем». Компании связывают долгие годы совместной работы над аппаратными и программными решениями для клиентов, а сейчас Intel поставляет чипы для облачной инфраструктуры Oracle OCI.

29.05.2023 [07:30], Сергей Карасёв

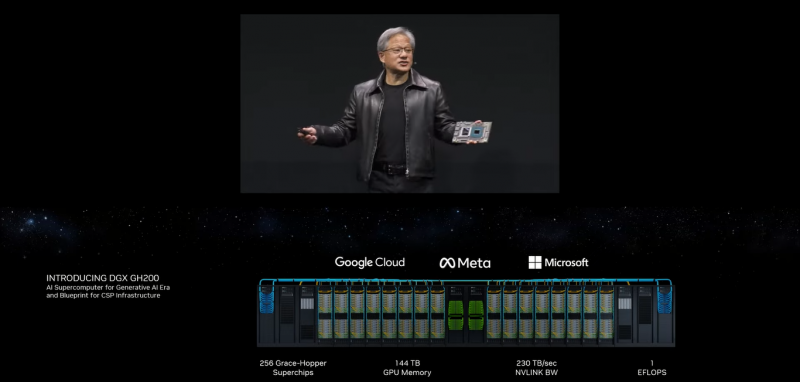

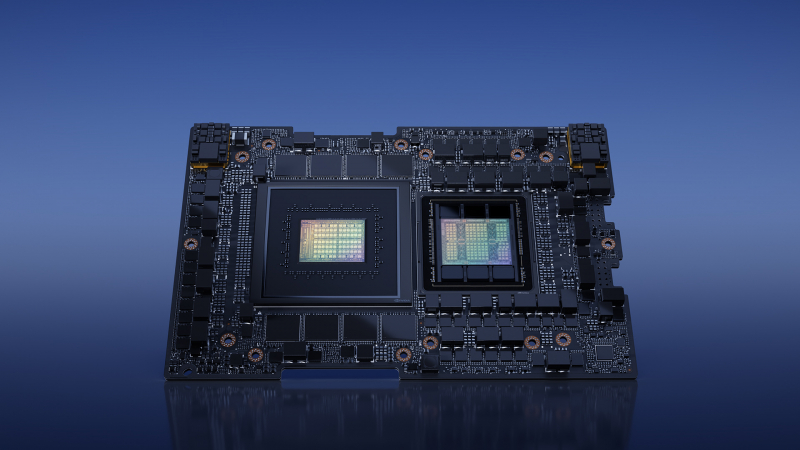

NVIDIA представила 1-Эфлопс ИИ-суперкомпьютер DGX GH200: 256 суперчипов Grace Hopper и 144 Тбайт памятиКомпания NVIDIA анонсировала вычислительную платформу нового типа DGX GH200 AI Supercomputer для генеративного ИИ, обработки огромных массивов данных и рекомендательных систем. HPC-платформа станет доступна корпоративным заказчикам и организациям в конце 2023 года. Платформа представляет собой готовый ПАК и включает, в частности, наборы ПО NVIDIA AI Enterprise и Base Command. Для платформы предусмотрено использование 256 суперчипов NVIDIA GH200 Grace Hopper, объединённых при помощи NVLink Switch System. Каждый суперчип содержит в одном модуле Arm-процессор NVIDIA Grace и ускоритель NVIDIA H100. Задействован интерконнект NVLink-C2C (Chip-to-Chip), который, как заявляет NVIDIA, значительно быстрее и энергоэффективнее, нежели PCIe 5.0. В результате, скорость обмена данными между CPU и GPU возрастает семикратно, а затраты энергии сокращаются примерно в пять раз. Пропускная способность достигает 900 Гбайт/с. Технология NVLink Switch позволяет всем ускорителям в составе системы функционировать в качестве единого целого. Таким образом обеспечивается производительность на уровне 1 Эфлопс (~ 9 Пфлопс FP64), а суммарный объём памяти достигает 144 Тбайт — это почти в 500 раз больше, чем в одной системе NVIDIA DGX A100. Архитектура DGX GH200 AI Supercomputer позволяет добиться 10-кратного увеличения общей пропускной способности по сравнению с HPC-платформой предыдущего поколения. Ожидается, что Google Cloud, Meta✴ и Microsoft одними из первых получат доступ к суперкомпьютеру DGX GH200, чтобы оценить его возможности для генеративных рабочих нагрузок ИИ. В перспективе собственные проекты на базе DGX GH200 смогут реализовывать крупнейшие провайдеры облачных услуг и гиперскейлеры. Для собственных нужд NVIDIA до конца 2023 года построит суперкомпьютер Helios, который посредством Quantum-2 InfiniBand объединит сразу четыре DGX GH200.

29.05.2023 [07:30], Сергей Карасёв

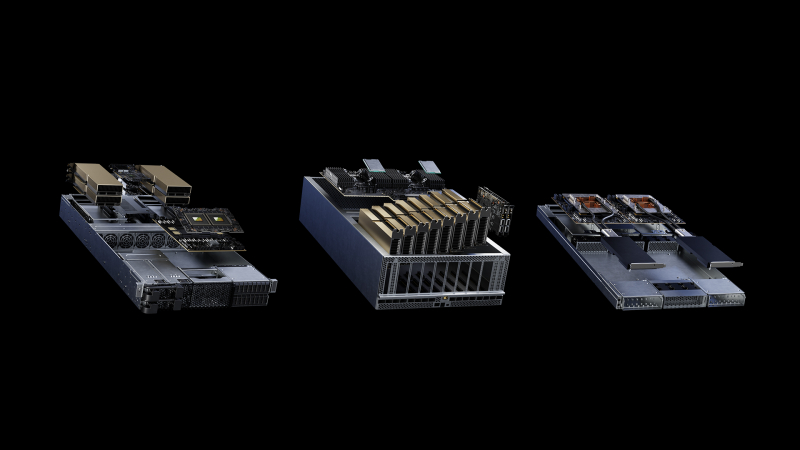

NVIDIA представила модульную архитектуру MGX для создания ИИ-систем на базе CPU, GPU и DPUКомпания NVIDIA на выставке Computex 2023 представила архитектуру MGX, которая открывает перед разработчиками серверного оборудования новые возможности для построения HPC-систем, платформ для ИИ и метавселенных. Утверждается, что MGX закладывает основу для быстрого создания более 100 вариантов серверов при относительно небольших затратах. Концепция MGX предусматривает, что разработчики на первом этапе проектирования выбирают базовую системную архитектуру для своего шасси. Далее добавляются CPU, GPU и DPU в той или иной конфигурации для решения определённых задач. Таким образом, на базе MGX может быть построена серверная система для уникальных рабочих нагрузок в области наук о данных, больших языковых моделей (LLM), периферийных вычислений, обработки графики и видеоматериалов и пр. Говорится также, что благодаря гибридной конфигурации на одной машине могут выполняться задачи разных типов, например, и обучение ИИ-моделей, и поддержание работы ИИ-сервисов. Одними из первых системы на архитектуре MGX выведут на рынок компании Supermicro и QCT. Первая предложит решение ARS-221GL-NR с NVIDIA Grace, а вторая — сервер S74G-2U на базе NVIDIA GH200 Grace Hopper. Эти платформы дебютируют в августе нынешнего года. Позднее появятся MGX-платформы ASRock Rack, ASUS, Gigabyte, Pegatron и других производителей. Архитектура MGX совместима с нынешним и будущим оборудованием NVIDIA, включая H100, L40, L4, Grace, GH200 Grace Hopper, BlueField-3 DPU и ConnectX-7. Поддерживаются различные форм-факторы систем: 1U, 2U и 4U. Возможно применение воздушного и жидкостного охлаждения.

23.05.2023 [19:36], Руслан Авдеев

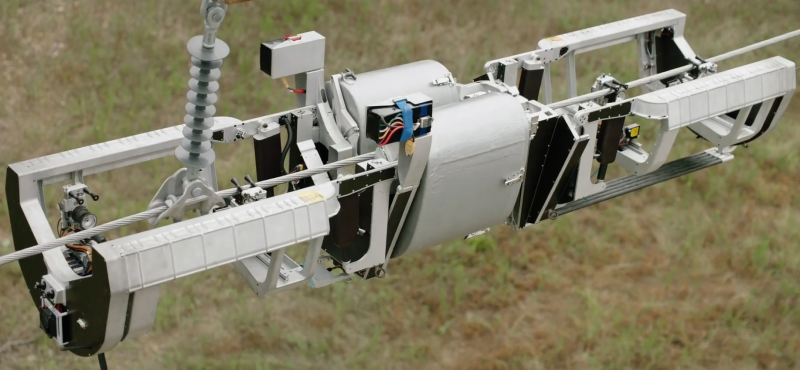

Meta✴ лицензирует робота Bombyx, предназначенного для прокладки оптоволоконных интернет-кабелей по ЛЭПРобот Meta✴ Bombyx — это специальное устройство, способное прокладывать оптоволоконные кабели, передвигаясь по линиям электропередач. Bombyx переводится с латыни как «мотылёк шелкопряда». Разработка робота была начата Facebook✴ и ULC Robotics ещё в 2018 году. Теперь Meta✴ сделала ставку на сторонний бизнес, который готов взять реализацию проекта на себя — робота лицензируют для дальнейшей разработки японской IT-компанией. Лицензию получит японская Hibot, обладающая десятилетиями опыта в разработке роботов различного назначения. В компании уже заявили, что считают большой честью получение лицензии и намерены работать над проектом уже существующими партнёрами и теми, кто пожелает присоединиться к разработке. Робот Bombyx поддержит прокладку оптических линий в труднодоступных местностях, где проникновение интернета оставляет желать лучшего.

Источник изображения: Meta✴ В дополнение к возможности прокладки кабеля, Hibot будет использовать инновационные технологии Meta✴ для создания машины, пригодной для проверки уже существующей инфраструктуры и, возможно, для модернизации электросетей. Хотя оптоволоконные кабели являются недорогими и эффективным решением для создания информационных сетей, сама прокладка обычно обходится значительно дороже самого кабеля и представляет собой относительно сложный процесс.

Источник изображения: Meta✴ В случае Bombyx кабель обвивается вокруг проводов на линиях электропередач. При этом снятие напряжения не требуется, а протяжённость кабеля может быть весьма велика. Правда, речь идёт о специальном кабеле в кевларовой рубашке, который значительно легче традиционных вариантов (менее 13 кг/км). Bombyx может преодолевать препятствия, используя механизмы машинного зрения и сенсоры для ориентации в пространстве.

23.05.2023 [15:26], Сергей Карасёв

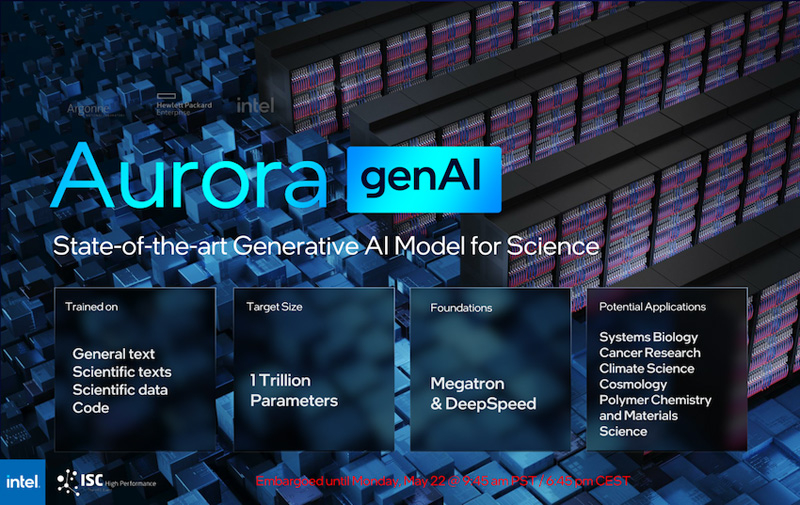

Intel рассказала о суперкомпьютере Aurora производительностью более 2 ЭфлопсКорпорация Intel в ходе конференции ISC 2023, как сообщает AnandTech, поделилась информацией о проекте Aurora по созданию суперкомпьютера с производительностью экзафлопсного уровня. Эта система создаётся для Аргоннской национальной лаборатории Министерства энергетики США. Изначально анонс HPC-комплекса Aurora состоялся ещё в 2015 году с предполагаемым запуском в 2018-м: ожидалось, что машина обеспечит быстродействие на уровне 180 Пфлопс. Однако реализация проекта значительно затянулась, а технические параметры платформы неоднократно менялись. Пока что развёрнуты тестовый кластер Sunspot. Как теперь сообщается, в конечной конфигурации Aurora объединит 10 624 узла, каждый из которых будет включать два процессора Xeon Max и шесть ускорителей Ponte Vecchio. Таким образом, общее количество CPU будет достигать 21 248, число GPU — 63 744. Быстродействие FP64, как и было заявлено ранее, превысит 2 Эфлопс.

Источник изображений: Intel (via AnandTech) Каждый процессор оперирует 64 Гбайт памяти HBM, ускоритель — 128 Гбайт. В сумме это даёт соответственно 1,36 Пбайт и 8,16 Пбайт памяти HBM с пиковой пропускной способностью 30,5 Пбайт/с и 208,9 Пбайт/с. В дополнение система сможет использовать 10,9 Пбайт памяти DDR5 с пропускной способностью до 5,95 Пбайт/с. Вместимость подсистемы хранения данных составит 230 Пбайт со скоростью работы до 31 Тбайт/с.  На сегодняшний день Intel поставила более 10 тыс. «лезвий» для Aurora, а это означает, что практически все узлы готовы к окончательному монтажу. Ввод суперкомпьютера в эксплуатацию намечен на текущий год. Для НРС-платформы готовится специализированная научная модель генеративного ИИ — Generative AI for Science, насчитывающая около 1 трлн параметров. Применять Aurora планируется для решения наиболее ресурсоёмких задач в различных областях.

19.05.2023 [10:10], Сергей Карасёв

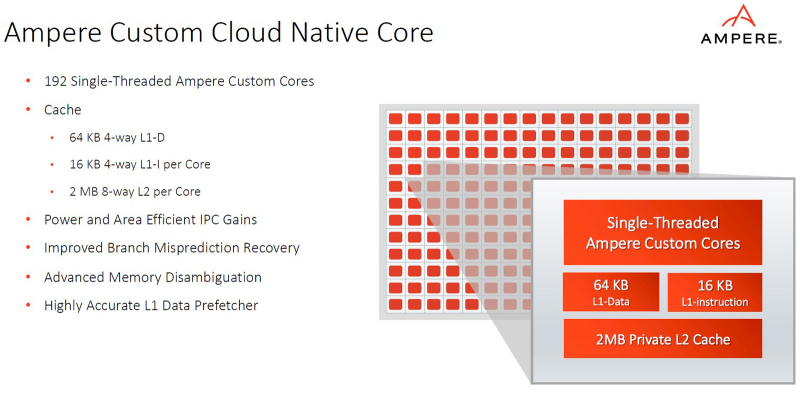

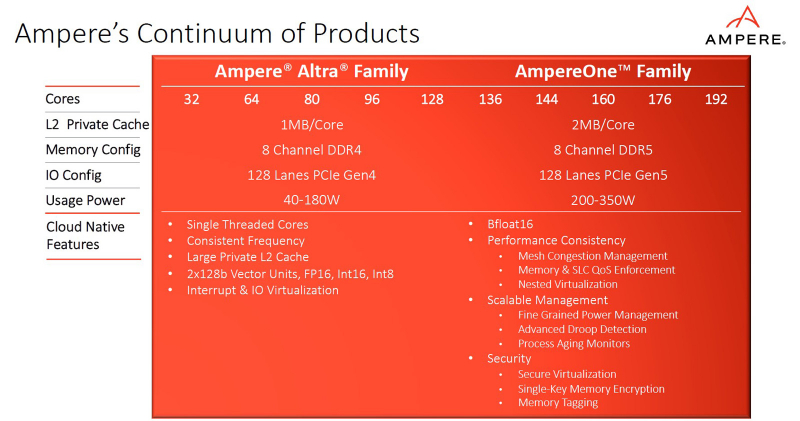

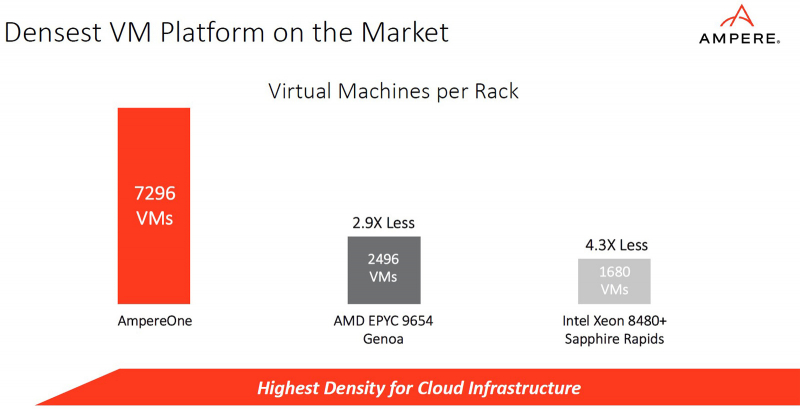

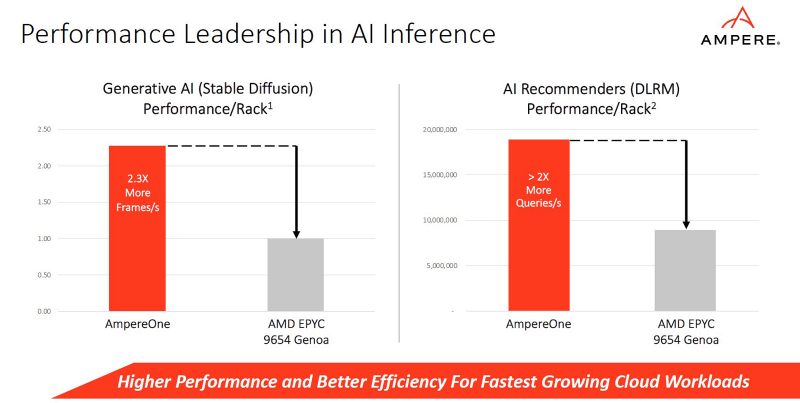

Ampere представила процессоры AmpereOne: до 192 ядер Arm, 8 каналов DDR5 и 128 линий PCIe 5.0Компания Ampere анонсировала процессоры серии AmpereOne, предназначенные для использования в серверах и оборудовании для дата-центров. Утверждается, что по сравнению с изделиями предыдущих поколений — Ampere Altra и Ampere Altra Max — новые чипы обеспечивают более высокие показатели производительности и энергоэффективности, а также обладают улучшенной масштабируемостью. Процессоры AmpereOne основаны на кастомизированных ядрах собственной разработки Ampere с набором инструкций Arm. Задействована чиплетная компоновка. Изготавливаются решения на предприятии TSMC на основе комбинации технологий с нормами 5 и 7 нм.

Источник изображений: Ampere В семейство AmpereOne вошли пять моделей — со 136, 144, 160, 172 и 192 ядрами. Каждое ядро способно обрабатывать один поток инструкций. Объём кеша L2 составляет 2 Мбайт в расчёте на ядро; размер кеша L1 — 16 Кбайт для инструкций и 64 Кбайт для данных. Кроме того, есть 64 Мбайт системного кеша. Тактовая частота достигает 3,0 ГГц. Конструкция AmpereOne включает восемь каналов памяти DDR5 с поддержкой ECC: сервер может быть оборудован 16 слотами DIMM с возможностью использования до 8 Тбайт ОЗУ. Доступны 128 линий PCIe 5.0. Упомянута поддержка Armv8.6+ и SBSA 5. Чипы имеют исполнение FCLGA (5964-Pin). Ampere отмечает, что процессоры AmpereOne ориентированы прежде всего на облачные платформы и среды виртуализации. Они обеспечивают высокую плотность вычислений и возможность формирования виртуальных машин, использующих от одного vCPU. Кроме того, достигается высокая производительность при ИИ-нагрузках (BF16). Заявленное энергопотребление AmpereOne составляет 1,8 Вт в расчёте на ядро, или от 200 до 350 Вт на сокет в зависимости от модификации решения.

16.05.2023 [19:10], Руслан Авдеев

Поллитра воды на полсотни вопросов: ИИ-серверы с ChatGPT потребляют не только много энергии, но и немало воды для охлажденияХотя в генеративных ИИ-моделях вроде GPT-4 или Midjourney отдельные эксперты усматривают много угроз человечеству, далеко не все обращают внимание на важный фактор — не исключено, что скоро ИИ и люди будут конкурировать за обычную пресную воду. Как сообщает The Register, по прогнозам учёных, её будет всё больше требоваться для охлаждения ЦОД. Проблема привлекла внимание учёных Калифорнийского университета в Риверсайде и Техасского университета в Арлингтоне. По оценкам исследователей, обучение языковой модели уровня GPT-3 требует использования около 700 тыс. литров воды — столько тратится на выпуск 320 электромобилей Tesla. Более того, на простой диалог из 20-50 вопросов ChatGPT требуется около 500 мл воды, а с развитием ИИ потребление воды такими системами достигнет огромных масштабов — если заранее не принять меры по оптимизации охлаждения ЦОД.

Источник изображения: Drew Dizzy Graham/unsplash.com При этом эксперты обещают, что к середине века огромные территории в США будут страдать от засухи. Уже сейчас ЦОД крайне неохотно делятся информацией о потреблении воды, при этом используя разные системы подсчёта и, как Google, пытаясь скрыть следы в судебном порядке. В результате учёным приходится при расчётах пользоваться преимущественно косвенными данными. Впрочем, утверждается, что можно повсеместно использовать модель, разработанную SPX Cooling Technologies, и это позволит определить, сколько воды уходить на обучение и эксплуатацию языковых моделей. Но, как считают в Dell'Oro Group, проблема на деле не в ИИ — он не испытывает настоящей жажды. В первую очередь речь идёт о рационализации систем терморегулирования. Даже от того, где находится ЦОД с ИИ, может значительно меняться потребление воды. Многие ЦОД используют не жидкостное охлаждение, а другие варианты. Например, в прошлом месяце Microsoft говорит об использовании систем с нулевым водопотреблением в ЦОД Аризоны — но они потребляют больше энергии. Предлагается немало вариантов — от воздушного до водяного или погружного охлаждения, каждый из которых имеют свои преимущества и недостатки. Впрочем, вендоры вроде Submer и LiquidStack предлагают системы иммерсионного охлаждения, обеспечивающие PUE на уровне менее 1,05, тогда как системы воздушного охлаждения обычно обеспечивают лишь 1,4–1,5.

Источник изображения: redcharlie | @redcharlie1/unsplash.com В научной работе приводятся не только возможные пути оптимизации систем охлаждения, но и рекомендации для того, чтобы ЦОД в принципе выделяли меньше тепла. В частности, речь идёт о том, что дата-центры стоит строить в местах с прохладным климатом вместо жарких азиатских стран, а некоторые задачи можно выполнять во второй половине дня, когда становится прохладнее. Хотя это ограничивает использование солнечных элементов питания, сам собой напрашивается вывод о применении резервных аккумуляторных источников вместо генераторов для накопления энергии днём. Учёные считают, что залогом эффективного использования энергетических систем и охлаждения является большая прозрачность деятельности ЦОД. В Европе, например, пересматривают поправки к Директиве об энергоэффективности, которые заставят отчитываться по многим параметрам всё ЦОД кроме самых мелких. Как заявил один из учёных, «индустрия ЦОД столь скрытна, что иногда трудно получить подходящие данные для построения моделей». Впрочем, учёные опасаются, что у гиперскейлеров может не хватить времени на внедрение качественной отчётности — индустрия ИИ развивается чересчур быстро.

16.05.2023 [09:23], Сергей Карасёв

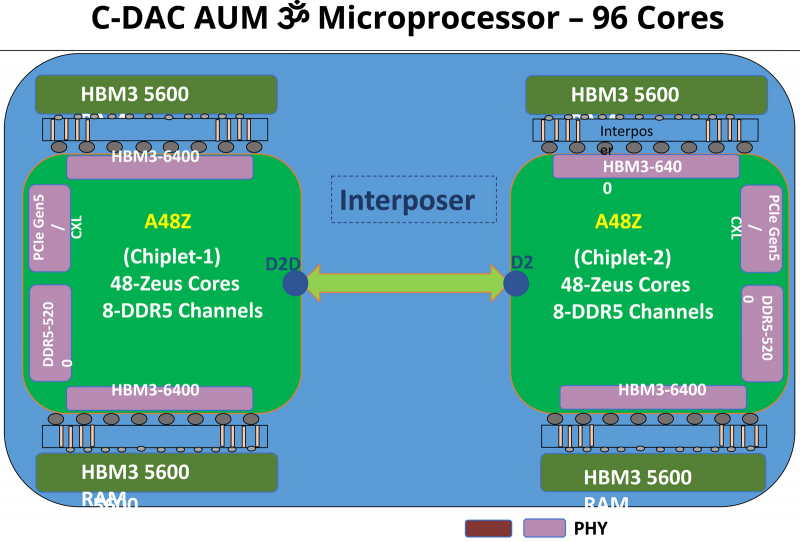

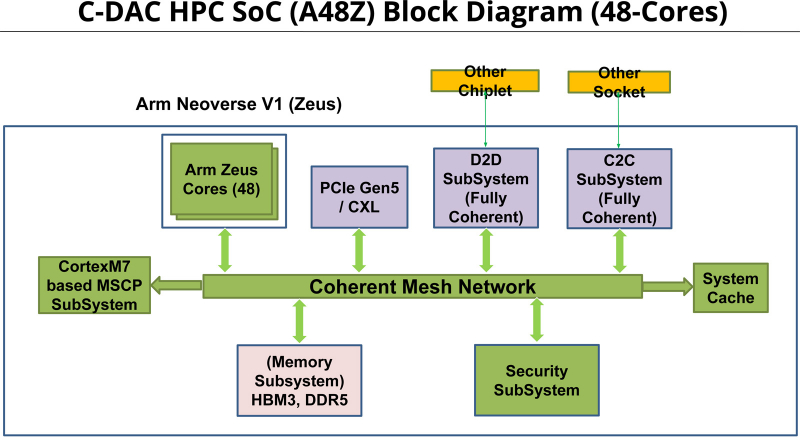

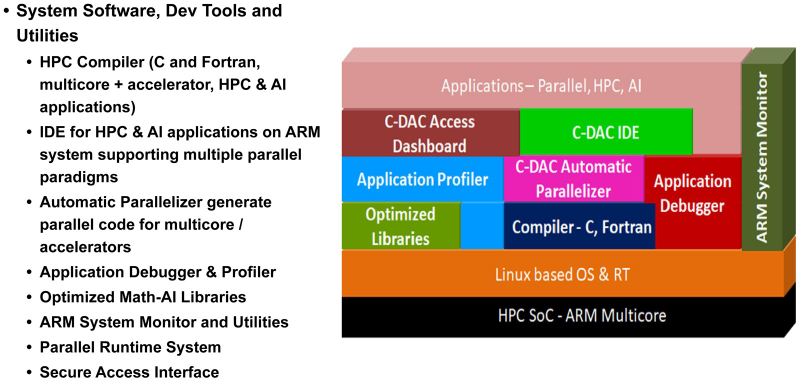

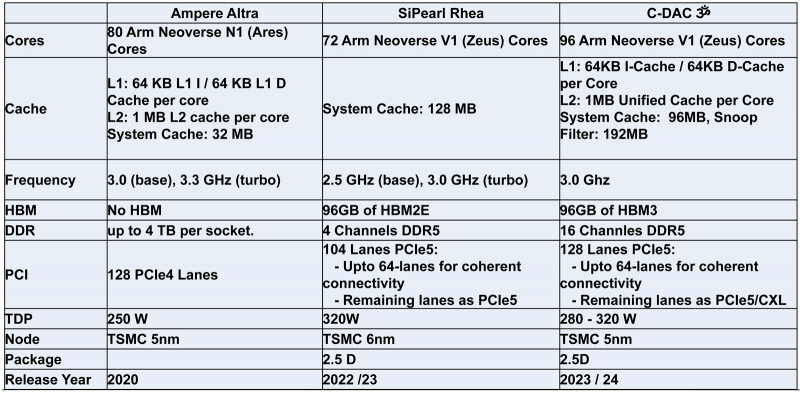

Индия представила свой первый серверный процессор AUM: 96 ядер и 96 Гбайт памяти HBM3Центр развития передовых вычислений (C-DAC) Департамента электроники и информационных технологий Министерства коммуникаций и информационных технологий Индии представил первый в стране процессор для серверов и НРС-систем. Изделие под названием AUM выйдет на коммерческий рынок в текущем или следующем году. Решение имеет чиплетную компоновку на базе двух модулей A48Z, каждый из которых насчитывает 48 вычислительных ядер Zeus с архитектурой Arm. Таким образом, суммарное количество ядер достигает 96. Тактовая частота составляет 3,0 ГГц (до 3,5 ГГц в турбо-режиме); показатель TDP варьируется от 280 до 320 Вт. Новинка будет изготавливаться на предприятии TSMC по 5-нм технологии. Чип содержит 96 Мбайт кеша L2 и 96 Мбайт системного кеша. Изделие получило 96 Гбайт памяти HBM3 и 8-канальный контроллер DDR5-5200; кроме того, имеется доступ к 64 Гбайт памяти HBM3-5600. Таким образом, задействована трёхуровневая подсистема памяти. Упомянуты до 128 линий PCIe 5.0 с поддержкой CXL. Процессор AUM может применяться в двухсокетных серверах. Заявленная производительность превышает 4,6 Тфлопс в расчёте на разъём. Реализованы различные средства обеспечения безопасности, в том числе функция Secure Boot и криптографические алгоритмы.

14.05.2023 [16:10], Владимир Мироненко

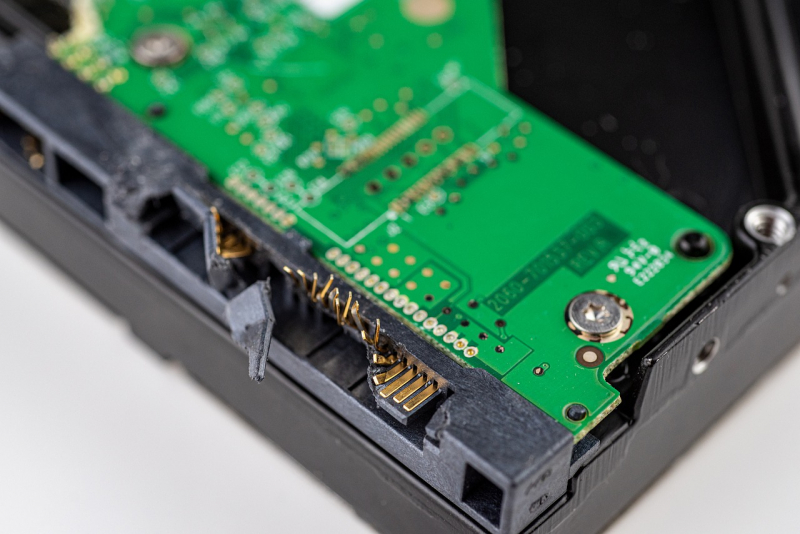

Pure Storage: после 2028 года SSD полностью вытеснят HDD из ЦОДНекоторые эксперты считают, что жизненный цикл жёстких накопителей подходит к концу. В их числе Шон Розмарин (Shawn Rosemarin), вице-президент по исследованиям и разработкам в подразделении по работе с клиентами (Customer Engineering) компании Pure Storage, заявивший, что после 2028 года жёсткие диски больше продаваться не будут из-за их плохой энергоэффективности и ограниченности применения, а также снижения стоимости флеш-накопителей. Розмарин подчеркнул, что главным фактором падения конкурентоспособности жёстких дисков по сравнению с SSD станет высокий расход электроэнергии, а не снижение стоимости SSD или появление DFM ёмкостью 300 Тбайт собственной разработки Pure. Он отметил, что даже новейшие технологии магнитной записи с энергетической поддержкой, позволяющие значительно увеличить плотность записи, не спасут ситуацию. Производители HDD придерживаются другого мнения. Ещё в 2021 году Seagate заявила, что SSD не станут убийцами жёстких дисков. Мнения VAST и Infinidat по этому поводу заметно отличаются. Если VAST считает, что низкий уровень IOPS приведёт к ограничению использования ёмких HDD в хранилищах данных петабайтного масштаба, то Infidat отвечает, что это «должно быть шутка». Согласно оценкам Gartner, к 2026 году на долю SSD придётся 35 % от общего объёма поставок накопителей корпоративного класса (в Эбайт), что это делает маловероятным прогноз Розмарина. «3 % мирового энергопотребления приходится на ЦОД, — приводит слова гендиректора Pure Розмарин. — Примерно треть от этого приходится на хранение. Почти всё это — HDD. Если отказаться от HDD и перейти на флеш-память, мы сможем, по сути, снизить энергопотребление на 80–90 %, увеличив плотность [хранения] на порядок в условиях, когда цены на NAND продолжают падать. Становится очевидным, что HDD уходят в прошлое». Розмарин также отметил проблемы с поставками электроэнергии, доступность которой придётся учитывать при создании или расширении ЦОД — компаниям придётся выбирать между энергоэффективными SSD или ёмкими HDD. Скачок в развитии ИИ-технологий увеличил потребность в хранилищах, добавил Розмарин, что, по его словам, усугубляет проблему с точки зрения того, сколько данных смогут хранить провайдеры в связи с грядущим повышением спроса на электроэнергию. Следует отметить, что Pure Storage является конкурентом производителей жёстких дисков, поэтому заявление её топ-менеджера необходимо оценивать с учётом этого факта. На данный момент массового перехода на флеш-память не наблюдается — ни один из гиперскейлеров пока не объявил о таком шаге. «Если же кто-то из них это сделает, то это будет сигналом того, что Pure Storage не одинока в своём убеждении », — пишет Blocks & Files.

24.04.2023 [22:02], Руслан Авдеев

С заботой о людях и природе: деревянный дата-центр EcoDataCenter 2 поможет создать новые рабочие места и обеспечить продуктами питания жителей ШвецииПринадлежащая шведскому фонду Areim компания EcoDataCentr, занимающаяся строительством и эксплуатацией экобезопасных ЦОД, намерена возвести в шведском Эстерсунде экоустойчивый дата-центр EcoDataCenter 2. Как сообщает HPC Wire, новый кампус предусматривает внедрение «циркулярной» экосистемы, и в числе прочего, обеспечит «симбиоз» с производителями еды. Известно, что оператор уже реализовал проект EcoDataCenter 1, в рамках которого возведён «первый в мире» ЦОД, построенный полностью из дерева и при участии местной рабочей силы — его избыточное тепло используется при выпуске древесных гранул. Впрочем, теперь речь идёт о значительно более сложном «зелёном» проекте. EcoDataCenter 2 расположится в муниципалитете Эстерсунд (Östersund) — известно, что в местных энергосетях циркулирует только электричество из возобновляемых источников. Проект позволит создать 800–1000 рабочих мест, а «зелёная» энергия, помимо прочего, позволит выращивать в этой местности нехарактерные для местного холодного климата продукты питания. В расчёт принимается и то, какие материалы используются или применяются повторно, как организованы трудовые отношения, какая именно энергия потребляется и другие важные аспекты. Ключевым участником процесса стала компания Wa3rm, на основе идей которой будет строиться «циркулярный» бизнес, именно она будет заниматься производством продуктов питания. В компании заявляют, что проект изначально проектируется с прицелом на реализацию «циркулярной» концепции. По словам оператора ЦОД, поскольку большая часть HPC-вычислений мало зависит от временных задержек, размещение ЦОД для таких проектов можно проектировать именно там, где будет обеспечен наиболее высокий уровень экологической эффективности систем. К 2026 году планируется ввести в эксплуатацию первую очередь проекта мощностью 20 МВт, к 2033 году он должен «разрастись» до 150 МВт. Известно, что похожие проекты, предусматривающие выращивание рыб и омаров, уже реализованы в Японии и Норвегии. |

|