Материалы по тегу: облако

|

02.12.2024 [11:28], Сергей Карасёв

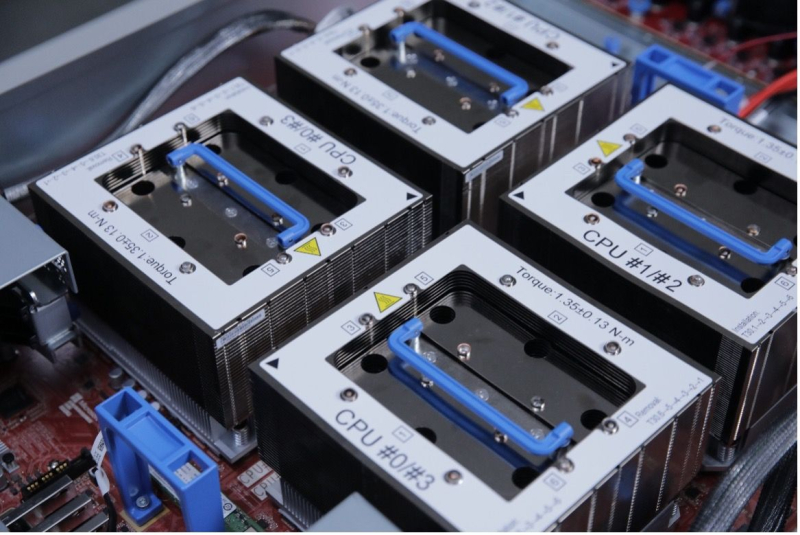

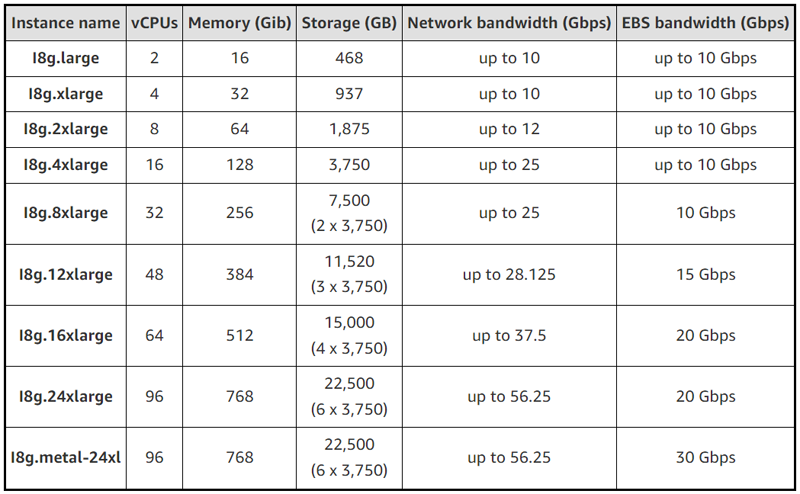

AWS запустила инстансы EC2 I8g с собственными процессорами Graviton4 и накопителями Nitro SSDОблачная платформа Amazon Web Services (AWS) анонсировала инстансы EC2 I8g, оптимизированные для хранения данных. Утверждается, что по сравнению с решениями предыдущего поколения EC2 I4g достигается прирост производительности на операциях хранения в реальном времени до 65 % в расчёте на 1 Гбайт. Инстансы EC2 I8g базируются на фирменных процессорах Graviton4, насчитывающих до 96 ядер Arm. Кроме того, впервые применены накопители AWS Nitro SSD третьего поколения, которые изготавливаются по индивидуальному заказу Amazon. Эти устройства, как утверждается, обеспечивают высокую производительность ввода-вывода, низкую задержку, минимальную изменчивость задержки и безопасность благодаря шифрованию. В зависимости от модификации инстансы EC2 I8g предлагают от 2 до 96 vCPU, а объём памяти варьируется от 16 до 768 ГиБ. Вместимость хранилища составляет от 468 Гбайт до 22,5 Тбайт. Пропускная способность сетевого подключения находится в диапазоне от 10 Гбит/с до 56,25 Гбит/с, пропускная способность EBS-томов — от 10 до 30 Гбит/с.

Источник изображения: AWS Отмечается, что инстансы I8g предназначены для рабочих нагрузок с интенсивными IO-операциями, требующими доступа к информации с минимальными задержками. Это могут быть различные базы данных, включая платформы реального времени (MySQL, PostgreSQL, Aerospike, Apache Druid, MongoDB), а также аналитика реального времени. Задействована система AWS Nitro, которая переносит функции виртуализации, хранения и сетевые операции на выделенное оборудование и ПО для повышения производительности и улучшения безопасности. Говорится о совместимости с Amazon Linux 2023, Amazon Linux 2, CentOS Stream 8 или новее, Ubuntu 18.04 или новее, SUSE 15 SP2 или новее, Debian 11 или новее, Red Hat Enterprise 8.2 или новее, CentOS 8.2 или новее, FreeBSD 13 или новее, Rocky Linux 8.4 или новее, Alma Linux 8.4 или новее и Alpine Linux 3.12.7 или новее.

01.12.2024 [11:08], Сергей Карасёв

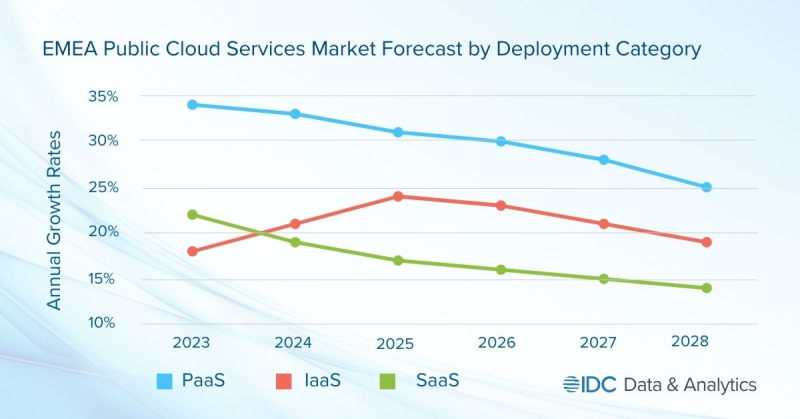

Объём рынка публичных облаков в регионе EMEA в 2024 году превысит $200 млрдКомпания International Data Corporation (IDC) обнародовала прогноз по рынку публичных облачных услуг в регионе EMEA, который включает Европу, Ближний Восток и Африку. Отрасль демонстрирует стремительный рост, что объясняется быстрым внедрением ИИ, в то числе сервисов генеративного ИИ, а также расширением инфраструктур ведущих облачных провайдеров. По оценкам, в 2024 году объём отрасли превысит $200 млрд, достигнув приблизительно $203 млрд. Аналитики IDC учитывают затраты в области публичных услуг SaaS, PaaS и IaaS. Первый из этих сегментов, который включает SaaS-приложения и SaaS-SIS (SaaS в области системных инфраструктур), обеспечивает наибольшую выручку — 64,4 % в общем объёме рынка ЕМЕА. Отмечается, что из-за своего размера и зрелости SaaS демонстрирует самые медленные темпы роста среди облачных услуг всех типов. Наиболее высокий показатель CAGR (среднегодовой темп роста в сложных процентах) прогнозируется в категории PaaS — 29,3 % в период 2023–2028 гг. В сегменте IaaS это значение ожидается на уровне 21,6 %. С субрегиональной точки зрения Западная Европа доминирует на рынке EMEA с долей около 80 % в общем объёме рынка. Далее следуют Ближний Восток и Африка (MEA), а также Центральная и Восточная Европа (CEE). Основные инвестиции в сегменте публичных облаков приходятся на Германию, Великобританию, Францию и Италию. Ключевыми игроками в регионе являются Google, Amazon, Microsoft и Oracle. Аналитики IDC считают, что глобальные технологические компании продолжат вкладывать средства в ИИ, что обеспечит дальнейший рост рынка. Величина CAGR в регионе EMEA прогнозируется на уровне 20,0 %: таким образом, к 2028-му затраты могут подняться до $415,1 млрд.

30.11.2024 [22:26], Владимир Мироненко

HPE VM Essentials упростит работу в облаке HPE GreenLake и может использоваться на сторонних платформах

hpe

hpe greenlake

software

виртуализация

гибридное облако

конфиденциальность

миграция

облако

частное облако

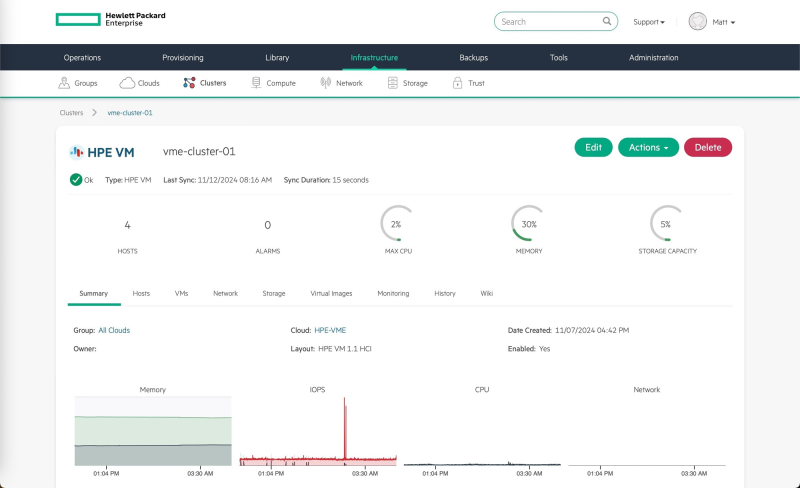

Компания Hewlett Packard Enterprise (HPE) объявила о ключевых усовершенствованиях в облаке HPE GreenLake, благодаря которым упрощается управление в сложных, гетерогенных гибридных ИТ-средах. В числе представленных HPE новинок — VM Essentials, ПО для управления виртуальными машинами, которое также можно использовать для управления виртуальными средами на основе KVM и VMware. Гипервизор HPE VM Essentials (HPE VME) поддерживает ведущие протоколы хранения, распределённое размещение рабочих нагрузок, высокую доступность, живую миграцию и интегрированную защиту данных. Благодаря усовершенствованию облака HPE GreenLake и ПО HPE VM Essentials предприятия могут пятикратно снизить совокупную стоимость владения, утверждает компания. Сообщается, что HPE VM Essentials снижает затраты для клиентов за счёт экономически эффективного ценообразования на сокет и встроенной поддержки обнаружения существующих виртуальных машин, а также предоставления виртуальных машин как услуги. ПО может интегрировать существующие кластеры гипервизоров клиентов для обеспечения управления и контроля над виртуальными машинами, в том числе на базе KVM, с помощью одного простого интерфейса, а также базового преобразования образов ВМ в HPE VM Essentials. HPE VM Essentials предлагается как часть HPE Private Cloud и как отдельная программа.

Источник изображений: HPE Для ревиртуализации и управления HPE использует гибридное облачное решение компании Morpheus Data, которую HPE приобрела в прошлом году. HPE отметила, что поглощение Morpheus Data позволило ещё больше унифицировать и упростить ИТ-операции для клиентов в облаке HPE GreenLake. HPE VM Essentials — это первый шаг к использованию Morpheus во всём портфеле решений HPE, сообщила она, добавив, что клиенты могут гибко управлять существующими виртуализированными рабочими нагрузками или переходить на гипервизор HPE VME с простым лицензированием виртуальных машин в обоих стеках. «Теперь, независимо от того, где работает VM Essentials, будь то частное облако, наше оборудование или стороннее оборудование, благодаря Morpheus мы можем позволить нашим клиентам управлять всеми этими виртуальными машинами в единой плоскости управления с помощью Morpheus Data», — заявил Ханг Тан (Hang Tan), главный операционный директор подразделения Hybrid Cloud. VM Essentials поддерживает собственное ПО HPE, включая Zerto, OpsRamp и Cloudphysics, а также внешние инструменты резервного копирования и восстановления от Cohesity и Commwall. С запуском VM Essentials компания HPE ориентируется на клиентов, недовольных повышением цен VMware. Почти половина из них сообщила об удвоении цен, а 15 % — о десятикратном увеличении. Другие компании, такие как Nutanix и Veeam, также ранее расширили свои портфели, чтобы привлечь клиентов VMware. При этом, как сообщает ITPro, Ульрих Зайбольд (Ulrich Seibold), вице-президент по глобальным продажам партнеров и поставщиков услуг HPE GreenLake, заявил следующее: «Мы не позиционируем VM Essentials как инструмент или ПО, конкурирующее с Broadcom. Во все наши продукты включены сервисы Broadcom, и у нас с ними прочные партнёрские отношения. Но могут быть области или среды, где у партнёров или клиентов есть бюджетные ограничения или они не хотят получать полную скорость — для них вполне достаточно виртуальной машины». Сообщается, что HPE VM Essentials в качестве отдельного приложения станет общедоступным в декабре. Оно будет сертифицировано для работы с последними версиями HPE ProLiant Compute и HPE Alletra Storage. Ожидается, что HPE VM Essentials с HPE Private Cloud Business Edition станет общедоступным весной 2025 года. HPE также представила HPE Private Cloud Enterprise Disconnected и HPE Alletra Storage MP Disconnected — решения для изолированного частного облака и блочных СХД, которые обеспечивают облачный опыт с автономным управлением. Для клиентов GreenLake Cloud это означает возможность его использования в изолированном режиме без подключения к интернету. HPE стремится удовлетворить повышенные требования организаций к безопасности. Крупные клиенты получат индивидуальные предложения для особых требований. А авторизованные партнёры HPE Partner Ready Vantage смогут предоставлять услуги суверенного частного облака на базе HPE GreenLake. В Европе партнёры смогут предлагать возможности суверенного облака, соответствующие местным, региональным и отраслевым нормам.

24.11.2024 [11:43], Сергей Карасёв

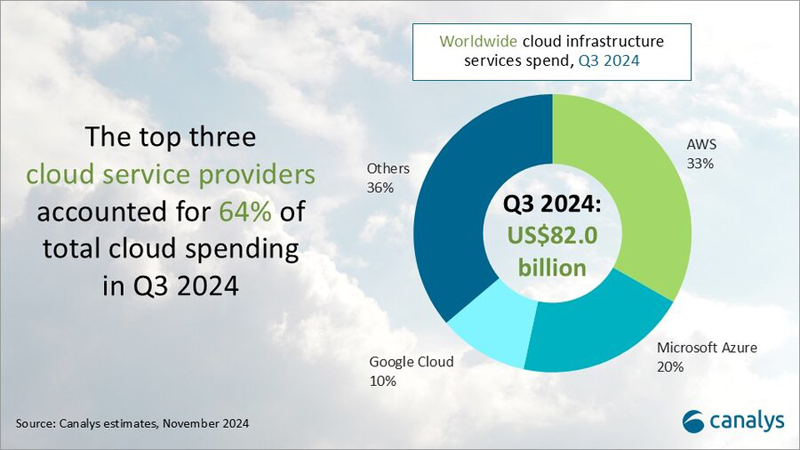

Квартальная выручка на рынке облачных инфраструктур подскочила на 21 %, превысив $80 млрдКомпания Canalys подвела итоги исследования глобального рынка облачных инфраструктур в III квартале 2024 года. Расходы в данной области продолжают быстро увеличиваться на фоне стремительного внедрения ИИ и расширения мощностей гиперскейлеров. В период с июля по сентябрь включительно объём отрасли достиг $82 млрд. Это на 21 % больше результата за III четверть прошлого года. Причём на трёх ведущих поставщиков облачных услуг — Amazon Web Services (AWS), Microsoft Azure и Google Cloud — пришлось 64 % от суммарных затрат, или приблизительно $52,5 млрд.

Источник изображения: Canalys Крупнейшим игроком на мировом рынке остаётся AWS с долей 33 % по итогам III квартала 2024 года: компания получила примерно $27,1 млрд. При этом в годовом исчислении выручка поднялась на 19 %. AWS объявила о планах по дальнейшему увеличению инвестиций в облачном сегменте: прогнозируемые расходы составят около $75 млрд в 2024 году. Средства пойдут в первую очередь на расширение технологической инфраструктуры для удовлетворения растущего спроса на услуги ИИ. На втором месте в рейтинге находится Microsoft Azure с 20 % отрасли, что соответствует $16,4 млрд. Редмондский гигант нарастил показатель на треть (33 %) по отношению к III четверти прошлого года. Существенный рост обусловлен востребованностью сервисов в сегменте ИИ. Замыкает тройку Google Cloud с 10 % ($8,2 млрд) и ростом на 36 % год к году. Таким образом, Google показала самую существенную прибавку среди лидеров. Компания, как отмечается, активно разрабатывает новые сценарии применения ИИ. Все три облачных гиперскейлера сообщили о положительной отдаче от инвестиций в сервисы ИИ, которые начали вносить значительный вклад в общую эффективность бизнеса.

22.11.2024 [14:47], Руслан Авдеев

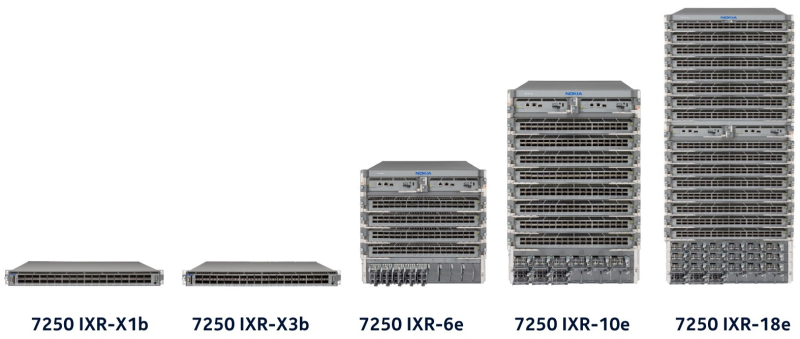

Nokia подписала пятилетнее соглашение по переводу ЦОД Microsoft Azure со 100GbE на 400GbEФинская Nokia расширила соглашение о поставке ЦОД Microsoft Azure маршрутизаторов и коммутаторов. По данным пресс-службы Nokia, соглашение будет действительно в течение пяти лет. Оборудование Nokia, по словам самой компании, повысит масштабируемость и надёжность ЦОД облака Azure по всему миру. Финансовые условия соглашения пока не разглашаются, но, по данным Nokia, благодаря сотрудничеству компаний финский вендор сможет расширить присутствие на рынках более чем на 30 стран и усилить свои позиции в качестве стратегического поставщика для облачной инфраструктуры Microsoft. На уже существующих объектах Azure будет поддерживаться миграция внутренних сетей со 100GbE на 400GbE. Вендор отмечает, что компании, как и ранее, сотрудничают в работе над open source ПО SONiC для маршрутизаторов и коммутаторов ЦОД. В Nokia заявили, что с февраля 2025 года начнёт внедрение платформы 7250 IXR-10e для поддержки многотерабитных сетей в дата-центров Microsoft. Маршрутизатор и коммутаторы, использующие платформу SONiC, будут внедряться на новых площадках ЦОД, что поможет Microsoft справиться с растущим требованиям к объёмам трафика в ближайшие годы. В Nokia заявляют, что новая фаза сотрудничества повысит масштабируемость и надёжность дата-центров Microsoft Azure по всему миру. По словам представителя Microsoft, в последние шесть лет компания сотрудничала с инженерами Nokia для разработки маршрутизаторов на базе SONiC для содействия экспансии гиперскейлера. В последние месяцы Nokia заявила о наличии амбиций в индустрии ЦОД. В прошлом месяце глава компании Пекка Лундмарк (Pekka Lundmark) заявил, что вендор видит «важную возможность» расширить присутствие на рынке дата-центров. Также в минувшем сентябре Nokia анонсировала запуск платформы автоматизации ЦОД — Event-Driven Automation (EDA).

22.11.2024 [10:15], Сергей Карасёв

Oracle объявила о доступности облачного ИИ-суперкомпьютера из 65 тыс. NVIDIA H200Корпорация Oracle сообщила о доступности облачного суперкластера с ускорителями NVIDIA H200, предназначенного для ресурсоёмких ИИ-нагрузок, включая обучение больших языковых моделей (LLM). Арендовать мощности системы можно по цене от $10 в час в расчёте на GPU. Кластер масштабируется до 65 536 ускорителей. В максимальной конфигурации теоретическое пиковое быстродействие достигает 260 Эфлопс на операциях FP8, что более чем в четыре раза превышает показатели систем предыдущего поколения. Утверждается, что на сегодняшний день это самый высокопроизводительный облачный ИИ-суперкомпьютер, доступный в облаке. Сейчас компания готовится к созданию облачного кластера из 131 тыс. NVIDIA B200. Новые инстансы получили обозначение BM.GPU.H200.8. Каждая виртуальная машина типа Bare Metal (без гипервизора) содержит восемь изделий NVIDIA H200 (141 Гбайт памяти HBM3e), объединённых посредством NVIDIA NVLink. Задействованы два процессора Intel Xeon Platinum 8480+ поколения Sapphire Rapids (56C/112T; до 3,8 ГГц; 350 Вт). Объём системной памяти DDR5 составляет 3 Тбайт. В состав локального хранилища входят восемь NVMe SSD вместимостью 3,84 Тбайт каждый.

Источник изображения: NVIDIA Кластер использует кастомную RoCE-сеть на базе NVIDIA ConnectX-7 с суммарной пропускной способностью 3200 Гбит/с (восемь каналов по 400 Гбит/с) на узел. Инстансы включают frontend-сеть с пропускной способностью 200 Гбит/с. По данным Oracle, каждый инстанс в суперкластере содержит на 76 % больше памяти HBM по сравнению с виртуальными машинами на основе NVIDIA H100, а пропускная способность памяти увеличена на 40 %. Таким образом, производительность инференса выросла в 1,9 раза.

20.11.2024 [17:16], Руслан Авдеев

AWS предоставит IBM доступ к ИИ-ускорителям на $475 миллионовAWS близка к заключению сделки с компанией IBM на сумму $475 млн. По данным Business Insider, компания готовится предоставить компании IBM доступ к своим облачным ИИ-решениям. Компании ведут переговоры о пятилетнем использовании IBM ИИ-ускорителей в облаке Amazon. В частности, IBM планирует задействовать инстансы EC2 с чипами NVIDIA, что подтверждается одним из внутренних документов Amazon. По некоторым данным, сотрудничество уже началось — IBM начала обучать отдельные модели на указанных системах с использованием платформы AWS SageMaker. Однако переговоры ещё продолжаются, и подписание окончательного соглашения пока не гарантировано. Примечательно, что IBM имеет собственное облако, где так же предоставляет доступ к ускорителям. Однако, по оценкам экспертов, её доля на мировом облачном рынке не превышает 10 %. Ранее, в 2024 году, IBM анонсировала увеличение использования сервисов AWS для своей платформы Watson AI. Компании намерены интегрировать IBM watsonx.governance с платформой Amazon SageMaker, чтобы помочь клиентам эффективно управлять рисками, связанными с ИИ-моделями, и упростить их использование.

Источник изображения: AWS Amazon активно продвигает чипы собственной разработки — Inferentia и Trainium, а ранее в этом месяце пообещала предоставить «кредиты» исследователям в сфере ИИ на сумму $110 млн для доступа к свои чипам в рамках программы Build on Trainium. Пока неизвестно, намерена ли IBM применять чипы AWS или отдаст предпочтение более популярным решениям, таким как продукты NVIDIA.

20.11.2024 [13:04], Руслан Авдеев

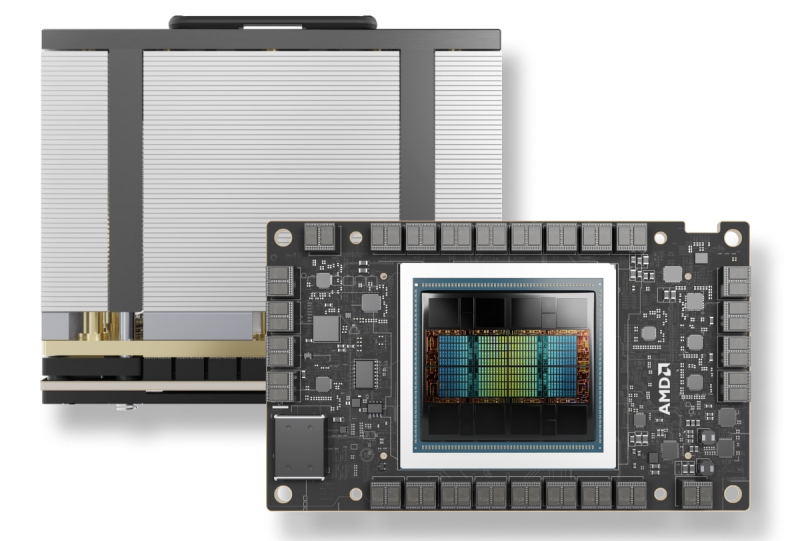

IBM и AMD расширяют сотрудничество: Instinct MI300X появится в облаке IBM CloudКомпания IBM объявила о расширении сотрудничества с AMD для предоставления ускорителей Instinct MI300X в формате «ускорители как услуга» (Accelerators-as-a-Service). По словам IBM, новое решение расширяет возможности и энергоэффективность генеративных ИИ-моделей и HPC-приложений. AMD Instinct MI300X станут доступны в IBM watsonx, а также будут поддерживаться в Red Hat Enterprise Linux AI. Они дополнят портфолио IBM Cloud, уже включающее Intel Gaudi 3 и NVIDIA H100. Ускоритель AMD Instinct MI300X оснащён 192 Гбайт памяти HBM3. И относительно малое количество ускорителей способно обеспечить работу больших ИИ-моделей, что позволяет снизить затраты с сохранением производительности и масштабируемости. Ускорители будут доступны в составе виртуальных серверов и частных виртуальных облаков, а также в контейнеризированных средах IBM Cloud Kubernetes Service и IBM Red Hat OpenShift. Кроме того, для MI300X будут доступны LLM Granite и инструмент InstructLab. Речь идёт в том числе об интеграции программных решений IBM с ПО AMD ROCm. По словам компании, предложенные решения обеспечит клиентов гибкой, безопасной, высокопроизводительной и масштабируемой средой для рабочих нагрузок ИИ. AMD Instinct MI300X станут доступны пользователям IBM Cloud в I половине 2025 года.

20.11.2024 [10:56], Сергей Карасёв

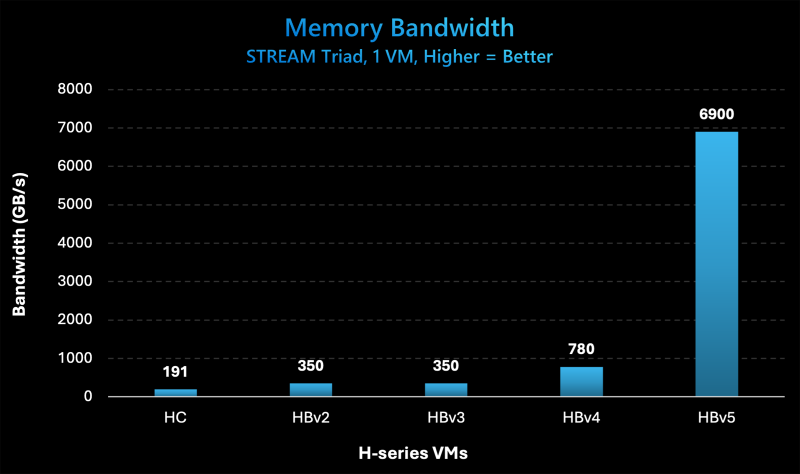

Microsoft представила инстансы Azure HBv5 на основе уникальных чипов AMD EPYC 9V64H с памятью HBM3Компания Microsoft на ежегодной конференции Ignite для разработчиков, IT-специалистов и партнёров анонсировала облачные инстансы Azure HBv5 для HPC-задач, которые предъявляют наиболее высокие требования к пропускной способности памяти. Новые виртуальные машины оптимизированы для таких приложений, как вычислительная гидродинамика, автомобильное и аэрокосмическое моделирование, прогнозирование погоды, исследования в области энергетики, автоматизированное проектирование и пр. Особенность Azure HBv5 заключается в использовании уникальных процессоров AMD EPYC 9V64H (поколения Genoa). Эти чипы насчитывают 88 вычислительных ядер Zen4, тактовая частота которых достигает 4 ГГц. Ближайшим родственником является изделие EPYC 9634, которое содержит 84 ядра (168 потоков) и функционирует на частоте до 3,7 ГГц. По данным ресурса ComputerBase.de, чип EPYC 9V64H также фигурирует под именем Instinct MI300C: по сути, это процессор EPYC, дополненный памятью HBM3. При этом клиентам предоставляется возможность кастомизации характеристик. Отметим, что ранее x86-процессоры с набортной памятью HBM2e были доступны в серии Intel Max (Xeon поколения Sapphire Rapids). Каждый инстанс Azure HBv5 объединяет четыре процессора EPYC 9V64H, что в сумме даёт 352 ядра. Система предоставляет доступ к 450 Гбайт памяти HBM3, пропускная способность которой достигает 6,9 Тбайт/с. Задействован интерконнект NVIDIA Quantum-2 InfiniBand со скоростью передачи данных до 200 Гбит/с в расчёте на CPU. Применены сетевые адаптеры Azure Boost NIC второго поколения, благодаря которым пропускная способность сети Azure Accelerated Networking находится на уровне 160 Гбит/с. Для локального хранилища на основе NVMe SSD заявлена скорость чтения информации до 50 Гбайт/с и скорость записи до 30 Гбайт/с. Отмечается, что по показателю пропускной способности памяти виртуальные машины Azure HBv5 примерно в 8 раз превосходят новейшие альтернативы bare-metal и cloud, в 20 раз опережают инстансы Azure HBv3 и Azure HBv2 (на базе EPYC Milan-X и EPYC Rome) и в 35 раз обходят HPC-серверы возрастом 4–5 лет, жизненный цикл которых приближается к завершению. Машины Azure HBv5 станут доступны в I половине 2025 года.

20.11.2024 [01:40], Владимир Мироненко

Microsoft представила кастомные чипы Azure Boost DPU и Integrated HSM, уникальный AMD EPYC 9V64H с HBM и собственный вариант NVIDIA GB200 NVL72

amd

azure arc

azure stack

dpu

epyc

gb200

hardware

hbm

hpc

microsoft

microsoft azure

nvidia

гибридное облако

ии

информационная безопасность

облако

ускоритель

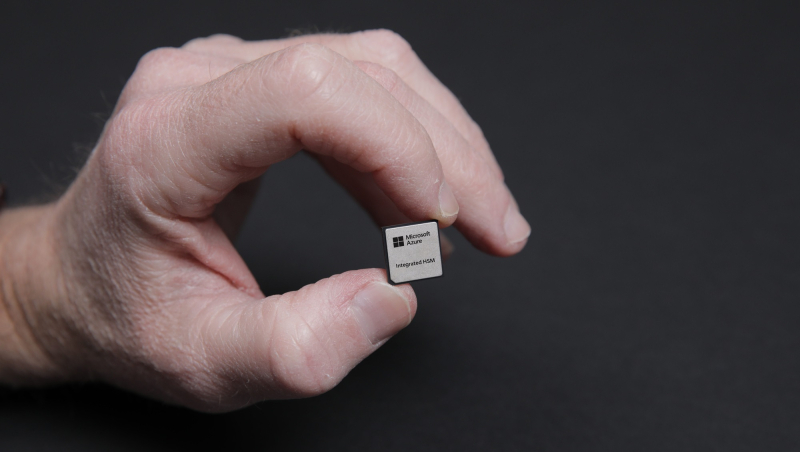

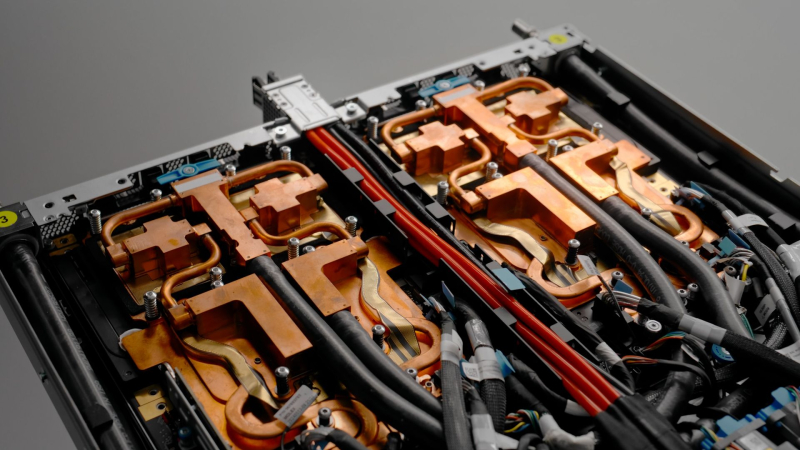

Microsoft представила на конференции Microsoft Ignite новые специализированные чипы Azure Boost DPU и Azure integrated Hardware Security Module (HSM), предназначенные для использования в ЦОД с целью поддержки рабочих нагрузок в облаке Azure и повышения безопасности.

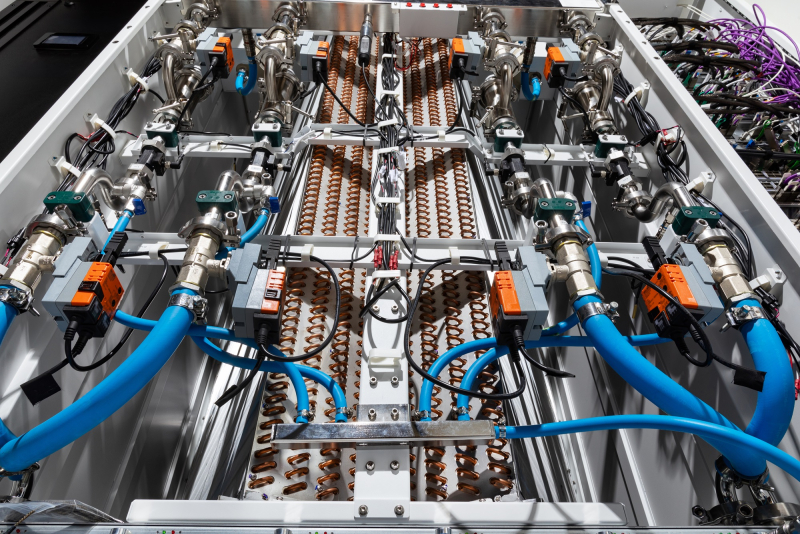

Источник изображений: Microsoft Чтобы снизить зависимость от поставок чипов сторонних компаний, Microsoft занимается разработкой собственных решений для ЦОД. Например, на прошлогодней конференции Microsoft Ignite компания представила Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100 собственной разработки. Azure Boost DPU включает специализированные ускорители для работы с сетью и хранилищем, а также предлагает функции безопасности. Так, скорость работы с хранилищем у будущих инстансов Azure будет вчетверо выше, чем у нынешних, а энергоэффективность при этом вырастет втрое. Не вызывает сомнений, что в разработке Azure Boost DPU участвовали инженеры Fungible, производителя DPU, который Microsoft приобрела в декабре прошлого года. Как отмечает TechCrunch, в последние годы популярность DPU резко увеличилась. AWS разработала уже несколько поколений Nitro, Google совместно с Intel создала IPU, AMD предлагает DPU Pensando, а NVIDIA — BlueField. Есть и другие нишевые игроки. Согласно оценкам Allied Analytics, рынок чипов DPU может составить к 2031 году $5,5 млрд. Ещё один кастомный чип — Azure integrated Hardware Security Module (HSM) — отвечает за хранение цифровых криптографических подписей и ключей шифрования в защищённом модуле «без ущерба для производительности или увеличения задержки». «Azure Integrated HSM будет устанавливаться на каждом новом сервере в ЦОД Microsoft, начиная со следующего года, чтобы повысить защиту всего парка оборудования Azure как для конфиденциальных, так и для общих рабочих нагрузок», — заявила Microsoft. Azure Integrated HSM работает со всем стеком Azure, обеспечивая сквозную безопасность и защиту. Microsoft также объявила, что задействует ускорители NVIDIA Blackwell и кастомные серверные процессоры AMD EPYC. Так, инстансы Azure ND GB200 v6 будут использовать суперускорители NVIDIA GB200 NVL 72 в собственном исполнении Microsoft, а интерконнект Quantum InfiniBand позволит объединить десятки тысяч ускорителей Blackwell. Компания стремительно наращивает закупки этих систем. А инстансы Azure HBv5 получат уникальные 88-ядерные AMD EPYC 9V64H с памятью HBM, которые будут доступны только в облаке Azure. Каждый инстанс включает четыре таких CPU и до 450 Гбайт памяти с агрегированной пропускной способностью 6,9 Тбайт/с. Кроме того, Microsoft анонсировала новое решение Azure Local, которое заменит семейство Azure Stack. Azure Local — это облачная гибридная инфраструктурная платформа, поддерживаемая Azure Arc, которая объединяет локальные среды с «большим» облаком Azure. По словам компании, клиенты получат обновление до Azure Local в автоматическом режиме. Наконец, Microsoft анонсировала новые возможности в Azure AI Foundry, новой «унифицированной» платформе приложений ИИ, где организации смогут проектировать, настраивать и управлять своими приложениями и агентами ИИ. В числе новых опций — Azure AI Foundry SDK (пока в виде превью). |

|