Материалы по тегу: облако

|

10.12.2024 [15:21], Владимир Мироненко

Спрос на ИИ-ускорители в облаке Oracle вырос за квартал на 336 %, а новым крупным клиентом стала Meta✴Американская корпорация Oracle сообщила результаты работы во II квартале 2025 финансового года, закончившемся 30 ноября 2024 года. Результаты и прогноз на текущий квартал оказались ниже ожиданий аналитиков Уолл-стрит и инвесторов, в связи с чем акции корпорации упали в понедельник в ходе расширенных торгов на 7 %. Выручка Oracle составила $14,06 млрд, превысив результат аналогичного финансового квартала годом ранее на 9 %, а также консенсус-прогноз аналитиков, опрошенных LSEG, в размере $14,1 млрд. Вместе с тем скорректированная прибыль на акцию (non-GAAP), составившая $1,47 и превысившая прошлогодний результат на 10 %, оказалась ниже ожиданий Уолл-стрит в размере $1,48 на акцию. Чистая прибыль (GAAP) увеличилась на 26 % до $3,15 млрд, или $1,10 на акцию, с $2,5 млрд, или $0,89 на акцию годом ранее. Выручка в сфере облачных сервисов и поддержки Oracle выросла по сравнению с прошлым годом на 12 % до $10,81 млрд, что составляет 77 % от общей выручки корпорации. Выручка от лицензирования облачных и локальных продуктов увеличилась всего на 1 % до $1,2 млрд. Вместе с тем упали продажи оборудования — на 4 % год к году до $728 млн, и сократилась выручка от сервисов — на 3 % до $1,33 млрд.

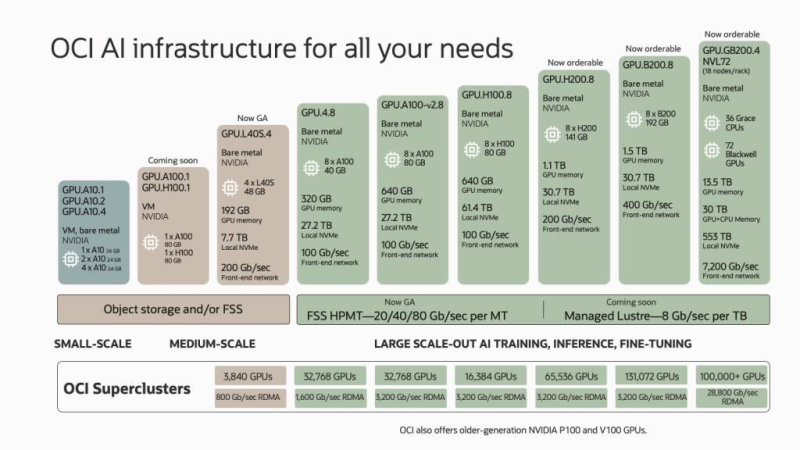

Источник изображения: Oracle Генеральный директор Oracle Сафра Кац (Safra Catz) заявила в ходе отчёта, что рекордный спрос на ИИ привёл к росту выручки Oracle Cloud Infrastructure во II квартале на 52 %, что намного выше темпов роста любого из гиперскейлеров. «Рост в сегменте ИИ нашего инфраструктурного бизнеса был необычайным — потребление GPU выросло на 336 % за квартал — и мы развернули самый большой и быстрый в мире облачный ИИ-суперкомпьютер из 65 тыс. ускорителей NVIDIA H200», — сообщила она, добавив, что в этом финансовом году общий доход Oracle Cloud должен превысить $25 млрд. Oracle заявила, что только что подписала соглашение с Meta✴, позволяющее последней использовать её инфраструктуру для работы в различных проектах, связанных с семейством больших языковых моделей Llama. Одним из ключевых заказчиков ИИ-ускорителей в облаке Oracle также являются Microsoft с OpenAI. «Oracle Cloud Infrastructure обучает несколько важнейших в мире моделей генеративного ИИ, поскольку мы быстрее и дешевле других облаков», — указал основатель и главный технический директор Oracle Ларри Эллисон (Larry Ellison) в своем заявлении. В III квартале 2025 финансового года Oracle ожидает роста выручки на 7–9 % — около $14,3 млрд в средней точке, что ниже прогноза Уолл-стрит в размере $14,65 млрд (согласно LSEG). Прогноз по скорректированной прибыли Oracle находится в пределах от $1,50 до $1,54 на акцию. Аналитики прогнозируют прибыль на акцию в размере $1,57. В сентябре Oracle повысила прогноз выручки на 2026 финансовый год до $66 млрд, что примерно на $1,5 млрд больше, чем ожидают аналитики. Также Oracle тогда объявила, что ее облачное подразделение начнёт принимать заказы клиентов на вычислительные кластеры из более чем 131 тыс. ускорителей NVIDIA Blackwell.

10.12.2024 [12:19], Руслан Авдеев

Запас карман не тянет: Huawei получила более 2,5 дециллионов IPv6-адресовКомпания Huawei получила в своё распоряжение 2 596 148 429 267 413 814 265 248 164 610 048 адресов IPv6 — более 2,5 дециллионов (один дециллион — 1033). Столько выделил китайскому техногиганту азиатский интернет-регистратор Asia Pacific Network Information Center (APNIC), сообщает The Register. Это своего рода рекорд для APNIC. Для удовлетворения потребностей Huawei регистратор обратился к организации Internet Assigned Numbers Authority (IANA), контролирующей распределение адресов по всему миру. Для удовлетворения запроса APNIC запросила второй блок /12. Он состоит из более 83 дециллионов адресов. Впрочем, на долю Huawei приходится лишь подмножество — блок /17. Всего пространство IPv6 вмещает более 340 ундециллионов адресов (340∙1036), но многие зарезервированы или не могут использоваться по разным причинам. Хотя выделенное Huawei количество адресов выглядит невероятно большим, но в общем объёме адресного пространства оно практически теряется. Конечно, у компании вряд ли когда-нибудь будет такое количество устройств для подключения. Впрочем, даже если из общего числа будут использоваться далеко не все, можно предположить, что у компании большие планы. По данным APNIC, в Huawei намерены использовать выделенные IPv6 для «глобального внедрения облачных сервисов и CDN».

Истчоник изображения: engin akyurt/unsplash.com Сейчас Китай активно продвигает использование устройств Интернета вещей. Пара миллиардов из них уже функционирует, а в ближайшие годы их число должно вырасти до 30 млрд. Huawei Cloud управляет 33 облачными регионами, поэтому в его распоряжении имеется немало физических устройств и виртуальных машин. Впрочем, имеющихся в запасе компании адресных ресурсов теперь с лихвой хватит на покрытие её потребностей. Фактически даже если бы каждое интернет-устройство на Земле получило бы адрес IPv6, Huawei не смогла бы потратить и малой доли своих невообразимых ресурсов. Примечательно, что буквально в ноябре главный научный сотрудник APNIC (Asia Pacific Network Information Centre) Джефф Хьюстон (Geoff Huston) заявил, что перспективы перехода на протокол IPv6 не особенно привлекательны из-за меняющейся структуры сети. По словам эксперта, переход от IPv4 к IPv6 не обеспечит принципиально новых функциональных возможностей. Однако некоторые всё равно запасаются адресами. Так, в октябре прошлого года американский регистратор ARIN выделил банку Capital One блок 2630::/16. Банк получил вдвое больше адресов, чем Huawei, отмечает The Register.

09.12.2024 [15:02], Руслан Авдеев

На пять лет позже и впятеро дороже: внедрение ERP Oracle обойдётся Бирмингему в £108 млн и закончится в 2026 годуКрупнейшему в Европе муниципалитету Бирмингема катастрофическая замена ERP SAP на ERP Oracle в конечном итоге обойдётся в £108 млн ($137 млн). Это впятеро превышает сумму, которую планировалось заплатить изначально, не говоря уже о задержке с внедрением на пять лет (2018–2026 гг.), напоминает The Register. По иронии судьбы переход на систему управления персоналом и финансами Oracle Fusion был затеян в попытке сэкономить средства, отказавшись от менее эффективной в теории платформы SAP, работавшей с 1999 года. В результате оказалось, что городской совет практически потерял возможность работы с финансовой документацией, в том числе выявлять возможные финансовые махинации, а расходы на миграцию оказались кратно выше изначальных. Так, с 2018 года затраты на внедрение ПО Oracle в Бирмингеме уже составили £63,4 млн ($80 млн). Сбои при запуске системы в апреле 2022 года привели к катастрофическим последствиям. Теперь совет всеми силами пытается решать хотя бы текущие вопросы на базе имеющегося ПО, только на поддержку тратя большие деньги. Более того, в следующие два года планируется повторно внедрить платформу Oracle «из коробки», на что до 2026 года дополнительно выделены £45 млн ($57 млн).

Источник изображения: Tom Podmore/unsplash.com В 2019 году, когда городской совет представил экономическое обоснование отказа от варианта SAP использовавшегося с 1999 года, всё выглядело совсем иначе — планировалось, что внедрение новой ERP-системы обойдётся в £19,965 млн ($25 млн), а генерируемая ей отчётность будет невероятно точной. Предполагалось, что проект реализуют до конца 2021 года. Фактически внедрение началось на год позже запланированного, а сам процесс оказался настолько проблемным, что в итоге пришлось тратить по £61,3 тыс. ($78 тыс.) еженедельно на «обходные пути» для банковской сверки и выполнения других задач вручную. По оценкам, общая стоимость внедрения могла вырасти до £131 млн ($167 млн), из проекта исключили учебные заведения, снизив сумму на £23 млн. Утверждается, что для школ в долгосрочной перспективе ПО не вполне подходит и будет слишком дорогим и малоэффективным. В ноябре в совете признали отсутствие эффективного управления и контроля за внедрением ERP Oracle, серьёзную нехватку навыков, опыта и возможностей. По расчётам агентства Audit Reform Lab, общая стоимость проекта фактически составит £216,5 млн, поскольку власти рассчитывали по итогам внедрения ERP сэкономить £69 млн только в 2023–2024 гг.

05.12.2024 [13:37], Сергей Карасёв

AWS представила инстансы EC2 P5en на базе NVIDIA H200 и кастомизированных чипов Intel XeonОблачная платформа AWS объявила о доступности инстансов EC2 P5en, рассчитанных на такие нагрузки, как глубокое обучение, генеративный ИИ, обработка данных в реальном времени и приложения HPC. В основу новых экземпляров положены аппаратные компоненты Intel и NVIDIA. В частности, задействованы кастомизированные процессоры Xeon Sapphire Rapids. У них все ядра могут одновременно работать на турбо-частоте 3,2 ГГц, а максимальная частота отдельных ядер достигает 3,8 ГГц. Кроме того, применяются ИИ-ускорители NVIDIA H200 и адаптеры AWS Elastic Fabric Adapter (EFA) v3 с пропускной способностью до 3,2 Тбит/с. Конфигурация инстансов EC2 P5en включает 192 vCPU, 2048 ГиБ памяти, восемь ускорителей H200 и восемь SSD вместимостью 3,84 Тбайт каждый. Пропускная способность EBS составляет 100 Гбит/с. Отмечается, что экземпляры P5en демонстрируют увеличение производительности локального хранилища до двух раз и пропускной способности EBS до 25 % по сравнению с инстансами P5 на базе NVIDIA H100.

Источник изображения: NVIDIA На сегодняшний день инстансы EC2 P5en доступны в американских регионах AWS US East (Огайо) и US West (Орегон), а также в Азиатско-Тихоокеанском регионе в Токио. Предлагаются различные тарифные опции, включая оплату по мере использования. Ранее были представлены инстансы EC2 P5e с процессорами AMD EPYC Milan, 2 ТиБ памяти, восемью ускорителями NVIDIA H200 и восемью NVMe SSD на 3,84 Тбайт каждый. У этих экземпляров пропускная способность EBS равна 80 Гбит/с.

04.12.2024 [19:26], Владимир Мироненко

С Microsoft в Великобритании требуют £1 млрд за завышение расценок для клиентов облачных конкурентовВ минувший вторник на Microsoft подали в суд в Великобритании с обвинением в несправедливом завышении цен для клиентов конкурирующих облачных компаний, сообщил ресурс CNBC. В иске утверждается, что клиенты платформ Amazon Web Services (AWS), Google Cloud Platform и Alibaba Cloud, являющихся основными конкурентами облака Microsoft Azure, вынуждены платить больше за лицензии на Windows Server в инфраструктуре конкурентов. В качестве компенсации пострадавшие британские фирмы требуют выплатить £1 млрд. Microsoft предлагает фирмам, использующим Windows Server в Azure, более низкую цену, чем у прямых конкурентов на облачном рынке. В иске указано, что фирмы, пользующиеся серверным ПО Microsoft, фактически переплачивают за использование альтернативных облачных платформ. Утверждается, что Microsoft использует своё доминирующее положение на рынке облачных серверных ОС, устанавливая более высокие цены и побуждая клиентов переходить на Azure. Представляющая интересы истцов Мария Луиза Стази (Maria Luisa Stasi), глава отдела права и политики группы по защите цифровых прав Article19, сообщила CNBC, что «Microsoft пытается заставить клиентов использовать свой сервис облачных вычислений Azure и ограничить конкуренцию в секторе», добавив, что иск «нацелен на то, чтобы оспорить антиконкурентное поведение Microsoft, заставить её раскрыть суммы незаконных переплат компаний в Великобритании и вернуть деньги организациям, с которых несправедливо взимают завышенную плату». Коллективный иск против Microsoft включает тысячи компаний и организаций. Иск подан по модели opt-out, согласно которой участники включаются в группу истцов без надобности в обязательном волеизъявлении, если только они сами не откажутся от участия в процессе. Это означает, что любая потенциально пострадавшая компания автоматически учитывается в иске и может получить компенсацию в случае проигрыша Microsoft. Представитель Стази сообщил CNBC, что она представляет интересы клиентов Amazon, Google и Alibaba, но не самих облачных платформ. Ранее в этом году Microsoft заключила соглашение на €20 млн с поддерживаемой AWS группой лоббистов CISPE, что позволило ей избежать антимонопольного расследования ЕС по поводу обвинений в несправедливой практике лицензирования ПО в Azure. Вместе с тем в мировое соглашение не были включены Amazon Web Services (AWS), Google Cloud Platform и Alibaba Cloud. Вскоре после этого Google подала жалобу в Еврокомиссию на антиконкурентную практику лицензирования Microsoft. В июне 2023 года Google направила в Федеральную торговую комиссию США (FTC) письмо с обвинением Microsoft в антиконкурентной практике, в связи с чем регулятор начал подготовку к антимонопольному расследованию. Основанная Google новая группа Open Cloud Coalition (OCC) намерена поддерживать открытость на облачном рынке, в частности, с помощью поддержки деятельности антимонопольных органов. Microsoft, в свою очередь, утверждает, что за последние пару лет выручка Google и AWS только росла, что говорит о наличии конкуренции, а не об её отсутствии.

04.12.2024 [17:43], Сергей Карасёв

AWS построит распределённый ИИ-суперкомпьютер Project Rainier с десятками тысяч ИИ-ускорителей Trainium2Облачная платформа AWS официально представила инстансы EC2 Trn2 и Trn2 UltraServer — самые высокопроизводительные решения EC2, ориентированные на ИИ-приложения, машинное обучение и задачи инференса. В основу положены фирменные ускорители Amazon Trainium2 второго поколения. ИИ-ускорители Trainium2 содержат восемь ядер NeuronCore и 96 ГиБ памяти HBM с пропускной способностью 2,9 Тбайт/с. Ядра могут адресоваться и использоваться по отдельности или же пары физических ядер могут быть сгруппированы в один логический блок. Trainium2 обеспечивает FP8-быстродействие до 1,3 Пфлопс, а FP8-производительность в разреженных вычислениях достигает 5,2 Пфлопс. Инстансы EC2 Trn2 содержат 16 ускорителей Trainum2, связанных посредством интерконнекта NeuronLink. В сумме это даёт 128 ядер NeuronCore и 1,5 ТиБ памяти HBM с суммарной пропускной способностью 46 Тбайт/с. Производительность на операциях FP8 достигает 20,8 Пфлопс. Каждый инстанс включает 192 vCPU, 2 ТиБ памяти и адаптеры AWS Elastic Fabric Adapter (EFA) v3 на 3,2 Тбит/с. Утверждается, что инстансы Trn2 обеспечивают в четыре раза более высокую производительность, в четыре раза большую пропускную способность памяти и в три раза большую ёмкость памяти, нежели инстансы Trn1. Кроме того, экземпляры Trn2 предлагают на 30–40 % лучшее соотношение цены и производительности, чем EC2 P5e и P5en на базе GPU. Инстансы Trn2 доступны в регионе AWS US East (Огайо), а в ближайшем будущем появятся и в других зонах. В свою очередь, платформа UltraServer включает четыре инстанса Trn2 (64 ускорителя Trainum2) с интерконнектом NeuronLink с низкой задержкой. В сумме это даёт 512 ядер NeuronCore и 6 ТиБ памяти HBM с суммарной пропускной способностью 185 Тбайт/с. Быстродействие на операциях FP8 составляет 83 Пфлопс (332 Пфлопс в разреженных вычислениях). Новые узлы используют СЖО. Десятки тысяч ускорителей Trainium2 могут формировать кластеры EC2 UltraCluster. В частности, такую систему в рамках инициативы Project Rainier компания Amazon намерена создать в партнёрстве со стартапом Anthropic, который специализируются на технологиях генеративного ИИ. Интересно, что ИИ-суперкомпьютер Project Rainier будет распределённым — его узлы разместятся сразу в нескольких ЦОД. ВОЛС между дата-центрами организует Lumen. Одной из причин от попытки построить один гигантский кампус называется невозможность быстро получить достаточно энергии в одном месте, хотя у компании уже есть площадка рядом с АЭС. Недавно Amazon объявила о намерении удвоить инвестиции в Anthropic, доведя их до $8 млрд. Создание системы Rainier планируется завершить в следующем году. Ожидается, что она станет одним из крупнейших в мире вычислительных кластеров для обучения моделей ИИ. По заявлениям AWS, комплекс обеспечит в пять раз более высокую производительность по сравнению с платформой, которую Anthropic использовала до сих пор для разработки своих языковых моделей. Достанутся ли Anthropic и ресурсы ещё облачного ИИ-суперкомпьютера Project Ceiba, который получит 21 тыс. суперчипов NVIDIA Blackwell, не уточняется. Кроме того, по сообщению The Register, компания Amazon приоткрыла завесу тайны над ИИ-ускорителями следующего поколения — изделиями Trainium3. По сравнению с предшественниками они, как утверждается, обеспечат четырёхкратное увеличение быстродействия. Говорится, что Trainium3 станет первым специализированным ускорителем для ИИ и машинного обучения, созданным на основе 3-нм техпроцесса. Эффективность по сравнению с Trainium2 увеличится примерно на 40 %. Ожидается, что на коммерческом рынке изделия Trainium3 появятся в конце 2025 года.

04.12.2024 [15:44], Руслан Авдеев

Marvell перенесёт разработку чипов в облако AWS, а AWS получит от Marvell новые чипы для своих ЦОДКомпания Marvell Technology, занимающаяся полупроводниковыми инфраструктурными решениями, объявила о расширении стратегического партнёрства с Amazon Web Services (AWS). Стороны заключили соглашение сроком на пять лет, включающее сотрудничество в работе над несколькими продуктами AWS, а также использование облачной инфраструктуры техногиганта, сообщает пресс-служба Marvell. Соглашение касается широкого спектра решений Marvell, предназначенных для дата-центров. В том числе речь идёт о поставке кастомизированных ИИ-чипов для AWS, оптических и электрических DSP, PCIe-ретаймеров, оптических сетевых решениях, чипсетов для коммутаторов и др. Компетенции Marvell позволят AWS усовершенствовать собственные продукты, сетевое оборудование и СХД, добившись большей эффективности и снижения стоимости эксплуатации. Для автоматизации проектирования электроники (EDA) в Marvell приняли подход cloud first, разработка ведётся с использованием облака AWS, где компании доступны практически неограниченные вычислительные ресурсы. В Marvell уже заявили, что решения AWS EDA помогут компании быстро, гибко и безопасно масштабировать проектирование полупроводников с лучшим в своём классе временем выхода на рынок. Сотрудничество играет на руку и AWS — продукты Marvell активно используются в инфраструктуре Amazon.

03.12.2024 [05:58], Руслан Авдеев

Сдайте ваши файлы: Amazon открыла в США пункты выгрузки данных в AWSAmazon представила сервис AWS Data Transfer Terminal — пункты, где можно быстро и безопасно выгрузить большие объёмы данных в облако AWS. Первые терминалы расположены в Лос-Анджелесе и Нью-Йорке, в будущем планируется добавить пункты приёма данных и в других локациях по всему миру. Использование пунктов AWS Data Transfer Terminal позволит значительно снизить время передачи данных (не считая времени на дорогу и обратно) в хранилища S3, EFS и др. Например, можно выгрузить большие датасеты от парка беспилотных машин, видеофайлы или картографические данные для дальнейшего анализа и обработки. Также с собой можно принести носители Snowball, хотя в целом AWS постепенно сворачивает сервисы Snow по физической доставке данных в облако. Список терминалов доступен в AWS Management Console, где можно заранее назначить дату и время визита и вписать участников. В назначенный час сотрудник AWS проверит документы и проводит до отдельной комнаты, где есть патч-панель, оптоволоконный кабель и ПК. Патч-панель интегрирована в небольшую стойку, а компьютер можно использовать для контроля процесса передачи данных. Примечательно, что в целях безопасности на зданиях и в помещениях нет никаких символов AWS. Плата за гигабайты не предусмотрена, вместо этого платить придётся за время загрузки в регионы AWS. При этом доступны только те регионы, которые находятся на том же континенте, где и пользователь.

02.12.2024 [21:29], Руслан Авдеев

Google предлагала европейским облакам миллионы евро для продолжения борьбы с MicrosoftСогласно закрытым документам, тексты которых попали в распоряжение The Register, в своё время Google Cloud предлагала «финансовые стимулы» на сотни миллионов евро для организации европейских облачных провайдеров CISPE, жаловавшихся регуляторам на Microsoft. Как свидетельствуют источники, представитель Google общался как с руководством группы, так и со всему участниками организации CISPE. В ходе одной из презентаций предлагалось создать для участников организации Фонд инноваций в объёме €4 млн, который использовался бы для финансирования проектов и лицензионных сборов участников CISPE, для поддержки инноваций в открытых облачных экосистемах. На каждого участника пришлось бы порядка €100 тыс. — сейчас в CISPE 36 членов, в том числе Oxya, Leaseweb, UpCloud и даже AWS, единственная «неевропейская» компания. Ещё в июле группа включала лишь 27 компаний. Дополнительно Google предложила выделить CISPE ещё €10 млн в качестве «ресурсов на участие и членство». Наконец, Google предложила участникам CISPE кредиты на использование Google Distributed Cloud в размере €100 млн в течение пяти лет. При этом в презентации подчёркивалось, что фонд инноваций и программная платформа будут доступны действующим членам CISPE с условием «сохранения организацией неограниченных возможностей в продвижении принципов справедливого ПО».

Источник изображения: David Clode/unsplash.com Предполагается, что предложение было сделано с целью убедить участников CISPE не отказываться от жалоб на Microsoft, связанных с политикой лицензирования последней, которая делает использование продуктов редмондского гиганта в чужих облаках неоправданно дорогим. Жалобу подали в ноябре 2022 года, но позже Microsoft небезвозмездно уговорила большинство участников CISPE (кроме гиперскейлеров) отказаться от претензий — о попытках Google остановить этот процесс сообщалось ранее. Правда, в самой Google заявляют, что жалоба и финансовые стимулы с её стороны никак не связаны. Несмотря на отчаянные попытки Google, CISPE приняла решение отказаться от тяжб с Microsoft. По слухам, последняя потратила на улаживание претензий €10–€30 млн. При этом членам CISPE станет доступно решение Azure Local (Stack HCI) для развёртывания облака на базе собственной инфраструктуры. Источники в CISPE сообщают, что устали бороться с Microsoft и хотят просто решить проблему лицензирования, а не начинать новую войну, навязываемую Google. Microsoft, вполне возможно, тоже так или иначе заплатила участникам CISPE за отказ от преследования. Сама Google создала Open Cloud Coalition (OCC), в которую входят преимущественно небольшие британские облачные операторы и один испанский провайдер. Microsoft уже назвала группу «искусственным газоном, созданным Google» для дискредитации компании и введения регуляторов в заблуждение. OCC заявляет, что выступает за открытые стандарты и против ограничительного лицензирования и иных барьеров, мешающих конкуренции и инновациям — в Google обеспокоены тем, что массовый переход в облако Microsoft фактически лишает её клиентов. OCC можно использовать для лоббирования и жалоб в Управлении по конкуренции и рынкам Великобритании (CMA). В Евросоюзе Google также подавала жалобу на антиконкурентные практики и доминирование Microsoft в сфере облачного ПО в сентябре. Впрочем, большую часть облачного рынка Европы и так занимают AWS, Microsoft и Google. По данным Synergy Research, во II квартале 2024 года расходы на облачный рынок в Европе составили $16 млрд. На долю AWS пришлось 32 % рынка, Microsoft — 26 %, а на Google — 15 %. Крупнейшие конкуренты Microsoft называют политику лицензирования её ПО несправедливой. Так, за использование Windows Server вне Azure обходится вчетверо дороже. Тем не менее, по словам представителя CISPE, общавшегося с The Register, участники организации проголосовали за предложения Microsoft, оптимальные для европейского облачного сектора. Ранее представитель Google уклонился от прямого ответа на вопрос о том, предлагала ли компания заплатить участникам CISPE за продолжение тяжбы с Microsoft. Ранее топ-менеджмент Google официально заявлял, что оплата не предлагалась.

02.12.2024 [11:46], Сергей Карасёв

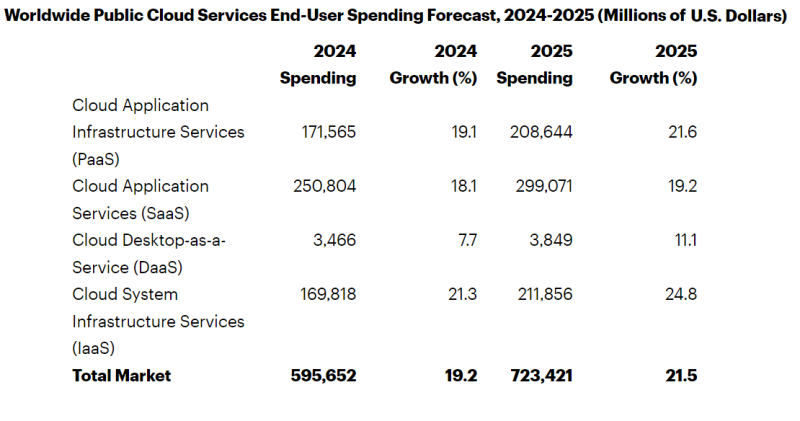

Gartner: затраты на публичные облака в мире в 2025 году достигнут $723 млрдКомпания Gartner обнародовала прогноз по мировому рынку публичных облачных услуг на 2025 год. Отрасль демонстрирует стремительный рост на фоне продолжающегося развития ИИ-приложений, включая генеративные сервисы. Аналитики учитывают затраты на платформы SaaS, IaaS и PaaS, а также DaaS (десктоп как сервис). По оценкам, в 2024-м объём отрасли достигнет $595,7 млрд, показав прибавку на уровне 19,2 % по отношению к предыдущему году. При этом наибольшую выручку обеспечит сектор SaaS — $250,8 млрд. Ещё приблизительно $171,6 млрд придётся на PaaS, около $169,8 млрд — на IaaS. Наименьший вклад внесёт DaaS-направление с расходами $3,5 млрд. В 2025 году, по мнению специалистов Gartner, отрасль продемонстрирует рост на 21,5 %: выручка поднимется до $723,4 млрд. Доминирующим сегментом останется SaaS с прибавкой на уровне 19,2 % в годовом исчислении и результатом примерно $299,1 млрд. Максимальные темпы роста прогнозируются в секторе IaaS — плюс 24,8 % год к году. В результате, выручка от этих услуг достигнет $211,9 млрд. Причём сегмент IaaS по денежным поступлениям опередит сферу PaaS, где выручка ожидается на уровне $208,6 млрд с ростом на 21,6 % по отношению к 2024-му. В области DaaS увеличение составит около 11,1 % — до $3,8 млрд. В Gartner также говорят о росте популярности концепции CIPS — Cloud Infrastructure and Platform Services. Речь идёт о полнофункциональной платформе, предоставляющей IaaS и PaaS в виде интегрированных облачных сервисов. Аналитики прогнозируют, что расходы конечных пользователей на CIPS поднимутся на 24,2 % в 2025 году и достигнут $301 млрд. Ожидается, что в 2025 году предложения CIPS составят 72 % суммарных затрат на IaaS и PaaS по сравнению с 70 % в 2022 году. |

|