Материалы по тегу: ии

|

23.07.2025 [01:39], Владимир Мироненко

Oracle поставит OpenAI два миллиона ИИ-чипов для ЦОДOpenAI объявила о заключении соглашения с Oracle о строительстве дополнительных ЦОД мощностью 4,5 ГВт в США в рамках расширенного партнёрства, что станет дальнейшим развитием проекта Stargate. OpenAI пока не назвала площадки для этих ЦОД, но рассматриваются штаты, Мичиган, Висконсин и Вайоминг, пишет Bloomberg. Компания сообщила, что с учётом строящегося объекта в Абилине (штат Техас), общая мощность дата-центров Stargate в США составит более 5 ГВт, и в них будет использоваться более чем 2 млн чипов для ИИ-задач. Ранее в этом месяце стало известно о планах OpenAI арендовать дополнительные мощности ЦОД у Oracle. В январе OpenAI, Oracle и SoftBank Group объявили о намерении инвестировать $500 млрд в развёртывание ИИ-инфраструктуры на 10 ГВт в США в течение следующих четырёх лет. Теперь OpenAI заявляет, что рассчитывает превысить это обязательство «благодаря сильной динамике сотрудничества с такими партнёрами, как Oracle и SoftBank». Как отметил Bloomberg, хотя OpenAI назвала строительство дополнительных ЦОД совместно с Oracle частью проекта Stargate, SoftBank не участвует в его финансировании. В мае Bloomberg сообщил, что SoftBank столкнулась с трудностями в переговорах о финансировании проекта на фоне общей экономической неопределенности, связанной с пересмотром пошлин США. OpenAI также рассказала о ходе строительства кампуса Stargate I в Абилине (Техас), где часть объекта уже введена в эксплуатацию. Oracle начала поставлять первые стойки с чипами NVIDIA GB200 в прошлом месяце, и часть ЦОД уже работает несколько недель, сообщила компания. Также OpenAI отметила, что Microsoft продолжит предоставлять облачные сервисы для неё, в том числе через Stargate.

22.07.2025 [17:22], Руслан Авдеев

xAI купила за $10 территорию бывшей газовой электростанции неподалёку от будущего ИИ ЦОДxAI приобрела бывшую газовую электростанцию Duke Energy в Саутхейвене (Southaven, Миссисипи), неподалёку от нового дата-центра в Мефисе (Теннесси). Точнее говоря, то, что от неё осталось. Главную ценность представляют земля и коммуникации, сообщает Datacenter Dynamics. Площадка находится на Стентон-роуд (Stanton Road) в штате Миссисипи, в нескольких километрах от Тулейн-роуд (Tulane Road), где xAI намерена возвести ЦОД площадью более 90 тыс. м2, который станет частью уже действующего суперкомпьютера Colossus. xAI уже эксплуатирует дата-центр в Мемфисе и недавно получила разрешение на использование газовых турбин на площадке на постоянной основе, к большому сожалению местных активистов. Ранее местные СМИ сообщали, что бывшая электростанция с территорией была куплена калифорнийской MZT Tech LLC. По официальным данным, xAI контролирует её деятельность. По данным местных властей, формально xAI приобрела собственность у некой Джули Джеймс (Julie M. James) за $10 наличными. Ранее сотрудников xAI уже замечали на площадке, но представитель xAI заявил, что компания не раскрывает происходящего на территории бывшей электростанции. На тот момент, по его словам, сделка была «всё ещё на стадии обсуждения». Электростанция на территории 46 га в Саутхейвене была построена Duke Energy в 2003 году и в своё время могла обеспечить до 640 МВт. Позже владелец продал объект, наряду с семью другими газовыми электростанциями на северо-востоке США, компании Kgen Partners за $475 млн. Спутниковые изображения свидетельствуют, что на площадке осталось немного инфраструктуры, но сохранились подключения к коммунальным сетям — электричеству, газу и воде. Фактически площадка имеет подключение к 200-МВт газовой электростанцией Southaven, управляемой Tennessee Valley Authority (TVA). Компании, похоже, приходится рассматривать самые необычные сценарии для обеспечения своих потребностей в энергии. Пару недель назад её основатель Илон Маск (Elon Musk) заявил, что намерен купить электростанцию за границей и импортировать её в США для обеспечения своих дата-центров электричеством.

22.07.2025 [10:29], Руслан Авдеев

Великобритания и OpenAI подписали новое соглашение о стратегическом сотрудничествеВласти Великобритании подписали с компанией OpenAI договор о новом стратегическом партнёрстве для углубления сотрудничества в области исследований аспектов ИИ-безопасности. Также будут изучаться возможности инвестиций OpenAI в британскую ИИ-инфраструктуру, сообщает Reuters. По словам представителя правительства, искусственный интеллект будет играть основополагающую роль для изменений по всей стране — от улучшения работы системы здравоохранения до устранения барьеров, мешающих экономическому росту. Власти считают, что добиться этого невозможно без компаний вроде OpenAI, которые продвигают новую технологическую революцию на международном уровне. Благодаря новому соглашению значительная часть соответствующих работ будет проводиться в Великобритании. Правительство намерено организовать инвестиции £1 млрд в вычислительную инфраструктуру для развития ИИ, рассчитывая увеличить публичные вычислительные мощности в 20 раз в течение следующих пяти лет.

Источник изображения: Ian Taylor/unsplash.com В гонке технологий искусственного интеллекта в лидеры выходят США, Китай и Индия, а Европа играет роль «догоняющего». Партнёрство с OpenAI, чье взаимодействие с Microsoft в своё время привлекло внимание британского регулятора, возможно, позволит компании расширить лондонский офис и изучить возможность применения ИИ в самых разных областях — при отправлении правосудия, в обороне, для обеспечения безопасности и в образовательных целях. Глава OpenAI Сэм Альтман похвалил правительство за то, что оно признало потенциал ИИ-технологий в рамках проекта AI Opportunities Action Plan, инициатива в реализации которого принадлежит британскому премьеру, планирующему превратить страну в «ИИ-сверхдержаву» — для этого рассматривается даже создание новых АЭС. Правительство лейбористов не особенно справляется с обеспечением экономического роста в первый год у власти и теперь заявляет, что ИИ может повысить производительность на 1,5 % в год, что принесёт £47 млрд ($63,37 млрд) ежегодно в течение десятилетия.

21.07.2025 [18:58], Владимир Мироненко

xAI ищет разработчиков кастомных чипов для ИИ-системИИ-стартап xAI Илона Маска (Elon Musk) разместил вакансии для разработчиков кастомных полупроводников, сообщил ресурс DataCenter Dynamics (DCD). Стартап ищет сотрудников для «создания ИИ-систем нового поколения, охватывающих весь спектр, от полупроводниковых чипов до компиляторов и моделей». Круг должностных обязанностей специалистов включает «разработку и доработку новых аппаратных архитектур для расширения границ вычислительной эффективности», а также использование ИИ в процессе проектирования оборудования. От кандидатов на должность ожидается знание инструментов для создания чипов, таких как Chisel, а также VHDL и Verilog. В идеале претенденты должны иметь опыт «симуляции обучающих рабочих нагрузок на новых аппаратных ИИ-архитектурах». Соответствующий требованиям сотрудник присоединится к команде xAI, работающей над «созданием ИИ-систем нового поколения, которые обеспечат революционную эффективность и масштабируемость на новом оборудовании, компиляторах и моделях».

Источник изображения: xAI Как полагает DCD, команду, о которой идёт речь, возглавляет Сяо Сан (Xiao Sun), ранее работавший в Meta✴, а до этого занимавшийся разработкой аппаратного обеспечения и алгоритмов машинного обучения, а также CMOS-устройств в IBM. DCD отметил, что на данный момент неясно, сотрудничает ли xAI с другой компанией в разработке полупроводниковых чипов, как, например, Google и OpenAI, которые работают с Broadcom над созданием семейства TPU и ИИ-чипа соответственно. Компания Tesla, в которой Маск является крупнейшим акционером, также разработала собственный чип — Dojo D1, ориентированный на обработку видеоданных для обучения полуавтономных автомобилей. Однако большая часть команды, стоящей за чипом Dojo D1, покинула Tesla, и его будущее туманно. Илон Маска показал систему в 2024 году. Годом ранее Маск заявил, что чип используется из-за нехватки ускорителей NVIDIA: «Честно говоря, я не знаю, смогут ли они поставить нам достаточно графических процессоров — возможно, Dojo нам и не нужен, — но они не смогут». Как и Tesla, xAI использует значительное количество ускорителей NVIDIA для своих вычислительных задач, более 200 тыс. из них входят в состав суперкомпьютера Colossus в Мемфисе (США). Маск надеется расширить Colossus до миллиона ускорителей. В свою очередь, xAI приобрела участок под второй дата-центр в Мемфисе.

21.07.2025 [16:42], Сергей Карасёв

Запущен самый мощный в Великобритании ИИ-суперкомпьютер — комплекс Isambard-AIВ Великобритании официально введён в эксплуатацию суперкомпьютер Isambard-AI: это самый мощный в стране вычислительный комплекс, ориентированный на задачи ИИ. В июньском рейтинге TOP500 машина занимает 11-е место, а в списке наиболее энергоэффективных систем Green500 — четвёртую позицию. Суперкомпьютер назван в честь британского инженера Изамбарда Кингдома Брюнеля (Isambard Kingdom Brunel), внёсшего значимый вклад в Промышленную революцию. Проект реализован при участии компаний NVIDIA и HPE, Бристольского университета (University of Bristol) и других организаций. Создание Isambard-AI обошлось примерно в £225 млн ($302 млн). В основу комплекса положена платформа HPE Cray EX с интерконнектом Slingshot 11. Задействованы 5448 суперчипов NVIDIA GH200 Grace Hopper, которые объединяют 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H200. Применена СХД Cray ClusterStor E1000 вместимостью 25 Пбайт. Питание полностью обеспечивается от источников энергии с нулевыми выбросами углерода. Избыточное тепло может использоваться для обогрева близлежащих зданий. Развёрнута система прямого жидкостного охлаждения HPE. В тесте Linpack комплекс Isambard-AI демонстрирует FP64-быстродействие на уровне 216,5 Пфлопс, тогда как теоретический пиковый показатель составляет 278,58 Пфлопс. Производительность при решении ИИ-задач достигает 21 Эфлопс (FP8). Как отмечается, Isambard-AI более чем в 10 раз превосходит по скорости второй по быстродействию суперкомпьютер в Великобритании и предоставляет больше вычислительной мощности, чем все остальные НРС-машины страны вместе взятые. Новый комплекс будет применяться для решения наиболее сложных и ресурсоёмких задач, таких как разработка передовых лекарственных препаратов, моделирование климата, материаловедение, большие языковые модели (LLM) и др. Доступ к ресурсам Isambard-AI регулируется Министерством науки, инноваций и технологий и Департаментом исследований и инноваций Великобритании.

21.07.2025 [09:27], Сергей Карасёв

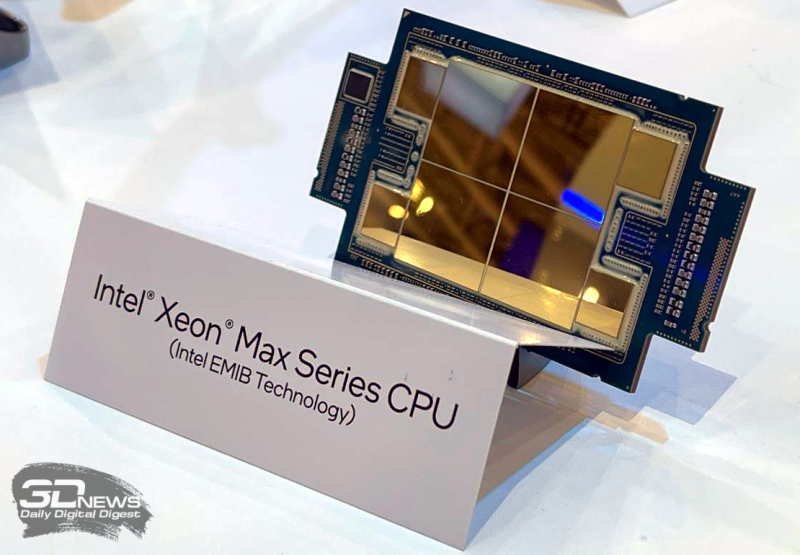

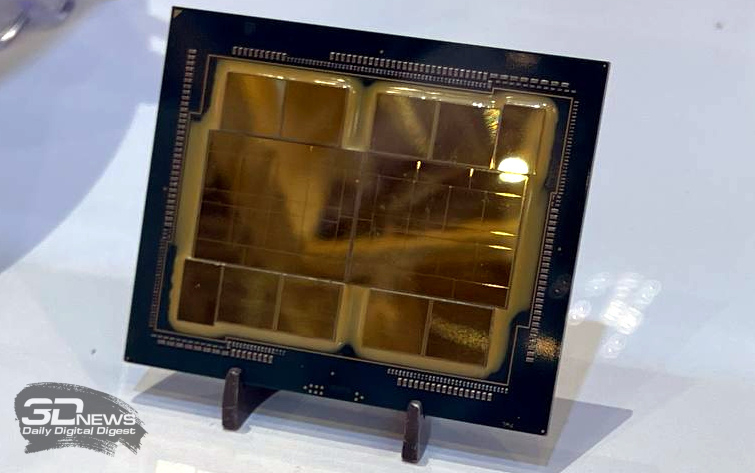

10 долгих лет: состоялся официальный запуск экзафлопсного суперкомпьютера AuroraВ Аргоннской национальной лаборатории (ANL) Министерства энергетики США (DOE) в Иллинойсе состоялась церемония торжественного разрезания ленты в честь официального запуска суперкомпьютера Aurora экзафлопсного класса. В мероприятии приняли участие руководители и исследователи Intel, HPE и DOE. Церемония была скорее формальностью, поскольку Aurora стала доступна исследователям со всего мира в начале текущего года. Aurora является одним из трёх суперкомпьютеров DOE с производительностью более 1 Эфлопс. Наряду с El Capitan в Ливерморской национальной лаборатории имени Лоуренса (LLNL) и Frontier в Национальной лаборатории Оук-Ридж (ORNL) эти НРС-комплексы занимают первые три места как в списке TOP500 самых быстрых суперкомпьютеров мира, так и в бенчмарке HPL-MxP для оценки производительности ИИ. У суперкомпьютера непростая судьба. Анонс машины состоялся в 2015 году — система с FP64-производительностью на уровне 180 Пфлопс по плану должна была заработать в 2018 году. Однако планы неоднократно корректировались, а проект в конце концов был кардинально пересмотрен. Первые тестовые кластеры системы заработали более двух лет назад, а частично запущенная система попала в TOP500 в конце 2023 года. Целиком она заработала в 2024 году. В проекте по созданию Aurora принимали участие Intel и HPE. Машина построена на платформе HPE Cray EX — Intel Exascale Compute Blade: задействованы процессоры Intel Xeon CPU Max и ускорители Intel Data Center GPU Max, объединённые интерконнектом HPE Slingshot. В общей сложности применяются 63 744 ускорителей, что делает Aurora одним из крупнейших в мире суперкомпьютеров на базе GPU. Установлена ОС SUSE Linux Enterprise Server 15 SP4. Производительность в тесте Linpack составляет 1,012 Эфлопс, а теоретический пиковый показатель достигает 1,980 Эфлопс. НРС-комплекс занимает площадь около 930 м2. Развёрнута современная инфраструктура жидкостного охлаждения. Общая протяжённость соединений превышает 480 км, а количество конечных точек сети достигает 85 тыс. Aurora останется по-своему уникальным суперкомпьютером: CPU с HBM на борту больше не планируются, от Ponte Vecchio компания отказалась в пользу Habana Gaudi и Falcon Shores. Но и последние на рынок не попадут, а будут использоваться для внутренних тестов и обкатки технологий. На смену им должны прийти Jaguar Shores, но точных дат Intel не называет.  Вычислительные мощности Aurora, как отмечается, помогают в решении сложнейших задач в самых разных областях. В биологии и медицине исследователи используют ИИ-возможности суперкомпьютера для прогнозирования эволюции вирусов, улучшения методов лечения рака и картирования нейронных связей в мозге. В аэрокосмической сфере Aurora используется для создания двигательных установок нового поколения и моделирования аэродинамических процессов. Комплекс играет важную роль в развитии технологий термоядерной энергетики, квантовых вычислений и пр.

20.07.2025 [14:26], Сергей Карасёв

NVIDIA приступила к производству ИИ-ускорителей GB300Компания NVIDIA, по сообщению DigiTimes, приступила к ограниченному производству суперчипов Grace Blackwell GB300 для ресурсоёмких ИИ-нагрузок. Ожидается, что поставки изделия будут организованы в сентябре с постепенным наращиванием объёмов выпуска. Решение GB300 представляет собой связку из Arm-процессора Grace с 72 ядрами Neoverse V2 и двух чипов Blackwell Ultra. В оснащение входят 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. Ускоритель GB300 является основой стоечной системы GB300 NVL72, которая насчитывает 36 чипов Grace и 72 процессора Blackwell Ultra. ИИ-производительность такого комплекса достигает 720 Пфлопс на операциях FP8/FP6. «На данном этапе серьёзных проблем с GB300 нет. Поставки должны идти гладко со II половины года», — подчеркнули представители одного из ODM-производителей.

Источник изображения: NVIDIA Вместе с тем, как отмечается, сохраняется высокий спрос на ускорители GB200. Заказчики продолжают закупать эти изделия, несмотря на сложности с охлаждением. Огромная вычислительная мощность и повышенная плотность компоновки серверов обусловили необходимость применения жидкостных систем отвода тепла. Однако при этом возникли проблемы протечек. Оказалось, что во многих случаях это связано с быстроразъёмными соединениями, которые не всегда удовлетворяют нужным требованиям — даже после стресс-тестирования на заводе. ODM-производители отмечают, что реальные условия эксплуатации сильно различаются по давлению воды и конструкции трубопроводов, что затрудняет полное исключение протечек. Послепродажное обслуживание требует значительных временных и финансовых затрат. В случае GB200 основные сложности были обусловлены переходом от архитектуры Hopper к Blackwell, что привело к комплексным изменениям на уровне платформы. С другой стороны, GB300 использует существующую инфраструктуру, а поэтому, как ожидается, серьёзных проблем при выпуске и поставках этих изделий не возникнет. ODM-производители, которые в настоящее время активно тестируют GB300, говорят об обнадёживающих результатах. Предполагается, что переход пройдёт гладко: массовые поставки запланированы на III квартал с увеличением объёмов выпуска в последней четверти текущего года. Новые вызовы может создать появление ускорителей следующего поколения семейства Rubin, которые придут на смену Blackwell Ultra во II половине 2026 года. Эта платформа предполагает использование чиплетов и полностью новой стойки Kyber (для VR300 NVL 576), которая заменит нынешнюю конструкцию Oberon. Плотность компоновки возрастёт до 600 кВт на стойку, что потребует ещё более надёжных систем охлаждения. Отмечается, что применение СЖО станет обязательным для суперускорителей Rubin. Вместе с тем с восстановлением производства ослабленных ускорителей H20, которые США вновь разрешили поставлять в Китай, возможны проблемы. Как передаёт Reuters со ссылкой на The Information, TSMC успела переключить производственные линии, которые использовались для H20, на выпуск других продуктов. Полное восстановление производства H20 может занять девять месяцев.

19.07.2025 [13:46], Сергей Карасёв

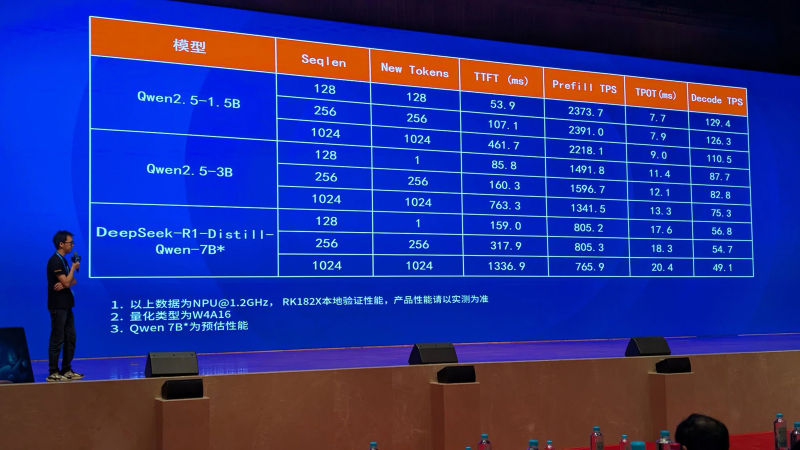

Rockchip анонсировала ИИ-ускоритель RK182X с архитектурой RISC-VКомпания Rockchip, по сообщению ресурса CNX Software, представила в Китае ИИ-ускоритель RK182X, предназначенный для работы с большими языковыми моделями (LLM) и визуально-языковыми моделями (VLM) на периферии. Новинка ориентирована на совместное использование с другими SoC Rockchip. Изделие получило многоядерную архитектуру RISC-V (точное количество ядер пока не раскрывается). В зависимости от модификации задействованы 2,5 или 5 Гбайт памяти DRAM со «сверхвысокой пропускной способностью» (ПСП тоже не раскрывается). Реализована поддержка интерфейсов PCIe 2.0, USB 3.0 и Ethernet. По заявлениям Rockchip, ИИ-ускоритель RK182X способен обрабатывать LLM/VLM, насчитывающие до 7 млрд параметров. В частности, таким моделям требуется примерно 3,5 Гбайт памяти при использовании режимов INT4/FP4. Говорится о совместимости с фреймворками PyTorch, ONNX и TensorFlow, а также форматом HuggingFace GGUF (GPT-Generated Unified Format). ИИ-ускоритель спроектирован для применения в связке с такими процессорами Rockchip, как RK3576/RK3588 и другими, вероятно, включая решения RK3668 и RK3688, которые были также представлены вчера. Эти чипы содержат собственный интегрированный NPU-модуль с производительностью 6 TOPS или более для обработки ИИ-нагрузок. Однако благодаря применению отдельного ускорителя ИИ-быстродействие на определённых задачах может быть повышено в 8–10 раз. Rockchip, в частности, обнародовала скоростные показатели RK182X для таких популярных моделей, как DeepSeek-R1-Distill-Qwen-7B, Qwen2.5-1.5B и Qwen2.5-3B.

19.07.2025 [00:15], Руслан Авдеев

Углеродные выбросы Amazon выросли в 2024 году на 6 % из-за ИИ ЦОД и любителей шопингаУглеродные выбросы Amazon выросли в 2024 году, впервые за три года — это следствие масштабного строительства дата-центров, сообщает Bloomberg. Правда, компанию обвиняют в сокрытии реальных объёмов выбросов её ЦОД. Некоторую роль в росте выбросов сыграло и потребление топлива сервисами доставки. В ежегодном отчёте Amazon, посвящённом устойчивому развитию, крупнейший онлайн-ретейлер мира сообщил росте выбросов на 6 % год к году — они составили 68,25 млн т в CO2-эквиваленте (при этом показатель за 2023 год был скорректирован до 64,38 млн т). В 2019 году компания обязалась свести выбросы к нулю к 2040 году, однако с тех пор они выросли на треть. Впрочем, и к этим данным у активистов есть вопросы. Для сравнения, с 2019 по 2023 гг. включительно выбросы Google выросли на 48 %, а за последние 14 лет, по данным НКО Kairos Fellowship, на 1515 %. Amazon, как и её конкуренты, вкладывает немалые ресурсы в строительство и эксплуатацию дата-центров для ИИ-приложений. Всё это требует очень много бетона и стали, которые требуют много энергии при производстве. Да и самим ИИ ЦОД нужно немало электричества. В некоторых регионах энергокомпании возвращаются к использованию газа и угля для генерации электричества, хотя ещё совсем недавно такие энергоносители теряли популярность. Технологические компании обещали найти более «чистые» источники энергии и свести к минимуму углеродные выбросы. Amazon, как и Alphabet (Google), Meta✴ и Microsoft заключили ряд сделок, связанных с использованием «безуглеродной» атомной энергии в ближайшие годы. В целом сообщалось, что Amazon, Meta✴ и Google помогут утроить мощность АЭС во всём мире к 2050 году. Среди гиперскейлеров Amazon первой обратилась напрямую к АЭС для закупки энергии. Тем временем в 2024 году выбросы Amazon, связанные с закупаемой электроэнергией, выросли на 1 % год к году — впервые с тех пор, как компания начала публиковать соответствующие показатели в 2019 году. Сообщается, что отчасти это связано с повышением потребления электричества. Как заявляют в отчёте Amazon, именно поэтому так важно масштабировать безуглеродную энергетику. В прошлом году Amazon снова стала крупнейшим в мире корпоративным покупателем возобновляемой энергии.

18.07.2025 [17:11], Руслан Авдеев

США намерены ослабить влияние Китая на подводную интернет-инфраструктуру, но у них это вряд ли получитсяВ погоне за технологическим лидерством США, похоже, решили пойти на новые меры. В частности, присутствие китайских технологий в кабелях, от которых зависит инфраструктура США, решено минимизировать — но пока неизвестно, хватит ли у Соединённых Штатов на это ресурсов, сообщает The Register. Глава Федеральной комиссии по связи США (FCC) Брендан Карр (Brendan Carr) объявил, что его ведомство обсуждает правило, которое не только защитит подводные кабели от противников США, но и будет способствовать инвестициям в подводную инфраструктуру. Как и в случае со многими другими технологическими проектами 2025 года, меры принимаются для того, чтобы «ускорить развитие ИИ-инфраструктуры». По словам Карра, поскольку США строят ИИ ЦОД и прочую инфраструктуру, необходимую для лидерства в ИИ и других сферах, подводные телеком-кабели стали «важны как никогда». Чиновник отметил, что на подводные кабели приходится 99 % международного интернет-трафика и они, по его мнению, регулярно подвергаются угрозам. Новые правила предусматривают автоматический запрет компаниям, контролируемым «враждебными государствами», на строительство, эксплуатацию или аренду подводных кабелей. Также запрещается использование «регулируемого» (covered) оборудования в подводной инфраструктуре. Поскольку текст самого правила не опубликован, пока можно только догадываться, о каком именно оборудовании идёт речь. В FCC отказались предъявлять документ или отвечать на дополнительные вопросы журналистов.

Источник изображения: Zulfugar Karimov/unspalsh.com Не исключено, что речь идёт о чём-то, похожем на приказ о постепенной замене в американских телеком-сетях оборудования китайских компаний Huawei и ZTE, подписанный в 2021 году. По данным на июль 2024 года, FCC заявляла, что до полного успеха в этом направлении ещё очень далеко и большинству телеком-компаний не хватает миллиардов долларов на финансирование исполнения. Судя по тому, что этот приказ в полной мере не выполнен в США до сих пор, реализация нового запрета тоже вряд ли будет простой. Проблема безопасности подводных кабелей активно обсуждается в последние годы, а сообщения об атаках на них появляются всё чаще. Причём желающих совершить диверсию, предположительно, немало — от крупных стран до небольших группировок. При этом ежегодно десятки инцидентов с кабелями происходят по естественным причинам. Однако утверждается, что Китай не ограничивается диверсиями в своих прибрежных водах и вредит даже на Балтике, хотя такие атаки не подтверждаются. Европейские страны активно принимают меры для совместной защиты акватории региона. Так, собственные силы для охраны уже выделила Швеция, подводный беспилотник намерена применять Германия, а Китай якобы разрабатывает специальное оружие для уничтожения подводной кабельной инфраструктуры. Правда, слухи порой оборачиваются фарсом. |

|