Материалы по тегу: hpc

|

24.03.2023 [23:38], Сергей Карасёв

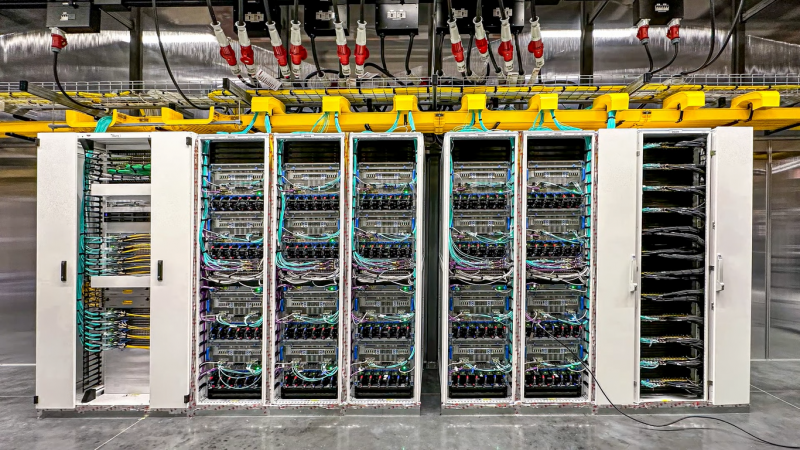

Supermicro представила быструю и тихую рабочую станцию для работы с ИИ: 4 × A100, 2 × Sapphire Rapids, RTX A4000 и СЖОКомпания Supermicro анонсировала рабочую станцию SYS-751GE-TNRT-NV1, предназначенную для ИИ- и HPC-нагрузок. Устройство, как утверждается, обладает высокой производительностью, хорошими показателями энергоэффективности и низким уровнем шума. Применена материнская плата Super X13DEG-QT с парой Intel Xeon 6444Y (16C/32T; 3,6–4,0 ГГц; 270 Вт). В базовую комплектацию входят 512 Гбайт DDR5-4800 в виде 16 модулей по 32 Гбайт. В оснащение включены четыре ускорителя NVIDIA A100 (80 Гбайт, PCIe), попарно соединённых мостиками NVLink и оснащённых водоблоками, и 25GbE-адаптер NVIDIA ConnectX-6 Dx. Кроме того, есть два сетевых порта 10GbE (Intel X550-AT2) и выделенный 1GbE-порт для BMC ASPEED AST2600. Подсистема хранения данных объединяет шесть 1,92-Тбайт NVMe SSD, два из которых объединены в массив RAID 1. Для вывода изображения используется NVIDIA RTX A4000.

Источник изображения: Supermicro Для всех CPU и GPU предусмотрено использование СЖО. Станция также наделена тремя вентиляторами — двумя на 120 мм и одним диаметром 80 мм. Задействованы два блока питания мощностью 2200 Вт каждый. Упомянуты семь слотов расширения PCIe 5.0 x16 FHFL, последовательный порт, разъёмы USB 3.2 Gen1, USB 3.2 Gen2 Type-C и D-Sub. Габариты составляют 218,4 × 454,7 × 701 мм, вес — 44 кг. Диапазон рабочих температур — от +10 до +25 °C. Установлена операционная система Ubuntu 22.04 LTS. В комплекте поставляется подписка на NVIDIA AI Enterprise на 3 года.

23.03.2023 [22:55], Владимир Мироненко

Инстансы AWS EC2 P5 позволят объединить в облаке до 20 тыс. ускорителей NVIDIA H100AWS и NVIDIA объявили о заключении соглашения о многостороннем сотрудничестве с целью создания самой масштабируемой в мире инфраструктуры искусственного интеллекта (ИИ) по требованию, оптимизированной для обучения всё более сложных больших языковых моделей (LLM) и разработки генеративных приложений ИИ. Компании займутся развёртыванием инстансов следующего поколения EC2 P5 на базе ускорителей NVIDIA H100 с продвинутыми сетевыми возможностями и возможностями масштабирования в AWS, что позволит достичь производительности 20 Эфлопс. Каждый инстанс P5 оснащён восемью ускорителями NVIDIA H100. P5 станут первыми инстансами с ускорителями, в которых используются адаптеры AWS Elastic Fabric Adapter (EFA) 2-го поколения с низкой задержкой, скоростью передачи данных 3,200 Тбит/с и поддержкой NVIDIA GPUDirect RDMA, что позволит объединить до 20 тыс. ускорителей. Для сравнения — OCI SuperCluster позволяет объединить до 32 768 ускорителей A100).

Источник изображения: NVIDIA Как отмечено в пресс-релизе NVIDIA, инстансы P5 идеально подходят для обучения и инференса для всё более сложных LLM и моделей компьютерного зрения, лежащих в основе самых требовательных и ресурсоёмких приложений генеративного ИИ. Повышенная производительность инстансов P5 позволяет сократить время обучения моделей машинного обучения (ML) до 6 раз. Ожидается, что инстансы P5 снизят затраты на обучение моделей машинного обучения по сравнению с предыдущим поколением на 40 %. В результате заказчики получают производительность сравнимую с таковой у локальных HPC-кластеров, но с эластичностью и гибкостью AWS. Кроме того, клиенты смогут использовать портфолои сервисов AWS, включая S3, FSx, SageMaker и т.д. Инстансы P5 станут доступны в ближайшие недели в ограниченной предварительной версии.

23.03.2023 [13:26], Сергей Карасёв

Австралийский суперкомпьютер Gadi стал мощнее, получив чипы Intel Xeon Sapphire RapidsКорпорация Fujitsu, по сообщению ресурса HPC Wire, модернизировала суперкомпьютер Gadi, установленный в Национальном университете Австралии в Канберре (NCI). Комплекс получил узлы на новейших процессорах Intel Xeon Sapphire Rapids, что позволило существенно понять общую производительность. В прежней конфигурации в HPC-системе Gadi уже широко применялись различные чипы Intel. В состав суперкомпьютера, в частности, входят 3074 узла, каждый из которых содержит два 24-ядерных процессора Intel Xeon Cascade Lake и 192 Гбайт памяти. Также в состав комплекста входят 804 узла с парой 14-ядерных чипов Broadwell, 192 узла с двумя 16-ядерными процессорами Skylake и 160 узлов, каждый из которых наделён четырьмя ускорителями NVIDIA V100 и двумя 24-ядерными процессорами Intel Xeon Cascade Lake-SP. Наконец, есть 10 узлов с двумя 14-ядерными чипами Intel Broadwell и 512 Гбайт памяти и два узла NVIDIA DGX A100. После модернизации, как сообщается, комплекс получил 720 узлов с парой 52-ядерных процессоров Intel Xeon Sapphire Rapids и 512 Гбайт RAM, объединённых 200G-интерконнектом InfiniBand HDR. О быстродействии обновлённого суперкомпьютера ничего не сообщается, но ранее Gadi обеспечивал пиковую производительность в 15,14 Пфлопс и занимал 62-ю строку в списке Top500. Отмечается, что появление узлов на базе Sapphire Rapids — это лишь первый этап масштабной программы по расширению вычислительных ресурсов NCI. Планируется добавление новых GPU и улучшение подсистемы электропитания. Общие инвестиции в проект составят около $26 млн.

22.03.2023 [22:02], Алексей Степин

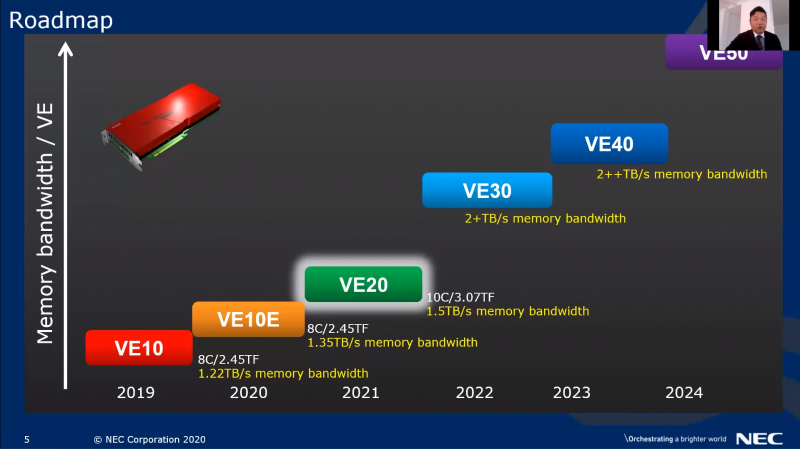

AMD и NVIDIA победили: NEC останавливает разработку уникальных векторных процессоров SX-AuroraЯпонская компания NEC была одной из немногих, отстаивавших собственный уникальный путь в сфере развития вычислительных технологий со своими векторными процессорами SX-Aurora. Хотя данное направление до недавних пор активно развивалось, компания, похоже, не выдержала давления со стороны NVIDIA и AMD и объявила о прекращении разработок новых решений в серии Aurora. Работы над усовершенствованием векторной архитектуры NEC продолжались до конца прошлого года, когда компания объявила о подготовке новых вычислительных узлов SX-Aurora TSUBASA C401-8 на базе ускорителей с 16 блоками Vector Engine 3.0 и 96 Гбайт интегрированной памяти HBM2. И хотя в августе этого года в Научном центре Университета Тохоку будет запущен новый суперкомпьютер на их основе, новых разработок в этой сфере не будет.

Вычислительный модуль SX-Aurora TSUBASA C401-8. Источник изображений здесь и далее: NEC Как отметил Сатоши Мацуока (Satoshi Matsuoka), глава крупнейшего в Японии суперкомпьютерного центра RIKEN, где был создан суперкомпьютер Fugaku, NEC неслучайно объявила об отказе от разработки нового поколения процессоров SX-Aurora. Хотя в целях компании значилось 10-кратное повышение энергоэффективности, теперь NEC считает, что эта цель может быть достигнута с использованием стандартных коммерческих ускорителей. Главной причиной называется появление решений AMD и NVIDIA, на голову превосходящих все наработки NEC. В частности, упоминается AMD Instinct MI300. При этом отмечено, что это решение «похоронило» бы даже новое поколение SX-Aurora, когда речь заходит о ПСП. Целью NEC был показатель 2+ Тбайт/с, в то время как новинка AMD, располагая памятью HBM3 с 8192-бит шиной, может обеспечить 6,8 Тбайт/с.

Планы NEC по развитию VE-архитектуры. Похоже, им уже не суждено сбыться Также «естественным врагом» SX-Aurora является NVIDIA Grace Hopper с его мощной процессорной частью и развитой инфраструктурой NVLink, демонстрирующий к тому же выдающуюся энергоэффективность. Примечательно, что оба продукта от AMD и NVIDIA являются APU, то есть гибридными чипами, объединяющими ускорители и CPU собственной разработки, а также быструю память. Финансовый кризис 2009 года ударил по разработкам NEC в области процессоростроения сильно, но ситуацию тогда спасла общая незрелость рынка GPGPU и технологии HBM. Сейчас на это надеяться нельзя, да и ситуация с точки зрения программной экосистемы в мире HPC говорит не в пользу NEC. По всей видимости, прямо на наших глазах ещё одна уникальная вычислительная архитектура становится достоянием истории. При этом в Японии пока что сохраняется ещё одна уникальная отечественная архитектура — PEZY-SC. Arm-процессоры Fujitsu A64FX, ставшие основой Fugaku, тоже достаточно уникальны, однако их наследники в лице MONAKA переориентированы на более массовый сегмент. Таким образом, собственные массовые HPC-решения сейчас есть только у Китая, которому новейшие американские и британские ускорители достанутся в кастрированном виде.

22.03.2023 [00:22], Сергей Карасёв

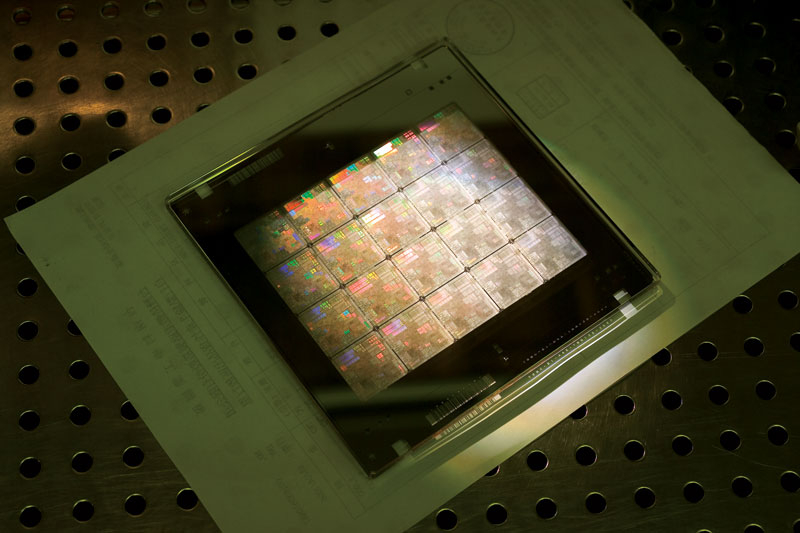

Решения NVIDIA в области вычислительной литографии заложат основу для выпуска чипов нового поколенияNVIDIA в рамках GTC 2023 объявила о новом решении, которое привносит возможности ускорения работы в сферу вычислительной литографии. Это позволит крупным игрокам полупроводниковой отрасли, таким как ASML, TSMC и Synopsys, ускорить разработку и производство микросхем нового поколения по мере приближения характеристик чипов к физическим ограничениям. Речь идёт о библиотеке NVIDIA cuLitho для вычислительной литографии. Говорится, что её интеграцией уже занимаются контрактный производитель TSMC, а также фирма Synopsys, работающая в области САПР для проектирования электроники. Производитель оборудования ASML также сотрудничает с NVIDIA в области GPU и cuLitho. Эти компании намерены встроить cuLitho в своё ПО, производственные процессы и системы на базе чипов с архитектурой NVIDIA Hopper. Говорится, что предприятия, использующие cuLitho, смогут ежедневно производить в 3–5 раз больше фотошаблонов при в 9 раз меньших затратах энергии по сравнению с традиционными методами.

Источник изображения: NVIDIA Предполагается, что решение NVIDIA позволит проектировать микросхемы по более «тонкому» техпроцессу, нежели это возможно сейчас. Кроме того, сократится время выхода продуктов на рынок и повысится энергоэффективность крупных дата-центров, отвечающих за управление производственными процессами. В частности, с применением cuLitho может быть заложена основа для выпуска изделий с нормами 2 нм и менее. Утверждается, что, работая на базе GPU разработки NVIDIA, платформа cuLitho обеспечивает скачок производительности до 40 раз по сравнению с обычной литографией. Это даёт возможность 500 системам NVIDIA DGX H100 заменить 40 000 CPU благодаря параллельной обработке различных элементов вычислительной литографии. Кроме того, значительно снижается энергопотребление ЦОД и сокращается негативное воздействие на окружающую среду.

21.03.2023 [21:43], Сергей Карасёв

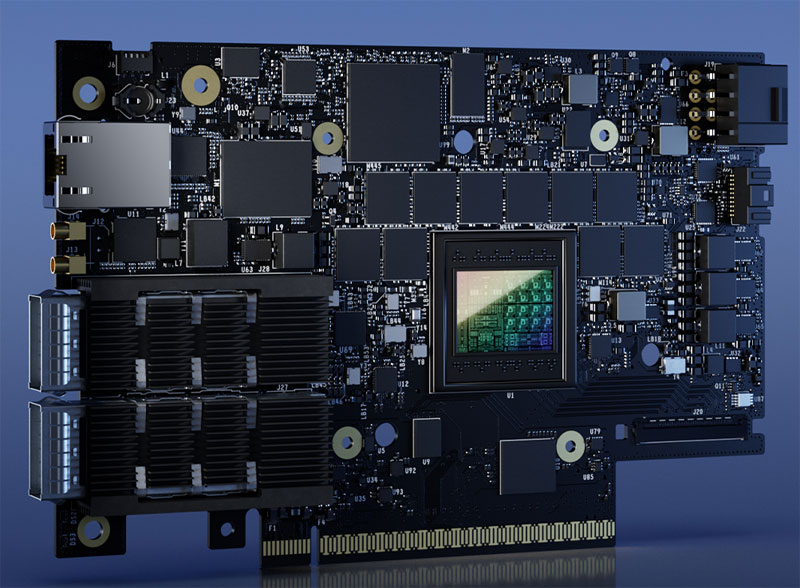

Облако Oracle взяло на вооружение DPU NVIDIA BlueField-3Компания NVIDIA объявила о том, что облачная инфраструктура Oracle Cloud Infrastructure (OCI) начала внедрение DPU NVIDIA BlueField для высокопроизводительных вычислений. Это позволит снять нагрузку с CPU и повысить общую эффективность ЦОД. Кроме того, новинка нашла место в инфраструктуре Baidu, JD, Tencent, CoreWeave и Microsoft Azure. Речь идёт о применении 400Gbe-модулей BlueField-3. Благодаря возможности обеспечить разгрузку, ускорение и изоляцию широкого спектра процессов в работе сети, СХД и решений по безопасности, DPU BlueField позволяют создать безопасную и ускоренную инфраструктуру для решения различных задач в любой среде — от облака и дата-центра до периферийных устройств. Именно эти DPU явяются одним из ключевых компонентов платформы NVIDIA DGX Cloud в OCI.

Источник изображения: NVIDIA Благодаря BlueField-3, как отмечается, ресурсы CPU в дата-центрах могут быть перенаправлены на обработку бизнес-приложений. BlueField-3 трансформируют традиционные среды облачных вычислений в ускоренную, энергоэффективную и безопасную инфраструктуру для обработки ресурсоёмких рабочих нагрузок генеративного ИИ. Тесты показывают снижение энергопотребления до 24 % на серверах с DPU BlueField по сравнению с традиционными системами. «DPU NVIDIA BlueField-3 являются ключевым компонентом нашей стратегии по созданию современной устойчивой облачной инфраструктуры с высочайшей производительностью», — отметил Клэй Магуирк (Clay Magouyrk), исполнительный вице-президент Oracle Cloud Infrastructure. Программный фреймворк NVIDIA DOCA позволяет разработчикам создавать инфраструктуры нового поколения для дата-центров, обеспечивая высокопроизводительные, программно-определяемые облачные сервисы с ускорением на основе DPU и высоким уровнем безопасности по модели Zero Trust.

21.03.2023 [20:45], Владимир Мироненко

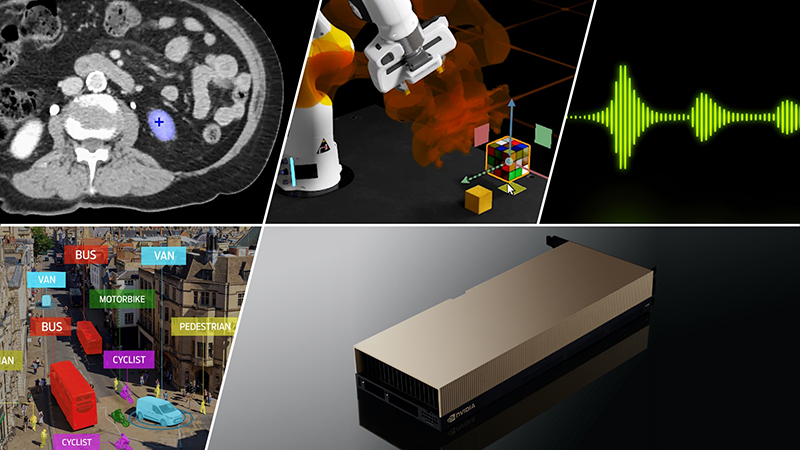

NVIDIA запустила облачный сервис DGX Cloud — доступ к ИИ-супервычислениям прямо в браузереNVIDIA запустила сервис ИИ-супервычислений DGX Cloud, предоставляющий предприятиям доступ к инфраструктуре и программному обеспечению, необходимым для обучения передовых моделей для генеративного ИИ и других приложений. DGX Cloud предлагает выделенные ИИ-кластеры NVIDIA DGX в сочетании с фирменным набором ПО NVIDIA. С его помощью предприятие сможет получить доступ к облачному ИИ-суперкомпьютеру, используя веб-браузер и без надобности в приобретении, развёртывании и управлении собственной HPC-инфраструктурой. Правда, удовольствие это всё равно не из дешёвых — стоимость инстансов DGX Cloud начинается от $36 999/мес., причём деньги получает в первую очередь сама NVIDIA. Для сравнения — полностью укомплектованная система DGX A100 в Microsoft Azure обойдётся примерно в $20 тыс. Облачные кластеры DGX предлагаются предприятиям на условиях ежемесячной аренды, что гарантирует им возможность быстро масштабировать разработку больших рабочих нагрузок. «DGX Cloud предоставляет клиентам мгновенный доступ к супервычислениям NVIDIA AI в облаках глобального масштаба», — сообщил Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA.

Источник изображения: NVIDIA Развёртыванием инфраструктуры DGX Cloud компания NVIDIA будет заниматься в сотрудничестве с ведущими поставщиками облачных услуг. Первым среди них стала платформа Oracle Cloud Infrastructure (OCI), предлагающая суперкластер (SuperCluster) с объединёнными RDMA-сетью (в том числе на базе BlueField-3 и Connect-X7) системами DGX (bare metal), которые дополняет высокопроизводительное локальное и блочное хранилище. Cуперкластер может включать до 32 768 ускорителей, но этот рекорд был поставлен с использованием DGX A100, а вот предложение DGX H100 пока что ограничено. В следующем квартале похожее решение появится в Microsoft Azure, а потом в Google Cloud и у других провайдеров. Первыми пользователями DGX Cloud стали Amgen, одна из ведущих мировых биотехнологических компаний, лидер рынка страховых технологий CCC Intelligent Solutions (CCC) и провайдер цифровых бизнес-платформ ServiceNow. «Мощные вычислительные и многоузловые возможности DGX Cloud позволили нам в 3 раза ускорить обучение белковых LLM с помощью BioNeMo и до 100 раз ускорить анализ после обучения с помощью NVIDIA RAPIDS по сравнению с альтернативными платформами», — сообщил представитель Amgen. Для управления нагрузками в DGX Cloud предлагается NVIDIA Base Command. Также DGX Cloud включает в себя набор инструментов NVIDIA AI Enterprise для создания и запуска моделей, который предоставляет комплексные фреймворки и предварительно обученные модели для ускорения обработки данных и оптимизации разработки и развёртывания ИИ. DGX Cloud предоставляет поддержку экспертов NVIDIA на всех этапах разработки ИИ. Клиенты смогут напрямую работать со специалистами NVIDIA, чтобы оптимизировать свои модели и быстро решать задачи разработки с учётом сценариев отраслевого использования.

21.03.2023 [19:15], Сергей Карасёв

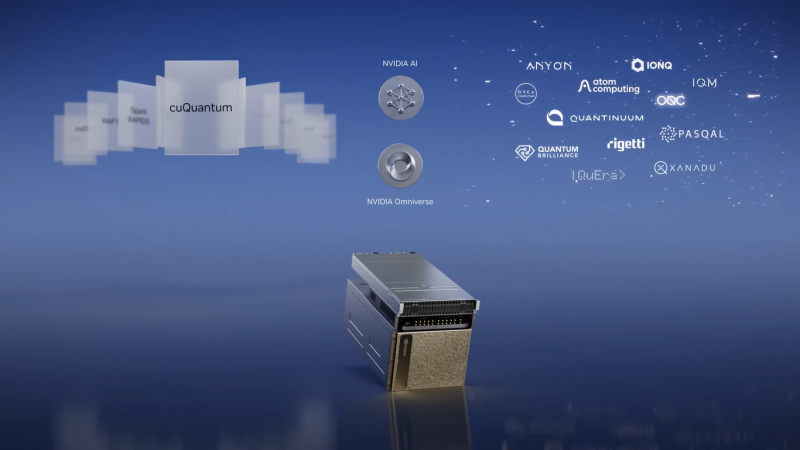

NVIDIA представила систему DGX Quantum для гибридных квантово-классических вычисленийКомпания NVIDIA в партнёрстве с Quantum Machines анонсировала DGX Quantum — первую систему, объединяющую GPU и квантовые вычисления. Решение использует новую открытую программную платформу CUDA Quantum. Утверждается, что система предоставляет революционно архитектуру для исследователей, работающими с гибридными вычислениями с низкой задержкой. NVIDIA DGX Quantum объединяет средства ускоренных вычислений на базе Grace Hopper (Arm-процессор + ускоритель H100), модели программирования с открытым исходным кодом CUDA Quantum и передовую квантовую управляющую платформу Quantum Machines OPX+. Такая комбинация позволяет создавать ресурсоёмкие приложения, сочетающие квантовые вычисления с современными классическими вычислениями. При этом в числе прочего обеспечивается работа гибридных алгоритмов и коррекция ошибок.

Источник изображения: NVIDIA Представленное решение предполагает соединение Grace Hopper и Quantum Machines OPX+ посредством интерфейса PCIe. Это обеспечивает задержку менее микросекунды между ускорителем и блоками квантовой обработки (QPU). Отмечается, что OPX+ — это универсальная система квантового управления. Таким образом, можно максимизировать производительность QPU и предоставить разработчикам новые возможности при использовании квантовых алгоритмов. Системы Grace Hopper и OPX+ можно масштабировать в соответствии с потребностями — от QPU с несколькими кубитами до суперкомпьютера с квантовым ускорением. О намерении интегрировать CUDA Quantum в свои платформы уже заявили компании по производству квантового оборудования Anyon Systems, Atom Computing, IonQ, ORCA Computing, Oxford Quantum Circuits и QuEra, разработчики ПО Agnostiq и QMware, а также некоторые суперкомпьютерные центры.

18.03.2023 [21:52], Сергей Карасёв

Samsung SDS построила в Южной Корее новый облачный дата-центр, ориентированный на ИИ, HPC и Big DataSamsung SDS, подразделение IT-сервисов и облачных услуг южнокорейского гиганта, по сообщению ресурса Datacenter Dynamics, открыло в Южной Корее новый ЦОД для организации HPC-вычислений. Планируется, что платформа Samsung Cloud Platform (SCP) станет доступна более широкому кругу клиентов. В глобальном масштабе Samsung SDS оперирует 17 дата-центрами. В рамках программы по расширению облачных услуг Samsung запустила свой третий южнокорейский дата-центр: он расположен в Донтане в провинции Кёнгидо (Gyeonggi-do). Это, как утверждается, первый в стране специализированный ЦОД для HPC-задач, спроектированный с прицелом на ИИ-приложения и анализ больших данных. Площадка получила название Dongtan IDC. Дата-центр сейчас включает четыре зала. Коэффициент энергоэффективности PUE равен 1,1 — используется естественное охлаждение благодаря ветрам и прохладному климату. Введя этот ЦОД в эксплуатацию, компания рассчитывает сократить выбросы парниковых газов на 21 443 т к 2035 году. Показатели мощности ЦОД не раскрываются. Отмечается, что Dongtan IDC — это единственный кампус в Южной Корее, который предлагает взаимное резервирование между тремя дата-центрами, что обеспечивает ему дополнительную избыточность.

18.03.2023 [16:18], Сергей Карасёв

Lenovo представила шасси ThinkSystem D4390 для СХД высокой плотностиКитайская компания Lenovo анонсировала DAS ThinkSystem D4390, предназначенную для создания программно определяемых СХД высокой плотности. Новинка, как утверждается, подходит для HPC-сервисов, объектного хранения, частных и гибридных облаков, аналитики, а также резервного копирования и архивирования больших объёмов информации.

Источник изображения: Lenovo Допускается применение накопителей SAS HDD, NL-SAS HDD и SAS SSD для обеспечения высокой производительности и большой ёмкости. В корпусе предусмотрены посадочные места для 90 устройств LFF с возможностью горячей замены (поддерживаются 12 модулей SAS SSD объёмом до 800 Гбайт каждый). К примеру, могут применяться 18-Тбайт жёсткие диски NL-SAS со скоростью вращения шпинделя 7200RPM: в этом случае суммарная «сырая» ёмкость достигает 1,62 Пбайт. Могут быть организованы массивы RAID 0/1/10/5/50/6/60 или JBOD. Допускается использование хост-контроллеров ThinkSystem RAID 940-8e PCIe 12Gb, ThinkSystem 440-16e SAS/SATA PCIe Gen4 12Gb HBA и ThinkSystem 440-8e PCIe 12Gb SAS/SATA HBA. Доступны четыре 24-Гбит/с порта Mini-SAS HD (SFF-8644). Возможно последовательное соединение шасси для масштабирования СХД. Шасси оборудовано четырьмя блоками питания 80 Plus Titanium мощностью 1300 Вт каждый с возможностью горячей замены и резервированием. Система воздушного охлаждения включает пять 80-мм вентиляторов с горячей заменой. Диапазон рабочих температур — от +5 до +35 °C. 4U-шасси имеет габариты 175,3 × 446,0 × 1080,0 мм. Минимальная масса составляет 45 кг. На новинку предоставляется трёхлетняя гарантия. |

|