Материалы по тегу: cloud

|

29.07.2025 [14:30], Владимир Мироненко

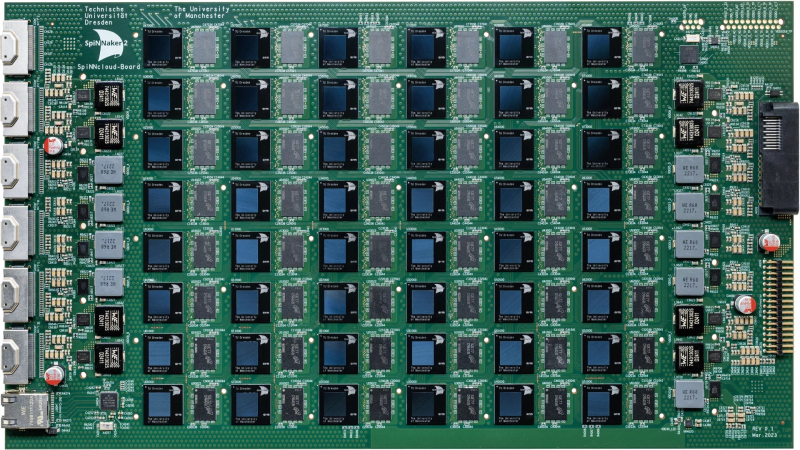

Стартап SpiNNcloud поставит Лейпцигскому университету «нейроморфный» суперкомпьютер для создания новых лекарств in silicoСтартап SpiNNcloud Systems из Дрездена (Германия) сообщил о заключении сделки на поставку Лейпцигскому университету нейроморфного суперкомпьютера, основанного на принципах функционирования человеческого мозга и предназначенного для разработки новых лекарственных препаратов. Суперкомпьютер будет использоваться учёными для моделирования сворачивания белков в рамках исследований в области персонализированной медицины, объединяющей достижения геномики, ИИ, робототехники и новейших диагностических технологий. Стоимость сделки не разглашается. В суперкомпьютере применена высокопараллельная архитектура с 48 чипами SpiNNaker2 на серверной плате, каждый из которых содержит 152 Arm-ядра со специализированными ускорителями и потребляет 0,8–2,5 Вт. Вся система, оснащённая 4320 чипами с 656 640 ядрами, помещается в одну стойку, но университет решил развернуть её в двух стойках, сообщил Гектор Гонсалес (Hector Gonzalez), соучредитель и генеральный директор SpiNNcloud, отметив, что общий энергетический бюджет системы составляет 25 кВт. Новый подход к разработке лекарств использует исключительную параллельность и масштабируемость суперкомпьютера для развёртывания миллионов небольших моделей, которым поручено находить соответствия между молекулами и профилями пациентов. Эта конструкция обеспечивает эффективные, событийно-ориентированные вычисления, позволяя выполнять сложное моделирование и разрабатывать новые персонализированные препараты с более высокой скоростью сходимости и при более низком энергопотреблении по сравнению с традиционными системами на базе GPU. «Точное и детализированное управление процессорами позволяет использовать очень разреженный маршрут, не задействуя все ядра, — поясняет Гонсалес. — Это один из фундаментальных аспектов, который очень сложно реализовать на GPU, поскольку GPU устроен как каскад вычислительных блоков, которые необходимо задействовать максимально полно, чтобы добиться синхронной эффективности». «Архитектура SpiNNcloud делает возможным скрининг миллиардов молекул in silico (виртуальное клиническое исследование)», — сообщил Кристиан Майр (Christian Mayr), соучредитель SpiNNcloud. По его словам, изначально разработанная для моделирования биологических нейронных сетей серверная система SpiNNcloud адаптирована для массивно-параллельного выполнения небольших гетерогенных задач. Прототип нейронной сети позволяет провести скрининг 20 млрд молекул менее чем за час — это на два порядка быстрее, чем на 1000 CPU-ядер. Гонсалес сообщил ресурсу EE Times, что индивидуальный подход к разработке лекарств, используемый в персонализированной медицине, хорошо вписывается в архитектуру SpiNNcloud. «Это множество небольших моделей, которые взаимодействуют друг с другом через чрезвычайно быструю сеть», — пояснил он. «Наша вычислительная архитектура <…> уникально подходит для развёртывания эффективных алгоритмов, требующих динамической разреженности и экстремального параллелизма», — добавил глава SpiNNcloud. «Экстремальный параллелизм SpiNNcloud делает их идеально подходящими для задач, связанных со сворачиванием белков, например, для поиска низкомолекулярных лекарственных препаратов, — отметил Йенс Майлер (Jens Meiler), профессор Института Александра фон Гумбольдта по Интернету и обществу и директор Института поиска лекарственных препаратов Лейпцигского университета. — «Фолдинг белков можно рассматривать как задачу оптимизации, в которой белок стремится найти своё наименьшее энергетическое состояние. Суперкомпьютеры SpiNNcloud хорошо справляются с такими задачами». Самая крупная система, развёрнутая SpiNNcloud на данный момент, включает 30 тыс. чипов (более 5 млрд вычислительных элементов) в Дрезденском университете. «Максимально возможная система, которую мы можем спроектировать, – это 16 стоек, — говорит Гонсалес. — При более чем 16 стойках будет сложно поддерживать достаточную связанность между моделями». По его словам, можно было бы развернуть в Лейпциге и более крупный суперкомпьютер с большим числом ядер, но компании пришлось учитывать финансовые ограничения университета. Как сообщает EE Times, SpiNNcloud также тестирует своё оборудование в новых исследовательских направлениях, основанных на классических методах глубокого обучения, в частности, в работе с MoE-моделями. По словам Гонсалеса, архитектура SpiNNcloud хорошо подходит для таких задач. Разработчик выразил надежду, что архитектуры, вдохновлённые принципами работы мозга, такие как SpiNNcloud, позволят создавать новые типы моделей, невозможные для реализации на массовом оборудовании.

04.07.2025 [08:39], Руслан Авдеев

Облако с ИИ: Alibaba расширяет ЦОД в Малайзии и на ФилиппинахAlibaba Group Holding развивает дата-центры в Малайзии и на Филиппинах на волне популярности ИИ-проектов. На днях её облачное подразделение запустило свой третий ЦОД в Малайзии, а в октябре намерено открыть второй дата-центр на Филиппинах, сообщает Bloomberg. Также Alibaba Cloud откроет глобальный центр компетенций в соседнем Сингапуре, что поможет ускорить внедрение ИИ в различных сферах — более 5 тыс. предприятий и 100 тыс. разработчиков получат доступ к передовым ИИ-моделям. По словам главы Alibaba Эдди Ву (Eddie Wu), долгосрочной стратегией компании является глобализация её бизнеса. В следующие три года Alibaba ускорит создание глобальной облачной сети в Китае, Японии, Южной Корее, странах Юго-Восточной Азии и на Ближнем Востоке. Планируется и экспансия в Европе, США, Таиланд и Мексике. Всего компания намерена потратить на ИИ-инфраструктуру почти $53 млрд. Пока неизвестно, насколько планы китайского IT-гиганта осуществимы, поскольку совсем недавно появилась информация о масштабном сотрудничестве Малайзии с Huawei в сфере ИИ, но спустя буквально пару дней власти страны дезавуировали прежние заявления на высшем уровне, вероятно, под давлением США. Впрочем, Alibaba не испытывает такого санкционного давления, как Huawei, и широко известна операциями в сфере электронной коммерции за пределами Китая. Компания давно занимается системами искусственного интеллекта и создаёт специальные приложения на основе ИИ-моделей Qwen, параллельно развивая облачные сервисы. После выхода на мировую арену китайского ИИ-стартапа DeepSeek Эдди Ву заявил в феврале 2025 года, что главной целью Alibaba стало создание общего искусственного интеллекта, не уступающего возможностями человеческому сознанию. Это является и целью отрасли в целом.

10.06.2025 [12:15], Руслан Авдеев

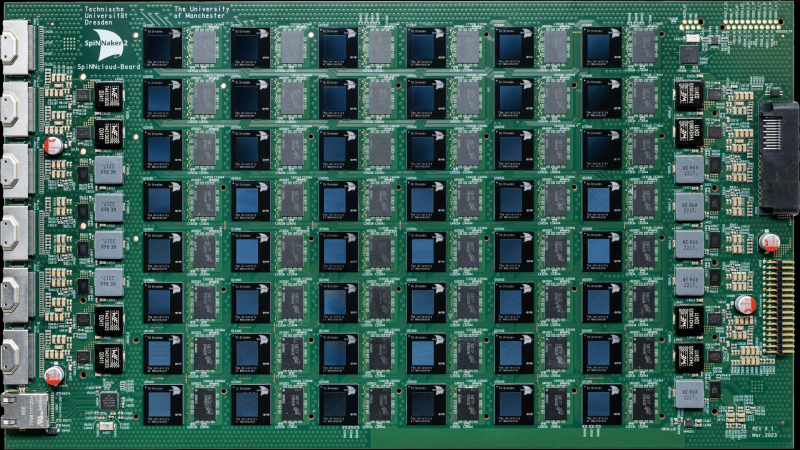

Нейроморфный суперкомпьютер SpiNNaker2, способный имитировать до 180 млн нейронов, прописался в Сандийских национальных лабораторияхНемецкая SpiNNcloud Systems, занимающаяся разработкой нейроморфных суперкомпьютеров, ввела в эксплуатацию в Сандийских национальных лабораториях (Sandia National Laboratories, SNL) суперкомпьютер SpiNNaker2, созданный по подобию человеческого мозга. Это имеет большое значение для развития вычислительной техники и выполнения задач, связанных с обеспечением национальной безопасности, сообщает Silicon Angle. SNL — это научно-исследовательский комплекс правительства США, занимающийся проектами в области национальной безопасности, энергетики и передовых технологических инноваций. Sandia управляется одним из специализированных подразделений Министерства энергетики США (DoE) и более всего известна проектами, связанными с ядерным арсеналом Соединённых Штатов и обеспечением его сохранности и эффективности. Суперкомпьютер SpiNNaker2 анонсировали в мае 2024 года. Он представляет собой высокопроизводительную нейроморфную компьютерную систему, основанную на принципах работы человеческого мозга. Платформа создана разработчиком архитектур Arm и SpiNNaker1 Стивом Фербером (Steve Furber) и использует множество чипов с низким энергопотреблением для ИИ-вычислений и выполнения других задач.

Источник изображения: SpiNNcloud Systems Как сообщает Datacenter Dynamics, система использует тысячи Arm-ядер для имитации работы нейронов мозга. В Sandia National Labs развёрнута одна из крупнейших в мире конфигураций SpiNNaker из 24 плат о 175 104 ядрами, способная моделировать 150–180 млн нейронов, что делает её одной из пяти самых мощных нейроморфных платформ в мире для исследований в области ИИ и нейротехнологий. Впрочем, от человеческого мозга со 100 млрд нейронов система, по данным Blocks & Files, пока ещё сильно отстаёт. SpiNNaker2 использует высокопараллельную архитектуру из 48 чипов SpiNNaker2 на плату, каждый из которых имеет по 152 ядра на основе Arm, 20 Мбайт SRAM и специализированные ускорители. Конструкция обеспечивает эффективные вычисления, позволяющие системе выполнять сложные симуляции с более низким энергопотреблением в сравнении с ИИ-ускорителями традиционного типа. Высокая эффективность SpiNNaker2 делает его особенно ценным для выполнения задач в сфере обеспечения национальной безопасности. Каждая плата оснащена 96 Гбайт оперативной памяти LPDDR4. В конфигурации с 90 платами система имеет 8640 Гбайт DRAM, а в максимальном варианте (1440 плат) — 138 240 Гбайт. Архитектура использует высокоскоростную межчиповую связь, что вообще исключает необходимость в централизованном хранилище данных, а огромный объём памяти позволяет эффективно моделировать крупномасштабные нейронные сети.

Источник изображения: SpiNNcloud Systems SpiNNaker2 интегрирован в существующие HPC-системы и работает без ОС или дисков, достигая высокой скорости работы за счет хранения данных в SRAM и DRAM. Система использует стандартные параллельные порты для загрузки и выгрузки данных, а её текущая максимальная конфигурация включает более 10,5 млн ядер, что позволяет моделировать нейронные сети в режиме «биологического реального времени». По словам представителя Sandia, хотя системы на базе классических ускорителей способны повысить эффективность суперкомпьютеров в сравнении с обычными CPU, системы на основе «архитектуры» человеческого мозга вроде SpiNNaker2 — ещё более привлекательная альтернатива. В SpiNNcloud заявляют, что система поддерживает и следующего поколения алгоритмов систем генеративного ИИ, обеспечивая значительно более эффективный путь развития машинного обучения с применением «динамической разреженности» (dynamic sparsity). По данным сайта SpiNNcloud, в скором будущем появится чип SpiNNext, в 78 раз более энергетически эффективный, чем традиционные ИИ-ускорители.

02.06.2025 [11:47], Руслан Авдеев

Принадлежащая Alibaba турецкая Trendyol Group построит ЦОД на 48 МВт в АнкареСпециалист в области электронной коммерции Trendyol Group построит дата-центр в Анкаре. Объявлено о партнёрстве с Castle Investments их ОАЭ для строительства и эксплуатации ЦОД на 48 МВт. Ввод объекта в эксплуатацию должен состояться в III квартале 2026 года, сообщает Datacenter Dynamics. Первый этап реализации проекта обеспечит мощность 9,6 МВт. Как заявляют представители компании, новый проект не только помогает лучше обслуживать растущую клиентскую базу, но и подчёркивает приверженность инвестициям в турецкую экономику. В новой сделке эксклюзивным финансовым консультантом выступила Dome Group, которая заявила, что в проект будет вложено около $500 млн. По данным Dome, 49 % мощностей ЦОД Trendyol будет направлено на поддержку расширения внутренних и международных цифровых операций, а остальные предоставят провайдерам облачных услуг и корпоративным пользователям. В Trendyol подчеркнули, что дата-центр в Анкаре значительно повысит качество сервисов компании, предлагаемых национальным и зарубежным клиентам. Помимо прочего, это продемонстрирует уверенность бизнеса в сильной цифровой экосистеме страны.

Источник изображения: Engin Yapici/unsplash.com Castle Investments дополнила, что сочетание опыта арабской компании в предоставлении критически важных для обработки данных объектов с технологическим лидерством Trendyol и масштабной цифровизацией в Турции сделает Ankara Data Hub знаковым проектом и новым «региональным эталоном». Castle Investments принадлежит Тареку Аль Ашраму (Tarek Al Ashram) — основателю оператора ЦОД Gulf Data Hub в ОАЭ, недавно получившего инвестиции от KKR. Помимо использования облаков Alibaba и Google, Trendyol также имеет и собственные мощности. Ранее она сообщала, что распоряжается семью залами в трёх ЦОД. Ещё раньше сообщалось, что в 2019 году компания владела одним ЦОД на 30 стоек и 500 серверов, то к 2022 году она выросла до трёх объектов (в самой компании их называют «Земля», «Марс» и «Венера», т.е. Earth, Mars и Venus) от трёх разных провайдеров. Trendyol основана в 2010 году и контролируется китайской Alibaba, обслуживая более 40 млн клиентов по всему миру. В начале 2023 года Alibaba объявила о планах создания ЦОД недалеко от Анкары в Темелли (Temelli). Потенциальные спецификации или сроки создания дата-центров не раскрывались, о создании облачного региона в Турции Alibaba Cloud тоже не сообщала. Пока нет ясности, связаны ли прежние анонсы Alibaba с объявлением Trendyol. В мае Alibaba Cloudподтвердила планы расширения облачной сети на $52,7 млрд.

28.05.2025 [15:03], Руслан Авдеев

Alibaba Cloud подтвердила планы расширения облачной сети на $52,7 млрдГенеральный директор Alibaba Эдди Ву (Eddie Wu) заявил об ускорении глобального расширения Alibaba Cloud — компания намерена создать «единую глобальную облачную сеть», вложив в этот проект ¥380 млрд ($52,7 млрд), сообщает Datacenter Dynamics. Ранее в принадлежащем Alibaba издании South China Morning Post сообщалось, что компания намерена ускорить создание сети ЦОД, охватывающей Японию, Южную Корею, Юго-Восточную Азию, Ближний Восток, Европу и Америку для предоставления китайским компаниям ИИ-инфраструктуры единого образца как в КНР, так и за рубежом. На сегодня Alibaba Cloud управляет 87 зонами доступности в 29 регионах. В 2025 году компания запустила регион в Мексике и второй дата-центр в Таиланде. Впервые компания рассказала о планах масштабных капиталовложений в феврале 2025 года, позже их подтвердили на фоне роста напряжённости между США и КНР. Соединённые Штаты долгое время ограничивают доступ Китая к передовым ускорителям, поэтому NVIDIA постоянно ослабляет свои чипы для китайского рынка, чтобы те соответствовали экспортным ограничениям. В апреле 2025 года правительство США ввело ограничения на экспорт ускорителей H20, что обойдётся NVIDIA в $5,5 млрд в виде списанных расходов и отказа от продаж на сумму $15 млрд.

Источник изображения: Poodar Chu/unsplash.com Развивая глобальную облачную сеть, Alibaba позволит своим китайским клиентам получать доступ к ИИ-инфраструктуре за рубежом, что особенно важно в условиях западных санкций. Многие китайские компании, как уже сообщалось, используют зарубежные облачные сервисы для обхода ограничений на поставку ИИ-оборудования в Поднебесную. В Alibaba уже подчёркивали, что западные масштабные инвестиции в ИИ-инфраструктуру напоминают пузырь. Для сравнения — Microsoft пообещала потратить $80 млрд, Amazon — $100 млрд, Google — $75 млрд, а Meta✴ — от $60 до $65 млрд. По итогам квартала, закончившегося 31 марта 2025 года, выручка Alibaba Cloud выросла на 18 % год к году до $4,152 млрд, что в компании объяснили высоким спросом на ИИ. Утверждается, что речь идёт о трёхзначном росте год к году в процентном отношении седьмой квартал подряд. По словам руководства Alibaba, если ранее ИИ активно внедряли преимущественно интернет-компании, то теперь можно увидеть множество сценариев использования в других секторах. ИИ при этом оказался мощным стимулом для перехода в облака.

21.05.2025 [10:39], Владимир Мироненко

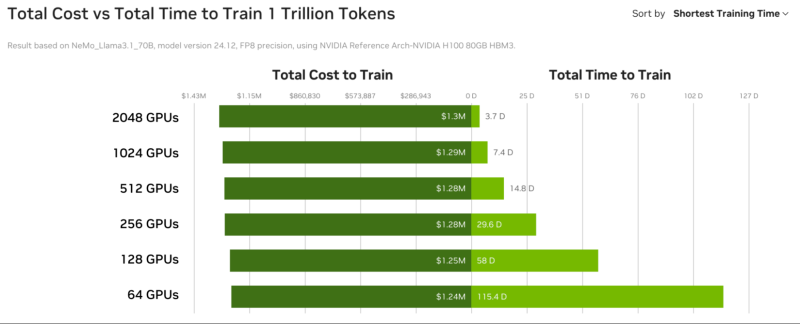

GPU-маркетплейс NVIDIA DGX Cloud Lepton упростит доступ к дефицитным ИИ-ускорителямNVIDIA анонсировала GPU-маркетплейс NVIDIA DGX Cloud Lepton, которая позволит разработчикам со всего мира, создающим агентские и другие ИИ-приложения использовать NVIDIA Blackwell и другие модели ускорителей в глобальной сети партнёрских облаков (NCP): CoreWeave, Crusoe, Firmus, Foxconn, GMI Cloud, Lambda, Nebius, Nscale, Softbank и Yotta Data Services. Ожидается, что ведущие провайдеры облачных услуг и другие GPU-маркетплейсы также присоединятся к DGX Cloud Lepton. Разработчики смогут использовать вычислительные мощности ускорителй в определённых регионах как для вычислений по требованию, так и на постоянной основе. «NVIDIA DGX Cloud Lepton свяжет нашу сеть глобальных поставщиков облачных GPU с разработчиками в сфере ИИ, — заявил основатель и генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang). — Вместе с нашими NCP мы строим ИИ-фабрику планетарного масштаба». По замыслу NVIDIA, платформа DGX Cloud Lepton поможет решить критическую задачу обеспечения разработчиков надёжными, высокопроизводительными ресурсами ускорителей путём унификации доступа к облачным ИИ-сервисам и мощностям собственных ускорителей. Платформа интегрирована с программным стеком NVIDIA, включая микросервисы NIM и NeMo, Blueprints и Cloud Functions. В числе основных преимуществ новой платформы компания назвала:

А для самих провайдеров, участвующих в DGX Cloud Lepton, предоставляется ПО для управления, которое обеспечивает диагностику состояния ускорителей в реальном времени и автоматизирует анализ первопричин возникших проблем, избавляя от ручной диагностики и сокращая время простоев. NVIDIA также анонсировала инициативу Exemplar Clouds, предназначенную для стандартизации прозрачного сравнительного анализа облачной ИИ-инфраструктуры. Это предложение должно решить серьёзную проблему, с которой сталкиваются разработчики и предприятия, развёртывающие рабочие ИИ-нагрузки — прогнозирование эффективности, надёжности и ценовой эффективности облачной платформы. Exemplar Clouds использует NVIDIA DGX Cloud Benchmarking, комплексный набор инструментов и рекомендаций для оптимизации производительности облачных ИИ-нагрузок и количественной оценки связи между стоимостью и производительностью.

24.03.2025 [20:02], Владимир Мироненко

ИИ в один клик: NVIDIA и Equinix предложат готовые к использованию кластеры DGX GB300 и DGX B300 в 45 регионах по всему мируЧтобы удовлетворить растущий спрос на ИИ-инфраструктуру, NVIDIA представила NVIDIA Instant AI Factory — управляемый сервис на базе платформ NVIDIA DGX SuperPOD с ускорителями Blackwell Ultra и ПО NVIDIA Mission Control. NVIDIA сообщила, что её партнёр Equinix станет первой компанией, которая предложит новые системы DGX GB300 и DGX B300 в своих предварительно сконфигурированных ЦОД с жидкостным или воздушным охлаждением, готовых к обработке ИИ-нагрузок и расположенных на 45 рынках по всему миру. Как пишет SiliconANGLE, Тони Пейкдей (Tony Paikeday), старший директор NVIDIA по маркетингу продуктов и систем ИИ, заявил, что партнёрство с Equinix позволит компании выйти на более чем 45 рынков по всему миру «с предварительно настроенными объектами, которые готовы в зависимости от спроса клиентов масштабировать, эксплуатировать и управлять ИИ-инфраструктурой». NVIDIA отметила, что сервис предоставит предприятиям полностью готовые ИИ-фабрики, оптимизированные для обучения современных моделей и рабочих нагрузок моделей рассуждений в реальном времени, что избавит от многомесячного планирования инфраструктуры перед развёртыванием. Поскольку Equinix предоставляет средства и инфраструктуру для разработки ИИ, Пейкдей возлагает большие надежды на платформу SuperPOD и считает, что она окажет позитивное влияние на развёртывание ИИ компаниями. «Equinix — ключевой компонент этой платформы, потому что вам нужно жидкостное охлаждение, вам нужны ЦОД следующего поколения, вам нужны сверхскоростные соединения с внешним миром, чтобы передавать эти данные», — заявил он.

23.02.2025 [22:52], Владимир Мироненко

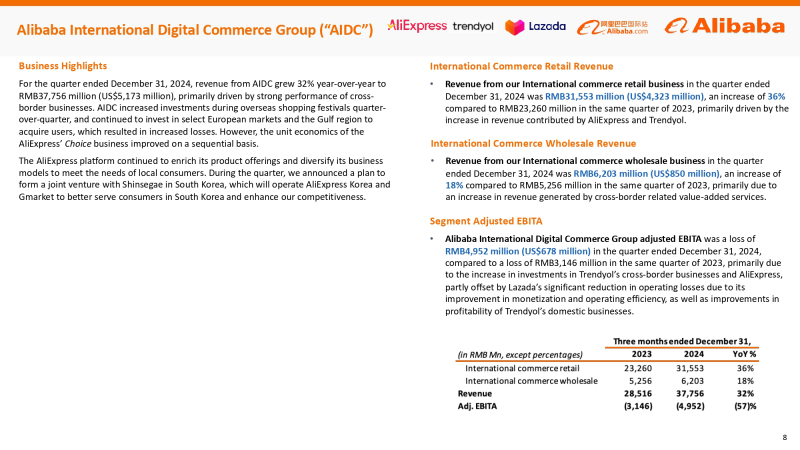

Alibaba в ближайшие три года инвестирует в ИИ и облака $52 млрд — больше, чем за десять лет до этогоAlibaba Group Holding Limited сообщила финансовые результаты III квартала 2024 финансового года, закончившегося 31 декабря 2024 года, которые превысили прогнозы аналитиков. Выручка компании составила ¥280,15 млрд ($38,38 млрд), что на 8 % больше результата аналогичного квартала предыдущего финансового года и выше консенсус-прогноза 17 аналитиков, опрошенных LSEG, в размере ¥279,34 млрд. Инвесторы позитивно оценили квартальные итоги, а также планы китайского технологического гиганта больше инвестировать в электронную коммерцию и ИИ. Благодаря этому на торгах Гонконгской фондовой биржи акции Alibaba поднялись в цене более чем на 10 %, достигнув самого высокого уровня за более чем три года, пишет Reuters. Американские депозитарные расписки компании выросли примерно на 12 % на утренних торгах в Нью-Йорке после публикации результатов, демонстрируя самый большой однодневный процентный прирост с сентября прошлого года, сообщила газета The Wall Street Journal. Согласно Reuters, стоимость акции Alibaba выросла с начала года на 60 %. Чистая прибыль (GAAP), причитающаяся держателям обыкновенных акций, составила ¥48,95 млрд ($6,71 млрд), что значительно превышает прошлогодний результат в размере ¥14,43 млрд ($1,98 млрд) и консенсус-прогноз аналитиков от LSEG в размере ¥40,6 млрд ($5,56 млрд). Чистая прибыль (GAAP) на разводнённую акцию составила ¥2,55 ($0,35). Скорректированная чистая прибыль (Non-GAAP) за квартал составила ¥51,07 млрд ($7,0 млрд), что на 6 % больше результата за III квартал 2023 финансового года. Скорректированная разводнённая прибыль на акцию (Non-GAAP) составила ¥2,67 ($0,37), превысив на 13 % прошлогодний показатель. Скорректированная EBITA выросла на 33 % в годовом исчислении до ¥3,14 млрд ($430 млн). Рост произошёл в основном за счёт сдвига в ассортименте продукции в сторону более прибыльных публичных облачных продуктов и повышения операционной эффективности, что частично компенсировалось ростом инвестиций в развитие клиентской базы и технологий. Международный бизнес электронной коммерции, включающий платформу AliExpress, B2B-площадку Alibaba.com и другие региональные платформы, остался одним из самых быстрорастущих в компании, увеличив выручку на 32 % до ¥37,76 млрд ($5,18 млрд). Выручка подразделения Cloud Intelligence Group компании Alibaba выросла на 13 % с ¥28,07 млрд ($3,85 млрд) в прошлом году до ¥31,74 млрд ($4,35 млрд). Как сообщает компания, рост был обусловлен увеличением внедрения продуктов, связанных с ИИ, выручка от которых сохраняла трехзначный процентный годовой рост шестой квартал подряд. Компания подчеркнула приверженность продвижению мультимодального ИИ и open source. В январе 2025 года Alibaba открыла исходный код Qwen2.5-VL, мультимодальной модели следующего поколения, и запустила флагманскую MoE-модель Qwen2.5-Max. Обе модели доступны пользователям и предприятиям через Qwen Chat и собственную платформу Bailian. С августа 2023 года компания открыла целый ряд различных LLM Qwen. По состоянию на 31 января 2025 года на Hugging Face было разработано более 90 тыс. производных моделей на основе семейства Qwen, что делает его одним из крупнейших семейств ИИ-моделей. Alibaba добилась «значительных успехов» в развитии своего облачного бизнеса в области ИИ после запуска своей флагманской модели Qwen 2.5-Max AI Foundation, сообщила компания Barclays в заметке для инвесторов, добавив, что наблюдается резкий рост спроса на инференс, на который приходится до 70 % всех заказов клиентов. Глава Alibaba Эдди Ву (Eddie Wu) сообщил на встрече с аналитиками, что ИИ — это «та возможность для трансформации отрасли, которая появляется только раз в несколько десятилетий». Он также сказал, что Alibaba вложит в течение следующих трёх лет больше средств в ИИ и облачные вычисления, чем за последнее десятилетие, но не назвал точную сумму. По оценкам Barclays, запланированные инвестиции превысят ¥270 млрд ($37,0 млрд). В этом месяце Alibaba Cloud открыла второй ЦОД в Таиланде в рамках стратегии по расширению присутствия в Юго-Восточной Азии, сообщил ресурс Data Center Dynamics. UPD 24.02.2024: компания официально объявила о намерении инвестировать не менее ¥380 млрд ($52,44 млрд) в облачную и ИИ-инфраструктуру в течение трёх лет.

15.01.2025 [11:24], Владимир Мироненко

В совет директоров UALink вошли представители Alibaba, Apple и SynopsysКонсорциум Ultra Accelerator Link (UALink) объявил о расширении состава совета директоров представителями Alibaba Cloud, Apple и Synopsys. Новые члены совета будут использовать свои отраслевые знания для продвижения разработки и внедрения в отрасли UALink — высокоскоростного масштабируемого интерконнекта для производительных ИИ-кластеров следующего поколения, указано в пресс-релизе. Фактически UALink занят созданием более открытой альтернативы NVLink. С момента основания в конце октября 2024 года количество участников UALink выросло до более чем 65 компаний, сообщил Куртис Боуман (Kurtis Bowman), председатель совета директоров UALink. Новые участники совета директоров заявили, что совместная работа над интерконнектом для ускорителей будет способствовать повышению эффективности выполнения рабочих нагрузок ИИ. Представитель Apple отметил, что UALink демонстрирует большие перспективы в решении проблем подключения и создании новых возможностей ИИ-индустрии. В консорциум входит широкий круг компаний, от поставщиков облачных услуг и OEM-производителей до разработчиков ПО и полупроводниковых компонентов во главе с AMD, AWS, Astera Labs, Cisco, Google, HPE, Intel, Meta✴ и Microsoft, представляющих основные области разработки решений для повышения производительности нагрузок ИИ.

Источник изображения: UALink Ожидается, что выпуск спецификации UALink 1.0 состоится в I квартале 2025 года. Она предусматривает пропускную способность до 200 Гбит/с на линию и возможность объединения до 1024 ИИ-ускорителей в пределах одного домена.

20.11.2024 [13:04], Руслан Авдеев

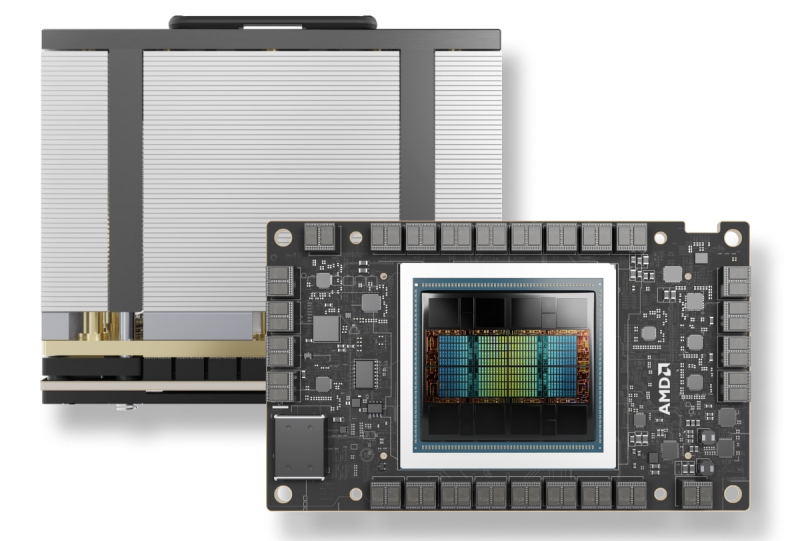

IBM и AMD расширяют сотрудничество: Instinct MI300X появится в облаке IBM CloudКомпания IBM объявила о расширении сотрудничества с AMD для предоставления ускорителей Instinct MI300X в формате «ускорители как услуга» (Accelerators-as-a-Service). По словам IBM, новое решение расширяет возможности и энергоэффективность генеративных ИИ-моделей и HPC-приложений. AMD Instinct MI300X станут доступны в IBM watsonx, а также будут поддерживаться в Red Hat Enterprise Linux AI. Они дополнят портфолио IBM Cloud, уже включающее Intel Gaudi 3 и NVIDIA H100. Ускоритель AMD Instinct MI300X оснащён 192 Гбайт памяти HBM3. И относительно малое количество ускорителей способно обеспечить работу больших ИИ-моделей, что позволяет снизить затраты с сохранением производительности и масштабируемости. Ускорители будут доступны в составе виртуальных серверов и частных виртуальных облаков, а также в контейнеризированных средах IBM Cloud Kubernetes Service и IBM Red Hat OpenShift. Кроме того, для MI300X будут доступны LLM Granite и инструмент InstructLab. Речь идёт в том числе об интеграции программных решений IBM с ПО AMD ROCm. По словам компании, предложенные решения обеспечит клиентов гибкой, безопасной, высокопроизводительной и масштабируемой средой для рабочих нагрузок ИИ. AMD Instinct MI300X станут доступны пользователям IBM Cloud в I половине 2025 года. |

|