Материалы по тегу: cloud

|

11.11.2024 [12:39], Руслан Авдеев

Alibaba Cloud завершила миграцию 500 Пбайт данных китайской социальной сети XiaohongshuПопулярная в Китае социальная сеть Xiaohongshu перенесла 500 Пбайт данных в облако Alibaba Cloud. На миграцию ушёл год, в переносе Alibaba помогали 1,5 тыс. сотрудников Xiaohongshu, сообщает SCMP. По имеющимся данным, предоставленным компаниями-партнёрами, речь идёт об одном из крупнейших проектов миграции данных «за всю историю». Сообщается, что «озеро данных» вмещает все структурированные и неструктурированные данные социальной платформы, собранные с момента запуска 11 лет назад. Xiaohongshu, базирующаяся в Шанхае — крупнейшая в Китае лайфстайл-платформа, насчитывающая более 300 млн активных пользователей. Как заявила в WeChat компания Alibaba, ежедневно Xiaohongshu генерирует «невообразимые» объёмы данных. По данным облачного провайдера, успех миграции в облако предопределили тесное сотрудничество команд двух компаний, быстрое реагирование на возникающие задачи и проблемы, а также взаимно согласованные стандарты разработки.

Источник изображения: Wikipedia Alibaba Cloud является крупнейшим облачным провайдером в Китае. Один из дата-центров компании пострадал от пожара в сентябре 2024 года, что заставило Alibaba довольно долго и очень тщательно сушить оборудование для сохранения данных. Весной компания снизила цены на облачные услуги на 55 % для Китая в попытке отвоевать клиентов у конкурентов из числа других местных игроков — Tencent, JD.com и Baidu.

23.09.2024 [15:52], Владимир Мироненко

Alibaba Cloud сократила время сборки ЦОД на 50 % с помощью модульной архитектурыAlibaba Cloud представила на своей ежегодной конференции Apsara модульную архитектуру ЦОД под названием «CUBE DC 5.0», которая, по словам компании, поможет ей удовлетворить спрос на инфраструктуру ИИ за счёт повышения производительности и сокращения времени сборки новых объектов, пишет ресурс The Register. Согласно заявлению Alibaba Cloud, архитектура CUBE DC 5.0 основана на использовании «готовых модульных конструкций» и «передовых фирменных технологий, таких как гибридная система охлаждения (wind-liquid, воздушно-жидкостная), архитектура распределения DC-питания постоянного тока». Не раскрывая подробности используемых технологий, Alibaba Cloud сообщила, что модульный подход сокращает время развёртывания ЦОД до 50 % по сравнению с традиционными методами строительства. The Register попросил Alibaba объяснить работу «гибридной системы охлаждения wind-liquid». Предположительно, речь идёт о СЖО с охлаждающей пластиной — метод, при котором тонкие резервуары с охлаждённой жидкостью размещаются на оборудовании, а охлаждение достигается за счёт циркуляции жидкости и/или продувки воздуха по пластинам.

Источник изображений: Alibaba Cloud Гендиректор Alibaba Cloud Intelligence Эдди Ву (Eddie Wu) заявил, что компания «вкладывает значительные средства в создание ИИ-инфраструктуры ИИ будущего». Компания анонсировала на конференции планировщик, который позволяет улучшить управление аппаратными ресурсами, повышая коэффициент использования до 90 %. Также было представлено IaaS-предложение Enterprise Elastic Compute Service (ECS) девятого поколения, получившее улучшения для обработки приложений ИИ. В частности, были увеличены скорость работы механизма рекомендаций на 30 % и количество запросов на чтение/запись в базу данных в секунду на 17 %. Кроме того, Alibaba Cloud анонсировала ПО Open Lake, которая объединяет несколько крупных движков данных для использования их приложениями генеративного ИИ. Ещё одно новое предложение от китайской компании — DMS: OneMeta+OneOps, которое, по-видимому, объединяет и управляет метаданными из 40 различных источников данных. Также Alibaba Cloud сообщила о выходе новых ИИ-моделей с открытым исходным кодом семейства Qwen 2.5 и новой ИИ-модели семейства Tongyi Wanxiang для преобразования текста в видео с поддержкой китайского и английского языков.

18.09.2024 [17:52], Руслан Авдеев

Куда по мокрому?! Alibaba Cloud ждёт пока просохнет оборудование, пострадавшее от пожара в сингапурском ЦОД Digital RealtyКатастрофический пожар, произошедший во вторник на прошлой неделе в сингапурском дата-центре Digital Realty, всё ещё осложняет работу облачных операторов. The Register, в частности, сообщает, что к полноценной работе не может приступить облачный регион Alibaba Cloud — в компании ждут, когда просохнет оборудование, чтобы попытаться восстановить данные. Согласно данным Alibaba Cloud, миграция и восстановление данных в повреждённом ЦОД SIN11 идёт по плану. Работа облачных сервисов постепенно восстанавливается. В компании подчеркнули, что часть оборудования по-прежнему находится в небезопасной и заблокированной зоне дата-центра. О возможном затоплении ряда помещений пожарные предупредили оператора заранее. Некоторое оборудование требует тщательной просушки до того, как можно будет попытаться запустить его без дополнительной угрозы целостности данных. На их восстановление уйдёт некоторое время. Из-за сбоя Alibaba Cloud, как выяснилось, пострадали и различные сервис-провайдеры, включая Lazada и ByteDance. Причиной пожара, вероятно, стало возгорание Li-Ion элементов ИБП. Сообщалось, что для тушения и охлаждения АКБ пришлось задействовать пожарного робота, поскольку аккумуляторы могли повторно воспламениться, взорваться и выделить токсичные вещества. Ситуация усугублялась тем, что АКБ находились на третьем этаже четырёхэтажного ЦОД. Хотя современные нормы Сингапура предписывают размещать ИБП на первом этаже, объект Digital Realty ввели в эксплуатацию задолго до принятия этих норм. Это единственный из трёх кампусов Digital Realty в Сингапуре, созданный на основе уже имеющейся инфраструктуры. Ещё два были возведены с нуля. Как сообщает Alibaba Cloud, к вечеру злополучного вторника всё ещё звучала пожарная сигнализация, а некоторое сетевое оборудование функционировало со сбоями из-за высоких температур. Клиентов предупредили о возможных сбоях во всех зонах доступности данного облачного региона. В среду большинство облачных сервисов восстановили работу в результате переноса части нагрузок. В пятницу было объявлено, что часть оборудования находится «в стадии безопасной миграции». В субботу уже проводилась подготовка к установке оборудования, включая его сушку. От грандиозного пожара в своём время пострадал ЦОД OVHCloud в Страсбурге, долгое время оператор разбирался многочисленными претензиями пользователей. В самом Сингапуре после крупного сбоя дата-центра Equinix в прошлом году власти пообещали жёстко отрегулировать деятельность ЦОД и облаков.

12.09.2024 [14:46], Руслан Авдеев

Возгорание литий-ионных аккумуляторов вызвало экстренное отключение ЦОД Digital Realty в Сингапуре10 сентября 2024 года в сингапурском дата-центре Digital Realty SIN11 произошёл пожар, последствия которого ещё предстоит оценить. По информации Datacenter Dynamics, больше всех пострадало облако Alibaba Cloud, одна из зон доступности (Singapore Availability Zone C) которого была развёрнута на базе этого ЦОД. Также пострадали Lazada, ByteDance, Digital Ocean, Coolify и Cloudflare. Пожар начался во вторник в 7:45 по местному времени. В течение получаса весь персонал был эвакуирован. Причиной пожара предварительно названо возгорание литий-ионных аккумуляторов в ИБП на третьем этаже четырёхэтажного здания. Силы гражданской обороны Сингапура (Singapore Civil Defence Force, SCDF) даже применили автономного робота в попытке охладить аккумуляторные блоки, однако в результате в отсеке и соседних помещениях стала накапливаться вода, из-за чего возник риск коротких замыканий. В итоге пришлось экстренно отключать питание одного из зданий, что также привели к проблемам с сетевым подключением в соседних зданиях. Работы по тушению и устранению рисков заняли более суток. К вечеру среду пожарные службы всё ещё не пускали в пострадавшие помещения инженеров ЦОД и его клиентов. По словам Digital Realty, сейчас ситуация стабилизировалась, а надёжность конструкций самого здания в результате пожара не пострадала. ЦОД SIN11 Digital Loyang 1 включает четыре здания общей площадью 17 тыс. м2. Он был введён в эксплуатацию в 2016 году. Стандарты SCDF требуют, чтобы все системы хранения энергии (Energy Storage Systems, ESS) находились на первом этаже. При этом Digital Realty отметила, что новые правила ввели в действие с 2020 года, через четыре года после запуска SIN11. Ранее от грандиозного пожара пострадал оператор ЦОД OVHCloud, который долго время разбирался многочисленными претензиями клиентов. Крупнейший в мире инцидент с южнокорейском ЦОД Kakao тоже произошёл из-за Li-Ion аккумуляторов. Весной 2023 года пожар в ЦОД LAX12 той же Digital Realty привёл к приостановке обслуживания части клиентов. А в самом Сингапуре после масштабного сбоя дата-центра Equinix власти пообещали жёстко отрегулировать деятельность ЦОД и облаков.

30.08.2024 [13:11], Руслан Авдеев

ИИ-ускорители Intel Gaudi 3 дебютируют в облаке IBM CloudКомпании Intel и IBM намерены активно сотрудничать в сфере облачных ИИ-решений. По данным HPC Wire, доступ к ускорителям Intel Gaudi 3 будет предоставляться в облаке IBM Cloud с начала 2025 года. Сотрудничество обеспечит и поддержку Gaudi 3 ИИ-платформой IBM Watsonx. IBM Cloud станет первым поставщиком облачных услуг, принявшим на вооружение Gaudi 3 как для гибридных, так и для локальных сред. Взаимодействие компаний позволит внедрять и масштабировать современные ИИ-решения, а комбинированное использование Gaudi 3 с процессорами Xeon Emerald Rapids откроет перед пользователями дополнительные возможности в облаках IBM. Gaudi 3 будут применяться и в задачах инференса на платформе Watsonx — клиенты смогут оптимизировать исполнение таких нагрузок с учётом соотношения цены и производительности. Для помощи клиентам в различных отраслях, в том числе тех, деятельность которых жёстко регулируется, компании предложат возможности IBM Cloud для гибкого масштабирования нагрузок, а интеграция Gaudi 3 в среду IBM Cloud Virtual Servers for VPC позволит компаниям, использующим аппаратную базу x86, быстрее и безопаснее использовать свои решения, чем до интеграции. Ранее сообщалось, что модель Gaudi 3 готова бросить вызов ускорителям NVIDIA. В своё время Intel выступила с заявлением о 50 % превосходстве новинки в инференс-сценариях над NVIDIA H100, а также о 40 % преимуществе в энергоэффективности при значительно меньшей стоимости. Позже Intel публично раскрыла стоимость новых ускорителей, нарушив негласные правила рынка.

22.08.2024 [00:13], Руслан Авдеев

Alibaba и Tencent отметили стабилизацию спроса на облачные CPU и рост спроса на ИИ-ускорителиСпрос на CPU-мощности в ключевых китайских облаках Alibaba Cloud и Tencent Cloud выровнялся и теперь клиентов больше интересуют ИИ-ускорители, сообщает The Register. Рост спроса на предложения, связанные с ИИ, зарегистрировала и Lenovo. На прошлой неделе Alibaba и Tencent опубликовали квартальную отчётность, выручка Alibaba Cloud выросла год к году на 6 % до $3,7 млрд. Tencent не раскрывает показатели гиперскейл-сегмента, но отмечает рост спроса на облачные сервисы, благодаря чему квартальные показатели подразделения Business Services выросли год к году на «десятки процентов». Представитель Tencent объявил инвесторам, что бизнес по аренде ИИ-ускорителей переживает настоящий бум. Впрочем, абсолютные показатели достаточно скромные в сравнении с американским рынком, поскольку у КНР меньше хорошо финансируемых ИИ-стартапов. По некоторым данным, местные стартапы часто располагают $1–$2 млрд, тогда как в США объём инвестиций может достигать и $10–$90 млрд. Tencent в любом случае не теряет клиентов даже на фоне замещения CPU на GPU. В Alibaba сообщают, что спрос на ИИ-продукты и связанные технологии очень большой, причём он всё ещё далёк от удовлетворения. Для Alibaba Cloud во II половине 2024 года прогнозируется двузначный рост в процентах и большая часть выручки придётся на ИИ-продукты. При этом в Alibaba констатируют, что спрос на традиционные вычисления в облаке на базе классических процессоров ограничен, большая часть роста связана именно с ИИ-продуктами на основе ускорителей. В Lenovo тоже сообщили, что в подразделении Infrastructure Solutions Group (ISG) зарегистрирован рекордный рост выручки до $3,2 млрд — это на 65 % выше год к году, частично благодаря спросу на ИИ-решения, причём и на базе обычных серверов, и на базе систем с ИИ-ускорителями. Инвесторам объявили, что оживлённые вложения в ИИ-инфраструктуру и улучшение поставок ускорителей помогут компании вырасти. Пока же ISG отчиталась о квартальных убытках в объёме $37 млн. Впрочем, это лучше, чем $60,4 млн убытков в аналогичном квартале прошлого года и $97 млн в прошлом квартале. В ходе отчёта экспертов заинтересовало, почему рост выручки на 65 % не привёл к прибыльности соответствующего бизнеса. В самой компании обещают дальнейшую оптимизацию бизнеса в соответствии с требованиями эры гибридных и ИИ-вычислений. Другими словами, не исключены увольнения и/или сокращение продуктовых линеек.

21.08.2024 [23:12], Владимир Мироненко

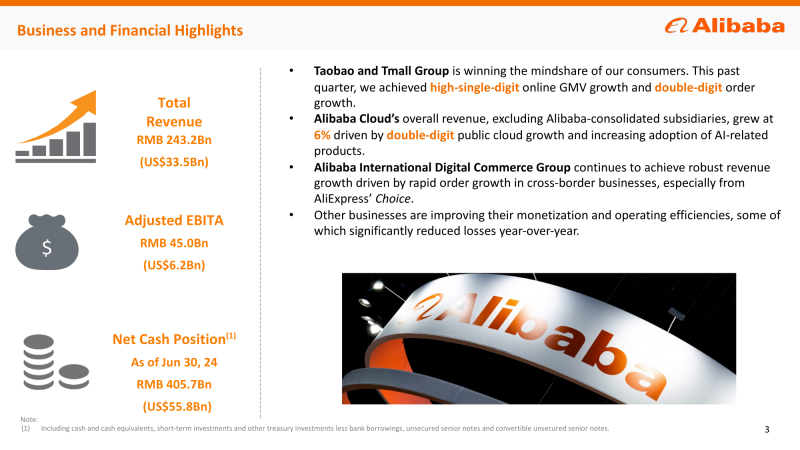

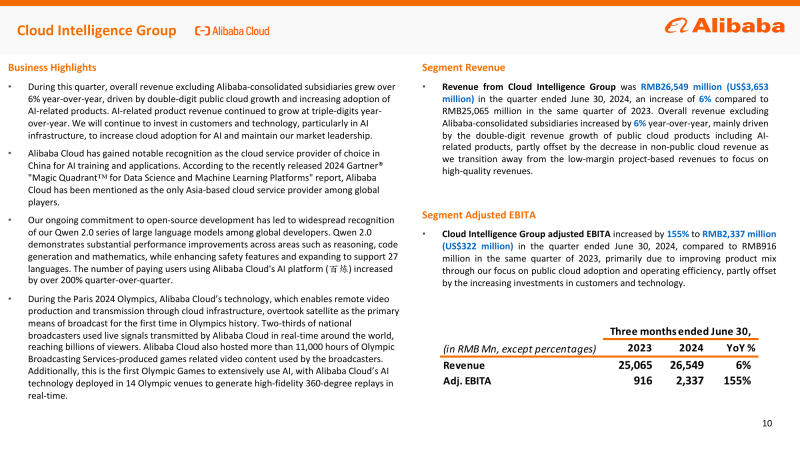

Облако Alibaba Cloud увеличило выручку на 6 %, в основном благодаря ИИAlibaba Group Holding Limited сообщила финансовые результаты II квартала 2024 года, закончившегося 30 июня. Выручка компании выросла год к году на 4 % до ¥243,2 млрд ($33,5 млрд). Чистая прибыль (GAAP) составила ¥24,0 млрд ($3,3 млрд) или ¥1,24 ($0,17) на акцию, что на 27 % и 26 % меньше по сравнению с прошлым годом соответственно, в основном из-за снижения доходов от операций и обесценивания инвестиций. Скорректированная чистая прибыль (Non-GAAP) за квартал составила ¥40,7 млрд ($5,6 млрд), что на 9 % меньше результата за II квартал 2023 года. Скорректированная разводнённая прибыль на акцию (Non-GAAP) составила ¥2,05 ($0,28) — снижение год к году на 5 %. Облачное подразделение Cloud Intelligence Group увеличило выручку на 6 % — с ¥25,1 млрд во II квартале 2023 года до ¥26, 5 млрд ($3,7 млрд) в отчётном. EBITA подразделения облачных вычислений выросла на 155 % в годовом исчислении до ¥2,3 млрд ($322,15 млн). Было отмечено, что в основном рост показателей был достигнут благодаря ИИ-услугам. Гендиректор Alibaba Эдди Ву (Eddie Wu) сообщил, что во II половине 2024 года Alibaba Cloud покажет двузначный рост в процентах, причём большая его часть будет обеспечена за счёт решений ИИ. «Среди наших клиентов наблюдается очень, очень высокий спрос на ИИ и продукты, связанные с ИИ», — отметил он, добавив, что «спрос всё ещё далёк от удовлетворения». Ву сообщил, что, если рассматривать отрасль в целом, спрос на традиционные облачные вычисления на базе CPU относительно ограничен, и большая часть роста сейчас достигается благодаря разработке продуктов ИИ на базе GPU/ускорителей. Гендиректор подчеркнул, что во II квартале рост выручки от реализации продуктов, связанных с ИИ, исчислялся трёхзначными числами в процентах. Он сообщил, что фирменные большие языковые модели (LLM) Alibaba получают всё более широкое распространение. В этом году Alibaba Cloud также выступила в качестве основного поставщика облачных услуг для Олимпийских игр, предоставив облачные вычисления и ИИ-услуги для Olympic Broadcasting Services (OBS). Ву сообщил, что компания продолжит инвестировать в ИИ высокими темпами «в течение следующих нескольких кварталов». В этом году Alibaba снизила стоимость своих облачных сервисов, причём в некоторых случаях снижение для китайских клиентов составило 55 %, что позволило ей вернуть клиентов, ушедших ранее к конкурентам, таким как Tencent, JD.com и Baidu.

16.08.2024 [12:24], Руслан Авдеев

Huawei Cloud рассматривает Азиатско-Тихоокеанский регион в качестве ключевого рынка для своих ИИ-продуктовОблачное подразделение Huawei Technologies рассматривает Азиатско-Тихоокеанский регион (АТР) как потенциально огромный рынок для своих ИИ-решений. Как сообщает SCMP, облачные сервисы компании в регионе за последние четыре года выросли в 20 раз несмотря на американские санкции. По словам представителя Huawei Cloud Жаклин Ши (Jacqueline Shi), следующим шагом компании в регионе станет предоставление всеобъемлющих ИИ-решений. В их числе облачный сервис Ascend Cloud, платформа для ИИ-разработки ModelArts и разработанная самой Huawei большая языковая модель (LLM) Pangu. Компания уже сотрудничает со службой прогнозов погоды в Таиланде над внедрением Pangu, также работая с другими отраслями, например — финансовой.

Источник изображения: Jovan Vasiljević/unsplash.com План экспансии в АТР демонстрирует намерения компании диверсифицировать денежные поступления и привлечь больше зарубежных клиентов на фоне роста интереса к генеративным ИИ-решениям во многих отраслях. По словам Ши, регион является для компании одним из крупнейших рынков облачных вычислений, именно здесь Huawei в первую очередь запускала некоторые облачные продукты, вроде DBaaS — до того, как предложить их по всему миру. В мае 2024 года Huawei запустила первый в Египте публичный облачный сервис в Каире, одновременно запустив LLM для арабского языка. В сентябре прошлого года Huawei запустила ЦОД в столице Саудовской Аравии Эр-Рияде для обеспечения страны и других государств Ближнего Востока, Северной Африки и Центральной Азии публичными облачными сервисами. По данным Canalys, сегодня компания считается вторым по величине провайдером облачных сервисов в материковом Китае, отставая только от облачного подразделения Alibaba Group. Согласно отчётам Huawei, облачные вычисления стали одним из сильнейших векторов роста компании в 2023 году, выручка год к году выросла на 21,9 % до ¥55,29 млрд ($7,6 млрд). Облачная ИИ-платформа Ascend строится на разработанных самой компанией процессорах и фреймфорках, это позволяет преодолевать американские санкции, ограничивающие доступ КНР к полупроводникам и технологиям американского происхождения. В материковом Китае чипы семейства Huawei Ascend теперь служат альтернативой ускорителям NVIDIA, поставки которых в Китай ограничены. Это не единственные инициативы Huawei, связанные с облачными решениями. Недавно компания представила сетевой монитор, способный быстро найти даже отдельный неисправный чип в целом дата-центре, а на днях появилась информация о том, что Huawei готовит к выпуску ИИ-ускоритель Ascend 910C способный конкурировать с NVIDIA H100.

13.08.2024 [18:43], Руслан Авдеев

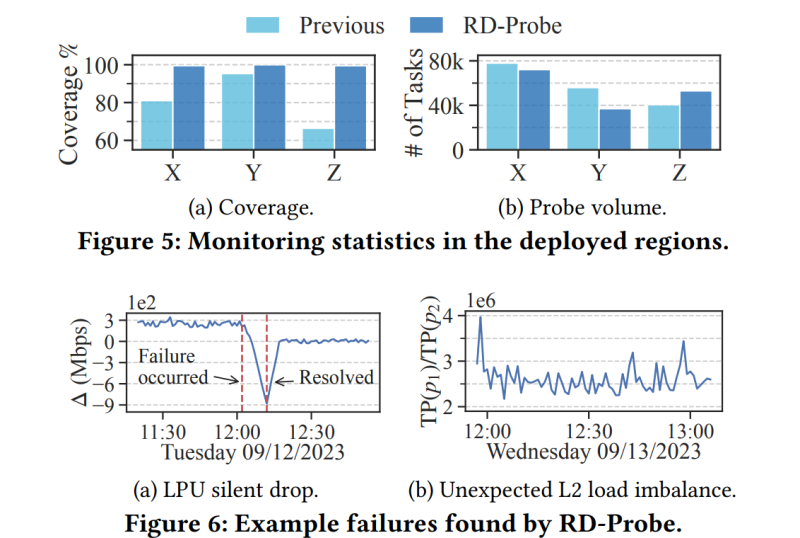

Huawei Cloud построила сетевой монитор, способный быстро найти отдельный неисправный чип в целом ЦОДВ Huawei Cloud разработали собственный сверхточный инструмент сетевого мониторинга RD-Probe для обслуживания для своих облачных регионов. По данным The Register, он способен выявить проблемы, которые человек заметить не способен. В докладе Huawei и представители Пекинского университета ссылаются на данные Amazon: лишь внутри одного облачного региона AWS имеется 1087 возможных путей передачи данных и 10176 — между регионами. В ЦОД Huawei Cloud используются более 100 тыс. коммутаторов и миллион серверов. Мониторинг всей этой инфраструктуры является чрезвычайно сложной задачей. RD-Probe отслеживает состояние всех L2-портов во всей сетевой фабрике. Исследователи отмечают, что традиционно осуществляется именно мониторинг L3, что не даёт полной картины состояния сети. При этом инструмент Huawei воспринимает коммутаторы как «чёрные ящики» и не полагается исключительно на их внутреннюю телеметрию, благодаря чему легко интегрируется с уже существующей архитектурой системы мониторинга. Инструмент сначала проводит зондирование случайным образом, потом — детерминированным. Подобная двухэтапная схема обеспечивает максимальное покрытие сети при проверках и вместе с тем не нагружает её. Для генерации трафика выделен кластер из 16 узлов, каждый из которых имеет неназванный восьмиядерный процессор с частотой 2,80 ГГц и 64 Гбайт оперативной памяти. Полученные данные в потоковом режиме обрабатывают 48 узлов (16-ядерный CPU и 32 Гбайт RAM). Через месяц после начала использования RD-Probe в Huawei Cloud было найдено множество незамеченных ранее проблем. Конечно, большинство касалось небольших сбоев и эпизодических потерь пакетов, зато выявили их до того, как могли серьёзно пострадать пользователи. Например, инструмент помог определить сбойный чип в коммутаторе ядра сети, из-за которого периодически отбрасывался входящий трафик, но при этом отчёты об ошибках не генерировались. Также была выявлена ошибка в балансировке нагрузки, сбойное SerDes-подключение и проблема с некоторыми BGP-маршрутами. Исследователи Huawei выразили удовлетворение тем, что RD-Probe улучшило покрытие мониторингом сети с 80,9 % до 99,5 %. В скором времени решение планируется применить в других облачных регионах Huawei. При этом авторы доклада подчёркивают, что RD-Probe оценивает только внутренний трафик и не может фильтровать сбои на серверной стороне. Отмечается, что ручной мониторинг не даёт таких хороших результатов.

18.07.2024 [18:23], Руслан Авдеев

Четвёртый за год: NVIDIA приобрела ещё один облачный стартап — Brev.devNVIDIA приобрела стартап, помогающий ИИ-разработчикам найти среди предложений облачных провайдеров наиболее подходящий по соотношению цена/качество доступ к ускорителям. Как сообщает портал CRN, это уже четвёртая заметная покупка NVIDIA с начала года. Представитель NVIDIA подтвердил, что сделка по приобретению Brev.dev действительно состоялась, но сумму и условия сделки не сообщил. Brev.dev предоставляет платформу для создания, обучения и внедрения ИИ-моделей в облаках. Целью Brev.dev, по словам самого стартапа, является поиск простейшего способа использования ускорителей для разработчиков систем ИИ и машинного обучения. Сотрудничество с NVIDIA обеспечит выполнение этой миссии, с комбинацией максимально возможно производительной аппаратной составляющей с самым передовым программным обеспечением. На сайте Brev.dev официальными партнёрами стартапа названы NVIDIA, Intel и AWS. Там же говорится, что платформа служит единым интерфейсом для взаимодействия AWS, Google Cloud Platform, Fluidstack и прочими облаками с ИИ-ускорителями. Это позволяет разработчикам искать подходящие инстансы на основе их цены и доступности. Хотя NVIDIA поставляет GPU и ИИ-ускорители облачным провайдерам более десяти лет, в последние годы компания уделяет немало внимания расширению собственного бизнеса в сфере облачных инфраструктур.

Источник изображения: NVIDIA В прошлом году компания запустила сервис DGX Cloud, который развёрнут в облачной инфраструктуре других провайдеров и на собственных мощностях и ИИ-суперкомпьютерах. Ранее в этом году NVIDIA купила ещё два стартапа для развития возможностей DGX Cloud. В конце апреля компания анонсировала покупку израильского стартапа Run:ai, занимающегося решениями для оркестрации ИИ-инфраструктур. Его планируется интегрировать в DGX Cloud, а также с DGX- и HGX-серверами. По имеющимся данным, покупка Run:ai обошлась в $700 млн. Практически одновременно с Run:ai компания приобрела ещё один израильский стартап — Deci, предлагающий ПО, способное на любом железе ускорить инференс ИИ-моделей, сохраняя точность данных. Сделку, по слухам, оценили приблизительно в $300 млн. Наконец, месяц назад NVIDIA купила калифорнийский стартап Shoreline.io, основанный бывшим управленцем AWS — компания разрабатывает ПО для автоматического устранения проблем в инфраструктуре ЦОД. По некоторым данным, команда Shoreline присоединилась к DGX Cloud, а покупка обошлась в $100 млн. |

|