Лента новостей

|

18.06.2021 [13:31], Владимир Агапов

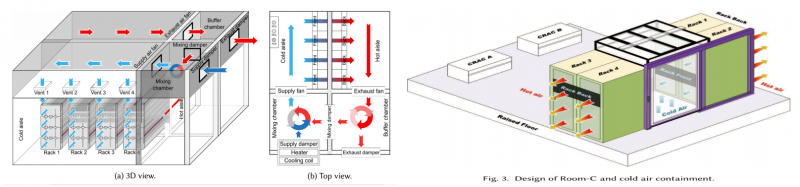

Сингапур и Facebook✴ разработают проект тропического дата-центраВ рамках проекта «Устойчивый тропический дата-центр» (STDC) будут протестированы новые методы охлаждения оборудования ЦОД с целью снижения нагрузки на сингапурскую электросеть. Необходимость в этом назрела, поскольку на Сингапур приходится около 60% центров обработки данных Юго-Восточной Азии и они потребляют уже 7% всей доступной стране электроэнергии. Несмотря на растущий спрос, властям пришлось наложить мораторий на строительство новых объектов. Тестовая площадка STDC, которая разместится на территории кампуса Kent Ridge Национального университета Сингапура (NUS). Она позволит испытать конструкцию теплообменника с влагопоглощающим покрытием и систему StatePoint, которую Facebook✴ и Nortek разработали для тропических районов. Также будет рассмотрен вариант гибридного охлаждения на уровне чипов и система динамического управления охлаждением на основе цифровых двойников и алгоритмов искусственного интеллекта (ИИ). Исследователи планируют выяснить, может ли теплообменник, покрытый адсорбентом, улучшить непрямое испарительное охлаждение в условиях тропического климата. Тестирование такой системы в реальных условиях эксплуатации необходимо для последующего безопасного внедрения на коммерческих объектах. А гибридное охлаждение чипов должно повысить надёжность, поскольку систему воздушного охлаждения можно использовать во время обслуживания водяного контура. Также будут исследованы возможности «Тропического ЦОД с воздушным охлаждением 2.0» — обновлённой версии системы, проектирование которой было начато в 2017 году. Она способна эффективно работать при повышенных температуре воздуха и влажности, что позволяет снизить энергопотребление оборудования воздухоподготовки. На уровне государства создание стенда для испытаний инновационных систем охлаждения поддержали национальный исследовательский фонд (NRF) и Агентство развития информационных технологий (IMDA). На реализацию проекта суммарно выделено $17 млн. Крупнейшим частным инвестором стала Facebook✴, которая ещё в 2018 году выбрала Сингапур для размещения крупного 11-этажного ЦОД мощностью 150 МВт. Энергию для него предоставят солнечные электростанции местной компании Sunseap, расположенные на крышах домов и воде. Энергоэффективность (PUE) объекта планируется на уровне 1,19. Для этого и нужна будет система жидкостного охлаждения StatePoint. Участники проекта надеются, что все эти технологии в совокупности помогут снизить энергопотребление в индустрии центров обработки данных на 40%, если они будут внедрены во всём тропическом регионе. Учитывая высокую долю ископаемого топлива в местной электроэнергетике, это позволит сократить выбросы парниковых газов на 25%.

13.06.2021 [20:13], Владимир Мироненко

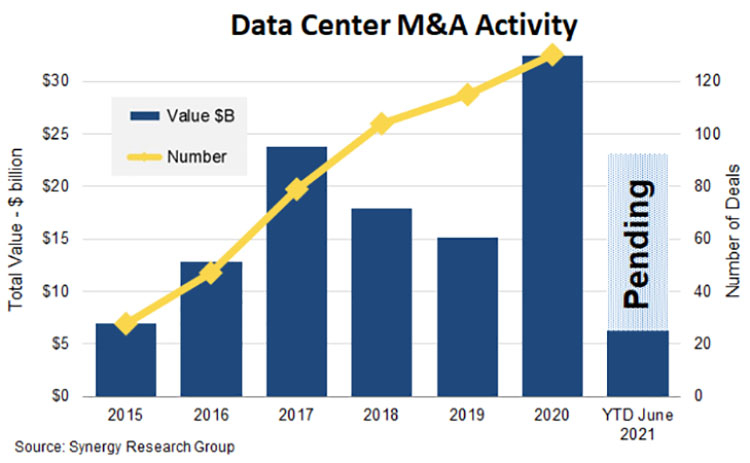

Blackstone купила оператора ЦОД QTS Realty Trust за рекордную сумму в $10 млрдНа минувшей неделе стало известно о приобретении одного из крупнейших в мире операторов центров обработки данных QTS Realty Trust инвестиционной компанией Blackstone за рекордную для рынка сумму в $10 млрд. Blackstone приобрела акции QTS по цене $78/шт., что на 21 % выше их цены на момент закрытия биржевых торгов в день анонса сделки. Blackstone сообщила, что условия включают 24-процентную премию к средней цене акций QTS за последние три месяца. Условия контракта также включают 40-дневный период, в течение которого QTS вправе рассматривать и принимать более выгодные альтернативные предложения по её покупке. Как ожидается, после завершения сделки QTS сохранит нынешнее руководство и по-прежнему будет базироваться в Оверленд-Парке (Канзас, США). Blackstone заявила, что предоставит QTS все ресурсы и постоянный доступ к капиталу, что позволит расширить спектр услуг для поддержки существующих клиентов и привлечения новых.

commercialsearch.com Компания отметила, что видит возможности быстрого и значительного роста на рынке дата-центров. Её словам вторит глава QTS Чад Уильямс (Chad Williams): «Мы видим значительную рыночную возможность для роста, поскольку гиперскейлеры и предприятия продолжают использовать нашу инфраструктуру мирового класса для поддержки своих инициатив по цифровой трансформации». Сделка является крупнейшим на сегодняшний день приобретением такого рода на рынке центров обработки данных. По данным Synergy Research Group, до этого объявления крупнейшими сделками по слиянию и поглощению ЦОД были приобретение компанией Digital Realty европейского конкурента Interxion за $8,4 млрд, поглощение Digital Realty в 2017 году DuPont Fabros за $7,6 млрд и последовательный выкуп долей в Global Switch промышленной группой Jiangsu Shagang Group, который в конечном итоге был оценён более чем в $8 млрд по сумме сделок, заключённых на протяжении трёх лет.  Этот также означает, что в 2021 году годовая стоимость слияний и поглощений на рынке ЦОД приближается к новому рекорду. Менее чем за шесть месяцев в году уже были закрыты или близки к завершению сделки на сумму более $6 млрд. Поскольку общая сумма транзакций вместе со сделкой по покупке QTS приближается к $17 млрд, можно ожидать, что в этом году будет превзойдено рекорд 2020 года — итоговая сумма сделок превысили отметку в $30 млрд.

09.06.2021 [23:00], Илья Коваль

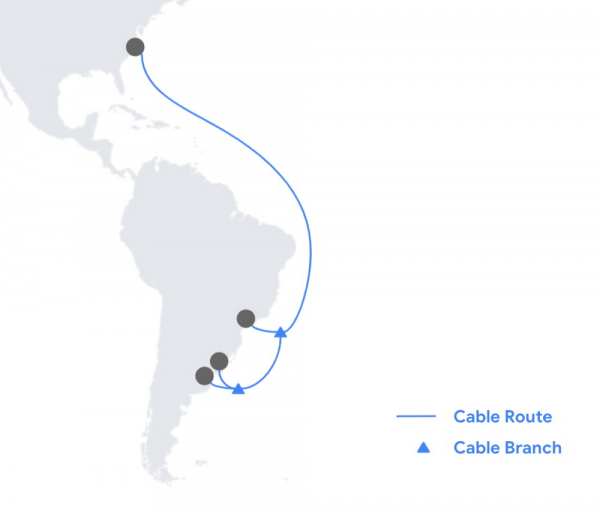

Google соединит Северную и Южную Америку уникальным подводным интернет-кабелем FirminaGoogle объявила о планах проложить новый подводный кабель Firmina, который протянется от восточного побережья США до Лас-Тонинаса в Аргентине. В южной части он получит дополнительные ответвления до Прайя-Гранде (Бразилия) и Пунта-дель-Эсте (Уругвай). Кабель назван в честь бразильской писательницы и аболиционистки XIX века Марии Фирмины дос Рейс (Maria Firmina dos Reis). Кабель будет включать 12 оптоволоконных пар (ёмкость пока не уточняется) и позволит южноамериканским пользователям получить быстрый доступ с малой задержкой к продуктам Google, включая поиск, Gmail, YouTube и облачные сервисы Google Cloud. Этот кабель станет 16-м по счёту, в постройку которого вложилась Google. Уникальным Firmina делает то, что он будет самым длинным кабелем в мире, способным работать от одного источника питания на любом из его концов. Даже если один из источников станет временно недоступным, второй сможет обеспечить полную работоспособность кабеля, что повышает устойчивость и надёжность связи. Достигается это за счёт подачи более высокого (+20%) напряжения, чем в аналогичных решениях.  Обычным кабелям требуются дополнительные усилители, которые устанавливаются примерно через каждые 100 км. Для их питания необходимо высокое напряжение, которое подаётся с береговых станций. И если на коротких дистанциях можно организовать питание только с одного конца, то с увеличением длины кабеля и числа волокон это становится всё более трудной задачей.

06.06.2021 [22:07], Владимир Агапов

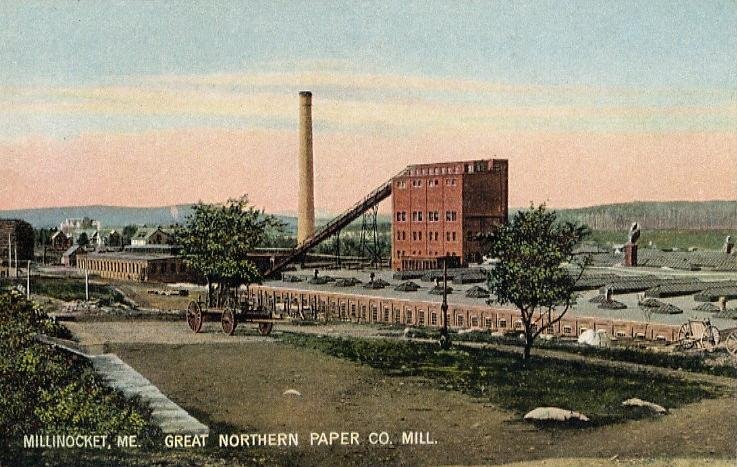

Nautilus превратит неработающую бумажную фабрику в ЦОД за $300 млнКомпания Nautilus Data Technologies, специализирующаяся на плавучих центрах обработки данных, объявила о том, что построит новый ЦОД на территории бывшей бумажной фабрики в Миллинокете (США, штат Мэн). Его энергетические потребности в 60 МВт полностью будут обеспечены местной гидроэлектростанцией. А система водяного охлаждения, питаемая из резервуара ГЭС, позволит сократить до 70% потребление энергии на охлаждение и до 30% выбросы CO2 в атмосферу. Запатентованная компанией двухконтурная система охлаждения позволит рециркулировать воду без загрязнения водоёма. А для достижения ещё более низкого показателя PUE, ЦОД разместится ниже водохранилища ГЭС, чтобы поток воды для охлаждения поступал под действием силы тяжести, а не требовал дополнительных насосов. Предприятие получит федеральные налоговые льготы, так как Миллинокет — один из экономически неблагополучных населённых пунктов. Для их преобразования в зоны «благоприятных возможностей» власти применяют финансовые стимулы, вплоть до освобождения от уплаты налогов компаний, инвестирующих в развитие общества. ЦОД Nautilus — первый, который будет построен в подобной зоне. Его клиентами станут местные предприятия: лаборатория Джексона и Торговая палата штата Мэн. Возможность создания большого кампуса ЦОД вкупе с недорогой электроэнергией, вероятно, привлечет также гиперскейлеров и облачных провайдеров. Местная оптоволоконная сеть Three-Ring Binder, построенная в 2012 году, сможет обеспечить с транзитом через Бостон подключение с низкой задержкой к другим крупным узлам, включая Нью-Йорк, Чикаго и Лондон. Компания Nautilus приобрела комплекс площадью 13 акров, расположенный на месте бывшей фабрики, в 99-летнюю аренду у местной некоммерческой организации Our Katahdin. Первый этап проекта стоимостью $300 млн, как ожидается, будет завершён к концу 2022 года.

04.06.2021 [02:43], Владимир Агапов

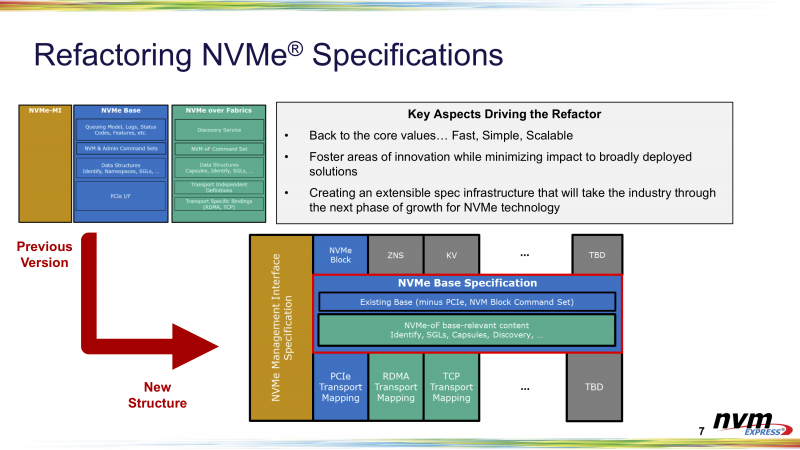

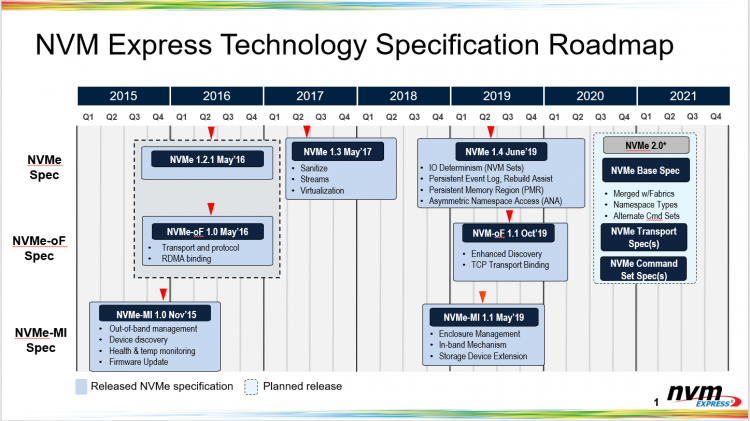

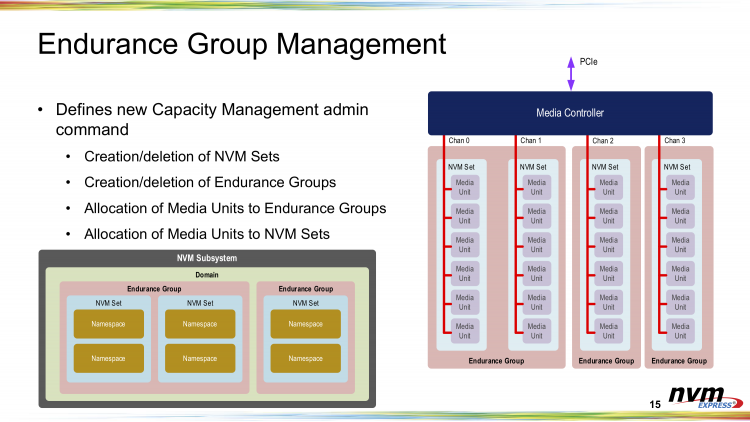

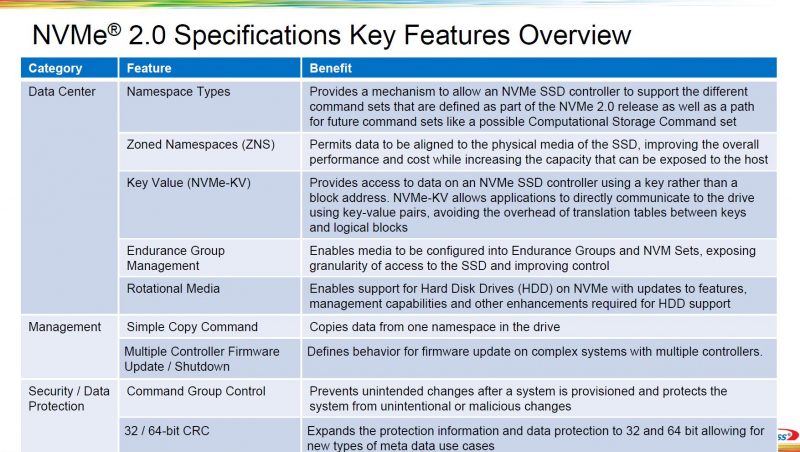

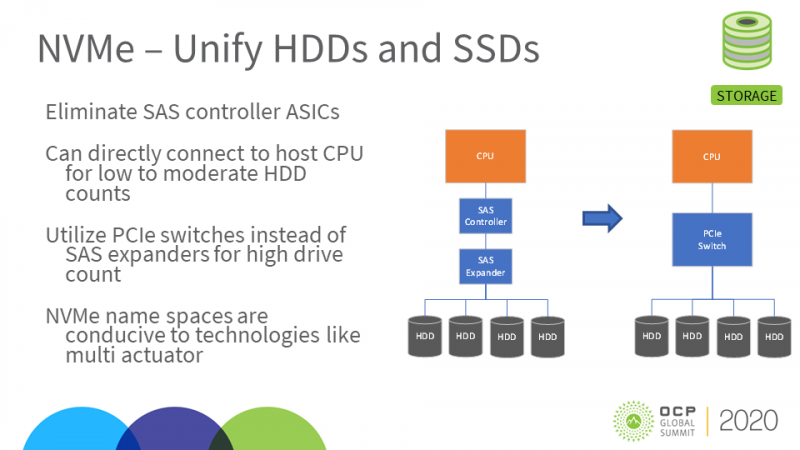

В спецификации NVMe 2.0 официально вошла поддержка HDDВчера был опубликован релиз спецификаций NVMe 2.0. Из скромного протокола для блочных устройств хранения данных, использующих PCI Express, NVMe эволюционирует в один из самых важных и универсальных протоколов для хранилищ практически любого типа. Новые спецификации будут способствовать развитию экосистемы устройств NVMe: SSD, карт памяти, ускорителей и даже HDD. Вместо базовой спецификации для типовых PCIe SSD и отдельной спецификации NVMe-over-Fabrics (NVMe-oF), версия 2.0 изначально разработана как модульная и включает целый ряд отдельных стандартов: базовый набор (NVMe Base), отдельные наборы команд (NVM, ZNS, KV), спецификации транспортного уровня (PCIe, Fibre Channel, RDMA, TCP) и спецификации интерфейса управления (NVMe Management Interface). Вместе они определяют то, как программное обеспечение хоста взаимодействует с накопителями и пулами хранения данных через интерфейсы PCI Express, RDMA и т.д. Базовая спецификация теперь охватывает и локальные устройства, и NVMe-oF, но является намного более абстрактной и не привязанной к реальному миру — было изъято столько всего, что её уже недостаточно для определения всей функциональности, необходимой для реализации даже простого SSD. Реальные устройства должны ссылаться ещё как минимум на одну спецификацию транспортного уровня и на одну спецификацию набора команд. В частности, для типовых SSD, к которым все привыкли, это означает использование спецификации транспорта PCIe и набора команд блочного хранилища. Три стандартизированных набора команд (блочный доступ, ZNS и Key-Value) охватывают области применения от простых твердотельных накопителей с «тонкими» абстракциями над базовой флеш-памятью до относительно сложных интеллектуальных накопителей, которые берут на себя часть задач по управлению хранением данных, традиционно выполнявшихся программным обеспечением на хост-системе. При этом различным пространствам имен, расположенным за одним контроллером, дозволено поддерживать разные наборы команд. В NVMe 2.0 также добавлен стандартный механизм управления пулами хранения данных, который позволяет более тонко управлять нагрузкой в зависимости от производительности, ёмкости и выносливости конкретных устройств. Иерархия пулов также была расширена ещё одним уровнем доменов, внутри которых теперь существуют группы, где, в свою очередь, находятся отдельные наборы NVM-устройств. Будущие наборы команд, например для вычислительных накопителей (computational storage), все еще находятся в стадии разработки и пока не готовы к стандартизации, но новый подход NVMe 2.0 позволит легко добавить их при необходимости. В принципе, в состав NVMe мог бы войти и стандарт Open Channel, но отрасль считает, что парадигма зонированного хранения обеспечивает более разумный баланс, и интерес к Open Channel SSD ослабевает в пользу ZNS-решений. Из прочих изенений в NVMe 2.0 можно отметить поддержку 32-бит и 64-бит CRC, новые правила безопасного отключения устройств в составе общих хранилищ (при доступе через несколько контроллеров), более тонкое управление правами доступа — можно разрешить чтение и запись, но запретить команды, меняющие настройки или состояние накопителя — и дополнительные протоколы, касающиеся обновления прошивок. Также в NVMe 2.0 появилась явная поддержка жёстких дисков. Хотя маловероятно, что HDD в ближайшее время перейдут на использование PCIe вместо SAS или SATA, поддержка таких носителей означает, что в будущем предприятия смогут унифицировать свои SAN c помощью NVMe-oF и отказаться от старых протоколов, таких как iSCSI. В целом, NVMe 2.0 приносит не та уж много новых функций, как это было с прошлыми версиями. Однако сама реорганизация спецификации поощряет итеративный подход и эксперименты с новыми функциями. Так что в ближайшие несколько лет, вероятно, обновления будут менее масштабными и станут выходить чаще.

02.06.2021 [19:14], Игорь Осколков

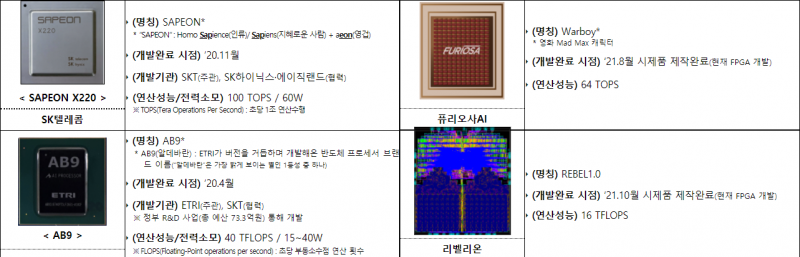

Южная Корея намерена разработать собственные CPU и ИИ-чипы для суперкомпьютеров и серверовЮжная Корея намерена добиться большей независимости в сфере разработки и производства чипов для серверов и суперкомпьютеров, в первую очередь для нужд внутри страны. По сообщению Министерства науки и ИКТ Южной Кореи, пять гиперскейлеров подписали меморандум о взаимопонимании с пятью производителями микросхем. Меморандум предполагает расширение использования отечественных технологий, в частности, ИИ-ускорителей в центрах обработки данных на территории страны. Производители и разработчики чипов — SK Group, Rebellions, FuriosaAI и Исследовательский институт электроники и телекоммуникаций — также согласились создать для этого новый технологический центр в Кванджу на юго-западе страны. Отечественные чипы получат компании Naver Cloud, Douzone Bizon, Kakao Enterprise, NHN и KT. Все они являются крупными игроками на местном рынке и, каждая в своей области, довольно успешно конкурируют с зарубежными IT-гигантами. Это во многом напоминает ситуацию в Китае и Японии, которые также имеют сильных локальных игроков и вкладываются в разработку собственной микроэлектроники, чтобы быть менее зависимыми от США, как минимум, в области суперкомпьютинга. Несколько недель назад правительство объявило о пакете поддержки в размере 510 трлн вон ($451 млрд) для увеличения производства микросхем в стране, что принесёт пользу не только Samsung и SK Hynix, но и небольшим компаниям. Также ранее сообщалось, что Южная Корея намерена к 2030 году построить суперкомпьютер экзафлопсного класса на базе преимущественно «домашних» компонентов.

28.05.2021 [15:28], Сергей Карасёв

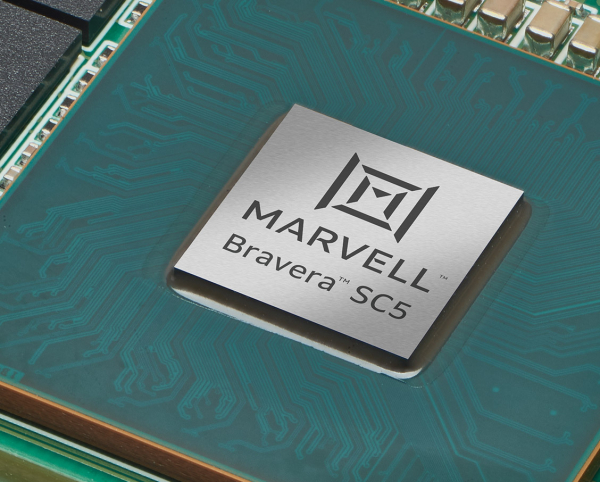

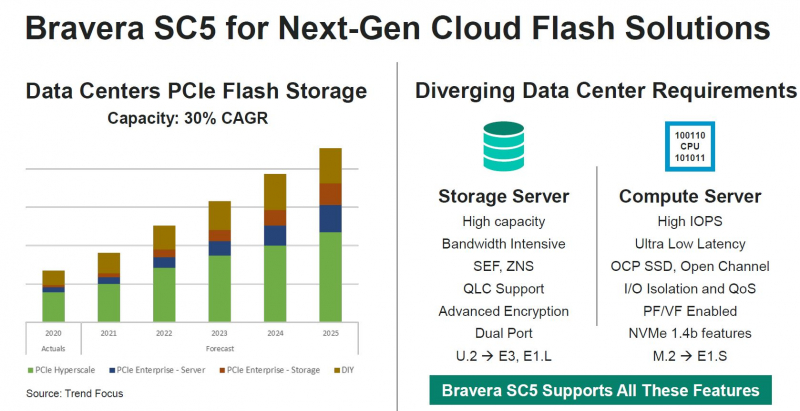

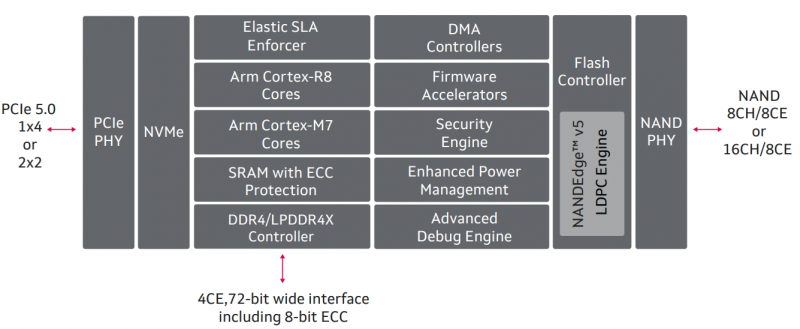

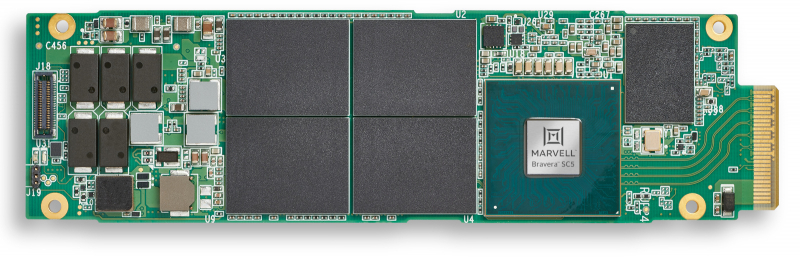

Marvell Bravera SC5 — первый в мире SSD-контроллер с поддержкой PCIe 5.0Компания Marvell анонсировала контроллеры Bravera SC5, предназначенные для построения серверных SSD нового поколения с интерфейсом PCIe 5.0. Представлены изделия MV-SS1331 и MV-SS1333 с восемью и шестнадцатью каналами доступа к NAND-памяти (до 1600 МТ/с) соответственно. В семейство Bravera впоследствии войдут и другие продукты. Заявленная скорость последовательного чтения информации может достигать 14 Гбайт/с, скорость последовательной записи — 9 Гбайт/с. Производительность случайного чтения достигает 2 млн IOPS, записи — 1 млн IOPS. Задержка составляет менее 6 мкс, а функция Elastic SLA Enforcer позволит более тонко управлять приоритетами и очередями, а также собирать телеметрию на аппаратном уровне. В составе изделий задействованы наборы ядер ARM Cortex-R8, Cortex-M7 и Cortex-M3. Есть аппаратные движки для шифрования и обеспечения безопасности. Контроллер поддерживает ECC-память DDR4-3200 и LPDDR4x-4266, а также NAND-чипы SLC/MLC/TLC/QLC от крупнейших производителей: Kioxia, Micron, Samsung, SK hynix, Western Digital и YMTC. Партнёрами в рамках запуска названы AMD, Intel и Renesas. Контроллер поддерживает спецификации NVMe 1.4b и предлагает четыре линии PCIe 5.0 (x4 или два порта x2). Компания постаралась сделать его как можно более универсальным и подходящим как для нужд гиперскейлеров, так и для корпоративных решений. Он поддерживает стандарты ZNS, >Open Channel SSD, Kioxia SEF. Пробные поставки образцов контроллеров уже начались. Первыми заказчиками стали Facebook✴ и Microsoft, развивающие стандарт OCP Cloud SSD, который несколько шире спецификаций NVMe. Именно на них ориентирована старшая, 16-канальная версия контроллера, которая благодаря своим габаритам (20 × 20 мм) позволяет создавать накопители в форм-факторе EDSFF E1.S. Правда, энергопотребление у неё выше, чем у 8-канальной — 9,8 Вт против 8,7 Вт.

28.05.2021 [00:33], Владимир Мироненко

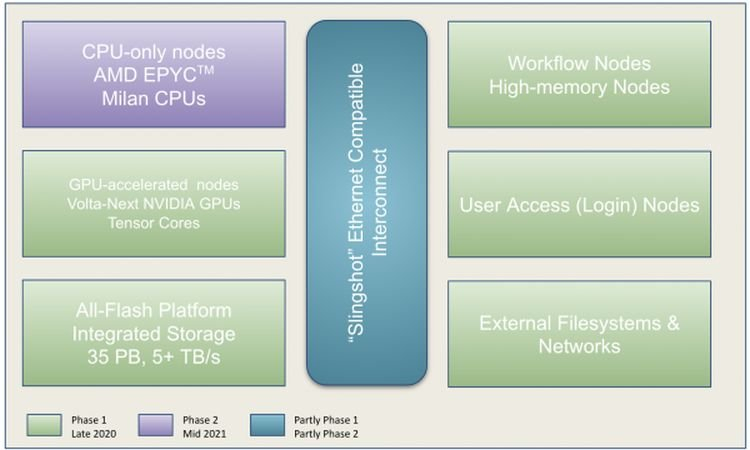

Perlmutter стал самым мощным ИИ-суперкомпьютером в мире: 6 тыс. NVIDIA A100 и 3,8 ЭфлопсВ Национальном вычислительном центре энергетических исследований США (NERSC) Национальной лаборатории им. Лоуренса в Беркли состоялась торжественная церемония, посвящённая официальному запуску суперкомпьютера Perlmutter, также известного как NERSC-9, созданного HPE в партнёрстве с NVIDIA и AMD. Это самый мощный в мире ИИ-суперкомпьютер, базирующийся на 6159 ускорителях NVIDIA A100 и примерно 1500 процессорах AMD EPYC Milan. Его пиковая производительность в вычислениях смешанной точности составляет 3,8 Эфлопс или почти 60 Пфлопс в FP64-вычислениях. Perlmutter основан на платформе HPE Cray EX с прямым жидкостным охлаждением и интерконнектом Slingshot. В состав системы входят как GPU-узлы, так и узлы с процессорами. Для хранения данных используется файловая система Lustre объёмом 35 Пбайт скорость обмена данными более 5 Тбайт/с, которая развёрнута на All-Flash СХД HPE ClusterStor E1000 (тоже, к слову, на базе AMD EPYC). Установка Perlmutter разбита на два этапа. На сегодняшней презентации было объявлено о завершении первого (Phase 1) этапа, который начался в ноябре прошлого года. В его рамках было установлено 1,5 тыс. вычислительных узлов, каждый из которых имеет четыре ускорителя NVIDIA A100, один процессор AMD EPYC Milan и 256 Гбайт памяти. На втором этапе (Phase 2) в конце 2021 года будут добавлены 3 тыс. CPU-узлов c двумя AMD EPYC Milan и 512 Гбайт памяти., а также ещё ещё 20 узлов доступа и четыре узла с большим объёмом памяти.

NERSC Также на первом этапе были развёрнуты служебные узлы, включая 20 узлов доступа пользователей, на которых можно подготавливать контейнеры с приложениями для последующего запуска на суперкомпьютере и использовать Kubernetes для оркестровки. Среда разработки будет включать NVDIA HPC SDK в дополнение к наборам компиляторов CCE (Cray Compiling Environment), GCC и LLVM для поддержки различных средств параллельного программирования, таких как MPI, OpenMP, CUDA и OpenACC для C, C ++ и Fortran. Сообщается, что для Perlmutter готовится более двух десятков заявок на вычисления в области астрофизики, прогнозирования изменений климата и в других сферах. Одной из задач для новой системы станет создание трёхмерной карты видимой Вселенной на основе данных от DESI (Dark Energy Spectroscopic Instrument). Ещё одно направление, для которого задействуют суперкомпьютер, посвящено материаловедению, изучению атомных взаимодействий, которые могут указать путь к созданию более эффективных батарей и биотоплива.

17.05.2021 [18:26], Сергей Карасёв

Иран запустил Simurgh, свой самый мощный суперкомпьютерВ Иране введён в эксплуатацию самый мощный в стране вычислительный комплекс: система получила название Simurgh — в честь фантастического существа в иранской мифологии, царя всех птиц. Суперкомпьютер разработан специалистами Технологического университета имени Амира Кабира (Amirkabir University of Technology). Смонтирована система в Иранском исследовательском центре высокопроизводительных вычислений (IHPCRC). В настоящее время быстродействие комплекса составляет 0,56 Пфлопс. В дальнейшем мощность суперкомпьютера планируется довести до 1 Пфлопс — на доработку системы потребуется около двух месяцев. Конфигурация суперкомпьютера не раскрывается, а появление его в публичных рейтингах производительности вряд ли стоит ожидать. Новый суперкомпьютер, по словам представителей власти, по мощности приблизительно в 100 раз превосходит системы высокопроизводительных вычислений, до сих пор применявшиеся в Иране. Система будет использоваться для задач в области генетики, Big Data, ИИ, интернета вещей и так далее. Часть мощностей будет выделена для облачных систем. Интернет-источники отмечают, что Simurgh, по всей видимости, построен с использованием комплектующих, приобретённых на «чёрном» рынке, поскольку официально Иран не может закупать многие современные технологии из-за санкций — несколько лет назад ZTE получила крупный штраф из-за нелегальных поставок оборудования в страну. Тем не менее, Ирану периодически удаётся получить необходимые компоненты: в начале века был построен кластер из Pentium III/IV, а в 2007 году был построен суперкомпьютер на базе AMD Opteron.

15.04.2021 [21:24], Игорь Осколков

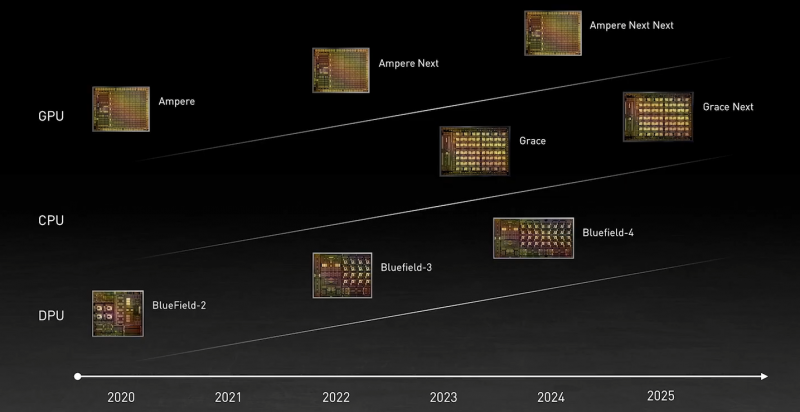

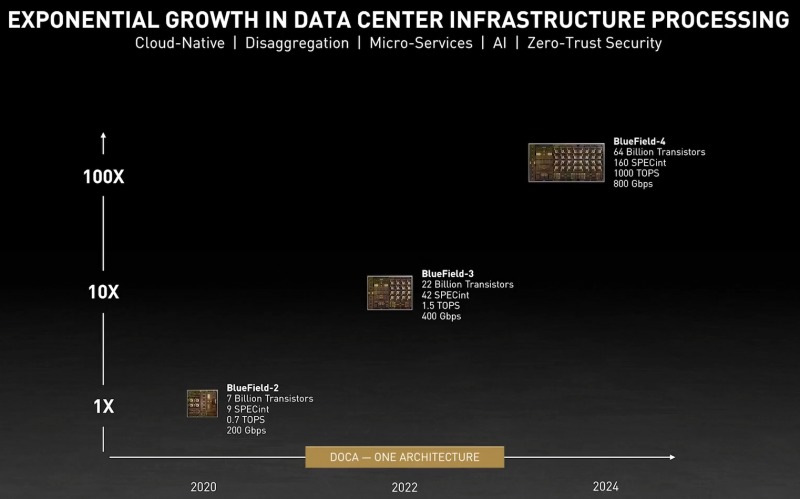

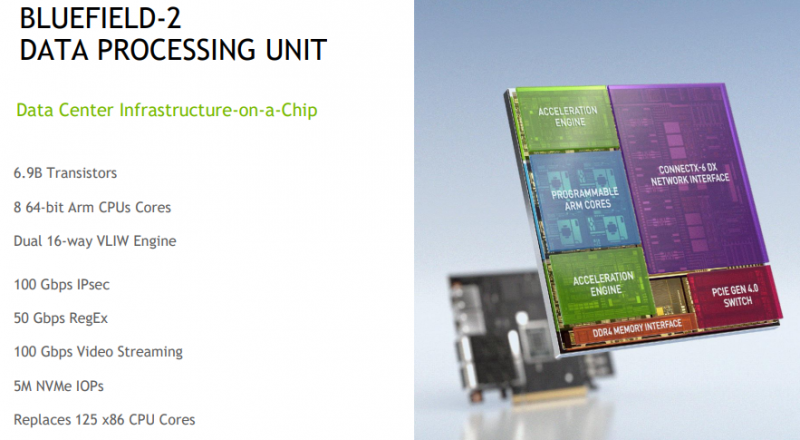

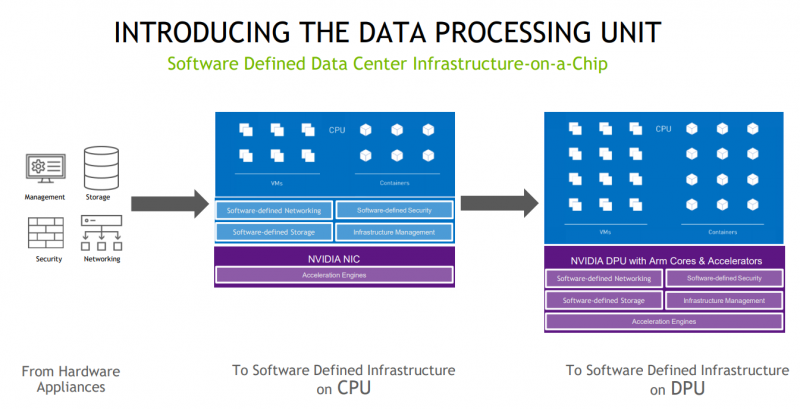

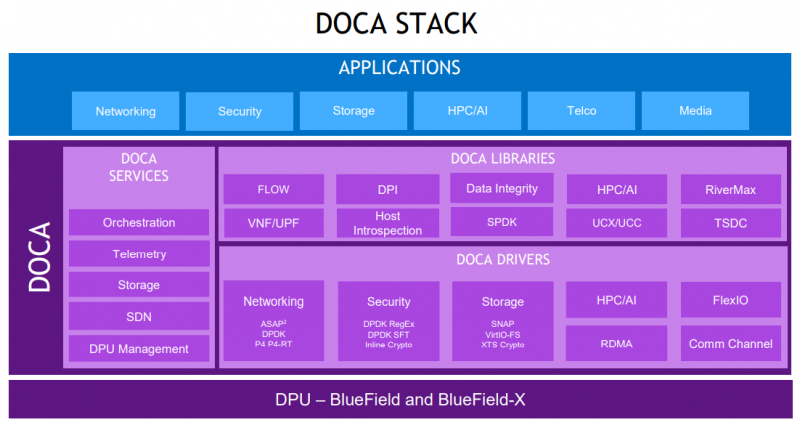

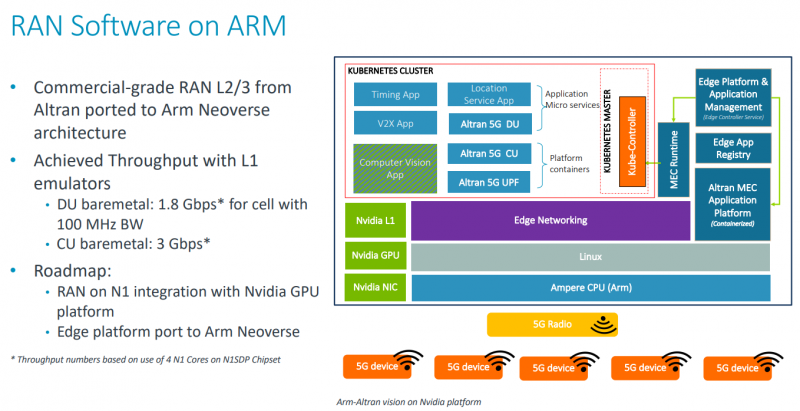

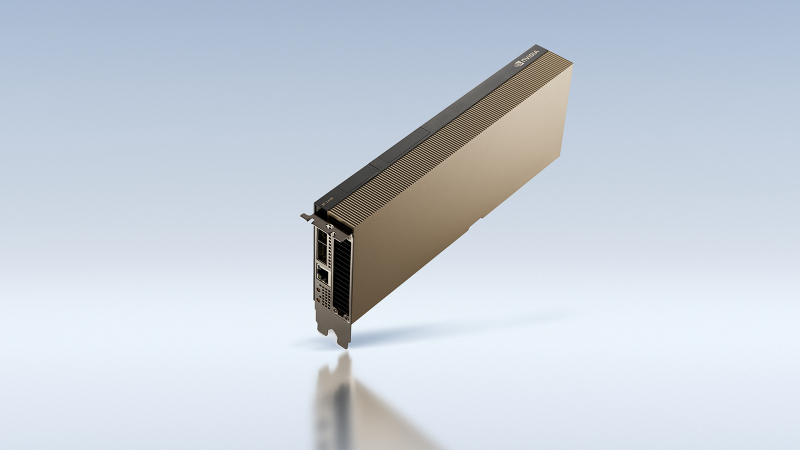

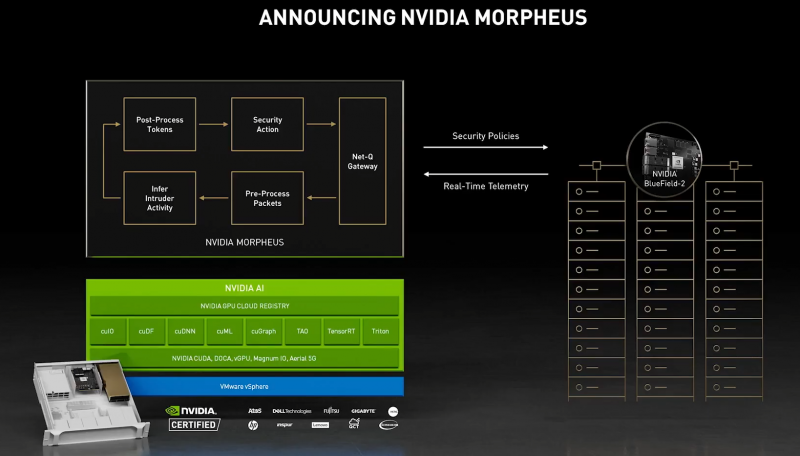

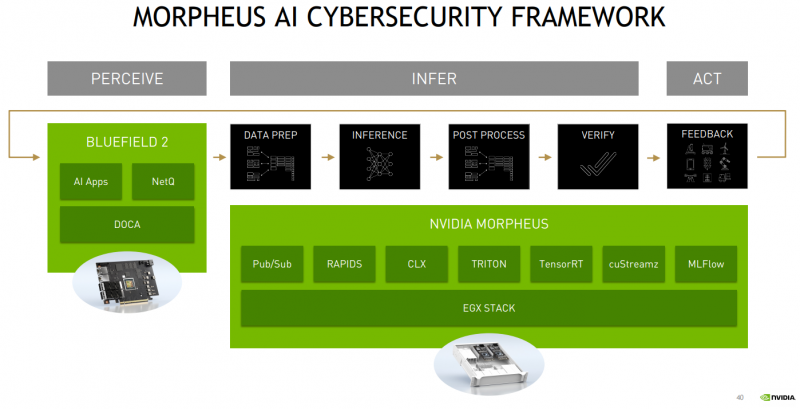

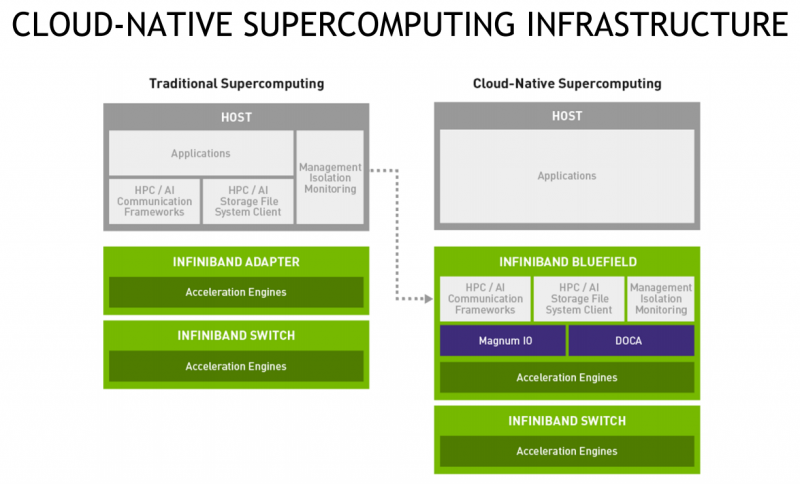

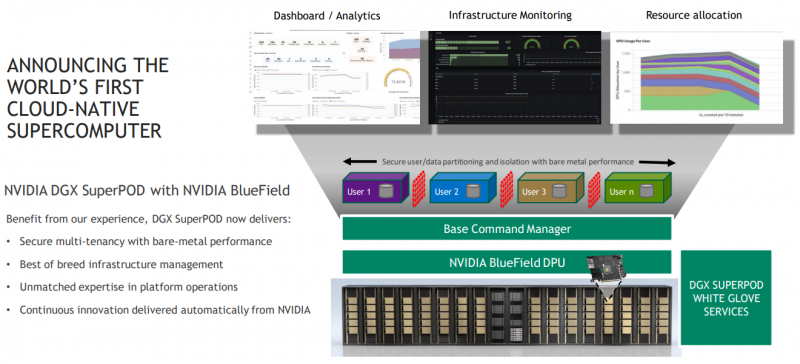

DPU BlueField — третий столп будущего NVIDIAВо время открытия GTC’21 наибольшее внимание привлёк, конечно, анонс собственного серверного Arm-процессора NVIDIA — Grace. Говорят, из-за этого даже акции Intel просели, хотя в последних решениях самой NVIDIA процессоры x86-64 были нужны уже лишь для поддержки «обвязки» вокруг непосредственно ускорителей. Да, теперь у NVIDIA есть три точки опоры, три столпа для будущего развития: GPU, DPU и CPU. Причём расположение их именно в таком порядке неслучайно. У процессора Grace, который выйдет только в 2023 году, даже по современным меркам «голая» производительность не так уж высока — в SPECrate2017_int его рейтинг будет 300. Но это и неважно потому, что он, как и сейчас, нужен лишь для поддержки ускорителей (которые для краткости будем называть GPU, хотя они всё менее соответствуют этому определению), что возьмут на себя основную вычислительную нагрузку. Гораздо интереснее то, что уже в 2024 году появятся BlueField-4, для которых заявленный уровень производительности в том же SPECrate2017_int составит 160. То есть DPU (Data Processing Unit, сопроцессор для данных) формально будет всего лишь в два раза медленнее CPU Grace, но при этом включать 64 млрд транзисторов. У нынешних ускорителей A100 их «всего» 54 млрд, и это один из самых крупных массово производимых чипов на сегодня. Значительный объём транзисторного бюджета, очевидно, пойдёт не на собственной сетевую часть, а на Arm-ядра и различные ускорители. Анонсированные в прошлом году и ставшие доступными сейчас DPU BlueField-2 намного скромнее. Но именно с их помощью NVIDIA готовит экосистему для будущих комплексных решений, где DPU действительно станут «третьим сокетом», как когда-то провозгласил стартап Fubgible, успевший анонсировать до GTC’21 и собственную СХД, и более общее решение для дата-центров. Однако подход двух компаний отличается. Напомним основные характеристики BlueField-2. Сетевая часть, представленная Mellanox ConnectX-6 Dx, предлагает до двух портов 100 Гбит/с, причём доступны варианты и с Ethernet, и с InfiniBand. Есть отдельные движки для ускорения криптографии, регулярных выражений, (де-)компрессии и т.д. Всё это дополняют 8 ядер Cortex-A78 (до 2,5 ГГц), от 8 до 32 Гбайт DDR4-3200 ECC, собственный PCIe-свитч и возможность подключения M.2/U.2-накопителя. Кроме того, будет вариант BlueField-2X c GPU на борту. Характеристики конкретных адаптеров на базе BlueField-2 отличаются, но, в целом, перед нами полноценный компьютер. А сама NVIDIA называет его DOCA (DataCenter on a Chip Architecture), дата-центром на чипе. Для работы с ним предлагается обширный набор разработчика DOCA SDK, который включает драйверы, фреймворки, библиотеки, API, службы и собственно среду исполнения. Все вместе они покрывают практически все возможные типовые серверные нагрузки и задачи, а также сервисы, которые с помощью SDK относительно легко перевести в разряд программно определяемых, к чему, собственно говоря, все давно стремятся. NVIDIA обещает, что DOCA станет для DPU тем же, чем стала CUDA для GPU, сохранив совместимость с последующими версиями ПО и «железа». На базе этого программно-аппаратного стека компания уже сейчас предлагает несколько решений. Первое — платформа NVIDIA AI Enterprise для простого, быстрого и удобного внедрения ИИ-решений. В качестве основы используется VMware vSphere, где развёртываются виртуальные машины и контейнеры, что упрощает работу с инфраструктурой, при этом производительность обещана практически такая же, как и в случае bare-metal. DPU и в текущем виде поддерживают возможность разгрузки для некоторых задач, но VMware вместе с NVIDIA переносят часть типовых задач гипервизора с CPU непосредственно на DPU. Кроме того, VMware продолжает работу над переносом своих решений с x86-64 на Arm, что вполне укладывается в планы развития Arm-экосистемы со стороны NVIDIA. Одним из направлений является 5G, причём работа ведётся по нескольким направлениям. Во-первых, сама Arm разрабатывает периферийную платформу на базе Ampere Altra, дополненных GPU и DPU. Во-вторых, у NVIDIA конвергентное решение — ускоритель Aerial A100, который объединяет в одной карте собственно A100 и DPU. При этом он может использоваться как для ускорения работы собственно радиочасти, так и для обработки самого трафика и реализации различных пограничных сервисов. Там же, где не требуется высокая плотность (как в базовой станции), NVIDIA предлагает использовать более привычную EGX-платформу с раздельными GPU (от A100 и A40 до A30/A10) и DPU. Одним из вариантов комплексного применения таких платформ является проект Morpheus. В его рамках предполагается установка DPU в каждый сервер в дата-центре. Мощностей DPU, в частности, вполне хватает для инспекции трафика, что позволяет отслеживать взаимодействие серверов, приложений, ВМ и контейнеров внутри ЦОД, а также, очевидно, применять различные политики в отношении трафика. DPU в данном случае выступают как сенсоры, данных от которых стекаются в EGX, и, вместе с тем локальными шлюзами безопасности. Ручная настройка политик и отслеживание поведения всего парка ЦОД возможны, но не слишком эффективны. Поэтому NVIDIA предлагает как возможность обучения, так и готовые модели (с дообучением по желанию), которые исполняются на GPU внутри EGX и позволяют быстро выявить аномальное поведение, уведомить о нём и отсечь подозрительные приложения или узлы от остальной сети. В эпоху микросервисов, говорит компания, более чем актуально следить за состоянием инфраструктуры внутри ЦОД, а не только на его границе, как было раньше, когда всё внутри дата-центра по умолчанию считалось доверенной средой. Кроме того, с помощью DPU и DOCA можно перевести инфраструктуру ЦОД на облачную модель и упростить оркестрацию. Но не только ЦОД — обновлённая суперкомпьютерная платформа DGX SuperPOD for Enterprise теперь тоже обзавелась DPU (с InfiniBand) и ПО Base Command, которые позволяют «нарезать» машину на изолированные инстансы с необходимой конфигурацией, упрощая таким образом совместное использование и мониторинг. А это, в свою очередь, повышает эффективность загрузки суперкомпьютера. Base Command выросла из внутренней системы управления Selene, собственным суперкомпьютером NVIDIA, на котором, например, компания обучает модели. DPU доступны как отдельные устройства, так и в составе сертифицированных платформ NVIDIA и решений партнёров компании, причём спектр таковых велик. Таким образом компания пытается выстроить комплексный подход, предлагая программно-аппаратные решения вкупе с данными (моделями). Аналогичный по своей сути подход исповедует Intel, а AMD с поглощением Xilinx, надо полагать, тоже будет смотреть в эту сторону. И «угрозу» для них представляют не только GPU, но теперь и DPU. А вот новые CPU у NVIDIA, вероятно, на какое-то время останутся только в составе собственных продуктов, в независимости от того, разрешат ли компании поглотить Arm. |

|