Лента новостей

|

10.10.2025 [17:37], Руслан Авдеев

Подобранные ИИ бактерии спасут ЦОД от дефицита медиПричиной следующего экзистенциального кризиса интернета, похоже, станут не дезинформация и не дипфейки. По словам основателя стартапа Endolith Лиз Деннетт (Liz Dennett), индустрия ЦОД остро нуждается в меди, для которой найден обновлённый способ добычи, сообщает IEEE Spectrum. Вся современная IT-инфраструктура зависит от меди. Создание ИИ ЦОД лишь ускоряет рост спроса, поскольку для одного дата-центра гиперскейл-уровня требуется более 2 тыс. т меди или около 27 т/МВт. McKinsey прогнозирует, что только развитие линий электропередачи может привести к росту годового спроса на медь в мире до 37 млн т к 2031 году. Хуже того, запасы доступной меди истощаются — более 70 % мировых резервов находятся в рудах, трудно поддающихся обработке, а это десятки миллиардов тонн. При этом потенциал таких «непривлекательных» запасов огромен. В 2023 году Деннетт основала стартап Endolith для извлечения меди из нерентабельных ныне источников. Помогут в этом микроорганизмы. Эволюционировавшие естественным путём бактерии оказались довольно эффективны для добычи меди из «сложных» руд вроде халькопирита и энаргита. При этом они хорошо переносят воздействие неблагоприятной среды, и при добыче меди с их помощью потребуется меньше энергии, чем при использовании традиционных методов вроде высокотемпературной плавки или химического выщелачивания, оставляющих после себя большое количество отходов. Бактерии ускоряют естественный процесс биовыщелачивания. Микроорганизмы можно подобрать к химическому составу разных пород, что позволит извлекать больше металла и окажет меньшее влияние на окружающую среду. Для этого используется ИИ. Свойства тысяч микробов учитываются при моделировании процессов получения меди. Это позволяет прогнозировать, какие штаммы оптимально подойдут для тех или иных условий, не полагаясь на медленный метод проб и ошибок. Технологию уже изучают некоторые крупные производители меди, включая BHP. Разрабатываемые Endolith «биоинкубаторы» представляют собой полевые установки для выращивания и доставки специально подобранных микроорганизмов. Они могут быть развёрнуты за считанные дни и адаптированы под местные условия. Скептики отмечают, что биовыщелачивание — технология довольно старая и исторически малопригодная для работы с рудами вроде халькопирита. О том, что развитие рынка ИИ со многом зависит от наличия чистой меди, говорилось ещё в конце 2024 года. Более того, есть и ещё один источник металла, который поможет справиться с дефицитом. В январе 2025 года сообщалось, что телеком-компании смогут заработать миллиарды долларов, сдав в переработку старые медные кабели.

10.10.2025 [16:34], Руслан Авдеев

Google вложит €5 млрд в ИИ и облако в БельгииВ следующие два года Google намерена потратить дополнительные €5 млрд ($5,8 млрд) в облачную и ИИ-инфраструктуру Бельгии. Инвестиции пойдут на расширение ЦОД в Сен-Гислене (Saint-Ghislain) и позволят создать ещё 300 постоянных рабочих мест, сообщает Datacenter Dynamics. Дополнительно компания намерена объединить усилия с Eneco, Luminous и Renner для строительства наземных ветряных электростанций. Google намерена укрепить свои позиции в Бельгии, поэтому расширяет инвестиции и создаёт новые возможности для преобразований страны с помощью ИИ. О проекте упомянул и премьер-министр страны Барт де Вевер (Bart Albert Liliane De Wever), заявив, что инвестиции Google — весомый символ доверия к Бельгии как к центру цифровых инноваций и устойчивого развития. По его словам, расширяя передовую облачную и ИИ-инфраструктуру в стране, создавая рабочие места для квалифицированных сотрудников и новые источники безуглеродной энергии, Бельгия укрепляет собственную экономику и ускоряет переход на возобновляемую энергию. Проект имеет для неё и стратегическое значение, позволяя укрепиться в роли лидера в формировании цифрового будущего Европы.

Источник изображения: Google В 2009 году Google впервые открыла дата-центр в Бельгии, там расположен облачный регион компании Europe-west1. Кампус в Сен-Гислене — первый кампус Google в Европе, неоднократно расширявшийся. По состоянию на апрель 2024 года он занимал территорию 90 га, где размещалось пять ЦОД и солнечная электростанция. Также она строит кампус в Фарсьене (Farciennes, провинция Эно), проект стартовал в апреле 2024 года. По информации Google, с 2007 года гиперскейлер уже инвестировал более €5 млрд в инфраструктуру ЦОД в Бельгии. AWS управляет локальной зоной доступности в Брюсселе, но не имеет облачного региона в стране. Microsoft управляет облачным регионом в Бельгии, получившим название belgiumcentral. Впрочем, приоритетными для Google и других компаний остаются США. Только на ИИ и облачную инфраструктуру в Оклахоме Google готова потратить $9 млрд, не считая других проектов.

10.10.2025 [15:25], Владимир Мироненко

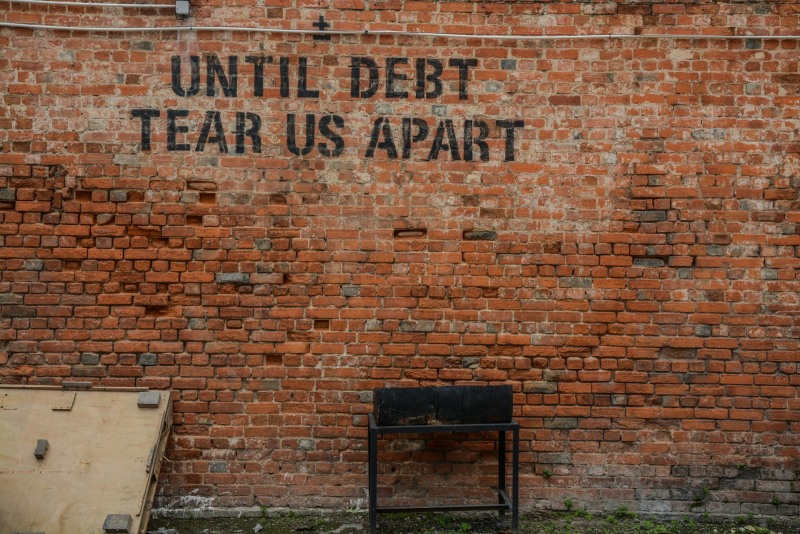

Бизнес Oracle по сдаче в аренду ИИ-мощностей оказался не таким прибыльным, как ожидалосьБизнес Oracle по сдаче в аренду ИИ-серверов оказался гораздо менее прибыльным, чем ранее прогнозировали фондовые аналитики, сообщил ресурс The Information после ознакомления со внутренними документами компании, о чём пишет DataCenter Dynamics. Средняя валовая рентабельность Oracle по сделкам с такими компаниями, как OpenAI, составила всего лишь 16 %, хотя выручка за последний год утроилась. Что касается новейших ускорителей NVIDIA, то компания терпит убытки, составившие почти $100 млн от сдачи в аренду чипов Blackwell за I квартал 2026 финансового года, закончившийся в августе. По данным The Information, за последний квартал Oracle выручила $900 млн от сдачи в аренду ИИ-серверов, получив валовую прибыль в размере $125 млн, или 14 центов на каждый доллар продаж. Компания не раскрывает финансовые показатели по использованию ИИ-серверов. На рентабельность влияют различные факторы, включая зарплату, стоимость электроэнергии и другие эксплуатационные расходы ЦОД Oracle, а также амортизационные расходы на оборудование. Кроме того, существует разрыв во времени между покупкой чипов и началом их использования клиентами. Oracle сообщила, что на конец I квартала 2026 финансового года благодаря подписанию многомиллиардных контрактов с тремя клиентами объём оставшихся обязательств по контрактам (RPO) составил более $455 млн. Позже выяснилось, что был заключён контракт с OpenAI на $300 млрд. Аналитики полагают, что для финансирования этой сделки Oracle может потребоваться привлечь до $100 млрд заёмных средств в течение следующих четырёх лет для наращивания мощностей. В прошлом месяце Oracle продала серию облигаций инвестиционного уровня на сумму $18 млрд для расширения бизнеса и строительства ИИ-инфраструктуры. Следует отметить, что речь идёт лишь о части бизнес-предложения Oracle. Как полагает The Information, если доля аренды ИИ-серверов в общем объёме бизнеса Oracle продолжит расти, общая валовая рентабельность снизится с нынешних 70 %. Ресурс предупредил, что это затронет всех основных провайдеров облачных услуг, поскольку ИИ-серверы на чипах NVIDIA значительно дороже традиционных серверов и их использование требует дополнительных расходов, в том числе на специализированное сетевое оборудование и электроэнергию. Чтобы привлечь клиентов, поставщики облачных услуг предлагают скидки, что также отражается на прибыльности бизнеса. The Information назвал такую ситуацию плохой новостью для Oracle, но не все эксперты разделяют это мнение. По мнению ряда аналитиков, рентабельность вполне соответствует ожиданиям. Например, согласно отчёту Investor's Business Daily, аналитик Stifel Брэд Рибак (Brad Reback) ранее прогнозировал валовую рентабельность облачного бизнеса Oracle примерно в 16 %. Он также указал в аналитической записке для инвесторов, что «по мере масштабирования этого сегмента OCI валовая рентабельность должна существенно вырасти». Аналитик Guggenheim Джон ДиФуччи (John DiFucci) тоже считает, что вышеупомянутый разрыв между вводом мощностей в эксплуатацию и оплатой клиентами не следует воспринимать как дурное предзнаменование. «Мы не удивимся, если увидим более низкую валовую рентабельность в начале сделки по обучению ИИ до начала получения дохода, но мы считаем разумным ожидать, что любая сделка будет обеспечивать не менее 25 % валовой рентабельности в течение всего срока её действия — иначе Oracle её не подпишет», — заявил ДиФуччи. Следует также учесть мнение NVIDIA по этому поводу, генеральный директор которой Дженсен Хуанг (Jensen Huang) отверг критику финансового положения Oracle, заявив, что компания «будет невероятно успешна». «Когда вы только начинаете внедрять новую технологию, вполне вероятно, что поначалу вы можете не заработать, но со временем система станет невероятно прибыльной», — сказал Хуанг.

10.10.2025 [14:50], Руслан Авдеев

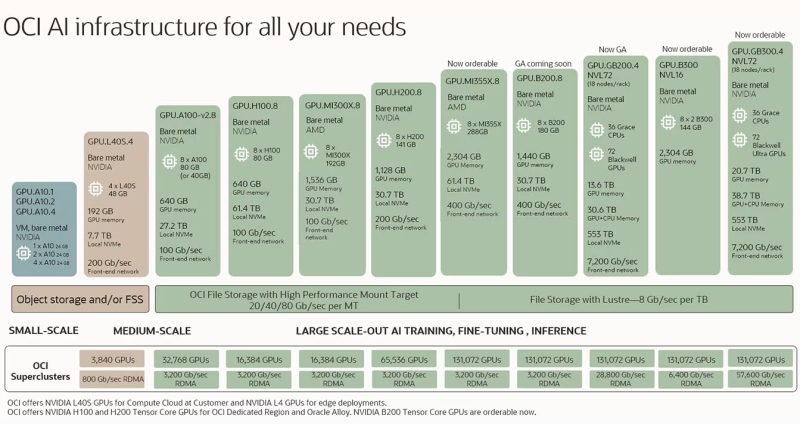

Не для себя стараемся: Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72Microsoft представила первый в мире ИИ-кластер, использующий более 4,6 тыс. NVIDIA Blackwell Ultra в составе суперускорителей NVIDIA GB300 NVL72, объединённых интерконнектом Quantum-X800 InfiniBand. Этот кластер — лишь первый из многих. Компания развернёт сотни тысяч ускорителей Blackwell Ultra в ИИ ЦОД по всему миру. Благодаря им Microsoft намерена стать первой, поддерживающей обучение для моделей с сотнями триллионов параметров. Как сообщают в Microsoft, запуск в Microsoft Azure суперкластера NVIDIA GB300 NVL72 стал важным шагом в развитии передовых ИИ-технологий. Разработанная совместно с NVIDIA система представляет собой первый в мире масштабируемый ИИ-кластер на основе GB300, обеспечивающий вычислительные мощности, необходимые OpenAI для обслуживания моделей с триллионами параметров. Речь идёт о новом стандарте ускоренных вычислений, говорят компании. Новые инстансы Azure ND GB300 v6 оптимизированы для рассуждающих моделей, агентных систем и мультимодального генеративного ИИ. Каждая стойка GB300 NVL72 обслуживает 18 виртуальных машин, а сам суперускоритель с производительностью до 1,44 Эфлопс (FP4 Tensor Core) включает:

Источник изображения: Microsoft Создание передовой инфраструктуры требует переосмысления всех уровней системы, включая вычисления, память, системы охлаждения и питания, ЦОД в целом как единой структуры. Новая архитектура стоек обеспечивает высокую пропускную способность инференса при меньших задержках на крупных моделях, это позволяет агентным и мультимодальным ИИ-системам быть более масштабируемыми и эффективными, чем когда-либо, говорит компания. Для масштабирования за пределы стойки используется NVIDIA Quantum-X800 InfiniBand, что гарантирует обучения сверхбольших моделей с применением десятков тысяч ИИ-ускорителей с минимальными накладными расходами на их синхронизацию, что дополнительно повышает производительность.

Источник изображения: Microsoft Передовые системы охлаждения Azure используют автономные теплообменники, чтобы свести к минимуму расход воды и поддерживать температурную стабильность для высокоплотных кластеров. Также продолжается разработка и внедрение новых моделей распределения питания, обеспечивающих высокую энергетическую плотность и динамический баланс нагрузок. Дополнительную помощь в оптимизации работы оказывает и модернизированное программное обеспечение. Ранее Microsoft обладала эксклюзивными правами на предоставление облачных сервисов компании OpenAI, но в январе 2025 года появилась новость, что ИИ-стартапу разрешили пользоваться и облаками других провайдеров, если у Microsoft не хватит собственных мощностей. Разногласия между компаниями продолжают нарастать. Формально первенство по создание кластера на базе GB300 NVL72 принадлежит CoreWeave, имеющей тесные отношения с NVIDIA и обслуживающей OpenAI — как напрямую, так и при посредничестве Microsoft.

10.10.2025 [14:07], Руслан Авдеев

Dell удвоила прогноз выручки из-за высокого проса на ИИ-решенияСогласно последним прогнозам Dell, рост годовой выручки компании составит 7–9 %, что почти вдвое прошлого прогноза на уровне 3-4 %. Это связано с тем, что спрос на ИИ-решения превзошёл все ожидания, сообщает eWeek. Прибыль на акцию составит 15 % или более, что тоже вдвое превышает предыдущий целевой показатель в 8 %. Глава компании Майкл Делл (Michael Dell) назвал возможности ИИ «огромными», поскольку клиенты борются за доступ к ИИ-вычислениям и сетевой инфраструктуре для масштабного развёртывания ИИ-проектов. Бизнес Dell по производству ИИ-серверов в некоторой степени стал напоминать «машину для печатания денег», цели компании в этой сфере растут квартал за кварталом. Она уже увеличила годовой прогноз поставок ИИ-серверов ещё на $5 млрд, доведя его до $20 млрд. По данным Nasdaq, только за II квартал компания поставила таких серверов на $8,2 млрд. По информации Futurum Group, обнародованным в сентябре, дополнительный портфель заказов на год составил $11,7 млрд, а поставки ИИ-решений за I полугодие уже превысили общие показатели за прошлый год. Отложенный спрос фактически конвертируется в многочисленные заказы, что станет драйвером многолетнего цикла поставок.

Источник изображения: Dell В настоящее время Dell позиционирует себя как «тяжеловес» на рынке ИИ-инфраструктуры. Согласно последним данным, приведённым подразделением Infrastructure Solutions Group два месяца назад, отмечен рост выручки на 44 % в годовом исчислении — до $16,8 млрд. Львиная доля — $12,9 млрд приходится на серверы и сетевое оборудование. Меняется и положение акционеров. Dell обязалась ежегодно увеличивать дивиденды на 10 % и более до 2030 финансового года, тем самым продлив обязательства на два года. В текущем году акции выросли на 27 %, хотя это всё ещё не дотягивает до пиковых значений 2024 года, когда цена акций составила $175. Сильный операционный денежный поток в $2,5 млрд за квартал и стратегический подход к долгу обеспечивают компании возможность инвестировать в развитие ИИ-бизнеса, не жертвуя выплатами инвесторам. Рост Dell — часть более масштабной картины перезагрузки корпоративных расходов, меняющей рынок серверов. По прогнозам экспертов, сегмент ИИ-серверов в 2025 году вырастет на 55 % и достигнет $252 млрд. По данным прогноза Bloomberg Intelligence, на Dell придётся значительная доля наряду с HPE и Lenovo. Меняется и экономика ИИ-бизнеса «на местах». Если предыдущие поколения серверных ИИ-стоек обходились в $1,5–$3 млн, то новые — $3–$4 млн за шт., в результате чего выручка производителей с каждого клиента значительно вырос.

10.10.2025 [12:00], Сергей Карасёв

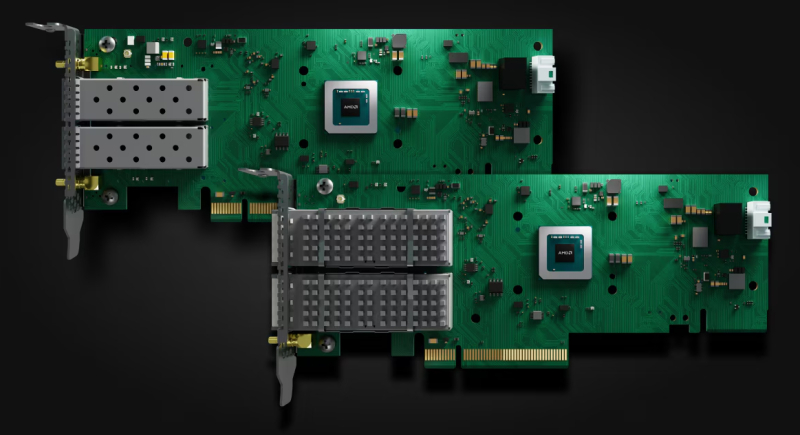

AMD представила Ethernet-адаптеры Solarflare X4 со сверхнизкой задержкойКомпания AMD анонсировала Ethernet-адаптеры Solarflare X4 для систем, в которых критическое значение имеет минимальная задержка. Это могут быть платформы для трейдинга, анализа финансовых данных в реальном времени и других задач, где, как подчеркивается, важна каждая наносекунда. В семейство Solarflare X4 вошли две модели — X4542 и X4522. По сравнению с изделиями Solarflare предыдущего поколения новинки, по заявлениям AMD, обеспечивают уменьшение задержки до 40 %. Производительность на системном уровне увеличилась на 200 % по отношению к адаптерам Solarflare X2. Обе новинки выполнены в виде низкопрофильных карт расширения половинной длины с интерфейсом PCIe 5.0 x8. В основу положена кастомизированная ASIC, обеспечивающая сверхнизкие задержки. AMD уверяет, что при использовании адаптеров в связке с процессорами EPYC 4005 Grado достигается снижение задержки до 12 % по сравнению с аналогичными по классу решениями конкурентов. Версия Solarflare X4542 оснащена двумя разъёмами QSFP с поддержкой двух портов 40/50/100GbE или четырёх портов 1/10/25GbE. Модификация Solarflare X4522, в свою очередь, получила два разъёма SFP с поддержкой пары портов 1/10/25/50GbE. Карты оснащены пассивным охлаждением. Энергопотребление составляет менее 25 Вт. Для адаптеров доступно фирменное ПО AMD Solarflare Onload, которое отвечает за повышение производительности при работе с ресурсоёмкими сетевыми приложениями, такими как резидентные базы данных, программные балансировщики нагрузки и веб-серверы. Solarflare Onload помогает поднять эффективность обработки огромных объёмов небольших пакетов данных — даже в периоды пиковой нагрузки. AMD отмечает, что 9 из 10 крупнейших мировых фондовых бирж используют решения Solarflare для обеспечения работы своих торговых платформ.

10.10.2025 [10:11], Сергей Карасёв

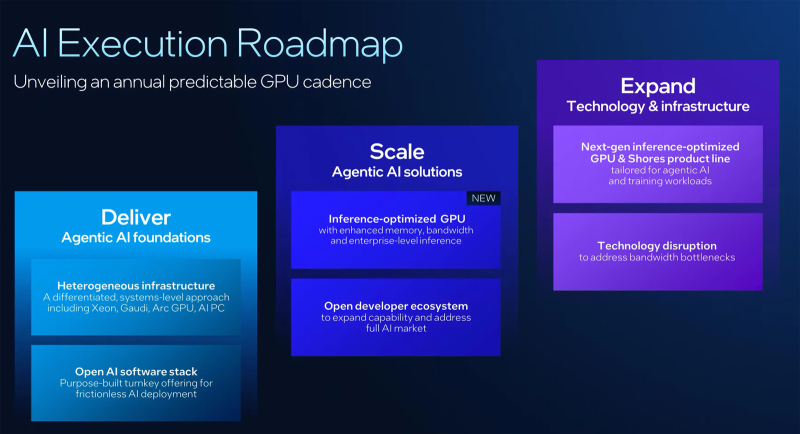

Intel готовит новый GPU-ускоритель, оптимизированный для инференсаКорпорация Intel в ходе мероприятия Intel Tech Tour Arizona сообщила о подготовке новых ИИ-ускорителей на базе GPU. Речь идёт об изделиях, специально оптимизированных для задач инференса. Кроме того, компания поделилась планами по развитию ИИ-продуктов в целом. Ранее предполагалось, что в 2025 году Intel выведет на рынок ускорители Falcon Shores. Изначально планировалось, что это будут гибридные решения, содержащие блоки CPU и GPU. Однако впоследствии Intel сделала выбор в пользу конфигурации исключительно на основе GPU. А затем корпорация и вовсе заявила, что на коммерческом рынке изделия Falcon Shores не появятся. Вместо этого Intel решила сфокусировать внимание на выпуске ускорителей Jaguar Shores. Войдёт ли готовящийся к выпуску GPU для инференса в семейство Jaguar Shores, пока не ясно. Подробности о новинке Intel обещает раскрыть в ходе предстоящего мероприятия 2025 OCP Global Summit, которое пройдёт с 13 по 16 октября в Сан-Хосе (Калифорния, США). На сегодняшний день известно, что устройство получит улучшенную память с высокой пропускной способностью. Изделие будет ориентировано на корпоративный сектор. «Мы активно работаем над оптимизированным для инференса GPU, о котором подробнее расскажем на конференции OCP», — сообщил технический директор Intel Сачин Катти (Sachin Katti). Кроме того, Intel объявила о намерении перейти на ежегодный график выпуска ИИ-продуктов следующего поколения. Предполагается, что это поможет укрепить позиции на глобальном рынке ИИ, на котором корпорация уступила позиции NVIDIA. При этом Intel подчёркивает, что на ближайшую перспективу Jaguar Shores является основным приоритетом в области развития высокопроизводительных решений для ИИ-инфраструктуры.

10.10.2025 [01:23], Владимир Мироненко

Ложная надежда: Synology смягчила требования к использованию сторонних HDD/SSD, но профессиональных систем это не коснулосьSynology объявила о выпуске системы DiskStation Manager (DSM) 7.3, которая, как указано в пресс-релизе, обеспечивает повышенную эффективность хранения, усиленную безопасность и надёжность, а также получила новые функции для повышения производительности. Вместе с тем компания под давлением пользователей ослабила политику ограничения использования сторонних накопителей в своих NAS. Однако поблажки сделаны только для SOHO-пользователей. Как отметил ресурс NAScompares.com, с выпуском DSM 7.3 компания официально представила самый подробный на сегодняшний день пакет политик совместимости с указанием, какие жёсткие диски и твердотельные накопители поддерживаются в её экосистеме. Ограничения DSM 7.2 на использование накопителей сторонних брендов, сделавшее жёсткие диски Seagate, Toshiba и WD, практически непригодными для использования в новых моделях серии DiskStation Plus вызвало серьёзную негативную реакцию со стороны пользователей, которые полагались на гибкий выбор дисков. Представленный в DSM 7.3 фреймворк HCL 5.0 частично смягчает введенные ранее ограничения для DiskStation Plus и серии J 2025 модельного года, возвращая возможность использования неперечисленных в списке совместимых HDD и SSD с интерфейсом SATA для создания пулов. Synology описала это как прагматичную эволюцию своей политики, которая соответствует ожиданиям клиентов. Компания продолжит сотрудничать с основными производителями накопителей для проверки дополнительных моделей. С точки зрения Synology есть три типа накопителей:

Источник изображения: Synology DSM 7.3 теперь отображает более понятные уведомления в диспетчере хранения, различая совместимые, несовместимые и прочие диски, что позволяет оценить влияние выбора оборудования на работу системы до создания томов и кешей. Кроме того, Synology пояснила, что для прохождения сертификации и попадания в список совместимых накопители должны пройти тесты на термические нагрузки, устойчивость к циклам вкл./выкл. и аварийное выключение. В DSM 7.3 Synology пересмотрела подход своих NAS к работе с SATA-дисками, которых нет в списке совместимых и нет в списке несовместимых. Для моделей DS+ Plus 2025 года, включая DS1525+, DS925+ и DS725+, эти диски теперь считаются полностью функциональными и в работе ничем не отличаются от официально совместимых накопителей, поддерживая установку, создание/расширение пулов/томов, работу со снимками и шифрование, использование HyperBackup и т.д., а DSM больше не «ругается» на них. DSM 7.2 блокировала создание пула, если установленный диск не входил в список совместимых. С M.2 NVMe SSD ситуация особая. Для создания новых кешей или пулов хранения требуются только накопители из списка совместимых, поскольку такие диски подвергаются более высоким постоянным нагрузкам записи и выделяют больше тепла при непрерывной работе NAS. Ранее сконфигурированные NVMe SSD по-прежнему можно использовать только при миграции со старых NAS на новые. Гарантия предоставляется в полном объёме, но техподдержка Synology может отказать в помощи с проблемами, которые, как доказано, вызваны оборудованием, не входящим в список совместимых. В то же время корпоративные серии СХД Synology FS, HD, SA, UC, XS+, XS, RS+, RS и DP продолжают работать в соответствии с более строгими правилами, согласно которым для полноценной работы требуются только диски SAS/SATA/NVMe из списка совместимых. SATA-накопители, не входящие в список совместимых, можно использовать только для миграции. Кеширующие накопители вне списка совместимых также запрещены к использованию. Synology объясняет это тем, что для корпоративных нагрузок требуются надёжные накопители с устойчивостью к различным сбоям, в том числе в многоузловых конфигурациях, способностью к корректному восстановлению после сбоев и с заданным уровнем производительности. Похожие аргументы приводятся и в пользу допустимости использования в СХД DVR/NVR SATA-накопителей вне списка совместимых только для миграции данных со старых систем. Совместимые накопители также должны пройти отдельные тесты на возможность непрерывной записи с малым временем отклика. Проблема в том, что Synology не спешит сертифицировать сторонние накопители. Так, Seagate IronWolf/SkyHawk и WD Purple в списках толком нет. Параллельно Synology подталкивает к использованию фирменных накопителей HAT/HAS/SAT. При покупке NAS/СХД вместе с ними можно получить расширенную гарантию сроком до пяти лет. Также Synology запустила программу экспресс-замены, позволяющую производить немедленную замену дисков в течение гарантийного срока, не дожидаясь отправки и проверки неисправного устройства.

09.10.2025 [22:09], Владимир Мироненко

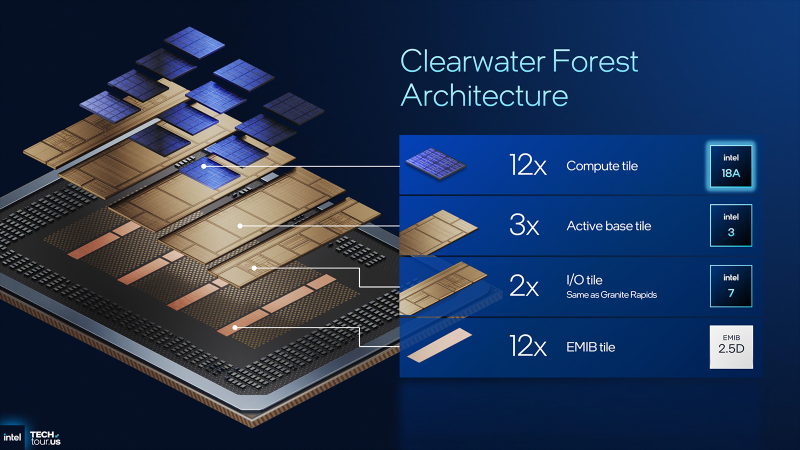

Intel анонсировала процессоры Xeon 6+ — Clearwater Forest с 288 E-ядрами DarkmontIntel раскрыла на мероприятии Intel Tech Tour Arizona новые подробности о следующем поколении серверных процессоров, выполненных по техпроцессу Intel 18A, которые получат название Xeon 6+ (Clearwater Forest) и будут иметь до 288 энергоэффективных ядер Darkmont E-Core, сообщил ресурс Phoronix. В максимальной конфигурации Xeon 6+ включает 12 чиплетов E-Core (Intel 18A с RibbonFET и PowerVia), 3 базовых тайла (Intel 3) и 2 чиплета I/O (Intel 7). 12 EMIB-тайлов объединяют все чиплеты в единую 2.5D-упаковку. Как сообщается, Xeon 6+ имеет в 1,9 раза более высокую пропускную способность памяти по сравнению с предыдущим поколением. Это связано с поддержкой 12 каналов памяти DDR5-8000 по сравнению с восемью каналами DDR5-6400 в процессорах Xeon 6700E (Sierra Forest-SP). Впрочем, у Xeon 6900E (Sierra Forest-AP) тоже поддерживает 12 каналов памяти, хотя и DDR5-6400 (а в 2DPC — 5200). Модули памяти MRDIMM новинки не поддерживают. Производительность Clearwater Forest также обеспечивается L3-кешем объёмом до 576 Мбайт (в 6700E было до 108 Мбайт, а 6900P — до 504 Мбайт), техпроцессом 18A и новой функцией Intel AET. Intel AET (Application Energy Telemetry) — технология телеметрии энергопотребления приложений, помогающая разработчикам/администраторам профилировать и масштабировать рабочие нагрузки на этих процессорах с большим количеством ядер. Intel Xeon 6+ также позиционируется как процессор с улучшенной эффективностью до 23 % по всем видам нагрузок. На ещё одном слайде указано, что у Intel Xeon 6+ «в 1,9 раза более высокая производительность», чем у Xeon 6780E. Ресурс Phoronix вполне справедливо считает такое сравнение некорректным, учитывая удвоенное количество ядер, большее количество каналов памяти и более высокую скорость памяти, больший размер L3-кеша и т. д. Впрочем, есть надежда, что Intel вскоре опубликует более конкретные сравнительные показатели, а также таблицу с моделями Xeon 6+, чтобы получить точное представление о сравнении с серией Xeon 6700E. Intel также подтвердила, что Xeon 6+ будет обладать максимальным TDP в диапазоне от 300 до 500 Вт и совместимостью с одно- и двухсокетными платформами. Также доступно до шести каналов UPI 2.0, до 96 линий PCIe 5.0 и до 64 линий CXL 2.0. Ускорители Intel QAT, DLB, DSA и IAA по-прежнему поддерживаются Xeon 6+, но Intel практически ничего не рассказала об этих блоках.

09.10.2025 [16:50], Руслан Авдеев

«Безответственный» ИИ: большинство компаний пока несут финансовые потери, связанные с внедрением ИИПо данным исследования британской консалтинговой компании EY (Ernst & Young), почти каждый крупный бизнес, внедривший ИИ в свои операции, понёс определённые финансовые потери. Часто это происходит из-за несоблюдения нормативных требований, получения ошибочных результатов, «предвзятости» или негативного влияния на достижение целей устойчивого развития, сообщает Reuters. Несколько реже сообщалось о репутационном ущербе и юридических проблемах. В июле-августе 2025 года EY провела анонимный опрос среди 975 топ-менеджеров, курирующих внедрение ИИ в компаниях со всего мира с годовым оборотом не менее $1 млрд. Совокупные потери бизнеса оцениваются в $4,4 млрд, при этом от ожиданий бизнеса отставали показатели вроде роста выручки, уровня экономии затрат и степени удовлетворённости сотрудников. Тем не менее, представители опрошенных компаний настроены оптимистично и полагают, что внедрение ИИ в конце концов принесёт ощутимые плоды.

Источник изображения: micheile henderson/unsplash.com По словам представителя EY, искусственный интеллект, безусловно, повышает производительность и эффективность бизнеса — сотрудники при прочих равных способны выполнять больше задач и делать это быстрее. При этом создание ценности не настолько велико, поскольку часто удаётся выполнять больший объём работы, а не обязательно сокращать расходы или получать немедленную выручку. Исследование EY уделяло основное внимание «ответственному внедрению ИИ» — ряду показателей, которые дают возможность оценить, разработал ли бизнес внутреннюю политику управления ИИ, довели ли до пользователей чёткие правила эксплуатации и осуществляют ли контроль за соблюдением правил. По словам EY, компании с более подробно разработанной политикой «ответственного ИИ» (Responsible AI) утверждают, что добились больших продаж, сокращения затрат и большее высокой степени удовлетворённости сотрудников. Примечательно, что жертвой ИИ недавно стал другой консалтинговый гигант — компания Deloitte, представившая австралийскому правительству документ с фейковыми ссылками, цитатами и даже полностью выдуманной выдержкой из постановления Австралийского федерального суда. |

|