Лента новостей

|

13.05.2024 [12:27], Руслан Авдеев

DigitalBridge: энергия для ЦОД закончится через два годаРуководитель DigitalBridge Марк Ганзи (Marc Ganzi) выступил с чрезвычайно пессимистичным прогнозом. По данным Datacenter Dynamics, он уверен, что энергия для дата-центров закончится уже через два года — значительно раньше, чем прежде считали в самой компании. Американская DigitalBridge владеет ЦОД и инвестирует в инфраструктуру по всему миру. На её долю приходится более 60 дата-центров и 20 интерконнект-хабов на 30 региональных рынках, а также модульная ЦОД-платформа для периферийных вычислений. Выступление главы бизнеса состоялось в ходе отчёта о финансовых показателях I квартала 2024 года. По словам Ганзи, энергия будет исчерпана в ближайшие 18–24 месяца. Ранее он был более оптимистичен — на мероприятии Berlin Infrastructure Conference руководитель DigitalBridge заявлял, что электричество для ЦОД закончится только через пять лет.

Источник изображения: American Public Power Association/unsplash.com По его мнению, в американских сетях остался резерв менее 7 ГВт и менее 3 ГВт — в Европе. Проблема даже не только и не столько в производстве энергии, сколько в её передаче и распределении, поскольку допустимая ёмкость сетей электропередач ограничена. При этом бизнесмен подчеркнул, что разрешение на новую линию электропередач или подстанцию гораздо сложнее получить, чем, например, на вышку мобильной связи. В DigitalBridge сообщают, что к концу 2023 года компания зарезервировала доступ к более 5 ГВт, а сейчас идёт строительство 2 ГВт ёмкостей. При расходах по $10 млн за МВт, компания ожидает, что капитальные издержки в грядущие годы составят $20 млрд. Также Ганзи добавил, что DigitalBridge намерена построить объекты ёмкостью 3 ГВт при сотрудничестве с Silver Lake для удовлетворения спроса на ИИ и облачную инфраструктуру. Ранее Ганзи заявлял, что потенциал рынка ЦОД для генеративных облачных ИИ-решений, кабелей и другого оборудования имеет ёмкость в 38 ГВт и сотни миллионов долларов. Компания намерена обучать ИИ-модели с низкой задержкой с использованием ЦОД, расположенных недалеко от существующих «зелёных» энергомощностей, т.е. ветряных, солнечных, газовых и гидроэлектростанций. Например, принадлежащий DigitalBridge оператор ЦОД — компания Switch использует преимущественно ветряную и солнечную энергию, активно применяются и гидроресурсы. Ганзи назвал искусственный интеллект частью решения проблемы энергетики, по его словам, ИИ будет внедряться для оптимизации дата-центров DigitalBridge.

13.05.2024 [11:12], Сергей Карасёв

Supermicro представила ИИ-серверы на базе Intel Gaudi3 и AMD Instinct MI300XКомпания Supermicro анонсировала новые серверы для задач ИИ и НРС. Дебютировали системы высокой плотности с жидкостным охлаждением, а также устройства, оборудованные высокопроизводительными ускорителями AMD, Intel и NVIDIA.

Источник изображений: Supermicro В частности, представлены серверы SYS-421GE-TNHR2-LCC и AS-4125GS-TNHR2-LCC в форм-факторе 4U, оснащённые СЖО. Первая из этих моделей рассчитана на установку двух процессоров Intel Xeon Emerald Rapids или Xeon Sapphire Rapids (до 385 Вт), а также 32 модулей DDR5-5600. Второй сервер поддерживает два чипа AMD EPYC 9004 Genoa с показателем TDP до 400 Вт и 24 модуля DDR5-4800. Обе новинки могут быть оборудованы восемью ускорителями NVIDIA H100 (SXM). В одной стойке могут размещаться до восьми серверов, что в сумме даст 64 ускорителя. При этом общая заявленная производительность такого кластера на операциях FP16 превышает 126 Пфлопс. Серверы оборудованы восемью фронтальными отсеками для SFF-накопителей NVMe. Питание обеспечивают четыре блока мощностью 5250 Вт с сертификатом Titanium. Слоты расширения выполнены по схеме 8 × PCIe 5.0 x16 LP и 2 × PCIe 5.0 x16 FHHL. На ISC 2024 компания Supermicro также демонстрирует сервер типоразмера 8U, оборудованный ускорителями Intel Gaudi3. Это одна из первых систем такого рода. Кроме того, представлена система AS-8125GS-TNMR2 формата 8U, рассчитанная на восемь ускорителей AMD Instinct MI300X. Этот сервер может комплектоваться двумя процессорами EPYC 9004 с TDP до 400 Вт, 24 модулями оперативной памяти DDR5-4800, фронтальными накопителями SFF (16 × NVMe и 2 × SATA), двумя модулями M.2 NVMe. Установлены шесть блоков питания на 3000 Вт с сертификатом Titanium. Наконец, Supermicro готовит серверы формата 4U с жидкостным охлаждением, которые могут оснащаться восемью ускорителями NVIDIA H100 и H200. Компания демонстрирует на конференции ISC 2024 и другие системы для приложений ИИ, а также задач НРС.

13.05.2024 [10:30], Сергей Карасёв

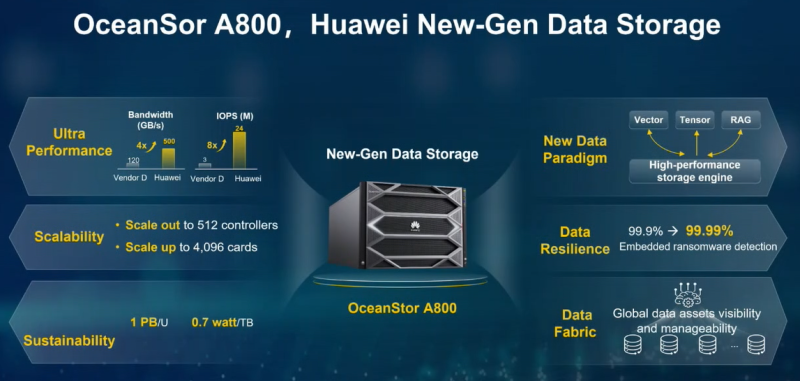

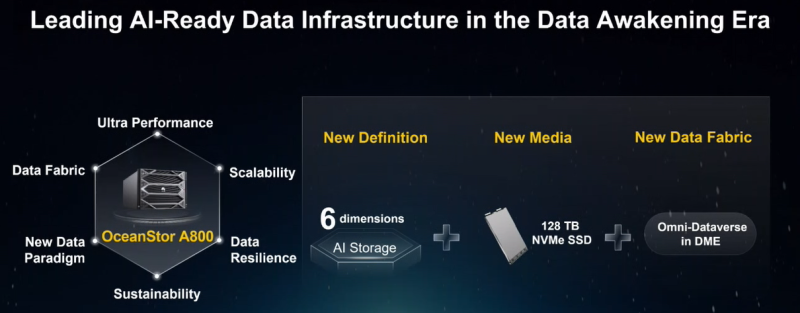

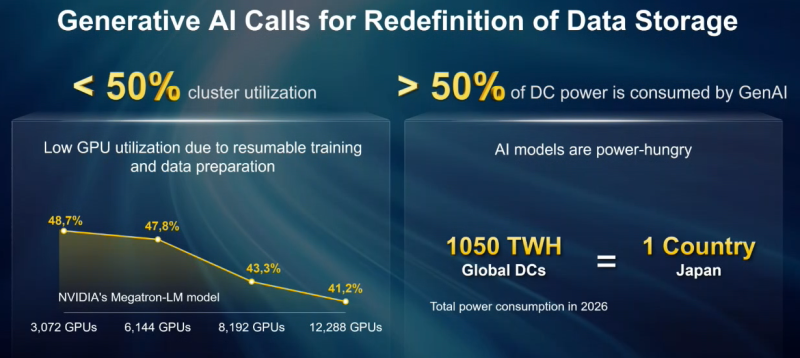

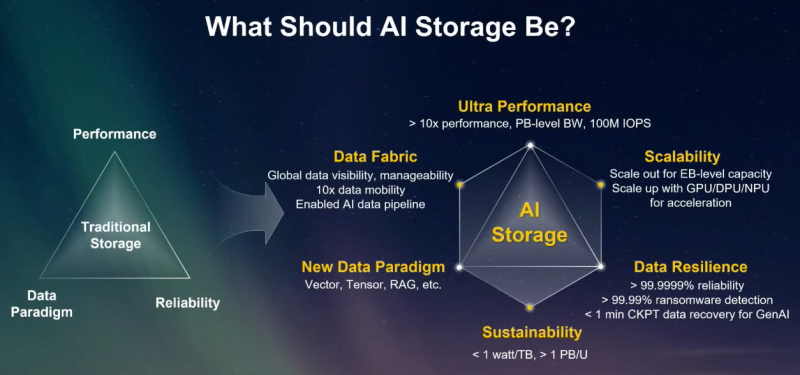

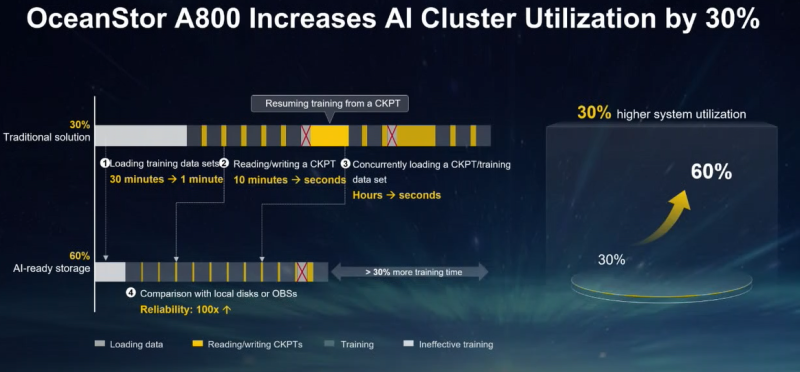

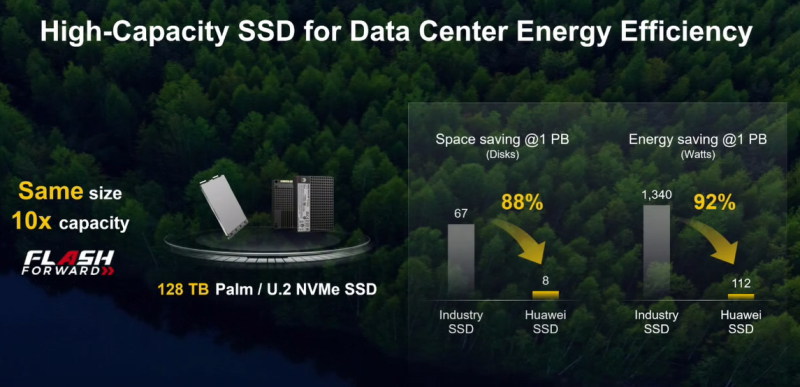

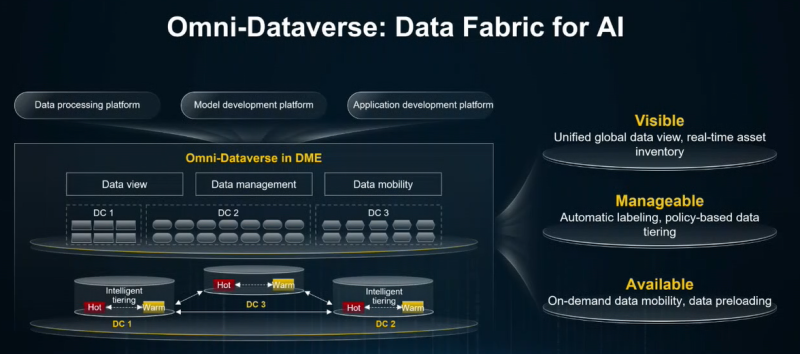

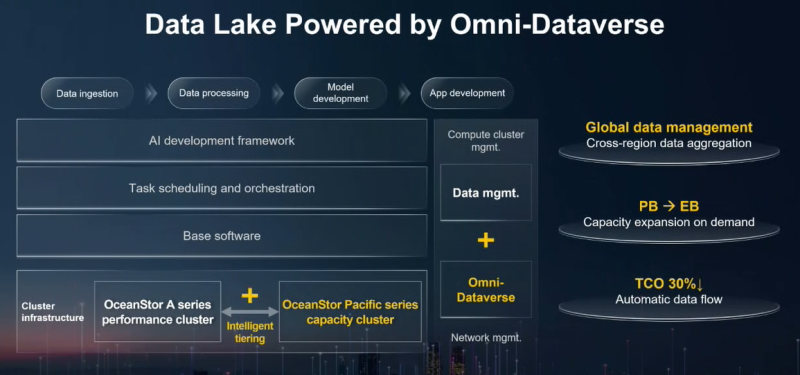

Экзабайты для ИИ: Huawei представила All-Flash СХД OceanStor A800Компания Huawei, по сообщению Datacenter Dynamics, представила СХД нового поколения OceanStor A800, специально разработанную для задач ИИ. Новинка позволяет формировать массивы экзабайтного уровня. Питер Чжоу (Peter Zhou), президент подразделения систем хранения Huawei, отмечает, что стремительное внедрение ИИ, в том числе генеративных сервисов, изменило требования к традиционным платформам СХД. Поэтому возникают проблемы с производительностью, надёжностью и масштабируемостью. В этой связи Huawei стремится переосмыслить подход к хранению информации, внедряя инновации по ряду направлений, включая новые парадигмы данных, повышение устойчивости и быстродействия. Платформа OceanStor A800 использует архитектуру SmartMatrix Pro для разделения уровней данных и управления: это позволяет передавать информацию через интерфейсные модули на/с SSD, обходя узкие места, связанные с CPU и памятью. В результате, как утверждается, производительность повышается практически на порядок по сравнению с традиционными хранилищами. В частности, A800 до восьми раз быстрее позволяет загружать наборы данных для обучения ИИ, а средняя утилизация GPU/NPU в кластере повышается почти на треть. Новая система выполнена в формате 8U. Конструкция включает два модуля обработки с поддержкой CPU и GPU, а также два модуля хранения на основе SSD. В качестве CPU применяется фирменное изделие Huawei Kunpeng с архитектурой Arm. Модули обработки могут дооснащаться дополнительными GPU, DPU и NPU. Основной шиной является PCIe 5.0. Показатель IOPS достигает 24 млн, а пропускная способность — 500 Гбайт/с. СХД поддерживает проприетарные накопители Palm SSD с высокоплотной упаковкой NAND-чипов и вместимостью 30 или 50 Тбайт, а в следующем году будет реализована возможность применения SSD на 128 Тбайт. Утверждается, что OceanStor A800 обеспечивает плотность хранения более 1 Пбайт на 1U, а энергоэффективность составляет 0,7 Вт/Тбайт. Платформа может масштабироваться до 512 контроллеров и 4096 вычислительных блоков, что обеспечивает вместимость в экзабайты и возможность обслуживания моделей с триллионами параметров. Применена параллельная файловая система OceanFS, причём Huawei предлагает унифицированное управление данными сразу в нескольких кластерах посредством Omni-Dataverse. Поддерживаются протоколы NFS, SMB, HDFS, S3, POSIX, MP-IO, а также интерфейсы для работы с векторными/тензорными данными. Предусмотрены встроенные средства обнаружения программ-вымогателей, эффективность которых, по заявлениям Huawei, достигает 99,99 %.

13.05.2024 [09:00], Сергей Карасёв

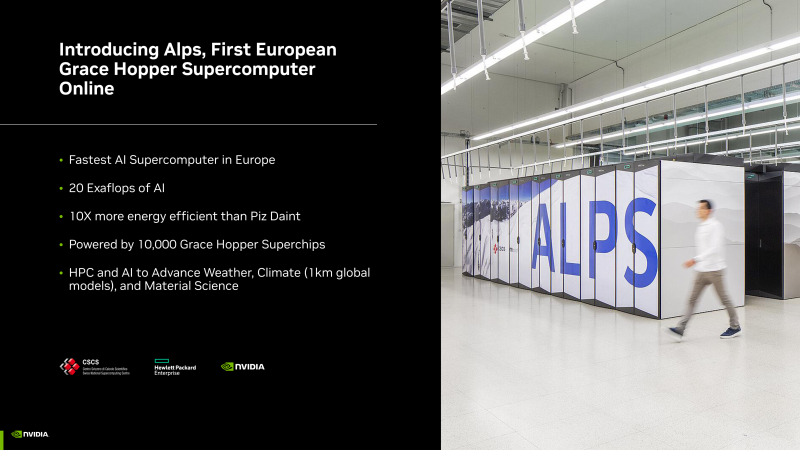

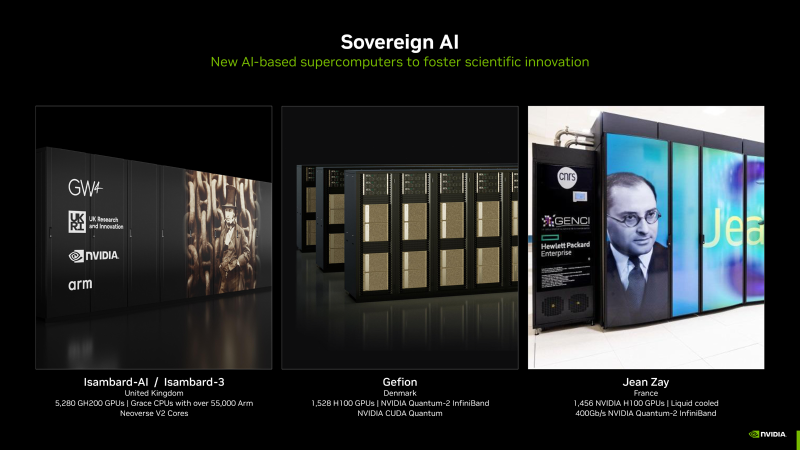

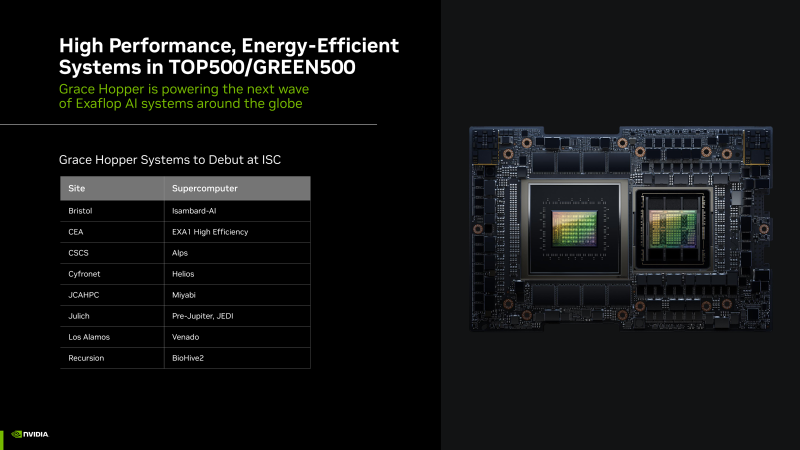

Более 200 Эфлопс для ИИ: NVIDIA представила новые НРС-системы на суперчипах Grace HopperКомпания NVIDIA рассказала о новых высокопроизводительных комплексах на основе суперчипов Grace Hopper для задач ИИ и НРС. Отмечается, что суммарная производительность этих систем превышает 200 Эфлопс. Суперкомпьютеры предназначены для решения самых разных задач — от исследований в области изменений климата до сложных научных проектов. Одним из таких НРС-комплексов является EXA1 — HE, который является совместным проектом Eviden (дочерняя структура Atos) и Комиссариата по атомной и альтернативным видам энергии Франции (СЕА). Система использует 477 вычислительных узлов на базе Grace Hopper, а пиковое быстродействие достигает 104 Пфлопс. Ещё одной системой стал суперкомпьютер Alps в Швейцарском национальном компьютерном центре (CSCS). Он использует в общей сложности 10 тыс. суперчипов Grace Hopper. Заявленная производительность на операциях ИИ достигает 10 Эфлопс, и это самый быстрый ИИ-суперкомпьбтер в Европе. Утверждается, что по энергоэффективности Alps в 10 раз превосходит систему предыдущего поколения Piz Daint. В свою очередь, комплекс Helios, созданный компанией НРЕ для Академического компьютерного центра Cyfronet Научно-технического университета AGH в Кракове (Польша), содержит 440 суперчипов NVIDIA GH200 Grace Hopper. Пиковое быстродействие на ИИ-операциях достигает 1,8 Эфлопс. В список систем на платформе Grace Hopper также входит Jupiter — первый европейский суперкомпьютер экзафлопсного класса. Комплекс расположится в Юлихском исследовательском центре (FZJ) в Германии. Кроме того, в список вошёл комплекс DeltaAI на основе GH200 Grace Hopper, созданием которого занимается Национальный центр суперкомпьютерных приложений (NCSA) при Университете Иллинойса в Урбане-Шампейне (США). В числе прочих систем названы суперкомпьютер Miyabi в Объединённом центре передовых высокопроизводительных вычислений в Японии (JCAHPC), Isambard-AI в Бристольском университете в Великобритании (5280 × GH200), а также суперкомпьютер в Техасском центре передовых вычислений при Техасском университете в Остине (США), комплекс Venado в Лос-Аламосской национальной лаборатории США (LANL) и суперкомпьютер Recursion BioHive-2 (504 × H100).

13.05.2024 [09:00], Сергей Карасёв

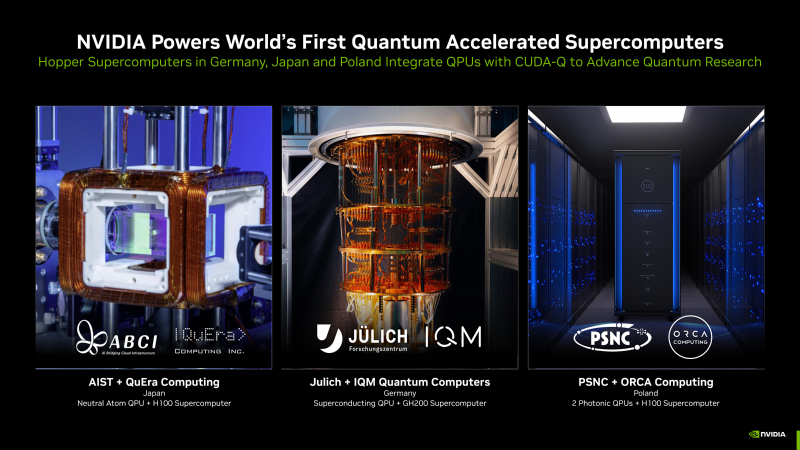

NVIDIA представила гибридные квантовые системы на платформе CUDA-QКомпания NVIDIA сообщила о том, что её платформа CUDA-Q будет использоваться в суперкомпьютерных центрах по всему миру. Она поможет ускорить исследования в области квантовых вычислений, что в перспективе позволит решать наиболее сложные научные задачи. Технология CUDA-Q предназначена для интеграции CPU, GPU и квантовых процессоров (QPU) и разработки приложений для них. Она даёт возможность выполнять сложные симуляции квантовых схем. О намерении использовать CUDA-Q в составе своих НРС-систем объявили организации в Германии, Японии и Польше. В частности, Юлихский суперкомпьютерный центр в Германии (JSC) намерен использовать квантовое решение производства IQM Quantum Computers в качестве дополнения к Jupiter — первому европейскому суперкомпьютеру экзафлопсного класса. Этот комплекс будет смонтирован в Юлихском исследовательском центре (FZJ). Суперкомпьютер Jupiter получит приблизительно 24 тыс. гибридных суперчипов NVIDIA GH200 Grace Hopper. Ещё одной гибридной системой, объединяющей классические и квантовые технологии, станет комплексе ABCI-Q, который расположится в суперкомпьютерном центре ABCI (AI Bridging Cloud Infrastructure) Национального института передовых промышленных наук и технологий Японии (AIST). В состав суперкомпьютера войдут QPU разработки QuEra, а также более 2000 ускорителей NVIDIA H100. Ввод ABCI-Q в эксплуатацию состоится в начале 2025 года. Применять систему планируется при проведении исследований в области ИИ, энергетики, биологии и пр. Вместе с тем Познаньский центр суперкомпьютерных и сетевых технологий (PSNC) в Польше приобрёл две квантовые вычислительные системы британской компании ORCA Computing. Они интегрированы в существующую HPC-инфраструктуру PSNC, которая в числе прочего использует изделия NVIDIA Hopper. Узлы на базе QPU помогут в решении задач в области химии, биологии и машинного обучения.

12.05.2024 [21:57], Сергей Карасёв

ИИ федерального значения: правительственные учреждения США получат 17-Пфлопс суперкомпьютер на базе NVIDIA DGX SuperPOD H100Компания NVIDIA сообщила о том, что её система DGX SuperPOD ляжет в основу нового вычислительного комплекса для задач ИИ, который будет использоваться различными правительственными учреждениями США для проведения исследований в области климатологии, здравоохранения и кибербезопасности. Внедрением суперкомпьютера занимается MITRE — американская некоммерческая организация, специализирующаяся в области системной инженерии. Она ведёт разработки и исследования в интересах госорганов США, включая Министерство обороны (DoD), Федеральное управление гражданской авиации (FAA) и пр. Система DGX SuperPOD станет основой вычислительной платформы MITRE Federal AI Sandbox, доступ к ресурсам которой будет предоставляться различным организациям на федеральном уровне. Государственные учреждения смогут сообща использовать суперкомпьютер для обучения больших языковых моделей (LLM), развёртывания генеративных приложений и других современных ИИ-решений. В состав MITRE Federal AI Sandbox войдут 32 системы NVIDIA DGX H100, а общее количество ускорителей NVIDIA H100 составит 256 штук. Производительность на операциях ИИ будет достигать примерно 1 Эфлопс. Быстродействие FP64 — приблизительно 17 Пфлопс. Ввод суперкомпьютера в эксплуатацию состоится позднее в текущем году. «Развёртывание MITRE DGX SuperPOD поможет ускорить реализацию инициатив федерального правительства США в области ИИ. Технологии ИИ обладают огромным потенциалом для улучшения государственных услуг в гражданской области и решения серьёзных проблем, в том числе в сфере кибербезопасности», — сказал Энтони Роббинс (Anthony Robbins), вице-президент NVIDIA.

12.05.2024 [21:43], Владимир Мироненко

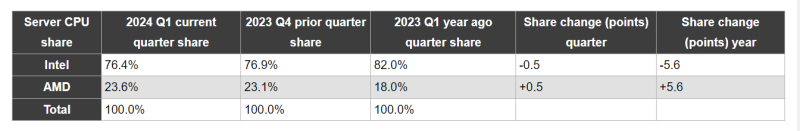

Доля AMD на рынке серверных процессоров выросла в I квартале 2024 года до 23,6 %Согласно данным компании Mercury Research, которая отслеживает рынки полупроводников и компонентов для ПК, Intel продолжает доминировать на рынке чипов для ПК, но AMD завоёвывает позиции на рынках чипов для серверов, десктопов и мобильных устройств, пишет AnandTech. В I квартале 2024 года AMD достигла рекордно высокой доли на рынках процессоров с архитектурой x86 для десктопов и серверных процессоров x86 благодаря успеху продуктов серии Ryzen 8000 и процессоров EPYC Genoa. Хотя доля AMD на рынке настольных компьютеров и ноутбуков в последние годы колебалась, компания неуклонно расширяет присутствие на рынке серверов как по объёмам поставок, так и по росту доходов. В I квартале 2024 года доля AMD на рынке процессоров для серверов увеличилась до 23,6 %, что означает прирост на 0,5 % последовательно и на 5 % год к году, обусловленный ростом числа платформ на базе процессоров AMD EPYC Genoa. Intel продолжает доминировать на рынке серверов с долей 76,4 %, но прогресс AMD вполне очевиден. Доля выручки AMD на рынке серверов на платформе x86 достигла 33 %, что на 5,2 % больше год к году и на 1,2 % больше, чем в предыдущем квартале. Это означает, что компания набирает обороты в производстве hi-end устройств с современными процессорами. Учитывая, что на данный момент у Intel нет прямых конкурентов 96-ядерным и 128-ядерным (Bergamo) процессорам AMD, неудивительно, что AMD удалось добиться увеличения доли на рынке чипов для серверов. «Как мы отметили во время нашего финансового отчёта за I квартал, продажи серверных процессоров выросли по сравнению с прошлым годом благодаря росту внедрения на предприятиях и расширению облачных развертываний», — указала AMD в своём заявлении.

11.05.2024 [14:00], Сергей Карасёв

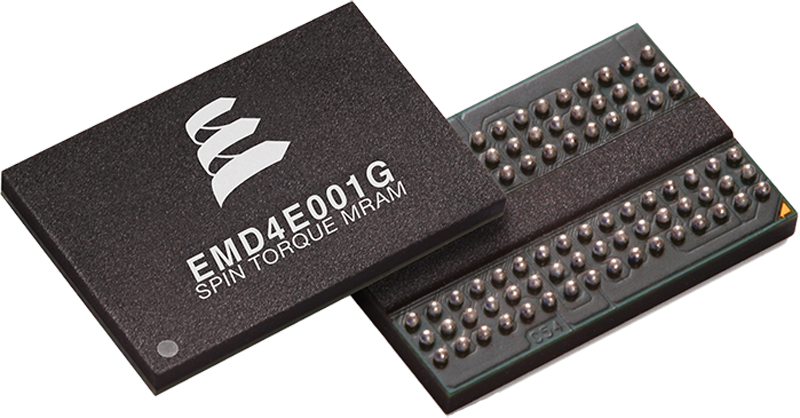

IBM оснастит накопители FCM четвёртого поколения памятью Everspin STT-MRAMКомпания Everspin Technologies сообщила о том, что её чипы магниторезистивной памяти с произвольным доступом (MRAM) войдут в состав вычислительных накопителей IBM FlashCore Modules (FCM) четвёртого поколения. Это обеспечит дополнительный уровень защиты данных при отключении питания. Речь идёт о применении изделий Everspin Persyst EMD4E001G ёмкостью 1 Гбит. Эти высокопроизводительные энергонезависимые чипы выполнены по технологии STT-MRAM (запись данных с помощью переноса спинового момента).

Источник изображения: Everspin Изделия Everspin используют интерфейс DDR4. Заявленная скорость передачи информации в режимах чтения и записи достигает 2,7 Гбайт/с. В случае внезапного сбоя питания критически важные данные могут быть быстро перенесены в память STT-MRAM, что обеспечит их сохранность. Что касается FCM4, то это проприетарные накопители IBM, выполненные на 176-слойных чипах TLC NAND. Вместимость составляет 4,8, 9,6, 19,2 или 38,4 Тбайт. Реализована технология защиты от вредоносного ПО, работающая на уровне прошивки. Накопители анализируют I/O-операции с помощью ИИ-алгоритмов, оперативно выявляя проникновение программ-вымогателей и других зловредов. Согласно прогнозам Technavio, показатель CAGR (среднегодовой темп роста в сложных процентах) на мировом рынке MRAM составит 37,39 % до 2026 года. Таким образом, прирост продаж в денежном выражении с 2021-го по 2026 год достигнет $1,43 млрд.

11.05.2024 [13:52], Сергей Карасёв

CoreWeave вложит £1 млрд в ИИ ЦОД в ВеликобританииКомпания CoreWeave, специализирующаяся на предоставлении облачных услуг для решения ИИ-задач, по сообщению Datacenter Dynamics, намерена активно развивать бизнес в Великобритании. В ближайшее время в соответствующие проекты планируется инвестировать £1 млрд (приблизительно $1,25 млрд). Отмечается, что CoreWeave уже открыла представительство в Лондоне, которое станет европейской штаб-квартирой компании. В 2024 году CoreWeave намерена запустить в Великобритании два дата-центра с последующим развитием инфраструктуры в 2025-м. Подробности об этих ЦОД пока не раскрываются. Майк Интратор (Mike Intrator), соучредитель и генеральный директор CoreWeave, заявил, что укрепление присутствия в Великобритании является важной вехой на пути дальнейшего развития компании. CoreWeave рассчитывает разворачивать облачные сервисы на местном рынке, предоставляя клиентам вычислительные ресурсы для внедрения приложений ИИ.

Источник изображения: CoreWeave Стартап CoreWeave, основанный в 2017 году, изначально занимался майнингом криптовалют. Затем компания переориентировалась на вычисления общего назначения и хостинг проектов генеративного ИИ. Недавно CoreWeave привлекла финансирование в размере $1,1 млрд, получив оценку в $19 млрд. CoreWeave заявляет, что её сервисы с ускорителями NVIDIA позволяют клиентам выполнять задачи более эффективно и с повышенной производительностью, нежели традиционные публичные облака. На сегодняшний день CoreWave предоставляет услуги из трёх ЦОД-регионов. Это площадки US East в Уихокене (Нью-Джерси), US West в Лас-Вегасе (Невада) и US Central в Чикаго (Иллинойс). К концу 2024 года компания рассчитывает управлять в общей сложности 28 дата-центрами. В частности, CoreWeave намерена потратить не менее $1,6 млрд на ЦОД в городе Плано (Техас).

11.05.2024 [13:46], Сергей Карасёв

Южнокорейский разработчик ИИ-чипов Deepx привлек более $80 млнЮжнокорейский стартап Deepx, занимающийся разработкой специализированных чипов для задач ИИ, сообщил о проведении раунда финансирования Series C, в ходе которого на развитие получено $80,5 млн. В инвестиционной программе принимают участие SkyLake Equity Partners, BNW Investments, AJU IB и TimeFolio Asset Management. Deepx была основана в 2018 году бывшим инженером Apple и Cisco Локвоном Кимом (Lokwon Kim). В настоящее время в Deepx работает около 65 человек. Компания подала примерно 260 патентных заявок в США, Китае и Южной Корее на различные разработки, связанные с ИИ. Полученные средства Deepx намерена направить на ускорение разработки и коммерциализации своих продуктов. Отмечается, что стартап ведёт переговоры более чем со 100 потенциальными клиентами и стратегическими партнёрами.

Источник изображения: Deepx Deepx проектирует ИИ-процессоры для разных сфер применения. Это, в частности, изделия DX-V1 и DX-V3 для бытовой электроники, DX-M1 для промышленных роботов и периферийных вычислений, а также DX-H1 для серверов. Производительность этих чипов на ИИ-операциях варьируется от 5 до 400 TOPS. Архитектура решений Deepx предусматривает сокращение интенсивности обмена данными с памятью DRAM, что позволяет повысить общую эффективность вычислений. Помимо аппаратных компонентов, Deepx предоставляет программную платформу DXNN, которая позволяет автоматически компилировать модели ИИ в формат, поддерживаемый чипами компании. Причём компилятор производит оптимизацию (квантование) моделей для улучшения производительности. |

|