Материалы по тегу: сервер

|

26.06.2025 [12:05], Сергей Карасёв

HPE представила ИИ-систему Compute XD690 на базе NVIDIA HGX B300Компания HPE анонсировала высокопроизводительный сервер Compute XD690, предназначенный для решения таких ресурсоёмких задач, как обучение ИИ-моделей, инференс и пр. В основу новинки положены процессоры Intel и ускорители NVIDIA на архитектуре Blackwell. Поставки новинки компания планирует организовать в октябре нынешнего года. Система Compute XD690 выполнена в форм-факторе 10U с воздушным охлаждением. Полностью технические характеристики не раскрываются, но известно, что конфигурация включает два чипа Intel Xeon 6. Задействована платформа NVIDIA HGX B300 с восемью модулями Blackwell Ultra SXM. Заявленная производительность на операциях FP64 достигает 10 Тфлопс, на операциях FP4 — 144 Пфлопс. Суммарный объём памяти HBM3e составляет около 2,3 Тбайт. Применяется интерконнект NVLink пятого поколения с общей пропускной способностью 14,4 Тбайт/с. Говорится о поддержке XDR InfiniBand и Spectrum-X Ethernet.

Источник изображения: HPE Как отмечает HPE, ускорители Blackwell Ultra обеспечивают на 50 % более высокую производительность FP4 и удвоенную пропускную способность GPU↔CPU по сравнению с решениями на архитектуре Blackwell предыдущего поколения. Благодаря этому возможна работа со сложными ИИ-моделями, агентами ИИ, рассуждающими системами и пр. Среди других вариантов использования названы генерация фотореалистичных видеоматериалов и симуляция детализированного 3D-окружения для робототехнических сред и самоуправляемых транспортных средств.

24.06.2025 [11:42], Сергей Карасёв

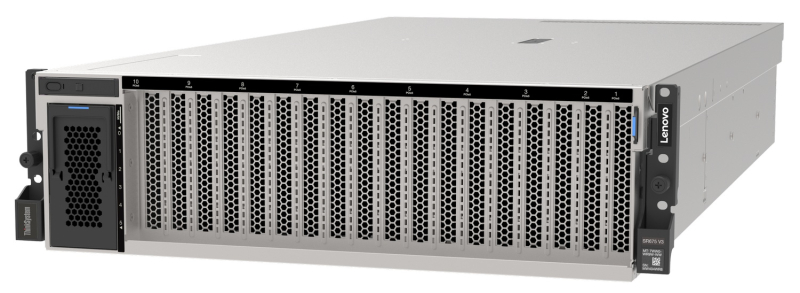

Lenovo анонсировала новые системы для дата-центров, оптимизированные для ИИКомпания Lenovo анонсировала новые гибридные платформы, оптимизированные для решения ресурсоёмких ИИ-задач в дата-центрах. Представлены системы различного уровня, созданные в партнёрстве с NVIDIA, Cisco и IBM. В частности, дебютировала модель ThinkSystem SR680a V4 на аппаратной платформе Intel. Полностью характеристики платформы не раскрываются. Известно, что применены процессоры семейства Xeon 6, в которое входят изделия на основе энергоэффективных E-ядер (Sierra Forest) и производительных P-ядер (Granite Rapids). Система несёт на борту восемь ускорителей NVIDIA Blackwell B200, а также восемь карт NVIDIA SuperNIC и NVIDIA BlueField-3 DPU. Утверждается, что по сравнению с серверами предыдущего поколения модель ThinkSystem SR680a V4 обеспечивает семикратный рост вычислительной производительности, тогда как объём памяти увеличился в четыре раза. Скорость инференса при работе с большими языковыми моделями (LLM) поднялась приблизительно в 11 раз. Кроме того, Lenovo представила ИИ-систему Hybrid AI на платформе IBM watsonx. В основу этого решения положены серверы Lenovo ThinkSystem SR675 (V3), оснащённые системой жидкостного охлаждения Neptune. Ещё одна система Lenovo Hybrid AI создана в партнёрстве с Cisco: она объединяет коммутаторы Cisco Nexus с технологией NVIDIA Spectrum-X для ускорения развёртывания ИИ-фабрик на предприятиях. Задействован сервер ThinkSystem SR675 V3, который может содержать до восьми ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. Говорится о поддержке карт NVIDIA SuperNIC и NVIDIA BlueField-3 DPU. Платформа призвана ускорить переход организаций от ИИ-вычислений на базе CPU к средам на основе GPU.

23.06.2025 [12:51], Руслан Авдеев

Бум ИИ-технологий заставляет Wistron оперативно масштабировать производство серверовСпрос на ИИ-технологии в мире по-прежнему остаётся устойчивым, а перспективы отрасли — весьма благоприятными. Президент и генеральный директор Wistron Джефф Лин (Jeff Lin) объявил, что большинство клиентов размещают долгосрочные 12-месячные заказы на оборудование компании и востребованность её продуктов останется высокой до мая 2026 года, сообщает DigiTimes. По словам директора, недавно введённый в эксплуатацию AI Smart Campus Wistron в Чжубэе (Zhubei), вероятно, уже столкнётся с дефицитом мощностей в 2026 году. Открытие кампуса, одновременно являющегося новой штаб-квартирой компании для глобальных операций, состоялось 19 июня. На мероприятии присутствовал ряд руководителей Wistron, а также представители поставщиков разных уровней. Глава NVIDIA Дженсен Хуанг (Jensen Huang), чья компания является ключевым клиентом Wistron, прислал специальное видеопоздравление. В интервью после мероприятия Джефф Лин сообщил, что новый объект будет использоваться для выпуска ИИ-серверов. Пока осуществляется монтаж оборудования, а производство начнётся после его установки. Исходя из текущих заказов ожидается, что завод выйдет на полную мощность к 2026 году. В феврале Wistron объявила, что для удовлетворения растущего спроса компания подписала договор с компанией Lien Fa Textile на аренду объекта площадью 56 тыс. м2. Он послужит дополнительной площадкой для выпуска ИИ-серверов. Аренда на 10 лет обойдётся не дороже NT$2,503 млрд ($84 млн).

Источник изображения: Wistron Хотя конкретики о параметрах масштабирования кампуса в Чжубэе немного, известно, что с использованием нового арендованного объекта Wistron рассчитывает существенно расширить производство на Тайване. В конце прошлого года уже сообщалось о намерении Wistron расширить мировое присутствие и укрепить производство ИИ-серверов. Линь признал, что загрузка производственных мощностей произошла неожиданно быстро, заставив компанию активно расширяться. Теперь у неё три производственных площадки в Синьчжу (Hsinchu), увеличиваются штаты исследователей и разработчиков, а также специалистов по продажам. Кроме того, новый головной офис в Тайбэе (Taipei) достроят к 2027 году, но действующий офис в Сичжи (Xizhi) пока сохранят из-за нехватки свободных площадей. Что касается производства ИИ-серверов за пределами Тайваня, небольшие партии выпускаются лишь в Техасе. Завод выпускает те же модели серверов, что и кампус в Чжубэе, предполагается расширить производство в 2026 году. Компания уже сообщала выделить на расширение производства в США $50 млн. На вопрос журналистов о возможности переноса выпуска вычислительной техники в США, Лин сообщил, что некоторые клиенты запросили подготовку технико-экономического обоснования. Впрочем, такие обсуждения пока находятся на ранней стадии и никакие решения ещё не приняты. При этом планирование цепочки поставок заметно усложнилось, поскольку приходится учитывать неопределённость тарифной политики США.

07.06.2025 [16:35], Сергей Карасёв

HPE представила отказоустойчивые системы Nonstop Compute на базе Intel Xeon Sapphire RapidsКомпания HPE пополнила семейство отказоустойчивых решений Nonstop Compute двумя новинками — системой начального уровня NS5 X5 и флагманской моделью NS9 X5. Архитектура платформ объединяет вычислительные мощности, ресурсы хранения, сетевые функции и сопутствующее ПО. Решение Nonstop Compute NS5 X5 ориентировано на сравнительно небольших корпоративных заказчиков. Система формата 36U/42U может нести на борту до четырёх процессоров Intel Xeon Bronze 3400 поколения Sapphire Rapids. Объём оперативной памяти достигает 128 Гбайт в расчёте на CPU, что в сумме даёт до 512 Гбайт. Возможна установка до 100 SAS SSD вместимостью 1,6 Тбайт каждый. Допускается также подключение внешних массивов хранения HPE XP8. В общей сложности могут использоваться до 20 сетевых портов, в том числе 10GbE.

Источник изображения: HPE В свою очередь, модель Nonstop Compute NS9 X5 ориентирована на ресурсоёмкие нагрузки, такие как обработка транзакций в реальном времени в больших масштабах и интенсивная работа с данными. Максимальная конфигурация включает 16 процессоров Xeon Gold 6400 семейства Sapphire Rapids с 512 Гбайт памяти в расчёте на CPU, что в сумме обеспечивает до 8 Тбайт ОЗУ. Система может быть оборудована 2700 SAS SSD ёмкостью до 1,6 Тбайт каждый. Предусмотрена возможность использования до 270 сетевых портов на систему, в том числе 25GbE. В целом, решения Nonstop Compute ориентированы на сегмент рынка, где требуется менее высокая стоимость по сравнению с традиционными мейнфреймами, но при этом предъявляются более высокие требования в плане надёжности и масштабируемости, чем к стандартным серверам. IDC относит продукты Nonstop Compute к системам с доступностью класса Availability Level 4 (AL4): это означает, что показатель безотказной работы составляет от 99,999 % до 99,9999 %. Таким образом, системы подходят для применения в том числе в финансовом секторе. HPE утверждает, что шесть из десяти крупнейших мировых банков используют устройства Nonstop Compute.

26.05.2025 [11:21], Сергей Карасёв

Supermicro представила сервер SYS-822GS-NB3RT на базе NVIDIA HGX B300Компания Supermicro представила модель SYS-822GS-NB3RT на аппаратной платформе NVIDIA HGX B300 (Blackwell Ultra) для ресурсоёмких ИИ-нагрузок. Устройство выполнено в форм-факторе 8U и . Допускается установка двух процессоров Intel Xeon 6500P или 6700P поколения Granite Rapids с высокопроизводительными Р-ядрами. Доступны 32 слота для модулей оперативной памяти DDR5 с поддержкой MRDIMM-8000. Система имеет архитектуру 8-GPU. Во фронтальной части располагаются отсеки для восьми накопителей E1.S (NVMe) с возможностью горячей замены. Кроме того, есть два внутренних слота М.2 для NVMe SSD. Сервер оснащён двумя разъёмами PCIe 5.0 х16 FHHL для DPU NVIDIA BlueField-3. Упомянуты сетевые адаптеры NVIDIA ConnectX-8 SuperNIC. Supermicro позиционирует модель SYS-822GS-NB3RT в качестве передового «строительного блока» для формирования масштабных ИИ-кластеров с воздушным охлаждением. Компания Supermicro также сообщила о том, что в её ассортименте для заказа доступны более 20 систем, поддерживающих установку ускорителей NVIDIA RTX PRO 6000 Blackwell Server Edition с 96 Гбайт памяти GDDR7. Это, в частности, многоузловые серверы SuperBlade, компактные edge-решения, серверы типоразмера 5U с поддержкой до восьми GPU-карт, системы на модульной архитектуре NVIDIA MGX для ИИ-приложений и задач НРС, а также мощные рабочие станции.

24.05.2025 [22:18], Сергей Карасёв

Supermicro представила сервер-микрооблако на базе AMD EPYC GradoКомпания Supermicro представила сервер MicroCloud A+ Server AS-3015MR-H5TNR типоразмера 3U. Эта пятиузловая система (3U5N) ориентирована на организацию облачных вычислений и CDN, поддержание работы потоковых видеосервисов, веб-приложений и пр. Каждый узел рассчитан на установку одного процессора AMD EPYC 4005 Grado в исполнении Socket AM5 (LGA1718) с показателем TDP до 175 Вт (воздушное охлаждение). Кроме того, могут применяться чипы EPYC 4004 и Ryzen 7000/9000, насчитывающие до 16 вычислительных ядер с поддержкой многопоточности. Доступны четыре слота для модулей DDR5-5600 суммарным объёмом до 192 Гбайт. Каждый узел располагает одним слотом PCIe 5.0 x16 FHFL и одним разъёмом PCIe 5.0 x4 Micro-LP или двумя слотами PCIe 5.0 x8 LP. Возможна установка ускорителя NVIDIA L40(S), L4, A16, A2 и A10 или AMD Instinct MI210. Предусмотрены по два посадочных места для накопителей SFF NVMe (PCIe 5.0) и SFF SATA-3. Кроме того, имеется коннектор M.2 M-key для SSD типоразмера 2280/22110 (NVMe). Доступны два порта USB 2.0. Вся система AS-3015MR-H5TNR в целом оборудована четырьмя блоками питания с резервированием мощностью 2000 Вт с сертификатом 80+ Titanium. Задействованы пять вентиляторов охлаждения диаметром 80 мм. Габариты составляют 449 × 775 × 131 мм, масса — 48,76 кг. Диапазон рабочих температур простирается от +10 до +35 °C. Упомянут встроенный модуль TPM 2.0 для обеспечения безопасности.

22.05.2025 [12:43], Сергей Карасёв

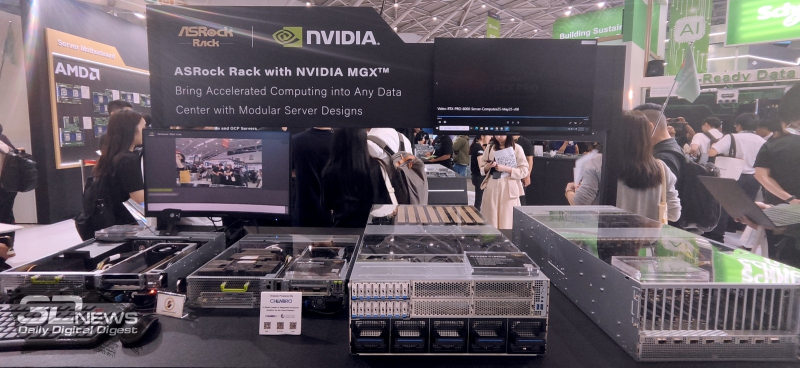

ASRock Rack показала серверы NVIDIA HGX B300 и систему XGMRACK GB300 NVL72Компания ASRock Rack в рамках выставки Computex 2025 представила серверы нового поколения, оснащённые ИИ-ускорителями NVIDIA на архитектуре Blackwell. Кроме того, демонстрируются другие индустриальные и корпоративные продукты, включая материнские платы и системы с процессорами AMD и Intel. В число новинок вошёл сервер ASRock Rack 8U16X-GNR2 типоразмера 8U с воздушным охлаждением. Он выполнен на платформе NVIDIA HGX B300. По заявления разработчика, достигается в семь раз более высокая ИИ-производительность по сравнению с сопоставимыми системами, оборудованными ускорителями NVIDIA на архитектуре Hopper. Суммарный объём памяти HBM3e составляет около 2,3 Тбайт. Задействованы сетевые адаптеры NVIDIA ConnectX-8 SuperNIC. Кроме того, ASRock Rack готовит к выпуску сервер 4U16X-GNR2 на базе NVIDIA HGX B300 с жидкостным охлаждением. Обе модели ориентированы на ресурсоёмкие рабочие ИИ-нагрузки, такие как агентные системы, рассуждающие модели и генеративные сервисы. На стенде ASRock Rack представлено стоечная система XGMRACK на основе NVIDIA GB300 NVL72. Она объединяет 36 чипов NVIDIA Grace и 72 ускорителя NVIDIA Blackwell Ultra. Вычислительные и коммутационные узлы используют на 100 % жидкостное охлаждение. Общий объём памяти HBM3e превышает 20 Тбайт. Применяются решения NVIDIA Quantum-X800 InfiniBand и Spectrum-X Ethernet. ASRock Rack также представила серверы на модульной архитектуре NVIDIA MGX для масштабируемых ИИ-приложений и периферийных вычислений. В число таких машин входит модель 4UXGM-GNR2 типоразмера 4U с поддержкой двух процессоров Intel Xeon 6700P, 6500P (Granite Rapids) или Xeon 6700E (Sierra Forest). Доступны 32 слота для модулей оперативной памяти DDR5-6400, 16 посадочных мест для накопителей E1.S с интерфейсом PCIe 5.0 x4, два коннектора М.2 22110/2280 для SSD (PCIe 5.0 x4 и PCIe5.0 x2), восемь слотов PCIe 5.0 x16 FHFL, пять слотов PCIe 5.0 x16 FHHL и один слот PCIe 5.0 x16 HHHL. Установлены контроллер ASPEED AST2600 и четыре блока питания мощностью 1200 Вт с сертификатом 80 PLUS Titanium.

02.05.2025 [13:55], Сергей Карасёв

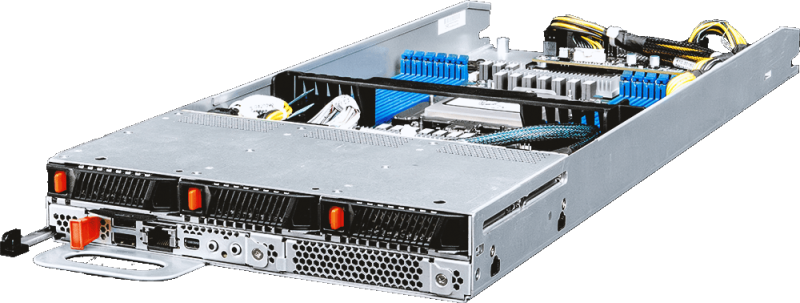

MSI представила многоузловые OCP-серверы на базе AMD EPYC 9005 TurinКомпания MSI анонсировала многоузловые серверы высокой плотности, выполненные в соответствии со стандартом OCP ORv3 (Open Rack v3). Дебютировали модели Open Compute CD281-S4051-X2 и Core Compute CD270-S4051-X4 на аппаратной платформе AMD EPYC 9005 Turin. Решение Open Compute CD281-S4051-X2, выполненное в форм-факторе 2OU, представляет собой двухузловой сервер для инфраструктур гиперскейлеров. Каждый узел может оснащаться одним процессором EPYC 9005 с показателем TDP до 500 Вт и 12 модулями DDR5. Доступны до 12 посадочных мест для накопителей E3.S с интерфейсом PCIe 5.0 (NVMe). Говорится о поддержке CPU-радиаторов Extended Volume Air Cooling (EVAC) и 48-вольтной архитектуры питания ORv3 (48VDC). В свою очередь, Core Compute CD270-S4051-X4 (S4051D270RAU3-X4) — это четырёхузловой сервер стандарта Data Center Modular Hardware Systems (DC-MHS). Устройство имеет типоразмер 2U. Оно подходит для облачных вычислений, CDN-сетей, ИИ-инференса и машинного обучения, виртуализации сетевых функций, телеком-приложений и пр. Каждый узел новинки рассчитан на один чип EPYC 9005 с TDP до 400 Вт. Есть 12 слотов для модулей DDR5-6000 RDIMM/RIMM-3DS суммарным объёмом до 3 Тбайт, три фронтальных отсека для накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe), два внутренних коннектора M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x2 (NVMe), а также слот PCIe 5.0 x16 OCP 3.0. Кроме того, каждый узел располагает контроллером ASPEED AST2600, сетевым портом управления 1GbE, разъёмами USB 2.0 Type-A и Mini DisplayPort, последовательным портом (USB Type-A). Вся система Core Compute CD270-S4051-X4 оборудована двумя блоками питания мощностью 2700 Вт с сертификатом 80 PLUS Titanium. Установлены четыре вентилятора охлаждения с возможностью горячей замены. Диапазон рабочих температур — от 0 до +35 °C. Габариты составляют 448 × 87 × 747 мм.

02.05.2025 [13:50], Сергей Карасёв

MiTAC анонсировала OCP-серверы на основе AMD EPYC Turin с воздушным и жидкостным охлаждением, а также edge-сервер на базе Intel Xeon Sapphire RapidsКомпания MiTAC Computing Technology представила OCP-серверы нового поколения C2810Z5 и C2820Z5, предназначенные для приложений ИИ и НРС. Устройства выполнены на аппаратной платформе AMD EPYC 9005 Turin. Решение C2810Z5 типоразмера 2OU имеет двухузловую конструкцию. Каждый узел допускает установку одного процессора и 12 модулей оперативной памяти DDR5-6400. Доступны шесть отсеков для накопителей U.2 и два посадочных места для SSD стандарта E1.S. Предусмотрены слоты PCIe 5.0 x16 для карт FHHL, HHHL и OCP NIC 3.0. Устройство оснащено воздушным охлаждением. Данная модель подходит для развёртывания микросервисов в облачных средах. В свою очередь, вариант C2820Z5 — это четырёхузловая система 2OU с технологией прямого жидкостного охлаждения. Каждый узел поддерживает два процессора EPYC 9005 Turin и 24 модуля памяти DDR5. Сервер подходит для высокопроизводительных вычислений. Кроме того, MiTAC анонсировала семейство серверов Whitestone 2 (WS2): это, как утверждается, компактная, но мощная платформа, специально оптимизированная для сетей Open RAN и периферийных задач. Система выполнена в корпусе небольшой глубины формата 1U. Задействован процессор Intel Xeon поколения Sapphire Rapids. Предусмотрены восемь слотов для модулей DDR5. Во фронтальной части находятся четыре порта 25GbE SFP28 и восемь портов 10GbE SFP+. Говорится о поддержке IEEE 1588 v2, Sync-E и GPS для синхронизации. В тыльной части располагаются вентиляторы охлаждения в виде девяти сдвоенных блоков.

29.04.2025 [22:41], Владимир Мироненко

Inventec вложит до $85 млн в производство серверов в ТехасеТайваньский производитель электроники Inventec объявил об утверждении советом директоров инвестиций на сумму до $85 млн в создание производственного предприятия в Техасе, что ознаменовало собой последний шаг крупного ODM-производителя по расширению операций в США, сообщил ресурс DigiTimes. Аналогичные решения по увеличению инвестирования производства в США приняли другие тайваньские технологические гиганты, включая Foxconn, Wistron и Wiwynn. Inventec заявила, что реализацией инвестиционного проекта займётся её дочерняя компания в США. Финансирование проекта будет осуществляться за счёт собственного оборотного капитала и банковских кредитов. Как сообщает компания, этот шаг направлен на укрепление отношений с клиентами и снижение рисков, связанных с торговой и тарифной политикой США. На первом этапе компания определится с участком, где будут располагаться производственные мощности. Inventec ранее заявила, что Техас является наиболее подходящим местом для строительства завода по сборке серверов в США, объяснив свой выбор близостью к собственному заводу в Мексике, а также стабильным и достаточным электроснабжением и общей пригодностью для сборки ИИ-серверов, требующей высокой мощности для тестирования. Как сообщают источники, Inventec с начала этого года изучает потенциальные площадки для размещения в Техасе. На данный момент из крупных тайваньских ODM-производителей серверов лишь Compal пока не объявил о планах по запуску производства серверного оборудования в США. У Quanta есть заводы в Калифорнии и Теннесси, у Foxconn — в Висконсине и Техасе, у Wistron и WiWynn — в Калифорнии и Техасе, у MiTAC и Pegatron — в Калифорнии. Ранее Inventec продала AMD свою долю в американском производителе серверов ZT Systems. Источники в отрасли полагают, что Compal рассматривает возможность участия в торгах по покупке производственных активов ZT Systems в США, что может обеспечить ей доступ к производственным мощностям и квалифицированным кадрам ZT, а также потенциально позволит углубить связи с AMD. Compal в настоящее время управляет заводом по производству автомобильного оборудования в Индиане. |

|