Материалы по тегу: облако

|

07.08.2025 [10:16], Сергей Карасёв

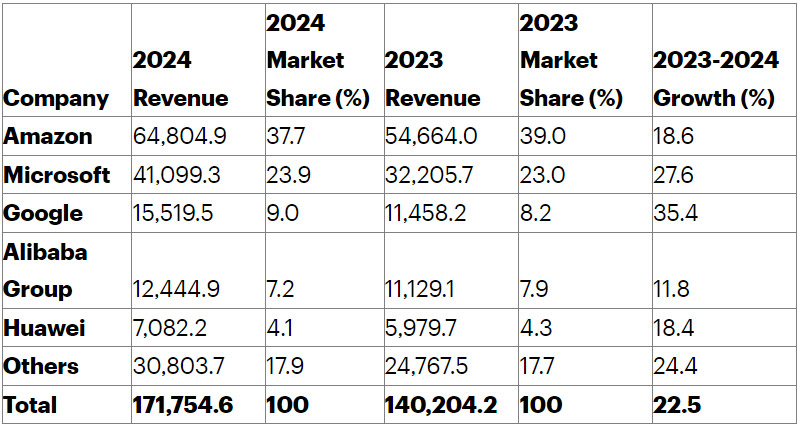

Объём мирового рынка IaaS в 2024 году превысил $170 млрдКомпания Gartner обнародовала результаты исследования мирового рынка IaaS в 2024 году. Расходы достигли $171,8 млрд, что на 22,5 % больше по сравнению с предыдущим годом, когда объём отрасли оценивался в $140,2 млрд. Самые высокие темпы роста демонстрирует Google. Аналитики отмечают, что предприятия по всему миру стремятся оптимизировать свои операции, повысить гибкость и производительность. На этом фоне продолжается активное перемещение рабочих нагрузок в облако. Дополнительным стимулирующим фактором является ИИ: многие компании трансформируют ИТ-инфраструктуру, внедряя облачные ИИ-сервисы.

Источник изображения: Gartner В 2024-м лидером глобального рынка IaaS осталась Amazon с $64,8 млрд выручки и ростом на 18,6 % по сравнению с 2023 годом. При этом доля компании сократилась с 39 % до 37,7 %. На втором месте располагается Microsoft, у которой поступления поднялись на 27,6 %, достигнув $41,1 млрд. Позиции редмондской корпорации укрепились с 23 % до 23,9 %. Замыкает тройку Google, показавшая рост на 35,4 % — до $15,5 млрд: доля компании поднялась с 8,2 % до 9 %. Alibaba Group находится на четвёртой строке с $12,4 млрд и ростом на 11,8 % по сравнению с 2023 годом: позиции компании ослабли с 7,9 % до 7,2 %. Пятое место досталось Huawei, у которой выручка в годовом исчислении поднялась на 18,4 %, составив примерно $7,1 млрд. Однако доля снизилась с 4,3 % до 4,1 %. В исследовании Gartner говорится, что в 2024 году пять ведущих поставщиков IaaS-услуг контролировали 82,1 % глобального рынка. Суммарная доля всех прочих игроков составила 17,9 %, а их общая выручка — $30,8 млрд. Для сравнения, годом ранее эти показатели равнялись 17,7 % и $24,8 млрд.

06.08.2025 [19:43], Руслан Авдеев

Восстановление ERP-системы Oracle для Бирмингема за £131 млн оказалось под угрозой срываВторая попытка Бирмингема, крупнейшего в Европе муниципалитета, внедрить ERP-систему для управления местными финансами и кадрами может закончиться неудачей. Уровень риска по-прежнему оценивается как «оранжевый» — менее чем за девять месяцев до предполагаемого запуска, сообщает The Register. Согласно результатам независимого аудита проекта, проведённого в мае 2025 года и опубликованного недавно, надёжность системы, которая должна управлять миллиардами британских фунтов, остаётся низкой. По-прежнему сохраняются риски, связанные с нехваткой ресурсов. Внедрением Oracle Fusion совместно занимаются сотрудники городского совета, представители Oracle Consulting и привлечённые подрядчики. Кроме того, приходится поддерживать работу действующего, но неудовлетворительного сервиса на фоне масштабной реструктуризации. Аудиторы также выразили обеспокоенность тем, что ответственность за управление данными и решение возникающих проблем часто ошибочно возлагается исключительно на отдельные программы, системы Oracle или ИТ-отдел, вместо того чтобы рассматривать эти задачи как часть общей бизнес-стратегии.

Источник изображения: Lulu Black/unsplash.com Ещё семь лет назад городской совет Бирмингема принял решение заменить устаревшую, но работоспособную систему SAP на Oracle Fusion. Первоначально запуск планировался в 2021 году, но состоялся только в апреле 2022 года — с катастрофическими последствиями. Система, управляющая бюджетом £3 млрд ($3,98 млрд), начала допускать ошибки при финансовых операциях, и к осени 2023 года Бирмингем фактически оказался банкротом, отчасти из-за нового ПО. С тех пор потрачены миллионы фунтов на «ручное управление» системой. Также возможно использование стороннего ПО для управления финансами. Общий бюджет программы с 2018–2019 по 2025–2026 финансовые годы составил £131 млн, хотя в совете надеются, что расходы можно будет сократить до £108 млн. Изначально бюджет составлял £20 млн, включая внедрение системы в школах — в итоге они были полностью исключены из проекта. Ожидается, что новая система Fusion заработает весной 2026 года. На днях один из членов аудиторского комитета совета поставил под сомнение текущую оценку риска как «оранжевую», заявив, что анализ реестра рисков указывает скорее на «красный» уровень. Тем не менее, в совете утверждают, что намерены пересмотреть методику оценки рисков в будущем. До успешного завершения проекта, по их признанию, ещё предстоит проделать большую работу.

04.08.2025 [16:08], Руслан Авдеев

CoreWeave заняла ещё $2,6 млрд для масштабирования ИИ-проектов OpenAICoreWeave закрыла сделку по получению отложенного кредита (DDTL 3.0) на сумму $2,6 млрд. Средства будут потрачены на покупку и обслуживание современного оборудования и элементов облачной инфраструктуры для предоставления услуг в рамках долгосрочного соглашения с OpenAI, сообщает Datacenter Dynamics. Раунд финансирования возглавили Morgan Stanley и MUFG, в качестве организатора выступила Goldman Sachs. В сделке также приняли участие JPMorgan Chase, Wells Fargo, BBVA, Crédit Agricole, SMBC, PNC и Société Générale. В CoreWeave подчеркнули, что гордятся сотрудничеством с ведущими финансовыми учреждениями на пути масштабирования узкоспециализированной облачной ИИ-платформы для удовлетворения потребностей клиентов-инноваторов. В OpenAI отметили, что CoreWeave является важным партнёром для комплексной инфраструктуры компании. Масштабирование ИИ-проектов требует вычислительных ресурсов мирового уровня, а партнёрство с CoreWeave и ведущими финансовыми учреждениями даёт возможность обучать более эффективные ИИ-модели и предоставлять более качественные услуги. В мае 2025 года CoreWeave подписала с OpenAI новый контракт на $4 млрд, дополнив предыдущее соглашение на $11,9 млрд. Также сообщается, что CoreWeave предоставит часть вычислительных мощностей для сделки OpenAI и Google.

Источник изображения: CoreWeave Кредит DDTL 3.0 предоставлен CoreWeave под плавающую ставку SOFR + 4 % (SOFR — базовая ставка ФРС) и должен быть погашен к 21 августа 2030 года. Залогом выступают практически все активы дочерней компании CoreWeave Compute Acquisition Co. VII, LLC. Новый раунд финансирования состоялся после закрытия 28 июля продажи облигаций на $1,75 млрд. Первоначально планировалось привлечь $1,5 млрд, однако сумма была увеличена. Средства будут направлены на общие корпоративные цели, включая погашение долгов и покрытие сопутствующих расходов. Это уже третий крупный раунд финансирования в 2025 году после майского привлечения $2 млрд. По данным CoreWeave, за последние 18 месяцев компания привлекла более $25 млрд как за счёт акционерного капитала, так и за счёт заёмных средств. Это превысило план в $21 млрд, озвученный в мае 2025 года. Дополнительно стало известно, что CoreWeave заключила соглашение с Applied Digital об аренде ЦОД мощностью 150 МВт, дополнив июньское соглашение с той же компанией на 250 МВт. Совокупная выручка Applied Digital составит $11 млрд за 15 лет. Кроме того, CoreWeave приобрела дата-центр Northeast Science & Technology Center (NEST) за $322 млн в Кенилворте (Нью-Джерси). Площадь кампуса составляет более 43 га, продавцами выступили Machine Investment Group и Onyx Equities. CoreWeave арендовала здание № 11 в кампусе ещё в октябре 2024 года, планируя превратить лабораторный и промышленный корпус площадью 26 тыс. м² в ЦОД, инвестировав $1,2 млрд. Ещё $50 млн на модернизацию должны были вложить предыдущие владельцы. Теперь компания приобрела весь кампус «смешанного назначения» площадью 185 тыс. м², включающий офисные здания, подстанцию на 50 МВт, котельную и другие помещения. В 2023 год нынешние владельцы купили кампус за $187,5 млн, но не преуспели в его использовании. В последнее время CoreWeave стремится получить управляемые ей ЦОД в собственность — в июле она сообщила о покупке компании Core Scientific за $9 млрд, у которой сейчас арендет ЦОД на 840 ГВт.

31.07.2025 [14:25], Владимир Мироненко

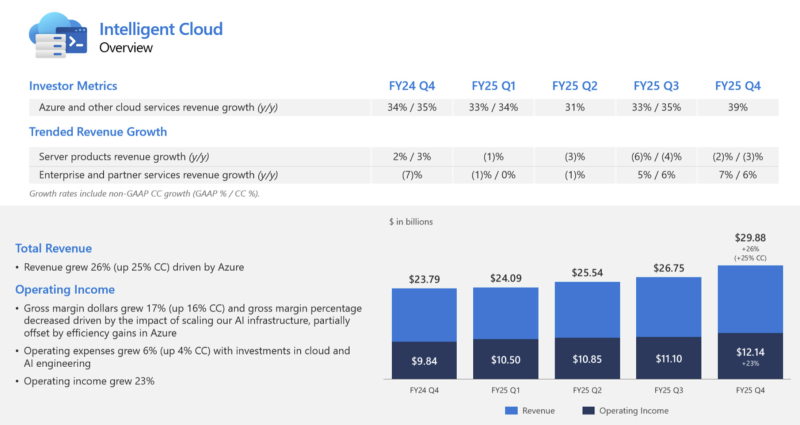

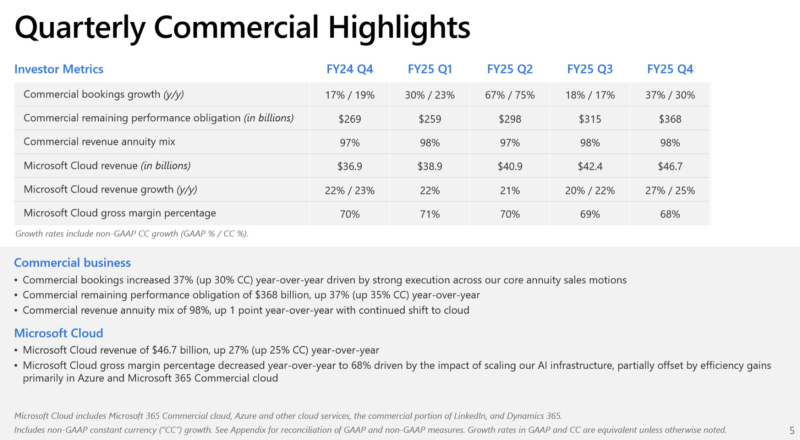

Microsoft увеличила выручку и впервые раскрыла цифры по AzureАкции Microsoft выросли на 9 % в ходе расширенных торгов после публикации компанией отчёта за IV квартал 2025 финансового года, согласно которому её прибыль и выручка превысили ожидания аналитиков. Благодаря росту акций рыночная капитализация Microsoft превысила отметку в $4 трлн, всё же уступая NVIDIA, которая преодолела данный рубеж ранее в этом месяце, отметил ресурс Siliconangle. Microsoft также впервые раскрыла годовой доход облачной платформы Azure, что позволило акционерам получить представление о её положении в облачном сегменте по сравнению с Amazon и Google. Выручка Microsoft за отчётный период выросла на 18 % до $76,44 млрд, превысив консенсус-прогноз аналитиков, опрошенных LSEG, в размере $73,81 млрд. Это самый быстрый рост показателя за более чем три года. Чистая прибыль увеличилась на 24 % до $27,23 млрд с $22,04 млрд годом ранее. Чистая прибыль на акцию составила $3,65 по сравнению с $3,37 согласно консенсус-прогнозу аналитиков, опрошенных LSEG. «Мы завершили финансовый год с сильным кварталом, о чем свидетельствует выручка от Microsoft Cloud, достигшая $46,7 млрд, что на 27 % больше по сравнению с аналогичным периодом прошлого года», — отметила Эми Худ (Amy Hood), исполнительный вице-президент и финансовый директор Microsoft. Выручка подразделения Microsoft Intelligent Cloud, в которое входят облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, составила $29,88 млрд (рост год к году на 26 %), что превзошло консенсус-прогноз StreetAccount в $28,92 млрд. Компания сообщила, что выручка облачной платформы Microsoft Azure за 2025 финансовый год превысила $75 млрд, что на 34 % больше, чем годом ранее. Это обусловлено не только спросом на ИИ, но и «ростом во всех рабочих нагрузках», указал генеральный директор Microsoft Сатья Наделла (Satya Nadella) в отчёте. Для сравнения, согласно данным Alphabet, о чём сообщает The Wall Street Journal, годовая выручка Google Cloud превысила $50 млрд, а у AWS — более $111 млрд (с учётом итогов завершившегося в марте квартала). В IV финансовом квартале выручка Azure выросла на 39 %. Аналитики, опрошенные StreetAccount и CNBC, прогнозировали рост Azure на 34,4 % и 35,3 % соответственно. Компания заявила, что ожидает рост на 37 % в текущем квартале, что превзошло прогнозы аналитиков в 33,5 % (согласно данным Visible Alpha), о чём сообщает Reuters. Выручка подразделения Microsoft Productivity and Business Processes составила $33,11 млрд (рост год к году на 16 %), превысив консенсус-прогноз в $32,12 млрд аналитиков, опрошенных StreetAccount. Сатья Наделла рассказал о том, как ставка компании на ИИ, включая значительные инвестиции в OpenAI и многомиллиардные затраты на чипы NVIDIA, способствует росту продаж ПО в этом подразделении. Он отметил, что интеграция Microsoft 365 Copilot с инструментами повышения производительности привела к заметному росту дохода на одного пользователя таких продуктов, как Office. В настоящее время насчитывается более 100 млн активных пользователей инструментов Copilot в месяц, включая Microsoft 365 Copilot для коммерческих клиентов и помощника Copilot для потребителей в Windows. Ставка Microsoft на ИИ, включая инвестиции в OpenAI и миллиарды долларов, потраченные на чипы NVIDIA, способствует росту продаж бизнес-ПО, отметил Сатья Наделла. Он подчеркнул, что интеграция Microsoft 365 Copilot с инструментами повышения производительности привела к заметному росту дохода в расчёте на пользователя таких продуктов, как Office. Количество активных пользователей продуктов Copilot, включая Microsoft 365 Copilot для коммерческих клиентов и помощника Copilot для пользователей Windows, составляет 100 млн ежемесячно, сообщил Наделла. Аналитик Valoir Ребекка Веттеманн (Rebecca Wettemann) сообщила SiliconANGLE, что комментарии Наделлы обнадёживают, но отметила, что компания всё ещё испытывает трудности с ростом популярности ИИ по сравнению с некоторыми конкурентами. «Microsoft медленнее, чем некоторые конкуренты, добивается успеха в области ИИ», — сказала аналитик. «Поскольку конкуренты начинают хвастаться корпоративными референциями и говорить о цифрах внедрения, Microsoft необходимо последовать их примеру, чтобы опровергнуть мнение о том, что Copilot всё ещё слишком дорог для широкого внедрения среди клиентов», — предложила она. Подразделение More Personal Computing увеличило выручку на 9 % до $13,45 млрд, что выше консенсус-прогноза StreetAccount в размере $12,68 млрд. Капитальные затраты Microsoft выросли год к году на 27 % до $24,2 млрд, по сравнению с прогнозом аналитиков в $23,08 млрд (согласно Visible Alpha), поскольку компания продолжает активно развивать инфраструктуру ИИ ЦОД. Ещё $1,71 млрд списаны на другие расходы, включая убытки от инвестиций в долевое участие в компаниях, включая OpenAI. Эми Худ сообщила, что компания прогнозирует выручку за I финансовый квартал в пределах от $74,7 до $75,8 млрд со средним показателем в размере $75,25 млрд, превосходящем консенсус-прогноз LSEG в $74,09 млрд Прогноз по операционной рентабельности в размере 46,6 % превышает консенсус-прогноз аналитиков, опрошенных StreetAccount, в 45,7 %. Прогноз Microsoft включает более $30 млрд на капзатраты и активы, приобретённые по финансовой аренде, что в итоге обеспечит рост год к году более 50 %. Аналитики, опрошенные Visible Alpha, ожидают около $24,23 млрд. Microsoft заявила, что её капитальные расходы несколько сместились в сторону активов с длительным сроком службы, таких как ЦОД, хотя ранее компания сообщила инвесторам, что в 2026 финансовом году структура капитальных расходов сместится в сторону активов с малым сроком службы, таких как чипы.

28.07.2025 [15:04], Руслан Авдеев

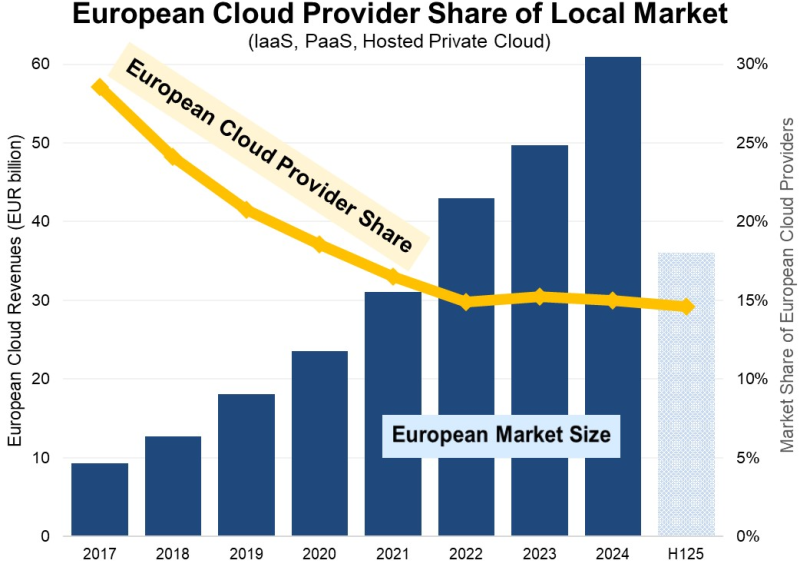

Доля европейских облачных провайдеров на местном рынке снизилась до 15 % и остаётся на этом уровне годамиКак свидетельствуют новые данные Synergy Research Group, европейские операторы облачных сервисов с 2017 по 2024 годы увеличили свои местные доходы более чем втрое. Правда, за тот же период облачный рынок вырос более чем в шесть раз, составив в 2024 году €61 млрд ($70 млрд), сообщает пресс-служба компании. При этом доля европейских облачных провайдеров на местном рынке снизилась с 29 % в 2017 году до 15 % в 2022 году, и с тех пор сохраняется на одном уровне. Основными бенефициарами стали Amazon (AWS), Microsoft и Google — на эту тройку приходится 70 % рынка региона. Среди европейских провайдеров лидируют SAP и Deutsche Telekom, но на каждого из них приходится лишь по 2 % европейского рынка. Определённую роль играют и OVHCloud, Telecom Italia, Orange, а также многочисленные игроки национального и регионального масштабов. Оставшаяся часть европейского рынка приходится на мелких облачных провайдеров из США и Азии. Как утверждают в Synergy, выручка от облачной инфраструктуры (включая IaaS, PaaS и хостинг частных облаков) в I полугодии текущего года составила €36 млрд, а за весь год она вырастет год к году на 24 %. Большая часть рынка приходится на IaaS- и PaaS-сервисы, и они растут быстрее, чем сегмент частных облаков. Драйвером рынка становится искусственный интеллект (ИИ) — рост генеративных сервисов на основе ИИ, вроде GPUaaS и GenAI PaaS, составляет 140–160 %.

Источник изображения: Synergy Research Group По статистике Synergy, крупнейшими облачными рынками в регионе являются Великобритания и Германия, но только сейчас крупнейшими рынками с самыми высокими темпами роста названы Ирландия, Испания и Италия. По словам представителя Synergy Research, на рынке облачных услуг начинающим игрокам приходится делать огромные финансовые ставки, иметь долгосрочное видение инвестиционной политики и грядущих прибылей, а также всё время совершенствовать бизнес. При этом ни одна европейская компания не соответствует этим критериям, и на рынке предсказуемо доминируют американские компании. Они ежеквартально вкладывают в европейские программы капиталовложения порядка €10 млрд — конкурировать с ними местному бизнесу буквально невозможно. В результате европейские облачные поставщики в основном обслуживают локальные группы клиентов с специфическими для региона потребностями, иногда взаимодействуя с крупными американскими провайдерами. Хотя многие европейские поставщики облачных услуг, вероятно, продолжат расти, вряд ли они смогут существенно изменить положение дел на облачном рынке. В конце мая эксперты заявили, что европейским пользователям отказаться от американских облаков сегодня уже практически невозможно. Более того, в июне SAP заявила, что не видит смысла в строительстве Европой собственной облачной инфраструктуры. Между тем, тотальное доминирование американского бизнеса в Европе грозит местным облачным провайдерам серьёзными проблемами. Так, в мае 2025 года сообщалось, что Microsoft всё ещё не создала продукта, удовлетворяющего требованиям соглашения с ассоциацией европейских облачных провайдеров CISPE. В рамках действующей под эгидой CISPE инициативы было решено, что относительно действий компании всё ещё «существуют опасения, хотя предложены меры для исправления». Кроме того, в июле Microsoft признала, что не может гарантировать суверенитет данных в Европе. Наконец, CISPE подала иск в Европейский суд общей юрисдикции, утверждая, что Еврокомиссия не выдвинула никаких условий, мешающих Broadcom злоупотреблять доминирующим положением на рынке. CISPE заявляет, что доминирование ПО VMware на рынке виртуализации означает, что обновление условий лицензирования затронут практически всех европейских облачных операторов и их пользователей. Год назад CISPE прямо заявила, что новая лицензионная политика Broadcom грозит банкротством небольшим облачным провайдерам.

27.07.2025 [23:55], Владимир Мироненко

Microsoft признала, что не может гарантировать суверенитет данных в Европе

aws

microsoft

microsoft azure

software

гиперскейлер

европа

евросоюз

закон

информационная безопасность

конфиденциальность

облако

сша

франция

Microsoft «не может гарантировать» суверенитет данных клиентам во Франции, и, как следствие, всему Европейскому союзу, если администрация Трампа потребует доступ к информации о клиентах, хранящейся на её серверах, пишет The Register. Об этом сообщил, выступая перед Сенатом Франции в рамках расследования государственных закупок и их роли в обеспечении цифрового суверенитета Европы, Антон Карньо (Anton Carniaux), директор по связям с общественностью и правовым вопросам французского отделения Microsoft. Согласно Акту о законном использовании данных за рубежом (The Cloud Act), правительство США наделено правом получать цифровые данные, хранящиеся у американских технологических корпораций, причём в независимости от того, хранятся ли эти данные на серверах внутри страны или за рубежом, и даже если эти данные принадлежат не гражданам США. Отвечая на вопрос о технических или юридических механизмах, которые могли бы помешать такому доступу в соответствии с The Cloud Act, Карньо заявил, что компания «имеет договорное обязательство перед своими клиентами, включая клиентов государственного сектора, отклонять эти запросы, если они необоснованны». Ранее Microsoft заверила, что работа облачных сервисов в ЕС будут контролироваться местным советом директоров и действовать в соответствии с местным законодательством. Карньо подчеркнул, что правительство не может делать запросы, которые не имеют чёткого определения — если такие запросы поступают, компания просит о возможности уведомить об этом соответствующего клиента. Карньо также спросили, может ли он, как представитель руководства Microsoft, в случае юридически обоснованного судебного запрета «гарантировать нашему комитету под присягой», что данные французских граждан не будут переданы американскому правительству без явного согласия французского правительства. «Нет, — сказал Карньо, — я не могу этого гарантировать, но, опять же, такого никогда раньше не случалось». Марк Буст (Mark Boost), генеральный директор облачного провайдера Civo, заявил: «Одна строка показаний только что подтвердила, что американские гиперскейлеры не могут гарантировать суверенитет данных в Европе». По его словам, Microsoft открыто признала то, что многим давно известно: согласно законам вроде The Cloud Act власти США могут принудительно запрашивать доступ к данным, хранящимся у американских провайдеров облачных услуг, независимо от того, где эти данные физически хранятся. «Это больше, чем просто формальность. Это реальная проблема, которая может повлиять на национальную безопасность, конфиденциальность персональных данных и конкурентоспособность бизнеса», — заявил Марк Буст. Параллельно на этой неделе AWS пояснила некоторые моменты реализации требований The Cloud Act в связи с ростом числа «запросов о том, как мы обрабатываем запросы государственных органов на предоставление данных». AWS утверждает, что закон не предоставляет правительству США «беспрепятственный или автоматический доступ к данным, хранящимся в облаке». The Cloud Act позволил США заключать взаимные исполнительные соглашения с доверенными иностранными партнёрами с целью получения доступа к электронным доказательствам для расследования тяжких преступлений, где бы эти доказательства ни находились, устранив препятствия, предусмотренные законодательством США. «Согласно законодательству США, провайдерам фактически запрещено раскрывать данные правительству США при отсутствии предусмотренного законом исключения», — сообщила AWS. — «Чтобы обязать провайдера раскрыть данные, правоохранительные органы должны убедить независимого федерального судью в наличии причины, связанной с конкретным преступлением, и в том, что доказательства преступления будут обнаружены там, где должен быть произведён обыск». AWS заявила, что до этого момента не раскрывала данные корпоративных или государственных клиентов в соответствии с законом The Cloud Act. По словам AWS, принципы закона «соответствуют международному праву и законам других стран»; и закон «не ограничивает технические меры и операционные средства контроля, которые AWS предлагает клиентам для предотвращения несанкционированного доступа к их данным». И последний аргумент AWS, который явно направлен против европейских конкурентов, пытающихся воспользоваться движением за суверенитет данных, заключается в том, что The Cloud Act распространяется не только на компании с головным офисом в США, но и на всех «поставщиков услуг электронной связи или удалённых вычислений», ведущих бизнес в США. То есть поставщики облачных услуг со штаб-квартирой в Европе, ведущие деятельность в США, также подпадают под его действие. Microsoft, AWS и Google пытаются заверить обеспокоенных клиентов в ЕС в том, что они смогут обеспечить суверенитет данных при не совсем дружелюбной позиции США по отношению к странам, некогда считавшимся близкими союзниками. Несмотря на это, в ЕС наблюдается тенденция на создание суверенной инфраструктуры, отметил The Register, хотя не все поддерживают эту идею. Более того, многие в Европе смирились с тем, что без американских облаков уже не обойтись. Согласно данным Synergy Research Group, доля локальных игроков на облачном рынке Европы замерла на уровне 15 %. При этом часть из них ещё и попала в зависимость от новой политики Broadcom в отношении VMware.

26.07.2025 [14:55], Сергей Карасёв

В Европе запущена первая метаоблачная ИИ-платформа Fact8raКомпания OpenNebula Systems объявила о запуске Fact8ra — это, как утверждается, первая в Европе платформа «ИИ как услуга» (AI-as-a-Service) на основе мультиоблачной архитектуры. Инициатива является важным этапом на пути формирования европейской суверенной инфраструктуры ИИ. Любопытно, что в Китае создаётся похожая платформа, но по совсем иным причинам — в результате не слишком удачного планирования значительная часть вычислительных мощностей простаивает без дела. Система Fact8ra предлагает многопользовательскую среду для развёртывания частных экземпляров больших языковых моделей (LLM) с открытым исходным кодом. Платформа объединяет НРС-мощности, публичное облако и периферийные ресурсы по всему ЕС. Fact8ra основана на суверенном облачном стеке ИИ, включающем решения OpenNebula, а также другие европейские технологии open source, такие как openSUSE и MariaDB. Поначалу Fact8ra объединит GPU-серверы в восьми странах ЕС: Франции, Германии, Италии, Латвии, Нидерландах, Польше, Испании и Швеции. Отмечается, что Fact8ra способна агрегировать ресурсы поставщиков публичных облачных сервисов, периферийных площадок, суперкомпьютерных центров и финансируемых ЕС фабрик ИИ. В частности, будут объединены мощности Arsys, CloudFerro, IONOS, Leaseweb, OVHcloud, Scaleway, StackScale и Tiscali. Говорится о расширенной поддержке ИИ-ускорителей NVIDIA. Fact8ra поддерживает работу с различными LLM, включая Mistral Nemo 12B, EuroLLM 9B, Salamandra 7B и Italia 9B. Кроме того, реализована интеграция с внешними каталогами ИИ-моделей, в том числе Hugging Face. Поначалу пользователям будут доступны возможности инференса, а затем появятся функции тонкой настройки и обучения моделей ИИ. Fact8ra реализуется как часть программы IPCEI-CIS (Important Project of Common European Interest on Next Generation Cloud Infrastructure and Services) — это европейский проект развития облачной инфраструктуры и услуг следующего поколения. Инициатива стоимостью €3 млрд была одобрена Европейской комиссией в декабре 2023 года. Проект поддерживается 12 государствами-членами ЕС и более чем 120 индустриальными партнёрами. Целями являются стимулирование исследований и увеличение инвестиций в технологии периферийных и облачных вычислений в ЕС, а также создание децентрализованной периферийной инфраструктуры. Ранее в рамках IPCEI-CIS была анонсирована суверенная облачная платформа Virt8ra.

26.07.2025 [14:46], Руслан Авдеев

Внеплановая экономика: Китай создаст метаоблако для продажи избыточных вычислительных мощностейКНР принимает меры по формированию сети продаж вычислительных мощностей и сдерживания неконтролируемого развития рынка ЦОД. Дело в том, что тысячи поддерживаемых местными властями дата-центров, уже построенных в Китае, привели к переизбытку предложения, сообщает Reuters. Государственные органы проводят оценку соответствующего рынка в общенациональном масштабе после трёхлетнего бума строительства дата-центров. По словам одного из представителей органов местной власти, Пекин также намерен создать общегосударственный облачный сервис для использования «лишних» вычислительных мощностей. Так, Министерство промышленности и информационных технологий взаимодействует с тремя государственными телеком-компаниями Китая для разработки способов объединения ЦОД в рамках единой платформы для продаж незадействованных вычислительных мощностей. В гонке с США за лидерство в ИИ-секторе неиспользуемые мощности и финансово нестабильные ЦОД — значимая проблема Пекина, способная помешать претворению в жизнь его амбиций. По словам местных исследователей и чиновников, к 2028 году Китай намерен стандартизировать доступ к вычислительным мощностям в стране, но некоторые эксперты сулят плану технические проблемы. Бум строительства ЦОД в Китае начался в 2022 году, после запуска амбициозного проекта «Восточные данные, Западные вычисления» (Eastern Data, Western Computing), в рамках которого планировалось построить множество ЦОД в западных регионах КНР, где стоимость энергии ниже, для обработки данных восточных регионов, где сосредоточена основная экономическая деятельность страны. В июне было заявлено, что на сегодня лицензии выданы не менее 7 тыс. вычислительных центров. Согласно анализу Reuters государственных закупок, в прошлом году инвестиции Китая в эту сферу выросли на порядок — с ¥2,4 млрд юаней в 2023 году до ¥24,7 млрд ($3,4 млрд). В текущем году в эти ЦОД уже инвестировано ¥12,4 млрд юаней, большая часть из них находится в Синьцзяне. Возможно, это связано с проектом гигантского комплекса ИИ ЦОД для 115 тыс. ускорителей NVIDIA. Тем не менее, если в 2023 году отменили лишь 11 проектов строительства ЦОД, то за последние 18 месяцев таковых стало более сотни — местные власти обеспокоены окупаемостью инвестиций. По данным источников Reuters, уровень загрузки построенных ЦОД крайне низок, порядка 20–30 %. Некоторые эксперты уже заявили, что инвесторы и местные власти, ожидающие заказы от правительства и госкомпаний, строят ЦОД без учёта реальных потребностей рынка. При этом идея строительства на западе страны изначально лишена экономического обоснования, поскольку снижение расходов идёт рука об руку со снижением производительности и доступности. Ранее уже сообщалось, что многочисленные и наспех построенные дата-центры в западных регионах попросту оказались невостребованными. Проблема и в архитектуре ЦОД, и в их удалённости. В рамках проекта Eastern Data, Western Computing планировалось добиться задержки 20 мс к 2025 году — это пороговое значение, необходимое для приложений вроде сверхбыстрой алгоритмической торговли и других сервисов в финансовом секторе. Тем не менее, многие объекты до сих пор не соответствуют этому стандарту, а аренда каналов связи восток–запад всё ещё очень дорога. Фактически многие предприятия предпочитают хранить данные в дата-центрах на западе, но не обрабатывать их там. Кроме того, построенные ИИ ЦОД опираются как на ускорители NVIDIA, так и на локальные альтернативы вроде Huawei Ascend, что усложняет интеграцию различных полупроводников, требующих разного аппаратного и программного обеспечения, что затрудняет создание единого облачного сервиса. Тем не менее, власти оптимистичны и рассчитывают преодолеть эти различия — по их словам, пользователям нового сервиса достаточно будет указать свои требования вроде необходимого объёма вычислений и пропускной способности сети. Для регулирования развития сектора ЦОД комиссия NDRC, занимающаяся планированием в Китае, в начале года инициировала ужесточение контроля за новыми проектами дата-центров, строительство которых запланировано после 20 марта. Кроме того, местным органам власти запретили участвовать в мелких проектах по созданию вычислительной инфраструктуры. Предположительно, NDRC желает предотвратить нерациональное использование ресурсов, устанавливая пороговые требования — вроде наличия соглашения о покупке запланированных мощностей и минимального уровня загрузки. Таким образом предполагается отсеять «мусорные» проекты.

24.07.2025 [16:38], Владимир Мироненко

Выручка Google Cloud выросла на треть — Alphabet увеличит капзатраты до $85 млрд на фоне высокого спроса на ИИХолдинг Alphabet, включающий компанию Google, объявил финансовые результаты II квартала 2025 года, закончившегося 30 июня. Согласно пресс-релизу, консолидированная выручка Alphabet выросла в отчётном квартале на 14 % в годовом исчислении до $96,4 млрд, отражая устойчивую динамику во всем бизнесе. Это выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $94 млрд или 10,9 % увеличения. Чистая прибыль увеличилась на 19 % до $28,2 млрд, а прибыль на акцию — на 22 % до $2,31, что тоже выше прогноза от LSEG в размере $2,18 на акцию. Выручка облачного подразделения Google Cloud увеличилась на 32 % до $13,62 млрд, главным образом за счёт роста доходов Google Cloud Platform (GCP) по основным продуктам GCP, ИИ-инфраструктуре и решениям для генеративного ИИ, при прогнозе аналитиков StreetAccount в размере $13,11 млрд. На прошлой неделе OpenAI объявила о начале использования ресурсов Google Cloud для поддержки ChatGPT. «Мы очень рады сотрудничеству», — отметил генеральный директор Alphabet Сундар Пичаи (Sundar Pichai) в ходе квартального отчёта. Стремительный рост Google Cloud и сделка с OpenAI — ещё одно свидетельство того, что предприятия наконец-то осознают преимущества TPU Google, заявил Хольгер Мюллер (Holger Mueller) из Constellation Research ресурсу SiliconANGLE. «Кроме того, Google Cloud на год опережает конкурентов в плане работы с мультимодальными моделями, что во многих случаях способствует созданию более качественной и дешёвой ИИ-инфраструктуры», — отметил аналитик, добавив, что это обеспечивает Google значительное преимущество в гонке за ИИ в облаке. Аналитик Forrester Research Ли Сустар (Lee Sustar) назвал впечатляющим рост Google Cloud за последние несколько лет. По его словам, то, что когда-то считалось второстепенным направлением, приносящим одни убытки, превратилось во всё более значимый источник доходаL «ИИ — важная, но не единственная причина этого роста. Google Cloud систематически наращивает вычислительные мощности для крупных предприятий, выходя за рамки привычных решений для обработки данных, аналитики и ИИ». Он также указал на тот факт, что операционная рентабельность Google Cloud выросла за квартал вдвое до примерно 20 %, т.е. бизнес может расти, не сжигая всю выручку. Компания получает прибыль от своих огромных инвестиций в ИИ. «Эра облачных технологий, разработанных специально для ИИ, уже наступила, и это заметно по показателям Google Cloud», — сказал Сустар. В ходе телефонной конференции с аналитиками финансовый директор Alphabet Анат Ашкенази (Anat Ashkenazi) заявила, что рост выручки обусловлен растущим спросом на облачные продукты и услуги, добавив, что в 2026 финансовом году, вероятно, потребуются дополнительные расходы. «Учитывая высокий и растущий спрос на наши облачные продукты и услуги, мы увеличиваем наши капитальные вложения в 2025 году примерно до $85 млрд», — сообщается в отчёте Alphabet. Напомним, что в феврале Alphabet объявил, что в этом году выделит на капзатраты $75 млрд по сравнению с $52,5 млрд в прошлом году. Холдинг отметил, что выручка от Google Services увеличилась на 12 % до $82,5 млрд, отражая высокие показатели поисковика, подписок, платформ и устройств Google, а также рекламы в YouTube. Выручка холдинга от YouTube составила $9,8 млрд, что немного выше прогноза StreetAccount в размере $9,56 млрд. Сундар Пичаи сообщил, что у бота AI Overviews, обобщающего результаты поиска, теперь более 2 млрд пользователей в более чем 200 странах, по сравнению с 1,5 млрд пользователей в конце предыдущего квартала. А Gemini теперь насчитывает более 450 млн активных пользователей. Добавление AI Overviews в Google Search может быть одной из причин, по которой этот бизнес продолжает демонстрировать силу, отметил SiliconANGLE. Выручка поисковика за квартал составила более $54,19 млрд, что составляет значительную часть от общей выручки от рекламы в размере $71,34 млрд, превысившей прошлогодний показатель на 10,5 %. Хольгер Мюллер отметил, что эти результаты, похоже, развеяли все опасения по поводу того, что генеративный ИИ может повлиять на доминирование Google в поиске, по крайней мере, на данный момент. Холдинг не предоставил прогноз на III финансовый квартал, но Ашкенази сообщила, что выручка Alphabet в текущем квартале может «снизиться» по нескольким причинам, включая падение доходов от рекламы, которая выиграла от «значительных расходов на выборы в США» в конце 2024 года, особенно на платформе YouTube.

21.07.2025 [16:08], Руслан Авдеев

Samsung начал поиск альтернатив VMwareОсновные компании, входящие в Samsung Group, начали искать альтернативы VMware в связи со значительным ростом цен на продукты последней, причём ПО, похоже, будут дорожать и дальше, передаёт ETNews. Как сообщают источники издания, Samsung Electronics, Samsung Display и другие подразделения Samsung Group уже реализуют либо готовятся к реализации проектов по постепенному отказу от VMware. Так, Samsung Electronics рассматривает альтернативные варианты с прошлого года. При этом компания не намерена немедленно отказываться от продуктов, пока заключён контракт на закупку ПО на сумму ₩40 млрд (около $29 млн). Параллельно компания участвует в проектах по разработке open source ПО. Цель состоит в том, чтобы разработать облачную среду, избегая коммерческих инструментов вроде продуктов VMware. Привлечены специалисты по виртуализации и облачным технологиям. В 2026 году будут определены направление и масштаб внедрения новых продуктов. Samsung Electronics намерена самостоятельно создать частное облако. Для работы над ним привлекут как сотрудников самой Samsung, так и специализированные компании. Проект планируется завершить в течение года. Samsung Display также готовит проект снижения зависимости от VMware. Компании Samsung Group являются одними из крупнейших заказчиков VMware в Южной Корее. Однако смена политики VMware привела к росту цен, так что дочерние структуры Samsung Group посчитали затраты слишком высокими в сравнении с выгодами от использования VMware. В 2023 году VMware была куплена Broadcom, а в 2024-м компания повысила цены на свою продукцию. По мнению экспертов, в ближайшие два-три года цена может значительно увеличиться в сравнении с текущей. Уже есть примеры пятикратного роста стоимости лицензий и обслуживания. Утверждается, что цены будут формироваться в индивидуальном порядке. Кроме того, постоянно меняются условия сделок. Есть претензии и к политике продаж. Флагманский продукт VMware Cloud Foundation (VCF) включает ПО для виртуализации, сетевые решения и решения для хранения данных единым пакетом. При этом многим корейским компаниям нужны только продукты для виртуализации, а переплачивать за ненужные продукты они не хотят. По словам одного из источников, большинство крупных компаний, включая производственные и финансовые, ускорят движение к отказу от VMware. |

|