Материалы по тегу: ии

|

22.08.2025 [18:08], Владимир Мироненко

Новейшие ИИ-технологии помогут трансформировать обучение, сделав его полностью персонализированнымСектор образования всегда отличался своей инновационностью, но в последние годы образовательные технологии (EdTech) претерпели беспрецедентную трансформацию. Стремительное развитие ИИ-технологий сделало EdTech-решения более персонализированными, доступными и привлекательными, заметно отразившись на методах обучения студентов, работе преподавателей и образовательных учреждений — от виртуальных классов и адаптивных платформ обучения до виртуальных ИИ-преподавателей и инструментов оценки. Одним из наиболее значимых достижений в области EdTech является переход от универсального обучения к персонализированному. ИИ-платформы позволяют анализировать поведение, прогресс и успеваемость учащихся в режиме реального времени, и с учётом этого корректировать планы уроков. Если, например, у учащегося будут обнаружены пробелы в конкретных навыках, ему будут автоматически предоставлены упражнения для их устранения. Это не только поможет учащимся успешно осваивать учебную программу в своем собственном темпе, но и сохранит им мотивацию к решению реальных задач. Еще одним прорывом в сфере образовательных технологий на основе ИИ стало появление иммерсивных образовательных сред. В настоящее время в преподавании широко используются инструменты на основе технологий виртуальной (VR) и дополненной (AR) реальности, позволяя более наглядно раскрывать сложные нюансы в области науки, техники и медицины. Способствуя более глубокому вовлечению в суть предмета, интерактивные возможности сокращают разрыв между теорией и практикой. Представьте себе студента-биолога, изучающего кровеносную систему человека в 3D, или ученика-историка, совершающего виртуальную экскурсию по Древнему Риму. ИИ также позволяет автоматизировать рутинную работу, включая выставление оценок за задания, создание учебных материалов и управление посещаемостью, благодаря чему преподаватели могут уделять больше внимания наставничеству. Автоматизированные системы оценивания, интеллектуальные инструменты составления расписания и генераторы учебных программ, управляемые ИИ, снижают затраты времени преподавателей на решение административных задач, предупреждая эмоциональное выгорание и способствуя повышению эффективности обучения. Даже такие продвинутые инструменты, как детекторы ИИ, всё чаще используются для проверки эссе, выявления плагиата и предоставления обратной связи в режиме реального времени для обеспечения академической честности и качества контента. Также одним из наиболее важных элементов использования ИИ сфере образовании считается прогнозирующая аналитика. ИИ на основе имеющихся данных может прогнозировать успеваемость учащихся, выявлять тех, кто подвержен риску отставания, и оперативно рекомендовать меры по предотвращению подобных случаев. Это позволяет преподавателям и учреждениям упреждать возникновение проблем, повышая качество обучения. Использование ИИ в EdTech открывает огромные перспективы, но также поднимает вопросы об обеспечении конфиденциальности, справедливости и предвзятости. Использование данных учащихся требует ответственного подхода и строгих мер предосторожности при их сборе и хранении. Кроме того, возникает риск увеличения разрыва в уровне образования, поскольку не у всех учащихся есть равный доступ к передовым цифровым инструментам. Программисты и разработчики политик должны уделять приоритетное внимание инклюзивности, прозрачности и справедливости по мере развития отрасли, считают эксперты. Слияние ИИ и EdTech, скорее всего, приведёт к гиперперсонализированному образованию, в рамках которого студенты будут иметь доступ к индивидуальной образовательной экосистеме, основанной на интеллектуальных помощниках, иммерсивном моделировании и обратной связи в режиме реального времени. По мере развития генеративного ИИ появятся полностью автономные виртуальные преподаватели, ведущие обучение по нескольким дисциплинам, со взаимодействием, максимально приближённым к человеческому. Следует отметить, что цель образовательных технологий на базе ИИ заключается не в том, чтобы заменить преподавателей, а в том, чтобы расширить их возможности, усилить воздействие и создать более инклюзивную, эффективную и увлекательную образовательную среду для всех учащихся.

22.08.2025 [17:23], Руслан Авдеев

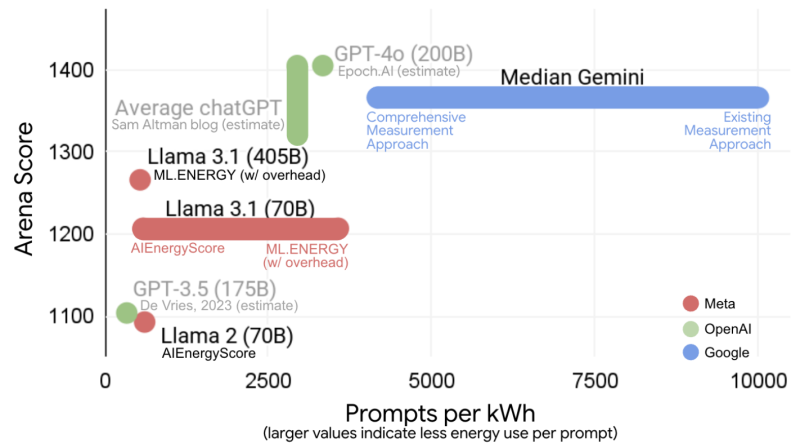

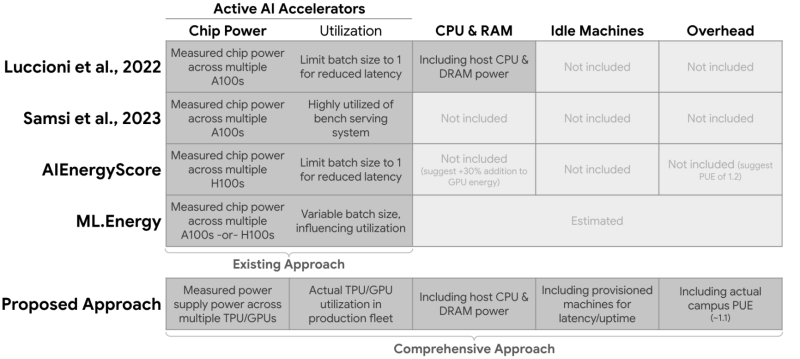

Google: медианный промпт Gemini потребляет 0,24 Вт·ч энергии и 0,26 мл водыКомпания Google опубликовала документ, в котором описывается методология измерения потребления энергии и воды, а также выбросов и воздействия на окружающую среду ИИ Gemini. Как утверждают в Google, «медианное» потребление энергии на одно текстовое сообщение в Gemini Apps составляет 0,24 Вт·ч, выбросы составляют 0,03 г эквивалента углекислого газа (CO2e), а воды расходуется 0,26 мл. В компании подчёркивают, что показатели намного ниже в сравнении со многими публичными оценками, а на каждый запрос тратится электричества столько же, сколько при просмотре телевизора в течение девяти секунд. Google на основе данных о сокращении выбросов в ЦОД и декарбонизации энергопоставок полагает, что за последние 12 месяцев энергопотребление и общий углеродный след сократились в 33 и 44 раза соответственно. В компании надеются, что исследование внесёт вклад в усилия по разработке эффективного ИИ для общего блага. Методологии расчёта энергопотребления учитывает энергию, потребляемую активными ИИ-ускорителями (TPU), CPU, RAM, а также затраты простаивающих машин и общие расходы ЦОД. При этом из расчёта исключаются затраты на передачу данных по внешней сети, энергия устройств конечных пользователей, расходы на обучение моделей и хранение данных. Впрочем, по мнению некоторых экспертов, данные вводят в заблуждение, поскольку часть информации не учитывается. Так, не принимается в расчёт «косвенное» использование воды, поскольку считается только вода, которую ЦОД применяют для охлаждения, хотя значительная часть водопотребления приходится на генерирующие мощности, а не на их потребителей. Кроме того, при учёте углеродных выбросов должны приниматься во внимание не купленные «зелёные сертификаты», а реальное загрязняющее действие ЦОД в конкретной локации с учётом использования «чистой» и «обычной» энергии в местной электросети. OpenAI также недавно оказалась в центре внимания экспертов и общественности, поскольку появилась информация, что её новейшая модель GPT-5 потребляет более 18 Вт·ч электроэнергии, до 40 Вт·ч на ответ средней длины. Сам глава компании Сэм Альтман (Sam Altman) объявил, что в среднем на выполнение запроса тратится около 0,34 Вт∙ч и около 0,32 мл воды. Это несколько больше, чем заявленные показатели Google Gemini, однако, согласно расчётам исследователей, эти цифры, скорее всего, актуальны для GPT-4o.

22.08.2025 [15:18], Руслан Авдеев

Исполинская 5-ГВт газовая электростанция Pacifico Energy в Техасе запитает ИИ ЦОД и никого большеКалифорнийская Pacifico Energy рассказала о планах строительства 5-ГВт автономной газовой электростанции GW Ranch в округе Пекос (Pecos County, Техас) на территории площадью более 3,2 тыс. га, где также разместятся аккумуляторные энергохранилища. Вся энергия пойдёт исключительно на питание ИИ ЦОД гиперскейл-класса, сообщает Datacenter Dynamics. В компании подчёркивают, что проект будет изолирован от энергосети штата. Это позволит ускорить развёртывание ИИ ЦОД без ущерба надёжности энергоснабжения. К 2028 году Pacifico намерена довести выработку до 1 ГВт, а к 2030 году выйти на проектную мощность в 5 ГВт. Мощность аккумуляторного хранилища составит 1,8 ГВт — его модульные системы будут внедряться поэтапно. Компания находится в процессе получения разрешений от техасского природоохранного регулятора Texas Commission on Environmental Quality. По её мнению, проект соответствует требованиям в области защиты окружающей среды. Топливо будет поставляться с месторождений Пермского нефтегазового бассейна США (Permian Basin), одного из крупнейших источников природного газа в стране. По данным Управления энергетической информации США (EIA), в 2024 году добыча природного газа в Пермском бассейне выросла на 12 % год к году, составив 22 % от общего объёма продаж природного газа в стране. Большие объёмы добычи и благоприятная нормативная база в Техасе побудили отдельных операторов ЦОД заняться развитием электростанций для обеспечения своих объектов энергией в обход основных электросетей. Занимающиеся добычей природного газа в Пермском бассейне компании также позиционируют себя в качестве поставщиков для сектора ЦОД.

Источник изображения: Chris LeBoutillier/unsplash.com Одобрение регуляторов получил и ещё один крупный проект — власти Луизианы разрешили Entergy постройку трёх газовых электростанций для питания крупнейшего ИИ ЦОД Meta✴ Hyperion, который после полного завершения строительства потребует до 5 ГВт. Для него придётся построить отдельную ЛЭП. Новые электростанции будут поставлять до 2,3 ГВт, ещё 1,5 ГВт планируется получить от проектов солнечной энергетики. Часть расходов по созданию новых объектов Meta✴ возьмёт на себя. Местные регуляторы быстро одобрили проект, поскольку Entergy намекнула, что в случае задержек Meta✴ может перенсти проект в другой штат. Некоторые эксперты опасаются, что расходы на строительство лягут на плечи обычных потребителей, а электростанции поставят под угрозу здоровье местных жителей (xAI уже столкнулась с такими претензиями) и состояние окружающей среды. А сам ЦОД может привести к дефициту питьевой воды.

22.08.2025 [13:30], Алексей Разин

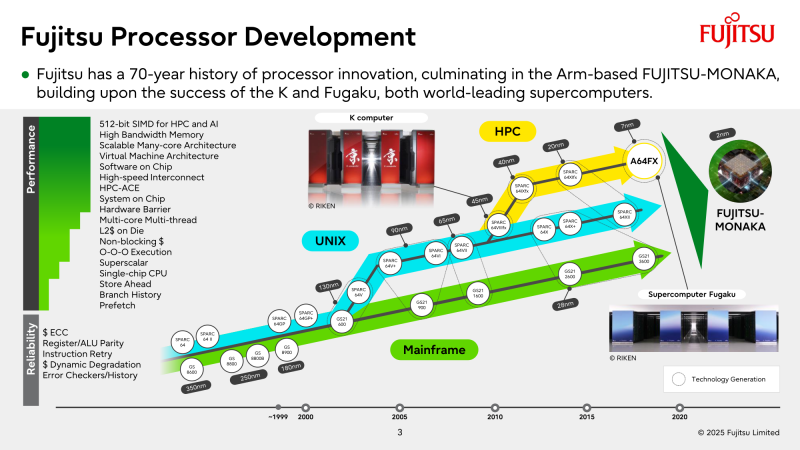

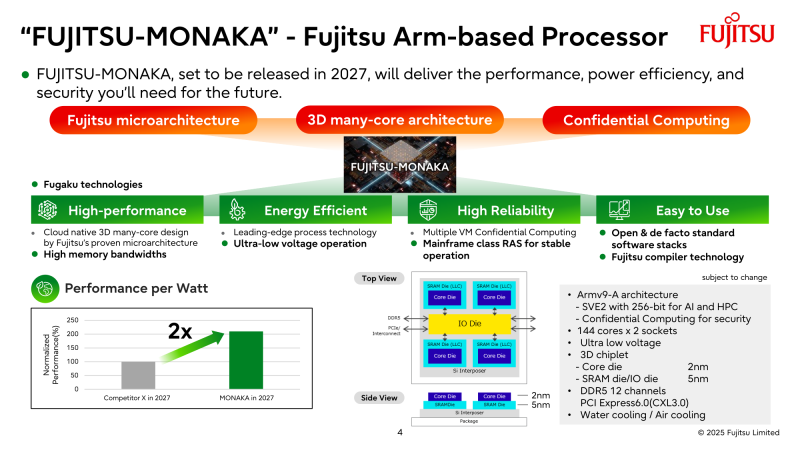

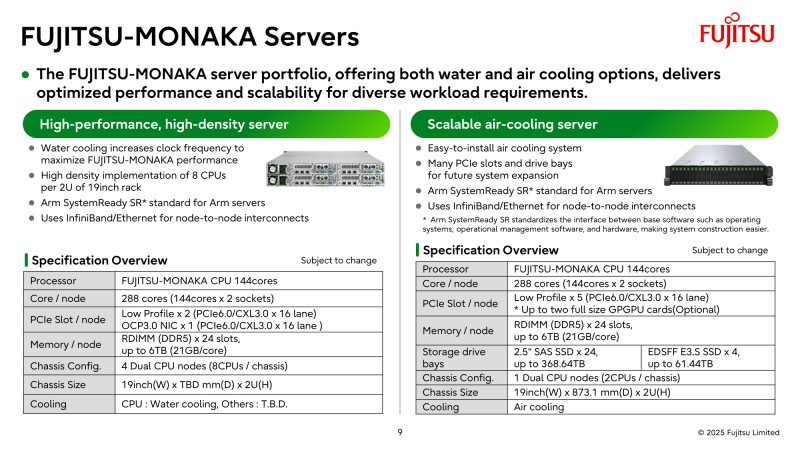

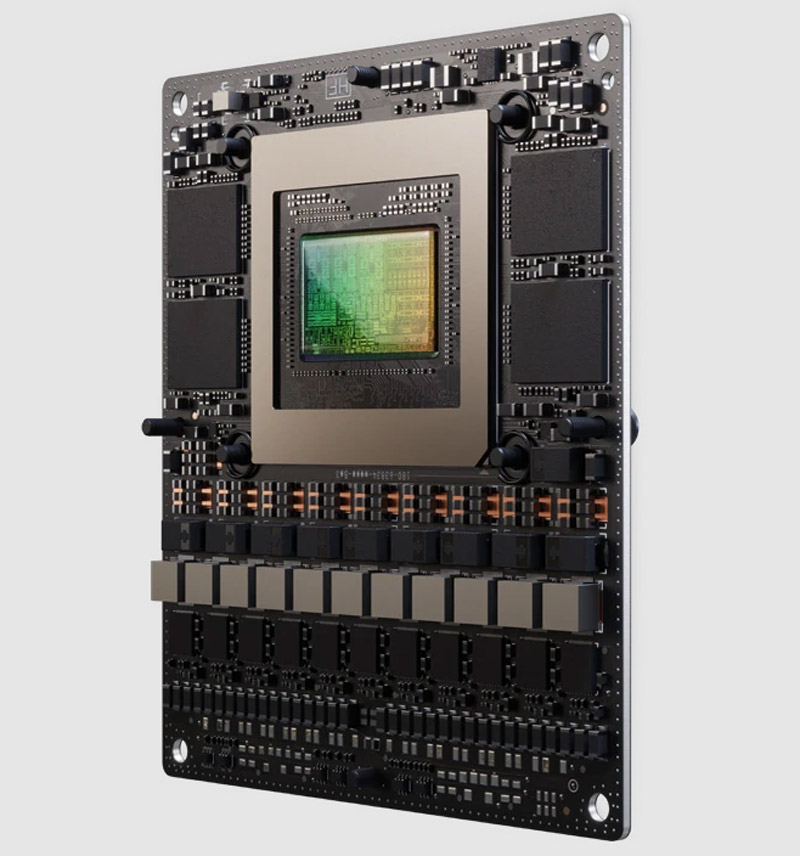

NVIDIA поможет японцам создать один из мощнейших суперкомпьютеров мира FugakuNEXTВ начале этого десятилетия созданный в Японии суперкомпьютер Fugaku пару лет удерживался на верхней строчке в рейтинге мощнейших систем мира TOP500, он и сейчас занимает в нём седьмое место. В попытке технологического реванша японский исследовательский институт RIKEN доверился компании NVIDIA, которая поможет Fujitsu создать суперкомпьютер Fugaku NEXT. Помимо Arm-процессоров Fujitsu MONAKA-X, в основу нового японского суперкомпьютера лягут и ускорители NVIDIA, хотя изначально планировалось обойтись без них. NVIDIA будет принимать непосредственное участие в интеграции своих компонентов в суперкомпьютерную систему, создаваемую японскими партнёрами. По меньшей мере, скоростные интерфейсы, которыми располагает NVIDIA, пригодятся для обеспечения быстрого канала передачи информации между CPU и ускорителями. Сама NVIDIA обтекаемо говорит, что для этого можно задействовать шину NVLink Fusion. С ускорителями AMD, по-видимому, эти процессоры будут общаться более традиционно, т.е. по шине PCIe. Кроме того, NVIDIA собирается применить в составе данной системы передовые типы памяти. Применяемые при создании FugakuNEXT решения, по мнению представителей NVIDIA, смогут стать типовыми для всей отрасли в дальнейшем. Подчёркивается, что будущая платформа станет не просто техническим апгрейдом, а инвестицией в будущее страны. Сама архитектура системы не уточняется, поэтому сложно судить, насколько активно японские разработчики будут использовать ускорители NVIDIA, и к какому поколению они будут относиться. Создатели ставят перед собой амбициозные цели — FugakuNEXT должна стать первой системой «зетта-масштаба». Своего предшественника она должна превзойти более чем в пять раз, обеспечив быстродействие на уровне 600 Эфлопс (FP8). На уровне приложений прирос быстродействия может быть стократным, отмечают создатели. Новый суперкомпьютер сможет применяться для обучения больших языковых моделей. Впрочем, в строй он будет введён лишь к 2030 году, а Fujitsu ещё только предстоит выпустить свои процессоры MONAKA-X для этой системы.

22.08.2025 [11:12], Руслан Авдеев

Meta✴ потратит $10 млрд на ИИ-инфраструктуру в Google CloudMeta✴ намерена потратить более $10 млрд на облачные сервисы Google в течение шести лет, сообщает CNBC со ссылкой на The Information. По словам одного из источников, сделка преимущественно связана с арендой ИИ-инфраструктуры. По данным Reuters, Meta✴ будет использовать серверы Google Cloud, её хранилища данных, сетевые и иные сервисы. Google путается угнаться за более крупными облачными конкурентами вроде AWS и Microsoft Azure. Ранее в этом году она заключила соглашение с OpenAI, которая ранее сильно зависела от Azure, но стала более свободна в выборе облачных партнёров. В июле Alphabet объявила, что подразделение Google Cloud во II квартале принесло $2,83 млрд операционной прибыли за подписки на ПО и инфраструктуру. В то же время выручка в тот же период составила $13,6 млрд, на 32 % больше, чем выручка компании в целом (13,8 %).

Источник изображения: Growtika/unsplash.com В прошлом месяце в отчёте о доходах Meta✴ заявила, что общие расходы в 2025 году составят $114–$118 млрд. Компания активно вкладывает средства ИИ-стартапы, собственные ИИ-модели Llama и иные ИИ-сервисы в своём портфолио услуг. Глава Meta✴ Марк Цукерберг (Mark Zuckerberg) заявил, что компания потратит «сотни миллиардов» долларов на создание огромных ИИ ЦОД. Также компания увеличила минимальную сумму запланированных капитальных затрат на $2 млрд., по итогам года они составят от $66 до $72 млрд. Примечательно, что Google и Meta✴ активно конкурируют на рынке онлайн-рекламы. Тем не менее, Meta✴ нужна буквально вся доступная облачная инфраструктура, до которой она сможет дотянуться, в том числе AWS и Microsoft. Также Meta✴ ищет внешних партнёров для финансирования своих запросов на инфраструктуру для ИИ-проектов. Ранее в этом месяце были раскрыты данные, согласно которым она намерена продать активы своих дата-центров на сумму $2 млрд.

22.08.2025 [10:09], Руслан Авдеев

От офиса до сборочных линий и складов: Advantech вложит $96,5 млн в новый кампус в СШАТайваньская Advantech, занимающаяся выпуском коммерческих и индустриальных вычислительных платформ, направит $96,5 млн на строительство новой штаб-квартиры в Тастине (Tustin, Калифорния) для расширения деловой активности компании в Северной Америке. Завершение строительства запланировано на III квартал 2026 года. Инициатива, как ожидается, поможет довести выручку в регионе до $1,5 млрд и более, сообщает DigiTimes. В новом кампусе компания разместит офисные помещения, сборочные линии, склады, выставочные и конференц-залы. Также там найдётся место для зон постпродажного ремонта. Это часть стратегии Advantech по укреплению локальных возможностей сборки и обслуживания оборудования, а также расширению присутствия на североамериканском рынке, на который в 2024 году приходилось более 38 % мирового рынка промышленных периферийных устройств, оцениваемого в $21,29 млрд. Эксперты ожидают, что сектор продуктов для периферийных вычислений компании Advantech будет расти приблизительно на 13,4 % в год до 2030 года благодаря развитию соответствующего рынка и ИИ-приложений. Компания намерена укреплять взаимодействие с основными клиентами в регионе и расширять сферу применения своих технологий.

Источник изображения: Suyash Mahar/unsplash.com Хотя у компании имеются определённые трудности вроде новых пошлин и «оптимизации складских запасов» клиентами, компания продемонстрировала значительный рост на ключевом для себя рынке: её выручка в Северной Америке в I квартале 2025 года выросла на 23% год к году, а высокие темпы роста (свыше 20 %) сохранялись в течение всего I полугодия. Компания сотрудничает с отраслевыми партнёрами, включая NVIDIA, ADATA и др. для продвижения инновационных ИИ-решений в промышленности. По словам Advantech, искусственный интеллект и периферийные вычисления играют ключевую роль в цифровой трансформации производственной сферы. Компания намерена продемонстрировать практические шаги по внедрению новых решений. Расширение бизнеса и акцент на передовых технологиях отражают стратегию Advantech по поддержанию долгосрочного роста на североамериканском рынке. Некоторые тайваньские компании идут более извилистым путём. Foxconn продала завод по производству электромобилей в США под давлением ряда факторов компании SoftBank, а теперь сама же займётся там в рамках нового партнёрства выпуском ИИ-оборудования для проекта Stargate.

21.08.2025 [10:56], Руслан Авдеев

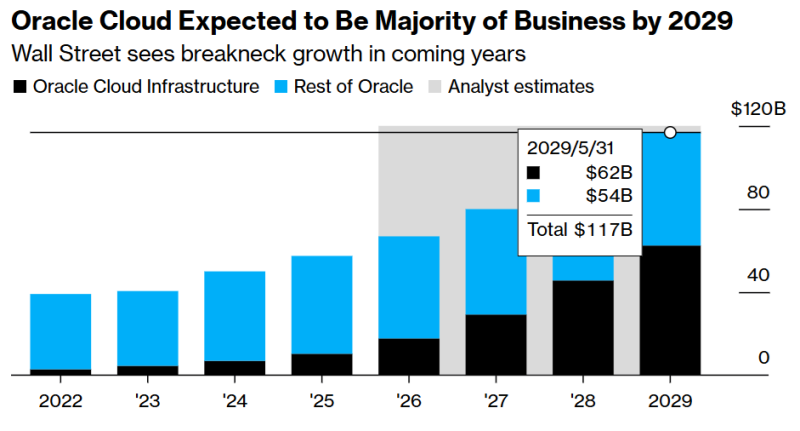

Oracle запитает гигантский ЦОД целиком от газовых генераторов, это будет стоить $1 млрд/годЭксперты Bloomberg проанализировали деятельность Oracle, особо отметив рост компании в сфере облачных вычислений и её стремление к развитию проектов в области ИИ. Подчёркивается, что компания пообещала вложить десятки миллиардов долларов в развитие ЦОД и сопутствующей инфраструктуры, в том числе в генерирующие мощности для их питания сообщает. Oracle уже заключила соглашение о предоставлении OpenAI 4,5 ГВт ЦОД-мощностей. Источник сообщил, что компания намерена тратить более $1 млрд ежегодно на энергоснабжение своего дата-центра посредством газовых генераторов — компания не намерена дожидаться подключения к магистральной энергосети. Речь идёт о техасском дата-центре Frontier мощностью 1,4 ГВт, который строит Vantage Data Centers. Он находится поблизости от Абилина (Abilene), где Crusoe для Oracle и OpenAI возводит 1,2-ГВт дата-центр в рамках проекта Stargate. Crusoe тоже заказала газовые турбины для питания ЦОД. По мнению некоторых экспертов, помимо прямых финансовых затрат, проект ожидают и другие издержки. Например, он может оказать негативное воздействие на окружающую среду. xAI Илона Маска (Elon Musk) уже подверглась критике и судебному преследованию за использование генераторов — её суперкомпьютер стал основным источником загрязнения воздуха в Мемфисе. Amazon, Google, Microsoft, Meta✴ и сама Oracle намерены использовать для энергоснабжения своих объектов атомную энергетику — это тоже сопряжено с определёнными сложностями и рисками.

Источник: Oracle, Bloomberg С финансовой точки зрения огромные инвестиции Oracle привели к первому отрицательному годовому денежному потоку компании впервые с 1990 года. Если инвестиции ИИ в конце концов окажутся очередным финансовым «пузырём» на мировом рынке, речь может идти о многомиллиардных убытках для инвесторов. Согласно расчётам Bloomberg, к 2029 году основной частью бизнеса компании станет облако Oracle Cloud. Oracle делает ставку именно на облачные решения для своих клиентов.

21.08.2025 [10:03], Сергей Карасёв

NVIDIA представила ИИ-платформу Jetson AGX Thor Developer Kit с GPU BlackwellКомпания NVIDIA анонсировала вычислительные модули Jetson T5000 и T4000, а также комплект для разработчиков Jetson AGX Thor Developer Kit. Изделия предназначены для создания роботов, периферийных ИИ-систем, обработки данных от камер и сенсоров и других задач. Решение Jetson T5000 объединяет CPU с 14 вычислительными 64-бит ядрами Arm Neoverse-V3AE с максимальной тактовой частотой 2,6 ГГц, а также 2560-ядерный GPU на архитектуре Blackwell с частотой до 1,57 ГГц (задействованы 96 тензорных ядер пятого поколения). Объём памяти LPDDR5X с пропускной способностью 273 Гбайт/с составляет 128 Гбайт. Заявленная производительность достигает 2070 Тфлопс (FP4—Sparse). Реализована поддержка четырёх интерфейсов 25GbE. В свою очередь, модель Jetson T4000 содержит CPU с 12 ядрами Arm Neoverse-V3AE (до 2,6 ГГц) и 1536-ядерный GPU на архитектуре Blackwell (до 1,57 ГГц; 64 тензорных ядра пятого поколения). Объём памяти LPDDR5X равен 64 Гбайт (273 Гбайт/с). У этого решения быстродействие составляет до 1200 Тфлопс (FP4—Sparse). Упомянуты три интерфейса 25GbE. Обе новинки обеспечивают возможность кодирования видео в многопоточных режимах: 6 × 4Kp60 (H.265), 12 × 4Kp30 (H.265), 24 × 1080p60 (H.265), 50 × 1080p30 (H.265), 48 × 1080p30 (H.264) или 6 × 4Kp60 (H.264). Декодирование возможно в следующих форматах: 4 × 8Kp30 (H.265), 10 × 4Kp60 (H.265), 22 × 4Kp30 (H.265), 46 × 1080p60 (H.265), 92 × 1080p30 (H.265), 82 × 1080p30 (H.264) и 4 × 4Kp60 (H.264). Допускается подключение до 20 камер посредством HSB, до 6 камер через 16 линий MIPI CSI-2 или до 32 камер через виртуальные каналы.  Среди прочего упомянута поддержка восьми линий PCIe 5.0, интерфейсов USB 3.2 (×3) и USB 2.0 (×4), HDMI 2.1 и DisplayPort 1.4a, I2S/2x (×5), DMIS (×2), UART (×4), SPI (×3), I2C (×13), PWM (×6). Габариты модулей составляют 100 × 87 мм. Решение Jetson AGX Thor Developer Kit построено на основе Jetson T5000. Система несёт на борту накопитель M.2 NVMe SSD вместимостью 1 Тбайт и комбинированный адаптер Wi-Fi 6E / Bluetooth (M.2 Key-E). Реализованы порты HDMI 2.0b и DisplayPort 1.4a, 5GbE RJ45 и QSFP28 (4 × 25 GbE), по два разъёма USB 3.2 Type-A и USB 3.1 Type-C. Размеры устройства составляют 243,19 × 112,4 × 56,88 мм. Комплект доступен для заказа по ориентировочной цене $3500.

20.08.2025 [16:15], Руслан Авдеев

Fluidstack арендовала 360 МВт у криптомайнера TeraWulf, который частично принадлежит GoogleКриптомайнинговая компания TeraWulf и провайдер ИИ-облака Fluidstack расширили договор аренды, подписанный буквально на прошлой неделе. На тот момент стороны заключили соглашение, предусматривавшее аренду Fluidstack 200 МВт IT-нагрузки (около 250 МВт общей мощности) в кампусе TeraWulf Lake Mariner в Нью-Йорке, а теперь решили добавить ещё 160 МВт, сообщает Datacenter Dynamics. Благодаря очередному расширению законтрактованная мощность увеличилась до 360 МВт, что соответствует $6,7 млрд выручки с потенциалом увеличения до $16 млрд путём дальнейшего развития бизнеса. Для поддержки расширения Google увеличит вливания до $3,2 млрд, доведя свою долю в TeraWulf приблизительно до 14 %. В настоящее время общая мощность кампуса Lake Mariner, расположенного на месте закрытой угольной электростанции, составляет 500 МВт с возможностью расширения до 750 МВт. Изначально кампус был ориентирован на криптомайнинг, но теперь обслуживает ИИ- и HPC-нагрузки. Так, одним из арендаторов кампуса стала Core42 (G42) из ОАЭ. Сделка позволит Fluidstack развернуть 40 МВт IT-нагрузок в I полугодии 2026 года, а 200 МВт будут развёрнуты к концу 2026 года на объектах CB-3 и CB-4. Оставшиеся 160 МВт будут развёрнуты на объекте CB-5, который должен заработать во II полугодии 2026 года. По словам TeraWulf, расширение подчёркивает масштаб и возможности кампуса. Построив CB-5, компания не только увеличит контрактные мощности для Fluidstack, но и укрепит стратегическое сотрудничество с ключевым финансовым партнёром в лице Google для создания ИИ-инфраструктуры нового поколения. Fluidstack основана в 2017 году в Оксфордском университете. Сегодня компания располагает более 100 тыс. ИИ-ускорителей, в число клиентов входят Mistral AI, Character.AI, Poolside и Black Forest Labs. В 2025 году компания объявила о соглашении с Macquarie Group об обеспечение ИИ-мощностями европейских исследовательских лабораторий, занимающихся ИИ-проектами. Кроме того, сообщалось о сотрудничестве с NVIDIA, Borealis и Dell для создания экзафлопсных ИИ-кластеров в Исландии и Северной Европе. В феврале 2025 года Fluidstack подписала меморандум о взаимопонимании с французским правительством, согласно которому она построит во Франции ИИ-суперкомпьютер мощностью 1 ГВт.

20.08.2025 [14:08], Руслан Авдеев

Amazon, Google и Microsoft призвали США сохранить субсидии на возобновляемые источники энергии ради борьбы с КНР за первенство в сфере ИИ

amazon

google

hardware

microsoft

возобновляемая энергия

гиперскейлер

дефицит

закон

ии

сша

цод

экология

энергетика

Объединение крупных владельцев ЦОД Data Center Coalition, включающее Microsoft, Amazon (AWS), Google, Meta✴, CyrusOne, Stack, CloudHQ, Vantage и др. призвало Министерство финансов США не отменять субсидии на ветряную и солнечную энергетику. По словам представителей коалиции, имеющиеся льготы дают отрасли в США преимущество перед конкурентами из Китая, передаёт Reuters. Как заявляется в письме коалиции главе министерства, любые регуляторные препятствия, замедляющие развёртывание новых генерирующих мощностей, напрямую влияют на способность удовлетворять энергетические потребности ИИ. Администрация Трампа предпринимает активные попытки отменить ряд налоговых льгот, способствующих росту возобновляемой энергетики США. Так, один из основополагающих новых законопроектов предполагает налог в 50 % с ветряных генерирующих мощностей и 30 % с солнечной энергетики, если соответствующие проекты завершены после декабря 2027 года. Во всяком случае, если те не смогут доказать, что в них не использовались китайские комплектующие. Если же строительство объекта «чистой» энергетики начнётся после 2032 года, то размер налоговых кредитов (Clean Electricity Tax Credits) будет автоматически уменьшаться, независимо от того, достигнуты ли общие целевые показатели по сокращению выбросов, установленные законом. В поддержку такого решения президент США заявил, что возобновляемые источники дорого обходятся, нестабильны, зависят от цепочек поставок, контролируемых из-за рубежа, и даже наносят вред окружающей среде и стабильности электросетей. На прошлой неделе Министерство финансов США опубликовало правила, регламентирующие получение налоговых льгот для проектов, связанных с ветряной и солнечной энергетикой. Они, в частности, отменяют налоговый вычет в размере 5 % для любых проектов мощнее 1,5 МВт — это может оказать негативное влияние на уже запланированные инвестиции в отрасль в объёме более $100 млрд в рамках проектов общей мощностью 6 ГВт.

Источник изображения: Laura Ockel/unsplash.com При этом источники возобновляемой энергии, особенно солнечные, в среднем дешевле других альтернатив ископаемому топливу. Опубликованное в 2023 году исследование Energy Innovation показало, что 99 % действующих угольных электростанций США дороже в эксплуатации, чем солнечные или ветряные электростанции. Утверждается, что солнечная энергия минимум на 30 % дешевле. Впрочем, Трамп принимает меры для реанимации угольных ТЭС и других источников на ископаемом топливе. Крупнейшими потребителями возобновляемой энергии в США являются операторы дата-центров, особенно крупные гиперскейлеры. В марте 2025 года сообщалось, что американские технологические бизнесы заключили контракты о поставке в общей сложности 48 ГВт «чистой» энергии (в годовом исчислении). Это на 66,4 % больше год к году. Большинство соответствующих договоров представляют собой соглашения о покупке электроэнергии (PPA), например, на 300 МВт между Meta✴ и Longroad Energy, на 734 МВт — между Google и Leeward Energy, отмечает DataCenter Dynamics. |

|