Материалы по тегу: ии

|

28.08.2025 [12:16], Владимир Мироненко

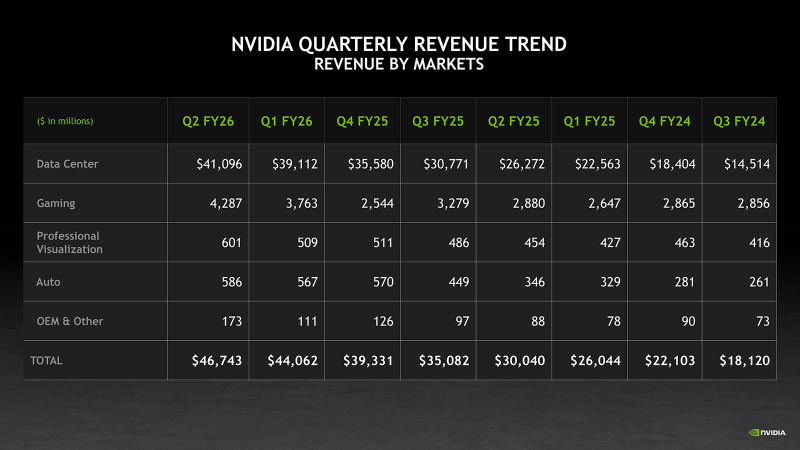

Рекордные продажи NVIDIA не впечатлили инвесторов из-за слабой выручки в сегменте ЦОД и неопределённости с поставками в КитайNVIDIA сообщила финансовые результаты за II квартал 2026 финансового года, завершившийся 27 июля 2025 года. Прибыль и выручка компании превзошли ожидания аналитиков. Также было заявлено, что рост продаж в III квартале сохранится на уровне выше 50 %, что стало для Уолл-стрит сигналом о том, что спрос на ИИ-инфраструктуру не будет снижаться, пишет ресурс CNBC. Выручка составила $46,74 млрд, что на 6 % больше, чем в предыдущем квартале, и на 56 % больше, чем годом ранее, а также больше прогноза аналитиков, опрошенных LSEG, в размере $46,06 млрд. Скорректированная чистая прибыль (Non-GAAP) составила $25,78 млрд или $1,05 на разводнённую акцию, что выше консенсус-прогноза аналитиков, по данным от LSEG, в размере $1,01 на разводнённую акцию. Несмотря на достигнутые результаты, акции компании упали в ходе расширенных торгов на 2,3 %, поскольку выручка от продуктов для ЦОД второй квартал подряд оказалась ниже прогнозов, составив $41,1 млрд (рост год к году на 56 %) при прогнозе StreetAccount в $41,34 млрд. Как полагает ресурс The Guardian, это также свидетельствует о том, что опасения инвесторов по поводу пузыря ИИ и последствий торговых войн Дональда Трампа (Donald Trump) не утихли. Рост выручки NVIDIA год к году превышает 50 % уже девять кварталов подряд, начиная с середины 2023 года, когда начался бум генеративного ИИ. Однако II квартал был отмечен для NVIDIA самым слабым ростом за этот период. NVIDIA также значительно увеличила чистую прибыль по сравнению с прошлым годом — до $26,42 млрд или $1,08 на разводнённую акцию, что на 59 % больше, чем за аналогичный период прошлого года. В сегменте продуктов для ЦОД выручка от поставки решений для вычислений выросла на 50 % год к году до $33,84 млрд, а выручка от продаж сетевого оборудования выросла за квартал на 98 % до $7,25 млрд. Более половины выручки в этом сегменте принесли крупные клиенты. Выручка от решений с архитектурой Blackwell увеличилась год к году на 17 % до $27 млрд. В прошедшем квартале продажи H20 китайским клиентам не осуществлялись. NVIDIA реализовала из ранее зарезервированных запасов H20 на сумму $180 млн клиентам за пределами Китая. Финансовый директор Колетт Кресс (Colette Kress) заявила, что NVIDIA может получить от $2 до $5 млрд выручки от продажи H20 в Китай в течение квартала, если позволит геополитическая обстановка. По её словам, некоторые компании выразили заинтересованность в приобретении H20, и первая группа компаний уже получила лицензии на его покупку. Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) подчеркнул важность для компании китайского рынка, продажи на котором, по его словам, могут составить до $50 млрд в этом году. «Мы обсуждаем с администрацией важность того, чтобы американские компании имели возможность работать на китайском рынке», — сказал Хуанг. Он также заявил, что помимо одобрения продаж H20 в Китае компаниям, не подпадающим под санкции, у NVIDIA есть потенциальная возможность в конечном итоге продавать в этой стране версию ускорителя на архитектуре Blackwell. Напомним, что американским компаниям было разрешено продавать чипы в Китай при условии уплаты 15 % экспортной пошлины в госбюджет. Предложенную правительством схему юристы назвали неконституционным злоупотреблением властью. Колетт Кресс дала понять, что отсутствие поставок в Китай в минувшем квартале был вызвано неопределённостью этой схемы, которая официально не закреплена в федеральном законодательстве. «Хотя некоторые наши китайские клиенты получили лицензии за последние несколько недель, — сказала Кресс, — мы не отгружали ни одного ускорителя H20 по этим лицензиям». Что касается других направлений деятельности NVIDIA, то выручка от игрового бизнеса в отчётном квартале выросла на 49 % по сравнению с прошлым годом до $4,29 млрд. Автомобильное и робототехническое подразделение компании увеличило продажи год к году на 69 % до $586 млн. В сегменте профессиональной визуализации продажи выросли на 32 % до $601 млн. NVIDIA прогнозирует выручку в текущем квартале в размере $54 млрд ± 2 %. Компания уточнила, что её прогноз не учитывает поставки H20 в Китай. По данным LSEG, аналитики ожидают выручку в финансовом III квартале в размере $53,1 млрд. Хуанг заявил, что компания ожидает, что к концу десятилетия расходы на ИИ-инфраструктуру составят от $3 до $4 трлн, пишет TechCrunch.

28.08.2025 [09:28], Владимир Мироненко

ASUS Cloud увеличит вычислительные мощности Тайваня на 50 %, построив 250-Пфлопс ИИ-суперкомпьютерASUS Cloud в партнёрстве с Taiwan AI Cloud (Taiwan Web Service Corp) и Национальным центром высокопроизводительных вычислений Тайваня (National Center for High-performance Computing, NCHC) в Тайнане (Тайвань) построит суперкомпьютер на ускорителях NVIDIA. Об этом сообщил гендиректор ASUS Cloud и Taiwan AI Cloud Питер Ву (Peter Wu, на фото ниже) в интервью газете South China Morning Post (SCMP). Питер Ву рассказал, что суперкомпьютер с начальной производительностью 80 Пфлопс (точность не уточняется) будет работать на 1700 ускорителях NVIDIA H200. Его запуск запланирован на декабрь, а со временем производительность новой системы вырастет до 250 Пфлопс. Ранее сообщалось, что NVIDIA также поставит два суперускорителя GB200 NVL72 и узлы HGX B300 для данной машины. По словам Ву, после запуска суперкомпьютера общая вычислительную мощность HPC-систем Тайваня вырастет минимум на 50 %. В феврале 2025 года Национальный совет по науке и технологиям Тайваня (NSTC) объявил о планах по увеличению общей вычислительной мощности систем страны примерно до 1200 Пфлопс к 2029 году с имеющихся 160 Пфлопс. Как отметил DataCenter Dynamics, ASUS ранее сотрудничала с NVIDIA в развёртывании суперкомпьютеров на Тайване, включая 9-Плфопс машину Taiwania 2. В 2022 году ASUS и NVIDIA построили на Тайване суперкомпьютер для медицинских исследований. Taiwan AI Cloud уже реализовала аналогичные нынешнему проекты по созданию ИИ-инфраструктуры в других странах. Среди них — ЦОД в Сингапуре, а также объект во Вьетнаме с 200 ускорителями NVIDIA, который строят для государственного оператора Viettel. Этот проект стартовал в начале 2025 года после того, как правительство США одобрило поставку чипов NVIDIA. Ву отметил рост популярности агентного ИИ. Министерство цифровых технологий острова (MODA) «рекомендовало нам предоставить открытую архитектуру с фреймворком агентного ИИ», чтобы помочь местным компаниям использовать или модернизировать свои существующие приложения, сказал он. Говоря о материковом Китае, Питер Ву заявил, что компании будет «непросто» реализовывать там аналогичные проекты «из-за ситуации с поставками GPU». Китайский подход, заключающийся в «стекировании и кластеризации» малопроизводительных чипов для достижения производительности, аналогичной системам с передовыми ИИ-ускорителями, может быть осуществим с точки зрения инференса. Ву отметил, что запуск DeepSeek «рассуждающей» модели R1 в январе спровоцировал рост спроса на инференс, поскольку эта модель превосходно справляется с такими задачами. «Если рабочая нагрузка аналогична [инференсу], будет легче внедрить альтернативную технологическую схему с существующими [чипами]», — сказал Ву, добавив, что разработчики «могут столкнуться с проблемами в выборе GPU», если проект предполагает обучение или тонкую настройку ИИ-систем. Говоря о будущем, Ву сообщил, что ожидает дальнейшего развития трёх сегментов ИИ в будущем: вычислительной геномики, квантовых вычислений и так называемых цифровых двойников. «Приложение-убийца [для цифровых двойников] может появиться в сфере ухода за пожилыми людьми, помогая им получать лекарства, еду или принимать душ», — прогнозирует Ву.

27.08.2025 [16:50], Руслан Авдеев

Дональд Трамп заявил, что ИИ ЦОД Meta✴ в Луизиане будет стоить $50 млрд, а не $10 млрдПрезидент США Дональд Трамп (Donald Trump) заявил, что Meta✴ Platforms намерена постратить $50 млрд на строительство своего гигантского дата-центра Hyperion в сельской местности Луизианы (США). По словам Трампа, он буквально «в восторге» от стоимости проекта, сообщает Bloomberg. В Meta✴ отказались комментировать высказывания Трампа. IT-гигант, готовый потратить сотни миллиардов долларов на попытки стать ключевым игроком в гонке ИИ-проектов, ранее сообщал только то, что инвестиции превысят $10 млрд. По словам Трампа, американские компании теперь могут строить крупные дата-центры только потому, что власти позволяют им строить собственные мощности для генерации электричества. Кампус Hyperion будет запитан от новой электростанции Entergy на природном газе. От неё до окрестностей ЦОД протянут отдельную ЛЭП, которая сама по себе обойдётся в $1,2 млрд.

Источник изображения: Kool C/unsplash.com Ранее в августе сообщалось, что Meta✴ выбрала Pacific Investment Management и Blue Owl Capital, чтобы те возглавили раунд финансирования на $29 млрд для развития кампуса в Луизиане. На сегодня это крупнейшее финансовое вливание, связанное с конкретным дата-центром — с большим отрывом от других проектов. Как сообщает Reuters, в июне 2025 года объединила все свои исследовательские группы по искусственному интеллекту в новое подразделение — Superintelligence Labs. Это стратегическое решение было реакцией на две ключевые проблемы: уход ведущих специалистов и довольно прохладный приём, который получила её последняя открытая модель Llama 4.

27.08.2025 [15:17], Руслан Авдеев

Малайзия анонсировала первый собственный ИИ-ускоритель SkyeChip MARS1000Малайзия анонсировала собственный 7-нм ИИ-ускоритель SkyeChip MARS1000, сообщает Bloomberg. Новый чип — первый в стране ускоритель для периферийных ИИ-вычислений. По данным Ассоциации полупроводниковой промышленности Малайзии (Malaysia Semiconductor Industry Association) этот компонент будет применяться в самых разных устройствах от автомобилей до роботов. Чип для периферийных ИИ-вычислений намного слабее, чем передовые решения компаний вроде NVIDIA, которые стоят за работой ИИ ЦОД, обучением больших ИИ-моделей и др. Тем не менее это ключевой шаг на пути создания передовых технологий в соответствующей сфере. Пока нет данных, где именно будет производиться ускоритель. Малайзия давно стремится стать более значимым игроком в мировой цепочке поставок полупроводников, получая выгоду от бума ИИ. Страна уже давно стала ключевым игроком в области упаковки чипов и является производственным хабом для множества поставщиков IT-оборудования. Местные власти поставили долговременную задачу по развитию разработки микросхем, производства полупроводниковых пластин и строительству дата-центров. Правительство обязалось потратить на рост значимости Малайзии в глобальной цепочке «создания стоимости» не менее RM25 млрд ($6 млрд). Попутно Малайзия стремится стать региональным IT-хабом на фоне дефицита мощностей и площадей в соседнем Сингапуре. Правда, усилия осложняются позицией руководства США, которое предложило ограничить поставки ИИ-полупроводников в Малайзию и Таиланд, подозревая, что контрабандисты будут использовать эти страны как перевалочные базы для перепродажи ИИ-ускорителей в государства, находящиеся под западными санкциями — в первую очередь, в Китай. Недавно Малайзия приняла меры по ужесточению реэкспорта ИИ-ускорителей, в которых применяются американские технологии. Власти заявили, что «не потерпят» использования своего государства для незаконной (с точки зрения США) торговли. Не так давно они уже объявляли, что китайская Huawei якобы обеспечит создание суверенной ИИ-инфраструктуры в стране, но вскоре новость была опровергнута на высшем уровне, по мнению экспертов — под давлением Соединённых Штатов.

27.08.2025 [13:31], Руслан Авдеев

Humain начала строительство двух ИИ ЦОД в Саудовской АравииИИ-стартап Humain, за которым стоит правительство Саудовской Аравии, начал строительство своих двух первых дата-центров в стране. Ускорители и другое оборудование будет закупаться в США, сообщает Bloomberg. Один ЦОД будет расположен Эр-Рияде (Riyadh), второй — в восточной провинции Даммам (Dammam). Первая очередь — по 100 МВт на каждый кампус — заработает в 2026 году. Фонд Humain Ventures на $10 млрд заработал этим летом и уже начал выделять инвестиции. Пока Humain находится в процессе закупки полупроводников у американских производителей, включая NVIDIA. Саудовская компания получила одобрение регуляторов США на покупку 18 тыс. новейших ускорителей NVIDIA (по некоторым данным — GB300). Помимо этих ускорителей, вопрос с которыми уже практически решён, речь идёт о ещё «сотнях тысяч». Компания также заключила сделку с AWS на $5 млрд для создания кластера AI Zone, а также сделку с AMD по созданию ИИ-инфраструктуры на 500 МВт. Глава компании Тарэк Амин (Tareq Amin) в ходе мероприятия, посвящённого запуску чат-бота Humain, отметил, что успех этих планов зависит от соблюдения правил управления, протоколов и одобрения правительства США — формальности, через которые Humain намерена пройти в ближайшее время.

Источник изображения: Matteo Di Iorio/unsplash.com Хотя Амин отказался назвать точные сроки реализации планов компании, его комментарии свидетельствуют, что Саудовская Аравия активно добивается импорта ИИ-чипов. Визит президента США Дональда Трампа (Donald Trump) в мае 2025 года в Эр-Рияд в рамках первого крупного зарубежного турне второго срока стал ключевым событием, открывшим королевству расширенный доступ к передовым полупроводникам от компаний вроде NVIDIA и AMD. Humain принадлежит саудовскому суверенному фонду благосостояния и основана лишь в мае 2025 года. Местные власти рассчитывают превратить страну в региональную ИИ-сверхдержаву, строя в регионе дата-центры, ИИ-инфраструктуру и облачные мощности. Humain намерена добавить к 2030 году ЦОД общей мощностью 1,9 ГВт, а в течение 10 лет — 6,6 ГВт, сообщает Datacenter Dynamics. Компания уже имеет партнёрские связи с калифорнийской Groq для обеспечения работы чат-бота Humain Chat и прочей ИИ-инфраструктуры. Humain Chat пока доступен только в Саудовской Аравии, но в октябре должен заработать и в других странах Ближнего Востока. Саудовская компания также является партнёром AMD, совместное предприятие является частью подписанной ранее сделки на $10 млрд. В рамках партнёрства AMD, вероятно, получит долю в специальном инвестиционном фонде, создаваемом в Саудовской Аравии. Humain заключила меморандум о взаимопонимании с Qualcomm, на ранней стадии находятся переговоры со стартапом xAI о возможном строительстве ЦОД в Саудовской Аравии.

26.08.2025 [22:13], Руслан Авдеев

IBM и AMD займутся разработкой новых вычислительных архитектур на стыке квантовых и классических подходовAMD и IBM анонсировали разработку нового поколения вычислительных архитектур, в основе которых лежат квантовые компьютеры и HPC-системы. Речь идёт о т.н. «квантово-центричных супервычислениях», сообщает пресс-служба AMD. Команды намерены продемонстрировать первые результаты до конца текущего года. Компании сотрудничают над разработкой масштабируемых, open source платформ, способствующих переосмыслению будущего вычислений с использованием лидерства IBM в сфере квантовых компьютеров и ПО для них, а также ведущей роли AMD в сфере HPC и ИИ-ускорителей. По словам главы IBM Арвинда Кришны (Arvind Krishna), квантовые вычисления со временем позволят «симулировать» реальный мир и представлять информацию принципиально новым способом. Комбинация технологий IBM и AMD позволят построить мощную гибридную модель, оставляющую позади традиционные вычисления. В новой архитектуре квантовые компьютеры будут работать в тандеме с HPC-кластерами и ИИ-инфраструктурой с использованием CPU, ИИ-ускорителей и прочих вычислительных модулей. При таком гибридном подходе различные части задачи решаются оптимальным для них типом оборудования. Например, в будущем квантовые компьютеры смогут моделировать поведение атомов и молекул, а классические ИИ-суперкомпьютеры — анализировать большие массивы данных. Вместе эти технологии смогут решать реальные задачи в беспрецедентном масштабе и с беспрецедентной скоростью, говорят компании.

Источник изображения: Yue WU/unsplash.com Компании изучают способы интеграции CPU, FPGA и ИИ-ускорителей AMD с квантовыми компьютерами IBM для совместного ускорения выполнения принципиально новых алгоритмов. Ключевым планом сотрудничества является разработка систем коррекции ошибок, что является важнейшим шагом на пути к созданию отказоустойчивых квантовых компьютеров, которые IBM планирует выпустить к 2030 году. Также компании планируют изучить, как именно open source решения вроде Qiskit могли бы выступить катализаторами развития и внедрения новых алгоритмов, использующих квантово-центричные супервычисления. IBM уже начала работать в направлении интеграции квантовых и традиционных систем. Недавно она заключила соглашение с японским НИИ RIKEN о подключении своего модульного квантового компьютера IBM Quantum System Two к одному из самых быстрых суперкомпьютеров мира Fugaku. Суперкомпьютеры Frontier в Ок-Риджской национальной лаборатории (ORNL) и El Capitan в Ливерморской национальной лаборатории (LLNL) полагаются на CPU и ускорители AMD. Другими словами, на чипах AMD работают два из быстрейших суперкомпьютеров из мирового рейтинга TOP500.

26.08.2025 [13:47], Руслан Авдеев

Crusoe расширит ИИ-мощности в исландском ЦОД atNorth ICE02Crusoe Energy и atNorth объявили о расширении мощностей Crusoe Cloud на 24 МВт в ЦОД ICE02 в Исландии. Дата-центр принадлежит atNorth и работает на «чистой» энергии. Новый проект должен удовлетворить растущий спрос на услуги Crusoe Cloud в Европе и Северной Америке, сообщает пресс-служба Crusoe. Для поддержки новой инициативы Crusoe получила от инвестиционной группы Victory Park Capital (VPC) кредитную линию на $175 млн. Расширение предусматривает использование современных решений NVIDIA, в том числе GB200 NVL72, а также внедрение СЖО. Дата-центр atNorth ICE02 на 100 % снабжается геотермальной энергией и энергией ГЭС. По словам Crusoe, расширения мощностей позволит ускорить удовлетворение «невероятного» спроса на Crusoe Cloud. atNorth сообщает, что в компании рады успехам Crusoe, достигнутым в обслуживании клиентов с использованием её исландского ЦОД. Расширение ICE02 — ключевой этап стратегии развития Crusoe в Европе, реализация которой стартовала в декабре 2023 года. Площадка предлагает доступ к телеком-сетям с низкими задержками и подключение по нескольким подводным кабелям — доступ к ресурсам получат не только европейские клиенты, но и компании из Северной Америки. Расширение регионального присутствия компании также включает и ввод в эксплуатацию недавно анонсированного ЦОД в Норвегии.

Источник изображения: Crusoe Crusoe Cloud представляет собой масштабируемую платформу для выполнения ИИ-задач нового поколения. Crusoe Cloud считается экономичным решением, позволяющим разработчикам и иным IT-специалистам сосредоточиться на инновациях, не уделяя лишнего внимания инфраструктуре. В марте сообщалось, что Crusoe окончательно избавилась от криптобизнеса для концентрации усилий на ИИ-проектах. Тогда же компания привлекла $225 млн на закупку чипов NVIDIA для развития облачной ИИ-инфраструктуры. Компания является одним из ключевых подрядчиков проекта OpenAI Stargate, но попутно развивает и собственное ИИ-облако.

25.08.2025 [18:15], Руслан Авдеев

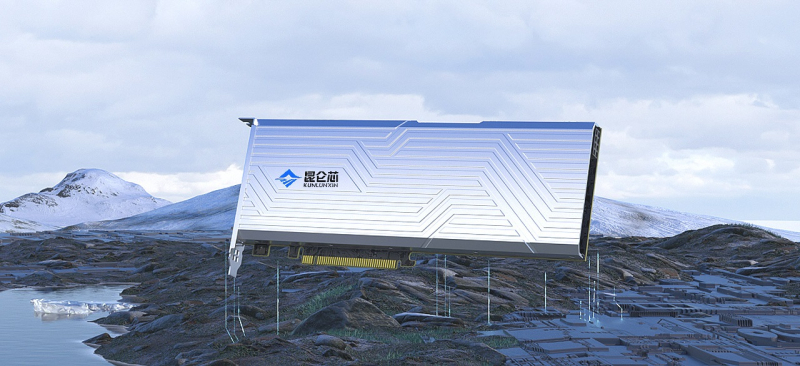

China Mobile заказала CUDA-совместимые ИИ-ускорители Kunlunxin на сумму более ¥1 млрдKunlunxin, «дочка» китайского IT-гиганта Baidu, получила от China Mobile заказ на ИИ-ускорители, совместимые с программной экосистемой NVIDIA CUDA, на сумму более ¥1 млрд ($140 млн), сообщает передаёт Reuters. Чипы достанутся поставщикам China Mobile, включая H3C и ZTE. Кроме того, компания закупит ускорители у Huawei. Заключение контракта — часть более широкой стратегии Китая по обретению технологического суверенитета в ИИ-секторе. В апреле Baidu успешно развернула кластер и 30 тыс. чипов собственной разработки — ИИ-ускорителей третьего поколения P800 Kunlun, способных обучать модели уровня DeepSeek. Технологический прогресс подчеркивает потенциал китайских разработок и позиционирует Baidu и Kunlunxin как ключевых игроков на рынке ИИ-ускорителей. Успех Kunlunxin и других китайских бизнесов может иметь важные последствия для мировой индустрии ИИ-ускорителей, в которой пока доминирует NVIDIA. По мере прогресса китайских технологий, позиции NVIDIA могут оказаться под вопросом, особенно в Поднебесной и на других рынках. Развитие технологий происходит на фоне технологического соперничества между США и Китаем. Практически сразу после послаблений США на поставки H20 Китай развернул активную кампанию против этих чипов, поэтому NVIDIA затормозила выпуск H20 и готовит для местного рынка другой, более мощный ускоритель. Глава NVIDIA Дженсен Хуанг (Jensen Huang) критиковал запреты на экспорт ИИ-полупроводников в Китай, подчёркивая, что из-за этого прогресс собственных технологий в КНР только ускорится.

24.08.2025 [23:18], Сергей Карасёв

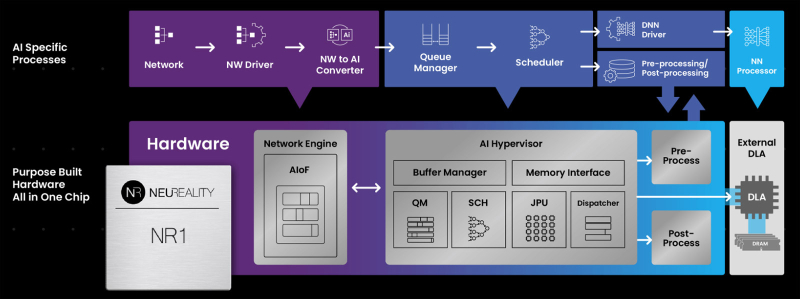

NeuReality готовит чип NR2 для оркестрации инференсаКомпания NeuReality раскрыла предварительную информацию об изделии NR2 — чипе второго поколения, предназначенном специально для оркестрации инференса. Изделие представляет собой более эффективную альтернативу связке CPU и NIC в высокопроизводительных системах ИИ. Чип первого поколения NR1 дебютировал в июне нынешнего года. Изделие может применяться в связке с любым GPU или ИИ-ускорителем. При этом, как утверждается, NR1 позволяет повысить эффективность использования GPU почти до 100 % по сравнению со средним показателем в 30–50 % при традиционном сочетании CPU и NIC в современных серверах. В состав NR1 входят четыре декодера видео/изображений, 16 DSP для аудио/речи, 16 векторных DSP общего назначения, два порта 10/25/50/100GbE и пр. Характеристики NR2 на данный момент полностью не раскрываются. Известно, что в основу решения положена платформа Arm Neoverse Compute Subsystems (CSS) V3. Чип может объединять до 128 ядер, оптимизированных для масштабных рабочих нагрузок обучения моделей ИИ и инференса. По сравнению с оригинальной версией в NR2 реализована более глубокая интеграция между CPU-блоком и NIC для координации ИИ-моделей в реальном времени, дезагрегации на основе микросервисов, потоковой передачи токенов, оптимизации KV-кеша и оркестровки. В целом, как отмечает NeuReality, чипы серии NR представляют собой качественно новый класс изделий, способных управлять рабочими нагрузками инференса с непревзойдённой эффективностью. Гипервизор ИИ в сочетании с ядрами Arm Neoverse обеспечивает оптимальную оркестровку и максимальную загрузку доступных ресурсов.

22.08.2025 [22:44], Владимир Мироненко

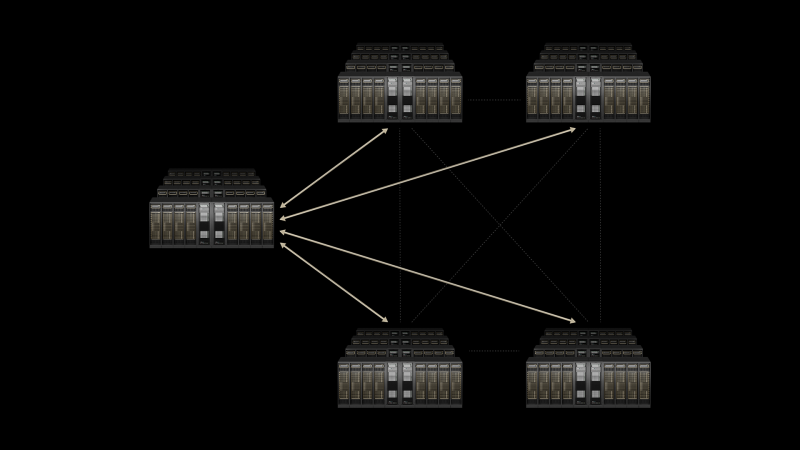

Связанные одной целью: NVIDIA Spectrum-XGS Ethernet объединит несколько ЦОД в одну ИИ-суперфабрикуNVIDIA анонсировала Spectrum-XGS Ethernet, масштабируемую технологию для объединения распределённых ЦОД в унифицированные гигантские ИИ-фабрики. Похожее решения не так давно предложила и Broadcom, анонсировав коммутаторы Jericho4. На фоне роста спроса на обработку ИИ-нагрузок отдельные ЦОД достигают пределов допустимой мощности, но выход за пределы одного объекта связан с трудностями из-за ограничений существующей сетевой инфраструктуры с высокой задержкой, джиттером и непрогнозируемой производительностью. NVIDIA позиционирует Spectrum-XGS Ethernet как революционное дополнение к платформе NVIDIA Spectrum-X Ethernet, которое устраняет эти ограничения. Решение служит третьим столпом ИИ-вычислений, выходящим за рамки вертикального и горизонтального масштабирования, и предназначено для повышения производительности и масштабируемости Spectrum-X Ethernet для объединения нескольких распределённых ЦОД в массивы ИИ-фабрик, способных обрабатывать ИИ-нагрузки в гигантских масштабах. «Индустриальная революция в области ИИ уже началась, и гигантские ИИ-фабрики являются важнейшей инфраструктурой, — заявил генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) — С помощью NVIDIA Spectrum-XGS Ethernet мы расширяем возможности по масштабированию, объединяя ЦОД в городах, странах и континентах в огромные ИИ-суперфабрики». Spectrum-XGS Ethernet дополняет платформу Spectrum-X алгоритмами, которые динамически адаптируют сеть с учётом расстояния между объектами ЦОД. Решение опирается на усовершенствованный автоматический контроль перегрузки, точное управление задержками и сквозную телеметрию. По словам NVIDIA, Spectrum-XGS Ethernet практически удваивает производительность работы библиотеки коллективных коммуникаций NVIDIA NCCL, ускоряя взаимодействие множества ускорителей и множества узлов и обеспечивая предсказуемую производительность в географически распределённых ИИ-кластерах. В результате несколько ЦОД будут работать как единая ИИ-фабрика, полностью оптимизированная для подключения на больших расстояниях. CoreWeave одной из первых внедрит Spectrum-XGS Ethernet в свои ЦОД. Сама NVIDIA не новичок в распределённых ИИ-вычислениях — её собственные кластеры для внутренних нужд размещались в нескольких дата-центрах США. |

|