Материалы по тегу: ии

|

10.10.2025 [15:25], Владимир Мироненко

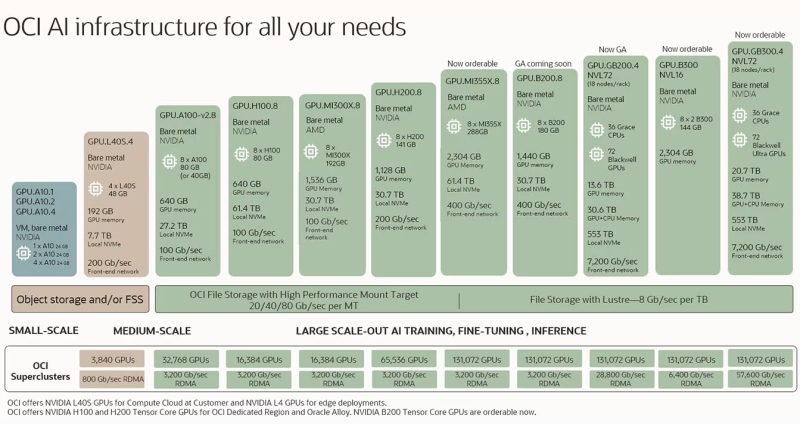

Бизнес Oracle по сдаче в аренду ИИ-мощностей оказался не таким прибыльным, как ожидалосьБизнес Oracle по сдаче в аренду ИИ-серверов оказался гораздо менее прибыльным, чем ранее прогнозировали фондовые аналитики, сообщил ресурс The Information после ознакомления со внутренними документами компании, о чём пишет DataCenter Dynamics. Средняя валовая рентабельность Oracle по сделкам с такими компаниями, как OpenAI, составила всего лишь 16 %, хотя выручка за последний год утроилась. Что касается новейших ускорителей NVIDIA, то компания терпит убытки, составившие почти $100 млн от сдачи в аренду чипов Blackwell за I квартал 2026 финансового года, закончившийся в августе. По данным The Information, за последний квартал Oracle выручила $900 млн от сдачи в аренду ИИ-серверов, получив валовую прибыль в размере $125 млн, или 14 центов на каждый доллар продаж. Компания не раскрывает финансовые показатели по использованию ИИ-серверов. На рентабельность влияют различные факторы, включая зарплату, стоимость электроэнергии и другие эксплуатационные расходы ЦОД Oracle, а также амортизационные расходы на оборудование. Кроме того, существует разрыв во времени между покупкой чипов и началом их использования клиентами. Oracle сообщила, что на конец I квартала 2026 финансового года благодаря подписанию многомиллиардных контрактов с тремя клиентами объём оставшихся обязательств по контрактам (RPO) составил более $455 млн. Позже выяснилось, что был заключён контракт с OpenAI на $300 млрд. Аналитики полагают, что для финансирования этой сделки Oracle может потребоваться привлечь до $100 млрд заёмных средств в течение следующих четырёх лет для наращивания мощностей. В прошлом месяце Oracle продала серию облигаций инвестиционного уровня на сумму $18 млрд для расширения бизнеса и строительства ИИ-инфраструктуры. Следует отметить, что речь идёт лишь о части бизнес-предложения Oracle. Как полагает The Information, если доля аренды ИИ-серверов в общем объёме бизнеса Oracle продолжит расти, общая валовая рентабельность снизится с нынешних 70 %. Ресурс предупредил, что это затронет всех основных провайдеров облачных услуг, поскольку ИИ-серверы на чипах NVIDIA значительно дороже традиционных серверов и их использование требует дополнительных расходов, в том числе на специализированное сетевое оборудование и электроэнергию. Чтобы привлечь клиентов, поставщики облачных услуг предлагают скидки, что также отражается на прибыльности бизнеса. The Information назвал такую ситуацию плохой новостью для Oracle, но не все эксперты разделяют это мнение. По мнению ряда аналитиков, рентабельность вполне соответствует ожиданиям. Например, согласно отчёту Investor's Business Daily, аналитик Stifel Брэд Рибак (Brad Reback) ранее прогнозировал валовую рентабельность облачного бизнеса Oracle примерно в 16 %. Он также указал в аналитической записке для инвесторов, что «по мере масштабирования этого сегмента OCI валовая рентабельность должна существенно вырасти». Аналитик Guggenheim Джон ДиФуччи (John DiFucci) тоже считает, что вышеупомянутый разрыв между вводом мощностей в эксплуатацию и оплатой клиентами не следует воспринимать как дурное предзнаменование. «Мы не удивимся, если увидим более низкую валовую рентабельность в начале сделки по обучению ИИ до начала получения дохода, но мы считаем разумным ожидать, что любая сделка будет обеспечивать не менее 25 % валовой рентабельности в течение всего срока её действия — иначе Oracle её не подпишет», — заявил ДиФуччи. Следует также учесть мнение NVIDIA по этому поводу, генеральный директор которой Дженсен Хуанг (Jensen Huang) отверг критику финансового положения Oracle, заявив, что компания «будет невероятно успешна». «Когда вы только начинаете внедрять новую технологию, вполне вероятно, что поначалу вы можете не заработать, но со временем система станет невероятно прибыльной», — сказал Хуанг.

10.10.2025 [14:50], Руслан Авдеев

Не для себя стараемся: Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72Microsoft представила первый в мире ИИ-кластер, использующий более 4,6 тыс. NVIDIA Blackwell Ultra в составе суперускорителей NVIDIA GB300 NVL72, объединённых интерконнектом Quantum-X800 InfiniBand. Этот кластер — лишь первый из многих. Компания развернёт сотни тысяч ускорителей Blackwell Ultra в ИИ ЦОД по всему миру. Благодаря им Microsoft намерена стать первой, поддерживающей обучение для моделей с сотнями триллионов параметров. Как сообщают в Microsoft, запуск в Microsoft Azure суперкластера NVIDIA GB300 NVL72 стал важным шагом в развитии передовых ИИ-технологий. Разработанная совместно с NVIDIA система представляет собой первый в мире масштабируемый ИИ-кластер на основе GB300, обеспечивающий вычислительные мощности, необходимые OpenAI для обслуживания моделей с триллионами параметров. Речь идёт о новом стандарте ускоренных вычислений, говорят компании. Новые инстансы Azure ND GB300 v6 оптимизированы для рассуждающих моделей, агентных систем и мультимодального генеративного ИИ. Каждая стойка GB300 NVL72 обслуживает 18 виртуальных машин, а сам суперускоритель с производительностью до 1,44 Эфлопс (FP4 Tensor Core) включает:

Источник изображения: Microsoft Создание передовой инфраструктуры требует переосмысления всех уровней системы, включая вычисления, память, системы охлаждения и питания, ЦОД в целом как единой структуры. Новая архитектура стоек обеспечивает высокую пропускную способность инференса при меньших задержках на крупных моделях, это позволяет агентным и мультимодальным ИИ-системам быть более масштабируемыми и эффективными, чем когда-либо, говорит компания. Для масштабирования за пределы стойки используется NVIDIA Quantum-X800 InfiniBand, что гарантирует обучения сверхбольших моделей с применением десятков тысяч ИИ-ускорителей с минимальными накладными расходами на их синхронизацию, что дополнительно повышает производительность.

Источник изображения: Microsoft Передовые системы охлаждения Azure используют автономные теплообменники, чтобы свести к минимуму расход воды и поддерживать температурную стабильность для высокоплотных кластеров. Также продолжается разработка и внедрение новых моделей распределения питания, обеспечивающих высокую энергетическую плотность и динамический баланс нагрузок. Дополнительную помощь в оптимизации работы оказывает и модернизированное программное обеспечение. Ранее Microsoft обладала эксклюзивными правами на предоставление облачных сервисов компании OpenAI, но в январе 2025 года появилась новость, что ИИ-стартапу разрешили пользоваться и облаками других провайдеров, если у Microsoft не хватит собственных мощностей. Разногласия между компаниями продолжают нарастать. Формально первенство по создание кластера на базе GB300 NVL72 принадлежит CoreWeave, имеющей тесные отношения с NVIDIA и обслуживающей OpenAI — как напрямую, так и при посредничестве Microsoft.

10.10.2025 [14:07], Руслан Авдеев

Dell удвоила прогноз выручки из-за высокого проса на ИИ-решенияСогласно последним прогнозам Dell, рост годовой выручки компании составит 7–9 %, что почти вдвое прошлого прогноза на уровне 3-4 %. Это связано с тем, что спрос на ИИ-решения превзошёл все ожидания, сообщает eWeek. Прибыль на акцию составит 15 % или более, что тоже вдвое превышает предыдущий целевой показатель в 8 %. Глава компании Майкл Делл (Michael Dell) назвал возможности ИИ «огромными», поскольку клиенты борются за доступ к ИИ-вычислениям и сетевой инфраструктуре для масштабного развёртывания ИИ-проектов. Бизнес Dell по производству ИИ-серверов в некоторой степени стал напоминать «машину для печатания денег», цели компании в этой сфере растут квартал за кварталом. Она уже увеличила годовой прогноз поставок ИИ-серверов ещё на $5 млрд, доведя его до $20 млрд. По данным Nasdaq, только за II квартал компания поставила таких серверов на $8,2 млрд. По информации Futurum Group, обнародованным в сентябре, дополнительный портфель заказов на год составил $11,7 млрд, а поставки ИИ-решений за I полугодие уже превысили общие показатели за прошлый год. Отложенный спрос фактически конвертируется в многочисленные заказы, что станет драйвером многолетнего цикла поставок.

Источник изображения: Dell В настоящее время Dell позиционирует себя как «тяжеловес» на рынке ИИ-инфраструктуры. Согласно последним данным, приведённым подразделением Infrastructure Solutions Group два месяца назад, отмечен рост выручки на 44 % в годовом исчислении — до $16,8 млрд. Львиная доля — $12,9 млрд приходится на серверы и сетевое оборудование. Меняется и положение акционеров. Dell обязалась ежегодно увеличивать дивиденды на 10 % и более до 2030 финансового года, тем самым продлив обязательства на два года. В текущем году акции выросли на 27 %, хотя это всё ещё не дотягивает до пиковых значений 2024 года, когда цена акций составила $175. Сильный операционный денежный поток в $2,5 млрд за квартал и стратегический подход к долгу обеспечивают компании возможность инвестировать в развитие ИИ-бизнеса, не жертвуя выплатами инвесторам. Рост Dell — часть более масштабной картины перезагрузки корпоративных расходов, меняющей рынок серверов. По прогнозам экспертов, сегмент ИИ-серверов в 2025 году вырастет на 55 % и достигнет $252 млрд. По данным прогноза Bloomberg Intelligence, на Dell придётся значительная доля наряду с HPE и Lenovo. Меняется и экономика ИИ-бизнеса «на местах». Если предыдущие поколения серверных ИИ-стоек обходились в $1,5–$3 млн, то новые — $3–$4 млн за шт., в результате чего выручка производителей с каждого клиента значительно вырос.

10.10.2025 [10:11], Сергей Карасёв

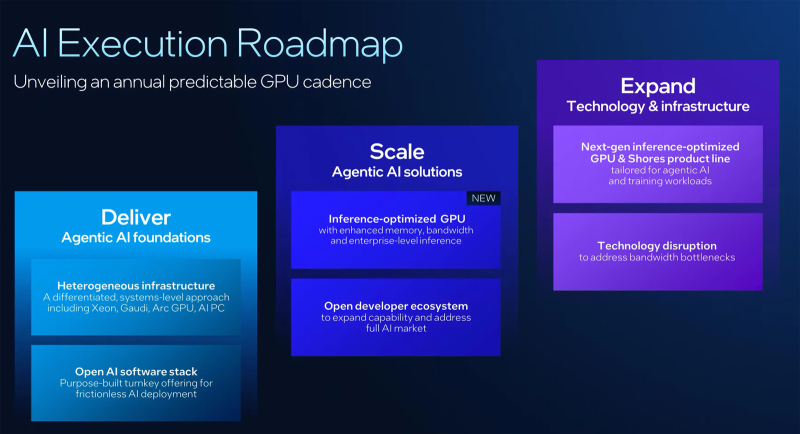

Intel готовит новый GPU-ускоритель, оптимизированный для инференсаКорпорация Intel в ходе мероприятия Intel Tech Tour Arizona сообщила о подготовке новых ИИ-ускорителей на базе GPU. Речь идёт об изделиях, специально оптимизированных для задач инференса. Кроме того, компания поделилась планами по развитию ИИ-продуктов в целом. Ранее предполагалось, что в 2025 году Intel выведет на рынок ускорители Falcon Shores. Изначально планировалось, что это будут гибридные решения, содержащие блоки CPU и GPU. Однако впоследствии Intel сделала выбор в пользу конфигурации исключительно на основе GPU. А затем корпорация и вовсе заявила, что на коммерческом рынке изделия Falcon Shores не появятся. Вместо этого Intel решила сфокусировать внимание на выпуске ускорителей Jaguar Shores. Войдёт ли готовящийся к выпуску GPU для инференса в семейство Jaguar Shores, пока не ясно. Подробности о новинке Intel обещает раскрыть в ходе предстоящего мероприятия 2025 OCP Global Summit, которое пройдёт с 13 по 16 октября в Сан-Хосе (Калифорния, США). На сегодняшний день известно, что устройство получит улучшенную память с высокой пропускной способностью. Изделие будет ориентировано на корпоративный сектор. «Мы активно работаем над оптимизированным для инференса GPU, о котором подробнее расскажем на конференции OCP», — сообщил технический директор Intel Сачин Катти (Sachin Katti). Кроме того, Intel объявила о намерении перейти на ежегодный график выпуска ИИ-продуктов следующего поколения. Предполагается, что это поможет укрепить позиции на глобальном рынке ИИ, на котором корпорация уступила позиции NVIDIA. При этом Intel подчёркивает, что на ближайшую перспективу Jaguar Shores является основным приоритетом в области развития высокопроизводительных решений для ИИ-инфраструктуры.

09.10.2025 [16:50], Руслан Авдеев

«Безответственный» ИИ: большинство компаний пока несут финансовые потери, связанные с внедрением ИИПо данным исследования британской консалтинговой компании EY (Ernst & Young), почти каждый крупный бизнес, внедривший ИИ в свои операции, понёс определённые финансовые потери. Часто это происходит из-за несоблюдения нормативных требований, получения ошибочных результатов, «предвзятости» или негативного влияния на достижение целей устойчивого развития, сообщает Reuters. Несколько реже сообщалось о репутационном ущербе и юридических проблемах. В июле-августе 2025 года EY провела анонимный опрос среди 975 топ-менеджеров, курирующих внедрение ИИ в компаниях со всего мира с годовым оборотом не менее $1 млрд. Совокупные потери бизнеса оцениваются в $4,4 млрд, при этом от ожиданий бизнеса отставали показатели вроде роста выручки, уровня экономии затрат и степени удовлетворённости сотрудников. Тем не менее, представители опрошенных компаний настроены оптимистично и полагают, что внедрение ИИ в конце концов принесёт ощутимые плоды.

Источник изображения: micheile henderson/unsplash.com По словам представителя EY, искусственный интеллект, безусловно, повышает производительность и эффективность бизнеса — сотрудники при прочих равных способны выполнять больше задач и делать это быстрее. При этом создание ценности не настолько велико, поскольку часто удаётся выполнять больший объём работы, а не обязательно сокращать расходы или получать немедленную выручку. Исследование EY уделяло основное внимание «ответственному внедрению ИИ» — ряду показателей, которые дают возможность оценить, разработал ли бизнес внутреннюю политику управления ИИ, довели ли до пользователей чёткие правила эксплуатации и осуществляют ли контроль за соблюдением правил. По словам EY, компании с более подробно разработанной политикой «ответственного ИИ» (Responsible AI) утверждают, что добились больших продаж, сокращения затрат и большее высокой степени удовлетворённости сотрудников. Примечательно, что жертвой ИИ недавно стал другой консалтинговый гигант — компания Deloitte, представившая австралийскому правительству документ с фейковыми ссылками, цитатами и даже полностью выдуманной выдержкой из постановления Австралийского федерального суда.

09.10.2025 [15:30], Руслан Авдеев

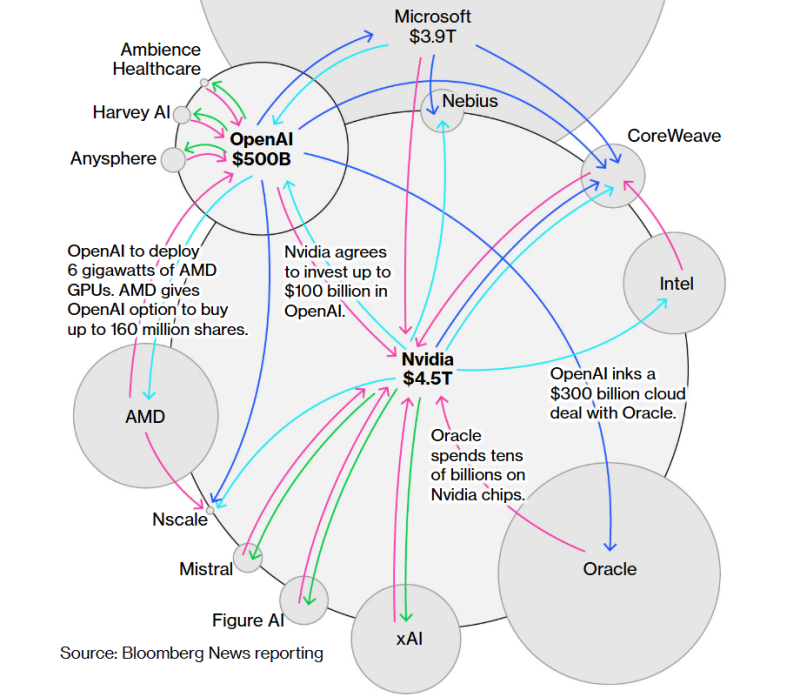

Круговая порука: всё больше аналитиков опасаются формирования «пузыря» на рынке ИИНесколько докладов аналитиков, опубликованных на текущей неделе, сообщают о потенциальных рисках, связанных с бумом на рынке искусственного интеллекта. Не исключается, что ситуация ведёт к возникновению пузыря в сфере ИИ, сообщает Silicon Angle. Так, Банк Англии (Bank of England) предупредил, что в данном сегменте возросла вероятность «резкой коррекции рынка». Одной из причин называются завышенные оценки фондового рынка по ряду показателей, особенно для технологических компаний, ориентирующихся на развитие бизнеса в сфере ИИ. Заявление последовало за публикацией материалов Bloomberg и NBC News, в которых анализировались «циклические сделки» между крупнейшими ИИ-компаниями. Особое внимание уделялось крупным инвестициям NVIDIA и AMD в стартапы.

Источник изображения: Alexas_Fotos/unsplash.com Зачастую выделенные гигантами средства используются для покупки стартапами ИИ-ускорителей тех же NVIDIA и AMD. Так NVIDIA использовала данную схему при работе с CoreWeave, Lambda и xAI. А OpenAI договорилась заключила соглашения на десятки миллиардов долларов с NVIDIA и AMD. Всего NVIDIA, согласно данным PitchBook, сделала 52 инвестиции в ИИ-компании в 2024 году, а в 2025-м — не менее 50. Если огромные расходы на ИИ ведут к возникновению пузыря, связанные с ним финансовые риски могут коснуться не только разработчиков ИИ-моделей и поставщиков чипов, но и повлияют на экономику в целом. Во вторник NBC News сообщила со ссылкой на аналитику Oxford Economics, что обвал рынка ИИ способен привести к «резкой коррекции» цены акций технологических компаний — это способно крайне негативно сказаться на реальной экономике. Подобные доклады о финансовых рисках в сфере ИИ появляются не впервые. В прошлом месяце экономист Джейсон Фурман (Jason Furman, бывший директор Совета экономических консультантов Белого дома США) опубликовал серию постов в X — по его расчётам, расходы на ИИ обеспечили 92 % роста ВВП США в I полугодии 2025 года. Эксперт считает, что без бума ИИ, вероятно, были бы более низкие процентные ставки и цены на электричество, что вызвало бы более активный рост в других секторах экономики. По «очень грубым» оценкам, речь могла бы идти об экономическом росте, сопоставимом с половиной того, что получено от бума ИИ. Ранее доклад Массачусетского технологического института (MIT) о трудностях получения «отдачи» от пилотных проектов в сфере генеративного ИИ привёл к падению индекса Nasdaq на 1,2 %. На это повлияло и высказывание главы OpenAI Сэма Альтмана (Sam Altman), заявившего в одном из интервью, что рынок ИИ, возможно, превращается в пузырь и сравнил его с пузырём доткомов. Это мнение поддержали некоторые деятели технологической отрасли. Сама OpenAI рассчитывает добиться положительного денежного потока к концу текущего десятилетия. NVIDIA заявила Bloomberg, что не требует от ИИ-стартапов покупок на свои инвестиции технологий самой компании, включая ускорители. Так или иначе, это далеко не первый прогноз такого рода. В сентябре Goldman Sachs заявила, что повсеместное внедрение ИИ может не оправдать ожиданий инвесторов. На китайской стороне председатель Alibaba Джо Цай (Joe Tsai) говорил о перегреве рынка ИИ ЦОД ещё в марте, предупредив, что текущие темпы строительства таких дата-центров могут опередить спрос.

09.10.2025 [13:10], Руслан Авдеев

Huawei попыталась продать свои ИИ-чипы Ascend в ОАЭ, пока США тянули с поставками ускорителей NVIDIA на Ближний ВостокВласти США, наконец, одобрили экспорт ИИ-чипов NVIDIA в Объединённые Арабские Эмираты (ОАЭ) на сумму в несколько миллиардов долларов. Это первый шаг на пути реализации двухсторонней сделки, которую американские чиновники могут взять за образец при организации экспорта ИИ-технологий в другие страны, сообщает Bloomberg. По словам источников издания, Министерство торговли США недавно выдало экспортные лицензии NVIDIA в соответствии с двусторонним соглашением по ИИ, анонсированным США и ОАЭ в мае. Разрешение на экспорт получено после того, как ОАЭ объявили о конкретных планах инвестиций на территории США. Речь идёт об ощутимом прогрессе в реализации соглашения, о котором было объявлено около пяти месяцев назад — оно касалось строительства кампуса ЦОД на 5 ГВт в ОАЭ, одним из арендаторов которого должна стать OpenAI. Некоторые политические фигуры в Вашингтоне усомнились в целесообразности реализации столь крупного ИИ-проекта за пределами США, особенно в регионе, имеющего тесные связи с Пекином. Получение разрешений на покупку чипов является одним из приоритетов для ОАЭ, многие чиновники страны недовольны темпами одобрения американского экспорта. Развитие ИИ является одним из ключевых интересов ближневосточной страны, вкладывающей огромные средства в инфраструктуру как на своей территории, так и за рубежом. По данным Bloomberg, в основе сделки — обещание ОАЭ инвестировать $1,4 трлн в США в следующие десять лет. Тем временем Вашингтон планировал ежегодно одобрять поставки в ОАЭ до 500 тыс. американских ИИ-ускорителей, каждый пятый из которых предназначался для ЦОД гиганта G42 из Абу-Даби. Правда, источники утверждают, что первая партия для G42, имеющей партнёрские отношения с OpenAI, не предназначена. Источники не сообщают, когда будут выданы дополнительные экспортные лицензии, отчасти это будет зависеть от реальных инвестиций ОАЭ. Страна предполагает вкладывать в экономику США ту же сумму, на которую США разрешать поставлять чипы (будут оплачиваться отдельно). На днях сообщалось, что задержки с одобрение поставок ускорителей в Объединённые Арабские Эмираты «расстраивают» NVIDIA и реализация сделки между странами фактически заморожена. В Персидском заливе большой спрос на ИИ и достаточно средств на их оплату, что делает регион одним из важнейших рынков для соответствующих технологий в перспективе для гигантов вроде NVIDIA и OpenAI. ОАЭ и Саудовская Аравия с 2023 года страдают от введённых США ограничений на поставку им ИИ-ускорителей. Вашингтон опасается, что технологии могут быть перенаправлены в Китай, экспорт в который строго ограничен. Ранее американские власти практически остановили утверждение экспортных лицензий, ограничив экспорт, в числе прочего, и в ОАЭ. Новая администрация уже меняет ситуацию. По некоторым данным, к концу прошлого года США выдали несколько лицензий для Эмиратов, а G42 заключила партнёрство с Microsoft, во многом основанное на обещание эмиратской компании разорвать связи с Huawei. ЦОД в Абу-Даби будет лишь одним из проектов, в ходе реализации которых планируется вытеснить Китай, также располагающий ИИ-технологиями, с Ближнего Востока.

Источник изображения: ZQ Lee/unspalsh.com В июле сообщалось, что Huawei пыталась привлечь клиентов в ОАЭ, предложив потенциальным покупателям тысячи ИИ-ускорителей Ascend 910B и удалённый доступ к более современным моделям, размещённым на территории КНР. Правда, усилия китайского бизнеса не увенчались успехом. Некоторые чиновники из США считают, что столь скромное предложение свидетельствует об ограниченных возможностях Китая для соперничества. До поездки Трампа на Ближний Восток ранее в этом году США планировали ежегодно одобрять поставку в регион около 100 тыс. ускорителей в год, но теперь речь идёт о 500 тыс. Некоторые чиновники считают, что майское соглашение не содержало подробно прописанного механизма обеспечения безопасности поставок ИИ-чипов в регионы, связанные с Пекином. Впрочем, администрация США заявляет, что подавляющее большинство передовых чипов в ОАЭ будет принадлежать американским компаниям и управляться ими же, местная G42 получит лишь 20 % от общего объёма поставок. Впрочем, когда именно эта и другие компании смогут покупать ускорители и на каких условиях, ещё неизвестно. В своё время министр торговли США Говард Лютник (Hovard Lutnik) заявлял, что союзники смогут покупать чипы при условии, что те будут использоваться аккредитованным американским оператором ЦОД, а облако, подключенное к этому дата-центру, будет также принадлежать аккредитованному американскому оператору.

09.10.2025 [11:12], Сергей Карасёв

Представлен маршрутизатор Cisco 8223 с пропускной способностью 51,2 Тбит/с для распределённых ИИ-кластеровКомпания Cisco анонсировала высокопроизводительную систему маршрутизации Cisco 8223, предназначенную для формирования масштабных ИИ-кластеров на базе географических распределённых дата-центров. Утверждается, что такие платформы способны обрабатывать более 20 млрд пакетов в секунду и обеспечивать общую пропускную способность до 3 Эбит/с. При подобных развёртываниях расстояние между ЦОД-площадками может достигать 1000 км. В основу Cisco 8223 положена ASIC собственной разработки Silicon One P200. Это, как утверждается, первый в отрасли полнодуплексный процессор маршрутизации с пропускной способностью 51,2 Тбит/с. Поддерживается гибкая конфигурация портов в режимах 10/25/40/50/100/200/400/800GbE. Заявлена совместимость со стандартами 802.1d, 802.1p, 802.1q, 802.1ad. Новая система маршрутизации представлена в вариантах 8223-64EF (OSFP) и 8223-64E (QSFP). Устройства выполнены в форм-факторе 3U и оснащены 64 портами 800G. Суммарная пропускная способность достигает 51,2 Тбит/с. Маршрутизаторы несут на борту процессор AMD с восемью вычислительными ядрами, который функционирует в тандеме с 64 Гбайт оперативной памяти. Установлен SSD вместимостью 128 Гбайт. На фронтальную панель выведены консольный порт RS-232, сетевые порты управления 10G SFP+ и 1GbE RJ45, порт QSFP28 PIE и разъём USB Type-C. Установлены четыре блока питания мощностью 3000 Вт. В системе охлаждения задействованы семь вентиляторов. Габариты составляют 132,1 × 439,6 × 640,8 мм, масса — 31,75 кг. Cisco говорит о развитых средствах обеспечения безопасности. В частности, предусмотрены средства непрерывного мониторинга и шифрования данных на полной скорости с использованием устойчивых постквантовых алгоритмов. При объединении в одной инфраструктуре тысяч маршрутизаторов Cisco 8223 может поддерживаться совместная работа миллионов высокопроизводительных ИИ-ускорителей. Это позволяет решать наиболее сложные задачи в области обучения больших языковых моделей и инференса.

08.10.2025 [23:55], Владимир Мироненко

xAI привлёк $20 млрд на покупку ускорителей NVIDIA для Colossus 2 — $2 млрд инвестировала сама NVIDIAxAI, ИИ-стартап Илона Маска (Elon Musk) проводит раунд финансирования, в рамках которого ему удалось привлечь гораздо больше средств, чем изначально планировалось — около $20 млрд, сообщил Bloomberg со ссылкой на информированные источники. В раунде также приняла участие NVIDIA, инвестировавшая $2 млрд в виде акций. Полученные инвестиции в виде акционерного капитала примерно на $7,5 млрд и заёмных средств на $12,5 млрд будут использованы на приобретение ускорителей NVIDIA для строящегося кластера Colossus 2. Для сделки по приобретению будет создана специализированная фирма, которая предоставит купленные чипы стартапу xAI в аренду на пять лет. Такая форма сделки позволяет институциональным инвесторам возмещать свои инвестиции за счёт аренды чипов, при этом долг будет обеспечен в виде залога ускорителями, а не более широкими активами xAI. Аналогичную схему использует и CoreWeave.

Источник изображения: xAI По данным источников, в привлечении заёмных средств участвуют Apollo Global Management и Diameter Capital Partners, а Valor Capital возглавляет часть сделки, посвящённую привлечению акционерного капитала. Ранее Bloomberg сообщал о планах xAI привлечь около $10 млрд инвестиций. Ресурс не исключает, что стартапу удастся получить даже больше, чем $20 млрд, поскольку сбор средств продолжается. В NVIDIA заявили, что будут использовать растущую финансовую мощь компании для ускорения внедрения ИИ в отрасли. В сентябре финансовый директор NVIDIA Колетт Кресс (Colette Kress) сообщила на конференции Goldman Sachs, что компания будет и дальше совершать стратегические приобретения и выкупать акции, но приоритетом останется использование денежных средств, чтобы помочь другим компаниям быстрее внедрять ИИ.

08.10.2025 [13:35], Руслан Авдеев

Техногиганты США приостановили развитие ЦОД в Индии, хотя ранее обещали вложить в них миллиарды долларовАмериканские технологические компании откладывают принятие решений об аренде крупных дата-центров в Индии, настороженные недавним ухудшением торговых связей Нью-Дели и Вашингтона, сообщает CNBC. Так, по данным NTT Global Data Centers, заказы гиперскейлеров и других крупных операторов всё ещё остаются в планах, но подписывать конкретные соглашения IT-гиганты пока не готовы. На гиперскейлеров, включая Amazon (AWS), Microsoft и Google сегодня приходится около 30 % спроса на индийские ЦОД и, по данным консалтинговой компании Anarock Capital, их доля должна была вырасти в обозримом будущем до 35 %. Тем не менее по данным экспертов, новые сделки на рынке ЦОД фактически заморожены уже более двух месяцев. Ожидается, что гиперскейлеры могут вернуться к своим планам в ближайшие три-шесть месяцев. В Argus Partners утверждают, что введение новых пошлин нанесло удар по мировым цепочкам поставок и затруднило контроль над стоимостью оборудования и производственных затрат. Попытки переложить друг на друга тарифы, изменения в законах и более осторожное «поэтапное» увеличение мощностей с учётом меняющейся ситуации на рынке становятся новой нормой. В последние два месяца торговые отношения между США и Индией заметно ухудшились. Так, в августе США ввели 25 % тарифы на продукцию из Индии, а позже повысили пошлины до 50 % из-за закупок страной российской нефти. В июле Microsoft прекратила предоставлять облачные услуги связанной с российским бизнесом компании Nayara Energy. Кроме того, сборы за получение виз H-1B IT-специалистами увеличились с незначительной суммы до $100 тыс., что сильнее всего ударит по индийским работникам.

Источник изображения: Nelson Winfred/unspalsh.com По оценкам экспертов, ёмкость индийских дата-центров в следующие пять лет должна почти утроиться с 1,2 ГВт до более 3,5 ГВт к 2030 году, даже несмотря на трения с Вашингтоном. Рост сервисов электронной коммерции, облачной инфраструктуры и ИИ-нагрузок подогрел спрос на ЦОД. Замедлил расширение местного рынка ЦОД и дефицит на ИИ-ускорители. Последние торговые трения только ухудшили ситуацию. «Гиперскейлеры не исчезли с рынка, но просто взяли паузу», утверждают эксперты по недвижимости. Сегодня в открытии больших дата-центров в Индии заинтересованы многие компании, включая Google, которая уже вела переговоры о строительстве 1-ГВт объекта в штате Андхра-Прадеш (Andhra Pradesh). Также OpenAI работает с партнёрами над аналогичным проектом. В январе AWS заявила, что намерена инвестировать $8,3 млрд в развитие облачного региона AWS Asia Pacific в штате Махараштра (Мумбаи), а Microsoft намеревалась потратить на развитие местной облачной и ИИ-инфраструктуры $3 млрд. Эксперты утверждают, что привлекательность Индии для бизнеса остаётся высокой, но теперь гораздо больше юридических споров о том, кто возьмёт на себя ответственность за компенсацию потрясений, способных повлиять на бизнес. |

|