Материалы по тегу: nvidia

|

28.09.2023 [02:09], Владимир Мироненко

Oracle запустила bare-metal инстансы с NVIDIA H100Несмотря на нехватку на рынке ускорителей NVIDIA H100 ещё один провайдер представил продукты на их основе. Облачная служба Oracle Cloud Infrastructure (OCI) объявила о доступности bare-metal инстансов OCI Compute на базе NVIDIA H100, предназначенных для крупномасштабных приложений искусственного интеллекта (ИИ) и высокопроизводительных вычислений (HPC). Инстанс OCI Compute BM.GPU.H100.8 содержит восемь ускорителей H100, каждый из которых имеет 80 Гбайт памяти HBM2, 16 локальных накопителей NVMe ёмкостью 3,84 Тбайт каждый, два 56-ядерных процессора Intel Xeon Sapphire Rapids (2,0/3,8 ГГц), 2 Тбайт памяти DDR5, а также восемь 400G-адаптеров. Также в этом году компании смогут воспользоваться OCI Supercluster для создания кластеров, включающих до 50 тыс. ускорителей H100. Эта опция поначалу будет доступна в регионах Лондона и Чикаго, а в будущем число регионов с её поддержкой будет увеличено. При этом в OCI доступен и сервис NVIDIA DGX Cloud, который также включает кластеры на базе H100.

Изображение: Oracle Oracle также сообщила, что в начале 2024 года представит инстансы с новейшими ускорителями NVIDIA L40S. Например, инстанс BM.L40S.4 предложит четыре L40S с двумя 56-ядерными процессорами Intel Xeon, 1 Тбайт RAM, 15,36 Тбайт NVMe-хранилища и сетевое подключение 400 Гбит/с.

22.09.2023 [12:29], Сергей Карасёв

Цукерберг создаст суперкомпьютер для биомедицинских исследований на ускорителях NVIDIA H100«Инициатива Чан Цукерберг» (CZI), благотворительная организация основателя Facebook✴ Марка Цукерберга (Mark Zuckerberg), намерена создать высокопроизводительный вычислительный кластер с ускорителями NVIDIA. Об этом сообщает ресурс Datacenter Dynamics. Говорится, что в основу платформы лягут более тысячи изделий NVIDIA H100. Кластер планируется использовать для биомедицинских исследований с применением средств ИИ. Суперкомпьютер будет использоваться для разработки открытых моделей человеческих клеток. При этом планируется применять прогностические методы, обученные на больших наборах данных, таких как те, которые интегрированы в программный инструмент Chan Zuckerberg CELL by GENE (CZ CELLxGENE). Модели также будут обучаться на данных, полученных исследовательскими институтами CZ Science, таких как атлас расположения и взаимодействия белков OpenCell и клеточный атлас Tabula Sapiens, созданный Биоцентром Чана Цукерберга в Сан-Франциско (Biohub San Francisco).

Источник изображения: pixabay.com Разработка цифровых моделей, способных предсказывать поведение различных типов клеток, поможет исследователям лучше понять здоровое состояние организма и изменения, происходящие при различных заболеваниях.

19.09.2023 [15:07], Сергей Карасёв

Исследовательская лаборатория ВВС США получила суперкомпьютер Raider мощностью 12 ПфлопсВысокопроизводительный вычислительный комплекс для Исследовательской лаборатории ВВС США (AFRL), по сообщению ресурса Datacenter Dynamics, прибыл на базу Райт-Паттерсон в Огайо. Суперкомпьютер, построенный Penguin Computing, получил название Raider.

Изображения: AFRL Новая НРС-система имеет производительность приблизительно 12 Пфлопс. Raider является частью более широкой программы модернизации высокопроизводительных вычислений Министерства обороны и будет доступен ВВС, армии и флоту США. Суперкомпьютер примерно в четыре раза мощнее своего предшественника — комплекса Thunder, запущенного в 2015 году: у этой системы производительность составляет 3,1 Пфлопс. Использовать Raider планируется прежде всего для решения сложных задач в области моделирования различных процессов. В опубликованных в прошлом году документах говорится, что Raider должен был получить 189 тыс. вычислительных ядер. Предполагалось, что система будет включать 356 узлов различного назначения и конфигурации и получит процессоры AMD EPYC 7713 (Milan), 44 Тбайт RAM, 152 ускорителя NVIDIA A100, 200G-интерконнект InfiniBand HDR и 20-Пбайт хранилище. Однако заявленная производительность этой системы составляла 6,11 Пфлопс, так что характеристики суперкомпьютера явно скорректировали. В дополнение к Raider Исследовательская лаборатория ВВС США заказала два других суперкомпьютера — TI-23 Flyer и TI-Raven, которые, как ожидается, будут обеспечивать производительность на уровне 14 Пфлопс. Ввод этих систем в эксплуатацию запланирован на 2024 год.

17.09.2023 [19:04], Сергей Карасёв

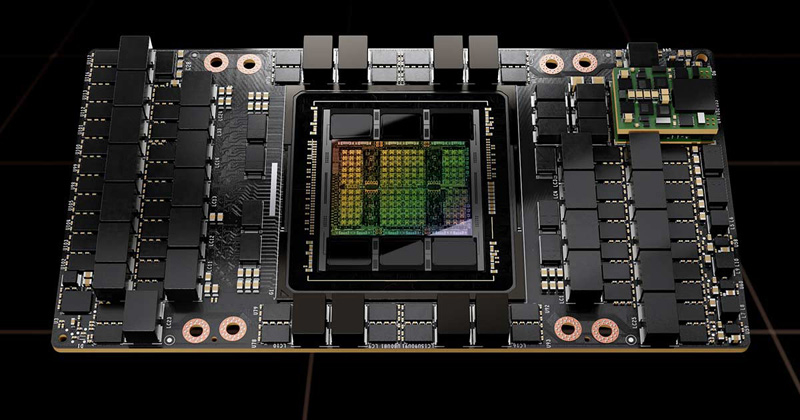

NVIDIA за квартал отгрузила 900 тонн ускорителей H100Во II четверти 2024 финансового года, которая была закрыта 30 июля, компания NVIDIA реализовала продукцию для дата-центров на сумму около $10,32 млрд — это на 171 % больше результата за предыдущий год. Аналитики Omdia, как сообщает ресурс Tom's Hardware, подсчитали, что за эти три месяца NVIDIA отгрузила свыше 300 тыс. флагманских ускорителей H100. Изделия H100 на архитектуре Hopper предназначены для ресурсоёмких приложений ИИ, а также задач НРС. Однако из-за стремительного развития платформ генеративного ИИ такие ускорители оказались в дефиците: выполнение новых заказов откладывается до 2024 года.

Источник изображения: NVIDIA По оценкам Omdia, во II квартале NVIDIA поставила более 900 тонн ускорителей H100. В своих расчётах аналитики полагают, что вес одного устройства с радиатором охлаждения превышает 3 кг. Таким образом, получается, что в течение рассматриваемого периода компания реализовала более 300 тыс. изделий. Ускорители H100 предлагаются в нескольких вариантах исполнения — в виде карты расширения PCIe и в формате модуля SXM. При этом масса (с учётом радиатора) различается: так, например, для карты она указана на отметке 1,2 кг. В случае SXM-изделий показатель не приводится, но, как отмечает Tom's Hardware, он не превышает 2 кг. Если предположить, что 80 % поставок H100 составляют модули, а 20 % — карты, то средний вес одного ускорителя должен составить около 1,84 кг. Omdia заявляет, что оценила общую массу в 900 тонн на основе количества H100, которые, по её мнению, NVIDIA поставила во II квартале. Таким образом, как отмечается, фактически суммарный вес может оказаться меньше, но речь всё равно идёт о сотнях тонн. Omdia прогнозирует, что до конца 2023 года темпы отгрузок Н100 сохранятся. Иными словами, NVIDIA сможет за год поставить около 1,2 млн таких ускорителей, а их суммарный вес достигнет 3600 тонн.

14.09.2023 [22:40], Руслан Авдеев

NVIDIA и Xanadu построят симулятор квантового компьютера на базе обычного суперкомпьютераКомпания NVIDIA начала сотрудничество с канадской Xanadu Quantum Technologies для того, чтобы запустить крупномасштабную симуляцию квантовых вычислений на суперкомпьютере. Как сообщает Silicon Angle, исследователи используют новейший фреймворк PennyLane компании Xanadu и разработанное NVIDIA ПО cuQuantum для создания квантового симулятора. PennyLane представляет собой фреймворк с открытым кодом, предназначенный для «гибридных квантовых вычислений», а инструменты cuQuantum для разработки программного обеспечения позволяют организовать симулятор квантовых вычислений, используя высокопроизводительные кластеры ускорителей. Вычислительных ресурсов действительно требуется немало, поскольку для воспроизведения работы квантовой модели из около 30 кубитов потребовалось 256 ускорителей NVIDIA A100 в составе суперкомпьютера Perlmutter.

Источник изображения: geralt/pixabay.com Как заявляют в Xanadu, комбинация PennyLane и cuQuantum позволяет значительно увеличить число симулированных кубитов — ранее подобных возможностей просто не было. Тесты cuQuantum с одним ускорителем показали повышение производительности симуляции на порядок. Уже к концу текущего года учёные рассчитывают масштабировать технологию до 1 тыс. узлов с использованием 4 тыс. ускорителей, что позволит создать симуляцию более 40 кубитов. Учёные утверждают, что крупными симуляциями в результате смогут пользоваться даже стажёры. Всего планируется реализация не менее шести проектов с использованием соответствующей технологии для изучения физики высоких энергий, систем машинного обучения, развития материаловедения и химии. Xanadu уже сейчас работает с Rolls-Royce над разработкой квантовых алгоритмов, позволяющих создавать более эффективные двигатели, а также с Volkswagen Group над проектами по созданию эффективных аккумуляторов.

14.09.2023 [18:26], Руслан Авдеев

Британский ИИ-суперкомпьютер Isambard-3 станет одним из самых мощных в ЕвропеВ Великобритании будет реализован новый амбициозный проект в сфере вычислительных технологий. Как сообщает Network World, власти страны объявили о строительстве нового суперкомпьютера, а всего в различные проекты с учётом создания центра по исследованию систем искусственного интеллекта (ИИ) будет вложено £900 млн ($1,1 млрд). Isambard-3 пообещали разместить на площадке в Бристоле в этом году. Машина будет включать тысячи передовых ускорителей и станет одним из самых мощных суперкомпьютеров Европы. Бристоль уже является одним из центров исследований ИИ-систем. На базе Бристольского университета будет создан национальный центр AI Research Resource (AIRR или Isambard-AI) для поддержки исследований в сфере ИИ, в том числего его безопасного использования. Суперкомпьютер и AIRR финансируются за счёт средств, выделить которые британское правительство пообещало ещё в марте текущего года. Британские власти ожидают, что центр в Бристоле станет «катализатором» для научных открытий и позволит Великобритании держаться в числе лидеров разработки ИИ, а суперкомпьютер поможет экспертам и исследователям использовать «меняющий правила» потенциал ИИ-систем. Отметим, что ранее Великобритания покинула EuroHPC в связи с Brexit'ом, что несколько затормозило развитие HPC-сферы в стране. Пока не раскрываются технические детали нового суперкомпьютера, хотя первые данные о его спецификациях появились ещё в мае. Правда, тогда речь шла только об использовании Arm-процессоров NVIDIA Grace. Это уже третье поколение HPC-систем на базе Arm, Isambard и Isambard 2 базировались на Cavium ThunderX2 и Fujitsu A64FX соответственно, причём основным поставщиком всех трёх систем является HPE/Cray.

09.08.2023 [18:00], Алексей Степин

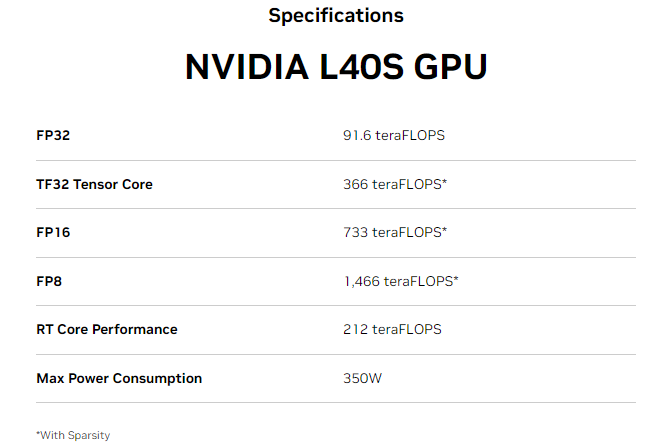

NVIDIA анонсировала L40S — новый универсальный ускоритель на базе Ada LovelaceКорпорация NVIDIA обновила серию укорителей L40, представленных осенью прошлого года в рамках платформы OVX. Новинка под названием NVIDIA L40S позиционируется как универсальный ускоритель в форм-факторе двухслотовой FHFL-карты расширения с интерфейсом PCIe 4.0 x16, пригодный для решения практически любых задач. Во многом L40S повторяет L40 — она также базируется на архитектуре Ada Lovelace, оснащена графическим процессором AD102, дополненным 48 Гбайт памяти GDDR6 ECC (384 бит, 864 Гбайт/с). В составе ускорителя работают 18176 ядер CUDA, 142 RT-ядра третьего поколения и 568 тензорных ядер четвёртого поколения. То есть в этом отличий от L40 нет. Но значение TDP у новинки выше на 50 Вт и составляет 350 Вт, она все ещё имеет пассивное охлаждение.

Источник изображений здесь и далее: NVIDIA При этом L40S умудряется быть практически вдвое быстрее L40 во всех форматах вычислений с использованием тензорных ядер, а вот без Tensor Core её FP32-производительность выросла минимально — с 90,5 до 91,6 Тфлопс. Поддержкой NVLink-мостика новинка так и не обзавелась. L40S оснащён четырьмя портами DP 1.4a с поддержкой NVIDIA Mosaic и Quadro Sync. Также доступны профили vGPU для vDWS, GRID vApps/vPC, vCS. Имеется поддержка Secure Boot с Root of Trust и соответствие стандарту NEBS Level 3.  Таким образом, новинка подходит не только в качестве ускорителя для обучения ИИ-моделей или инференс-систем, но и в качестве основы для систем рендеринга 3D-графики, визуализации или создания и запуска приложений для мета-вселенных. NVIDIA отмечает, что в ИИ-задачах L40S опережает A100 в 1,2–1,7 раза, а наличие трёх движков NVENC/NVDEC с поддержкой AV1 позволяет использовать новый ускоритель в качестве эффективной платформы транскодирования видео.

29.05.2023 [07:30], Сергей Карасёв

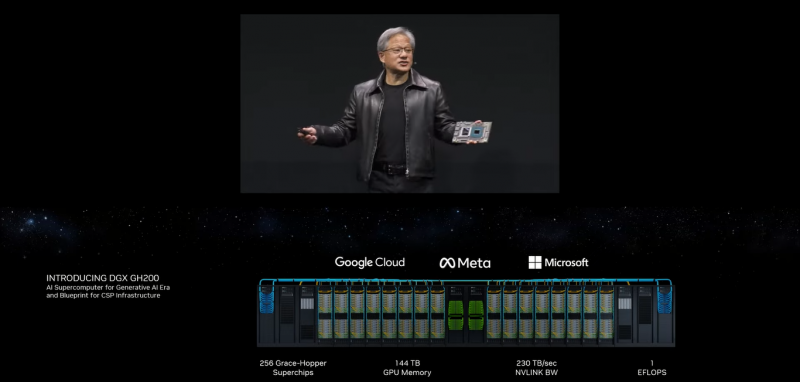

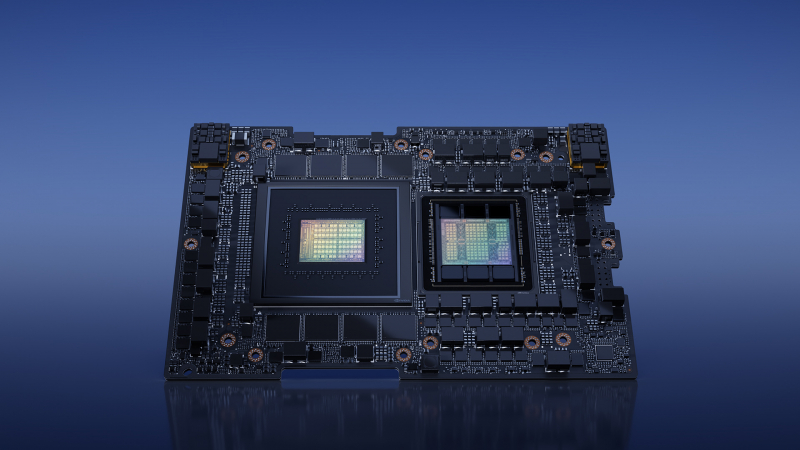

NVIDIA представила 1-Эфлопс ИИ-суперкомпьютер DGX GH200: 256 суперчипов Grace Hopper и 144 Тбайт памятиКомпания NVIDIA анонсировала вычислительную платформу нового типа DGX GH200 AI Supercomputer для генеративного ИИ, обработки огромных массивов данных и рекомендательных систем. HPC-платформа станет доступна корпоративным заказчикам и организациям в конце 2023 года. Платформа представляет собой готовый ПАК и включает, в частности, наборы ПО NVIDIA AI Enterprise и Base Command. Для платформы предусмотрено использование 256 суперчипов NVIDIA GH200 Grace Hopper, объединённых при помощи NVLink Switch System. Каждый суперчип содержит в одном модуле Arm-процессор NVIDIA Grace и ускоритель NVIDIA H100. Задействован интерконнект NVLink-C2C (Chip-to-Chip), который, как заявляет NVIDIA, значительно быстрее и энергоэффективнее, нежели PCIe 5.0. В результате, скорость обмена данными между CPU и GPU возрастает семикратно, а затраты энергии сокращаются примерно в пять раз. Пропускная способность достигает 900 Гбайт/с. Технология NVLink Switch позволяет всем ускорителям в составе системы функционировать в качестве единого целого. Таким образом обеспечивается производительность на уровне 1 Эфлопс (~ 9 Пфлопс FP64), а суммарный объём памяти достигает 144 Тбайт — это почти в 500 раз больше, чем в одной системе NVIDIA DGX A100. Архитектура DGX GH200 AI Supercomputer позволяет добиться 10-кратного увеличения общей пропускной способности по сравнению с HPC-платформой предыдущего поколения. Ожидается, что Google Cloud, Meta✴ и Microsoft одними из первых получат доступ к суперкомпьютеру DGX GH200, чтобы оценить его возможности для генеративных рабочих нагрузок ИИ. В перспективе собственные проекты на базе DGX GH200 смогут реализовывать крупнейшие провайдеры облачных услуг и гиперскейлеры. Для собственных нужд NVIDIA до конца 2023 года построит суперкомпьютер Helios, который посредством Quantum-2 InfiniBand объединит сразу четыре DGX GH200.

29.05.2023 [07:30], Сергей Карасёв

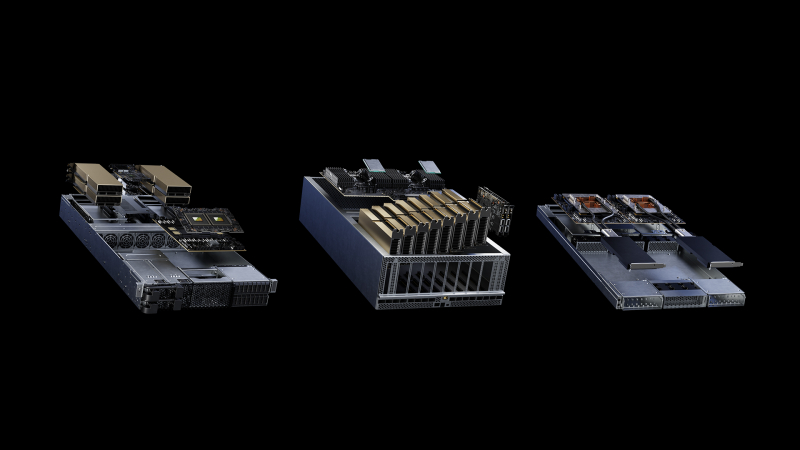

NVIDIA представила модульную архитектуру MGX для создания ИИ-систем на базе CPU, GPU и DPUКомпания NVIDIA на выставке Computex 2023 представила архитектуру MGX, которая открывает перед разработчиками серверного оборудования новые возможности для построения HPC-систем, платформ для ИИ и метавселенных. Утверждается, что MGX закладывает основу для быстрого создания более 100 вариантов серверов при относительно небольших затратах. Концепция MGX предусматривает, что разработчики на первом этапе проектирования выбирают базовую системную архитектуру для своего шасси. Далее добавляются CPU, GPU и DPU в той или иной конфигурации для решения определённых задач. Таким образом, на базе MGX может быть построена серверная система для уникальных рабочих нагрузок в области наук о данных, больших языковых моделей (LLM), периферийных вычислений, обработки графики и видеоматериалов и пр. Говорится также, что благодаря гибридной конфигурации на одной машине могут выполняться задачи разных типов, например, и обучение ИИ-моделей, и поддержание работы ИИ-сервисов. Одними из первых системы на архитектуре MGX выведут на рынок компании Supermicro и QCT. Первая предложит решение ARS-221GL-NR с NVIDIA Grace, а вторая — сервер S74G-2U на базе NVIDIA GH200 Grace Hopper. Эти платформы дебютируют в августе нынешнего года. Позднее появятся MGX-платформы ASRock Rack, ASUS, Gigabyte, Pegatron и других производителей. Архитектура MGX совместима с нынешним и будущим оборудованием NVIDIA, включая H100, L40, L4, Grace, GH200 Grace Hopper, BlueField-3 DPU и ConnectX-7. Поддерживаются различные форм-факторы систем: 1U, 2U и 4U. Возможно применение воздушного и жидкостного охлаждения.

26.04.2023 [19:50], Сергей Карасёв

Meta✴ вынужденно пересмотрела архитектуру своих ЦОД из-за отказа от выпуска собственных ИИ-чипов в пользу ускорителей NVIDIAКомпания Meta✴, по сообщению Reuters, была вынуждена пересмотреть конфигурацию своих дата-центров из-за отставания от конкурентов в плане развития ИИ-платформ. Компания, в частности, решила отказаться от дальнейшего внедрения инференс-чипов собственной разработки. Отмечается, что до прошлого года Meta✴ применяла архитектуру, в которой традиционные CPU соседствуют с кастомизированными решениями. Однако выяснилось, что такой подход менее эффективен по сравнению с применением ускорителей (GPU). При этом ранее компания отказалась от ИИ-ускорителей Qualcomm, указав на недоработки ПО, которые, судя по всему, были устранены только недавно. А с Esperanto, вероятно, отношения у Meta✴ пока не сложились. Впрочем, теперь компании интересен генеративный ИИ, а не только рекомендательные системы, что накладывает иные требования к оборудованию.

Источник изображения: Meta✴ В течение почти всего 2022 года Meta✴ активно инвестировала в развите инфраструктуры, однако в конце года стало известно, что она приостановила строительство целого ряда ЦОД, а затем пересмотрела расходы на дата-центры. Компания решила кардинально переосмыслить архитектуру своих ЦОД, сделав ставку на СЖО. Как теперь выясняется, связано это с тем, что Meta✴ отказалась от собственных ИИ-чипов в пользу ускорителей NVIDIA: объём заказов последних исчисляется «миллиардами долларов». Соответствующую платформу Grand Teton компания показала в конце прошлого года.

Источник изображения: Meta✴ Но ускорители потребляют больше энергии и выделяют больше тепла, нежели CPU или узкоспециализированные ASIC. Кроме того, ускорители должны физически находиться довольно близко друг к другу, хотя с интерконнектом компания тоже уже экспериментирует. Всё это влияет на архитектуру ЦОД. Тем не менее, Meta✴ всё же разрабатывает некий секретный чип, который сгодится и для обучения ИИ-моделей, и для инференса. Ожидается, что это решение увидит свет в 2025 году. Пока что для обучения ИИ компания намерена использовать собственный ИИ-суперкомпьютер RSC и облачные кластеры Microsoft Azure. Похожий путь избрала Microsoft, решившая создать свой ИИ-чип, не отказываясь пока от ускорителей NVIDIA. The Information добавляет, что вице-президент Microsoft по разработке «кремния» Жан Буфархат (Jean Boufarhat) присоединится к Meta✴. Он возглавит команду Facebook✴ Agile Silicon Team (FAST), чтобы помочь компании в реализации проектов по созданию чипов. Ранее Meta✴ переманила из Intel руководителя разработки сетевых решений для дата-центров. У Google и Amazon уже есть свои ИИ-чипы для обучения и инференса. |

|