Материалы по тегу: nvidia

|

02.11.2023 [01:35], Владимир Мироненко

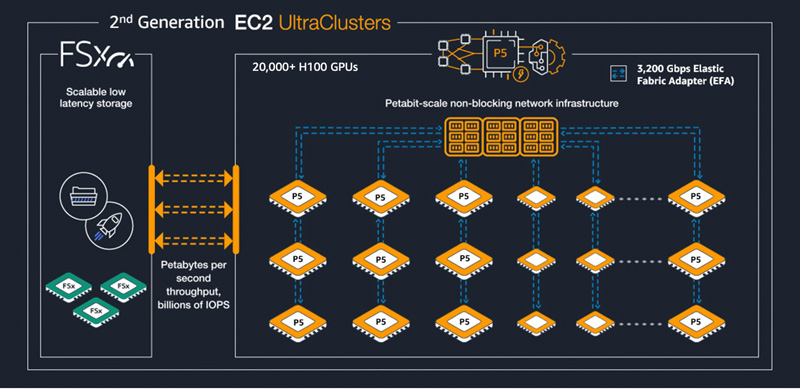

Бронь на ИИ: AWS предложила клиентам заранее заказывать кластеры с ускорителями NVIDIA H100Облачный провайдер Amazon Web Services (AWS) объявил о запуске новой модели потребления EC2 Capacity Blocks for ML, предназначенной для предприятий, желающих зарезервировать доступ к ускорителям вычислений для обработки кратковременных рабочих нагрузок ИИ. Решение Amazon EC2 Capacity Blocks for ML позволяет клиентам зарезервировать доступ к «сотням» ускорителей NVIDIA H100 в кластерах EC2 UltraClusters, которые предназначены для высокопроизводительных рабочих нагрузок машинного обучения. Клиенты просто указывают желаемый размер кластера, дату начала и окончания доступа. Таким образом повышается предсказуемость доступности ИИ-ресурсов и в то же время нет необходимости оплачивать доступ к мощностям, когда они не используются. AWS тоже в выигрыше, поскольку такой подход позволяет более полно использовать имеющиеся ресурсы.

Источник изображения: AWS В рамках EC2 Capacity Blocks предлагаются кластеры, включающие от 1 до 64 инстансов EC2 P5 с подключением на базе Elastic Fabric Adapter (EFA) второго поколения. Кластеры можно зарезервировать на срок от 1 до 14 дней, но не позднее чем за восемь недель до начала использования. Это делает их идеальными для обучения и тюнинга ИИ-моделей, краткосрочных экспериментов или для обработки пикового потока запросов, например, при запуске нового продукта, сообщила AWS. Хольгер Мюллер (Holger Mueller), аналитик компании Constellation Research Inc., отметил, что креативный подход AWS позволяет максимизировать эффективность имеющихся ресурсов ускорителей, которые сейчас пользуются пиковым спросом, а доступ к ним обходится дорого. По его словам, подход заимствован из эпохи мейнфреймов, и впервые был использован ещё в 1970-х годах, когда доступ распределялся по времени между сотнями пользователей с различными рабочими нагрузками. Клиенты могут использовать консоль AWS, CLI или SDK, чтобы найти и зарезервировать доступные кластеры. При использовании EC2 Capacity Blocks клиенты платят только за то время, которое они зарезервировали. Решение доступно в регионе AWS Восток США (Огайо). В дальнейшем число регионов и локальных зон AWS с доступностью этого решения будет расширено.

01.11.2023 [13:43], Руслан Авдеев

Из-за нехватки ИИ-ускорителей NVIDIA южнокорейский IT-гигант Naver Corporation вынужден перейти на CPU IntelСпрос на ИИ-ускорители NVIDIA так высок, что производитель чипов не может удовлетворить его в полной мере. В результате, как сообщает The Korean Economic Daily, создатель ведущего поискового портала Южной Кореи — компания Naver Corporation — для ряда ИИ-нагрузок перешла с использования ускорителей NVIDIA на Intel Xeon Sapphire Rapids, как из-за дефицита, так и по причине роста цен на продукцию. По данным СМИ, Naver Corp. начала использовать решения Intel для ИИ-серверов картографического сервиса Naver Place. Корейский IT-гигант использует ИИ-модель для распознавания ложных данных в случаях, когда пользователи ведут поиск по ключевым запросам вроде «ближайшие рестораны» в приложении Naver Map. Ранее именно продукты NVIDIA применялись для обработки таких данных. Впрочем, речь идёт в первую очередь об инференсе, а для обучения моделей компания всё равно вынуждена использовать ИИ-ускорители. Приобрести ИИ-ускорители NVIDIA, включая H100, стало очень сложно, а цены на последние с начала года выросли в Южной Корее вдвое. Но даже если у вас есть средства, время с момента размещения заказа на ускорители до их получения уже увеличилось до 52 недель, так что быстро обновить парк серверов не выйдет. При этом ускорители способны справляться с ИИ-задачами на порядок быстрее CPU. Как утверждают отраслевые эксперты, Intel усовершенствовала технологии работы с ИИ-системами, желая угодить клиентам, ищущим альтернативы ускорителям NVIDIA. Например, Naver в течение месяца тестировала ИИ-сервер на основе процессоров компании перед его вводом в эксплуатацию. Вероятно, южнокорейский IT-гигант продолжит использовать CPU Intel новых поколений. По мнению экспертов, сотрудничество Naver и Intel может привести к ослаблению позиций NVIDIA на рынке чипов для ИИ-вычислений. По некоторым данным, Microsoft объединила усилия с AMD, чтобы помочь последней в экспансии на рынке ИИ-процессоров. Компании сотрудничают для конкуренции с NVIDIA, контролирующей около 80 % мирового рынка ИИ-чипов.

31.10.2023 [20:58], Руслан Авдеев

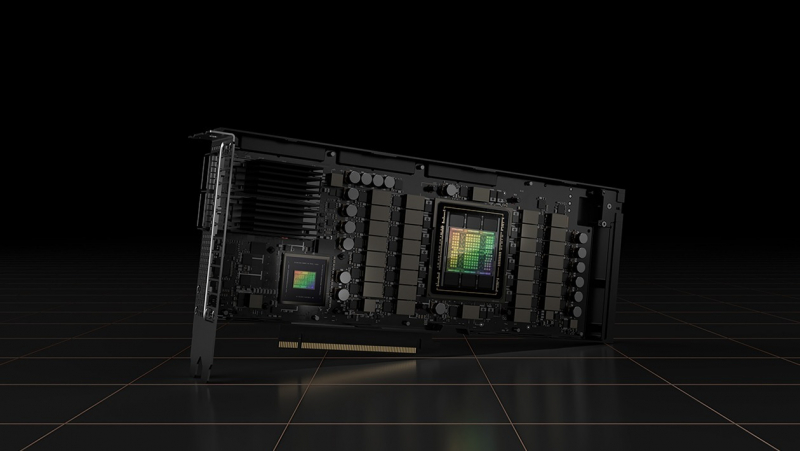

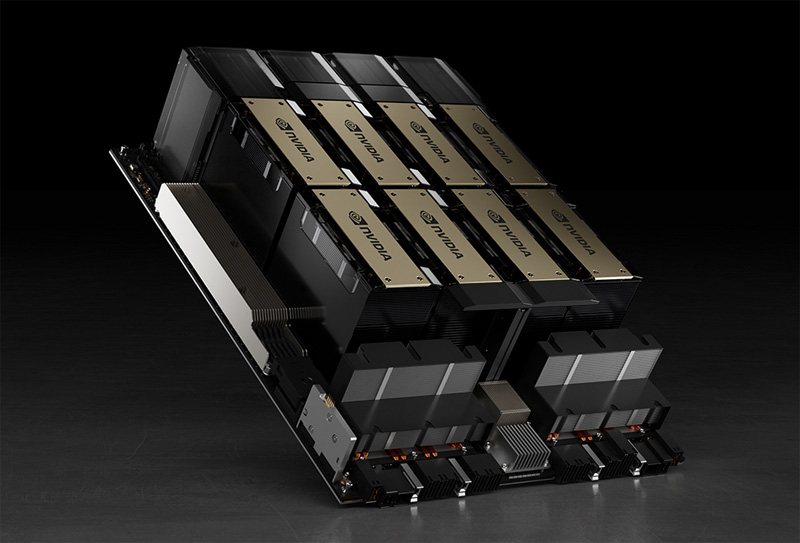

Voltage Park закупила 25 тыс. ускорителей NVIDIA H100, чтобы сбалансировать спрос и предложение на дефицитные ресурсы для ИИПровайдер ИИ-инфраструктуры Voltage Park объявил о приобретении 24 тыс. ускорителей NVIDIA H100. Как сообщает The Register, компания намерена сдавать их в аренду корпоративным клиентам, небольшим стартапам и исследовательским структурам уже в следующем году. Первые счастливчики в лице Imbue уже получили доступ, а формирование кластеров для Character.ai и Atomic AI находится на финальной стадии. В компании подчеркнули, что мало кто понимает, насколько недостаток вычислительных мощностей вредит инновациям — для реализации многих проектов в сфере ИИ и машинного обучения требуется или ждать месяцы своей очереди для доступа к ускорителям, или, если позволяет бюджет, платить доступ здесь и сейчас заоблачные суммы. Компания рассчитывает сбалансировать спрос и предложение.

Источник изображения: NVIDIA Voltage Park привлекла $500 млн. Ускорители купят у некоммерческой организации, поддерживаемой миллиардером Джедом Маккалебом (Jed MacCaleb), сколотившим состояние на крипторынке, а теперь заинтересовавшимся космическими проектами. Внедрение нового оборудования намечено в Техасе, Вирджинии и Вашингтоне. Компания намерена расширить портфолио долгосрочных и краткосрочных тарифов, а в начале следующего года появится возможность даже почасовой аренды мощностей отдельных ускорителей. Доступ к одному ускорителю у Voltage Park будет стоить от $1,89/час, но полные условия, в том числе особенности инфраструктуры, не раскрываются. Для сравнения — инстанcы AWS EC2 P5 с восемью NVIDIA H100 обойдутся в $98,32/час при доступе по запросу или же в $43,16/час при заключении контракта на три года. Voltage Park по запросу будет предоставлять мощности от 1 до 8 ускорителей, для доступа к 8–248 H100 придётся подписать краткосрочный договор аренды. Наконец, годовой контракт даёт доступ к 4088 ускорителям ($67,7 млн/год). Это далеко не единственная компания, выросшая на фоне высокого спроса на продукцию NVIDIA и AMD. Например, CoreWeave при сотрудничестве с NVIDIA построила собственный кластер, включающий более 22 тыс. ускорителей H100.

28.10.2023 [22:47], Сергей Карасёв

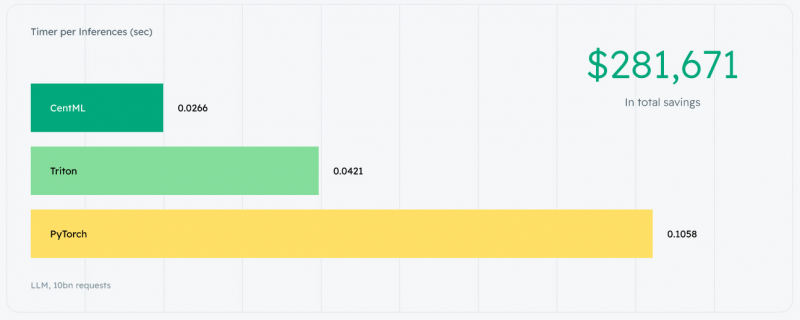

Разработчик инструментов ИИ-оптимизации CentML получил на развитие $27 млн, в том числе от Google и NVIDIAСтартап CentML, специализирующийся на технологиях машинного обучения, объявил о завершении начального раунда финансирования и привлечении на развитие дополнительно $27 млн. Деньги будут направлены в том числе на расширение штата и ускорение разработки продуктов. Компания CentML с численностью персонала около 30 человек была основана в 2022 году. Её соучредителем и генеральным директором является Геннадий Пехименко (Gennady Pekhimenko). В 2016 году он получил докторскую степень на факультете компьютерных наук Университета Карнеги-Меллона. Кроме того, Пехименко является доцентом кафедры компьютерных наук Университета Торонто. CentML разрабатывает программные инструменты для снижения стоимости и повышения производительности при работе с масштабными ML-моделями. Платформа выявляет узкие места в процессе обучения, а также прогнозирует общее время и стоимость внедрения ИИ-решений. Клиенты могут настраивать алгоритмы, выявлять неэффективные методы и получать доступ к аналитике в реальном времени. Утверждается, что система CentML работает без ущерба для точности работы модели, при этом инженерам «практически не требуются усилия по внедрению». «Обучение моделей ИИ становится всё дороже. Благодаря технологии оптимизации CentML мы можем сократить расходы до 80 % без ущерба для скорости и точности», — заявляет Пехименко. Закрытый раунд финансирования на $27 млн проведён под предводительством Gradient Ventures, венчурного фонда Google, ориентированного на ИИ. Кроме того, средства предоставили Radical Ventures, NVIDIA, Deloitte Ventures и Thomson Reuters Ventures. Таким образом, на сегодняшний день компания CentML получила от инвесторов $30,5 млн. Компания отмечает, что для одного из своих клиентов она оптимизировала модель Llama 2 так, что она стала работать в три раза быстрее на ускорителях предыдущего поколения (NVIDIA A10), а затраты сократились на 60 %. В целом, платформа CentML даёт возможность повысить скорость инференса и обучения до восьми раз по сравнению с существующими решениями. Похожее решение предлагает и MosaicML. При этом обучение больших языковых моделей возможно на ускорителях AMD Instinct MI250 без модификации кода. И в том, и в другом случае появляется возможность сэкономить, в том числе отказавшись от дефицитных ускорителей NVIDIA последнего поколения.

28.10.2023 [14:12], Сергей Карасёв

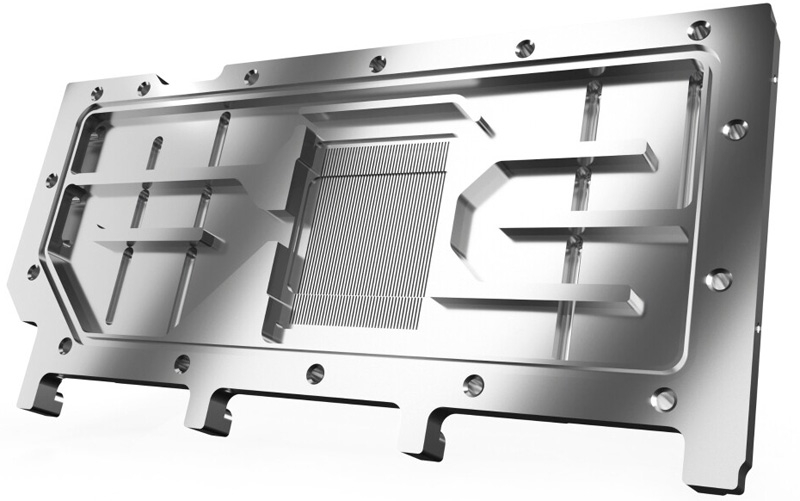

AlphaCool выпустила однослотовый водоблок за €300 для ускорителя NVIDIA H100Компания AlphaCool анонсировала водоблок ES H100 80GB HBM PCIe, предназначенный для использования в составе системы жидкостного охлаждения ускорителя NVIDIA H100. Новинка, получившая однослотовое исполнение, уже доступна для заказа по ориентировочной цене €300. Изделие полностью изготовлено из высококачественной хромированной меди. Верхняя часть водоблока выполнена из углеродного волокна. Новинка специально спроектирована для серверов с ограниченным внутренним пространством. В частности, коннекторы расположены в задней части изделия, благодаря чему упрощается прокладка шлангов. Это позволяет интегрировать решение в водяной контур даже в самых тесных корпусах.

Источник изображений: AlphaCool Задействованы фитинги стандарта G1/4". Габариты составляют 261,89 × 95,71 × 19,40 мм, а тыльная панель из алюминия чёрного цвета имеет размеры 261,89 × 95,71 × 4,00 мм. Максимальная рабочая температура — 60 °C. В комплект поставки входят термопрокладки толщиной 1 мм и термопаста Alphacool Apex с теплопроводностью 17 Вт/м·К.

25.10.2023 [19:26], Владимир Мироненко

NVIDIA и Lenovo расширяют сотрудничество для помощи компаниям в создании ИИ-решений нового поколенияNVIDIA и Lenovo объявили на ежегодной конференции Lenovo Tech World о расширении сотрудничества, в рамках которого они будут работать над созданием передовых гибридных вычислительных платформ, способных обеспечивать работу рабочих нагрузок генеративного искусственного интеллекта (ИИ) в любой локации, где генерируются данные. Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) и гендиректор Lenovo Юаньцин Ян (Yuanqing Yang) отметили рост спроса со стороны предприятий на ускоренные вычислительные системы, приложения ИИ и экспертные услуги, поскольку они стремятся создавать и запускать собственные модели ИИ, обученные на их собственных данных. По словам компаний, благодаря фреймворку NeMo в составе NVIDIA AI Enterprise компании могут тюнинговать ряд базовых больших языковых моделей (LLM) из набора NVIDIA AI Foundations и создавать специализированные приложения генеративного ИИ. Чтобы удовлетворить этот спрос, Lenovo выпустила новые локальные системы, оптимизированные для запуска программного стека NVIDIA AI Enterprise и обеспечения обработки рабочих нагрузок ИИ в любом месте. В их числе новый сервер Lenovo ThinkSystem SR675 V3 и рабочая станция ThinkStation PX. Так, ThinkSystem SR675 V3 оснащён ускорителями NVIDIA L40S, DPU BlueField-3 и сетевой платформой NVIDIA Spectrum-X. А ThinkStation PX обеспечивает расширенные возможности работы ИИ-приложений и высокую производительность благодаря использованию до четырёх видеокарт RTX 6000 Ada. Кроме того, NVIDIA и Lenovo будут сотрудничать в деле создания ещё более мощных систем на основе модульной архитектуры NVIDIA MGX. Клиенты смогут объединить это оборудование с платформой NVIDIA Omniverse для реализации иммерсивной симуляции и когнитивных решений в рамках предприятия. Наконец, системы Lenovo будут поддерживать платформу VMware Private AI Foundation. Lenovo также представила услугу AI Professional Services Practice, которая поможет бизнесу любого размера быстро, эффективного и без лишних затрат создать решения на базе генеративного ИИ.

25.10.2023 [12:15], Сергей Карасёв

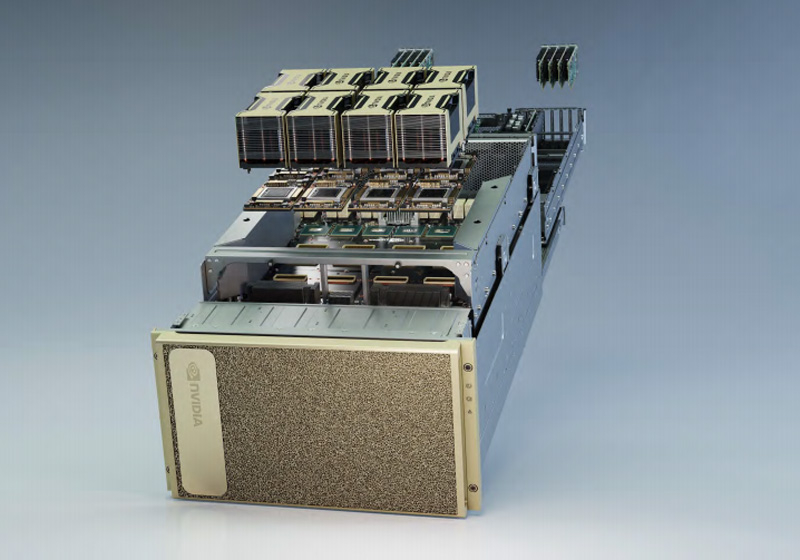

Taiga Cloud развернёт ИИ-платформу Gigabyte с 10 тыс. ускорителями NVIDIA H100Компания Northern Data Group объявила о том, что её облачное подразделение Taiga Cloud заключило соглашение о стратегическом сотрудничестве с Gigabyte. Партнёрство предполагает создание в европейском регионе НРС-площадки для решения ресурсоёмких задач, связанных с генеративным ИИ. Речь идёт об использовании ускорителей NVIDIA. В частности, Gigabyte по заказу Taiga Cloud создала архитектуру из NVIDIA DGX SuperPod, насчитывающих 512 ускорителей NVIDIA H100. Четыре таких блока (2048 ускорителей) связаны посредством NVIDIA BlueField и NVIDIA Quantum-2 InfiniBand, а всего таких блоков будет пять, т.е. суммарно оператор получит 10 240 ускорителей. Gigabyte поставит в интересах Taiga Cloud в общей сложности 20 вычислительных блоков с ускорителями NVIDIA H100 на общую сумму €400 млн. В результате, Taiga Cloud станет одним из крупнейших в Европе независимых поставщиков облачных услуг на основе оборудования NVIDIA — с более чем 19 тыс. ускорителей H100, A100 и RTX A6000.

Источник изображения: NVIDIA Предполагается, что развёртывание площадки поможет заказчикам ускорить инновации в области генеративного ИИ. Облачная платформа с ускорителями NVIDIA H100 повысит скорость обучения больших языковых моделей (LLM). Таким образом, клиенты смогут выводить свои продукты на коммерческий рынок в более сжатые сроки, что обеспечит конкурентное преимущество и даст возможность повысить выручку.

21.10.2023 [16:44], Сергей Карасёв

Gcore развернула кластер генеративного ИИ с ускорителями NVIDIAПровайдер облачных и периферийных сервисов Gcore, по сообщению ресурса Datacenter Dynamics, запустил вычислительный кластер для решения задач в области генеративного ИИ. Площадка, расположенная в Люксембурге, использует ускорители NVIDIA. Ранее Gcore уже развернула в Люксембурге ИИ-платформу на базе Graphcore IPU (Intelligence Processing Unit). Кроме того, компания оперирует такими системами в Амстердаме (Нидерланды) и Уэльсе (Великобритания). Новый кластер позволит клиентам ускорить решение задач в сферах генеративного ИИ и машинного обучения. Запущенная в Люксембурге площадка объединяет 20 серверов с ускорителями NVIDIA A100. До конца текущего года будут добавлены 128 узлов на базе NVIDIA H100 и ещё 25 серверов с изделиями A100. О текущей и планируемой производительности кластера данных пока нет. Отмечается лишь, что заказчики смогут разворачивать на базе платформы крупномасштабные ИИ-модели.

Источник изображения: NVIDIA На сегодняшний день Gcore имеет точки присутствия в более чем в 140 регионах на шести континентах, а также более чем 20 облачных локаций. Компания была основана в 2014 году, а услуги CDN и хостинга начала предоставлять в 2016 году.

20.10.2023 [14:46], Сергей Карасёв

Три поколения EPYC, A100, L40 и немного Xeon: HPE создала для Франции ИИ-суперкомпьютер Austral на базе Cray XD2000Компания Hewlett Packard Enterprise (HPE) объявила о вводе в эксплуатацию нового ИИ-суперкомпьютера под названием Austral, разработанного в интересах Регионального центра информатики и цифровых приложений Нормандии (CRIANN) во Франции. В основу вычислительного комплекса положена платформа Cray XD2000. Задействованы 11 двухпроцессорных узлов на базе AMD EPYC 7543 Milan (32 ядра на сокет; 2,8 ГГц; 512 Гбайт оперативной памяти DDR4-3200). Каждый из этих узлов использует восемь ускорителей NVIDIA A100 с 80 Гбайт памяти. Кроме того, в состав суперкомпьютера входят 124 двухпроцессорных узла с чипами AMD EPYC 9654 Genoa (96 ядер на сокет; 2,4 ГГц; 768 Гбайт оперативной памяти DDR5-4800). Есть и один специализированный узел с процессором AMD EPYC 7313P Rome (16 ядер; 3,0 ГГц; 96 Гбайт оперативной памяти DDR4-3200). Плюс к этому установлены пять двухсокетных узлов визуализации на основе AMD EPYC 9654 — каждый с двумя ускорителями NVIDIA L40 с 48 Гбайт памяти и 768 Гбайт ОЗУ DDR5-4800. Наконец, предусмотрен один узел HPE Superdome Flex 280 с восемью чипами Intel Xeon 8376H (28 ядер; 2,6 ГГц) и 6 Тбайт оперативной памяти DDR4-3200. Применяется 200G-интерконнект HPE Slingshot. Ёмкость хранилища достигает 2 Пбайт. Программная платформа основана на решениях Red Hat.

Источник изображения: HPE Заявленная пиковая FP64-производительность составляет 966 Тфлопс для CPU-части DP и 1034 Тфлопс — для GPU-блока. Применять суперкомпьютер планируется для проведения моделирования и анализа в таких областях, как изменения климата, биотехнологии, здравоохранение и материаловедение.

19.10.2023 [21:34], Сергей Карасёв

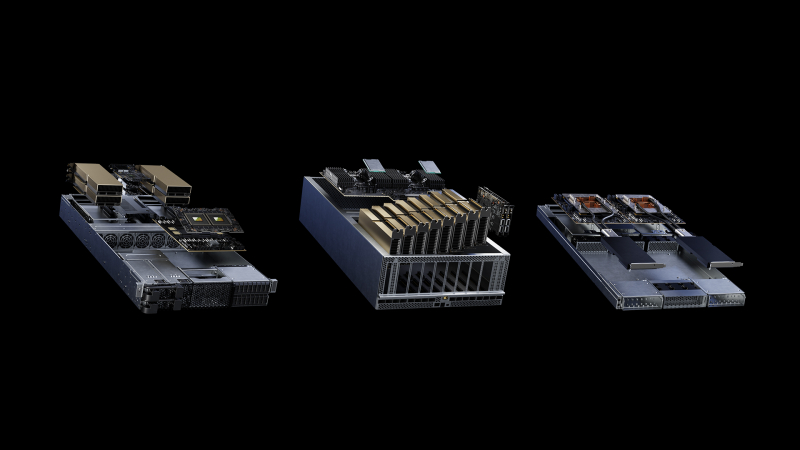

Supermicro выпустила первые в отрасли ИИ-системы NVIDIA MGX на базе гибридных суперчипов GH200 Grace HopperКомпания Supermicro сообщила о начале поставок первых в отрасли серверов на базе суперчипа NVIDIA GH200 Grace Hopper, предназначенных для поддержания ресурсоёмких нагрузок ИИ. Дебютировали стоечные решения в форм-факторах 1U и 2U с воздушным и жидкостным охлаждением. Серверы используют модульную платформу NVIDIA MGX, которая специально разработана для упрощения создания ИИ-систем. Разработчики на этапе проектирования выбирают базовую архитектуру для шасси, после чего добавляются CPU, GPU и DPU в той или иной конфигурации для решения определённых задач. В общей сложности выпущены шесть систем (см. характеристики в таблицах ниже). Все они допускают установку накопителей стандарта E1.S с возможностью горячей замены и SSD формата M.2. Есть слоты PCIe 5.0 x16 с поддержкой NVIDIA BlueField-3 и ConnectX-7. Питание обеспечивают два или три блока мощностью 2000 или 2700 Вт.

Источник изображений: Supermicro В список анонсированных серверов входят:

Supermicro отмечает, что заказчики могут использовать новые серверы в комплексе с софтом NVIDIA, включая NVIDIA AI Enterprise, для решения разнообразных задач в области генеративного ИИ, компьютерного зрения, речевых приложений и машинного обучения. А набор NVIDIA HPC SDK содержит компиляторы, библиотеки и программные инструменты, необходимые для организации высокопроизводительных вычислений. |

|