Материалы по тегу: nvidia

|

15.02.2024 [12:34], Сергей Карасёв

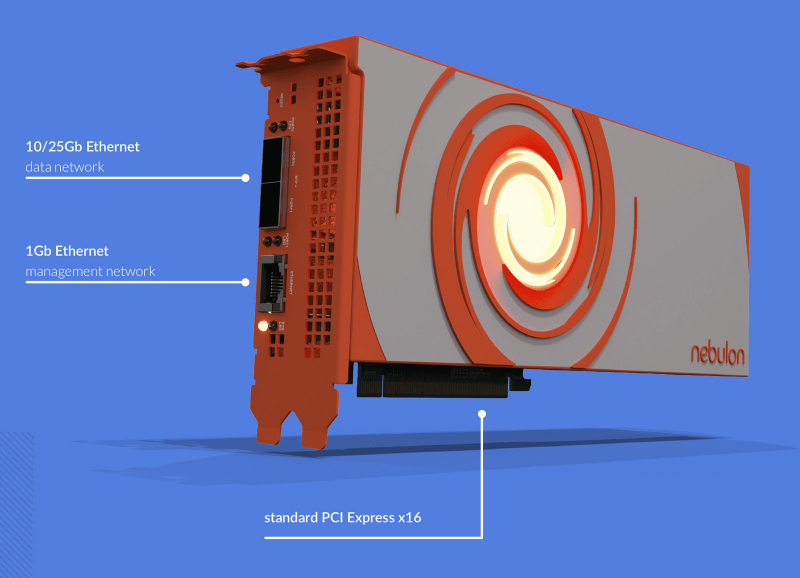

NVIDIA, возможно, поглотила разработчика DPU NebulonВ интернете появилась информация о том, что компания NVIDIA, возможно, заключила сделку по поглощению стартапа Nebulon — разработчика специализированных ускорителей SPU (Services Processing Unit) и одного из пионеров концепции DPU. По имеющимся данным, сумма сделки могла составить около $15 млн. На текущий момент стороны официальные комментарии не дают. Фирма Nebulon, основанная в 2018 году, создала SPU на базе неназванного SoC, которые обеспечивают разгрузку, ускорение и изоляцию широкого спектра процессов, обеспечивающих работу сети, СХД и подсистемы безопасности, включая обнаружение программ-вымогателей. В основе изделий Medusa2 последнего поколения лежат уже DPU NVIDIA BlueField-3. Буквально несколько дней назад, как сообщается, генеральный директор Nebulon Сиамак Назари (Siamak Nazari) на своей странице в соцсети LinkedIn объявил о переходе в NVIDIA. В эту компанию также перешли многие другие инженеры и специалисты стартапа, включая технического директора Nebulon Фила Хукера (Phil Hooker) и руководителя группы облачных вычислений Майкла Мигала (Michael Migal). Отмечается, что в течение некоторого времени 13 февраля при попытке посещения сайта Nebulon происходила переадресация на NVIDIA, однако затем работа ресурса восстановилась. По имеющимся данным, NVIDIA приобрела наработки и часть или же всю команду Nebulon. В 2018-м стартап привлёк $18,3 млн в рамках посевного раунда финансирования и программы Series A. Кроме того, был проведён раунд Series В на неназванную сумму — вероятно, около $5 млн. Однако впоследствии фирма столкнулась с трудностями из-за растущей конкуренции на рынке DPU. Объединив технологии и специалистов Nebulon со своими ресурсами, NVIDIA сможет расширить присутствие на DPU-рынке и предложить более комплексные решения для дата-центров.

13.02.2024 [15:16], Владимир Мироненко

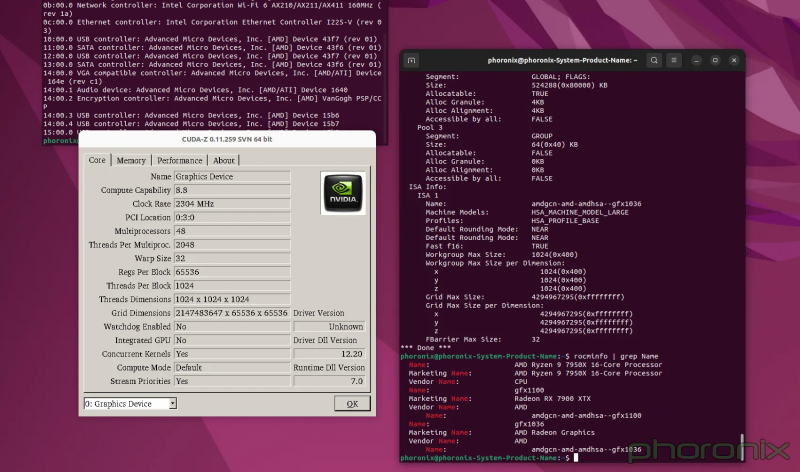

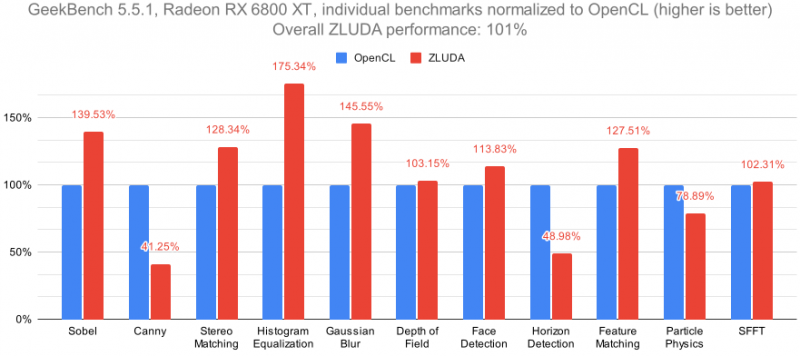

ZLUDA позволяет «в один клик» запускать CUDA-приложения на ускорителях AMDВ течение последних двух лет, как сообщает Phoronix, AMD без особой огласки финансировала проект по реализации бинарной совместимости ускорителей AMD и приложений NVIDIA CUDA. ПО работает поверх стека ROCm, используя готовые библиотеки без необходимости адаптации исходного кода. Возглавляет проект Анджей Яник (Andrzej Janik). Созданное им решение ZLUDA с открытым исходным кодом изначально предлагало реализацию CUDA на базе Intel oneAPI Level Zero, позволяя запускать CUDA-приложения на ускорителях Intel без каких-либо адаптаций и с относительно небольшой потерей производительности. Intel рассматривала возможность поддержки разработки ZLUDA, однако от этой идеи отказалась и не предоставила финансирование проекту. В итоге Яник заключил в 2022 году контракт с AMD, в рамках которого должен был адаптировать ZLUDA для использования с ускорителями AMD с HIP/ROCm. И ему это удалось, однако в этом году AMD решила прекратить финансирование проекта и не выпускать ZLUDA в качестве своего программного продукта. Согласно соглашению, Яник имеет право открыть исходный код продукта в случае, если срок действия контракта истечёт. Программист воспользовался этим правом, предоставив ресурсу Phoronix доступ к новой реализации ZLUDA. После нескольких дней тестирования специалисты Phoronix сообщили, что новый вариант действительно работает поверх ROCm, позволяя запускать практически любые CUDA-приложения без каких-либо дополнительных манипуляций. Хотя о 100 % совместимости речи пока не идёт, тем не менее, даже проприетарные инструменты рендеринга теперь работают с Radeon. Как сообщается, данное решение имеет двойную лицензию: Apache 2.0 и MIT. Коды проекта размещены в репозитории на GitHub. ZLUDA доступна для Windows и Linux. Примечательно, что поддержку ускорителей Intel автор из проекта удалил.

10.02.2024 [20:32], Алексей Степин

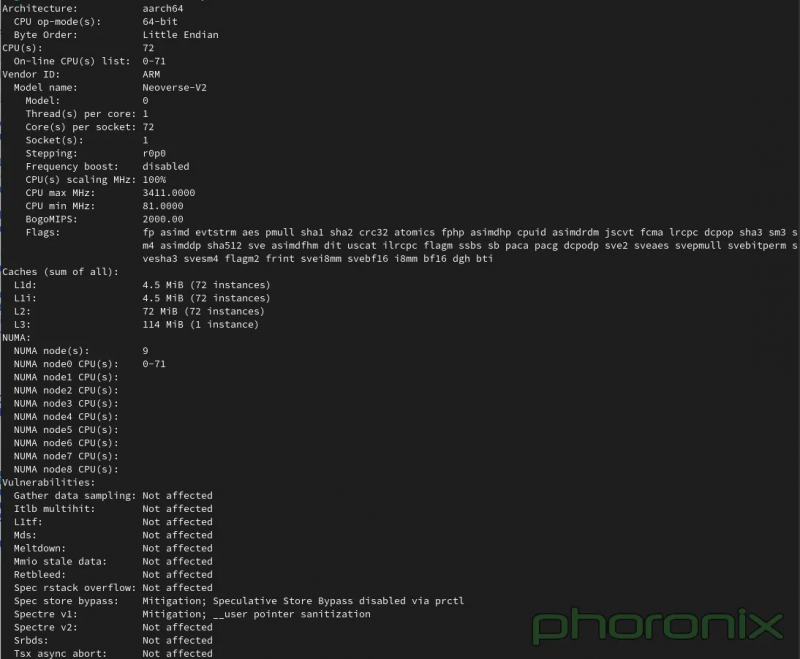

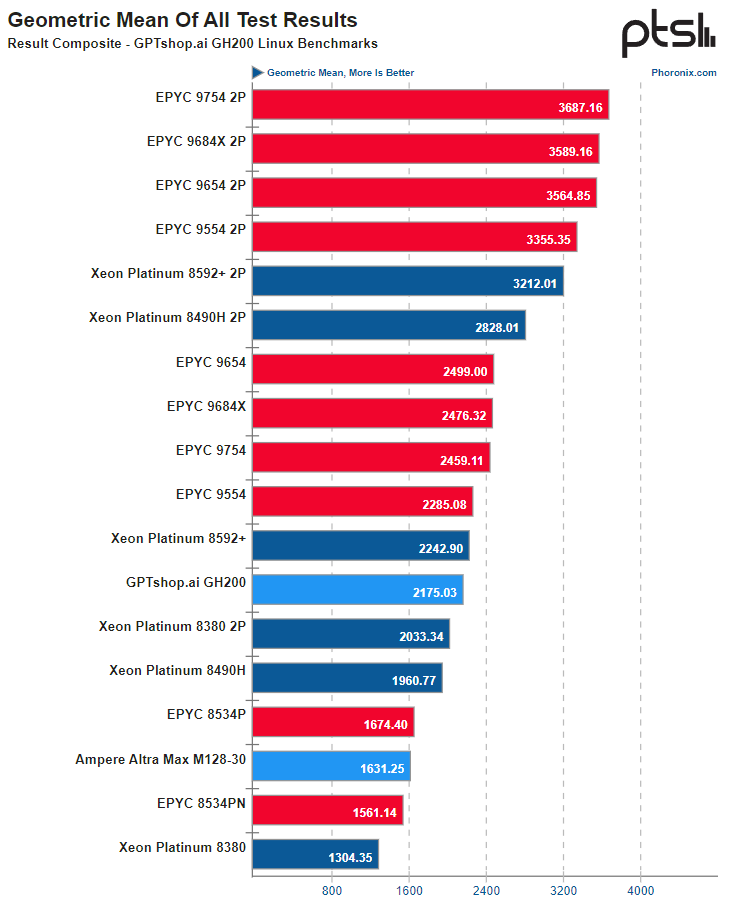

Опубликованы результаты тестирования рабочей станции на базе NVIDIA GH200Поскольку NVIDIA со своим проектом Grace явно метит в мир высокопроизводительных многоядерных процессоров, результаты тестирования новых чипов представляют существенный интерес для всех, кто интересуется решениями подобного класса. Ресурс Phoronix опубликовал результаты проведённого тестирования NVIDIA GH200, причём в составе рабочей станции. Это, напомним, гибридное решение, включающее в себя 72-ядерный Arm-процессор и ускоритель H100. Сборка также включает в себя 480 Гбайт памяти LPDDR5 для процессорной части, а ускоритель располагает собственной высокоскоростной памятью HBM3e объёмом 96 Гбайт или 144 Гбайт. Связаны CPU и GPU высокоскоростной шиной NVLink-C2C с пропускной способностью 900 Гбайт/с. С периферийными устройствами GH200 может общаться посредством четырёх комплексов PCIe 5.0 по 16 линий каждый, а со стороны ускорителя имеется 18 линий NVLink 4 (900 Гбайт/с совокупно). Систему на тестирование предоставил магазин GPTshop.ai, позиционирующий решения на базе GH200 в качестве «настольных суперкомпьютеров». Рабочая станция в башенном корпусе включает в себя модуль GH200 на плате QCT и два блока питания мощностью 2000 Ватт, твердотельные накопители и сетевые карты NVIDIA ConnectX/Bluefield — по желанию заказчика. Стоимость стартует с отметки €47,4 тыс. В качестве ОС может использоваться любой дистрибутив Linux с поддержкой AArch64. В Phoronix использовали Ubuntu 23.10 с ядром версии 6.5 и стоковым компилятором GCC 13. В сравнении приняли участия системы на базе Intel Xeon Emerald Rapids, AMD EPYC и Ampere Altra Max. В зависимости от сценария система на базе GH200 выступила с переменным успехом, но в среднем производительность процессорной части оказалась примерно на уровне 64-ядерных x86-процессоров — Xeon Platinum 8592+ или EPYC 9554. А 128-ядерный Altra Max M128-30 решение от NVIDIA уверенно обгоняет за счёт и более совершенной архитектуры, и более производительной подсистемы памяти.

Источник: Phoronix К сожалению, вопрос энергоэффективности пока остался непроясненным, поскольку система не предоставляет интерфейсов RAPL/PowerCap/HWMON в Linux и точных метрик потребления получить невозможно, доступно лишь примерное значение потребления системы в целом через IPMI. Потенциал у GH200, определённо, есть, хотя временами и сказывается недостаточная оптимизация программного обеспечения под архитектуру AArch64. Конкуренции двухпроцессорным решениям Intel или AMD GH200 не составляет, однако в распоряжении NVIDIA имеется и 144-ядерный вариант Grace Superchip. Тестирование такой системы уже значится в планах Phoronix.

07.02.2024 [22:31], Владимир Мироненко

Северный браузерный ИИ: Opera развернёт в исландском дата-центре atNorth кластер NVIDIA DGX SuperPOD для обучения чат-бота AriaНорвежская компания Opera Software, разработчик браузера Opera, объявила о предстоящем запуске в этом месяце ИИ-кластера на базе NVIDIA DGX SuperPOD в дата-центре atNorth в Кеблавике (Исландия). Принадлежащий atNorth ЦОД ICE02 ёмкостью более 80 МВт имеет площадь 13 750 м2 и вмещает около 3000 стоек. С помощью нового кластера Opera будет обучать встроенный в браузер чат-бот Aria на основе ИИ. Как сообщается в пресс-релизе ИИ-кластер спроектирован так, чтобы оказывать минимально возможное воздействие на окружающую среду. Он использует гидроэлектрическую и геотермальную энергию для получения энергии, и пользуется преимуществами прохладного климата Исландии для охлаждения оборудования. Кластер на базе NVIDIA DGX SuperPOD оснащён ускорителями NVIDIA H100 и программной платформой NVIDIA AI Enterprise. «Aria быстро развивается, и мы продолжаем расширять его возможности в качестве помощника в навигации для наших пользователей», — сообщил Кристиан Зубель (Krystian Zubel), вице-президент ИТ-группы компании Opera. Как отметил представитель NVIDIA Карло Руис (Carlo Ruiz), компаниям, модернизирующим свой бизнес с помощью ИИ, требуется мощная инфраструктура для разработки больших языковых моделей (LLM) и создания приложений генеративного ИИ. «NVIDIA DGX SuperPOD с ускорителями NVIDIA H100 предоставляет Opera расширенные возможности супервычислений на базе ИИ, помогая разработчикам создавать новые функции, которые сделают опыт генеративного ИИ доступным для пользователей», — заявил он.

07.02.2024 [21:05], Владимир Мироненко

Серверы и сети: Cisco и NVIDIA расширили сотрудничество, чтобы упростить клиентам развёртывание ИИ-инфраструктурыCisco и NVIDIA объявили о расширении сотрудничества, чтобы предложить корпоративным клиентам масштабируемое и автоматизированное управление кластерами искусственного интеллекта (ИИ), автоматическое устранение неполадок, высокое качество обслуживания и многое другое, сообщается в пресс-релизе NVIDIA. Интегрированное ПО и сетевое оборудование двух компаний упростит клиентам развёртывание инфраструктуры для поддержки приложений ИИ. Соглашение предусматривает расширение роли сетей Ethernet в обработке рабочих нагрузок ИИ на предприятии, а также обеспечивает компаниям доступ к системам продаж друг друга и возможность взаимной поддержки.

Источник изображения: NVIDIA Специализированные сетевые решения Cisco и NVIDIA на базе Ethernet будут продаваться через обширный глобальный канал Cisco, предлагая профессиональные услуги и поддержку через ключевых партнёров. Клиентам будут доступны новейшие ускорители NVIDIA в стоечных и блейд-серверах Cisco M7 UCS, включая Cisco UCS X-Series и UCS X-Series Direct, для поддержки ИИ и рабочих нагрузок с интенсивным использованием данных в ЦОД и на периферии. Интегрированный пакет, который станет доступен во II квартале, будет включать ПО NVIDIA AI Enterprise с программными платформами, предварительно обученными моделями и инструментами разработки. Совместно проверенные эталонные архитектуры Cisco Validated Designs (CVD) упростят развёртывание и управление кластерами ИИ в любом масштабе в широком спектре вариантов использования: виртуализированные и контейнерные среды, конвергентные и гиперконвергентные системы. CVD для FlexPod и FlashStack для генеративного ИИ с ПО NVIDIA AI Enterprise будут доступны в этом месяце. Cisco упростила управление и эксплуатацию ИИ-инфраструктуры за счёт локального и облачного управления посредством Cisco Nexus Dashboard и Cisco Intersight. А поддержка Cisco ThousandEyes Digital Experience Monitoring поможет обеспечить аналитику на основе ИИ и автоматическое устранение проблем в сетях. Наконец, расширяемая платформа Cisco Observability Platform использует ИИ для контекстуализации и корреляции телеметрии в реальном времени. Как отметил ресурс Network World, NVIDIA внедрила множество реализаций ИИ, основанных на сети InfiniBand. Теперь компания также участвует в отраслевых усилиях по обеспечению того, чтобы Ethernet стал важнейшей основой для поддерживающих ИИ сетей в будущем. В частности, прошлой осенью компания, наконец, представила SuperNIC — 400GbE DPU для ИИ-нагрузок.

04.02.2024 [14:47], Сергей Карасёв

SoftIron, разработчик «первого настоящего частного облака», представил обновлённые узлы на чипах AMD, NVIDIA и SocionextКомпания SoftIron, позиционирующая себя в качестве разработчика «первого настоящего частного облака», анонсировала новые аппаратные решения, позволяющие поддерживать ресурсоёмкие приложения. Представленные устройства ориентированы на корпоративных и государственных заказчиков. SoftIron заявляет, что 76 % предприятий хотят запустить частное облако. Однако существующие решения не могут обеспечить тот же набор сервисов и возможностей, которые дают публичные облака. SoftIron предлагает платформу HyperCloud, которая, как утверждается, позволяет решить проблему путём развёртывания полнофункциональной локальной облачной инфраструктуры. Одним из преимуществ HyperCloud компания SoftIron называет быстроту внедрения: в базовой конфигурации система занимает половину серверной стойки, а на ввод в эксплуатацию требуется примерно полдня. Кроме того, HyperCloud обладает гибкой масштабируемостью: клиенты смогут наращивать вычислительные ресурсы, СХД и сетевые компоненты. Узлы HyperCloud можно добавлять или удалять по необходимости, а HyperCloud автоматически перенастраивает и перераспределяет рабочие нагрузки, хранилище и т. д. Платформа поддерживает простые в использовании порталы и развёртывание по модели «инфраструктура как код» на основе API.

Источник изображения: SoftIron В число представленных аппаратных решений вошли новые вычислительные модули на процессорах AMD EPYC с 64 ядрами (128 потоков), а также GPU-узлы с ускорителями NVIDIA. Кроме того, дебютировали решения на базе ASIC разработки Socionext. Для хранения данных SoftIron теперь предлагает узлы на базе HDD общей ёмкостью 48, 72, 120, 144, 216 и 240 Тбайт. Дополнительно клиенты могут заказать производительные решения на основе SSD на 56 и 112 Тбайт, а также узлы с NVMe SSD вместимостью 26 и 52 Тбайт. Анонсированы и новые сетевые модули с поддержкой 1GbE, 25GbE и 100GbE.

02.02.2024 [13:29], Сергей Карасёв

Lenovo построит в Германии энергоэффективный суперкомпьютер на базе AMD EPYC Genoa и NVIDIA H100

amd

epyc

genoa

h100

hardware

hpc

lenovo

nvidia

германия

отопление

суперкомпьютер

энергоэффективность

Компания Lenovo объявила о заключении контракта с Падерборнским университетом в Германии (University of Paderborn) на создание нового НРС-комплекса, мощности которого будут использоваться для обеспечения исследований в рамках Национальной программы высокопроизводительных вычислений (NHR). В основу суперкомпьютера лягут двухузловые серверы ThinkSystem SD665 V3. Конфигурация каждого узла включает два процессора AMD EPYC Genoa и до 24 модулей оперативной памяти DDR5-4800. Применена технология прямого жидкостного охлаждения Lenovo Neptune Direct Water Cooling (DWC). Кроме того, НРС-комплекс будет использовать GPU-серверы ThinkSystem SD665-N V3, несущие на борту четыре ускорителя NVIDIA H100, связанные между собой посредством NVLink. Общее количество ядер составит более 136 тыс. Для подсистемы хранения выбрана платформа IBM ESS 3500, обеспечивающая возможности гибкого использования SSD (NVMe) и HDD. Новый суперкомпьютер расположится в Падерборнском центре параллельных вычислений (PC2). Монтаж оборудования планируется произвести во II половине текущего года. За интеграцию будет отвечать pro-com DATENSYSTEME GmbH. Ожидается, что по сравнению с нынешней системой центра Noctua 2 (на изображении), построенной Atos, готовящийся суперкомпьютер будет обладать примерно вдвое более высокой производительностью. Быстродействие Noctua 2 составляет до 4,19 Пфлопс (Linpack) для CPU-ядер и до 1,7 Пфлопс (Linpack) для GPU-блоков.

Источник изображения: University of Paderborn Особое внимание при строительстве суперкомпьютера будет уделяться энергетической эффективности. Благодаря использованию источников питания с жидкостным охлаждением и полностью изолированных стоек более 97 % вырабатываемого тепла может быть передано непосредственно в систему циркуляции тёплой воды. Применение теплообменников и блоков распределения охлаждающей жидкости (CDU) обеспечивает температуру носителя в обратном контуре выше 45 °C, что позволяет повторно использовать генерируемое тепло.

02.02.2024 [13:13], Сергей Карасёв

Цена ИИ-ускорителя NVIDIA H20 для Китая составляет $12–$15 тыс.Компания NVIDIA, по сообщению Reuters, начала принимать предварительные заказы на новый ИИ-ускоритель H20, разработанный специально для Китая. Утверждается, что данное изделие стоит примерно столько же, сколько конкурирующий продукт Huawei — Ascend 910B. Отмечается, что в последние недели NVIDIA оценивает решение H20 в диапазоне от $12 тыс. до $15 тыс. Некоторые китайские дистрибьюторы уже предлагают этот ускоритель за $15 500. Для сравнения: Ascend 910B на местном рынке стоит приблизительно $16 900. Ради обхода санкционных ограничений, введённых властями США, компании NVIDIA пришлось снизить производительность H20 по сравнению со своими флагманскими чипами. По некоторым ключевым параметрам H20 уступает карте Ascend 910B. Вместе с тем, согласно имеющимся данным, H20 превосходит конкурирующее изделие Huawei с точки зрения скорости передачи данных между ускорителями внутри готовой системы.

Источник изображения: NVIDIA Reuters также сообщает, что серверы, оснащённые восемью ускорителями H20, доступны в Китае для заказа по цене примерно $197 тыс. Это практически на треть меньше по сравнению с системами, оборудованными восемью чипами H800: такие устройства в прошлом году стоили около $282 тыс. Китайские дистрибьюторы сообщили, что смогут начать поставлять ускорители H20 небольшими партиями в текущем квартале, тогда как массовые отгрузки запланированы на II четверть 2024 года. При этом любое ужесточение санкций со стороны США может поставить крест на продажах новинок.

01.02.2024 [14:08], Сергей Карасёв

Singtel и NVIDIA построят в Юго-Восточной Азии сеть дата-центров для ИИКомпания Singapore Telecommunication (Singtel), ведущий поставщик коммуникационных услуг в Сингапуре, и NVIDIA объявили о сотрудничестве, нацеленном на создание в Юго-Восточной Азии сети ЦОД для решения ресурсоёмких ИИ-задач. Речь идёт о запуске площадок с высокой энергетической эффективностью. Первый дата-центр, созданный в рамках партнёрства, появится в Сингапуре. В дальнейшем планируется запуск ЦОД в Индонезии и Таиланде. Для поддержания ИИ-нагрузок будут задействованы ускорители на архитектуре NVIDIA Hopper и эталонные решения NVIDIA AI. Отмечается, что дата-центры будут выполнять функции «суверенных национальных ресурсов» — фабрик ИИ, позволяющих безопасно обрабатывать собственные наборы данных компаний, стартапов, университетов и государственных организаций. Клиенты в числе прочего смогут внедрять сервисы на базе генеративного ИИ. Singtel стремится к демократизации ИИ и декарбонизации своей деятельности. Компания также станет облачным партнером NVIDIA, предоставляя оптимизированные ИИ-услуги.

Источник изображения: NVIDIA Singtel построит новые дата-центры под брендом Nxera. Клиенты смогут использовать фиксированную широкополосную связь и сети 5G для управления своими рабочими нагрузками ИИ в мультисетевой и мультиоблачной среде. Singtel намерена задействовать свою программную платформу Paragon для координации работы приложений ИИ. Телекоммуникационная компания также сотрудничает с рядом энергетических организаций, включая таиландскую Gulf Energy Development, индонезийскую Medco Power и TNB Renewables в Малайзии, чтобы гарантировать, что её ЦОД достигнут нулевого уровня выбросов к 2028 году. Сингапур активно закупает оборудование NVIDIA. Это небольшое государство оказалось на четвёртом месте среди источников выручки NVIDIA, обеспечив долю в 15 % в III квартале 2023 года. Вместе с тем ещё в 2019 году в Сингапуре был введён мораторий на строительство новых ЦОД. Впоследствии ограничения были ослаблены, но власти заявили о намерении жёстко регулировать деятельность дата-центров и облаков, приравняв их к объектам критической инфраструктуры. Летом прошлого года также стало известно, что Сингапур потратит более $7 млрд на расширение инфраструктуры подводных интернет-кабелей.

19.01.2024 [19:16], Руслан Авдеев

В DigitalOcean Paperspace появились ускорители NVIDIA H100Облачный провайдер DigitalOcean Holdings Inc. заявил о доступности ускорителей NVIDIA H100 на платформе Paperspace, купленной в июле 2023 года. Решение ориентировано на представителей малого и среднего бизнеса. Ускорители доступны по запросу, но можно и зарезервировать их на заданный период. В компании подчёркивают, что доступ к NVIDIA H100 предоставляется малому и среднему бизнесу и стартапам в то время, как многие другие облачные провайдеры предпочитают обслуживать крупных клиентов — это снижает порог вхождения мелких игроков на рынок высокопроизводительных вычислений. Ожидается, что новые решения обеспечат работу стартапов следующего поколения, дав доступ к инструментам, необходимым для создания передовых ИИ-продуктов. Paperspace предлагает готовую среду для разработки, обучения и развёртывания ИИ. Доступно два варианта инстансов: с одним H100, 20 vCPU и 250 Гбайт RAM или с восемью H100 (NVLink 3,2 Тбайт/с), 128 vCPU и 1536 Гбайт RAM. Зарезервировать можно оба варианта, а вот по запросу доступен только первый. В обоих случаях используется хранилище на базе SSD с поддержкой снимков, а инстансы работают под управлением Ubuntu. Инстанс с одним ускоритель пока что предлагается по промо-цене $6/час (посекундная тарификация), но со временем цена вырастет до $8,96/час. Стоимость зарезервированных инстансов начинается от $2,24/час за каждый ускоритель при бронировании на три года. |

|