Материалы по тегу: hpc

|

15.01.2025 [11:24], Владимир Мироненко

В совет директоров UALink вошли представители Alibaba, Apple и SynopsysКонсорциум Ultra Accelerator Link (UALink) объявил о расширении состава совета директоров представителями Alibaba Cloud, Apple и Synopsys. Новые члены совета будут использовать свои отраслевые знания для продвижения разработки и внедрения в отрасли UALink — высокоскоростного масштабируемого интерконнекта для производительных ИИ-кластеров следующего поколения, указано в пресс-релизе. Фактически UALink занят созданием более открытой альтернативы NVLink. С момента основания в конце октября 2024 года количество участников UALink выросло до более чем 65 компаний, сообщил Куртис Боуман (Kurtis Bowman), председатель совета директоров UALink. Новые участники совета директоров заявили, что совместная работа над интерконнектом для ускорителей будет способствовать повышению эффективности выполнения рабочих нагрузок ИИ. Представитель Apple отметил, что UALink демонстрирует большие перспективы в решении проблем подключения и создании новых возможностей ИИ-индустрии. В консорциум входит широкий круг компаний, от поставщиков облачных услуг и OEM-производителей до разработчиков ПО и полупроводниковых компонентов во главе с AMD, AWS, Astera Labs, Cisco, Google, HPE, Intel, Meta✴ и Microsoft, представляющих основные области разработки решений для повышения производительности нагрузок ИИ.

Источник изображения: UALink Ожидается, что выпуск спецификации UALink 1.0 состоится в I квартале 2025 года. Она предусматривает пропускную способность до 200 Гбит/с на линию и возможность объединения до 1024 ИИ-ускорителей в пределах одного домена.

15.01.2025 [08:38], Руслан Авдеев

Новые ЦОД стоимостью £14 млрд помогут Великобритании превратиться в ИИ-сверхдержавуВ рамках нового плана британского правительства по развитию ИИ-проектов анонсированы инициативы по созданию ЦОД на общую сумму £14 млрд ($16,96 млрд). Так, Vantage, Nscale и Kyndryl обязались инвестировать в местную цифровую инфраструктуру и создать 13 тыс. рабочих мест. Планом предусмотрено и строительство нового ИИ-суперкомпьютера, сообщает Datacenter Dynamics. Ещё до объявления новой программы правительства об инвестициях в британские ЦОД сообщили Blackstone (£10 млрд) и DC01UK (£3,75 млрд), а также Cloud HQ, CyrusOne, CoreWeave и ServiceNow (суммарно £6,3 млрд) В рамках программы AI Opportunities Action Plan, некоторые детали которой появились ещё в ноябре, по всей стране будут созданы «Зоны роста ИИ» с приоритетным доступом к технологиям и энергии, призванные привлечь инвестиции со всего мира. Зоны станут и полигоном для энергетических проектов, связанных с ЦОД. Особая роль отведена атомной энергетике. Первую зону построят в Калхэме (графство Оксфордшир), где находится Управление по атомной энергии Великобритании и расположены кампусы AWS и CloudHQ. Оператор NScale объявил о намерении инвестировать в Великобританию £2,5 млрд ($3 млрд), где построит свой первый ИИ ЦОД в графстве Эссекс мощностью 50 МВт с возможностью расширения до 90 МВт. В компании надеются ввести дата-центр в эксплуатацию в IV квартале 2026 года, разместив в нём до 45 тыс. NVIDIA GB200 и наняв 250 постоянных сотрудников. В других графствах NScale начнёт строить модульные ЦОД во II половине 2025 года, а впоследствии будет развивать и стационарные дата-центры. Vantage Data Centers построит кампус на 10 зданий на месте бывшего автозавода Ford в Уэльсе. Речь идёт об инвестициях £12 млрд ($14,55 млрд) и создании 11,5 тыс. рабочих мест. Ещё в 2020 году Vantage приобрела Next Generation Data, управляющую дата-центрами в Уэльсе и Лондоне. Наконец, Kyndryl создаст 1 тыс. рабочих мест, связанных с ИИ, в новом технологическом центре в Ливерпуле, который построят в следующие три года. Ранее власти отнесли дата-центры к критически важной инфраструктуре (CNI) и пообещали реформировать законы о планировании, чтобы упростить строительство новых объектов. Более того, заново рассматриваются заявки, которые были отклонены. Например, в декабре дали «зелёный свет» отменённому годом ранее проекту в Бакингемшире. По словам премьер-министра Кира Стармера (Keir Starmer), индустрии ИИ нужно правительство, которое примет её сторону и не позволит упустить возможности развития. По словам министра, план сделает Великобританию мировым лидером в области ИИ, даст отрасли опору и импульс. Благодаря этому появится больше рабочих мест, больше денег у населения и, наконец, будет реформирована система государственных услуг. Подробнее о плане рассказывается на сайте самого британского правительства. Также Великобритания планирует построить ИИ-суперкомпьютер. Данных о нём пока немного, но Департамент науки, инноваций и технологий (DSIT) сообщил, что его создание — один из элементов плана по двадцатикратному увеличению вычислительных мощностей страны к 2030 году. Примечательно, что в прошлом году власти отложили реализацию HPC-проектов на £1,3 млрд, сославшись на нехватку средств. В том числе было отменено создание первого в стране экзафлопсного суперкомпьютера при Эдинбургском университете.

28.12.2024 [12:42], Сергей Карасёв

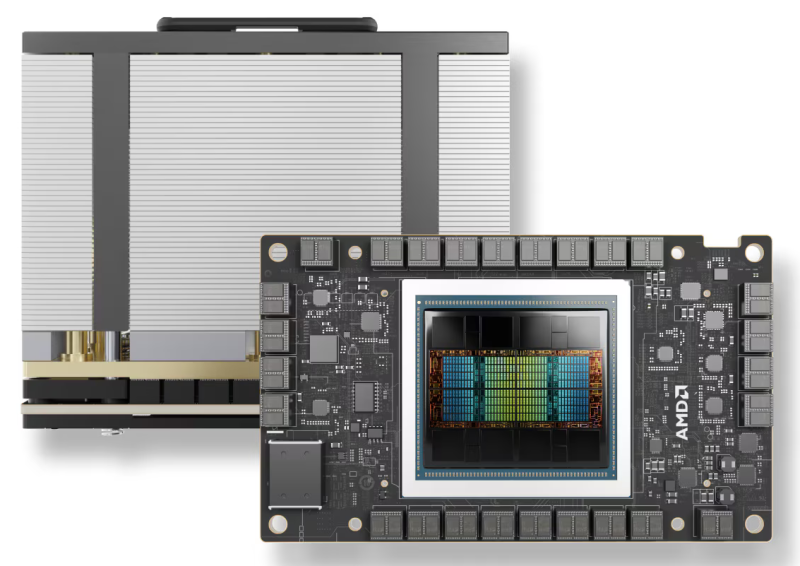

Итальянская нефтегазовая компания Eni запустила суперкомпьютер HPC6 с производительностью 478 ПфлопсИтальянский нефтегазовый гигант Eni запустил вычислительный комплекс HPC6. На сегодняшний день это самый мощный суперкомпьютер в Европе и один из самых производительных в мире: в свежем рейтинге TOP500 он занимает пятую позицию. О подготовке HPC6 сообщалось в начале 2024 года. В основу системы положены процессоры AMD EPYC Milan и ускорители AMD Instinct MI250X. Комплекс выполнен на платформе HPE Cray EX4000 с хранилищем HPE Cray ClusterStor E1000 и интерконнектом HPE Slingshot 11. В общей сложности в состав HPC6 входят 3472 узла, каждый из которых несёт на борту 64-ядерный CPU и четыре ускорителя. Таким образом, суммарное количество ускорителей Instinct MI250X составляет 13 888. Суперкомпьютер обладает FP64-быстродействием 477,9 Пфлопс в тесте Linpack (HPL), тогда как пиковый теоретический показатель достигает 606,97 Пфлопс. Максимальная потребляемая мощность системы составляет 10,17 МВА. Комплекс HPC6 смонтирован на площадке Eni Green Data Center в Феррера-Эрбоньоне: это, как утверждается, один из самых энергоэффективных и экологически чистых дата-центров в Европе. Новый суперкомпьютер оснащён системой прямого жидкостного охлаждения, которая способна рассеивать 96 % вырабатываемого тепла. ЦОД, где располагается HPC6, оборудован массивом солнечных батарей мощностью 1 МВт. Как отмечает ресурс Siliconangle, на создание суперкомпьютера потрачено более €100 млн. Применять комплекс планируется, в частности, для оптимизации работы промышленных предприятий, повышения точности геологических и гидродинамических исследований, разработки источников питания нового поколения, оптимизации цепочки поставок биотоплива, создания инновационных материалов и моделирования поведения плазмы при термоядерном синтезе с магнитным удержанием.

28.12.2024 [12:16], Сергей Карасёв

Xiaomi создаст ИИ-кластер с 10 тыс. GPUКитайская компания Xiaomi, по сообщению Jiemian News, намерена создать собственный вычислительный кластер для решения ресурсоёмких задач в области ИИ. Предполагается, что в основу системы лягут около 10 тыс. ускорителей на базе GPU. Отмечается, что Xiaomi активно развивает направление ИИ. Соответствующее подразделение было сформировано ещё в 2016 году, и с тех пор его штат увеличился примерно в шесть раз — до более чем 3000 сотрудников (включая специалистов, задействованных в смежных областях). С начала 2024 года Xiaomi использует для проектов ИИ вычислительную платформу, насчитывающую около 6500 ускорителей на основе GPU. В дальнейшем количество GPU планируется наращивать. Инициативы Xiaomi в области ИИ курирует генеральный директор компании Лэй Цзюнь (Lei Jun).

Источник изображения: Xiaomi Проекты Xiaomi в сфере ИИ охватывают самые разные направления, включая компьютерное зрение, обработку естественного языка, графы знаний, машинное обучение, большие языковые модели (LLM) и мультимодальные технологии. Эти технологии по мере развития интегрируются в смартфоны, автомобильные бортовые системы, робототехнику, а также в интеллектуальные устройства Интернета вещей (AIoT). Ранее Цзюнь сообщил, что Xiaomi успешно адаптировала LLM для локального использования на мобильных устройствах: утверждается, что модель с 1,3 млрд параметров достигла сопоставимой с облаком производительности в некоторых сценариях. Кроме того, компания создала более мощную LLM с 6 млрд параметров. Говорится также, что Xiaomi сотрудничает с другими участниками рынка в рамках развития проектов ИИ: в число партнёров входят Qualcomm и MediaTek.

28.12.2024 [11:35], Сергей Карасёв

Обнародован рейтинг Тор-100 суперкомпьютеров Китая: систем экзафлопсного класса в нём нетОбщество компьютерных наук Китая обнародовало свежий рейтинг 100 самых производительных суперкомпьютеров страны. Как отмечает ресурс Tom's Hardware, власти КНР, похоже, скрывают свой истинный вычислительный потенциал. Дело в том, что в опубликованном списке Тор-100 не только нет систем экзафлопсного класса, но и не представлено ни одной новой машины за год. В тройку лидеров в 2024 году вошли те же самые гетерогенные системы (CPU + GPU), которые возглавляли рейтинг в 2023-м. На первом месте располагается комплекс, обладающий FP64-быстродействием 487,94 Пфлопс в тесте Linpack (HPL) и пиковой производительностью на уровне 620 Пфлопс. Эта система, введённая в эксплуатацию в 2023 году, насчитывает в общей сложности 15 974 400 ядер CPU.

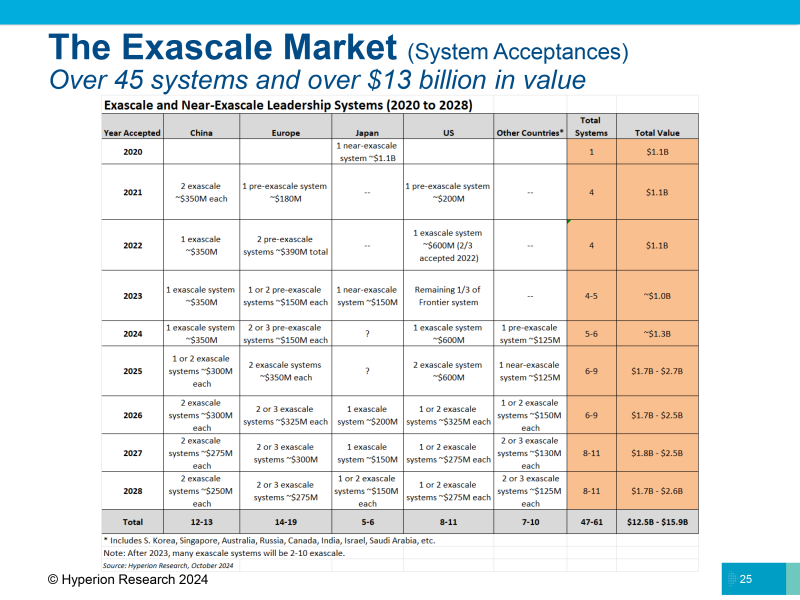

Источник изображения: Xinhua На второй позиции списка находится машина, запущенная в 2022 году: она использует 460 000 ядер CPU. Заявленное быстродействие составляет 208,26 Пфлопс, пиковое значение — 390 Пфлопс. Замыкает тройку система с 285 000 тыс. CPU-ядер, введённая в эксплуатацию в 2021-м: у неё показатели производительности достигают 125,04 и 240 Пфлопс. Фактически, как отмечается, единственное различие между списками Тор-100 суперкомпьютеров Китая от 2023 и 2024 годов заключается в их совокупной мощности, но даже этот показатель вырос незначительно — с 1,398 Эфлопс до 1,406 Эфлопс. Для сравнения: самый производительный в мире суперкомпьютер — американская система El Capitan — обладает быстродействием 1,742 Эфлопс. По косвенным признакам понятно, что у Китая есть несколько машин экзафлопсного класса. По оценкам Hyperion Research, в КНР развёрнуто уже пять подобных систем. Эти сведения официально не подтверждены, но участники рынка говорят, что китайские организации намеренно скрывают информацию о своих самых мощных НРС-системах, чтобы не спровоцировать дополнительные ограничения со стороны США. С 2021 года китайские компании не подают заявки на участие в рейтинге TOP500.

19.12.2024 [23:05], Руслан Авдеев

Терабитный «гиперинтернет» напрямую свяжет европейские квантовые и суперкомпьютерыЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) начло подгтовку к созданию передовых сетей, которые соединят суперкомпьютеры, квантовые компьютеры и дата-центры Евросоюза. Это позволит создать гиперсвязанную объединённую экосистему HPC и квантовых вычислений, сообщает HPC Wire. Сеть с пропускной способностью в несколько Тбит/с охватит не только площадки EuroHPC, но и национальные и региональные суперкомпьютеры и ЦОД, которые в консорциум не входят. Это позволит сформировать инфраструктуру будущего, поддерживающую самые передовые разработки, ИИ и цифровые инновации в континентальном масштабе, учитывающие критические проблемы вроде климатической устойчивости и общественного здоровья.

Истчоник изображения: EuroHPC JU «Гиперинтернет» объединит европейские системы в единую цифровую экосистему, позволяющую совместить самые разные технологии. Разработанная для HPC и Big Data сеть будет использовать самые передовые архитектуры, обеспечивая высокую скорость и производительность в целом. Объединённая инфраструктура, как ожидается, будет способствовать европейскому лидерству в суперкомпьютерных вычислениях и инновациях, обеспечивая качественную устойчивую связь в зоне обслуживания. Инициатива EuroHPC пока касается исключительно членов Евросоюза, дополнительные критерии соответствия требованиям можно найти на специальной странице. Создание сервисов «гиперсвязи» планируется с середины 2025 по середину 2029 гг.

19.12.2024 [10:27], Сергей Карасёв

Стартап xAI начал монтаж суперускорителей NVIDIA GB200 NVL72 для ИИ-кластера ColossusСтартап xAI Илона Маска (Elon Musk), по сообщению ресурса ServeTheHome, приступил к расширению мощности ИИ-кластера Colossus. Речь идёт о монтаже суперускорителей NVIDIA GB200 NVL72 на архитектуре Blackwell. В начале сентября уходящего года компания xAI запустила ИИ-суперкомпьютер Colossus, в основу которого изначально легли 100 тыс. ускорителей NVIDIA H100. Сообщалось, что в дальнейшем количество ускорителей NVIDIA планируется увеличить вдвое. В начале декабря стартап получил $6 млрд инвестиций с целью увеличения числа ускорителей в составе Colossus до 1 млн штук. Отмечалось, что проект по расширению ИИ-кластера реализуется в партнёрстве с NVIDIA, Dell и Supermicro. Вместе с тем ранее появилась информация, что Dell перехватила у Supermicro крупный заказ на ИИ-серверы для xAI. Судя по всему, именно Dell является поставщиком систем GB200 NVL72 для комплекса Colossus. На днях специалист xAI Удай Руддарраджу (Uday Ruddarraju) опубликовал на своей странице в социальной сети Х фотографию новых серверных модулей в составе Colossus. На снимке видны вычислительные узлы и лотки с коммутаторами NVLink. Наблюдатели отмечают, что компоненты пока не подключены к основной сети, на что указывает отсутствие оптоволоконных соединений. Вместе с тем уже подсоединены низкоскоростные сети управления. В узлах установлены карты NVIDIA Bluefield-3. В отражении от шара с логотипом xAI просматриваются стойки с оборудованием. Предположительно, это системы производства Dell. Ранее глава этой компании Майкл Делл (Michael Dell) объявил о начале поставок первых в мире серверных стоек GB200 NVL72. Кроме того, Dell представила систему PowerEdge XE9712, которая использует архитектуру суперускорителя GB200 NVL72.

17.12.2024 [08:38], Руслан Авдеев

В 2025 году в Европе появится сразу семь ИИ-фабрик EuroHPC

eurohpc

hardware

hpc

llm

германия

греция

европа

евросоюз

ии

испания

италия

люксембург

суперкомпьютер

финляндия

швеция

Консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory), которые появятся В 2025 году в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Всего в проекте участвуют 17 стран. В Финляндии, Германии, Италии, Люксембурге и Швеции будут установлены новые ИИ-суперкомпьютеры. В Испании фабрика будет создана путём модернизации суперкомпьютера MareNostrum 5. В Греции фабрика будет связана с суперкомпьютером DAEDALUS, внедрение которого происходит сейчас. В Испании и Финляндии AI Factory будут включать в себя экспериментальную платформу, которая послужит передовой инфраструктурой для разработки и тестирования инновационных ИИ-моделей и приложений. Первые семь фабрик объединят как ресурсы отдельных стран, так и ресурсы ЕС в целом. Инициатива EuroHPC AI Factories призвана создать надёжную и взаимосвязанную сеть ИИ-хабов, которые предоставят ИИ-стартапам, малому и среднему бизнесу и исследователям комплексную поддержку, включая доступ к оптимизированным для ИИ и HPC ресурсам, обучению и техническому опыту. Финская ИИ-фабрика предложит передовую вычислительную платформу LUMI-AI и доступ к новым источникам данных, а также сервисному центру и кадровому резерву. Систему разместят в IT-центре CSC, расположенном в Каяани рядом с действующим суперкомпьютером LUMI. В консорциуме LUMI AI Factory помимо Финляндии участвуют Чехия, Дания, Эстония, Норвегия и Польша. В Германии на базе HammerHAI (Hybrid and Advanced Machine Learning Platform for Manufacturing, Engineering, And Research @ HLRS) будет создан единый центр для промышленности и академических кругов. Особое внимание будет уделяться барьерам, в настоящее время мешающим использовать ИИ стартапам и бизнеса. Новая облачная ИИ-платформа разместится в HPC-центре Штутгарта (HLRS) и будет создана при участии GWDG, BADW-LRZ, KIT и SICOS. HammerHAI обеспечит комплексную поддержку на протяжении всего цикла разработки ИИ, от обучения модели до инференса, а также поддержку пользователей и профессиональное образование. Также будут подготовлены базовые модели и наборы данных. Греческая ИИ-фабрика Pharos будет использовать суперкомпьютер DAEDALUS для решения задач Греции и ЕС в области здравоохранения, культуры и языка, а также устойчивого развития (энергетика, окружающая среда, климат). Предполагается комплексная поддержка пользователей, включая повышение квалификации, предоставление датасетов и обучение ИИ-моделей, а также поддержка бизнес-инноваций. Платформа будет управляться Национальной инфраструктурой исследований и технологий GRNET S.A. в Афинах, действующей под патронажем Министерства цифрового управления Греции. Особое внимание будет уделяться созданию ИИ-решений, соответствующих требованиям ЕС и отдельных индустрий. ИИ-фабрика IT4LIA, совместно создаваемая Италией, Австрией и Словенией, предоставит инфраструктуру ИИ и экосистему, которая объединит исследователей, разработчиков, стартапы и малый и средний бизнес. Это упростит доступ к ИИ-ресурсам государственным органам, студентам, учёным и бизнесу. Новая система будет сформирована в CINECA Consorzio Interuniversitario в Болонье как дополнение к суперкомпьютеру LEONARDO. ИИ-кластер производительностью более 40 Эфлопс (смешанная точность вычислений) будет в основном использоваться для внедрения ИИ в агросекторе, кибербезопасности, землепользовании и производстве. Люксембургу достанется L-AI Factory на базе ИИ-суперкомпьютера MeluXina-AI, который будет соседствовать с действующим суперкомпьютером MeluXina. Местная AI Factory призвана укрепить позиции страны в качестве европейского лидера в сфере ИИ. AI Factory обеспечит быструю адаптацию и персонализированную поддержку для всех предприятий, особенно стартапов и малого и среднего бизнеса. BSC AI Factory — совместная инициатива Испании, Португалии, Турции и Румынии, представленных Барселонским суперкомпьютерным центром (BSC-CNS), Фондом науки и технологий (FCT) и Советом научных и технологических исследований Турции (TÜBİTAK), и Национальным институтом исследований и разработок в области информатики (ICI, Бухарест). Система обеспечит внедрение ИИ в промышленности, стартапах, малом и среднем бизнесе и государственных организациях.

Источник изображения: BSC Фабрика ориентирована на услуги для государственного управления, здравоохранения, фармацевтики и биотехнологий, финансов и права, сельского хозяйства и климата, государственного сектора, энергетики, связи и средств массовой информации. В числе прочего предусмотрена модернизация суперкомпьютера MareNostrum 5 — BSC AI Factory станет частью Суперкомпьютерного центра Барселоны (BSC-CNS). Наконец, AI Factory MIMER будет организована Национальной академической суперкомпьютерной инфраструктурой (NAISS) Швеции в Университете Линчепинга в сотрудничестве с исследовательскими институтами Швеции (RISE). MIMER получит специализированный ИИ-суперкомпьютер среднего уровня, причём приоритет отдаётся облачному доступу и предоставление масштабного хранилища конфиденциальных данных. MIMER будет наращивать опыт использования ИИ в области естественных наук и здравоохранения, материаловедения, автономных систем и игровой индустрии. Проект будет сосредоточен на генеративных моделях в структурной биологии и разработке лекарств, персонализированной медицине и работе с международными партнёрами над разработкой базовых моделей следующего поколения, которые будут настроены для конкретных целей.

15.12.2024 [13:00], Сергей Карасёв

Vultr запустил облачный ИИ-кластер на базе AMD Instinct MI300XКрупнейший в мире частный облачный провайдер Vultr объявил о заключении соглашения о четырёхстороннем стратегическом сотрудничестве с целью развёртывания нового суперкомпьютерного кластера. В проекте принимают участие AMD, Broadcom и Juniper Networks. Применяются ускорители AMD Instinct MI300X и открытый программный стек ROCm. Данные о количестве ускорителей и общей производительности платформы пока не раскрываются. Кластер размещён в дата-центре Vultr Centersquare в Лайле (юго-западный пригород Чикаго; Иллинойс; США). Новая НРС-система построена с использованием Ethernet-коммутаторов Broadcom и оптимизированных для ИИ-задач сетевых Ethernet-решений Juniper Networks. Благодаря этим компонентам, как утверждается, возможно построение безопасной высокопроизводительной инфраструктуры. Кластер ориентирован прежде всего на обучение ИИ-моделей и ресурсоёмкие нагрузки инференса. «Сотрудничество с AMD, Broadcom и Juniper Networks позволяет предприятиям и специалистам в области ИИ использовать весь потенциал ускоренных вычислений при одновременном обеспечении гибкости, масштабируемости и безопасности», — говорит Джей Джей Кардвелл (J.J. Kardwell), генеральный директор Vultr. О доступности Instinct MI300X в своей облачной инфраструктуре компания Vultr сообщила в сентябре нынешнего года. Ускорители AMD интегрируются с Vultr Kubernetes Engine for Cloud GPU для формирования кластеров Kubernetes, использующих ускорители. Предложение ориентировано на задачи ИИ и НРС. Vultr ставит своей целью сделать высокопроизводительные облачные вычисления простыми в использовании и доступными для предприятий и разработчиков по всему миру. На сегодняшний день экосистема Vultr включает 32 облачные зоны, в том числе площадки в Северной Америке, Южной Америке, Европе, Азии, Австралии и Африке.

14.12.2024 [15:25], Сергей Карасёв

HPE создаст HPC-систему Blue Lion для Суперкомпьютерного центра имени ЛейбницаСуперкомпьютерный центр имени Лейбница (LRZ) в Германии, управляемый Баварской академией наук в Мюнхене (BADW), объявил о подписании соглашения с HPE на строительство HPC-комплекса нового поколения. Проект получил название Blue Lion. LRZ, входящий в состав Суперкомпьютерный центр имени Гаусса (GCS), намерен запустить систему Blue Lion в 2027 году. Предполагается, что комплекс не только ускорит выполнение задач в области классического моделирования, но и откроет новые возможности для достижений в сфере ИИ. В основу Blue Lion ляжет платформа HPE Cray нового поколения с ускорителями NVIDIA. Говорится о применении интерконнекта HPE Slingshot с пропускной способностью до 400 Гбит/с. По производительности Blue Lion примерно в 30 раз превзойдёт предшественника — систему SuperMUC-NG, которая обеспечивает теоретическое пиковое быстродействие в 26,9 Пфлопс.

Источник изображения: GCS Blue Lion будет использовать на 100 % прямое жидкостное охлаждение тёплой водой температурой до +40 °C, протекающей по медным трубкам. Нагретую воду планируется повторно использовать для отопления помещений самого LRZ, а также соседних учреждений в Гархинге. Утверждается, что такая СЖО расходует примерно на 94 % меньше энергии в процессе работы, чем сопоставимая по классу система воздушного охлаждения. Blue Lion также потребует значительно меньше места для размещения благодаря более высокой плотности монтажа. Проект Blue Lion в равных долях финансируется Министерством науки и искусства Баварии (StMWK) и Федеральным министерством образования и исследований (BMBF). Затраты на создание суперкомпьютера оцениваются в €250 млн с учётом эксплуатационных расходов до 2032 года. |

|