Материалы по тегу: hpc

|

18.11.2024 [13:38], Руслан Авдеев

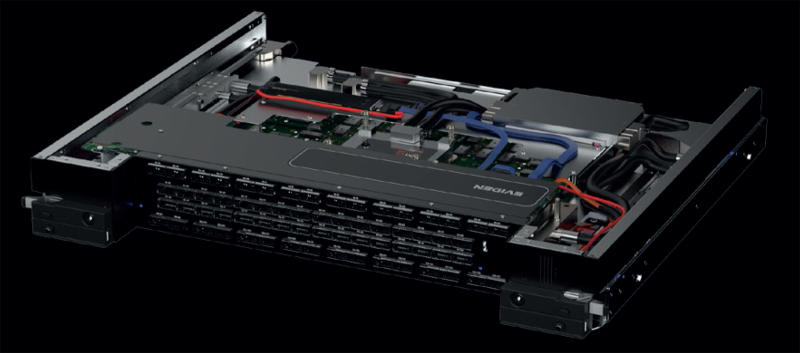

Foxlink запустила мощнейший на Тайване суперкомпьютер для малого и среднего бизнесаFoxlink Group (Cheng Uei Precision Industry) открыла крупнейший на Тайване суперкомпьютерный центр Ubilink (Ubilink.AI). По данным DigiTimes, центр предназначен для обслуживания предприятий малого и среднего бизнеса (SME), которые не могут позволить себе собственных вычислительных мощностей. Хотя основной деятельностью Foxlink является производство разъёмов, компания расширяет бизнес, осваивая решения для управления электропитанием и коммуникаций, а также выпуск энергетических модулей. Центр Ubilink создан дочерней Shinfox Energy совместно с Asustek Computer и японской Ubitus, занимающейся предоставлением облачных услуг. В Ubitus сообщили, что инфраструктура Ubilink включает 128 серверов Asus, 1024 ускорителя NVIDIA H100 и интерконнект NVIDIA Quantum-2 InfiniBand. Конфигурация обеспечивает до 45,82 Пфлопс (FP64) — система занимает 31-е место в рейтинге TOP500. В будущем станут применять и более современные B100 и B200 — когда те будут доступны. Ожидается, что в 2025 году суммарно будет установлено 10 240 ускорителей H100, B100 и B200. Представители местных властей уже заявили, что Ubilink существенно улучшит позиции Тайваня на рынке ИИ-вычислений, на котором территория сегодня занимает 26-е место. В Asustek добавляют, что достигнутая производительность в 45,82 Пфлопс заметно превышает плановые 40 Пфлопс. Кроме того, центр имеет PUE на уровне 1,2 — ранее ожидалось, что удастся добиться энергоэффективности лишь на уровне 1,38. Благодаря использованию опыта Shinfox Energy в области возобновляемой энергетики, Ubilink стал первым в Азии суперкомпьютерным центром, использующим «зелёные» источники энергии — клиенты могут воспользоваться вычислениями без существенного ущерба окружающей среде.

Источник изображения: UBITUS Предполагается, что Ubilink компенсирует отсутствие мощностей для местных малых и средних компаний, не имеющих доступа к значительным вычислительным ресурсам. Предлагая доступные вычислительные мощности, центр позволяет таким бизнесам расширить свои портфели предложений и конкурировать даже на мировом уровне. Суперкомпьютер уже востребован местными разработчиками чипов, компаний, занимающихся их упаковкой и тестированием, биотехнологическими бизнесами, а также исследовательскими институтами различной направленности. Из-за высокого спроса Foxlink уже рассматривает вторую и третью фазы расширения проекта.

17.11.2024 [11:32], Сергей Карасёв

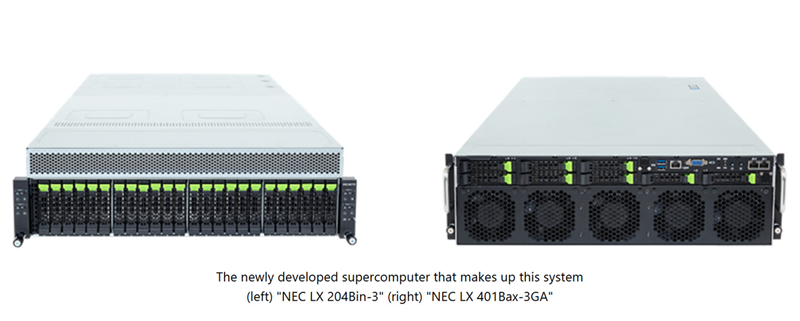

NEC создаст в Японии суперкомпьютер на базе Intel Xeon 6900P и AMD Instinct MI300A для исследований термоядерного синтезаКорпорация NEC займётся созданием нового НРС-комплекса, который планируется ввести в эксплуатацию в Японии в июле 2025 года. Система, базирующаяся на компонентах AMD и Intel, будет использоваться для различных исследований и разработок в области термоядерного синтеза. Заказ на создание суперкомпьютера поступил от Национальных институтов квантовой науки и технологий Японии (QST) при Национальном агентстве исследований и разработок (ANID), а также от Национального института термоядерных наук (NIFS) в составе Национальных институтов естественных наук (NINS). Система будет установлена в Институте термоядерной энергии Rokkasho (входит в QST) в Аомори (Япония). Основой проектируемого суперкомпьютера послужат 360 узлов NEC LX 204Bin-3, в состав каждого из которых войдут два процессора Intel Xeon 6900P поколения Granite Rapids (всего 720 чипов) и память DDR5 MRDIMM. Кроме того, будут задействованы 70 узлов NEC LX 401Bax-3GA, несущих на борту по четыре ускорителя AMD Instinct MI300A (в общей сложности 280 изделий). Говорится о применении интерконнекта InfiniBand с 400G-коммутаторами NVIDIA QM9700, а также хранилища DDN EXAScaler ES400NVX2 вместимостью 42,2 Пбайт с файловой системой Lustre. Для управления рабочими нагрузками будет использоваться софт Altair PBS Professional.

Источник изображения: NEC Ожидается, что производительность суперкомпьютера достигнет 40,4 Пфлопс. Это в 2,7 раза больше суммарных показателей двух нынешних НРС-систем, установленных в рамках независимых проектов QST и NIFS. Учёные намерены применять новый НРС-комплекс для точного прогнозирования экспериментов и создания сценариев работы для Международного экспериментального термоядерного реактора (ITER). Кроме того, мощности суперкомпьютера будут востребованы исследовательскими группами токамака Satellite Tokamak JT-60SA и электростанции DEMO (DEMOnstration Power Plant), использующей термоядерный синтез.

16.11.2024 [20:59], Сергей Карасёв

Стартап xAI Илона Маска получит от арабов $5 млрд на покупку ещё 100 тыс. ускорителей NVIDIAКак сообщает CNBC, стартап xAI Илона Маска (Elon Musk) привлёк многомиллиардные инвестиции: деньги будут направлены на закупку ускорителей NVIDIA для расширения вычислительных мощностей ИИ-суперкомпьютера. Напомним, в начале сентября нынешнего года компания xAI запустила ИИ-кластер Colossus со 100 тыс. ускорителей NVIDIA H100. В составе платформы применяются серверы Supermicro, узлы хранения типа All-Flash, адаптеры SuperNIC, а также СЖО. Суперкомпьютер располагается в огромном дата-центре в окрестностях Мемфиса (штат Теннесси). Как теперь стало известно, в рамках нового раунда финансирования xAI привлечёт $6 млрд. Из них $5 млрд поступит от суверенных фондов Ближнего Востока, а ещё $1 млрд — от других инвесторов, имена которых не раскрываются. При этом рыночная стоимость стартапа достигнет $50 млрд. О том, что xAI получит дополнительные средства на развитие, также сообщает Financial Times. По данным этой газеты, речь идёт о $5 млрд при капитализации стартапа на уровне $45 млрд.

Источник изображения: NVIDIA Ранее Маск говорил о намерении удвоить производительность Colossus: для этого, в частности, планируется приобрести примерно 100 тыс. ИИ-ускорителей, включая 50 тыс. изделий NVIDIA H200. Судя по всему, привлеченные средства стартап также направит на покупку других решений NVIDIA, в том числе коммутаторов Spectrum-X SN5600 и сетевых карт на базе BlueField-3. Между тем жители Мемфиса выражают недовольство в связи с развитием ИИ-комплекса xAI. Активисты, в частности, обвиняют стартап в том, что используемые на территории его дата-центра генераторы ухудшают качество воздуха в регионе.

16.11.2024 [20:49], Сергей Карасёв

Сандийские национальные лаборатории запустили ИИ-систему Kingfisher на огромных чипах Cerebras WSE-3Сандийские национальные лаборатории (SNL) Министерства энергетики США (DOE) в рамках партнёрства с компанией Cerebras Systems объявили о запуске кластера Kingfisher, который будет использоваться в качестве испытательной платформы при разработке ИИ-технологий для обеспечения национальной безопасности. Основой Kingfisher служат узлы Cerebras CS-3, которые выполнены на фирменных ускорителях Wafer Scale Engine третьего поколения (WSE-3). Эти гигантские изделия содержат 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт памяти SRAM. Суммарная пропускная способность встроенной памяти достигает 21 Пбайт/с, внутреннего интерконнекта — 214 Пбит/с. На сегодняшний день платформа Kingfisher объединяет четыре узла Cerebras CS-3, а конечная конфигурация предусматривает использование восьми таких блоков. Узлы Cerebras CS-3 мощностью 23 кВт каждый содержат СЖО, подсистемы питания, сетевой интерконнект Ethernet и другие компоненты.

Источник изображения: SNL Развёртывание кластера Cerebras CS-3 является частью программы Advanced Simulation and Computing (ASC), которая реализуется Национальным управлением по ядерной безопасности США (NNSA). Речь идёт, в частности, об инициативе ASC Artificial Intelligence for Nuclear Deterrence (AI4ND) — искусственный интеллект для ядерного сдерживания. Предполагается, что Kingfisher позволит разрабатывать крупномасштабные и надёжные модели ИИ с использованием защищённых внутренних ресурсов Tri-lab — группы, в которую входят Сандийские национальные лаборатории, Ливерморская национальная лаборатория имени Лоуренса (LLNL) и Лос-Аламосская национальная лаборатория (LANL) в составе (DOE).

15.11.2024 [10:31], Сергей Карасёв

Eviden представила интерконнект BullSequana eXascale третьего поколения для ИИ-системКомпания Eviden (дочерняя структура Atos) анонсировала BullSequana eXascale Interconnect (BXI v3) — интерконнект третьего поколения, специально разработанный для рабочих нагрузок ИИ и HPC. Технология станет доступа на рынке во II половине 2025 года. Отмечается, что существующие высокоскоростные сетевые решения недостаточно эффективны, поскольку не устраняют критическое узкое место, известное как «сетевая стена». По заявлениям Eviden, зачастую при крупномасштабном обучении ИИ компании наращивают количество ускорителей, однако на самом деле ограничивающим фактором является интерконнект. Хотя поставщики сетевых решений продолжают удваивать пропускную способность каждые несколько лет, этого недостаточно для решения проблемы. В результате, до 70 % времени GPU простаивают, ожидая получения данных из-за задержек, утверждает Eviden. Технология BXI v3 призвана устранить этот недостаток.

Источник изображений: Eviden Новый интерконнект использует стандарт Ethernet в качестве базового протокола связи. При этом реализованы функции, которые обычно характерны для масштабируемых сетей высокого класса, таких как Infiniband. Отмечается, что BXI v3 обеспечивает низкие задержки (менее 200 нс от порта к порту), высокую пропускную способность, упорядоченную (in order) доставку пакетов, расширенное управление перегрузками и масштабируемость. Технология BXI v3 ляжет в основу интеллектуального сетевого адаптера (Smart NIC) нового поколения, который поможет снизить влияние задержек сети на GPU и CPU. При использовании такого решения ускоритель ИИ выгружает данные на сетевой адаптер и сразу же переходит к другим задачам, что устраняет неэффективность, связанную с простоями. Подчёркивается, что протокол BXI v3 интегрируется непосредственно в Smart NIC, благодаря чему оборудование работает сразу после установки, а в приложения не требуется вносить какие-либо изменения. Кроме того, новая технология предоставляет ряд дополнительных функций, ориентированных на повышение производительности путём оптимизации системных операций и обработки данных. В частности, BXI v3 обеспечивает прозрачную трансляцию виртуальных адресов в физические, что позволяет приложениям напрямую отправлять запросы в SmartNIC с использованием виртуальных адресов без необходимости системных вызовов. Такой подход повышает эффективность, обеспечивая бесперебойное управление памятью при сохранении высокой производительности. Технология BXI v3 также позволяет регистрировать до 32 млн приёмных буферов, которые SmartNIC выбирает с помощью ключей сопоставления на основе атрибутов сообщения. Благодаря этому уменьшается нагрузка на CPU, что повышает общую эффективность системы. Кроме того, сетевой адаптер способен выполнять математические атомарные операции, что дополнительно высвобождает ресурсы CPU. Впрочем, деталей пока мало, зато говорится об участии в консорциуме Ultra Ethernet (UEC) и партнёрстве с AMD.

14.11.2024 [08:17], Владимир Мироненко

SoftBank построит в Японии первый в мире ИИ-суперкомпьютер на базе NVIDIA DGX B200NVIDIA объявила о серии совместных проектов с SoftBank, направленных на ускорение суверенных инициатив Японии в области ИИ, которые также обеспечат возможность получения дохода от ИИ для поставщиков телекоммуникационных услуг по всему миру. В выступлении на саммите NVIDIA AI Summit Japan генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) объявил, что SoftBank создаёт самый мощный в Японии ИИ-суперкомпьютер с использованием платформы NVIDIA DGX SuperPOD B200 и интерконнекта Quantum-2 InfiniBand. Эта система станет первой в мире, которая получит системы DGX B200. Она будет использоваться компанией для разработки генеративного ИИ и развития других бизнес-решений, а также для предоставления вычислительных услуг университетам, научно-исследовательским институтам и предприятиям в стране. Суперкомпьютер идеально подойдёт для разработки больших языковых моделей (LLM), говорится в пресс-релизе. Пока что на звание самого мощного ИИ-суперкомьютера Японии претендует система ABCI 3.0 на базе NVIDIA H200. Впрочем, Softbank не сидит сложа руки и планирует построить ещё один суперкомпьютер, на этот раз на базе суперускорителей GB200 NVL72. Они же будут использоваться в проекте Sharp, KDDI и Supermicro по созданию «крупнейшего в Азии» ИИ ЦОД. Также в ходе саммита было объявлено, что SoftBank, используя платформу ускоренных вычислений NVIDIA AI Aerial, успешно запустил первую в мире телекоммуникационную сеть, объединяющую возможности ИИ и 5G. В ходе испытаний, проведенных в префектуре Канагава, SoftBank продемонстрировала, что решение AI-RAN достигло производительности 5G операторского класса, используя ресурсы ускорителя для одновременной обработки сетевого трафика и инференса. Отмечается, что мобильные сети традиционно рассчитаны на обработку пиковых нагрузок и в среднем задействуют только треть аппаратных ресурсов, что позволяет монетизировать оставшиеся две трети путём предоставления ИИ-сервисов. NVIDIA и SoftBank также сообщили, что с помощью ПО NVIDIA AI Enterprise японская компания будет создавать локализованные безопасные ИИ-сервисы.

11.11.2024 [07:52], Сергей Карасёв

Lenovo поставит Италии НРС-кластер на базе Intel Xeon Emerald Rapids для исследований в области чистой энергииНациональное агентство по новым технологиям, энергетике и устойчивому экономическому развитию Италии (ENEA) выбрало компанию Lenovo для создания нового суперкомпьютера. Использовать НРС-комплекс планируется для ускорения исследований в области чистой энергии, в частности, по направлению ядерного синтеза. Проект нацелен на повышение вычислительной мощности платформы CRESCO (Computational Center for Research on Complex Systems — Вычислительный центр в области исследований сложных систем). Эта суперкомпьютерная система располагается в исследовательском центре Портичи (регион Кампания, административный центр Неаполь). Lenovo развернёт кластер из 758 узлов, в оснащение каждого из которых войдут два процессора Intel Xeon Platinum 8592+ поколения Emerald Rapids (64С/128T; 1,9–3,9 ГГц; 350 Вт). Говорится о применении технологии прямого жидкостного охлаждения Lenovo Neptune Direct Water-Cooling, которая позволяет отводить до 98 % тепла, генерируемого НРС-комплексом. Подчёркивается, что, помимо повышения производительности, оборудование Lenovo обеспечит высокую энергетическую эффективность. Серверы изготавливаются на предприятии Lenovo в Венгрии, а близость к месту установки позволяет сократить расходы по транспортировке и снизить выбросы вредных газов в атмосферу.

Источник изображения: Lenovo После введения в эксплуатацию новой системы общее быстродействие CRESCO поднимется примерно в шесть раз: с нынешних 1,01 до более чем 6,5 Пфлопс. Это выведет платформу в лидеры по вычислительной мощности в Италии. ENEA управляет развитой вычислительной инфраструктурой, которая предоставляет пользователям ресурсы для расчётов, моделирования и трёхмерной визуализации данных. В настоящее время сеть объединяет шесть объектов в разных областях: это Фраскати, Портичи, Болонья, Казачча, Трисайя и Бриндизи.

09.11.2024 [20:20], Руслан Авдеев

Жители Мемфиса не рады развитию ИИ-суперкомпьютера xAI Coloussus Илона МаскаАктивисты из числа жителей американского Мемфиса раскритиковали оператора энергосети Tennessee Valley Authority (TVA) за предоставление стартапу xAI Илона Маска доступа к дополнительным 150 МВт для питания ИИ-суперкомпьютера Colossus, сообщает Datacenter Dynamics. В минувший четверг TVA одобрил запрос от энергокомпании Memphis Light, Gas and Water (MLGW). Colossus предназначен для обучения и обслуживания ИИ-бота Grok, заработавшего ранее в этом году. Суперкомпьютер разместился в помещениях бывшего завода Electrolux в промышленном парке на юго-востоке Мемфиса. Ранее Маск заявлял, что речь идёт о самом быстром в мире ИИ-суперкомпьютере, включающем 100 тыс. ускорителей NVIDIA H100. Правда, буквально через несколько дней Meta✴ похвасталась ещё более крупной системой для обучения Llama-4. Но и Маск обещал в ближайшие месяцы удвоить мощность суперкомпьютера, который получит 50 тыс. ускорителей NVIDIA H200. Всё это означает, что машине потребуется много энергии. Ранее в этом году MLGW согласилась обеспечить xAI ещё 150 МВт, ожидалось лишь одобрение TVA. Комплекс даже пришлось запитать от мобильных газовых генераторов Voltagrid, что само по себе вызвало недовольство местных жителей. xAI со своей стороны пообещала построить крупнейшую в мире систему очистки сточных вод с керамическим мембранами, а также с дисконтом предоставлять ресурсы энергохранилища Tesla Megapack, построенного рядом с Colossus, для поддержки стабильности энергосети Мемфиса. Новость не вызывала энтузиазма у местных активистов и экозащитников, обеспокоенных вероятной нагрузкой на энергосети города и низким качеством воздуха. Активисты также подчёркивают, что оператор TVA обязан служить интересам общества и изучить последствия выделения xAI дополнительных 150 МВт, поскольку регион и так страдает от высоких нагрузок на сети и загрязнения окружающей среды. Дело, в частности, в том, что TVA намерена построить турбины на природном газе для получения ещё 200 МВт, поскольку оператор ещё прошлой осенью не справлялся со спросом. В TVA заявляют, что задача оператора — работать с партнёрами для привлечения в регион инвестиций и рабочих мест, в каждом случае аккуратно оцениваются детали каждого предложения. MLGW получит из бюджета $760 тыс. для введения в строй ещё 50 МВт, а xAI обязуется построить за $24 млн собственную подстанцию на 150 МВт. Существующие договорённости предусматривают, что xAI будет получать ежемесячные скидки от поставщика энергии, пока не компенсирует стоимость возводимой ей подстанции и та не перейдёт в собственность MLGW.

05.11.2024 [15:40], Сергей Карасёв

MONAKA + Instinct: AMD и Fujitsu вместе создадут Arm-платформы для ИИ и HPCAMD и Fujitsu объявили о подписании меморандума о взаимопонимании с целью формирования стратегического партнёрства, направленного на создание вычислительных платформ для ИИ и HPC. Предполагается, что сотрудничество охватит различные сферы — от разработки специализированных решений до коммерциализации. Речь идёт об объединении передовых аппаратных решений в области CPU и GPU с сопутствующим ПО. Партнёры намерены содействовать формированию открытой экосистемы для задач ИИ. В частности, упомянуты Arm-процессоры Fujitsu MONAKA и ускорители AMD Instinct. Стороны намерены задействовать открытый программный стек AMD ROCm и специализированный софт Fujitsu для изделий с архитектурой Arm. В целом, сотрудничество будет сосредоточено на трёх ключевых направлениях — инжиниринг, экосистемы и бизнес. Партнёры рассчитывают создать инновационные вычислительные платформы для ИИ и HPC к 2027 году. AMD и Fujitsu также будут сообща работать над маркетинговыми кампаниями и улучшать взаимодействие с заказчиками. Например, планируется создание совместного центра для клиентов. «Объединяя инновационную технологию графических чипов AMD с эффективными и высокопроизводительными процессорами Fujitsu, мы стремимся создать среду, в которой больше компаний смогут использовать инструменты ИИ при одновременном снижении энергопотребления в дата-центрах», — говорит Вивек Махаджан (Vivek Mahajan), корпоративный вице-президент и технический директор Fujitsu. Нужно отметить, что ранее Fujitsu заключила соглашение о сотрудничестве с Supermicro. Компании займутся разработкой СЖО для ЦОД, а также серверов следующего поколения на чипах Fujitsu MONAKA для широкого спектра рабочих нагрузок — от ИИ и НРС до облачных и периферийных задач. Два года назад AMD также подписала аналогичное соглашение о сотрудничестве с европейским разработчиком серверных Arm-процессоров SiPearl.

05.11.2024 [11:17], Сергей Карасёв

Создан консорциум UALink по разработке альтернативы NVIDIA NVLinkВ мае нынешнего года был сформирован альянс Ultra Accelerator Link (UALink) по разработке технологии, призванной составить конкуренцию NVIDIA NVLink. А теперь участники отрасли объявили о создании соответствующего консорциума — UALink Consortium. Новую структуру возглавляют представители AMD, AWS, Astera Labs, Cisco, Google, HPE, Intel, Meta✴ и Microsoft. В состав консорциума также входят Cadence, Lenovo, H3C, Centec, Anapass и пр. Кроме того, к участию приглашаются другие заинтересованные стороны. Фактически участники заняты созданием более открытой альтернативы NVLink. «Стандарт UALink определяет высокоскоростную связь с низкими задержками для масштабируемых систем ИИ в дата-центрах. Заинтересованные компании могут присоединиться к консорциуму и поддержать нашу миссию: создание открытого и высокопроизводительного интерконнекта для рабочих нагрузок ИИ», — сказал Вилли Нельсон (Willie Nelson), президент UALink. Отмечается, что компании, входящие в совет консорциума, охватывают широкий спектр отраслей — от поставщиков облачных услуг и OEM-производителей до разработчиков ПО и полупроводниковых компонентов. В I квартале 2025 года планируется представить общедоступную спецификацию UALink 1.0, которая предусматривает пропускную способность до 200 Гбит/с на соединение. В пределах одного домена при этом могут быть объединены до 1024 ускорителей ИИ. Выпуск спецификации UALink 1.0 станет важной вехой, поскольку она определит открытый отраслевой стандарт, позволяющий ускорителям и коммутаторам ИИ взаимодействовать более эффективно. Это откроет новые возможности в плане развития и внедрения крупных ИИ-моделей. |

|