Материалы по тегу: hpc

|

25.11.2024 [13:10], Руслан Авдеев

Эффективность новинок NVIDIA в рейтинге суперкомпьютеров Green500 оказалась под вопросом из-за чипов AMD и… самой NVIDIAХотя ускорители NVIDIA считаются одними из самых энергоёмких в своём классе, суперкомпьютеры на основе чипов компании по-прежнему доминируют в мировом рейтинге энергоэффективности соответствующих машин — Green500. Тем не менее компания столкнулась с сильной конкуренцией со стороны AMD и не всегда готова состязаться даже с собственной продукцией, сообщает The Register. На первый взгляд, лидерство проектов на базе NVIDIA неоспоримо. Восемь из десяти суперкомпьютеров, входящих в «Топ-10» энергоэффективных машин, построены на чипах NVIDIA, из них пять — на 1000-ваттных гибридных ускорителях GH200. В новейшем рейтинге Green500 на их основе построены первая и вторая из наиболее энергоэффективных систем — JEDI (EuroHPC) и ROMEO-2025 (Romeo HPC Center). В бенчмарке High-Performance Linpack они продемонстрировали производительность 72,7 Гфлопс/Вт и 70,9 Гфлопс/Вт соответственно (FP64). Системы почти идентичны и построены на платформе BullSequana XH3000 компании Eviden (Atos). На решение GH200 также приходятся четвёртая, шестая и седьмая позиции рейтинга: Isambard-AI Phase 1 (68,8 Гфлопс/Вт), Jupiter Exascale Transition Instrument (67,9 Гфлопс/Вт) и Helios (66,9 Гфлопс/Вт). Системы с проверенными NVIDIA H100 занимают пятое, восьмое и девятое места — это Capella, Henri и HoreKa-Teal.

Источник изображения: Jakub Żerdzicki/unsplash.com Тем не менее есть сомнения в том, что продукты NVIDIA и дальше будут безраздельно господствовать в рейтинге Green500. Уже на подходе решения Grace-Blackwell в виде GB200 (2,7 кВт) и GB200 NVL4 (5,4 кВт). Новые продукты далеко не всегда обеспечивают максимальную производительность на ватт энергии. При переходе от A100 (2020 год) к H100 (2022 год) FP64-производительность взлетела приблизительно в 3,5 раза, но в сравнении с 1,2-кВт платформой Blackwell даже 700-Вт H100 в режиме матричных FP64-вычислений фактически быстрее. Для FP64 улучшилась только работа с векторными операциями, где новинки оказались на 32 % производительнее. Другими словами, хотя сегодня NVIDIA может похвастаться высоким положением в рейтинге Green500, решение на ускорителях MI300A компании AMD уже заняло третье место (Adastra 2). MI300A анонсировали чуть менее года назад, решение получило 24-ядерный CPU и шесть чиплетов CDNA-3 в едином APU-модуле, оснащённым до 128 Гбайт памяти HBM3, а также настраиваемый уровень TDP 550–760 Вт. Более того, такая система в 1,8 раза производительнее NVIDIA H100 (по крайней мере, на бумаге). Суперкомпьютер Adastra 2 на базе HPE Cray EX255a обеспечивает производительность 69 Гфлопс/Вт. Десятое место также занимает машина на MI300A — RZAdams Ливерморской национальной лаборатории (62,8 Гфлопс/Вт). Таким образом, все системы, входящие в первую десятку рейтинга Green500, уже значительно превышают целевой показатель энергоэффективности в 50 Гфлопс/Вт, необходимый для достижений 1 Эфлопс (FP64) при энергопотреблении до 20 МВт. Проблема в том, что малые системы значительно эффективнее: JEDI потребляет всего 67 кВт, а самая производительная машина на базе GH200 в рейтинге TOP500 — швейцарская Alps — обеспечивает 434 Пфлопс (FP64), потребляя 7,1 МВт — это лишь 14-я из наиболее энергоэффективных машин (61 Гфлопс/Вт). Та же проблема и с Adastra 2: компьютер потребляет даже меньше JEDI — 37 кВт. Если бы удалось сохранять уровень 69 Гфлопс/Вт в больших масштабах, потребовалось бы всего 25,2 МВт для достижения 1,742 Эфлопс, как у El Capitan. Но последнему требуется около 29,6 МВт для достижения таких рекордных показателей.

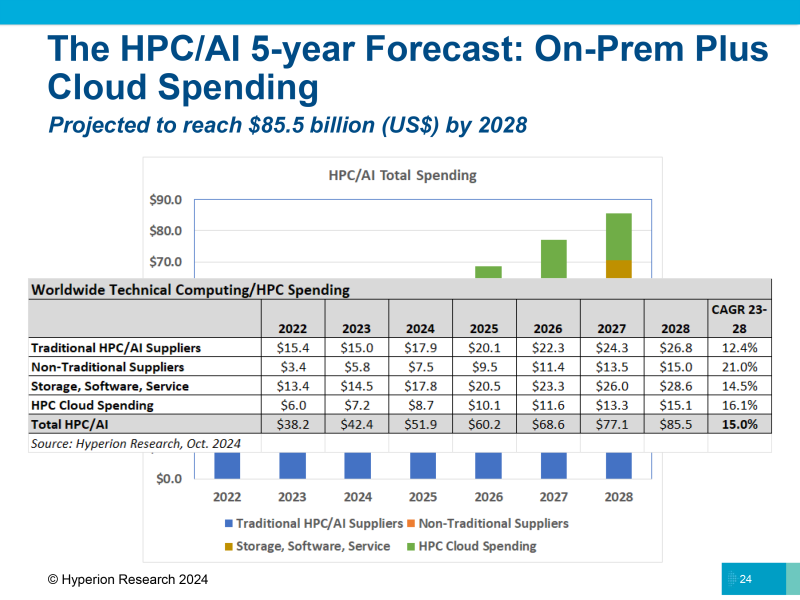

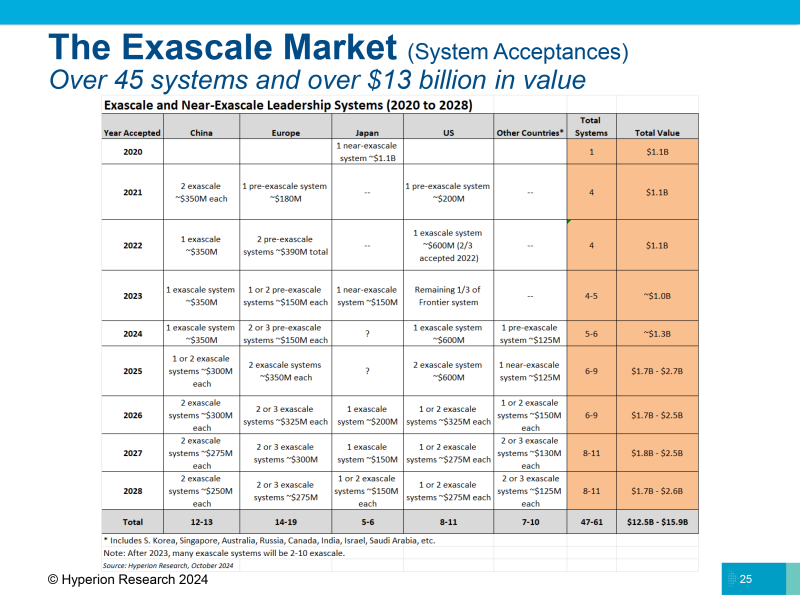

25.11.2024 [11:40], Владимир Мироненко

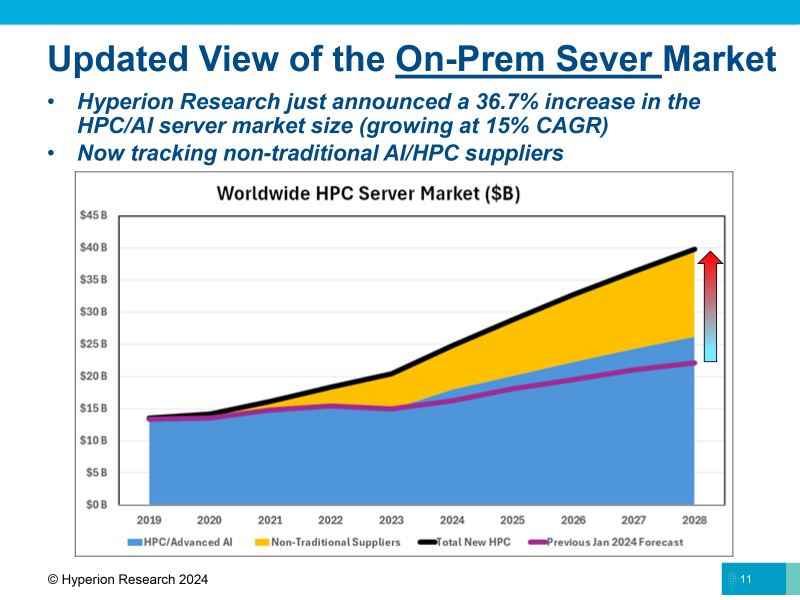

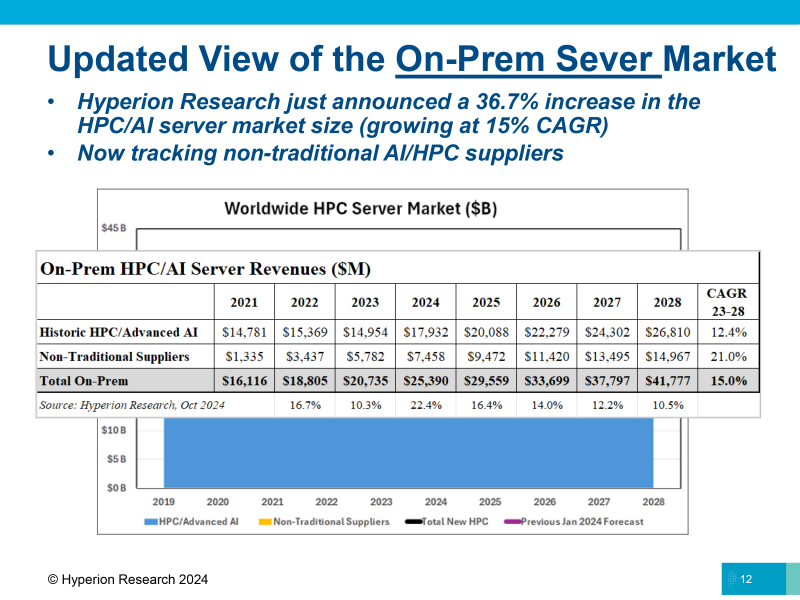

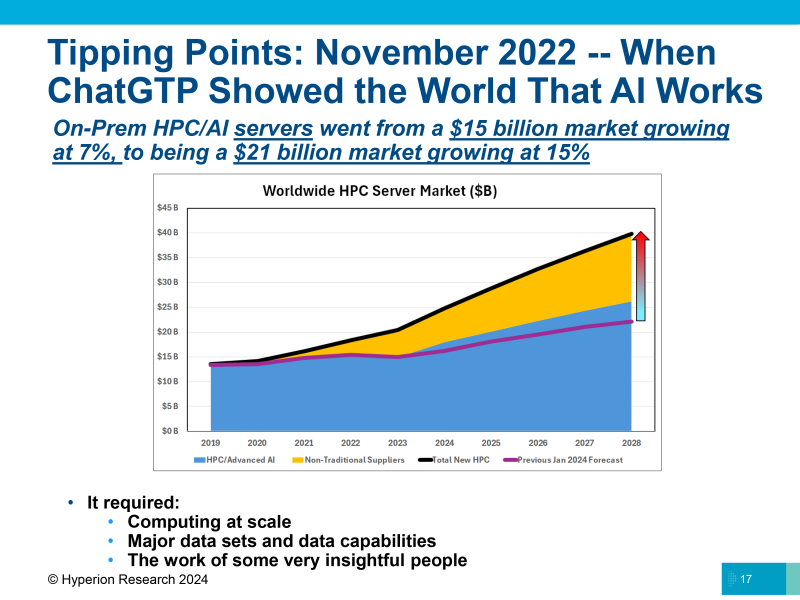

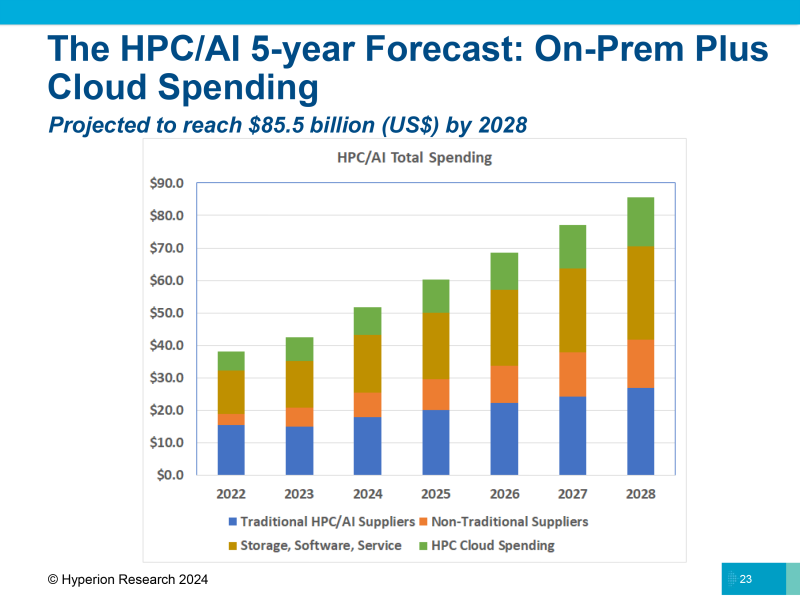

Hyperion Research: рынок HPC куда больше, чем считается, и растёт он куда быстрееАналитики The Next Platform считают, что обучение и инференс ИИ в ЦОД также относятся к высокопроизводительным вычислениям (HPC), хотя в некоторых случаях могут значительно отличаться от их традиционного определения. HPC используют небольшой набор данных, расширяя его до огромных симуляций, таких как прогнозы погоды или климата, в то время как ИИ анализирует массу данных о мире и преобразует их в модель, в которую можно добавлять новые данные для ответа на вопросы, сообщается на ресурсе The Next Platform. HPC и ИИ имеют разные потребности в вычислительных ресурсах, памяти и пропускной способности на разных этапах обработки приложений. Но в конечном итоге как при HPC, так и при обучении ИИ компании стремятся объединить множество узлов в единую систему для выполнения больших объёмов работы, которые невозможно выполнить иначе. Для получения «реальных» данных о рынке HPC необходимо добавить к расходам на традиционные платформы ModSim (моделирование и симуляция) средства, потраченные на применение технологий генеративного ИИ, традиционное обучение и инференс ИИ в ЦОД. Исходя из этого, Hyperion Research значительно пересмотрела оценку рынка, учтя продажи серверов ИИ, которые ранее не включались в расчёты, в том числе решения компаний NVIDIA, Supermicro и других. В обновлённом прогнозе рынка HPC, представленном Hyperion Research в минувший вторник, расходы на серверы значительно выросли благодаря добавлению «нетрадиционных поставщиков». В 2021 году было продано серверов в объединённом секторе HPC/ИИ на $1,34 млрд, в 2022 году расходы на их покупку составили $3,44 млрд, а в 2023 году, благодаря буму на генеративный ИИ, они подскочили до $5,78 млрд. Hyperion Research ожидает, что эти производители заработают на серверах $7,46 млрд в 2024 году, и их доходы почти удвоятся к 2028 году, достигнув $14,97 млрд. Историческая часть рынка серверов HPC/ИИ (согласно прежней методике), показанная синим цветом на диаграмме, как ожидается, составит $17,93 млрд в этом году и вырастет до $26,81 млрд к 2028 году. Объединённый рынок HPC/ИИ с учётом нового подхода составит в этом году $25,39 млрд и будет расти ежегодно на 15 %, достигнув $41,78 млрд к 2028 году. Как отметили в Hyperion Research, теперь не все расходы на вычисления HPC и ИИ осуществляются локально (on-premise). Большая часть ИТ-бюджета на рабочие нагрузки HPC и ИИ переносится в облако. Hyperion подсчитала, что приложения HPC и ИИ, работающие в облаке, в совокупности «потребили» $7,18 млрд виртуальных серверных мощностей в 2023 году и что эти цифры вырастут на 21,2 % до $8,71 млрд в 2024 году. К 2028 году расходы на вычислительные мощности HPC и ИИ в облаке составят $15,11 млрд, а совокупные годовые темпы роста с 2023 по 2028 год составят 16,1 %. Помимо затрат на вычисления, бюджет HPC и ИИ включает расходы на хранение, ПО и сервисы. Hyperion ожидает, что в 2024 году общие расходы на HPC и ИИ вырастут на 22,4 %, с $42,4 млрд до $51,9 млрд. При совокупном годовом темпе роста в 15 % в период с 2023 по 2028 год все затраты на HPC и ИИ составят к 2028 году $85,5 млрд, что в два раза превышает показатель нынешнего года. Согласно данным Hyperion, в 2021 году в Китае было установлено две экзафлопсные системы стоимостью $350 млн каждая. Также по одной системе с такой же стоимостью было установлено в 2023 году и нынешнем году. Hyperion ожидает, что в 2025 году Китай установит ещё одну или две экзафлопсные системы с оценочной стоимостью $300 млн за штуку и ещё две с такой же стоимостью в 2026 году. Общая стоимость девяти экзафлопсных систем составит около $2,95 млрд — примерно столько стартап xAI, курируемый Илоном Маском (Elon Musk), израсходовал на создание кластера Colossus из 100 000 ускорителей NVIDIA H100. В Японии до сих пор нет суперкомпьютера эксафлопсного класса (речь об FP64-производительности), и она получит свой первый такой суперкомпьютер стоимостью $200 млн в 2026 году. В 2027 и 2028 годах, как ожидает Hyperion, Япония построит две или три такие суперкомпьютерные системы стоимостью около $150 млн за единицу, потратив в общей сложности $300–450 млн. В Европе есть несколько преэкзафлопсных систем, и в 2025 году она получит две экзафлопсные системы по оценочной стоимости $350 млн каждая, а в 2026 году здесь появится ещё две или три системы стоимостью около $325 млн. Также следует ожидать строительство двух или трёх машин в 2027 году стоимостью $300 млн каждая и двух или трёх в 2028 году стоимостью $275 млн каждая. То есть в предстоящие несколько лет в Европе будет построено одиннадцать экзафлопсных суперкомпьютеров общей стоимостью $3,4 млрд. В США установили одну экзафлопсную систему в 2022 году (Frontier в Ок-Риджской национальной лаборатории, ORNL) и две — в 2024 году (Aurora в Аргоннской национальной лаборатории и El Capitan в Ливерморской национальной лаборатории им. Э. Лоуренса). По оценкам The Next Platform, за последние годы Соединённые Штаты потратили $1,4 млрд на установку трёх экзафлопсных машин. Согласно прогнозу Hyperion Research, в Соединённых Штатах в 2025 году установят две экзафлопсные системы стоимостью около $600 млн каждая, в 2026 году — одну или две стоимостью $325 млн каждая и одну или две стоимостью $275 млн каждая в 2027 и 2028 годах. В общей сложности будет потрачено $4,35 млрд на одиннадцать экзафлопсных систем.

23.11.2024 [15:57], Сергей Карасёв

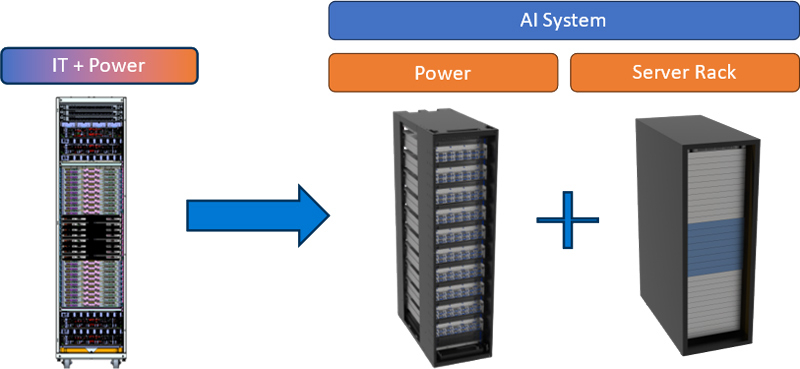

Microsoft и Meta✴ представили дизайн ИИ-стойки с раздельными шкафами для питания и IT-оборудованияКорпорация Microsoft в сотрудничестве с Meta✴ представила дизайн серверной стойки нового поколения для дата-центров, ориентированных на задачи ИИ. Спецификации системы, получившей название Mt. Diablo, предоставляются участникам проекта Open Compute Project (OCP). Отмечается, что инфраструктура ЦОД постоянно эволюционирует, а наиболее значительное влияние на неё оказывает стремительное внедрение ИИ. Тогда как традиционные стойки с вычислительным оборудованием и средствами хранения данных имеют мощность максимум до 20 кВт, при размещении современных ИИ-ускорителей этот показатель исчисляется сотнями киловатт. В результате при развёртывании дата-центров могут возникать различные сложности. Идея Mt. Diablo заключается в разделении стойки на независимые шкафы для компонентов подсистемы питания и вычислительного оборудования. То есть, речь идёт о дезагрегированной архитектуре, позволяющей гибко регулировать мощность в соответствии с меняющимися требованиями.

Источник изображения: Microsoft Одним из ключевых преимуществ нового подхода является оптимизация пространства. Утверждается, что в каждой серверной стойке можно размещать на 35 % больше ИИ-ускорителей по сравнению с традиционным дизайном. Ещё одним достоинством названа масштабируемость: конфигурацию стойки питания можно изменять в соответствии с растущими потребностями. Плюс к этому модульная конструкция позволяет реализовывать несколько проектов одновременно. Отмечается, что в современных OCP-системах уже используется единая шина питания постоянного тока с напряжением 48 В. В случае с новым дизайном возможен переход на архитектуру 400 В DC. Это открывает путь для создания более мощных и эффективных систем ИИ. Однако для внедрения стандарта 400 В потребуется общеотраслевая стандартизация. В индивидуальных проектах — например, суперкомпьютерах — для питания узлов уже используется шина HVDC.

23.11.2024 [15:35], Сергей Карасёв

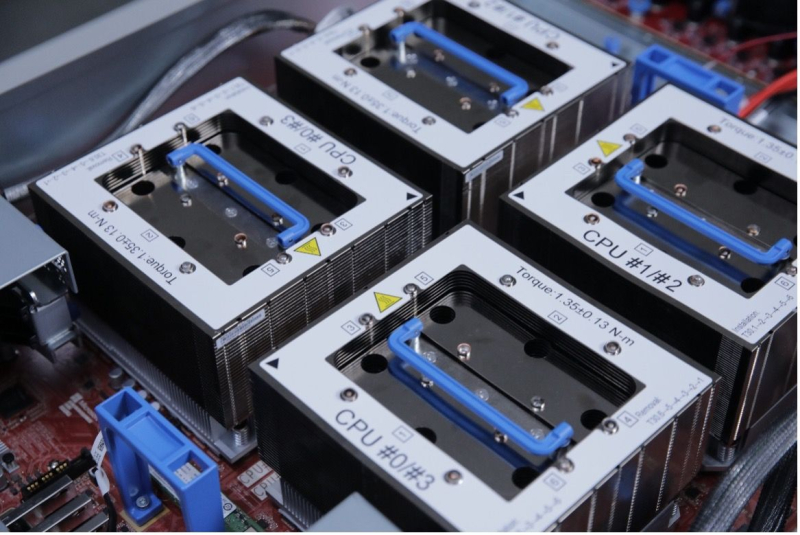

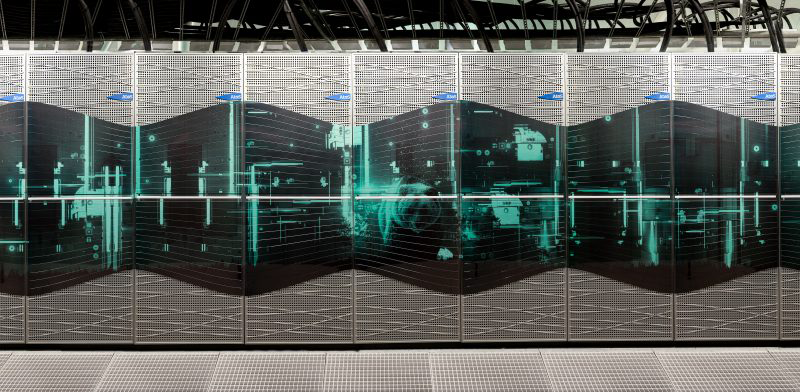

Eviden создаст для Финляндии ИИ-суперкомпьютер Roihu производительностью 49 ПфлопсКомпания Eviden (дочерняя структура Atos) объявила о заключении соглашения с Финским научным IT-центром CSC о создании нового национального суперкомпьютера для задач ИИ. Система под названием Roihu, как ожидается, утроит вычислительную мощность существующих комплексов Puhti и Mahti. Суперкомпьютер Puhti общего назначения, запущенный в 2019 году, построен на платформе Atos BullSequana X400 (X1000). В общей сложности используются 682 узла CPU на процессорах Intel Xeon Cascade Lake-SP с пиковой FP64-производительностью 1,8 Пфлопс. Кроме того, применены 80 узлов GPU, каждый из которых несёт на борту четыре ускорителя NVIDIA V100: быстродействие этой секции — до 2,7 Пфлопс. Основной интерконнект — InfiniBand HDR100. В свою очередь, система Mahti (на изображении), введённая в эксплуатацию в 2020-м, основана на платформе Atos BullSequana XH2000. Суперкомпьютер насчитывает 1404 узла CPU и 24 узла GPU с теоретической пиковой FP64-производительностью 7,5 Пфлос и 2,0 Пфлопс соответственно. Все узлы содержат по два чипа AMD Rome 7H12, тогда как GPU-серверы комплектуются четырьмя ускорителями NVIDIA Ampere A100.

Источник изображения: CSC В основу нового суперкомпьютера Roihu ляжет гибридная платформа BullSequana XH3000, которая позволяет объединять в рамках одного кластера чипы AMD, Intel и NVIDIA. Теоретическая пиковая производительность заявлена на уровне 49 Пфлопс (точность вычислений не уточняется). Прочие технические характеристики проектируемой машины пока не раскрываются. Стоимость контакта по созданию Roihu оценивается в €60 млн. Систему планируется использовать для широкого спектра задач, включая анализ аудио- и видеозаписей, ресурсоёмкие приложения ИИ в различных областях и традиционные нагрузки, такие как гидродинамика и моделирование климата. Кроме того, мощности суперкомпьютера будут применяться в образовательных целях.

21.11.2024 [10:09], Сергей Карасёв

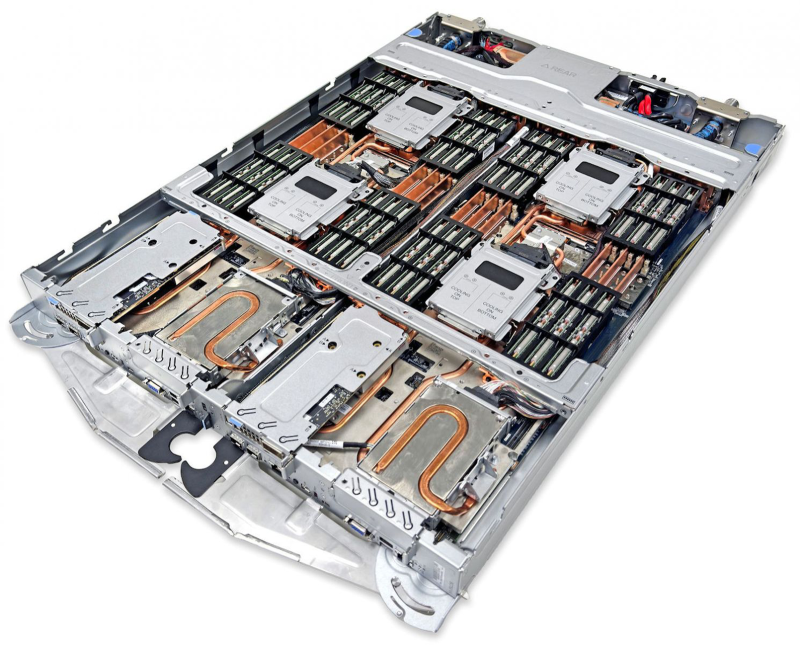

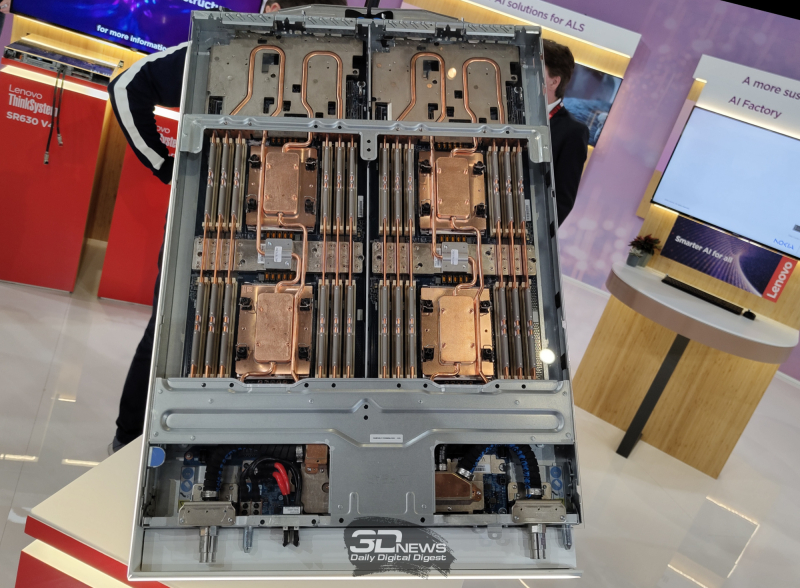

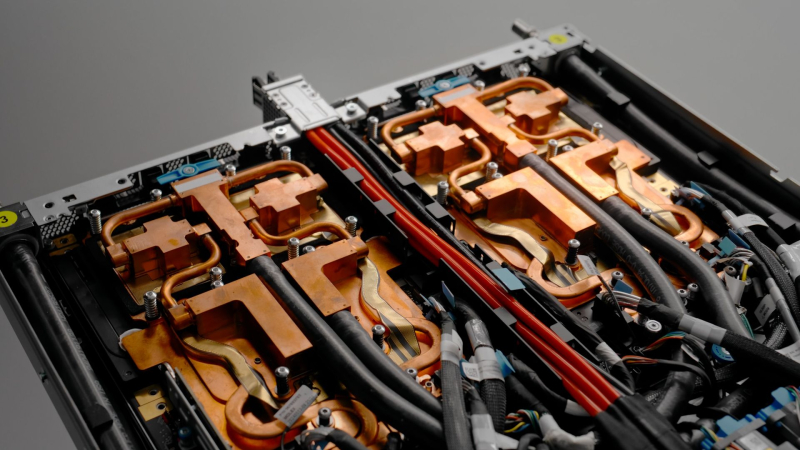

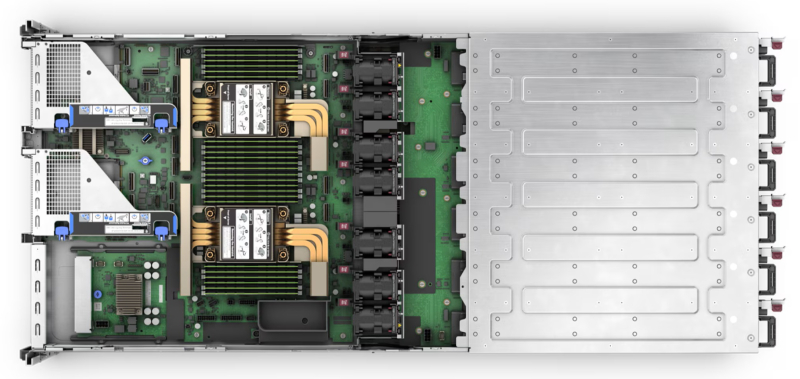

Lenovo представила сервер ThinkSystem SC750 V4 Neptune на базе Intel Xeon Granite Rapids с СЖОКомпания Lenovo анонсировала сервер ThinkSystem SC750 V4 Neptune, предназначенный для технических вычислений и обработки данных в различных областях, таких как аналитика, научные исследования, энергетика, проектирование и финансовое моделирование. Система ThinkSystem SC750 V4 Neptune объединяет два узла, которые заключены в 19″ корпус с возможностью вертикального монтажа. Каждый узел может нести на борту два процессора Intel Xeon 6900 поколения Granite Rapids (до 128 ядер) с показателем TDP до 500 Вт. В расчёте на узел доступны 24 слота для модулей оперативной памяти TruDDR5 RDIMM-6400 или MRDIMM-8800 (в сумме до 3 Тбайт). Каждый узел может комплектоваться шестью накопителями EDSFF E3.S NVMe SSD общей вместимостью до 92,16 Тбайт. Есть два сетевых порта 25GbE SFP28 на основе контроллера Broadcom 57414, один порт 1GbE RJ45 на базе Intel I210, два слота PCIe 5.0 x16. Габариты составляют 546 × 53 × 760 мм, масса — 37,2 кг. Говорится о совместимости с Red Hat Enterprise Linux, SUSE Linux Enterprise Server, Ubuntu и пр. Применено прямое жидкостное охлаждение Lenovo Neptune. Утверждается, что по сравнению с аналогичной системой с воздушным охлаждением сервер ThinkSystem SC750 V4 Neptune обеспечивает увеличение общей производительности до 10 % благодаря постоянной работе процессоров в турбо-режиме. При этом энергопотребление ЦОД от серверов может быть уменьшено на 40 %, тогда как шум от вентиляторов устраняется полностью. Восемь лотков ThinkSystem SC750 V4 Neptune могут быть установлены в шасси ThinkSystem N1380 формата 13U: в сумме это даёт 16 узлов. Шасси может быть оборудовано четырьмя узлами Power Conversion Stations (PCS) с сертификатом 80 PLUS Titanium.

20.11.2024 [10:56], Сергей Карасёв

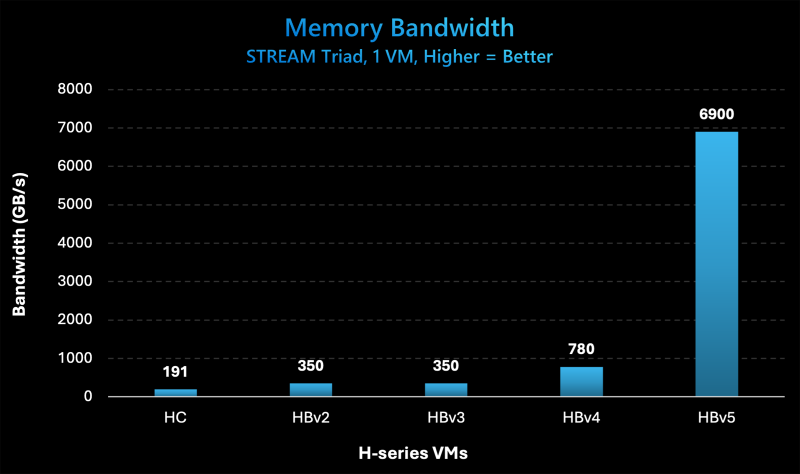

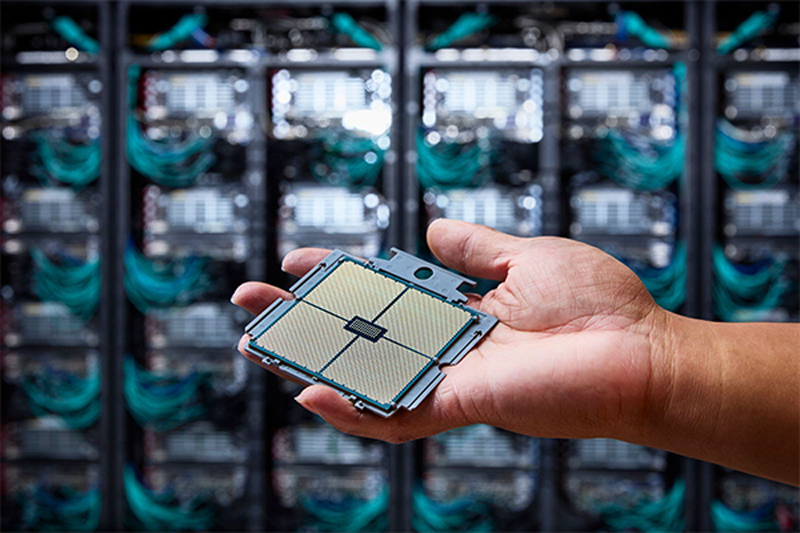

Microsoft представила инстансы Azure HBv5 на основе уникальных чипов AMD EPYC 9V64H с памятью HBM3Компания Microsoft на ежегодной конференции Ignite для разработчиков, IT-специалистов и партнёров анонсировала облачные инстансы Azure HBv5 для HPC-задач, которые предъявляют наиболее высокие требования к пропускной способности памяти. Новые виртуальные машины оптимизированы для таких приложений, как вычислительная гидродинамика, автомобильное и аэрокосмическое моделирование, прогнозирование погоды, исследования в области энергетики, автоматизированное проектирование и пр. Особенность Azure HBv5 заключается в использовании уникальных процессоров AMD EPYC 9V64H (поколения Genoa). Эти чипы насчитывают 88 вычислительных ядер Zen4, тактовая частота которых достигает 4 ГГц. Ближайшим родственником является изделие EPYC 9634, которое содержит 84 ядра (168 потоков) и функционирует на частоте до 3,7 ГГц. По данным ресурса ComputerBase.de, чип EPYC 9V64H также фигурирует под именем Instinct MI300C: по сути, это процессор EPYC, дополненный памятью HBM3. При этом клиентам предоставляется возможность кастомизации характеристик. Отметим, что ранее x86-процессоры с набортной памятью HBM2e были доступны в серии Intel Max (Xeon поколения Sapphire Rapids). Каждый инстанс Azure HBv5 объединяет четыре процессора EPYC 9V64H, что в сумме даёт 352 ядра. Система предоставляет доступ к 450 Гбайт памяти HBM3, пропускная способность которой достигает 6,9 Тбайт/с. Задействован интерконнект NVIDIA Quantum-2 InfiniBand со скоростью передачи данных до 200 Гбит/с в расчёте на CPU. Применены сетевые адаптеры Azure Boost NIC второго поколения, благодаря которым пропускная способность сети Azure Accelerated Networking находится на уровне 160 Гбит/с. Для локального хранилища на основе NVMe SSD заявлена скорость чтения информации до 50 Гбайт/с и скорость записи до 30 Гбайт/с. Отмечается, что по показателю пропускной способности памяти виртуальные машины Azure HBv5 примерно в 8 раз превосходят новейшие альтернативы bare-metal и cloud, в 20 раз опережают инстансы Azure HBv3 и Azure HBv2 (на базе EPYC Milan-X и EPYC Rome) и в 35 раз обходят HPC-серверы возрастом 4–5 лет, жизненный цикл которых приближается к завершению. Машины Azure HBv5 станут доступны в I половине 2025 года.

20.11.2024 [01:40], Владимир Мироненко

Microsoft представила кастомные чипы Azure Boost DPU и Integrated HSM, уникальный AMD EPYC 9V64H с HBM и собственный вариант NVIDIA GB200 NVL72

amd

azure arc

azure stack

dpu

epyc

gb200

hardware

hbm

hpc

microsoft

microsoft azure

nvidia

гибридное облако

ии

информационная безопасность

облако

ускоритель

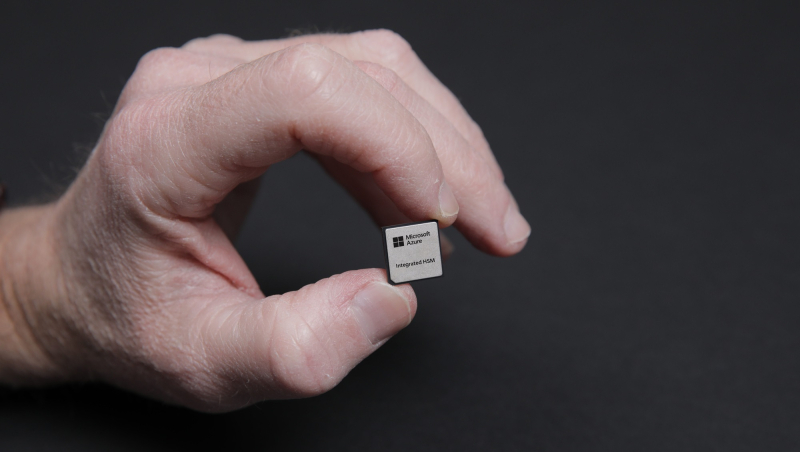

Microsoft представила на конференции Microsoft Ignite новые специализированные чипы Azure Boost DPU и Azure integrated Hardware Security Module (HSM), предназначенные для использования в ЦОД с целью поддержки рабочих нагрузок в облаке Azure и повышения безопасности.

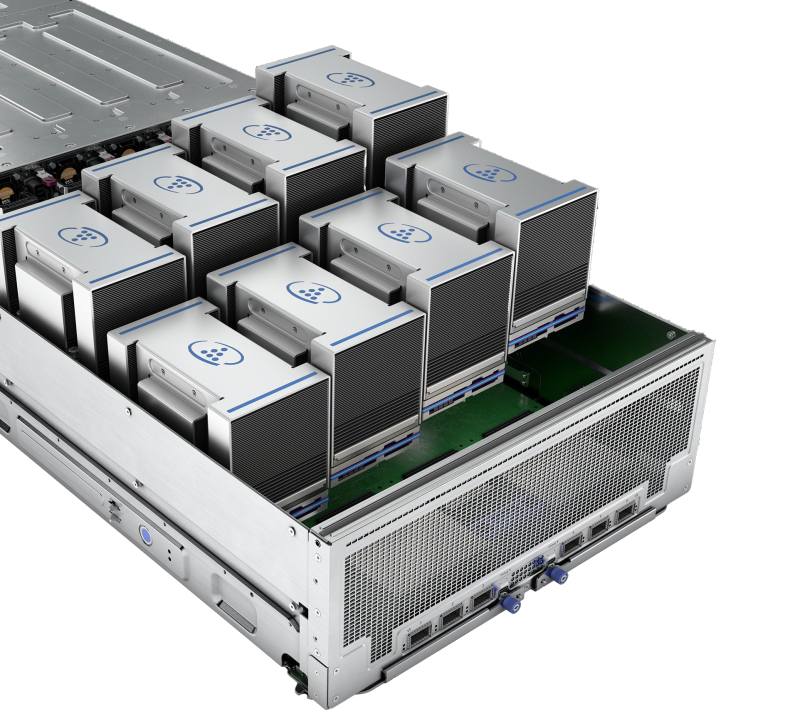

Источник изображений: Microsoft Чтобы снизить зависимость от поставок чипов сторонних компаний, Microsoft занимается разработкой собственных решений для ЦОД. Например, на прошлогодней конференции Microsoft Ignite компания представила Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100 собственной разработки. Azure Boost DPU включает специализированные ускорители для работы с сетью и хранилищем, а также предлагает функции безопасности. Так, скорость работы с хранилищем у будущих инстансов Azure будет вчетверо выше, чем у нынешних, а энергоэффективность при этом вырастет втрое. Не вызывает сомнений, что в разработке Azure Boost DPU участвовали инженеры Fungible, производителя DPU, который Microsoft приобрела в декабре прошлого года. Как отмечает TechCrunch, в последние годы популярность DPU резко увеличилась. AWS разработала уже несколько поколений Nitro, Google совместно с Intel создала IPU, AMD предлагает DPU Pensando, а NVIDIA — BlueField. Есть и другие нишевые игроки. Согласно оценкам Allied Analytics, рынок чипов DPU может составить к 2031 году $5,5 млрд. Ещё один кастомный чип — Azure integrated Hardware Security Module (HSM) — отвечает за хранение цифровых криптографических подписей и ключей шифрования в защищённом модуле «без ущерба для производительности или увеличения задержки». «Azure Integrated HSM будет устанавливаться на каждом новом сервере в ЦОД Microsoft, начиная со следующего года, чтобы повысить защиту всего парка оборудования Azure как для конфиденциальных, так и для общих рабочих нагрузок», — заявила Microsoft. Azure Integrated HSM работает со всем стеком Azure, обеспечивая сквозную безопасность и защиту. Microsoft также объявила, что задействует ускорители NVIDIA Blackwell и кастомные серверные процессоры AMD EPYC. Так, инстансы Azure ND GB200 v6 будут использовать суперускорители NVIDIA GB200 NVL 72 в собственном исполнении Microsoft, а интерконнект Quantum InfiniBand позволит объединить десятки тысяч ускорителей Blackwell. Компания стремительно наращивает закупки этих систем. А инстансы Azure HBv5 получат уникальные 88-ядерные AMD EPYC 9V64H с памятью HBM, которые будут доступны только в облаке Azure. Каждый инстанс включает четыре таких CPU и до 450 Гбайт памяти с агрегированной пропускной способностью 6,9 Тбайт/с. Кроме того, Microsoft анонсировала новое решение Azure Local, которое заменит семейство Azure Stack. Azure Local — это облачная гибридная инфраструктурная платформа, поддерживаемая Azure Arc, которая объединяет локальные среды с «большим» облаком Azure. По словам компании, клиенты получат обновление до Azure Local в автоматическом режиме. Наконец, Microsoft анонсировала новые возможности в Azure AI Foundry, новой «унифицированной» платформе приложений ИИ, где организации смогут проектировать, настраивать и управлять своими приложениями и агентами ИИ. В числе новых опций — Azure AI Foundry SDK (пока в виде превью).

19.11.2024 [23:28], Алексей Степин

HPE обновила HPC-портфолио: узлы Cray EX, СХД E2000, ИИ-серверы ProLiant XD и 400G-интерконнект Slingshot

400gbe

amd

epyc

gb200

h200

habana

hardware

hpc

hpe

intel

mi300

nvidia

sc24

turin

ии

интерконнект

суперкомпьютер

схд

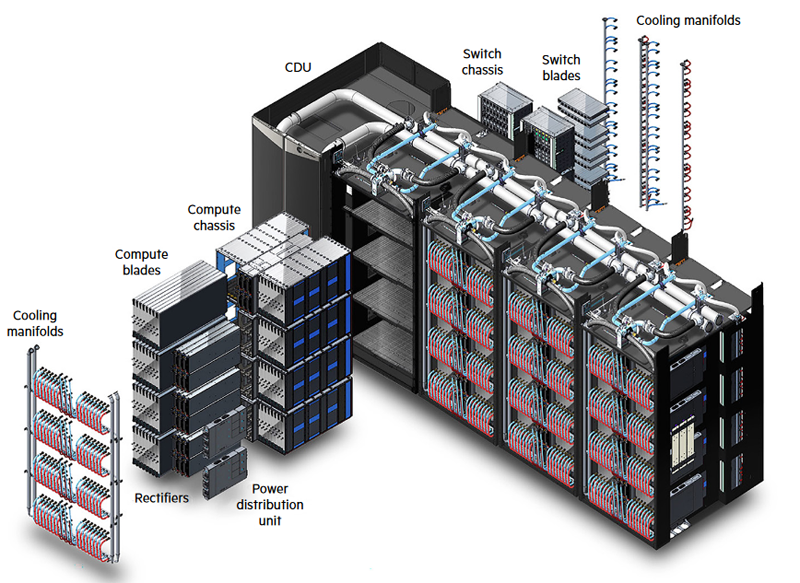

Компания HPE анонсировала обновление модельного ряда HPC-систем HPE Cray Supercomputing EX, а также представила новые модели серверов из серии Proliant. По словам компании, новые HPC-решения предназначены в первую очередь для научно-исследовательских институтов, работающих над решением ресурсоёмких задач.

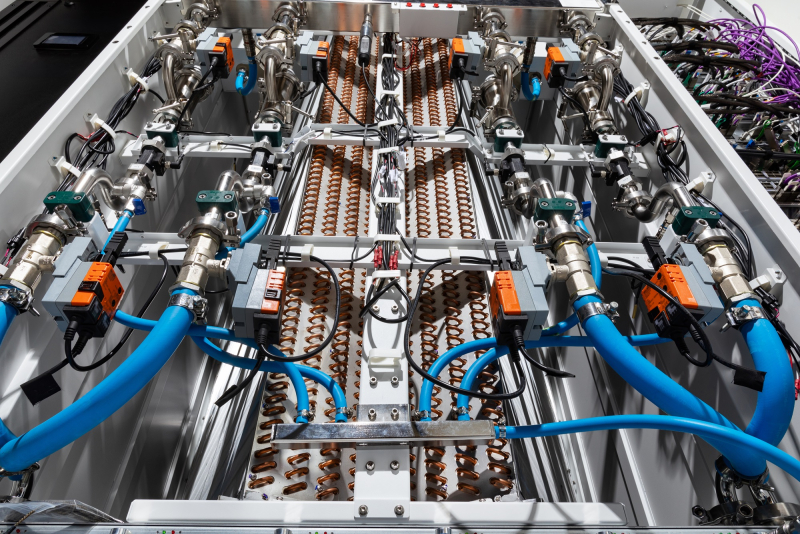

Источник изображений: HPE Обновление касается всех компонентов HPE Cray Supercomputing EX. Открывают список новые процессорные модули HPE Cray Supercomputing EX4252 Gen 2 Compute Blade. В их основе лежит пятое поколение серверных процессоров AMD EPYС Turin, которое на сегодняшний день является самым высокоплотным x86-решениями. Новые модули позволят разместить до 98304 ядер в одном шкафу. Отчасти это также заслуга фирменной системы прямого жидкостного охлаждения. Она охватывает все части суперкомпьютера, включая СХД и сетевые коммутаторы. Начало поставок узлов намечено на весну 2025 года. Процессорные «лезвия» дополнены новыми GPU-модулями HPE Cray Supercomputing EX154n Accelerator Blade, позволяющими разместить в одном шкафу до 224 ускорителей NVIDIA Blackwell. Речь идёт о новейших сборках NVIDIA GB200 NVL4 Superchip. Этот компонент появится на рынке позднее — HPE говорит о конце 2025 года. Обновление коснулось и управляющего ПО HPE Cray Supercomputing User Services Software, получившего новые возможности для пользовательской оптимизации вычислений, в том числе путём управления энергопотреблением. Апдейт получит и фирменный интерконнект HPE Slingshot, который «дорастёт» до 400 Гбит/с, т.е. станет вдвое быстрее нынешнего поколения Slingshot. Пропускная способность коммутаторов составит 51,2 Тбит/c. В новом поколении будут реализованы функции автоматического устранения сетевых заторов и адаптивноой маршрутизации с минимальной латентностью. Дебютирует HPE Slingshot interconnect 400 осенью 2024 года. Ещё одна новинка — СХД HPE Cray Supercomputing Storage Systems E2000, специально разработанная для применения в суперкомпьютерах HPE Cray. В сравнении с предыдущим поколением, новая система должна обеспечить более чем двукратный прирост производительности: с 85 и 65 Гбайт/с до 190 и 140 Гбайт/с при чтении и записи соответственно. В основе новой СХД будет использована ФС Lustre. Появится Supercomputing Storage Systems E2000 уже в начале 2025 года. Что касается новинок из серии Proliant, то они, в отличие от вышеупомянутых решений HPE Cray, нацелены на рынок обычных ИИ-систем. 5U-сервер HPE ProLiant Compute XD680 с воздушным охлаждением представляет собой решение с оптимальным соотношением производительности к цене, рассчитанное как на обучение ИИ-моделей и их тюнинг, так и на инференс. Он оснащён восемью ускорителями Intel Gaudi3 и двумя процессорами Intel Xeon Emerald Rapids. Новинка поступит на рынок в декабре текущего года. Более производительный HPE ProLiant Compute XD685 всё так же выполнен в корпусе высотой 5U, но рассчитан на жидкостное охлаждение. Он будет оснащаться восемью ускорителями NVIDIA H200 в формате SXM, либо более новыми решениями Blackwell, но последняя конфигурация будет доступна не ранее 2025 года, когда ускорители поступят на рынок. Уже доступен ранее анонсированный вариант с восемью ускорителями AMD Instinict MI325X и процессорами AMD EPYC Turin.

19.11.2024 [17:30], Сергей Карасёв

1,742 Эфлопс: El Capitan стал самым мощным в мире суперкомпьютером рейтинга TOP500Ливерморская национальная лаборатория им. Э. Лоуренса (LLNL) Министерства энергетики США (DOE), Администрация по национальной ядерной безопасности США (NNSA), компании AMD и HPE официально представили El Capitan — самый производительный в мире суперкомпьютер. Эта машина возглавила ноябрьский рейтинг мощнейших вычислительных систем TOP500. Комплекс El Capitan создан специалистами HPE Cray. Суперкомпьютер обладает FP64-быстродействием 1,742 Эфлопс в тесте Linpack (HPL), тогда как пиковый теоретический показатель достигает 2,746 Эфлопс. Прежний лидер TOP500 — система Frontier — с производительностью 1,353 Эфлопс теперь находится на втором месте рейтинга. Машина Aurora, так и не прибавившая в производительности, хотя и заявленная когда-то как 2-Эфлопс система, занимает теперь третье место. В основу El Capitan легла платформа HPE Cray Shasta. Используется гибридная архитектура AMD с APU Instinct MI300A: изделие содержит 24 ядра Zen 4 общего назначения, блоки CDNA 3 и 128 Гбайт памяти HBM3. В общей сложности в составе суперкомпьютера объединены 11 136 узлов, каждый из которых несёт на борту четыре экземпляра Instinct MI300A. Применён интерконнект HPE Slingshot-11 с пропускной способностью 200 Гбит/с. Система включает узлы Rabbit, которые формируют дезагрегированное NVMe-хранилище с прямым PCIe-подключением к вычислительным узлам. Суммарное количество ядер CPU и GPU в составе El Capitan достигает 11 039 616, объём памяти — 5,4375 Пбайт. За отвод тепла отвечает система прямого жидкостного охлаждения HPE. Заявленная энергетическая эффективность составляет 58,89 Гфлопс/Вт: с таким показателем машина оказалась на 18-м месте в списке «зелёных» суперкомпьютеров GREEN500, но с учётом масштаба и общего энергопотребления 29,58 МВт — это хороший показатель. Система охлаждения HPC-объекта использует 28 тыс. т воды. Отмечается, что El Capitan станет главным вычислительным ресурсом для Tri-lab — группы, в которую вместе с LLNL входят Сандийские национальные лаборатории (SNL) и Лос-Аламосская национальная лаборатория (LANL). Использовать мощности нового суперкомпьютера планируется для обеспечения национальной безопасности и решения сложных задач, связанных с ядерным оружием. В частности, El Capitan обеспечит беспрецедентные возможности моделирования и имитации, необходимые для Программы управления ядерными запасами NNSA. Кроме того, НРС-комплекс поможет в модернизации и создании нового оружия, такого как боеголовки W87-1 и W93, которые в настоящее время находятся на стадии разработки.  Отмечается также, что на 10-й позиции в рейтинге TOP500 оказался суперкомпьютер Tuolumne, также построенный в рамках проекта LLNL и NNSA. Фактически Tuolumne — это младший брат El Capitan: машина использует ту же архитектуру на базе Instinct MI300A, но обладает примерно на порядок меньшей FP64-производительностью 208,10 Пфлопс с пиковым значением 288,88 Пфлопс. Применять мощности Tuolumne планируется для «несекретных» задач, таких как исследования в области энергетической безопасности, изменений климата, вычислительной биологии, разработки лекарственных препаратов следующего поколения и пр. Стоит отметить, что Frontier — не единственная система, которая уступила пальму первенства более новым НРС-комплексам в ноябрьском рейтинге TOP500. Та же участь постигла самый мощный суперкомпьютер Европы LUMI, который опустился с пятого на восьмое место. На пятой позиции оказалась совершенно новая система HPC6, расположенная в центре нефтегазовой компании Eni в Феррера-Эрбоньоне (Италия). Её производительность достигает 477,9 Пфлопс при пиковом показателе 606,97 Пфлопс.

19.11.2024 [11:47], Сергей Карасёв

Esperanto и NEC займутся созданием HPC-решений на базе RISC-VСтартап Esperanto Technologies и корпорация NEC объявили о заключении соглашения о сотрудничестве в области НРС. Речь идёт о создании программных и аппаратных решений следующего поколения, использующих открытую архитектуру RISC-V. Напомним, Esperanto разрабатывает высокопроизводительные RISC-V-чипы для задач НРС и ИИ. Первым продуктом компании стало изделие ET-SoC-1, которое объединяет 1088 энергоэффективных ядер ET-Minion и четыре высокопроизводительных ядра ET-Maxion. Решение предназначено для инференса рекомендательных систем, в том числе на периферии. В августе 2023 года стало известно о подготовке чипа ET-SoC-2 с высокопроизводительными ядрами RISC-V с векторными расширениями. В рамках соглашения о сотрудничестве, как отмечается, будут объединены опыт и экспертизы NEC в области проектирования суперкомпьютеров и создания специализированного софта для HPC-задач с технологиями Esperanto в сфере высокопроизводительных энергоэффективных чипов на основе набора инструкций RISC-V. При этом упоминаются достижения NEC по направлению векторных процессоров: японская компания проектировала уникальные изделия SX-Aurora, но их разработка была остановлена в 2023 году.

Источник изображения: Esperanto «Используя глубокий опыт и экспертные знания NEC в области HPC, а также открытый набор инструкций RISC-V в сочетании с вычислительной технологией Esperanto, мы сможем разрабатывать масштабируемые и эффективные решения для ИИ и высокопроизводительных вычислений», — отметил Арт Свифт (Art Swift), президент и генеральный директор Esperanto. |

|