Материалы по тегу: epyc

|

15.03.2025 [14:08], Сергей Карасёв

Supermicro представила GPU-серверы на базе Intel Xeon 6900P и AMD EPYC 9005/9004

amd

b200

emerald rapids

epyc

genoa

granite rapids

hardware

intel

nvidia

sapphire rapids

supermicro

turin

xeon

ии

сервер

Компания Supermicro представила большое количество серверов, рассчитанных на ИИ-задачи, НРС-нагрузки и периферийные вычисления. В частности, дебютировали системы в форм-факторе 10U с возможностью установки восьми ускорителей NVIDIA B200 (SXM): это системы SuperServer SYS-A22GA-NBRT, SuperServer SYS-A21GE-NBRT и A+ Server AS-A126GS-TNBR. Модель SuperServer SYS-A22GA-NBRT рассчитана на два процессора Intel Xeon 6900P семейства Granite Rapids, каждый из которых может насчитывать до 128 ядер (TDP до 500 Вт). Доступны 24 слота для модулей оперативной памяти DDR5-8800 MRDIMM суммарным объёмом до 6 Тбайт. Есть десять фронтальных отсеков для SFF-накопителей с интерфейсом PCIe 5.0 x4 (NVMe) и два коннектора для SSD типоразмера M.2 2280/22110/25110 (PCIe 4.0 x4 NVMe). Предусмотрены десять слотов для карт PCIe 5.0 x16 LP и два слота для карт PCIe 5.0 x16 FHHL. Питание обеспечивают шесть блоков мощностью 5250 Вт. Реализовано воздушное охлаждение. Вариант SuperServer SYS-A21GE-NBRT поддерживает установку двух процессоров Intel Xeon поколения Emerald Rapids или Sapphire Rapids, содержащих до 64 вычислительных ядер (с показателем TDP до 350 Вт). Доступны 32 слота для модулей DDR5-4400/5600 максимальным объёмом 8 Тбайт. Предусмотрены десять отсеков для накопителей SFF (PCIe 5.0 x4 NVMe), два коннектора M.2 2280 (PCIe 3.0 x4 NVMe), восемь слотов PCIe 5.0 x16 LP, два слота PCIe 5.0 x16 FHHL, шесть блоков питания мощностью 5000 Вт. Модель A+ Server AS-A126GS-TNBR, в свою очередь, может комплектоваться двумя чипами AMD EPYC 9005 Turin или EPYC 9004 Genoa (максимум 192 ядра, до 500 Вт). Доступны 24 слота для модулей DDR5-6000 суммарным объёмом до 9 Тбайт. Реализованы десять фронтальных SFF-отсеков (8 × NVMe и 2 × SATA), два коннектора M.2 NVMe, восемь слотов PCIe 5.0 x16 LP и два слота PCIe 5.0 x16 FHHL. Задействованы шесть блоков питания мощностью 5250 Вт с сертификатом Titanium. Машина оборудована воздушным охлаждением.

Кроме того, Supermicro представила компактный сервер SYS-112D-36C-FN3P, в основу которого положена аппаратная платформа Intel Xeon 6 SoC (Granite Rapids-D), оптимизированная специально для сетевых и периферийных устройств. Эта модель наделена двумя портами 100GbE QSFP28 и слотом PCIe 5.0 FHFL. Поддерживается до 512 Гбайт памяти DDR5. Дебютировали системы SYS-E201-14AR и SYS-E300-14AR, рассчитанные на задачи IoT и ИИ на периферии.

13.03.2025 [15:55], Руслан Авдеев

ESA запустила суперкомпьютер Space HPC для европейских космических исследованийЕвропейское космическое агентство (ESA) запустило суперкомпьютерную платформу ESA Space HPC, специально разработанную для развития космических исследований и технологий в Евросоюзе. Открытие нового объекта состоялось на территории принадлежащего ESA центра ESRIN в Италии, сообщает HPC Wire. ESA Space HPC обеспечит поддержку исследований и развития технологий в рамках всех программ ESA, обеспечивая учёным и малому и среднему бизнесу из стран Евросоюза доступ к вычислительным мощностям. Инициатива призвана развить использование высокопроизводительных вычислений (HPC) в аэрокосмическом секторе ЕС, она станет основой для более масштабных инициатив в будущем. Как сообщается на сайте проекта, Space HPC построен при участии HPE. Суперкомпьютер включает порядка 34 тыс. ядер процессоров Intel и AMD последних поколений, 156 Тбайт RAM, 108 ускорителей NVIDIA H100, All-Flash подсистему хранения ёмкостью 3,6 Пбайт и пропускной способностью 500 Гбайт/с, а также 400G-интерконнект InfiniBand. Общая пиковая производительность кластера составляет 5 Пфлопс (FP64). Space HPC использует прямое жидкостное охлаждение, а PUE системы не превышает 1,09. Избыточное тепло отправляется на нужды отопления кампуса. Локальная солнечная электростанция обеспечивает более половины энергетических нужд кластера. Представители итальянских властей заявили, что технологические инновации в космическом секторе являются приоритетом для обеспечения безопасности и «стратегической автономии», а также будут способствовать конкурентоспособности европейской промышленности. Также отмечено, что местный аэрокосмический хаб Lazio стал домом для 250 компаний и играет ключевую роль в развитии авионики, электроники, радаров, спутниковых технологий и материаловедения. В руководстве ESA отметили потенциал Space HPC для инноваций в космической индустрии Евросоюза. Новый объект обеспечит агентству гибкую суперкомпьютерную инфраструктуру для исследований и разработок, тестирования и бенчмаркинга, поддержки программ ESA и промышленных предприятий. Доступ к вычислениям будет иметь и малый и средний бизнес, стартапы и т.п. Также отмечается, что дебют Space HPC наглядно продемонстрировал, ESA не только берёт ресурсы у государств-участников, но и много может дать им взамен. Утверждается, что одной из ключевых сфер деятельности, где требуются HPC-платформы, для ESA является наблюдение за Землёй. Новые мощности обеспечат управление наблюдениями, разработку новых приложений и сервисов. Space HPC будет поддерживать сложные нагрузки, включая моделирование, инженерные симуляции, обучение ИИ-моделей, аналитику данных и визуализацию, а также прочие эксперименты, которые помогут снизить риски будущих космических проектов. Это позволит ESA повысить финансовую эффективность проектов и обеспечит возможность обмена данными между разными программами агентства. В конце 2024 года сообщалось, что в 2025 году в Евросоюзе появится сразу семь ИИ-фабрик EuroHPC, а в середине минувшего февраля появилась информация, что Евросоюз направит €200 млрд на развитие ИИ, чтобы не отстать от США и Китая в этой сфере. В прошлом году было отмечено, что реализация миссий NASA задерживается из-за устаревших и перегруженных суперкомпьютеров.

09.03.2025 [14:02], Сергей Карасёв

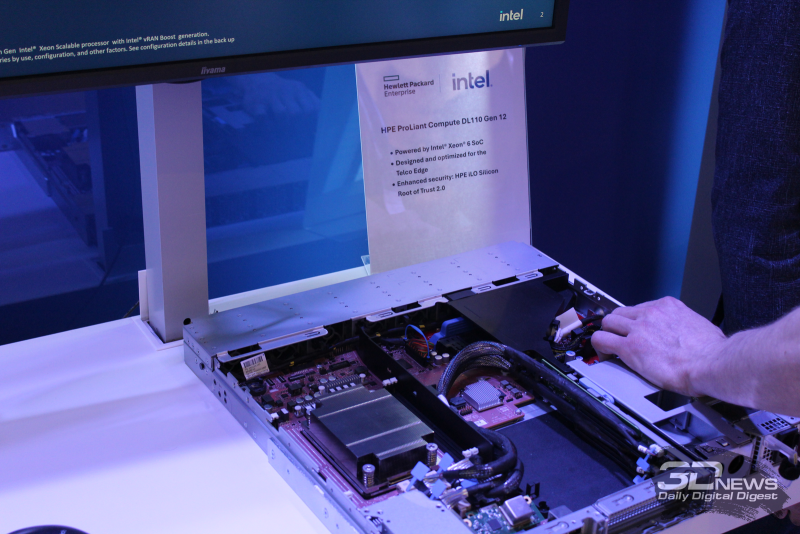

HPE представила сервер ProLiant Compute DL110 Gen12 на базе Intel Xeon Granite Rapids-DНа MWC 2025 компания HPE анонсировала сервер ProLiant Compute DL110 Gen12 для телекоммуникационных операторов. Новинка предназначена для решения различных задач на периферии, таких как виртуализованные сети радиодоступа (vRAN), приложения ИИ и пр. В основу сервера положена аппаратная платформа Intel Xeon 6 SoC (Granite Rapids-D), оптимизированная специально для сетевых и периферийных устройств. Показатель TDP варьируется от 110 до 235 Вт, турбо-частота при использовании всех ядер достигает 2,9 ГГц. Модель ProLiant Compute DL110 Gen12 выполнена в форм-факторе 1U. Полностью характеристики системы пока не раскрываются. Упомянуты функция синхронизации времени GNSS непосредственно на материнской плате и средства управления HPE iLO 7. На выставке MWC 2025 компания HPE демонстрирует ряд других серверов с процессорами AMD и Intel, а также ускорителями NVIDIA. В частности, на стенде производителя представлена машина ProLiant Compute DL384 Gen12 на базе NVIDIA GH200 NVL2. Кроме того, показана система ProLiant Compute XD680 в форм-факторе 5U: это двухпроцессорный GPU-сервер на основе Intel Xeon Emerald Rapids. Он оборудован восемью слотами HHHL PCIe 5.0, четырьмя разъёмами FHHL PCIe 5.0 и двумя слотами OCP 3.0. Возможна установка восьми накопителей SFF U.3 (NVMe). Также была показана свежая 2U-платформа ProLiant Compute DL340 Gen12. Она рассчитана на один процессор Xeon 6700 (Sierra Forest-SP или Granite Rapids-SP), установку до до 4 Тбайт RAM в виде 16 модулей DDR5-6400. Подсистема хранения может иметь несколько конфигураций: 20 × EDSFF, 8 × SFF или 12 × LFF. Поддерживаются установка шести карт расширения одинарной ширины или четырёх — двойной ширины.

Ещё один выставочный экспонат HPE — сервер ProLiant DL345 Gen11 формата 2U, который оснащается одним процессором AMD EPYC Turin. Он поддерживает до 3 Тбайт оперативной памяти DDR5-6400. В зависимости от конфигурации возможна установка до 20 накопителей LFF, до 34 устройств SFF или до 36 накопителей EDSFF. Доступны до шести слотов PCIe 5.0 х16.

06.03.2025 [21:36], Владимир Мироненко

Google раскрыла детали уязвимости в процессорах AMD и опубликовала инструментарий для анализа и изменения их микрокодаСпециалисты Google Security Team сообщили детали уязвимости (CVE-2024-56161), позволяющей обойти механизм проверки цифровой подписи при обновлении микрокода в процессорах AMD на базе микроархитектуры от Zen1 до Zen4, о чём пишет ресурс OpenNet. Уязвимости присвоен рейтинг опасности CVSS 7,2 балла из 10, что говорит о серьёзности проблемы. «Неправильная проверка подписи в загрузчике исправлений микрокода CPU AMD может позволить злоумышленнику с привилегиями локального администратора загрузить вредоносный микрокод», — говорится в сообщении Google. Исследователи известили AMD об обнаруженной уязвимости 25 сентября 2024 года. Уязвимость, сделавшая возможной загрузку собственных патчей для микрокода процессоров AMD Zen 1-4, вызвана использованием для верификации вместо рекомендованных хеш-функций алгоритма CMAC, который не подходит для этого и не защищён от подбора коллизий. Компания AMD устранила уязвимость в декабрьском обновлении микрокода путём замены CMAC на криптографически стойкую хеш-функцию. Google также опубликовала под лицензией Apache 2.0 инструментарий Zentool, с помощью которого можно анализировать микрокод, манипулировать им и создавать патчи для изменения микрокода в процессорах AMD Zen. Zentool включает команды: zentool edit — редактирует параметры файлов с микрокодом, изменяет микрокод и заменяет отдельные инструкции; zentool print — выводит информацию о структурах и параметрах микрокода; zentool load — загружает микрокод в CPU; zentool resign — корректирует цифровую подпись с учётом добавленных в микрокод изменений. Также в состав Zentool входят утилиты mcas и mcop с реализациями ассемблера и дизассемблера для микрокода. Специалисты Google также подготовили руководство по микроархитектуре RISC86, применяемой в микрокоде AMD, и рекомендации по созданию собственного микрокода с пояснением, как создавать собственные процессорные инструкции, реализуемые на микрокоде RISC86, менять поведение существующих инструкций и загружать изменения микрокода в процессор.

05.03.2025 [11:14], Сергей Карасёв

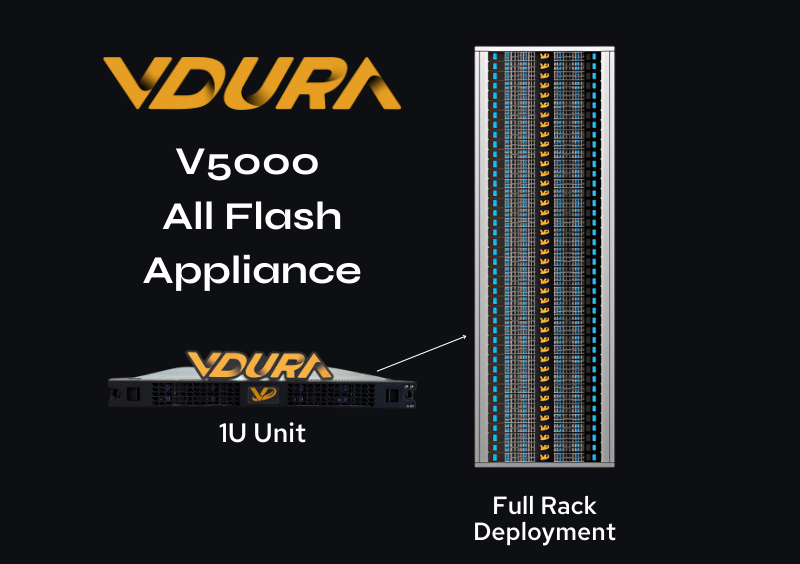

1,5 Пбайт в 1U: СХД Vdura V5000 получила All-Flash узлы F Node со 128-Тбайт NVMe QLC SSDКомпания Vdura анонсировала узел хранения данных V5000 All-Flash Appliance (F Node) типоразмера 1U, предназначенный для использования в составе платформы V5000. Изделие ориентировано на решение ресурсоёмких задач, связанных с ИИ, включая развёртывание генеративных моделей. Платформа V5000, анонсированная около трёх месяцев назад, объединяет управляющие узлы Director Node формата 1U и гибридные узлы хранения на основе SSD и HDD. Применяется фирменная программная платформа Vdura Data Platform (VDP) v11 с параллельной файловой системой PFS. Новые узлы F Node допускают установку 12 накопителей NVMe QLC вместимостью до 128 Тбайт каждый. Таким образом, суммарная «сырая» ёмкость узла достигает 1,536 Пбайт. В основу F Node положен процессор AMD EPYC 9005 Turin, функционирующий в тандеме с 384 Гбайт RAM. Задействован 400G-адаптер NVIDIA ConnectX-7 SmartNIC, обеспечивающий низкую задержку при передаче данных. Упомянуты три слота PCIe и один слот OCP 5.0. Минимальная конфигурация системы V5000 на базе All-Flash включает по три узла Director Node и F Node, которые могут масштабироваться независимо друг от друга для достижения необходимой производительности и/или вместимости. Одна стойка 42U может содержать три узла Director Node и до 39 узлов F Node, что обеспечит 59,9 Пбайт «сырой» ёмкости.

Источник изображения: Vdura В целом, как утверждается, возможно наращивание ресурсов до тысяч узлов F Node. Компания Vdura предлагает унифицированную высокопроизводительную инфраструктуру, которая способна поддерживать каждый этап жизненного цикла ИИ — от обучения модели до долгосрочного хранения данных.

18.02.2025 [14:04], Сергей Карасёв

Уязвимости в процессорах AMD EPYC обеспечивают выполнение произвольного кодаКомпания AMD сообщила о выявлении шести уязвимостей в процессорах EPYC различных поколений. Некоторые из этих «дыр» могут использоваться с целью выполнения произвольного кода в атакуемой системе. Наибольшую опасность представляют уязвимости CVE-2023-31342, CVE-2023-31343 и CVE-2023-31345, которые получили 7,5 балла (High) из 10 по шкале CVSS. Проблемы связаны с неправильной проверкой входных данных в обработчике SMM (System Management Mode). Успешная эксплуатация «дыр» позволяет злоумышленнику перезаписать SMRAM, что потенциально может привести к выполнению произвольных операций. Брешь CVE-2023-31352 с рейтингом CVSS 6,0 (Medium) связана с защитным механизмом AMD SEV (Secure Encrypted Virtualization), который применяется в системах виртуализации. Ошибка даёт атакующему возможность читать незашифрованную память, что может привести к потере гостевых данных. Уязвимость CVE-2023-20582 с рейтингом CVSS 5,3 (Medium) затрагивает технологию AMD Secure Encrypted Virtualization — Secure Nested Paging (SEV-SNP). Злоумышленник может обойти проверку RMP (Reverse Map Table), что может привести к потере целостности памяти виртуальной машины. Наконец, «дыра» CVE-2023-20581 с низким уровнем опасности CVSS 2,5 (Low) связана с ошибкой управления доступом к IOMMU (Input/Output Memory Management Unit). Привилегированный злоумышленник может обойти проверку RMP, что приведёт к потере целостности гостевой памяти. Уязвимости затрагивают процессоры EPYC Milan и Milan-X, EPYC Genoa и Genoa-X, а также EPYC Bergamo и Siena. Необходимые исправления уже выпущены: для устранения проблем необходимо обновить прошивку. Добавим, что ранее была выявлена опасная уязвимость в проверке подписи микрокода для процессоров AMD на архитектуре от Zen1 до Zen4. Успешная эксплуатация этой «дыры» может привести к потере защиты конфиденциальности.

04.02.2025 [13:52], Сергей Карасёв

Уязвимость в процессорах AMD позволяет загрузить модифицированный микрокодСпециалисты Google Security Team сообщили об обнаружении опасной уязвимости в проверке подписи микрокода для процессоров AMD на архитектуре от Zen1 до Zen4. Уязвимость даёт возможность загрузить модифицированный микрокод, позволяющий скомпрометировать технологию виртуализации с шифрованием SEV (Secure Encrypted Virtualization) и SEV-SNP (Secure Nested Paging), а также вмешаться в работу Dynamic Root of Trust for Measurement (DRTM). Успешная эксплуатация «дыры» может привести к потере защиты конфиденциальности. Проблема заключается в том, что процессоры используют небезопасную хеш-функцию при проверке подписи обновлений микрокода. Брешь позволяет злоумышленнику с привилегиями локального администратора загрузить вредоносный микрокод CPU. Исследователи подготовили пример атаки на AMD EPYC 7B13 (Milan) и Ryzen 9 7940HS (Phoenix), в результате которой функция RDRAND вместо возврата случайного числа всегда возвращает 4. AMD подготовила патчи для защиты функций SEV в EPYC 7001 (Naples), EPYC 7002 (Rome), EPYC 7003 (Milan и Milan-X), а также EPYC 9004 (Genoa, Genoa-X и Bergamo/Siena) и Embedded-вариантов EPYC 7002/7003/9004. Для устранения проблемы требуется обновление микрокода чипов. Уязвимость получила идентификатор CVE-2024-56161. Они признана достаточно опасной — 7.2 (High) по шкале CVSS. Отмечается, что Google впервые уведомила AMD об уязвимости 25 сентября 2024 года. При этом в связи с широкой распространённостью процессоров AMD и разветвлённой сетью их поставок Google сделала единовременное исключение из стандартной политики раскрытия информации об уязвимостях и отложила публичное уведомление до 3 февраля 2025-го. Кроме того, Google не стала раскрывать полные детали о «дыре», чтобы предотвратить возможные атаки. Все подробности и инструменты будут опубликованы 5 марта 2024 года.

03.02.2025 [15:06], Сергей Карасёв

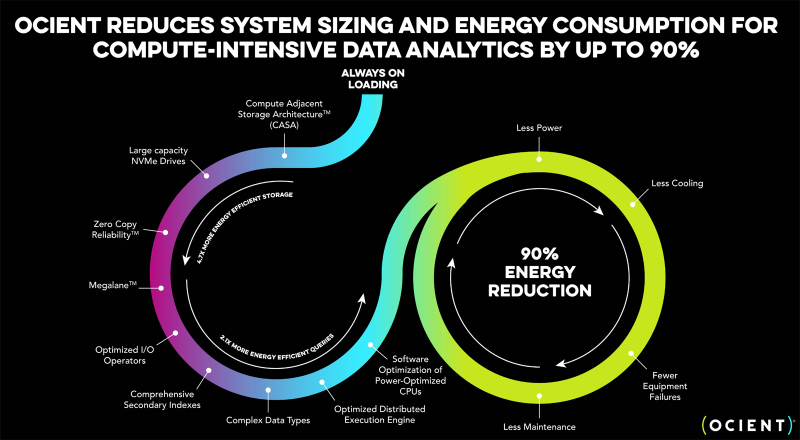

Разработчик гипермасштабируемых аналитических хранилищ Ocient выбрал чипы AMD EPYC GenoaКомпания Ocient, специализирующаяся на разработке гипермасштабируемых аналитических хранилищ данных, объявила о заключении соглашения о сотрудничестве с AMD с целью повышения производительности, снижения затрат и максимизации эффективности ресурсоёмких вычислений и рабочих нагрузок ИИ. Ocient была основана в 2016 году. Компания предлагает платформу на основе реляционной базы данных с массовым параллелизмом, которая способна анализировать огромные объёмы информации (триллионы строк) за секунды или минуты. Хранилище Ocient Hyperscale Data Warehouse (OHDW) использует архитектуру Compute Adjacent Storage Architecture (CASA) для устранения узких мест в сетевой инфраструктуре и обеспечения максимально быстрого доступа к данным. Функция Zero Copy Reliability отвечает за высокую надёжность хранения информации без репликации с помощью кодирования с контролем чётности. Генеральный директор Ocient Крис Гладвин (Chris Gladwin) отмечает, что задачи ИИ и аналитики больших данных создают огромную вычислительную нагрузку на ЦОД по всему миру. Это означает, что повышение эффективности оборудования и программного обеспечения имеет решающее значение для снижения расходов, уменьшения энергопотребления и улучшения производительности. В этой связи Ocient сделала выбор в пользу процессоров AMD EPYC 9654 поколения Genoa с 96 вычислительными ядрами, которые придут на смену 28-ядерным чипам Intel Xeon Gold 6348 семейства Ice Lake-SP. Говорится, что благодаря более высокой плотности ядер изделия AMD обеспечат трёхкратный рост производительности для ресурсоёмких вычислительных задач. При этом снизятся эксплуатационные расходы, что обусловлено повышением быстродействия и энергоэффективности. Плюс к этому достигается гибкость масштабирования.

19.01.2025 [23:24], Сергей Карасёв

Synology представила системы резервного копирования ActiveProtectКомпания Synology анонсировала устройства для бесшовного резервного копирования и быстрого восстановления данных семейства ActiveProtect. Решение объединяет специализированное ПО, серверы и хранилища резервных копий в единую унифицированную платформу. Утверждается, что ActiveProtect обеспечивает надёжную защиту всех корпоративных рабочих нагрузок. Это могут быть приложения SaaS, виртуальные машины, физические серверы, компьютеры с Windows и macOS, файловые серверы и базы данных. Благодаря встроенному гипервизору ActiveProtect пользователи могут в любое время тестировать резервные копии, а интуитивно понятный интерфейс упрощает управление. ActiveProtect предполагает применение стратегии 3-2-1-1-0, где:

Платформа ActiveProtect, как утверждается, позволяет выполнять резервное копирование с максимальной скоростью, устранять дублирование данных, увеличивать ёмкость хранилища и мгновенно восстанавливать информацию в случае необходимости. Консоль ActiveProtect Manager (APM) даёт возможность просматривать до 150 тыс. рабочих нагрузок, а также контролировать до 2500 систем. Возможно формирование среды с физической изоляцией (air-gap). В семейство устройств резервного копирования ActiveProtect вошли модели в настольном форм-факторе DP320 и DP340 на процессоре AMD Ryzen R1600. Первая оснащена 8 Гбайт RAM и двумя отсеками для LFF-накопителей (установлены два HDD по 8 Тбайт каждый). Возможна защита до 20 систем или 50 пользователей SaaS. Вторая модификация располагает 16 Гбайт ОЗУ и четырьмя отсеками для LFF-накопителей (установлены четыре HDD по 8 Тбайт каждый). Эта версия укомплектована двумя кеширующими SSD вместимостью по 400 Гбайт. Возможна защита до 60 систем или 150 пользователей SaaS. Младшая версия получила два сетевых порта 1GbE, старшая — по одному порту 1GbE и 10GbE. Кроме того, представлено стоечное устройство DP7400 типоразмера 2U с процессором AMD EPYC 7272 (12 ядер) и 64 Гбайт RAM (расширяется до 512 Гбайт). В оснащение входят десять LFF HDD ёмкостью 20 Тбайт каждый и два SFF SSD на 3,84 Тбайт. Есть один порт 1GbE и два порта 10GbE. Это решение может работать 2500 серверами или 150 тыс. рабочими нагрузками в кластере. Сетевые источники также сообщают, что к выпуску готовятся стоечные системы DP5200 и DP7300 в форм-факторе 1U и 2U соответственно, но их описание на момент подготовки материала отсутствовало на сайте производителя.

19.01.2025 [22:43], Сергей Карасёв

Германия запустила «переходный» 48-Пфлопс суперкомпьютер Hunter на базе AMD Instinct MI300AЦентр высокопроизводительных вычислений HLRS при Штутгартском университете в Германии объявил о вводе в эксплуатацию НРС-системы Hunter. Этот суперкомпьютер планируется использовать для решения широко спектра задач в области инженерии, моделирования погоды и климата, биомедицинских исследований, материаловедения и пр. Кроме того, комплекс будет применяться для крупномасштабного моделирования, ИИ-приложений и анализа данных. О создании Hunter сообщалось в конце 2023 года: соглашение на строительство системы стоимостью примерно €15 млн было заключено с HPE. Проект финансируется Федеральным министерством образования и исследований Германии и Министерством науки, исследований и искусств Баден-Вюртемберга. Hunter базируется на той же архитектуре, что El Capitan — самый мощный в мире суперкомпьютер. Задействована платформа Cray EX4000, а каждый из узлов оснащён четырьмя адаптерами HPE Slingshot. Суперкомпьютер использует комбинацию из APU Instinct MI300A и процессоров EPYC Genoa. Как отмечает The Register, в общей сложности система объединяет 188 узлов с жидкостным охлаждением и насчитывает суммарно 752 APU и 512 чипов Epyc с 32 ядрами. Применена СХД HPE Cray Supercomputing Storage Systems E2000, специально разработанная для суперкомпьютеров HPE Cray. HLRS оценивает пиковую теоретическую FP64-производительность Hunter в 48,1 Пфлопс на операциях двойной точности, что практически вдвое выше, чем у предшественника Hawk. В режимах BF16 и FP8 быстродействие, как ожидается, будет варьироваться от 736 Пфлопс до 1,47 Эфлопс. При этом Hunter потребляет на 80% меньше энергии, нежели Hawk. Отмечается, что Hunter задуман как переходная система, которая подготовит почву для суперкомпьютера HLRS следующего поколения под названием Herder. Ввести этот комплекс в эксплуатацию планируется в 2027 году. Предполагается, что он обеспечит производительность «в несколько сотен петафлопс». |

|