Материалы по тегу: rome

|

19.01.2025 [23:24], Сергей Карасёв

Synology представила системы резервного копирования ActiveProtectКомпания Synology анонсировала устройства для бесшовного резервного копирования и быстрого восстановления данных семейства ActiveProtect. Решение объединяет специализированное ПО, серверы и хранилища резервных копий в единую унифицированную платформу. Утверждается, что ActiveProtect обеспечивает надёжную защиту всех корпоративных рабочих нагрузок. Это могут быть приложения SaaS, виртуальные машины, физические серверы, компьютеры с Windows и macOS, файловые серверы и базы данных. Благодаря встроенному гипервизору ActiveProtect пользователи могут в любое время тестировать резервные копии, а интуитивно понятный интерфейс упрощает управление. ActiveProtect предполагает применение стратегии 3-2-1-1-0, где:

Платформа ActiveProtect, как утверждается, позволяет выполнять резервное копирование с максимальной скоростью, устранять дублирование данных, увеличивать ёмкость хранилища и мгновенно восстанавливать информацию в случае необходимости. Консоль ActiveProtect Manager (APM) даёт возможность просматривать до 150 тыс. рабочих нагрузок, а также контролировать до 2500 систем. Возможно формирование среды с физической изоляцией (air-gap). В семейство устройств резервного копирования ActiveProtect вошли модели в настольном форм-факторе DP320 и DP340 на процессоре AMD Ryzen R1600. Первая оснащена 8 Гбайт RAM и двумя отсеками для LFF-накопителей (установлены два HDD по 8 Тбайт каждый). Возможна защита до 20 систем или 50 пользователей SaaS. Вторая модификация располагает 16 Гбайт ОЗУ и четырьмя отсеками для LFF-накопителей (установлены четыре HDD по 8 Тбайт каждый). Эта версия укомплектована двумя кеширующими SSD вместимостью по 400 Гбайт. Возможна защита до 60 систем или 150 пользователей SaaS. Младшая версия получила два сетевых порта 1GbE, старшая — по одному порту 1GbE и 10GbE. Кроме того, представлено стоечное устройство DP7400 типоразмера 2U с процессором AMD EPYC 7272 (12 ядер) и 64 Гбайт RAM (расширяется до 512 Гбайт). В оснащение входят десять LFF HDD ёмкостью 20 Тбайт каждый и два SFF SSD на 3,84 Тбайт. Есть один порт 1GbE и два порта 10GbE. Это решение может работать 2500 серверами или 150 тыс. рабочими нагрузками в кластере. Сетевые источники также сообщают, что к выпуску готовятся стоечные системы DP5200 и DP7300 в форм-факторе 1U и 2U соответственно, но их описание на момент подготовки материала отсутствовало на сайте производителя.

17.09.2024 [23:07], Игорь Осколков

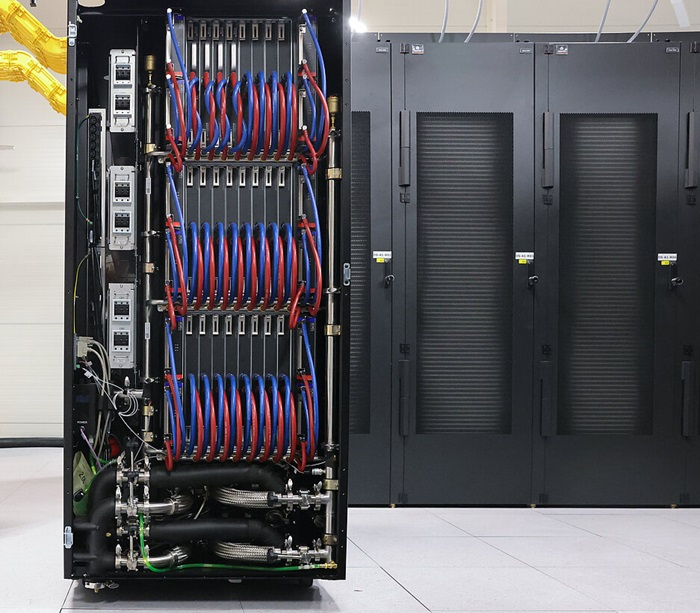

Швейцария ввела в эксплуатацию гибридный суперкомпьютер Alps: 11 тыс. NVIDIA GH200, 2 тыс. AMD EPYC Rome и щепотка A100, MI250X и MI300AШвейцарская высшая техническая школа Цюриха (ETH Zurich) провела церемонию официального запуска суперкомпьютера Alps в Швейцарском национальном суперкомпьютерном центре (CSCS) в Лугано. Система, построенная HPE, уже заняла шестую строчку в последнем рейтинге TOP500 и имеет устоявшеюся FP64-производительность 270 Пфлопс (теоретический пик — 354 Пфлопс). К ноябрю будут введены в строй остальные модули машины, и её максимальная производительность составит порядка 500 Пфлопс.

Источник изображений: CSCS В июньском рейтинге TOP500 участвовал раздел из 2688 узлов HPE Cray EX254n с «фантастической четвёркой» NVIDIA Quad GH200. Если точнее, это всё же «старый» вариант ускорителя с H100 (96 Гбайт HBM3), 72-ядерным Arm-процессором Grace и 128 Гбайт LPDDR5x — суммарно 10 752 Grace Hopper. Данный раздел потребляет 5,2 МВт и в Green500 находится на 14 месте. Узлы, конечно же, используют СЖО. Это основной, но не единственный раздел суперкомпьютера. Ещё в 2020 году HPE развернула 1024 двухпроцессорных узла с 64-ядерными AMD EPYC 7742 (Rome) и 256/512 Гбайт RAM. Его производительность составляет 4,7 Пфлопс. Кроме того, в состав Alps входят 144 узла с одним 64-ядерным AMD EPYC, 128 Гбайт RAM и четырьмя NVIDIA A100 (80 или 96 Гбайт HBM2e). Наконец, машина получит 24 узла с одним 64-ядерным AMD EPYC, 128 Гбайт RAM и четырьмя AMD Instinct MI250X (128 Гбайт HBM2e) и 128 узлов с четырьмя гибридными ускорителями AMD Instinct MI300A. Большая часть узлов будет объединена интерконнектом HPE Slingshot-11: 200G-подключение на узел или ускоритель. Более точную конфигурацию системы раскроют в ноябре. Lustre-хранилище для будущей машины обновили ещё в прошлом году. Основной СХД является Cray ClusterStor E1000 с подключением Slingshot-11. Так, было добавлено 100 Пбайт полезной HDD-ёмкости (8480 × 16 Тбайт) с пропускной способностью 1 Тбайт/с (300 тыс. IOPS на запись, 1,5 млн IOPS на чтение) и 5 Пбайт SSD, а также резервные ёмкости. За архивное хранение отвечают две ленточные библиотеки объёмом 130 Пбайт каждая. Особенностью системы является её геораспределённость (фактически узлы размещены в четырёх местах) и облачная модель использования. Так, метеослужба страны MeteoSwiss получила в своё распоряжение выделенный виртуальный кластер, что уже позволило перейти на использование метеомодели более высокого разрешения, которая лучше отражает сложный рельеф Швейцарии. Кроме того, для подстраховки часть узлов Alps размещена на территории Федеральной политехнической школы Лозанны (EPFL). Alps приходит на смену суперкомпьютеру Piz Daint (Cray XC50/40, 21,2 Пфлопс), о завершении жизненного цикла которого было объявлено в конце июля 2024 года. В CSCS пока останутся машины Arolla + Tsa (для нужд MeteoSwiss) и Blue Brain 5 (решает задачи реконструкции и симуляции мозга). Alps же помимо традиционных HPC-нагрузок, будет использоваться для разработки ИИ-решений.

18.09.2019 [19:50], Андрей Созинов

AMD представила EPYC 7H12: самый быстрый процессор семейства RomeСегодня в Риме компания AMD провела европейскую презентацию процессоров EPYC Rome (символично, не правда ли?), на которой неожиданно представила совершенно новый процессор — EPYC 7H12. Новинка отличается не только своим нестандартным названием, но и характеристиками, которые делают её самым мощным серверным процессором AMD на текущий момент. Процессор EPYC 7H12 обладает 64 ядрами, как и другие старшие модели семейства EPYC Rome. Базовая частота новинки составляет 2,6 ГГц, а максимальная Turbo-частота достигает 3,3 ГГц. Для сравнения — возглавлявший до этого семейство Rome процессор EPYC 7742 обладает значительно более низкой базовой частотой в 2,25 ГГц, а вот в режиме Turbo может разгоняться чуть выше — до 3,4 ГГц. Средняя же рабочая частота новинки будет выше.

Источник изображения: AMD Базовая частота напрямую влияет на уровень TDP процессора. Поэтому показатель TDP EPYC 7H12 увеличился до 280 Вт, тогда как у EPYC 7742 он составлял 225 Вт. Из-за возросшего TDP новый процессор рекомендуется использовать в серверах с системами жидкостного охлаждения. Один из партнёров AMD, компания Atos, уже показала узел Bullsequana XH2000 с восемью процессорами EPYC 7H12 и полностью жидкостным охлаждением, высота которого составит лишь 1U. Кроме как частотами и уровнем TDP, процессоры EPYC 7H12 и EPYC 7742 ничем не отличаются друг от друга. Оба имеют 64 ядра Zen 2, 128 вычислительных потоков, 256 Мбайт кеш-памяти третьего уровня, 128 линий PCIe 4.0 и контроллер памяти с восемью каналами и поддержкой DDR4-3200.  Процессор EPYC 7H12 ориентирован на использование в составе высокопроизводительных вычислительных систем и центрах обработки данных. Согласно синтетическому тесту Linpack, новый процессор обеспечивает прирост производительности до 11 % по сравнению с EPYC 7742, который мы протестировали в августе. Цена новинки пока не названа. Не исключено, что она будет заметно выше, чем у 7742. Всё-таки, это особый сегмент рынка, где даже за незначительный прирост производительности готовы платить. Аналогичную политику проводит и Intel. В семействе Xeon на базе Broadwell были модели с индексом A, которые отличались чуть более высокими частотами. А летом Intel представила процессор Xeon Platinum 8284, который в сравнении с базовой моделью 8280 также имеет повышенную частоту и возросший в полтора раза ценник. |

|